今年新年很特別,AI工具添光彩。今天就來感受下最新的AI神器天選組合“WasmEdge+Yi-34B”,只要短短三步,為這個甲辰龍年帶來一份九紫離火運的科技感。

環境準備

這次用的算力是OpenBayes提供的英偉達RTX_4090*1、24GB顯存、20核CPU、80GB內存、50 GB工作空間。可點擊本鏈接Yi-34B-Chat-GGUF LlamaEdge demo - OpenBayes

進入工作空間后,點擊頁面上方的克隆,它將依據當前模板創建新的訓練任務,并預裝本次運行需要的各項文件:

1、Yi-34B-Chat-Q4_K_M GGUF 模型。

2、使用 LlamaEdge 運行大模型所需要的Wasm推理文件。

3、用于構建 chatbot 的 web UI。

注意:如果要使用web的chatbot,需要完成實名認證。

福利彩蛋:通過以下鏈接注冊可獲免費英偉達RTX 4090(官方售價1599美元,漲價60%還買不到)計算資源1h

注冊 - OpenBayeshttps://openbayes.com/console/signup?r=wordsworth0126_GC2U大模型準備(重點)

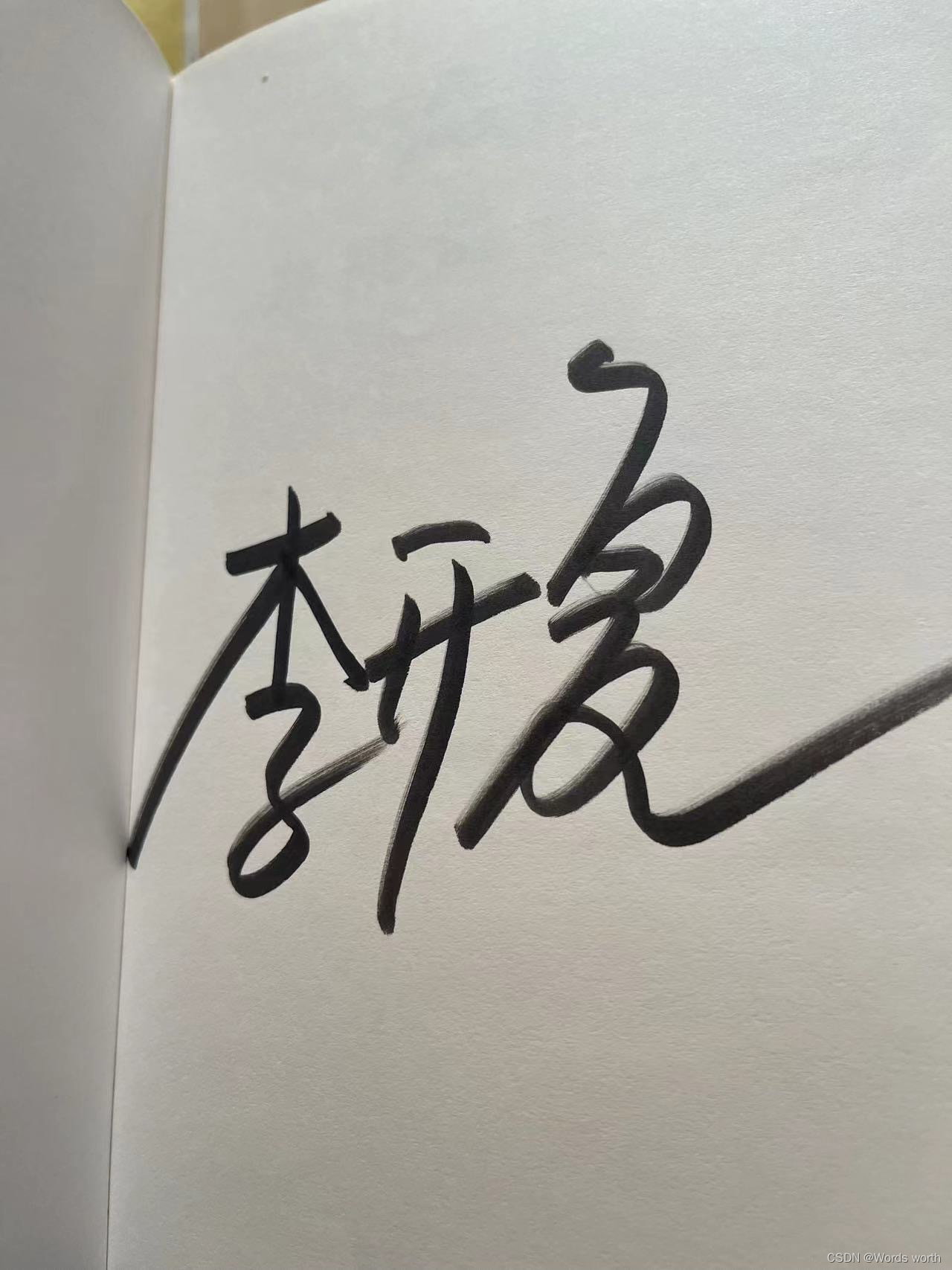

本次使用的大模型是李開復博士領導的零一萬物團隊發布的 Yi-34B-Chat,該因優越的中英雙語性能而受開發者廣泛歡迎,獲得全球開源評測“雙料冠軍”。

推理工具準備(重點)

本次推理使用LlamaEdge,它是一個基于Rust和WasmEdge的框架,可以實現本地開發與測試大模型應用,然后跨平臺地運行應用。

WasmEdge是輕量級、安全、高性能、可擴展、兼容OCI的軟件容器與運行環境。WasmEdge被廣泛應用在 SaaS、云原生,service mesh、邊緣計算、邊緣云、微服務、流數據處理、LLM 推理等領域。

模型啟動

1、SSH訪問

打開電腦上的終端,通過 SSH訪問OpenBayes工作空間。

ssh root@ssh.openbayes.com -p端口2、安裝WasmEdge和ggml plugin

輸入以下命令安裝 CNCF WasmEdge runtime 以及 ggml plugin。

curl -sSf https://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install.sh | bash -s -- --plugin wasi_nn-ggml安裝后要啟動容器

source /root/.bashrc3、與模型交互

本項目提供了兩種與模型交互的方式。 ? ? ? ?

3.1 通過 CLI 與大模型交互

使用下面的命令行,啟動大模型,然后可以通過 CLI 與 大模型交互。

wasmedge --dir .:. --nn-preload default:GGML:AUTO:/openbayes/input/input0/Yi-34B-Chat-Q4_K_M.gguf llama-chat.wasm -p chatml -r '<|im_end|>' -c 1024這里要注意模型所在的路徑(/openbayes/input/input0)。

3.2 通過 chatbot UI 與 大模型交互

1、先打開一個新的終端窗口,將 OpenBayes的8080 端口映射到本地。這一步需要 SSH 訪問的密碼。

ssh -vNL 8080:localhost:8080 root@ssh.openbayes.com -p端口2、在原終端窗口使用下面的命令行,創建 API server

wasmedge --dir .:. --nn-preload default:GGML:AUTO:/openbayes/input/input0/Yi-34B-Chat-Q4_K_M.gguf llama-api-server.wasm -p chatml -r '<|im_end|>' -c 1024這里要注意模型所在的路徑(/openbayes/input/input0)。

3、API 服務器啟動成功,出現 [INFO] Listening on http://0.0.0.0:8080 。在瀏覽器打開 http://localhost:8080/ ,這就可以搞搞大模型,調戲Yi-34B-Chat了。

(未完待續~)

Qt窗口)

求解23個基準函數)

:電解電容低阻如何選擇詳解)

)

)

)