多語言數據感覺主要還是fineweb和fineweb2, 其他數據都是主要針對特定語種比較多

101 Billion Arabic Words Dataset

ClusterlabAi/101_billion_arabic_words_dataset

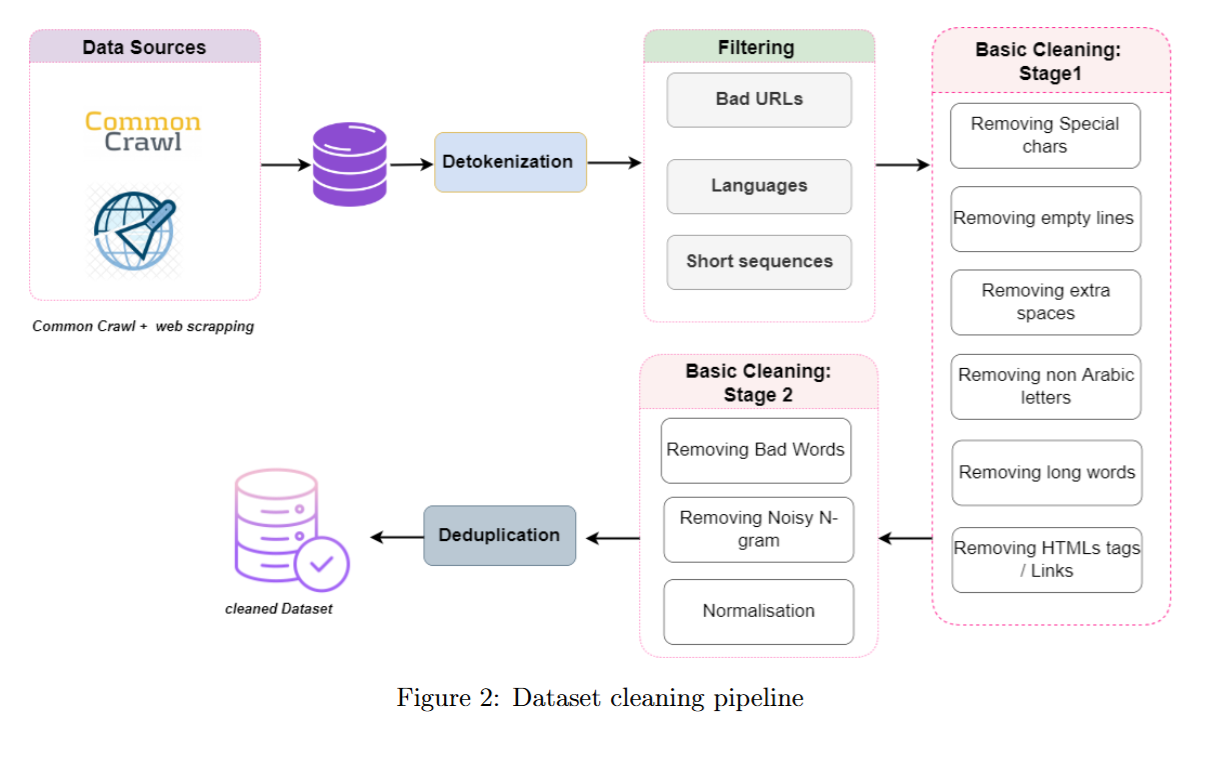

數據主要從e Common Crawl WET 中提取,并采用了創新的技術來進行去重和篩選,主要解決大部分語料是從英語翻譯過來的問題。

數據收集 :

- 時間 : week 39 of 2021 to week 27 of 2022的時間段內

- 從3000個網站中,篩選出250個阿拉伯網站,

數據清洗 :

數據去重 :

基于minihash的方式對 總文本和段落分別進行去重。

使用了一些專門針對阿拉伯語設計的分詞和處理的工具 : Camel tools library version 1.5.2, Tnkeeh v0.0.9。

最終數據集的情況:

缺陷 : 沒有對倫理、有害、敏感的數據進行去除,大部分依賴URL進行過濾和進行簡單的去重操作。

Chinese Tiny LLM: Pretraining a Chinese-Centric Large Language Model

m-a-p/MAP-CC

數據來源 : 包含CC, 學術論文, 百科全書, 書籍.

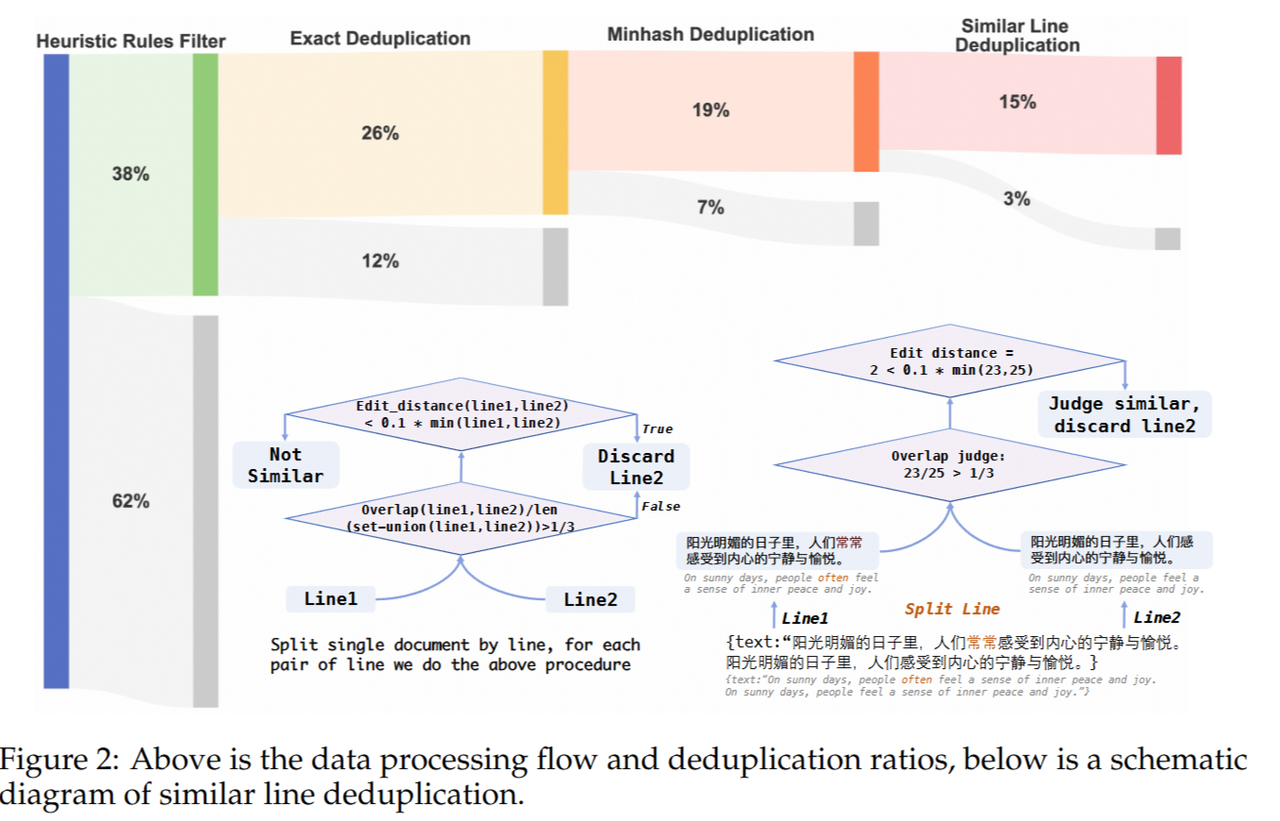

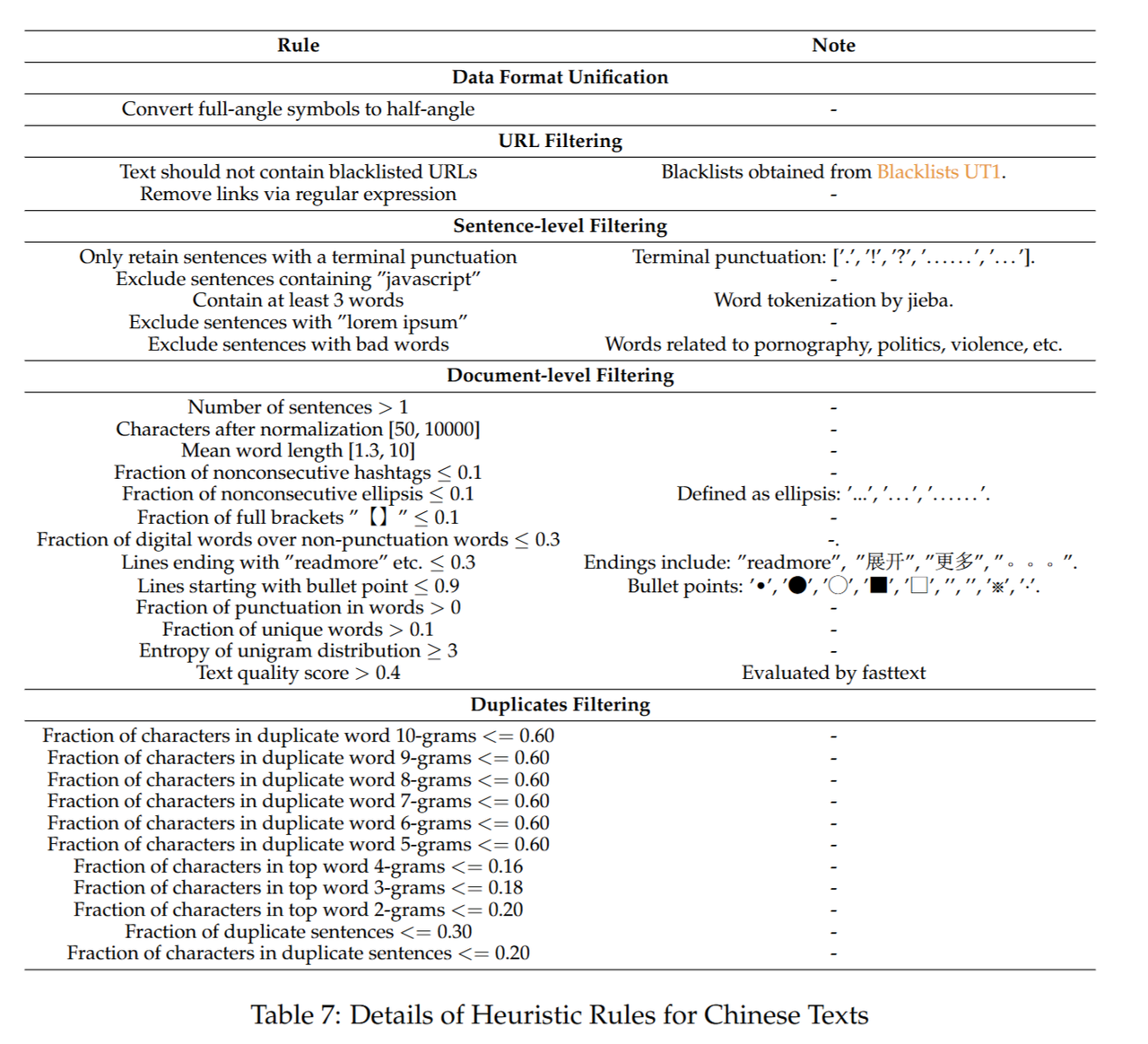

數據處理流程 :

對于上述的啟發式過濾采用了右圖辦法。附帶了一個CHC-Bench,評估在中文上的模型性能。

CroissantLLM: A Truly Bilingual French-English Language Model

(論文提到的Tokenizer也有變化,可以去看一看)

法語數據來源(英語和Code數據來源是公開數據集) :

-

Oscar、mC4等多個網絡爬蟲項目 + 比利時、瑞士和摩洛哥等非洲國家的主流新聞源

-

法國法律行政數據,5.3B

-

文化數據

? 古登堡計劃(Hart, 1971)截至2023年10月的全部法語公版書籍(3.02億token)

? 法國國家圖書館(BnF)的手稿與文檔:經OCR處理、公版認證且通過質量篩選(保留2700萬token,原始語料大部分因質量剔除)

? 詩歌網站爬取的法語經典詩歌

? 高質量語音轉文字生成的播客文本(規模有限)

? OpenSubtitles電影字幕(4180萬token) -

百科全書數據

-

工業數據

在對于Web Data做了一些數據清洗的工作,對于其他數據沒有進行系統的數據清洗

-> 配置構建(三))

——技術平臺——共享平臺)

)

有界面)

-Git篇)

)

—讓大模型理解表格數據(列車信息表))