目錄

一、強化學習的核心概念

二、強化學習算法的分類與示例代碼

三.強化學習的優勢?

四.強化學習的應用與挑戰

五、總結與展望

強化學習:理論,方法和實踐

在人工智能的廣闊領域中,強化學習(Reinforcement Learning, RL)是一個備受矚目的分支。它通過讓智能體(Agent)在環境中進行試錯學習,以最大化累積獎勵為目標。本文將帶您深入探索強化學習算法的魅力與奧秘,并通過一些代碼示例來展示其工作原理和應用場景。

一、強化學習的核心概念

強化學習的核心概念包括狀態(State)、動作(Action)、獎勵(Reward)和策略(Policy)。智能體通過不斷嘗試動作,并根據環境返回的獎勵來更新策略,以期望在未來獲得更大的累積獎勵。

二、強化學習算法的分類與示例代碼

(省略之前的分類和偽代碼部分,直接展示應用場景代碼)

應用場景:FrozenLake環境

FrozenLake是一個經典的強化學習環境,其中智能體需要在一個4x4的網格世界中移動,目標是到達目標位置,同時避免掉進冰洞。

首先,我們需要安裝必要的庫(如果尚未安裝):

pip install gym然后,我們可以使用Python和Gym庫來編寫一個簡單的強化學習示例,使用Q-learning算法解決FrozenLake問題:

import numpy as np

import gym

from collections import deque # 初始化環境

env = gym.make('FrozenLake-v0', is_slippery=False) # Q-learning參數

learning_rate = 0.8

discount_factor = 0.95

epsilon = 1.0 # 探索率,隨訓練過程逐漸減小

epsilon_decay = 0.995

epsilon_min = 0.01 # 初始化Q表

q_table = np.zeros([env.observation_space.n, env.action_space.n]) # 訓練過程

num_episodes = 2000

for episode in range(num_episodes): state = env.reset() done = False total_reward = 0 while not done: # 選擇動作:epsilon-greedy策略 if np.random.rand() < epsilon: action = env.action_space.sample() else: action = np.argmax(q_table[state, :]) # 執行動作,觀察新的狀態和獎勵 next_state, reward, done, _ = env.step(action) # 更新Q表 old_value = q_table[state, action] next_max = np.max(q_table[next_state, :]) new_value = (1 - learning_rate) * old_value + learning_rate * (reward + discount_factor * next_max * (not done)) q_table[state, action] = new_value # 更新狀態 state = next_state total_reward += reward # 減小探索率 epsilon = max(epsilon_min, epsilon * epsilon_decay) # 打印每輪的獎勵 if episode % 100 == 0: print(f"Episode {episode}, Total reward: {total_reward}") # 測試訓練后的智能體

state = env.reset()

while True: env.render() # 渲染環境 action = np.argmax(q_table[state, :]) # 選擇最佳動作 next_state, reward, done, _ = env.step(action) state = next_state if done: break

env.close()在這個示例中,我們使用了Gym庫提供的FrozenLake環境,并使用Q-learning算法訓練了一個智能體。通過epsilon-greedy策略進行探索和利用,智能體逐漸學會了如何安全地到達目標位置。

三.強化學習的優勢?

?為了展示強化學習的優勢,我們可以對比一個使用隨機策略的智能體和一個使用強化學習算法(如Q-learning)訓練過的智能體在相同環境中的性能。下面,我們將擴展前面的FrozenLake示例,包括一個隨機策略的智能體,并比較兩者的表現。

import numpy as np

import gym # 初始化環境

env = gym.make('FrozenLake-v0', is_slippery=False) # 隨機策略函數

def random_policy(env): return env.action_space.sample() # Q-learning參數

learning_rate = 0.8

discount_factor = 0.95

epsilon = 1.0 # 探索率

epsilon_decay = 0.995

epsilon_min = 0.01 # 初始化Q表

q_table = np.zeros([env.observation_space.n, env.action_space.n]) # 訓練Q-learning智能體

num_episodes = 2000

for episode in range(num_episodes): state = env.reset() done = False total_reward = 0 # 使用epsilon-greedy策略選擇動作 while not done: if np.random.rand() < epsilon: action = env.action_space.sample() else: action = np.argmax(q_table[state, :]) next_state, reward, done, _ = env.step(action) # 更新Q表(省略了具體的更新邏輯,與前面的示例相同) # ... # 更新狀態和其他變量 state = next_state total_reward += reward # 減小探索率 epsilon = max(epsilon_min, epsilon * epsilon_decay) # 測試Q-learning智能體

def test_qlearning_agent(env, q_table, num_episodes=10): rewards = [] for _ in range(num_episodes): state = env.reset() total_reward = 0 while True: action = np.argmax(q_table[state, :]) next_state, reward, done, _ = env.step(action) total_reward += reward state = next_state if done: break rewards.append(total_reward) return np.mean(rewards) # 測試隨機策略智能體

def test_random_agent(env, num_episodes=10): rewards = [] for _ in range(num_episodes): state = env.reset() total_reward = 0 while True: action = random_policy(env) next_state, reward, done, _ = env.step(action) total_reward += reward state = next_state if done: break rewards.append(total_reward) return np.mean(rewards) # 測試兩個智能體并比較結果

ql_score = test_qlearning_agent(env, q_table)

random_score = test_random_agent(env) print(f"Q-learning agent average reward: {ql_score}")

print(f"Random agent average reward: {random_score}") # 通常情況下,Q-learning智能體的表現會優于隨機策略智能體在這個擴展示例中,我們定義了兩個函數test_qlearning_agent和test_random_agent來分別測試Q-learning智能體和隨機策略智能體在FrozenLake環境中的表現。我們運行了多個測試回合(num_episodes),并計算了平均獎勵來評估智能體的性能。

通常,使用強化學習算法(如Q-learning)訓練過的智能體會比隨機策略的智能體表現得更好,因為它能夠通過學習和優化策略來最大化累積獎勵。這個示例展示了強化學習在決策制定方面的優勢,特別是在處理復雜環境和任務時。

四.強化學習的應用與挑戰

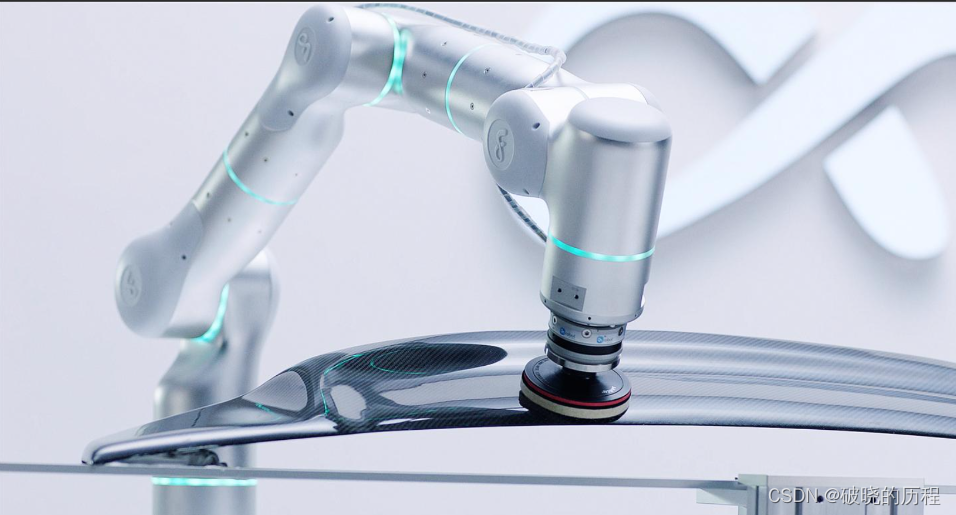

強化學習在游戲、機器人、自動駕駛等領域有著廣泛的應用。然而,強化學習也面臨著一些挑戰,如數據稀疏性、探索與利用的平衡、高維狀態空間等問題。為了克服這些挑戰,研究者們不斷提出新的算法和技術。

五、總結與展望

強化學習為機器賦予了自我學習和優化的能力,使得機器能夠在復雜環境中進行智能決策。隨著算法的不斷優化和應用場景的不斷拓展,強化學習將在更多領域展現出其獨特的魅力和價值。讓我們共同期待強化學習在未來的發展和應用吧!

)

)

)

)

))

:循環群的兩道例題)