一、AI、ML、DL、NLP的極簡概念

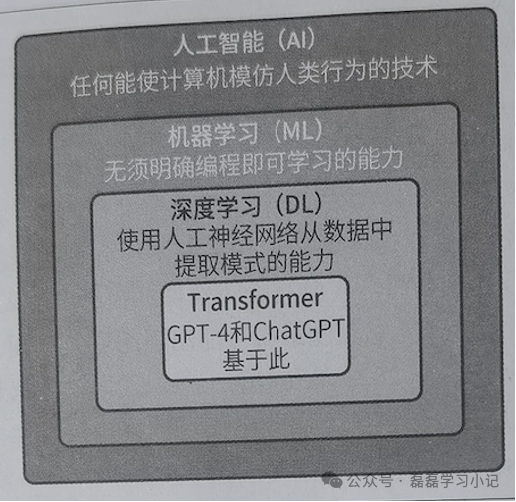

1、人工智能(AI)有不同的定義,但其中一個定義或多或少已成為共識,即AI是一個計算機系統,它能夠執行通常需要人類智能才能完成的任務。根據這個定義,許多算法可以歸納為AI算法,比如導航應用程序所用的交通預測算法或策略類視頻游戲所用的機遇規則的系統。從表面看,這些示例中,計算機似乎需要智能才能完成相關任務。

??從AI到Transformer的嵌套技術組合

2、機器學習(machine learning,ML)是AI的一個子集,在ML中,我們不試圖直接實現AI系統使用的決策規則。相反,我們試圖開發算法,使系統能夠通過示例數據自己學習。

3、深度學習(deep learning,DL)算法已經引起了廣泛關注。DL是ML的一個分支,專注于受大腦結構啟發的算法,這些事算法倍稱為人工神經網絡(artifical neural network)。它們可以處理大量的數據,并別在圖像識別、語音識別及NLP等任務上表現出色。

4、自然語言處理(Natural language process,NLP)是ML和AI的一個子領域。專注于使計算機能夠處理、解釋和生產人類語言,現代NLP解決方案基于ML算法。NLP的目標是讓計算機能夠處理自然語言文本。這個目標設計諸多任務,例如文本分類、自動翻譯、問題回答。

5、GPT-4和ChatGPT基于一種特定的神經網絡架構(即Transformer),基于大量數據訓練而成的NLP領域中的大語言模型(LLM),它們能夠以非常高的準確性識別和生成人類可讀的文本。

二、Transformer如何呼之欲出的

Transformer是一種基于自注意力機制的深度學習模型,由Google2017年提出。徹底改變了NLP領域的序列建模方式,它通過并行計算和全局依賴建模,解決了傳統循環神經網絡(RNN)的長距離依賴難題,成為現代大模型(如BERT、GPT)的基石。經歷了下面三個主要階段。

1、LLM的發展可以追溯到幾年前,它始于簡單的語言模型,如n-gram模型,n-gram模型通過使用詞頻來根據前面的詞預測句子中的下一個詞,因此又稱為概率模型,其預測結果是在訓練文中中緊隨前面的詞出現的頻率最高的詞。雖然這種方法提供了不錯的著手點,但是n-gram模型在理解上下文和語法方面仍需改進,因為它有時會生成不連貫的文本。

2、為了提高n-gram模型的性能,人們引入了更先進的學習算法,包括循環神經網絡(recurrent neural network,RNN)和長短期記憶(long short-term memory,LSTM)網絡。與n-gram模型相比,這些模型能夠學習更長的序列,并且能夠更好地分析上下文,但他們在處理大量數據時的效率仍然欠佳。盡管如此,在很長的一段時間里,這些模型算法是最高效的。因此在自動翻譯等任務中被廣泛使用。

3、Transformer架構徹底改變了NLP領域,這主要是因為它能夠有效地解決之前的NLP模型(如RNN)存在的一個關鍵問題:很難處理長文本序列并記住其上下文。換句話說,RNN在處理長文本序列時容易忘記上下文(也就是臭名昭著的“災難性遺忘問題”),Transformer則具備高效處理和編碼上下文的能力。改變的核心是注意力機制。

--素材來自《大模型應用開發極簡入門》和網絡材料

如何進行MySQL的全局變量設置?)