一、Scikit-learn 核心定位

是什么:Python 最主流的機器學習庫,涵蓋從數據預處理到模型評估的全流程。

為什么測試工程師必學:

? 80% 的測試機器學習問題可用它解決

? 無需深厚數學基礎,API 設計極簡

? 與 Pandas/Numpy 無縫集成,完美處理測試數據

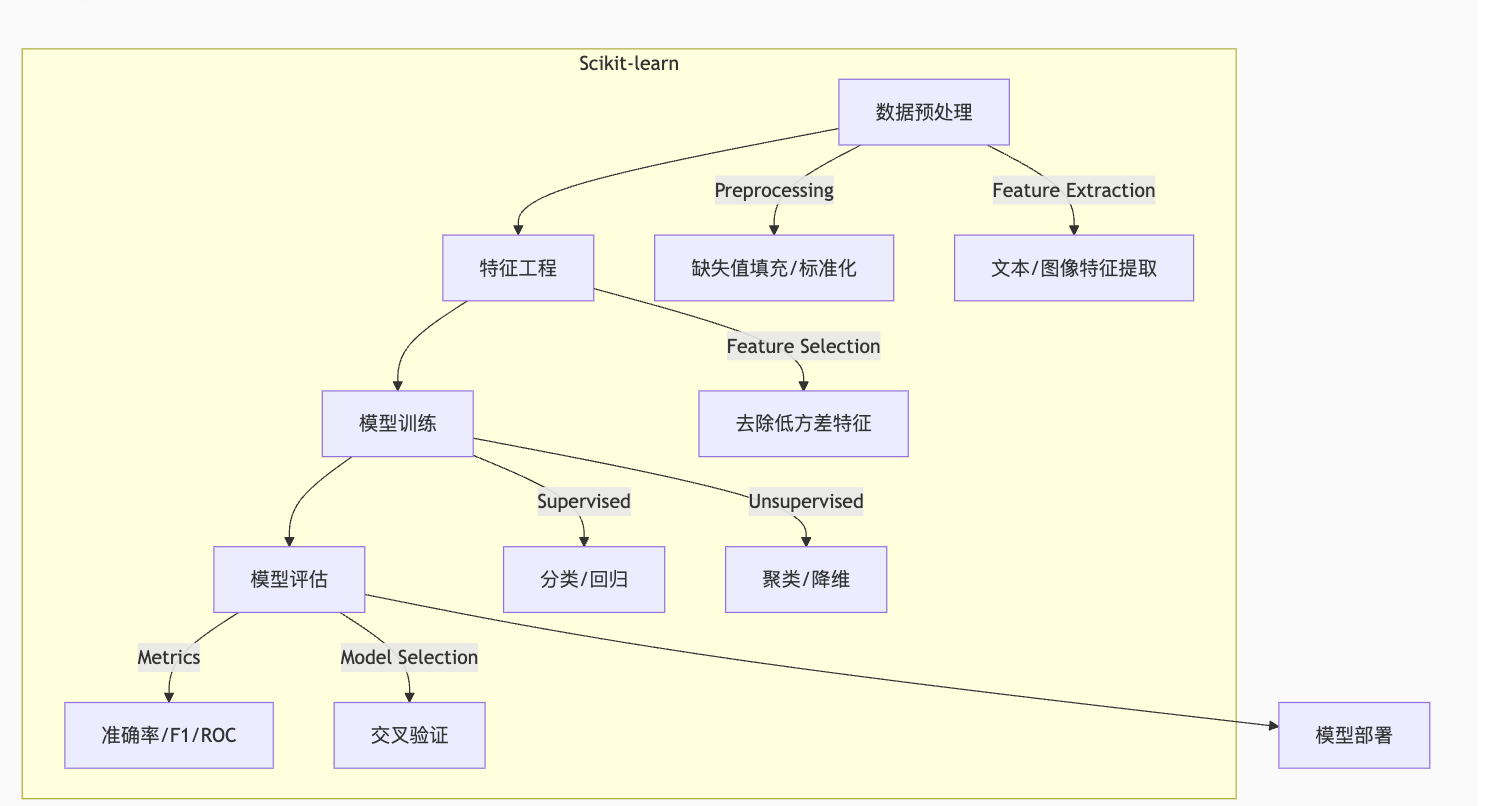

二、Scikit-learn 核心模塊圖解

三、測試工程師必掌握的 6 大核心功能

1. 數據預處理:清洗混亂的測試數據

測試痛點:測試日志缺失值、環境配置數值差異大

python

from sklearn.impute import SimpleImputer from sklearn.preprocessing import MinMaxScaler# 處理測試執行時間的缺失值(用中位數填充) imputer = SimpleImputer(strategy='median') test_data['execution_time'] = imputer.fit_transform(test_data[['execution_time']])# 將環境配置參數歸一化(如內存:4GB/16GB → 0.25/1.0) scaler = MinMaxScaler() test_data[['cpu_cores', 'memory_gb']] = scaler.fit_transform(test_data[['cpu_cores', 'memory_gb']])

2. 文本特征提取:分析缺陷報告

測試場景:自動分類缺陷報告(崩潰/性能/UI)

python

from sklearn.feature_extraction.text import TfidfVectorizer# 將缺陷描述轉為數值特征 bug_descriptions = ["UI按鈕點擊無響應", "API響應超時5s", "APP啟動時崩潰"] vectorizer = TfidfVectorizer(max_features=1000) # 提取最重要的1000個詞 X_text = vectorizer.fit_transform(bug_descriptions)# 輸出:<3x1000 sparse matrix> 可用于訓練分類模型

3. 分類模型:預測測試用例失敗概率

測試場景:優先執行高失敗風險的測試用例

python

from sklearn.ensemble import RandomForestClassifier from sklearn.model_selection import train_test_split# 特征:測試用例復雜度 + 歷史失敗率 + 關聯代碼變更次數 X = test_cases[['complexity', 'historical_fail_rate', 'code_changes']] y = test_cases['failed'] # 標簽:0=通過, 1=失敗# 拆分數據集(測試集永遠隔離!) X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 訓練隨機森林 model = RandomForestClassifier(n_estimators=100) model.fit(X_train, y_train)# 預測新測試用例失敗概率 new_case = [[5, 0.3, 8]] # 復雜度=5, 失敗率=30%, 變更次數=8 fail_prob = model.predict_proba(new_case)[0][1] # 輸出:0.87 (87%概率失敗)

4. 聚類分析:自動歸檔相似缺陷報告

測試場景:減少重復缺陷報告處理時間

python

from sklearn.cluster import KMeans

from sklearn.feature_extraction.text import TfidfVectorizer# 1. 提取文本特征

vectorizer = TfidfVectorizer(stop_words='english')

X = vectorizer.fit_transform(bug_reports['description'])# 2. 聚類相似缺陷(假設分5類)

kmeans = KMeans(n_clusters=5, random_state=42)

clusters = kmeans.fit_predict(X)# 3. 結果分析

bug_reports['cluster'] = clusters

print(bug_reports.groupby('cluster')['description'].count()) # 查看每類缺陷數量5. 回歸模型:預測測試執行時間

測試場景:優化測試資源調度

python

from sklearn.linear_model import Ridge from sklearn.metrics import mean_absolute_error# 特征:測試步驟數 + 涉及服務數 + 數據量大小 X = tests[['step_count', 'services_involved', 'data_size_mb']] y = tests['execution_time_sec']# 訓練回歸模型 model = Ridge(alpha=1.0) model.fit(X_train, y_train)# 評估模型 y_pred = model.predict(X_test) mae = mean_absolute_error(y_test, y_pred) # 平均絕對誤差:12.3秒

6. 模型評估:驗證測試效果

測試工程師必須掌握的評估技術:

python

from sklearn.metrics import classification_report, confusion_matrix# 分類模型評估

y_pred = model.predict(X_test)

print(classification_report(y_test, y_pred))

print("混淆矩陣:\n", confusion_matrix(y_test, y_pred))# 輸出示例:precision recall f1-score support0 0.92 0.95 0.93 120 # 通過類1 0.88 0.82 0.85 60 # 失敗類accuracy 0.91 180四、Scikit-learn 在測試中的典型應用場景

| 測試領域 | 問題類型 | 推薦算法 | 應用效果 |

|---|---|---|---|

| 缺陷優先級分類 | 文本分類 | SGDClassifier?(TF-IDF) | 自動區分 P0/P1/P2 缺陷 |

| 測試失敗根因分析 | 多分類問題 | RandomForest | 識別失敗原因:環境/數據/代碼缺陷 |

| 性能瓶頸預測 | 回歸分析 | GradientBoostingRegressor | 提前發現接口響應時間劣化 |

| 測試用例去冗余 | 聚類 | DBSCAN | 合并高度相似的測試用例 |

| 視覺測試差異檢測 | 圖像特征 + 分類 | PCA?+?SVM | 識別UI細微差異 |

?五、實操舉例說明

# 場景:自動分類缺陷報告from sklearn.cluster import KMeans

from sklearn.feature_extraction.text import TfidfVectorizer

import pandas as pd# 1. 提取文本特征

vectorizer = TfidfVectorizer(stop_words='english')

bug_reports = {'description': ['登錄頁無響應', '無法提交表單', '密碼重置失敗', '登錄超時', '驗證碼不顯示','按鈕無法點擊','按鈕點擊無反應','字符取值錯誤'],'cluster': []

}

X = vectorizer.fit_transform(bug_reports['description'])# 2. 聚類相似缺陷(假設分5類)

kmeans = KMeans(n_clusters=5, random_state=42)

clusters = kmeans.fit_predict(X)# 3. 結果分析

bug_reports['cluster'] = clusters

df = pd.DataFrame(bug_reports)# 按聚類分組后,打印每個聚類的具體描述

for cluster_id, group in df.groupby('cluster'):print(f"聚類 {cluster_id} 包含的缺陷:")for desc in group['description']:print(f"- {desc}")print("---")

- vectorizer = TfidfVectorizer(stop_words='english')

- 作用是創建一個TF-IDF 文本特征提取器,用于將文本數據轉換為數值特征向量。

TfidfVectorizer:這是 scikit-learn 庫中用于實現 TF-IDF算法的工具類,它能把人類可讀的文本翻譯成機器學習算法能理解的數字向量,同時還會自動忽略無意義的常用詞,讓翻譯結果更精準。

- TF(詞頻):衡量一個詞在某篇文檔中出現的頻率,出現次數越多,權重越高。

- IDF(逆文檔頻率):衡量一個詞在所有文檔中的普遍重要性,在越少文檔中出現的詞(越獨特),權重越高。

兩者結合可以將文本轉換為能體現詞語重要性的數值向量。

stop_words='english':這是一個參數設置,表示在處理文本時會自動過濾掉英文停用詞(如 "the"、"and"、"is" 等)。

這些詞在英文中出現頻率極高,但通常不攜帶實際語義,過濾后可以減少噪音,讓特征更聚焦于有意義的詞匯。

vectorizer.fit_transform(bug_reports['description'])

將文本數據轉換為機器學習算法可處理的數值特征矩陣,是文本特征提取的核心步驟。它完成了兩個關鍵操作:

擬合(fit):讓?

vectorizer(TF-IDF 提取器)“學習” 文本數據的特征,包括:- 分析所有文本中的詞匯,構建一個詞匯表(比如將 “登錄”“響應”“表單” 等詞映射為唯一的索引)。

- 計算每個詞的 IDF(逆文檔頻率)值,評估其在整個文本集合中的重要性。

轉換(transform):將原始文本數據轉換為 TF-IDF 數值矩陣:

- 矩陣?

X?的每一行對應一個文本(如一條缺陷報告)。 - 每一列對應詞匯表中的一個詞。

- 矩陣中的數值是該詞在對應文本中的 TF-IDF 分數(綜合了詞頻和重要性的權重)。

- 矩陣?

- KMeans

- 是一種經典的無監督聚類算法,全稱為 K - 均值聚類(K-Means Clustering)。它的核心作用是:將一堆沒有標簽的數據,自動劃分成 K 個不同的組別(聚類),使得同一組內的數據相似度高,不同組的數據相似度低。

- kmeans = KMeans(n_clusters=5, random_state=42)

random_state=42?是為了保證代碼運行結果的可重復性而設置的參數。相當于給隨機過程設定了一個 “種子值”(這里的種子是 42)。無論你運行多少次代碼,只要?random_state?保持不變,算法中涉及的隨機操作都會產生相同的結果。- 以 KMeans 為例,它在初始階段會隨機選擇 K 個聚類中心,這個隨機選擇會影響最終的聚類結果 —— 即使是同一組數據,不同的初始中心可能會得到略有差異的聚類結果。

- 為什么是42 ?這是編程領域的一個 “梗”(源自《銀河系搭車客指南》中 “生命、宇宙及一切的終極答案是 42”)。實際使用中,你可以換成任何整數(如 0、100 等),只要保持固定,就能保證結果可重復。

clusters = kmeans.fit_predict(X)

- 對特征矩陣 X 執行 KMeans 聚類,并返回每個樣本所屬的聚類標簽。

- df = pd.DataFrame(bug_reports)

- 將字典格式的?

bug_reports?轉換為 pandas 數據框(DataFrame),方便進行數據處理和分析。

- 將字典格式的?

周軍 -個人筆記版 5000字)

)

問題詳解)