數據及具體講解來源:

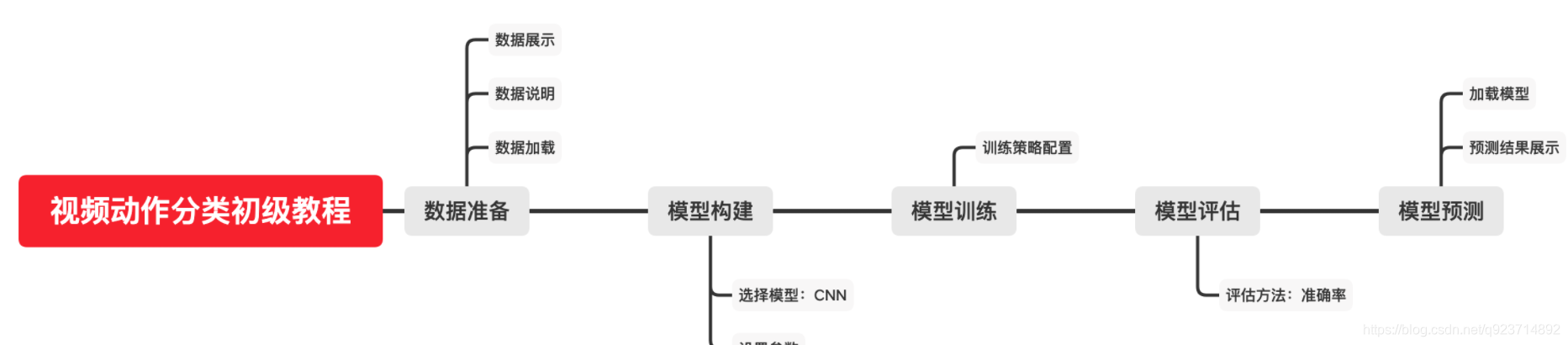

基于PyTorch搭建CNN實現視頻動作分類任務

import torch

import torch.nn as nn

import torchvision.transforms as T

import scipy.io

from torch.utils.data import DataLoader,Dataset

import os

from PIL import Image

from torch.autograd import Variable

import numpy as np"""

加載數據

"""

#獲得標簽

label_mat = scipy.io.loadmat('./datasets/q3_2_data.mat')

#獲得訓練集標簽

label_train = label_mat['trLb']

print(len(label_train))

#獲得驗證集標簽

label_val = label_mat['valLb']

print(len(label_val))"""

通過Dataset類進行數據預處理

"""

class ActionDataset(Dataset):def __init__(self,root_dir,labels = [],transform=None):"""Args::param root_dir: 數據路徑:param labels: 圖片標簽:param transform: 數據處理函數"""self.root_dir = root_dirself.transform = transformself.length = len(os.listdir(self.root_dir))self.labels = labelsdef __len__(self): #返回數據數量return self.length*3 #一個視頻片段包含3幀(3個圖片)def __getitem__(self, idx): #圖片處理及返回數據folder = idx//3+1 #判斷該幀屬于第幾個視頻中imidx = idx%3 + 1 #判斷該幀在該視頻中是第幾幀folder = format(folder,'05d') #將folder格式化,05d代表五位數,若不到五位用0填充imgname = str(imidx) + '.jpg'img_path = os.path.join(self.root_dir,folder,imgname)image = Image.open(img_path)"""當輸入標簽有值時,說明是訓練集和驗證集,輸出的樣本也是有標簽的,若沒有值,說明是測試集,輸出的樣本是沒有標簽的"""if len(self.labels)!=0:Label = self.labels[idx//3][0]-1#如果有對數據的處理先對數據進行處理if self.transform:image = self.transform(image)if len(self.labels)!=0:sample = {'image':image,'img_path':img_path,'Label':Label}else:sample = {'image':image,'img_path':img_path}return sampleimage_datast = ActionDataset(root_dir='./datasets/trainClips/',labels=label_train,transform=T.ToTensor())

# torchvision.transforms中定義了非常多對圖像的預處理方法,這里使用的ToTensor方法為將0~255的RGB值映射到0~1的Tensor類型。

# #測試一下

# for i in range(3):

# sample = image_datast[i]

# print(sample['image'].shape)

# print(sample['Label'])

# print(sample['img_path'])"""

Dataloader類進行封裝

注意:Windows不要用num_works

"""

#image_dataloader = DataLoader(image_datast,batch_size=4,shuffle=True)

# for i , sample in enumerate(image_dataloader):

# #enumerate(iteration, start):返回一個枚舉的對象

# sample['image'] = sample['image']

# print(sample[i,sample['image'].shape,sample['img_path'],'Label'])

# if i == 6:

# break

#訓練集

image_dataset_train=ActionDataset(root_dir='./datasets/trainClips/',labels=label_train,transform=T.ToTensor())

image_dataloader_train = DataLoader(image_dataset_train, batch_size=32,shuffle=True)

#驗證集

image_dataset_val=ActionDataset(root_dir='./datasets/valClips/',labels=label_val,transform=T.ToTensor())

image_dataloader_val = DataLoader(image_dataset_val, batch_size=32,shuffle=False)

#測試集:沒有給定labels

image_dataset_test=ActionDataset(root_dir='./datasets/testClips/',labels=[],transform=T.ToTensor())

image_dataloader_test = DataLoader(image_dataset_test, batch_size=32,shuffle=False)"""

搭建模型

"""dtype = torch.FloatTensor # 這是pytorch所支持的cpu數據類型中的浮點數類型。print_every = 100 # 這個參數用于控制loss的打印頻率,因為我們需要在訓練過程中不斷的對loss進行檢測。def reset(m): # 這是模型參數的初始化if hasattr(m, 'reset_parameters'):m.reset_parameters()#數據解釋和處理

class Flatten(nn.Module):def forward(self, x):N, C, H, W = x.size() # 讀取各個維度。return x.view(N, -1) # -1代表除了特殊聲明過的以外的全部維度。fixed_model_base = nn.Sequential(nn.Conv2d(3,8,kernel_size=7,stride=1), ##3*64*64 -> 8*58*58nn.ReLU(inplace=True),nn.MaxPool2d(2, stride = 2), # 8*58*58 -> 8*29*29nn.Conv2d(8, 16, kernel_size=7, stride=1), # 8*29*29 -> 16*23*23nn.ReLU(inplace=True),nn.MaxPool2d(2, stride = 2), # 16*23*23 -> 16*11*11Flatten(),nn.ReLU(inplace=True),nn.Linear(1936, 10) # 1936 = 16*11*11

)

fixed_model = fixed_model_base.type(dtype) #將模型數據轉換成pytorch所支持的cpu數據類型中的浮點數類型。

# #測試:

# x = torch.randn(32, 3, 64, 64).type(dtype)

# x_var = Variable(x.type(dtype)) # 需要將其封裝為Variable類型。

# ans = fixed_model(x_var)

# print(np.array(ans.size())) # 檢查模型輸出。

# np.array_equal(np.array(ans.size()), np.array([32, 10]))"""

訓練步驟及模塊

"""

optimizer = torch.optim.RMSprop(fixed_model_base.parameters(), lr = 0.0001)

loss_fn = nn.CrossEntropyLoss()def train(model,loss_fn,optimizer,dataloader,num_epoch = 1):for epoch in range(num_epoch):check_accuracy(fixed_model,image_dataloader_val) #在驗證集驗證模型效果model.train() #模型的.train()方法讓模型進入訓練模式,參數保留梯度,dropout層等部分正常工作for t,sample in enumerate(dataloader):x_var = Variable(sample['image'])y_var = Variable(sample['Label'].long())scores = model(x_var) #得到輸出loss = loss_fn(scores,y_var)if (t+1)%print_every ==0:print('t = %d, loss = %.4f' % (t + 1, loss.item()))#三步更新optimizer.zero_grad()loss.backward()optimizer.step()def check_accuracy(model,loader):num_correct = 0num_samples = 0model.eval() # 模型的.eval()方法切換進入評測模式,對應的dropout等部分將停止工作。for t,sample in enumerate(loader):x_var = Variable(sample['image'])y_var = Variable(sample['Label'])scores = model(x_var)_,preds = scores.data.max(1) # 找到可能最高的標簽作為輸出。num_correct += (preds.numpy() == y_var.numpy()).sum()num_samples += preds.size(0)acc = float(num_correct)/num_samplesprint('Got %d / %d correct (%.2f)' % (num_correct, num_samples, 100 * acc))"""

訓練并驗證

"""

torch.random.manual_seed(54321)

fixed_model.cpu()

fixed_model.apply(reset)

#pytorch中的model.apply(fn)會遞歸地將函數fn應用到父模塊的每個子模塊submodule,也包括model這個父模塊自身

fixed_model.train()

train(fixed_model, loss_fn, optimizer,image_dataloader_train, num_epoch=5)

check_accuracy(fixed_model, image_dataloader_val)"""

測試

"""def predict_on_test(model, loader):model.eval()results = open('results.csv', 'w') # 模型預測結果會被放在這里。count = 0results.write('Id' + ',' + 'Class' + '\n')for t, sample in enumerate(loader):x_var = Variable(sample['image'])scores = model(x_var)_, preds = scores.data.max(1)for i in range(len(preds)):results.write(str(count) + ',' + str(preds[i]) + '\n')count += 1results.close()return countcount = predict_on_test(fixed_model, image_dataloader_test) # 放入你想要測試的訓練集,然后打開文件去看一看結果吧。

print(count)

的認知)

: Ignite Java Thin Client)

論文及代碼解讀)