ReLU(Rectified Linear Unit)和Sigmoid都是神經網絡中常用的激活函數。

特點:

ReLU是一種簡單而有效的激活函數。它對于正數部分直接返回輸入,對于負數部分返回零。這種非線性轉換有助于網絡學習更復雜的表示。ReLU在許多深度學習模型中被廣泛使用,因為它在梯度下降中的計算上相對簡單,且有效防止了梯度消失問題。

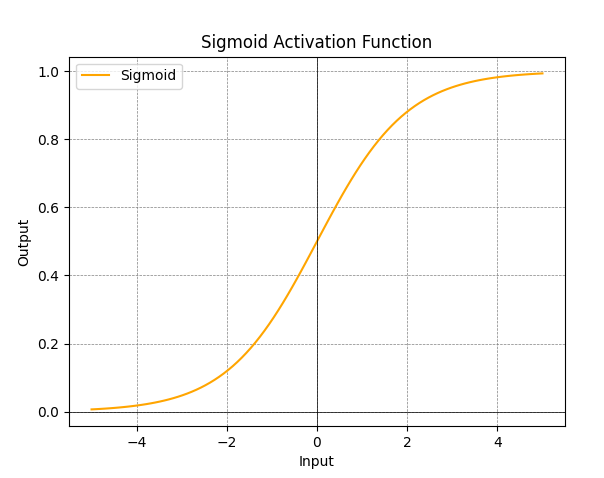

Sigmoid函數將輸入映射到(0,1)之間的范圍,常用于二分類問題。它的輸出可以解釋為概率值,因此在輸出層用于模型對樣本屬于某個類別的置信度。然而,Sigmoid函數在輸入遠離零時梯度接近零,可能導致梯度消失問題,尤其在深度網絡中。

ReLU激活函數圖:

- ReLU函數的圖形是一條直線,在輸入大于零時輸出與輸入相等,而在輸入小于等于零時輸出為零。

Sigmoid激活函數圖:

- Sigmoid函數的圖形是一條S形曲線,將輸入映射到(0,1)范圍內。

在實際使用中,ReLU常用于隱藏層,而Sigmoid常用于輸出層(用于二分類任務)。隨著研究的進展,有一些變體,如Leaky ReLU、Parametric ReLU、ELU等,旨在改進激活函數的性能。選擇激活函數通常取決于具體的任務和網絡結構。

)

)

)

(第15講))

)