機器學習常見方法

涉及方法:

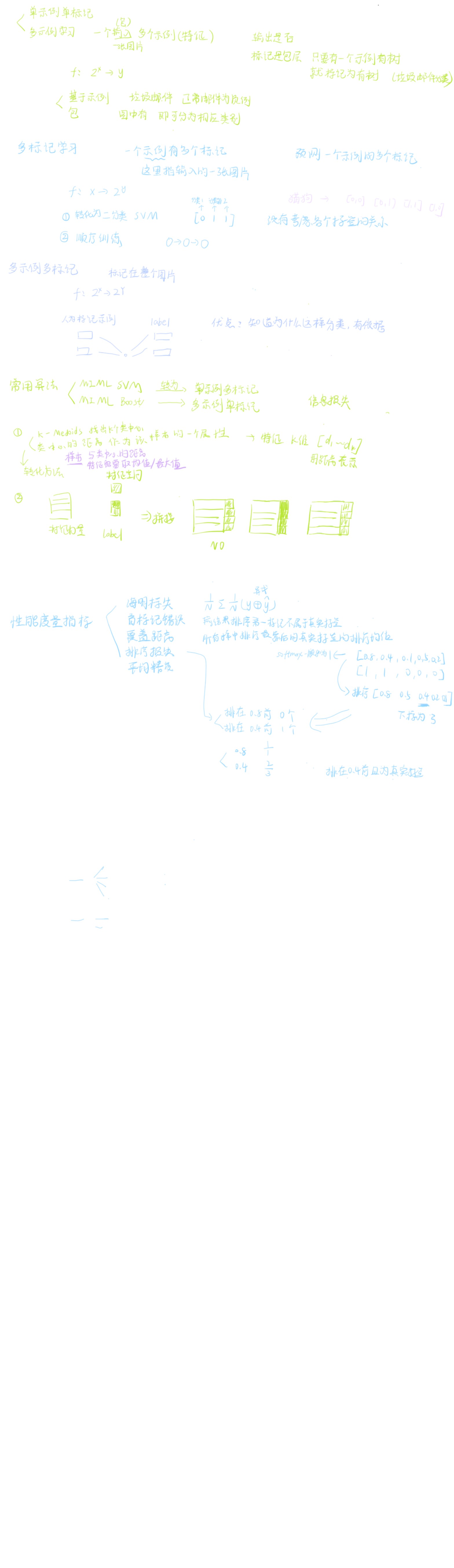

2.半監督學習

3.無監督學習

4.度量學習

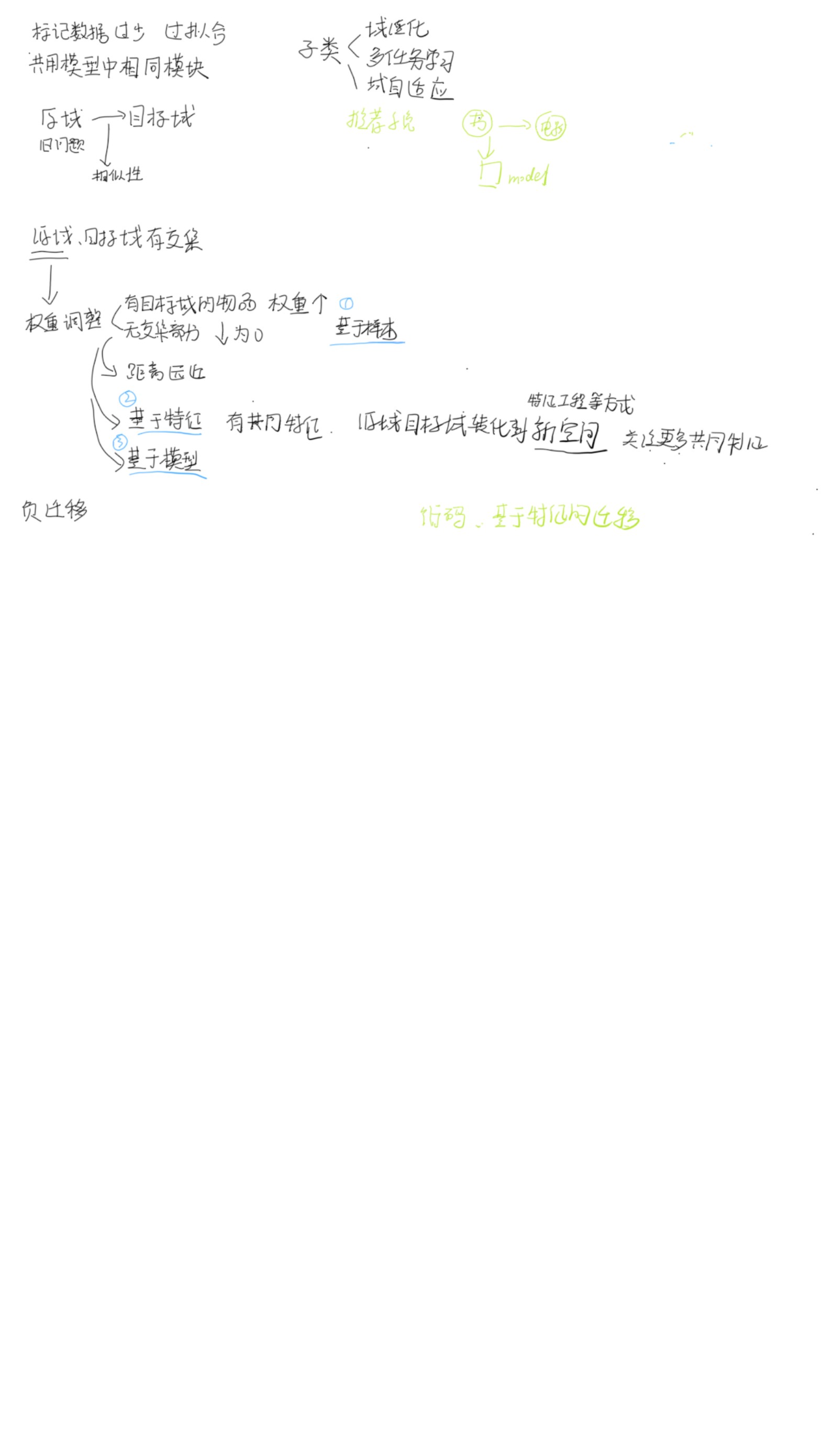

5.遷移學習

6.多示例多標記學習

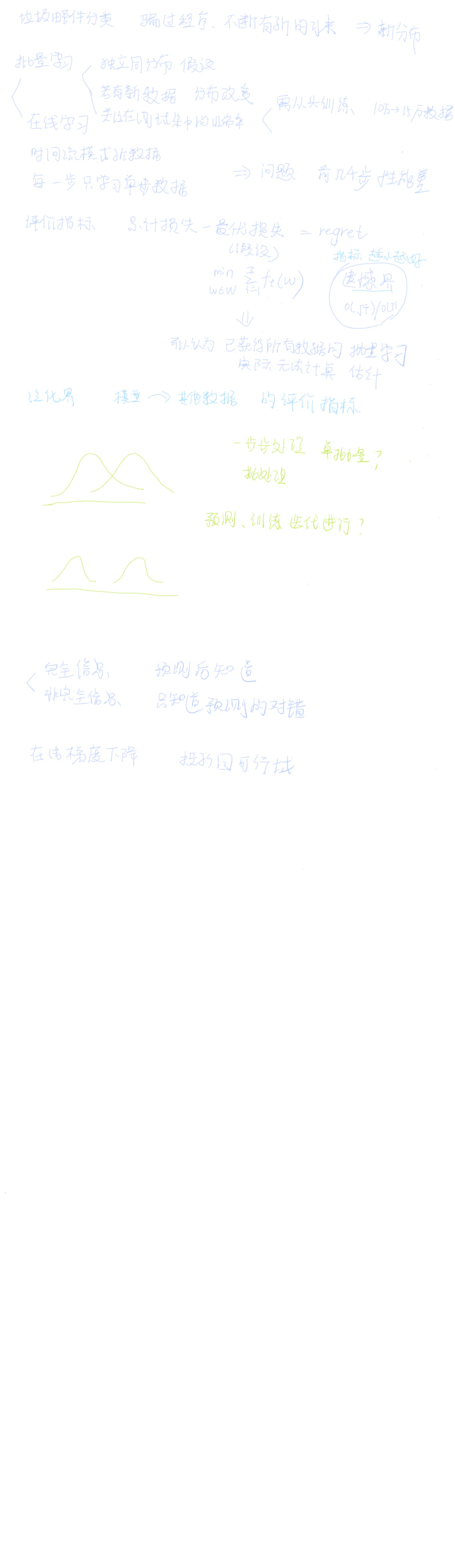

7.在線學習

8.元學習

9.聯邦學習

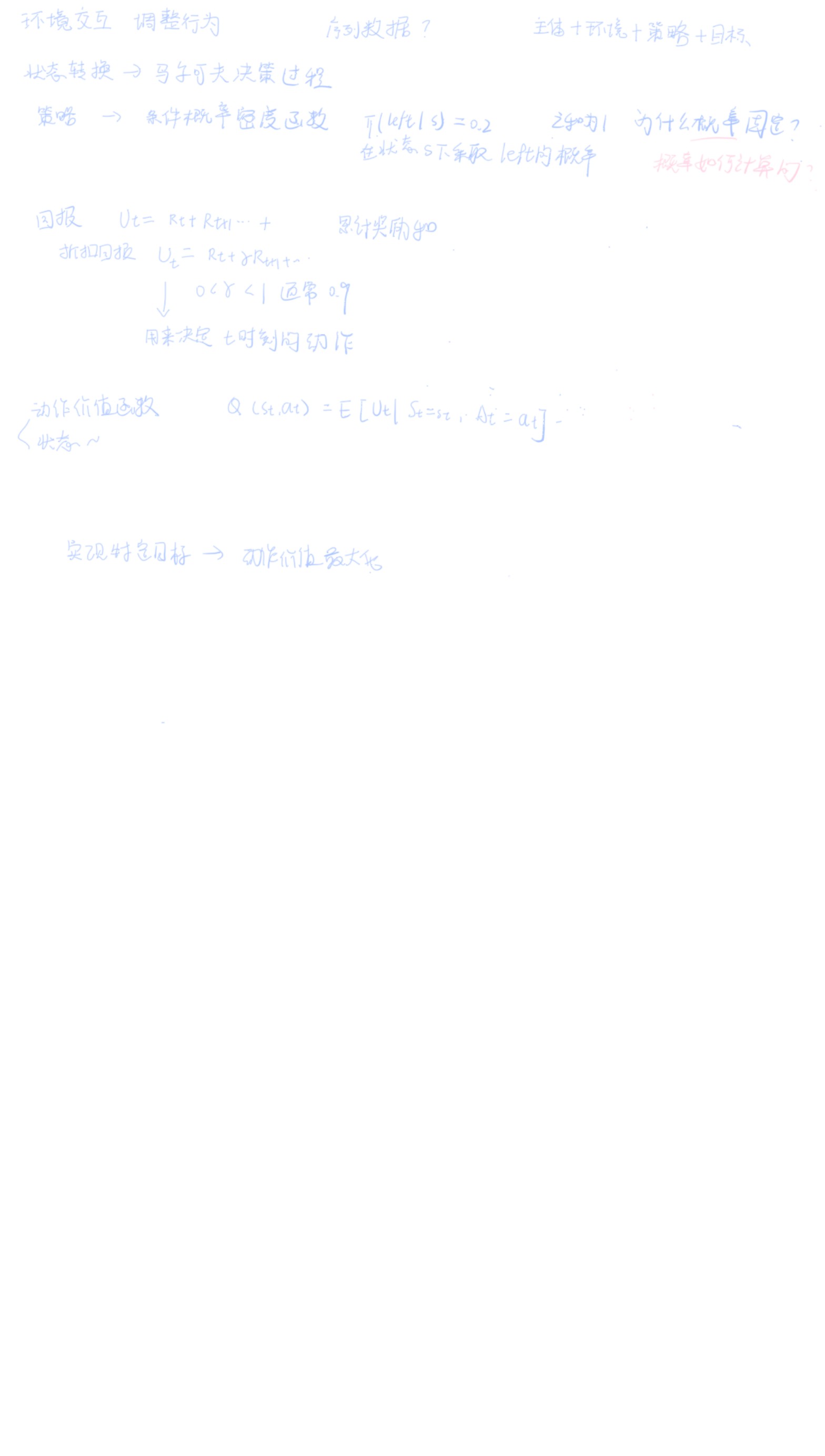

10.強化學習

11.概率圖模型

獨立同分布

獨立指的是,樣本集包括訓練集測試集的任意兩個樣本之間都是不相關的。在表示樣本的特征確定后,訓練樣本集的分布是具體而確定的,成為基于訓練樣本的分布;樣本全集,如果能夠獲取的話(通常無法獲取),也對應著一個具體而確定的分布,稱為基于樣本全集的分布,同分布就是基于訓練樣本集的分布與基于樣本全集的分布完全相同

2.半監督學習

訓練數據中一部分有標簽(xi,yi),一部分無標簽(xj),學習一個映射f:X->Y

預測數據(xt)

未標記數據的優點:優化決策邊界,提升泛化能力

假設

所有的無標記數據都屬于有標記數據中的某一類

1.光滑性假設,如果高密度區域兩個點x1x2很接近,那么相應輸出y1y2很接近

2.聚類假設:如果在同一個簇中,很可能為同一類

3.流形假設:高維數據大致位于低維流形上,如果高維中屬于一個類,那么低維也屬于一個類

常見方法

自訓練

1.假設:具有高置信度的預測是正確的

2.過程

用已有的有標記數據(xi,yi)訓練f,預測未標記(xu,f(xu)),將預測的未標記數據加入已標記數據,繼續訓練,預測再加入

(全部加入|基于置信度分配權重全部加入|少量最自信的加入)

3.優點

易于理解

框架性思路:自訓練+各種機器學習算法

4.缺點

對初始模型質量敏感

對數據分布敏感

偽標簽錯誤累加

協同訓練

1.假設

單獨使用單個視圖的數據可以訓練一個好的分類器

不同視圖數據相互獨立

2.過程?

兩個分類器f1,f2

分別對無監督數據標記,f1分類最自信的k個加入f2中,f2的加入f1中

3.優點?

互補信息

框架性思路

與自訓練相比,對錯誤的偽標記不太敏感

4.缺點

在某些任務中不一定有多視圖條件

5.風格

劃分特征|劃分數據集|劃分模型

6.擴展

兩個視角->三個視角

一致性正則化

1.數據增強

圖片旋轉裁剪放大縮小等

2.PI模型

輸入有標簽xi,無標簽xu,進行隨機數據增強,經過神經網絡模型,計算損失(監督損失+無監督損失(無標簽數據增強前后))

3.優點

使用簡單

對噪音不敏感

4.缺點

訓練時間長,效率低

3.無監督學習

最小化無監督損失函數

(k均值:樣本間的相似度集|主成分分析:信息損失|自編碼器:重構誤差)

方法

K-means

1.過程

隨機初始化k個點

計算其他數據點到這個k個的距離,選最近的中心點作為數據所在簇

在一個中心點的一個簇內,重新計算中心點的位置

重復n次

2.缺點

對初始點敏感

對噪聲敏感

3.k-means++

初始化k個點的時候

先隨機初始化一個中心點,算其他數據點離中心點的距離D(xi),選最遠的點作為新的中心點加入,繼續計算,直到得到k個中心點

主成分分析

自編碼器

4.度量學習

方法

線性判別分析

最大化類間距離,最小化類內距離

深度度量學習

5.遷移學習

6.多標記多示例學習

單標記多示例

多標記單示例,包

7.在線學習

全信息在線學習,知道損失函數

只知道回報,老虎機

8.元學習

學習很多任務,元學習器,針對每個任務優化,每個任務最后驗證的損失優化外層的參數

9.聯邦學習

信息加密,串行并行

10.強化學習

11.概率圖模型

貝葉斯

貝葉斯平均

基于后驗概率的預測

)

:Dify 的核心組件 —— 從節點到 RAG 管道)

)

簡介與簡單示例)

)