為什么這次開放值得關注?

OpenAI 時隔六年再次“放權重”,一次性公布 gpt-oss-120b 與 gpt-oss-20b 兩個尺寸,并允許商業化二次開發 —— 采用 Apache 2.0 許可且可直接在 Hugging Face 下載(WIRED)。官方表示,開放旨在 降低門檻、擴大安全研究樣本,同時給社區更大的定制自由(WIRED)。

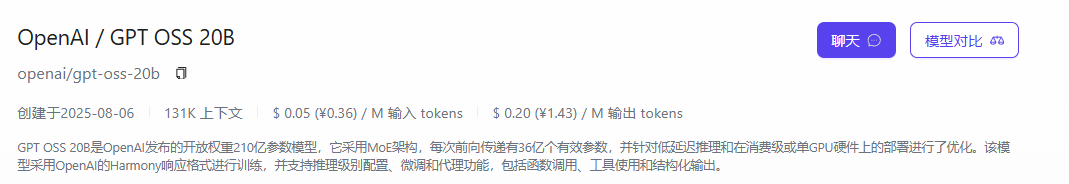

一、發布概覽:首次開源級權重釋放

-

雙版本:gpt-oss-120b(≈117 B 參數、36 層 MoE)與 gpt-oss-20b(≈21 B 參數、24 層),全部模型權重可自由下載。OpenAI

-

許可證:兩款模型均采用 Apache 2.0,允許商業部署、再分發及二次微調,無需回饋源代碼。WIRED

-

開放意義:這是 OpenAI 自 GPT-2 以來首度開放主流語言模型權重,意在降低開發門檻、鼓勵社區安全研究與定制化創新。WIRED

二、性能:小體積對標中端專有模型

| 關鍵基準 | gpt-oss-120b | gpt-oss-20b | 對比參考 |

| 復雜推理 (MMLU) | ≈ o4-mini 同級 | ≈ o3-mini 同級 | 競品 LLAMA 4 |

| 競賽數學 (AIME 2024/25) | 超越 o4-mini | 逼近 o3-mini | – |

| 代碼能力 (Codeforces) | 追平 o4-mini | 超過 o3-mini | – |

官方評測顯示,120B 版在推理、代碼、健康問答等任務上可與 o4-mini 持平或小幅領先;20B 版則在 16 GB 消費級 GPU 上跑出 o3-mini 級成績,適合邊緣部署與本地迭代。OpenAIReuters

三、部署與成本:單卡即可落地

-

硬件需求:120B 版在 80 GB GPU 即可單卡推理;20B 版僅需 16 GB 顯存即可桌面級運行。OpenAIReuters

-

效率設計:MoE 架構僅激活 3.6–5.1 B 活躍參數,配合 MXFP-4 量化,顯著降低顯存占用與功耗。Hugging Face

-

多場景可用:OpenAI 與 Azure、Hugging Face、vLLM、llama.cpp 等生態已完成適配,開發者可一鍵部署。OpenAI

四、安全基線與風險緩解

-

安全訓練:在 RLHF 階段加入“最壞情況微調”測試,并通過 OpenAI Preparedness Framework 審核,未觸達到高風險閾值。OpenAI+1

-

公開紅隊挑戰:OpenAI 同步啟動 50 萬美元賞金計劃,鼓勵社區發現潛在濫用路徑。OpenAI

-

開發者須知:開權重意味著您必須自行加裝內容過濾、速率限制與監控,才能復現 API 級安全防護。OpenAI

五、授權細節與合規要點

| 條款 | Apache 2.0 要點 | 對開發者影響 |

| 商用許可 | 可商業化、閉源發行,無版稅 | 直接嵌入自家產品或服務 |

| 責任聲明 | 免除作者責任,用戶自擔風險 | 部署方需承擔合規審核 |

| 變更與分發 | 允許修改、再分發 | 可結合私有數據微調后再出售 |

與 CC BY-SA、GPL 等“傳染式”協議不同,Apache 2.0 沒有代碼開源義務,是當前最寬松的 LLM 許可證之一。

六、快速上手的兩條典型路徑

1.自建 —— 適合已有 GPU 資源的團隊:

-

使用 vLLM + TensorRT-LLM 加速 MoE 路由。

-

按需啟用 4-bit 量化,16 GB 卡亦可推理 20B。

2.托管 —— 不想運維集群?可直接接入國內多云算力聚合平臺。

-

例如 勝算云 提供“一鍵 Key” 統一調用 GPT-OSS 與百余款模型;

-

智能路由與秒級彈性調度,實踐中 模型算力成本可削減至自建的 50 % – 80 %。

-

對初創團隊意味著 零預租、隨用隨付,也能在峰值并發下保持低延遲體驗。

GPT-OSS 120B / 20B API 快速調用示例:

打開VS Code——搜索Cline-中文版或Cline-Chinese——按照插件點擊獲取API——完成注冊自動填入API——選擇GPT-OSS 120B / 20B.

結語

GPT-OSS 的開放讓“可重訓練、可私有化”的高性能語言模型正式進入主流視野。無論你是打算在消費級設備上跑 20B,還是需要大型生產環境的 120B,趁著 Apache 2.0 的寬松條款與成熟的云端生態,把握窗口期,才是抓住下一輪 AI 創新的關鍵。如果想省去運維、聚焦業務邏輯,像勝算云這類聚合平臺也為“開權重”時代提供了更輕盈的落地選項。

)

)

)

--計數排序,排序算法復雜度對比和穩定性分析)

)

)

:繪圖)