#作者:stackofumbrella

文章目錄

- 一、Ceph集群的OSD基礎操作

- 查看osd的ID編號

- 查看OSD的詳細信息

- 查看OSD的狀態信息

- 查看OSD的統計信息

- 查看OSD在主機上的存儲信息

- 查看OSD延遲的統計信息

- 查看各個OSD使用率

- 集群暫停接收數據

- 集群取消暫停

- OSD寫入權重操作

- 查看默認OSD操作權重值

- 修改OSD數據操作權重值

- OSD上下線

- 臨時關閉OSD會自動被拉起

- 永久關閉

- 驅逐OSD設備

- 將驅逐的OSD設備加入到集群

- 二、Ceph集群的OSD節點縮容

- OSD縮容實戰案例

- 查看集群OSD狀態

- 停止需要下線節點的所有OSD守護進程

- 清理OSD數據和配置

- 移除所有OSD后從CRUSH map中刪除主機

- 自動驅逐被下線節點的服務組件

- OSD設備無法清除,只能通過手動刪除

- 刪除節點

- 解除ceph對磁盤的占用(在OSD節點上執行)

- OSD擴容實戰案例

- 將上面剔除的節點添加到集群

- 擦除磁盤的原有數據

- 出現此報錯需要到ceph03節點上執行擦除命令

- 在管理節點上再次擦除磁盤

- 查看設備

- 添加OSD到集群

一、Ceph集群的OSD基礎操作

查看osd的ID編號

$ sudo ceph osd ls

查看OSD的詳細信息

$ sudo ceph osd dump

查看OSD的狀態信息

$ sudo ceph osd status

查看OSD的統計信息

$ sudo ceph osd stat

查看OSD在主機上的存儲信息

$ sudo ceph osd stat

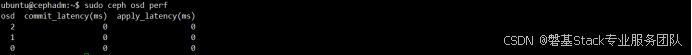

查看OSD延遲的統計信息

$ sudo ceph osd perf

查看各個OSD使用率

$ sudo ceph osd df

集群暫停接收數據

$ sudo ceph osd pause

集群取消暫停

$ sudo ceph osd unpause

OSD寫入權重操作

查看默認OSD操作權重值

$ sudo ceph osd crush tree

修改OSD數據操作權重值

$ sudo ceph osd crush reweight osd.2 0

OSD上下線

由于OSD有專門的管理服務器ceph-osd控制,一旦發現被下線會嘗試啟動它。

如果真的想要永久關閉,則需要關閉對應的ceph-osd進程即可。

臨時關閉OSD會自動被拉起

$ sudo ceph osd down 2;sudo ceph osd tree

然后會自動重啟

永久關閉

$ sudo ceph orch daemon stop osd.2;sudo ceph osd tree

驅逐OSD設備

驅逐關掉的osd.2,驅逐的本質是對ceph集群數據操作的權重值REWEIGHT重新調整

$ sudo ceph osd out 2

$ sudo ceph osd tree

將驅逐的OSD設備加入到集群

$ sudo ceph osd in 2

$ sudo ceph orch daemon start osd.2;sudo ceph osd tree

二、Ceph集群的OSD節點縮容

OSD縮容實戰案例

查看集群OSD狀態

$ sudo ceph osd tree

停止需要下線節點的所有OSD守護進程

$ sudo ceph orch daemon stop osd.2

$ sudo ceph osd tree

清理OSD數據和配置

$ sudo ceph osd purge 2 --force

$ sudo ceph osd tree

移除所有OSD后從CRUSH map中刪除主機

$ sudo ceph osd crush rm ceph03

$ sudo ceph osd tree

自動驅逐被下線節點的服務組件

$ sudo ceph orch host drain ceph03

OSD設備無法清除,只能通過手動刪除

$ sudo ceph orch daemon rm osd.2 --force

$ sudo ceph orch host drain ceph03

刪除節點

$ sudo ceph orch host rm ceph03

$ sudo ceph orch host ls

解除ceph對磁盤的占用(在OSD節點上執行)

$ lsblk

$ sudo dmsetup remove ceph–e16939c6–b24f–4e87–b6bd–ca4ddd1dffee-osd–block–b995ab08–d360–4a51–b750–fb193edcba4e

$ lsblk

OSD擴容實戰案例

將上面剔除的節點添加到集群

$ sudo ceph orch host add ceph03

擦除磁盤的原有數據

$ sudo ceph orch device zap --force ceph03 /dev/vdb

出現此報錯需要到ceph03節點上執行擦除命令

$ sudo wipefs -af /dev/vdb

在管理節點上再次擦除磁盤

$ sudo ceph orch device zap --force ceph03 /dev/vdb

查看設備

$ sudo ceph orch device ls

添加OSD到集群

$ sudo ceph orch daemon add osd ceph03:/dev/vdb

$ sudo ceph osd tree

)

)

)

)

no cameras available,完美解決)

)