《人工智能指數報告》由斯坦福大學、AI指數指導委員會及業內眾多大佬Raymond Perrault、Erik Brynjolfsson 、James Manyika、Jack Clark等人員和組織合著,旨在追蹤、整理、提煉并可視化與人工智能(AI)相關各類數據,該報告已被大多數媒體及機構公認為最權威、最具信譽的人工智能數據與洞察來源之一。2024年版《人工智能指數報告》是迄今為止最為詳盡的一份報告,包含了前所未有的大量原創數據。

報告一共分為九個章節,一共502頁,后續請關注“魯班模錘“一起深入探究。章節回目如下:

第一章節:研究與發展

基礎模型

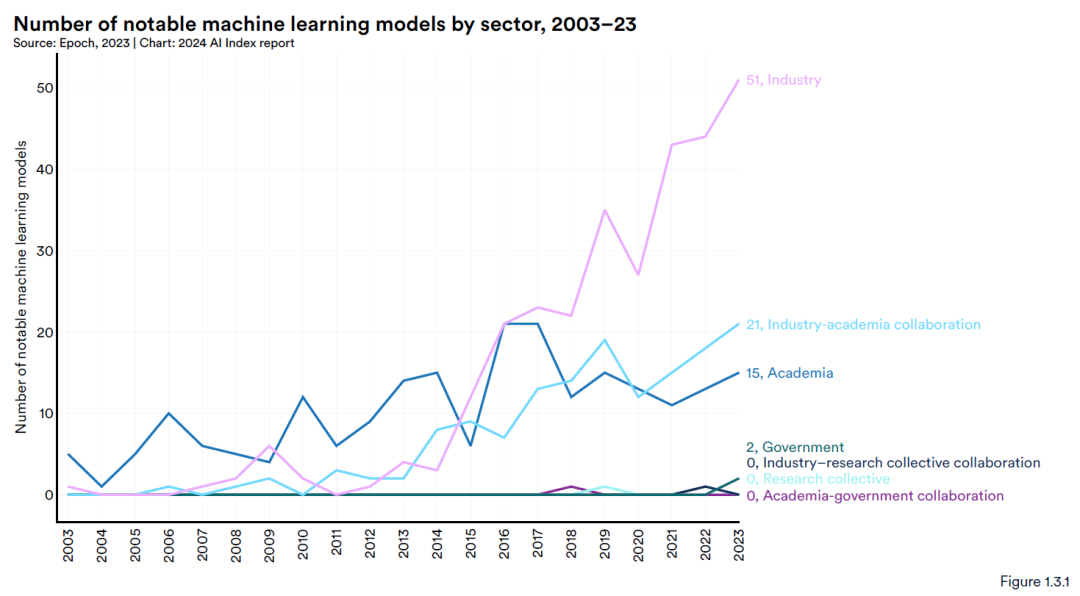

工業界整體而言繼續主導前沿人工智能研究。2023年,工業界發布了51個機器學習模型,而學術界只貢獻了15個。2023年產學研合作創歷史新高,發布21個著名模型。如今,創建前沿AI模型需要大量的數據、計算能力和資金資源,這些都是學術界所不具備的。例如,GPT-4大概花費了7800萬美元,而Google的Gemini大概花費了1.9億美元。

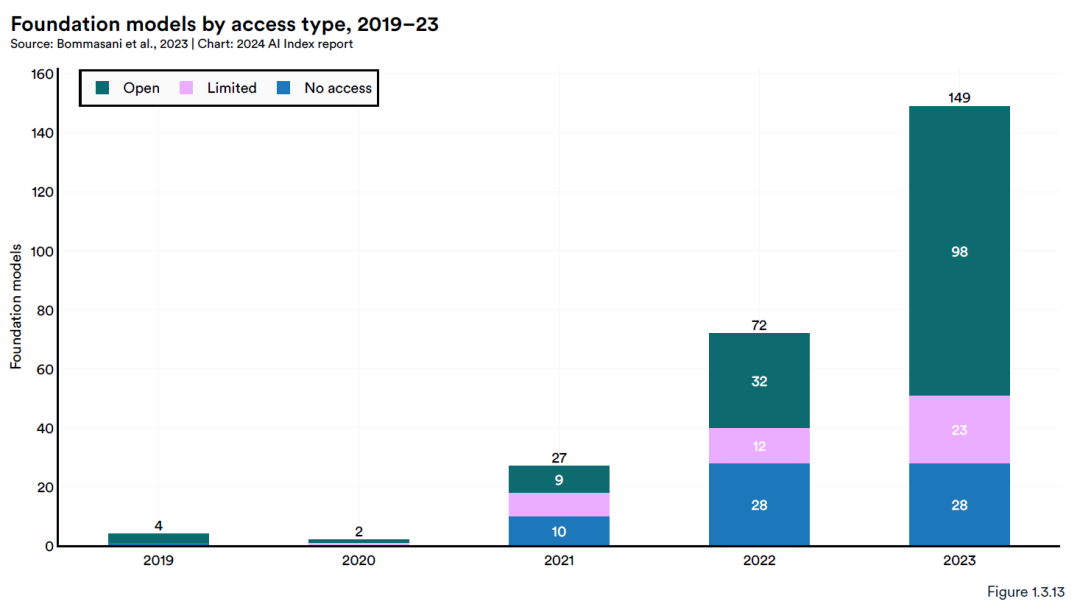

2023年,總共發布了149個基礎模型,是2022年發布數量的兩倍多。在這些新發布的模型中,65.7%是開源的,而2022年和2021年分別只有44.4%和33.3%。近年來,基礎模型的數量急劇上升,自2022年以來翻了一番多,自2019年以來增長了近38倍。在2023年發布的149個基礎模型中,98個為開放訪問。

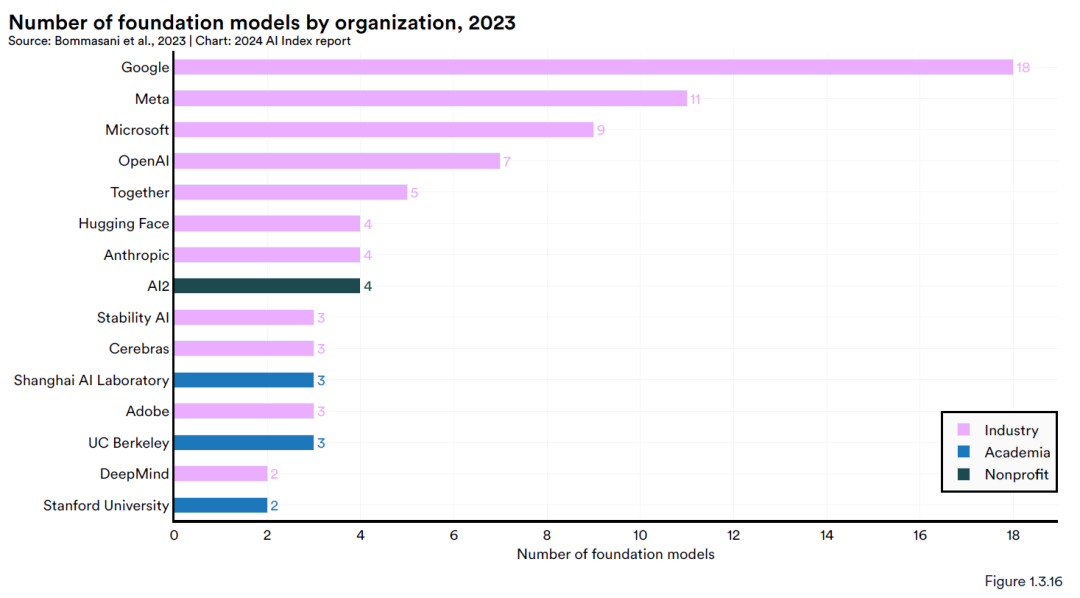

開源的基礎模型,谷歌推出了最多的模型(18個),其次是Meta(11個)和微軟(9個)。在2023年發布基礎模型最多的學術機構是加州大學伯克利分校(3個)。

|

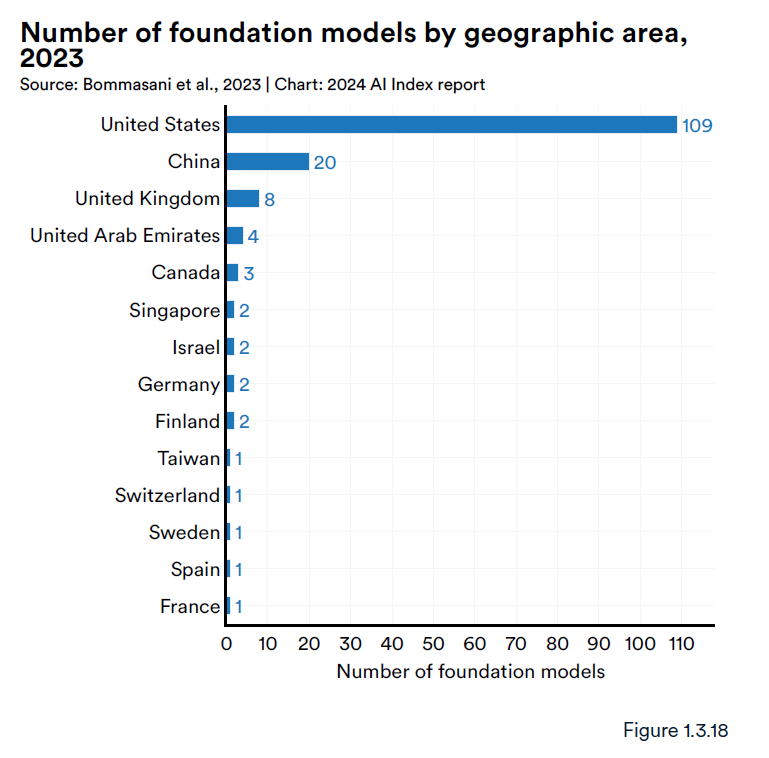

| 2023年,世界上大多數基礎模型來自美國(109個),其次是中國(20個)和英國。自2019年以來,美國一直保持著主導地位。 |

算力與成本

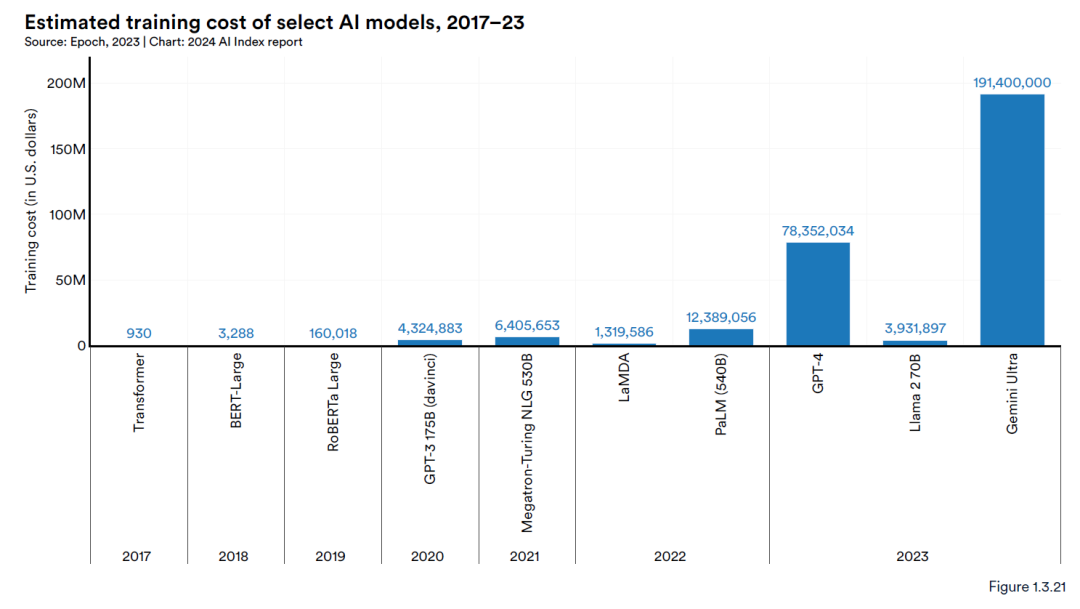

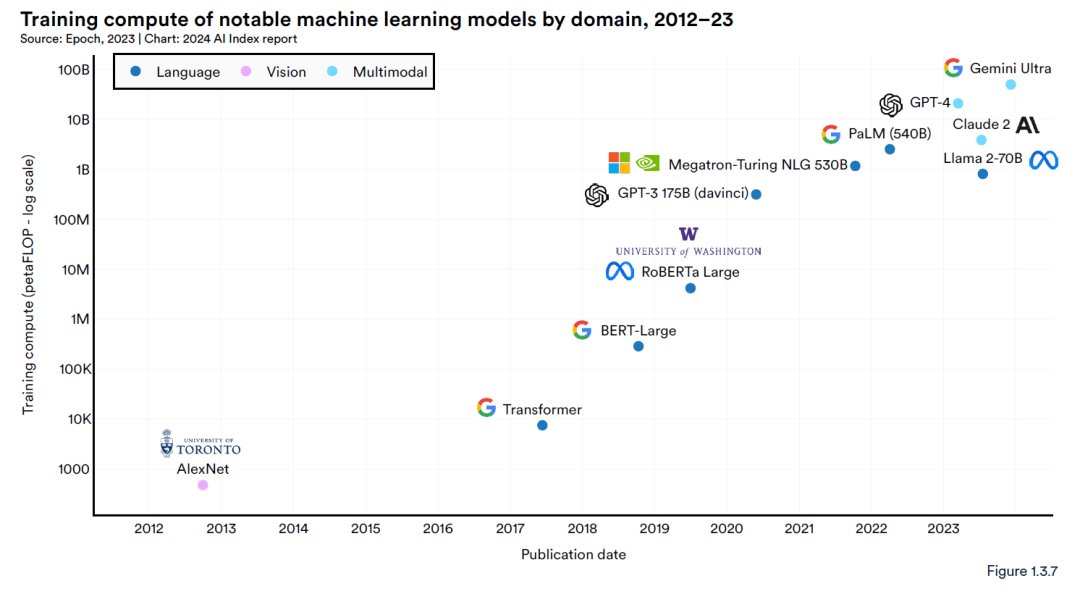

根據人工智能指數的估計,最先進的人工智能模型的培訓成本已經達到了前所未有的水平。AI指數的估計證實了近年來模型訓練成本顯著增加的猜測。例如,2017年,引入了支撐幾乎所有現代LLM架構的原始Transformer模型,其訓練成本約為900美元。2019年發布的RoBERTa Large在許多經典理解基準測試(如SQuAD和GLUE)上取得了最先進的成果,其訓練成本約為16萬美元。快進到2023年,OpenAI的GPT-4和Google的Gemini Ultra的訓練成本分別約為7800萬美元和1.91億美元。

自 2012 年以來著名機器學習模型的訓練計算。例如較早的AlexNet需要 470 PFLOP 進行訓練。2017年發布的Transformer需要大約 7,400PFLOP。谷歌的 Gemini Ultra是目前最先進的基礎模型之一,所需算力直接到達500億 PFLOP。

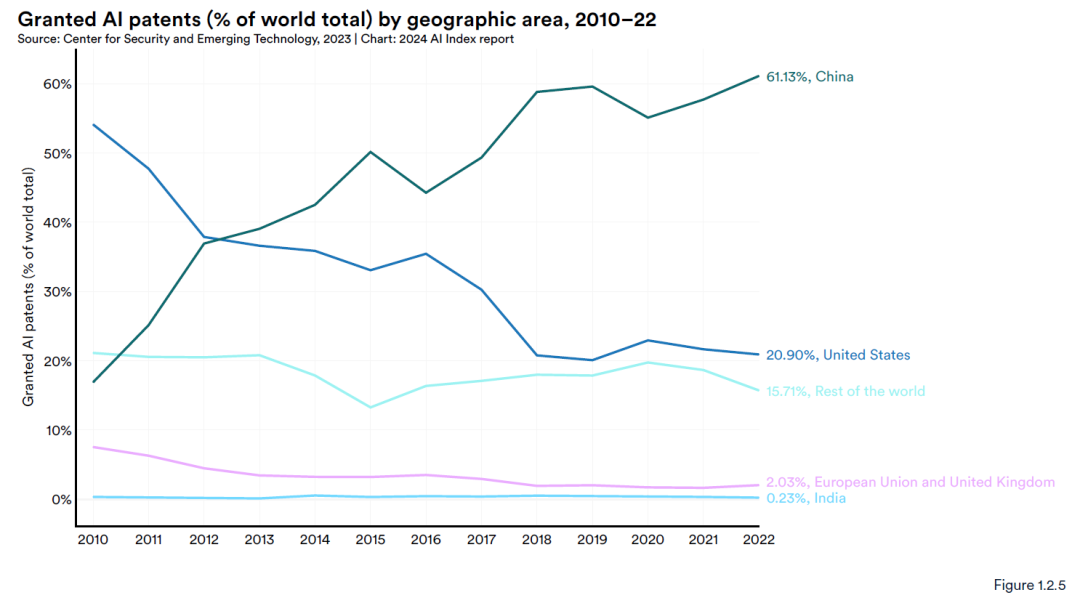

專利

從2021年到2022年,全球人工智能專利授權增加大幅上升62.7%。自2010年以來,獲得授權的人工智能專利數量增長了31倍以上。中國在AI專利領域占據主導地位。

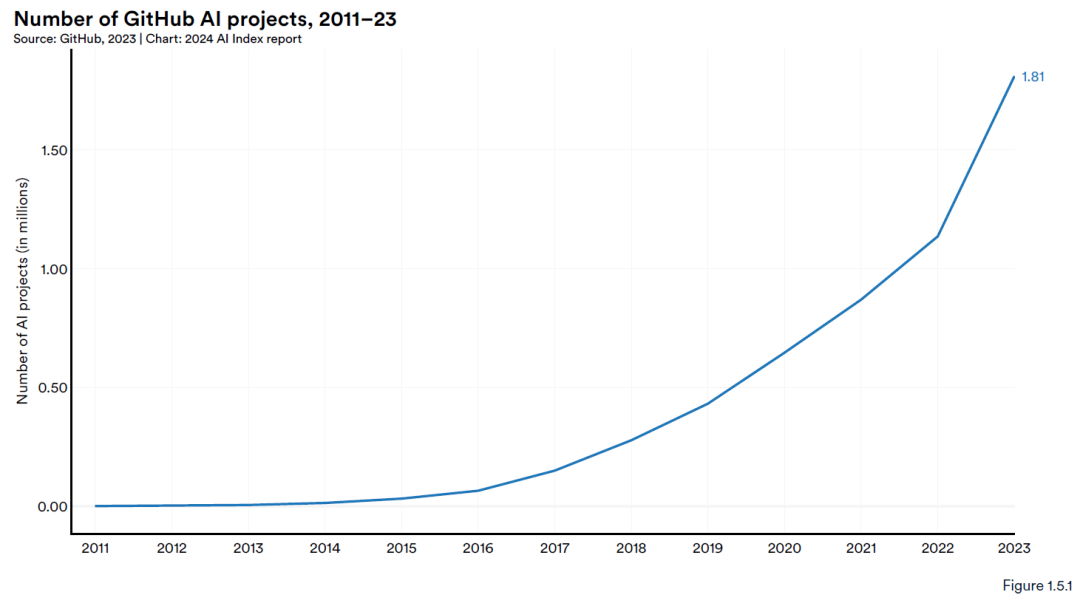

開源技術

自2011年起,GitHub上與AI相關的項目數量持續增長,從2011年的845個增至2023年的約180萬個。尤為顯著的2023,GitHub人工智能項目的總數就急劇增長了59.3%。

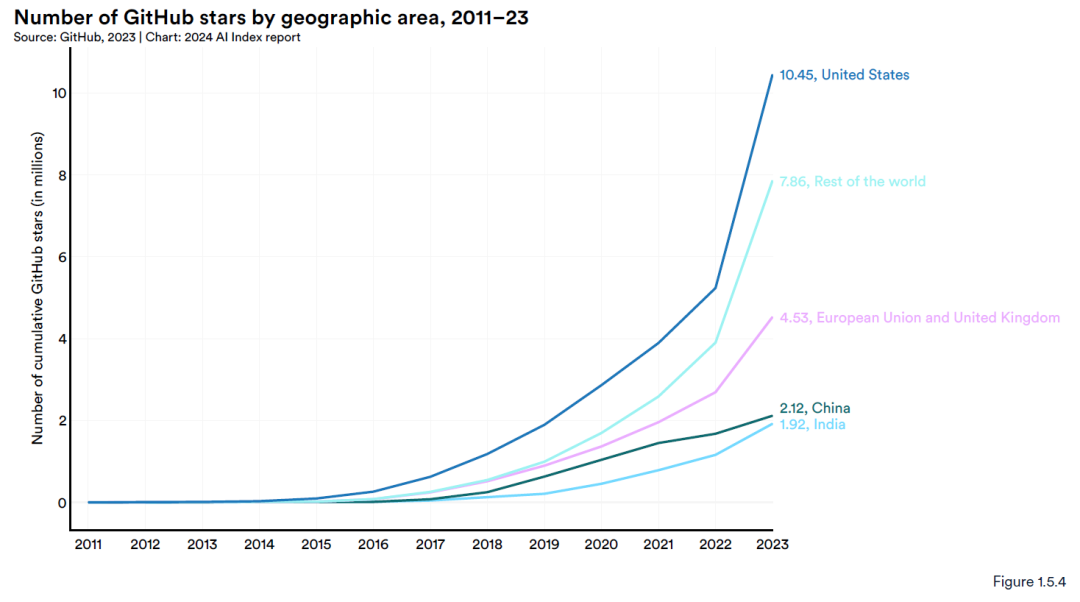

2023 年,美國在獲得 GitHub 星星數量最多的國家中處于領先地位,總數為 1050 萬。所有主要地理區域,包括歐盟和英國、中國和印度,授予其所在國家/地區的項目的 GitHub 星級總數均同比增加。

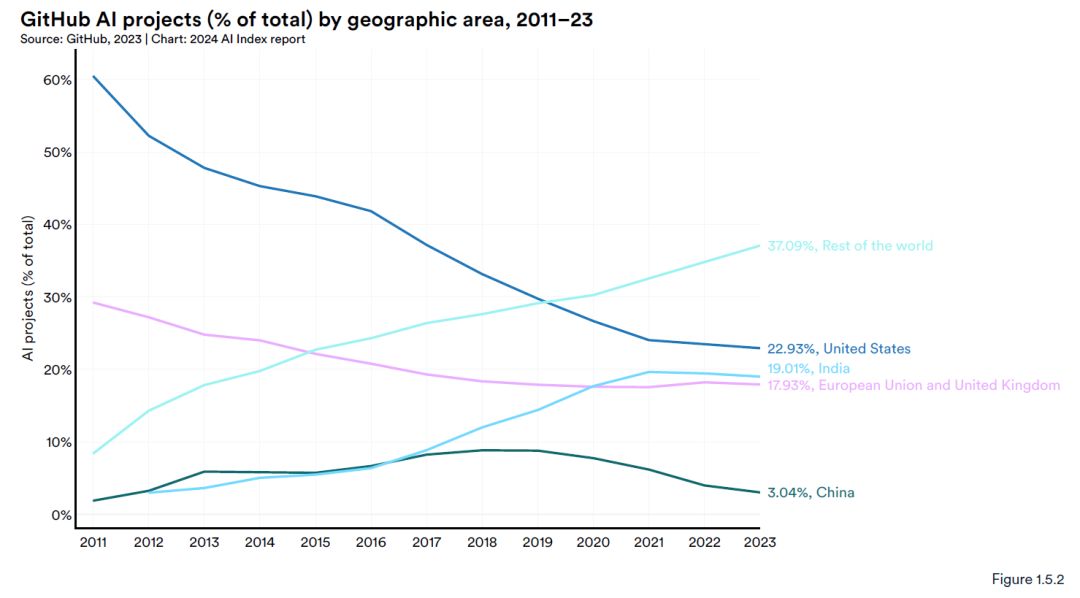

截至 2023 年,GitHub AI項目主要來至美國,印度為第二大貢獻者。值得深究的是自2016 年以來,來自美國的項目比例一直在穩步下降。

圖書出版

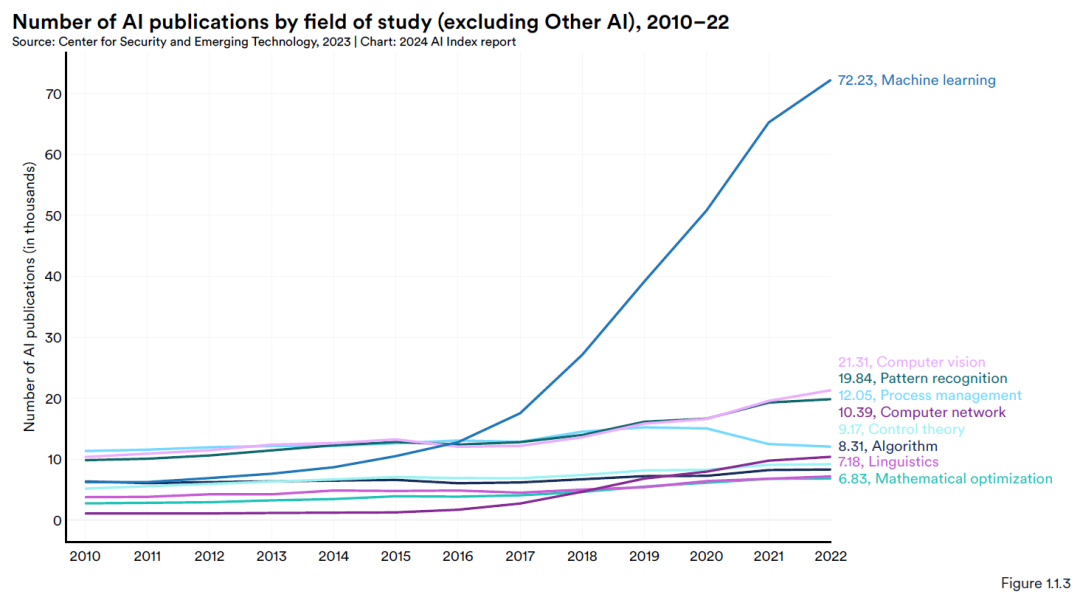

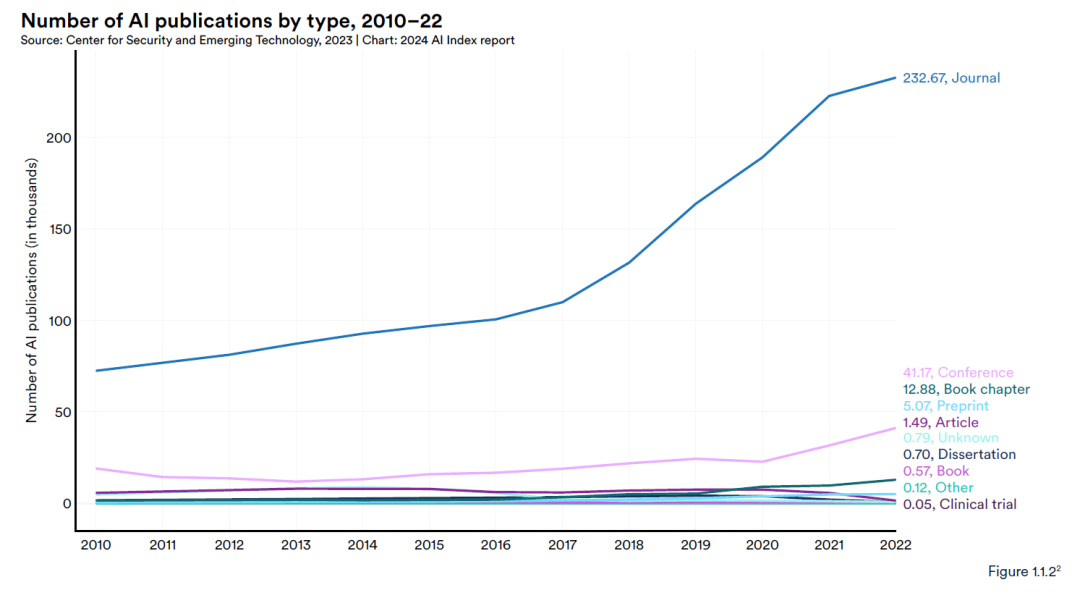

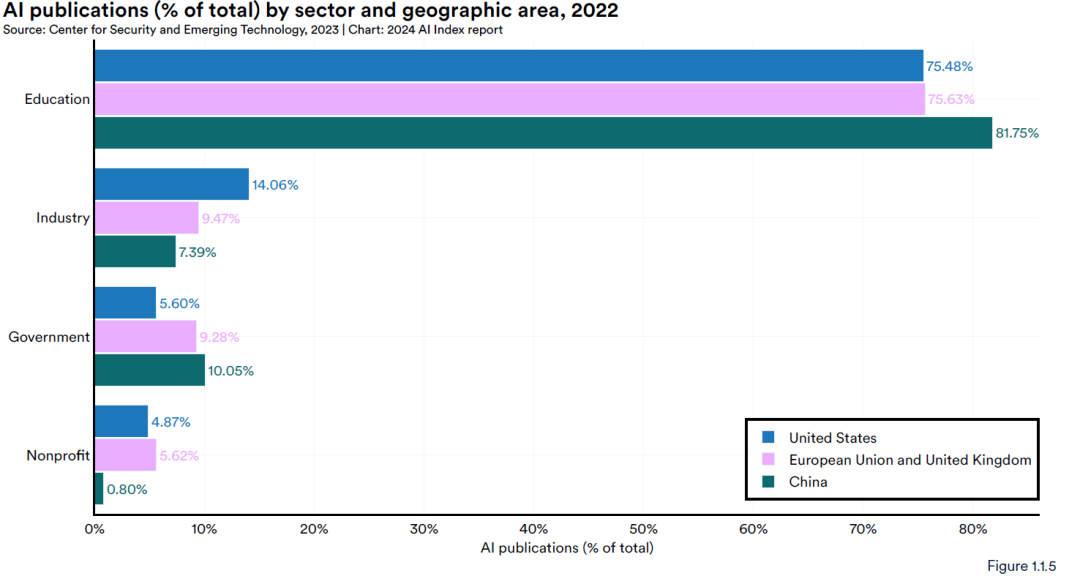

2010年至2022年間,人工智能出版物總量幾乎翻了兩番,從2010年的約8.8萬篇增至2022年的超過24萬篇。大部分的出版主題圍繞著機器學習,依托雜志,用于教學培訓。

數據處理)

【中等 前綴和數組+動態規劃 Java/Go/PHP/C++】)

)

)