一、MHA概述

- MHA(MasterHigh Availability)是一套優秀的mysql高可用環境下故障切換和主從復制的軟件。

- MHA的出現就是為了解決mysql單點故障。

- Mysql故障切換過程中,MHA能做到0-30秒內自動完成故障性切換操作。

- MHA能在故障切換的過程中最大程度保證數據的一致性,已達到真正意義上的高可用。

使用的是MHA保證主從復制中master的高可用,解決單點故障

使用MMM保證雙主雙從的高可用

1.1 MHA 的組成

MHA Node(數據節點)

MHA Node 運行在每臺 MySQL 服務器上。

Node功能:在發生故障時,盡可能的保存二進制日志,并且實現故障切換(VIP地址飄逸)

MHA Manager(管理節點)

MHA Manager 可以單獨部署在一臺獨立的機器上,管理多個 master-slave 集群;也可以部署在一臺 slave 節點上。MHA Manager 會定時探測集群中的 master 節點。當 master 出現故障時,它可以自動將最新數據的 slave 提升為新的 master, 然后將所有其他的 slave 重新指向新的 master。整個故障轉移過程對應用程序完全透明。

Manager功能:做MHA啟動、關閉管理和檢測MySQL健康狀態

1.2 MHA 的特點

- 自動故障切換過程中,MHA試圖從宕機的主服務器上保存二進制日志,最大程度的保證數據不丟失

- 使用半同步復制,可以大大降低數據丟失的風險,如果只有一個slave已經收到了最新的二進制日志,MHA可以將最新的二進制日志應用于其他所有的slave服務器上,因此可以保證所有節點的數據一致性

- 目前MHA支持一主多從架構,最少三臺服務,即一主兩從

1.3 MHA的工作原理

- 從宕機崩潰的master保存二進制日志事件(binlog events);

- 識別含有最新的更新slave 日志;

- 應用差異的中繼日志(relay log)到其他的slave;

- 應用從master保存的二進制日志事件;

- 提升一個slave為新的master;

- 使其他的slave連接新的master進行復制;

MHA有兩個節點,一個是MHA Node數據節點,運行在每臺MySQL服務器上。

一個是MHA Manager ,它可以定時探測集群中的主服務器。當主服務器出現故障時,它就會挑選最新數據的從服務器成為新的主服務器,然后其它從服務器重新指向新的主服務器做主從復制,并且主服務器會生成新的VIP。然后客戶端會通過VIP訪問新的主服務器。

1.4 故障切換時MHA會做什么

MHA會多次嘗試檢測master的存活狀態

MHA會多次嘗試盡可能地保存master的二進制日志

MHA會根據app1.cnf中的配置部分,進行從服務器切換到主服務器位置

MHA最后會將master的VIP地址切換到從服務器的位置

MHA在選擇完新的master之后,會在其余的slave上執行change master操作,指向新的master來保證MySQL的集群的健康

二、搭建MySQL+MHA

2.1 實驗思路

①.MHA架構

數據庫安裝、一主兩從、MHA搭建。

②.故障模擬

模擬主數據庫失效

備選庫成為主庫

原故障主庫恢復重新加入到MHA成為從庫

2.2 實驗環境、安裝包

MHA manager 節點服務器:CentOS7.4(64 位) manager/192.168.154.14 ,安裝MHA node 和 manager 組件

Master 節點服務器:CentOS7.4(64 位) mysql1/192.168.154.10 ,安裝mysql5.7、MHA node 組件

Slave1 節點服務器:CentOS7.4(64 位) mysql2/192.168.154.11 ,安裝mysql5.7、MHA node 組件

Slave2 節點服務器:CentOS7.4(64 位) mysql3/192.168.154.12 ,安裝mysql5.7、MHA node 組件

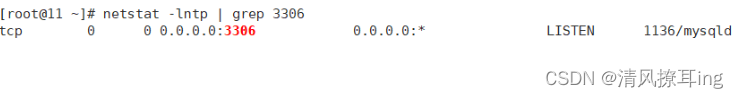

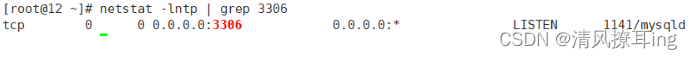

netstat -lntp | grep 3306

2.3 服務搭建

2.3-1 所有服務器掛壁防火墻和安全增強

systemctl stop firewalld

systemctl disable firewalld

setenforce 02.3-2 修改 Master、Slave1、Slave2 節點的主機名

hostnamectl set-hostname Mysql1

hostnamectl set-hostname Mysql2

hostnamectl set-hostname Mysql32.3-3 修改三臺MySQL服務器主配置文件/etc/my.cnf

master(192.168.154.10)

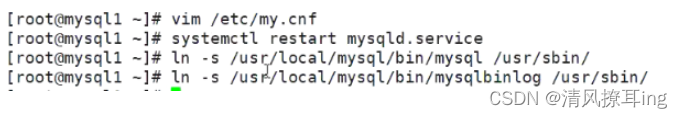

vim /etc/my.cnf

[mysqld]

server-id = 1

log_bin = master-bin

log-slave-updates = truesystemctl restart mysqldln -s /usr/local/mysql/bin/mysql /usr/sbin/

ln -s /usr/local/mysql/bin/mysqlbinlog /usr/sbin/

slave1(192.168.154.11),slave2 (192.168.154.12)

vim /etc/my.cnf

server-id = 2 ?

#server-id = 3 ?mysql3則為3,三臺服務器 server-id 不能一樣

log_bin = master-bin

relay-log = relay-log-bin

relay-log-index = slave-relay-bin.indexsystemctl restart mysqld

ln -s /usr/local/mysql/bin/mysql /usr/sbin/

ln -s /usr/local/mysql/bin/mysqlbinlog /usr/sbin/

2.3-4 配置MySQL一主兩從

192.168154.10、192.168154.11、192.168154.12

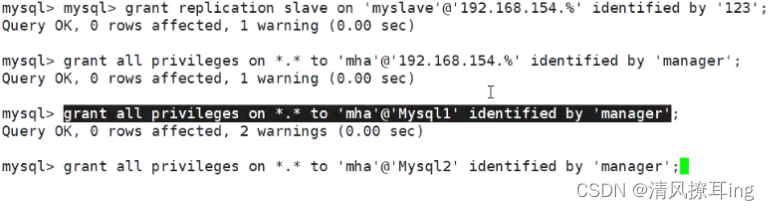

#所有數據庫節點進行 mysql 授權

#192.168154.10、192.168154.11、192.168154.12一主兩從都要配

mysql -uroot -p

grant replication slave on *.* to 'myslave'@'192.168.154.%' identified by '123';?? ??? ?#從數據庫同步使用

grant all privileges on *.* to 'mha'@'192.168.154.%' identified by 'manager';?? ??? ?#manager 使用grant all privileges on *.* to 'mha'@'Mysql1' identified by 'manager';?? ??? ??? ??? ?#防止從庫通過主機名連接不上主庫

grant all privileges on *.* to 'mha'@'Mysql2' identified by 'manager';

grant all privileges on *.* to 'mha'@'Mysql3' identified by 'manager';

flush privileges;

在master節點上查看二進制文件和同步點

show master status;

#每個人的二進制文件名或者偏移量都可能不一樣,記住自己的

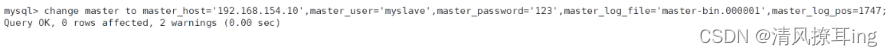

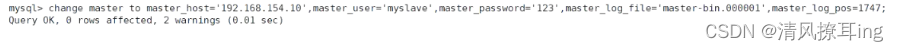

在slav1,slave2節點上開啟同步操作

#192.168.154.11及192.168.154.12

change master to master_host='192.168.154.10',master_user='myslave',master_password='123',master_log_file='master-bin.000001',master_log_pos=1747;?start slave;show slave status\G

測試兩臺從服務器 IO 和 SQL 線程都是 Yes,代表同步正常。

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

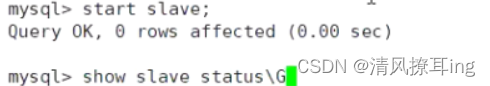

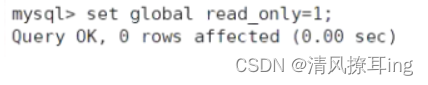

slave1、slave2節點設置為只讀模式

set global read_only=1;

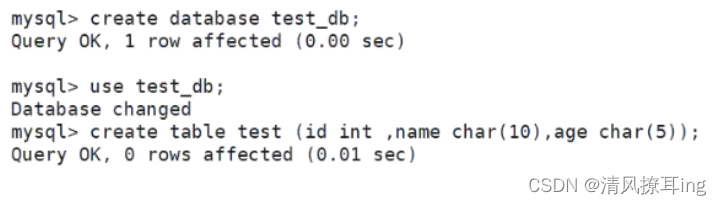

2.3-5 主從復制驗證

在主服務器 Master 主庫插入條數據,測試是否同步

兩臺從服務器都可以看的創建的庫及表

2.3-6 安裝MHA軟件

1、所有服務器上都安裝 MHA 依賴的環境,首先安裝 epel 源,需要在線源安裝

在所有服務器上安裝 node 組件

yum install epel-release --nogpgcheck -yyum install -y perl-DBD-MySQL \

perl-Config-Tiny \

perl-Log-Dispatch \

perl-Parallel-ForkManager \

perl-ExtUtils-CBuilder \

perl-ExtUtils-MakeMaker \

perl-CPAN1、對于每個操作系統版本不一樣,這里 CentOS7.4 必須選擇 0.57 版本。

2、在所有服務器上必須先安裝 node 組件,最后在 MHA-manager 節點上安裝 manager 組件,因為 manager 依賴 node 組件。

cd /opt

tar zxvf mha4mysql-node-0.57.tar.gz

cd mha4mysql-node-0.57

perl Makefile.PL

make && make install// MHA-manager 節點上安裝 manager 組件

cd /opt

tar zxvf mha4mysql-manager-0.57.tar.gz

cd mha4mysql-manager-0.57

perl Makefile.PL

make && make install

manager組件安裝后在/usr/local/bin下面會生成幾個工具,主要包括以下幾個:

- masterha_check_ssh 檢查 MHA 的 SSH 配置狀況

- masterha_check_repl 檢查 MySQL復制狀況

- masterha_manger 啟動 manager的腳本

- masterha_check_status 檢測當前 MHA運行狀態

- masterha_master_monitor 檢測 master 是否宕機

- masterha_master_switch控制故障轉移(自動或者手動)

- masterha_conf_host 添加或刪除配置的 server 信息

- masterha_stop 關閉manager

node 組件安裝后也會在/usr/local/bin 下面會生成幾個腳本(這些工具通常由 MHAManager 的腳本觸發,無需人為操作)主要如下:

- save_binary_logs 保存和復制 master 的二進制日志

- apply_diff_relay_logs 識別差異的中繼日志事件并將其差異的事件應用于其他的 slave

- filter_mysqlbinlog 去除不必要的 ROLLBACK 事件(MHA 已不再使用這個工具)

- purge_relay_logs 清除中繼日志(不會阻塞 SQL 線程)

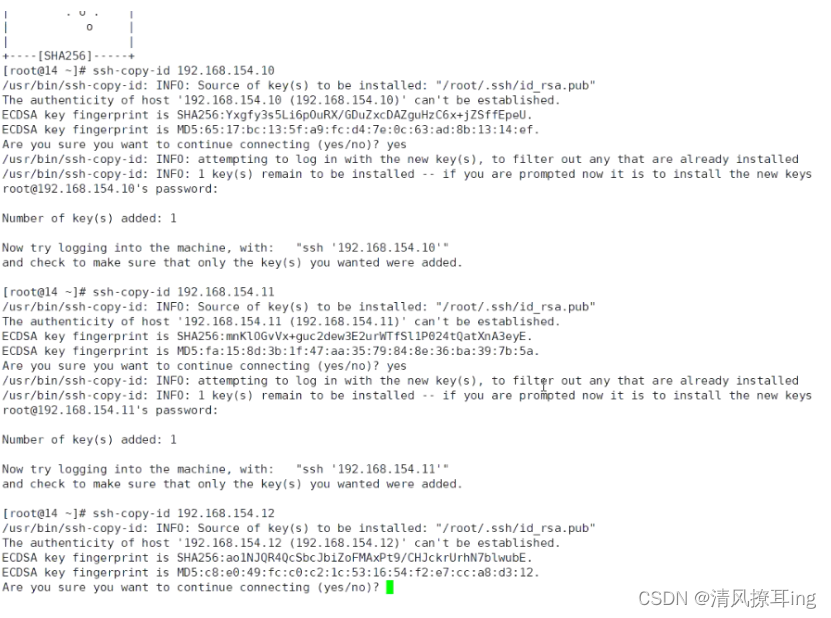

2.3-7 在所有服務器上配置免密認證

1、在manager(192.168154.10)節點上配置所有數據庫節點的免密認證

ssh-keygen -t rsa ?? ??? ??? ??? ?#一路按回車鍵

ssh-copy-id 192.168.154.10

ssh-copy-id 192.168.154.11

ssh-copy-id 192.168.154.12

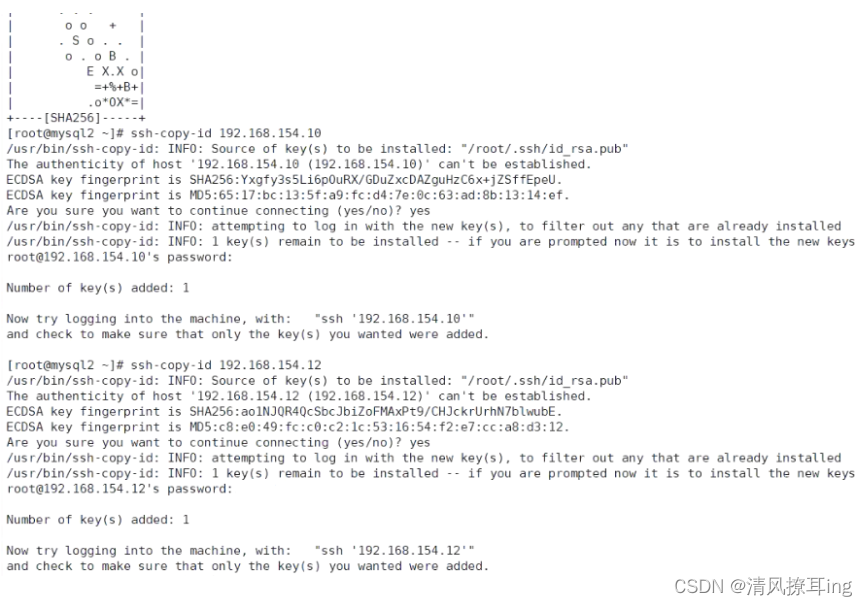

2、在 mysql1 上配置到數據庫節點 mysql2 和 mysql3 的無密碼認證

ssh-keygen -t rsa

ssh-copy-id 192.168.154.11

ssh-copy-id 192.168.154.12

3、在 mysql2 上配置到數據庫節點 mysql1 和 mysql3 的無密碼認證

4、在 mysql3 上配置到數據庫節點 mysql1 和 mysql2 的無密碼認證

ssh-keygen -t rsa

ssh-copy-id 192.168.154.10

ssh-copy-id 192.168.154.11

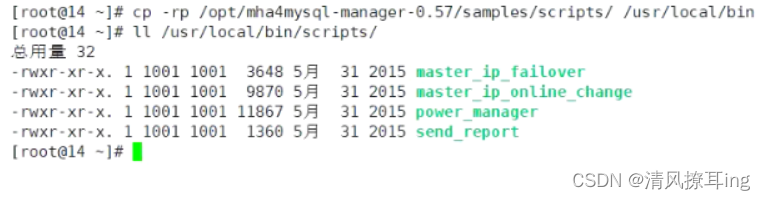

2.3-8 在manager上配置MHA

1、 在 manager 節點上復制相關腳本到/usr/local/bin 目錄

cp -rp /opt/mha4mysql-manager-0.57/samples/scripts /usr/local/bin

#拷貝后會有四個執行文件

ll /usr/local/bin/scripts/

master_ip_failover #自動切換時 VIP 管理的腳本

master_ip_online_change #在線切換時 vip 的管理

power_manager #故障發生后關閉主機的腳本

send_report #因故障切換后發送報警的腳本

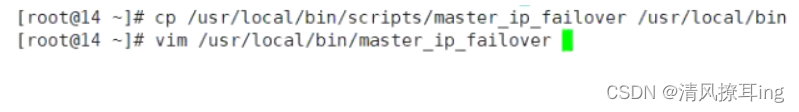

2、復制上述的自動切換時 VIP 管理的腳本到 /usr/local/bin 目錄,這里使用master_ip_failover腳本來管理 VIP 和故障切換

cp /usr/local/bin/scripts/master_ip_failover /usr/local/bin

vim /usr/local/bin/master_ip_failover 3、修改內容如下:(刪除原有內容,直接復制并修改vip相關參數。可在拷貝前輸入 :set paste 解決vim粘貼亂序問題)

3、修改內容如下:(刪除原有內容,直接復制并修改vip相關參數。可在拷貝前輸入 :set paste 解決vim粘貼亂序問題)

#!/usr/bin/env perl

use strict;

use warnings FATAL => 'all';use Getopt::Long;my (

$command, $ssh_user, $orig_master_host, $orig_master_ip,

$orig_master_port, $new_master_host, $new_master_ip, $new_master_port

);

#############################添加內容部分#########################################

my $vip = '192.168.154.200';?? ??? ??? ??? ??? ??? ??? ??? ??? ?#指定vip的地址

my $brdc = '192.168.154.255';?? ??? ??? ??? ??? ??? ??? ??? ?#指定vip的廣播地址

my $ifdev = 'ens33';?? ??? ??? ??? ??? ??? ??? ??? ??? ??? ?#指定vip綁定的網卡

my $key = '1';?? ??? ??? ??? ??? ??? ??? ??? ??? ??? ??? ??? ?#指定vip綁定的虛擬網卡序列號

my $ssh_start_vip = "/sbin/ifconfig ens33:$key $vip";?? ??? ?#代表此變量值為ifconfig ens33:1 192.168.154.200

my $ssh_stop_vip = "/sbin/ifconfig ens33:$key down";?? ??? ?#代表此變量值為ifconfig ens33:1 192.168.154.200 down

my $exit_code = 0;?? ??? ??? ??? ??? ??? ??? ??? ??? ??? ??? ?#指定退出狀態碼為0

#my $ssh_start_vip = "/usr/sbin/ip addr add $vip/24 brd $brdc dev $ifdev label $ifdev:$key;/usr/sbin/arping -q -A -c 1 -I $ifdev $vip;iptables -F;";

#my $ssh_stop_vip = "/usr/sbin/ip addr del $vip/24 dev $ifdev label $ifdev:$key";

##################################################################################

GetOptions(

'command=s' => \$command,

'ssh_user=s' => \$ssh_user,

'orig_master_host=s' => \$orig_master_host,

'orig_master_ip=s' => \$orig_master_ip,

'orig_master_port=i' => \$orig_master_port,

'new_master_host=s' => \$new_master_host,

'new_master_ip=s' => \$new_master_ip,

'new_master_port=i' => \$new_master_port,

);exit &main();sub main {print "\n\nIN SCRIPT TEST====$ssh_stop_vip==$ssh_start_vip===\n\n";if ( $command eq "stop" || $command eq "stopssh" ) {my $exit_code = 1;

eval {

print "Disabling the VIP on old master: $orig_master_host \n";

&stop_vip();

$exit_code = 0;

};

if ($@) {

warn "Got Error: $@\n";

exit $exit_code;

}

exit $exit_code;

}

elsif ( $command eq "start" ) {my $exit_code = 10;

eval {

print "Enabling the VIP - $vip on the new master - $new_master_host \n";

&start_vip();

$exit_code = 0;

};

if ($@) {

warn $@;

exit $exit_code;

}

exit $exit_code;

}

elsif ( $command eq "status" ) {

print "Checking the Status of the script.. OK \n";

exit 0;

}

else {

&usage();

exit 1;

}

}

sub start_vip() {

`ssh $ssh_user\@$new_master_host \" $ssh_start_vip \"`;

}

## A simple system call that disable the VIP on the old_master

sub stop_vip() {

`ssh $ssh_user\@$orig_master_host \" $ssh_stop_vip \"`;

}sub usage {

print

"Usage: master_ip_failover --command=start|stop|stopssh|status --orig_master_host=host --orig_master_ip=ip --orig_master_port=port --new_master_host=host --new_master_ip=ip --new_master_port=port\n";

}

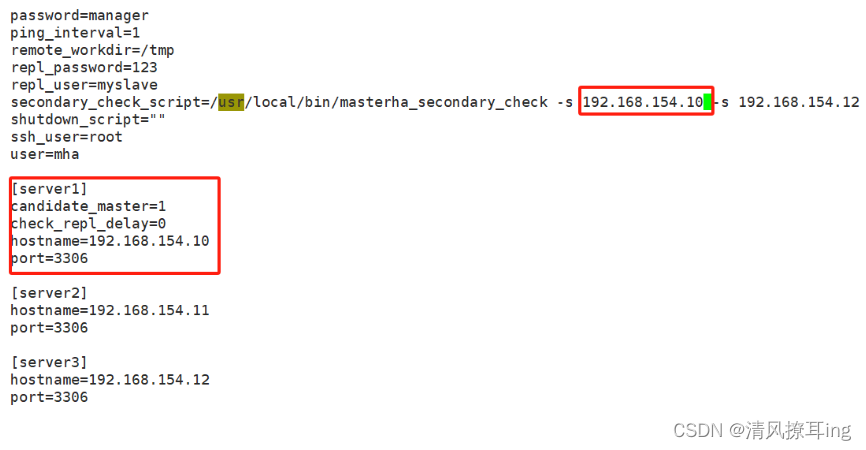

4、創建 MHA 軟件目錄并復制配置文件,使用app1.cnf配置文件來管理 mysql 節點服務器,配置文件一般放在/etc/目錄下

mkdir /etc/masterha

cp /opt/mha4mysql-manager-0.57/samples/conf/app1.cnf /etc/masterha刪除原有內容,直接復制并修改節點服務器的IP地址

vim /etc/masterha/app1.cnf?? ??? ?#刪除原有內容,直接復制并修改節點服務器的IP地址

[server default]

manager_log=/var/log/masterha/app1/manager.log

manager_workdir=/var/log/masterha/app1

master_binlog_dir=/usr/local/mysql/data

master_ip_failover_script=/usr/local/bin/master_ip_failover

master_ip_online_change_script=/usr/local/bin/master_ip_online_change

password=manager

ping_interval=1

remote_workdir=/tmp

repl_password=123

repl_user=myslave

secondary_check_script=/usr/local/bin/masterha_secondary_check -s 192.168.154.11 -s 192.168.154.12

shutdown_script=""

ssh_user=root

user=mha[server1]

hostname=192.168.154.10

port=3306[server2]

candidate_master=1

check_repl_delay=0

hostname=192.168.154.11

port=3306[server3]

hostname=192.168.154.12

port=3306

第一次配置需要在 Master 節點上手動開啟VIP

/sbin/ifconfig ens33:1 192.168.154.200/24

5、在 manager 節點上測試 ssh 無密碼認證,如果正常最后會輸出 successfully。

masterha_check_ssh -conf=/etc/masterha/app1.cnf

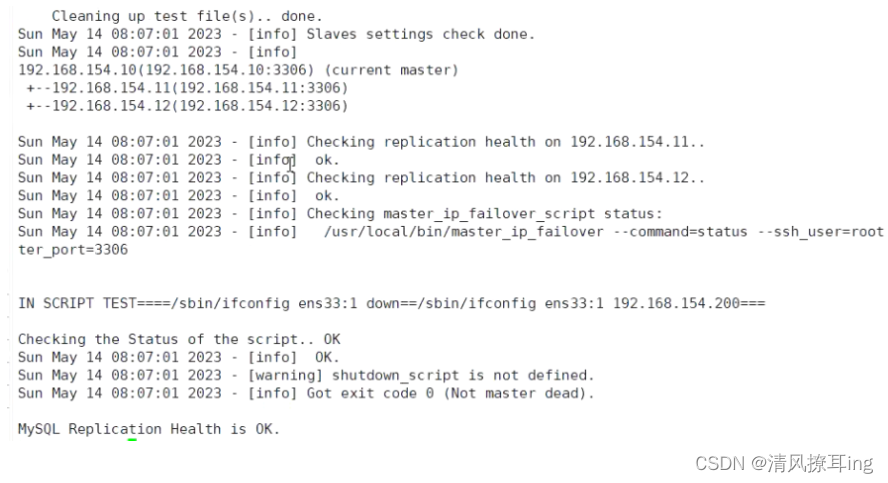

6、在 manager 節點上測試 mysql 主從連接情況,最后出現 MySQL Replication Health is OK 字樣說明正常。

masterha_check_repl -conf=/etc/masterha/app1.cnf

7、 manager 節點上啟動 MHA

nohup masterha_manager --conf=/etc/masterha/app1.cnf --remove_dead_master_conf --ignore_last_failover < /dev/null > /var/log/masterha/app1/manager.log 2>&1 &

--remove_dead_master_conf:該參數代表當發生主從切換后,老的主庫的 ip 將會從配置文件中移除。

--manger_log:日志存放位置。

--ignore_last_failover:在缺省情況下,如果 MHA 檢測到連續發生宕機,且兩次宕機間隔不足 8 小時的話,則不會進行 Failover, 之所以這樣限制是為了避免 ping-pong 效應。該參數代表忽略上次 MHA 觸發切換產生的文件,默認情況下,MHA 發生切換后會在 app1.failover.complete 日志文件中記錄,下次再次切換的時候如果發現該目錄下存在該文件將不允許觸發切換, 除非在第一次切換后刪除該文件,為了方便,這里設置為--ignore_last_failover。- 使用&后臺運行程序:結果會輸出到終端;使用Ctrl+C發送SIGINT信號,程序免疫;關閉session發送SIGHUP信號,程序關閉。

- 使用nohup運行程序:結果默認會輸出到nohup.out;使用Ctrl+C發送SIGINT信號,程序關閉;關閉session發送SIGHUP信號,程序免疫。

- 使用nohup和&配合來啟動程序nohup ./test &:同時免疫SIGINT和SIGHUP信號。

查看 MHA 狀態,可以看到當前的 master

masterha_check_status --conf=/etc/masterha/app1.cnf查看 MHA 日志,也以看到當前的 master 是 192.168.154.10,如下所示。

cat /var/log/masterha/app1/manager.log | grep "current master"查看 master 的 VIP 地址 192.168.154.200 是否存在,這個 VIP 地址不會因為 manager 節點停止 MHA 服務而消失。

ifconfig若要關閉 manager 服務,可以使用如下命令。

masterha_stop --conf=/etc/masterha/app1.cnf

或者可以直接采用 kill 進程 ID 的方式關閉三、故障模擬

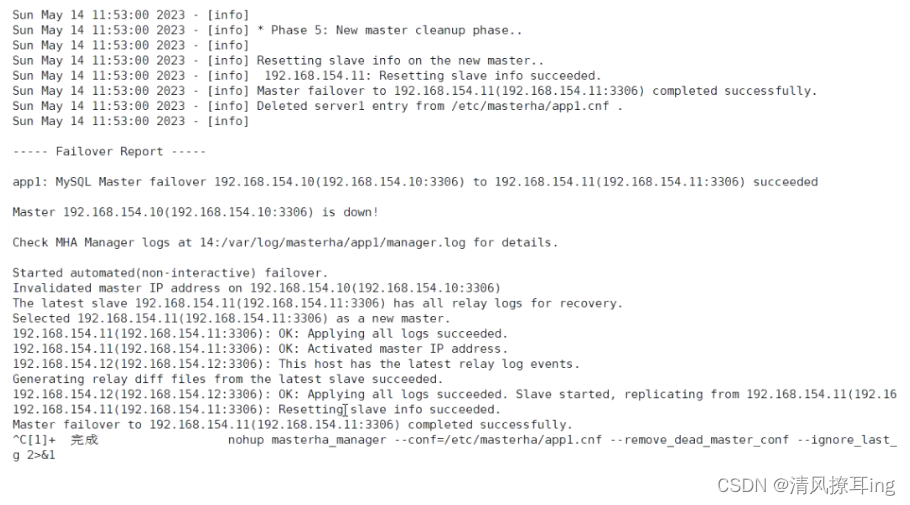

在 manager 節點上監控觀察日志記錄

#192.168.154.14

tail -f /var/log/masterha/app1/manager.log#關掉192.168.154.10的Mysql服務

systemctl stop mysqld?

正常自動切換一次后,MHA 進程會退出。HMA 會自動修改 app1.cnf 文件內容,將宕機的 master 節點刪除。

查看slave1是否接管VIP

3.1 故障切換備選主庫的算法

- 一般判斷從庫的是從(position/GTID)判斷優劣,數據有差異,最接近于master的slave,成為備選主。

- 數據一致的情況下,按照配置文件順序,選擇備選主庫。

- 設定有權重(candidate_master=1),按照權重強制指定備選主。

默認情況下如果一個slave落后master 100M的relay logs的話,即使有權重,也會失效。

如果check_repl_delay=0的話,即使落后很多日志,也強制選擇其為備選主。

四、故障修復

4.1 修復master

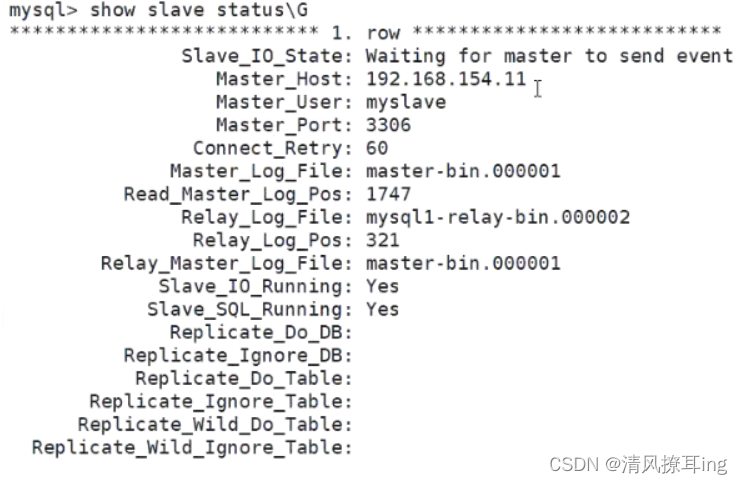

systemctl restart mysqld4.2 修復主從

在現主庫服務器 slave1(192.168.154.11) 查看二進制文件和同步點

mysql -u root -pshow master status;? 4.3 在原主庫服務器 master(192.168.154.10)執行同步操作

4.3 在原主庫服務器 master(192.168.154.10)執行同步操作

reset slave;

change master to master_host='192.168.154.11',master_user='myslave',master_password='123',master_log_file='master-bin.000001',master_log_pos=1745;start slave;

show slave status\G

4.4 在 manager 節點上修改配置文件app1.cnf(再把這個記錄添加進去,因為它檢測掉失效時候會自動消失)

4.5 在 manager 節點上啟動 MHA

masterha_stop --conf=/etc/masterha/app1.cnfnohup masterha_manager --conf=/etc/masterha/app1.cnf --remove_dead_master_conf --ignore_last_failover < /dev/null > /var/log/masterha/app1/manager.log 2>&1 &masterha_check_status --conf=/etc/masterha/app1.cnf

五、總結

MHA 作用

MySQL的高可用+故障切換

核心部分

MHA組件:Manager:主要功能:做MHA的啟動、關閉、管理和檢測MySQL的各種健康檢查

Node:再發生故障的時候,會盡可能的保存二進制日志文件,并且實現故障切換(VIP的漂移)

MHA需要配置的文件

master_ip_failover:命令工具,定義的是基于VIP漂移的檢測和故障轉移(VIP從Master---->新的Master)

app1.conf:MHA的主要配置文件,主要定義了MHA的工作目錄、日志

MySQL的二進制日志位置

使用MHA的登錄MySQL的用戶、密碼使用從服務器

身份同步Master的賬號和密碼(5個)

故障切換MHA會做哪些動作

- MHA會多次嘗試連接多測master的存活狀態

- MAH會多次嘗試、盡可能地保存Master的二進制日志文件

- MHA會根據配置文件app1.cnf中的配置部分,從服務器-------->主服務器的位置

- MHA最后會將Master的VIP地址作為切換到從服務器的位置

- MHA在選擇完新的Master之后會在其余的Slave上執行change master操作,指向新的Master,來保證MySQL的群集的健康性

MHA故障問題

- 軟連接問題

- 免交互登錄

- 五個用戶授權(其中3個賬號是測試環境需要做的)

- 初次運行MHA功能時需要臨時添加VIP地址

- 配置文件-----需要校驗

- 先安裝node節點,再安裝主節點

)

Adobe Flash Player已不再受支持)