本文介紹帝國理工學院等機構在 ICML 2025 發表的最新研究成果。該研究并未提出新模型,而是對現有時間序列 Transformer 模型進行了一次深刻的拷問——為何結構更簡單的 Transformer( PatchTST, iTransformer)在各大基準測試中,反而能優于設計更復雜的模型?

研究發現,當前主流基準數據集的性能主要由單變量內部的依賴關系主導,而跨變量間的影響較小。因此,模型的成功更多地得歸功于Z-score 歸一化和Skip connections等組件,它們極大地增強了模型捕捉單變量趨勢的能力。本文通過引入互信息分析和可控的合成數據集,系統性地揭示了現有 Transformer 模型的真實能力和局限性,為未來設計更適用于真實、復雜場景的模型提供了重要見解。

另外,我整理了ICML 2025時間序列相關論文合集,感興趣的dd我~

論文這里~

【論文標題】A Closer Look at Transformers for Time Series Forecasting: Understanding Why They Work and Where They Struggle

【論文鏈接】https://papers.cool/venue/kHEVCfES4Q@OpenReview

研究背景

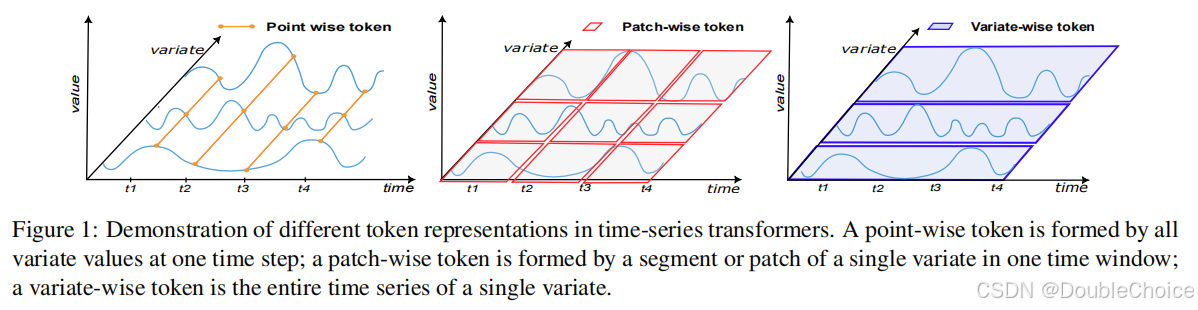

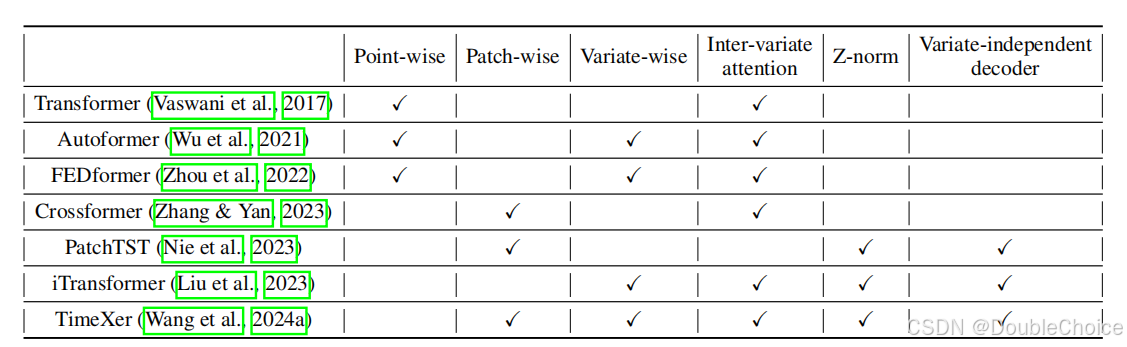

Transformer 在時間序列預測領域取得了巨大成功。研究者們提出了多種 Token 化策略,Point-wise、Patch-wise和Variate-wise,以捕捉不同維度的數據依賴。雖然模型架構日益復雜,但是一些設計相對簡單的模型,如僅關注單變量內部模式的 PatchTST 和專注于跨變量關系的 iTransformer,卻在性能測試中穩定名列前茅。

這種現象引出了一系列關鍵問題:

為什么以時間點為單位進行建模的 Point-wise Transformer 效果普遍較差?

為什么關注單變量的 Intra-variate attention 和關注多變量的 Inter-variate attention 會取得相似的性能?

那些成功的簡單 Transformer 模型,獲得其卓越性能的真正原因是什么?

針對這些問題,此論文摒棄了提出新模型的思路,轉而設計了一套系統的分析框架,目的是深入理解現有模型的工作機制和真正的優勢所在。

核心貢獻

本研究貢獻可總結如下:

- 通過實驗證明,在大多數標準基準上,模型的預測性能主要由捕捉單變量內部依賴的能力決定,而跨變量依賴的影響則小得多。這解釋了為何不同注意力機制的模型能取得相似結果。

- 設計了一套基于Mutual Information的評估指標,用于量化模型對不同維度依賴的捕捉能力。同時,創建了可控的合成數據集,能夠系統性地評估模型在不同依賴結構下的表現。

- 得出了時序模型的核心組件:研究發現,Z-score 實例歸一化和編碼器中的跳躍連接是推動模型成功的關鍵技術組件,而非復雜的注意力設計本身。

- 在真實的醫療健康數據集上驗證了研究發現,指出基準數據集的自依賴和平穩特性是影響模型評估結果的重要因素,并為設計面向更復雜應用的 Transformer 提供了實踐指導。

方法解析

本文的核心并非一個新模型,而是一套創新的分析框架。該框架旨在客觀、定量地評估不同 TransformerTransformerTransformer 模型捕捉時間序列依賴關系的能力。

111. 互信息評估指標

為了衡量模型預測對輸入各變量的依賴程度,作者提出了一種互信息分數 σij\sigma_{ij}σij?。它通過計算在固定其他變量時,輸入變量 iii 的變化對輸出變量 jjj 預測值方差的影響來估計。

- Intra?MIIntra-MIIntra?MI ScoreScoreScore (σii\sigma_{ii}σii?): 當 i=ji=ji=j 時,表示模型捕捉單變量自身依賴的能力。

- Inter?MIInter-MIInter?MI ScoreScoreScore (σij\sigma_{ij}σij?, i≠ji \neq ji=j): 當 i≠ji \neq ji=j 時,表示模型捕捉跨變量依賴的能力。

這些指標與模型無關,可以公平地比較不同架構的 TransformerTransformerTransformer。

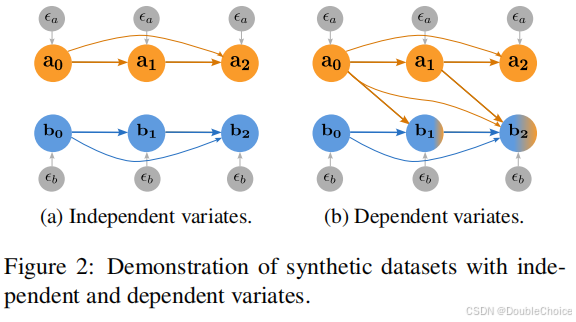

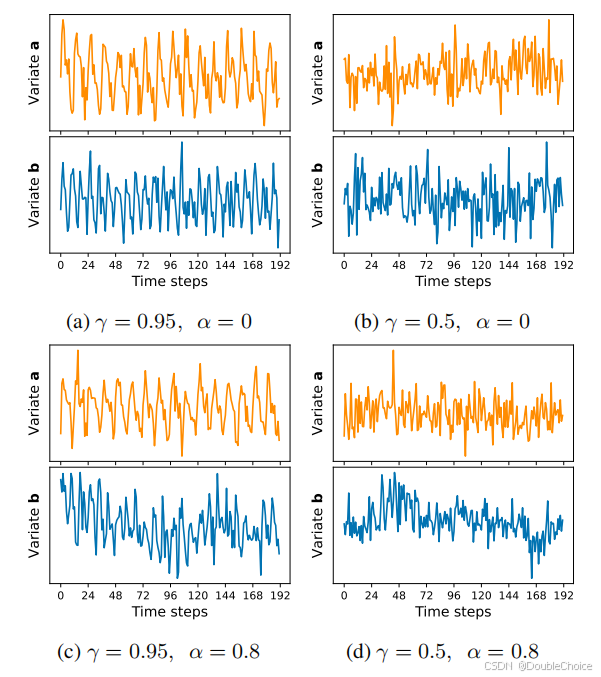

222. 可控合成數據集

為了擺脫基準數據集固有特性的限制,作者設計了可以精確控制依賴結構的合成數據集。如圖 222 所示,數據集生成過程包含兩個關鍵參數:

- 自相關強度 γ\gammaγ: 控制單個變量時間序列的平滑度和歷史依賴性。

- 跨變量依賴強度 α\alphaα: 控制變量之間相互影響的程度。

通過調整這兩個參數,可以模擬從完全獨立到強耦合的各種多變量時間序列場景,從而系統性地測試模型的“長板”和“短板”。

333. 模型消融實驗

作者對 iTransformer 等模型進行了深入的消融研究,例如:

- 移除編碼器中的跳躍連接(w/ow/ow/o SCSCSC)。

- 將與變量無關的解碼器替換為與變量相關的解碼器(VD?DeVD-DeVD?De)。

- 測試 Z?scoreZ-scoreZ?score 歸一化的有無。

實驗驗證

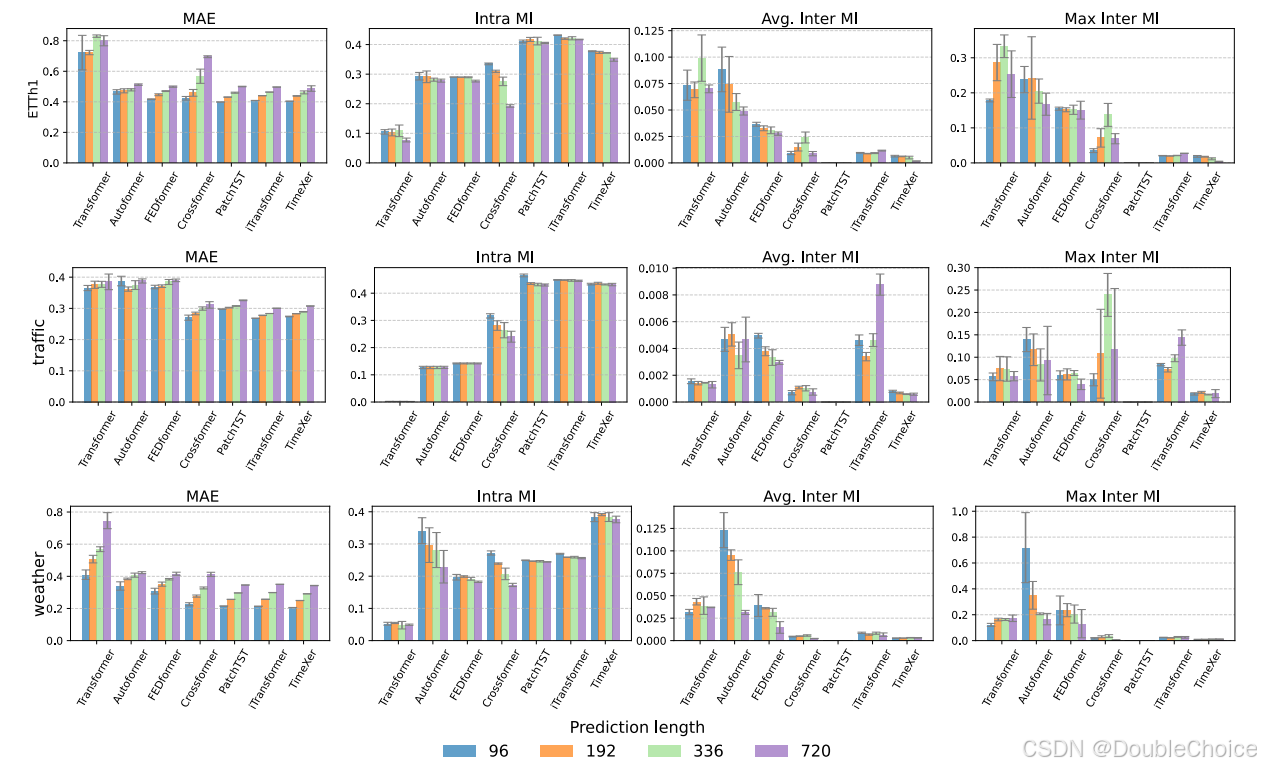

在 ETTh1、Traffic等多個基準數據集上:

- Point-wise模型,Transformer, Autoformer的Intra-MI分數最低,其預測誤差也最高。這表明它們難以有效捕捉單變量的時間模式。

- Patch-wise 和 Variate-wise模型,PatchTST, iTransformer, TimeXer具有非常高的Intra-MI分數和優越的性能。盡管 iTransformer設計用于捕捉跨變量關系,但其 Inter-MI 分數在這些數據集上并不突出,其成功仍然主要依賴于對單變量模式的建模。

這一結果有力地支持了“基準數據集由單變量依賴主導”的結論。

合成數據集上的實驗進一步證實了這一點。當跨變量依賴很弱時,α≤0.4\alpha \le 0.4α≤0.4,各模型性能相近。但當跨變量依賴性顯著增強時,α=0.8\alpha=0.8α=0.8,專門為跨維度交互設計的Crossformer開始展現出明顯的優勢,而PatchTST和iTransformer則表現不佳。

此外,消融實驗表明,移除跳躍連接會導致性能在基準上急劇下降,而在 Z-score歸一化上的測試則發現,該技術對平穩的基準數據集至關重要,但可能會損害模型在非平穩數據上的表現。

總結

本文通過一套嚴謹的分析框架,揭示了當前時間序列 Transformer研究中的一個重要“盲點”:模型的成功在很大程度上被基準數據集的內在特性以及簡單而有效的技術組件,Z-score歸一化、跳躍連接所驅動,而非表面上宣傳的復雜注意力機制。這提醒研究者們需要重新審視模型的評估方式,并開發更多樣化、更接近現實世界的基準,以推動領域向解決真正復雜問題邁進。

一言概括之,時序Transformer的成功秘訣,可能不在于花哨的注意力,而在于對單變量趨勢的精準捕捉和數據歸一化的巧妙運用。

![[AI Coding] 一.騰訊CodeBuddy IDE內測、安裝及基本用法(國產AI IDE啟航)](http://pic.xiahunao.cn/[AI Coding] 一.騰訊CodeBuddy IDE內測、安裝及基本用法(國產AI IDE啟航))

{ 罰金++ } else { 合規運行 })

實戰案例:信用卡欺詐檢測數據集)

)

![[RK3566-Android11] U盤頻繁快速插拔識別問題](http://pic.xiahunao.cn/[RK3566-Android11] U盤頻繁快速插拔識別問題)

)