摘要

通用型機器人需要具備多功能的身體和智能的大腦。近年來,類人機器人的發展在構建人類世界中的通用自主性硬件平臺方面展現出巨大潛力。一個經過大量多樣化數據源訓練的機器人基礎模型,對于使機器人能夠推理新情況、穩健處理現實世界的多變性以及快速學習新任務至關重要。為此,我們推出了GR00T N1,這是一個面向類人機器人的開放基礎模型。GR00T N1是一個視覺-語言-行動(VLA)模型,采用雙系統架構。視覺-語言模塊(系統2)通過視覺和語言指令解釋環境。隨后的擴散變換器模塊(系統1)實時生成流暢的運動動作。這兩個模塊緊密耦合,并且端到端聯合訓練。我們使用真實機器人軌跡、人類視頻以及合成數據集的異構混合來訓練GR00T N1。我們展示出,我們的通用型機器人模型GR00T N1在多個機器人實體上的標準仿真基準測試中,優于最先進的模仿學習基線。此外,我們將該模型部署在Fourier GR-1類人機器人上,用于受語言條件約束的雙臂操作任務,在數據效率方面取得了強勁表現。

1. 引言

在人類世界中創建能夠執行日常任務的自主機器人一直是一個令人著迷的目標,同時也是重要的技術挑戰。機器人硬件、人工智能以及加速計算的近期進展共同為開發通用型機器人自主性奠定了基礎。為了邁向人類水平的物理智能,我們倡導整合硬件、模型和數據這三大關鍵要素的全棧解決方案。首先,機器人是具有物理實體的代理,其硬件決定了其能力范圍。這使得類人機器人成為構建機器人智能的有吸引力的形式,因為它們具有類似人類的身體和多功能性。其次,現實世界的多樣性和多變性要求機器人能夠處理開放性目標并執行廣泛的任務。實現這一目標需要一個足夠表達且能夠處理各種任務的通用型機器人模型。第三,獲取大規模的現實世界類人機器人數據成本高昂且耗時。我們需要有效的數據策略來訓練大規模的機器人模型。

近年來,基礎模型在理解和生成視覺和文本數據方面取得了重大突破。它們展示了在大規模網絡數據上訓練通用型模型的有效性,以實現強大的泛化能力和快速適應下游任務。人工智能鄰近領域的基礎模型的成功描繪了為通用型機器人構建“智能骨干”的有前景的路線圖,賦予它們一系列核心能力,并使它們能夠在現實世界中快速學習和適應。然而,與文字和像素的數字領域不同,目前不存在用于大規模預訓練的類人機器人數據集。任何單一類人硬件可用的數據量將小得多。機器人學習社區的近期努力(Open X-Embodiment Collaboration等,2024年)探索了跨實體學習,通過匯集來自許多不同機器人的訓練數據來擴大數據集。然而,機器人實體、傳感器、執行器自由度、控制模式以及其他因素的巨大變異性導致形成了“數據孤島”,而不是訓練真正通用型模型所需的連貫的、互聯網規模的數據集。

我們介紹了GR00T N1,這是一個面向通用類人機器人的開放基礎模型。GR00T N1模型是一個視覺-語言-行動(VLA)模型,它從圖像和語言指令輸入中生成動作。它支持從桌面機器人手臂到靈巧類人機器人的跨實體功能。它采用雙系統組合架構,靈感來自人類認知處理(Kahneman,2011)。系統2推理模塊是一個預訓練的視覺-語言模型(VLM),在NVIDIA L40 GPU上以10Hz運行。它處理機器人的視覺感知和語言指令,以解釋環境并理解任務目標。隨后,經過動作流匹配訓練的擴散變換器作為系統1動作模塊。它交叉關注VLM輸出標記,并使用實體特定的編碼器和解碼器來處理可變的狀態和動作維度以生成運動。它以更高的頻率(120Hz)生成閉環運動動作。系統1和系統2模塊都作為基于Transformer的神經網絡實現,并且在訓練過程中緊密耦合和聯合優化,以促進推理和動作之間的協調。

和人類視頻構成了金字塔的底層;通過物理仿真生成的合成數據以及通過現成的神經模型增強的數據構成了中間層;在物理機器人硬件上收集的真實世界數據構成了金字塔的頂層。金字塔的下層提供廣泛的視覺和行為先驗知識,而上層則確保在實體化的真實機器人執行中落地生根。

?

Figure 1: Data Pyramid for Robot Foundation Model Training. GR00T N1’s heterogeneous training corpora can be represented as a pyramid: data quantity decreases, and embodiment-specificity increases, moving from the bottom to the top.

我們開發了一種有效的協同訓練策略,以在預訓練和后訓練階段跨整個數據金字塔進行學習。為了使用人類視頻和神經生成視頻等無動作數據源來訓練我們的模型,我們學習了一個潛在動作碼本 latent-action codebook(Ye等人,2025年),并且還使用經過訓練的逆動力學模型(IDM)來推斷偽動作 pseudo-actions.。這些技術使我們能夠為無動作的視頻標注動作,因此我們可以有效地將它們視為模型訓練的額外機器人實體。通過統一數據金字塔中的所有數據源,我們構建了一個一致的數據集,其中輸入包括機器人狀態、視覺觀察和語言指令,輸出是相應的運動動作。我們在三個數據層(標注過的視頻數據集、合成生成的數據集和真實機器人軌跡)中采樣訓練批次,進行端到端的預訓練。

憑借統一的模型和單一的權重集,GR00T N1能夠使用單臂、雙臂和類人機器人實體生成多樣化的操作行為。在標準仿真基準環境中評估時,GR00T N1取得了比最先進的模仿學習基線更優越的結果。我們還在GR-1類人機器人的現實世界實驗中展示了GR00T N1的強勁表現。我們的GR00T-N1-2B模型檢查點、訓練數據和仿真基準在GitHub和HuggingFace數據集上公開可用。

Figure 2: GR00T N1 Model Overview. Our model is a Vision-Language-Action (VLA) model that adopts a dual-system design. We convert the image observation and language instruction into a sequence of tokens to be processed by the Vision-Language Model (VLM) backbone. The VLM outputs, together with robot state and action encodings, are passed to the Diffusion Transformer module to generate motor actions.

2. GR00T N1基礎模型

GR00T N1是一個面向類人機器人的視覺-語言-行動(VLA)模型,經過多樣化數據源的訓練。該模型包含一個視覺-語言骨干網絡,用于編碼語言和圖像輸入,以及一個基于DiT的流匹配策略,用于輸出高頻動作。我們使用NVIDIA Eagle-2 VLM(Li等人,2025年)作為視覺-語言骨干網絡。具體來說,我們公開發布的GR00T-N1-2B模型總共有22億(?2.2B)個參數,其中VLM有13.4億(1.34B)個參數。在L40 GPU上使用bf16進行采樣時,生成16個動作的時間為63.9毫秒。圖2提供了我們模型設計的高級概述。我們強調GR00T N1的三個關鍵特點:

-

我們設計了一個組合模型,將基于視覺-語言模型(VLM)的推理模塊(系統2)和基于擴散變換器(DiT)的動作模塊(系統1)集成到一個統一的學習框架中;

-

我們開發了一種有效的預訓練策略,使用人類視頻、仿真和神經生成數據以及真實機器人演示的混合(見圖1),以實現泛化和魯棒性;

-

我們訓練了一個大規模多任務、受語言條件約束的策略,支持廣泛的機器人實體,并通過數據高效的后訓練快速適應新任務。

2.1 模型架構

在本節中,我們將描述如圖3所示的GR00T N1模型架構。GR00T N1使用流匹配(Lipman等人)來學習動作生成。一個擴散變換器(DiT)處理機器人的本體感知狀態和動作,然后與Eagle-2 VLM骨干網絡中的圖像和文本標記進行交叉關注,以輸出去噪后的運動動作。下面,我們將詳細闡述每個模塊。

狀態和動作編碼器

為了處理不同機器人實體的狀態和動作,這些狀態和動作的維度各不相同,我們使用每個實體的一個MLP,將它們投影到一個共享的嵌入維度,作為DiT的輸入。正如Black等人(2024年)所述,動作編碼器MLP還將擴散時間步與噪聲動作向量一起編碼。

我們使用動作流匹配,通過迭代去噪來采樣動作。模型的輸入除了機器人的本體感知狀態的編碼、圖像標記和文本標記外,還包括噪聲動作。動作以塊的形式進行處理,正如Zhao等人(2023年)所述,這意味著在任何給定時間at?,模型使用![]() ,其中包含從時間步 t?到t?+H??1的動作向量。在我們的實現中,我們設置H=16。

,其中包含從時間步 t?到t?+H??1的動作向量。在我們的實現中,我們設置H=16。

視覺-語言模塊(系統2)

為了編碼視覺和語言輸入,GR00T N1使用了在互聯網規模數據上預訓練的Eagle-2(Li等人,2025年)視覺-語言模型(VLM)。Eagle-2是基于SmolLM2(Allal等人,2025年)LLM和SigLIP-2(Tschannen等人,2025年)圖像編碼器進行微調的。圖像在224×224的分辨率下進行編碼,然后通過像素洗牌(Shi等人,2016年),每幀得到64個圖像標記嵌入。這些嵌入隨后與文本一起通過Eagle-2 VLM的LLM組件進行進一步編碼。LLM和圖像編碼器在廣泛的視覺-語言任務上進行了對齊,遵循Li等人(2025年)提出的一般方法。

在策略訓練期間,任務的文本描述以及(可能的多個)圖像以聊天格式傳遞給VLM,就像在視覺-語言訓練期間一樣。然后我們從LLM中提取形狀為(批量大小×序列長度×隱藏維度)的視覺-語言特征。我們發現,使用LLM中間層而不是最終層的嵌入,既加快了推理速度,又提高了下游策略的成功率。對于GR00T-N1-2B,我們使用第12層的表示。

擴散變換器模塊(系統1) 為了建模動作,GR00T N1使用了DiT(Peebles和Xie,2023年Scalable diffusion models with transformers)的一個變體,這是一個具有通過自適應層歸一化進行去噪步條件的變換器,記作?。如圖3所示,

由交替的交叉關注和自關注塊組成,類似于Flamingo(Alayrac等人,2022年)和VIMA(Jiang等人,2023年)。自關注塊在噪聲動作標記嵌入

和狀態嵌入

上進行操作,而交叉關注塊允許對VLM輸出的視覺-語言標記嵌入

進行條件設置。在最后一個DiT塊之后,我們應用一個實體特定的動作解碼器,另一個MLP,對最終的At?標記進行預測,以產生動作。

圖 3:GR00T N1 模型架構。GR00T N1 經過多種實例訓練,涵蓋單臂機械臂到雙手人形靈巧手等各種機器人實例。為了處理不同機器人實例的狀態觀察和動作,我們使用 DiT 模塊,并配備可感知實例的狀態和動作編碼器,以嵌入機器人的狀態和動作輸入。GR00T N1 模型利用 Eagle-2 模型的潛在嵌入,將機器人的視覺觀察和語言指令融合在一起。然后,視覺語言標記將通過交叉注意層輸入到 DiT 模塊中。

假設真實動作塊 𝐴𝑡、流匹配時間步 ![]() 以及采樣噪聲

以及采樣噪聲 ![]() ,則帶噪動作塊

,則帶噪動作塊 的計算公式為

![]() 。模型預測

。模型預測 ![]() 旨在通過最小化以下損失來近似去噪矢量場

旨在通過最小化以下損失來近似去噪矢量場 ![]() :

:

與 Black 等人 (2024 $\pi_0 $: A Vision-Language-Action Flow Model for General Robot Control) 的論文類似,我們使用 ![]() 。在推理過程中,我們采用 𝐾 步去噪生成動作塊。首先,隨機采樣

。在推理過程中,我們采用 𝐾 步去噪生成動作塊。首先,隨機采樣 ![]() ,然后使用前向歐拉積分迭代生成動作塊,更新如下:

,然后使用前向歐拉積分迭代生成動作塊,更新如下:

在實踐中,我們發現在所有實體中,使用 𝐾 = 4 的推理步驟效果良好。

2.2 訓練數據生成

為了訓練 GR00T N1,我們使用了多樣化數據源和目標來構建數據金字塔(如圖 1 所示)。我們首先從開放數據集中獲取多樣化的人類第一人稱視頻數據,這些數據構成了基礎部分,與用于 VLM 預訓練的網絡數據一起。接下來,我們使用預訓練的視頻生成模型生成合成神經軌跡。通過這種方式,我們將數據金字塔的“峰值”——即我們內部收集的 88 小時遙操作軌跡——從 88 小時擴展到 827 小時,增加了約 10 倍。我們使用多樣化的反事實機器人軌跡 counterfactual robot trajectories 和新的語言指令來生成這些數據(見圖 5 的示例)。我們還額外生成了多樣化的仿真軌跡,以擴展數據金字塔的中間部分。

在下一段中,我們首先描述如何從視頻中提取潛在動作,我們使用這些潛在動作來為大規模人類第一人稱數據集提取標簽。接下來,我們描述如何生成神經軌跡和仿真軌跡,以及如何為這些數據源獲取動作。

潛在動作

對于人類第一人稱視頻和神經軌跡,我們沒有可以直接用于訓練 GR00T N1 的動作數據。對于這些數據,我們通過訓練 VQ-VAE 模型從視頻的連續圖像幀中提取特征來生成潛在動作(Ye 等人,2025 年)。編碼器接收視頻中固定窗口大小 H 的當前幀 𝑥𝑡 和未來幀 𝑥𝑡+𝐻,并輸出潛在動作 𝑧𝑡。解碼器被訓練為接收潛在動作 𝑧𝑡? 和 𝑥t,并重建 𝑥𝑡+𝐻。該模型使用 VQ-VAE 目標進行訓練,其中編碼器的連續嵌入被映射到碼本中最近的嵌入。訓練完成后,我們取編碼器并將其用作逆動力學模型;給定 𝑥𝑡? 和 𝑥𝑡+𝐻 對,我們提取連續的預量化嵌入,并在預訓練期間將其用作潛在動作標簽,使用相同的流匹配損失,但將其視為一個不同的“LAPA”實體 embodiment。在所有異構數據上一起訓練 VQ-VAE 模型,使我們能夠統一所有數據以共享相同的已學習潛在動作空間,這可能會改善跨實體泛化能力。圖 4 顯示了從 8 種不同實體(包括機器人和人類實體)中檢索到的 𝑥𝑡 和 𝑥𝑡+𝐻 對,這些實體都來自相似的潛在動作;第一個潛在動作顯示所有實體都將右臂向左移動,第二個潛在動作顯示將右臂向右移動。

Figure 4: Latent Actions. We retrieve similar latent embeddings across various embodiments. The left images illustrate the latent action that corresponds to moving the right arm (or hand) to the left, while the right images illustrate the latent action that corresponds to moving the right arm (or hand) to the right. Note that this general latent action is not only consistent in different robot embodiments, but also in human embodiment.

神經軌跡?Neural Trajectories

機器人數據的規模與人類勞動呈線性關系,因為通常需要人類操作員通過遙操作機器人來生成每個軌跡。最近,視頻生成模型在高質量可控視頻生成方面展示了顯著潛力(Brooks 等人,2024 年;Lin 等人,2024 年;Ren 等人,2025 年;Wan 團隊,2025 年;Xiang 等人,2024 年;Yang 等人,2024 年),這為在機器人領域構建世界模型鋪平了道路。為了利用這些模型,我們在我們內部收集的所有 88 小時遙操作數據上對圖像到視頻生成模型(Agarwal 等人,2025 年;Wan 團隊,2025 年;Yang 等人,2024 年)進行微調,并根據現有的初始幀和新的語言提示生成 827 小時的視頻數據,增加了約 10 倍。這使得我們能夠在不實際收集每個案例的遙操作數據的情況下,生成更多包含現實世界中反事實場景的訓練數據(示例見圖 5;更多夢想生成示例見圖 14)。

Figure 5: Synthetically Generated Videos. We leverage off-the-shelf video generation models to create neural trajectories to increase the quantity and diversity of our training datasets. These generated data can be used for both pre- and post-training of our GR00T N1. (1) The first three rows are generated from the same initial frames but with different prompts (change left or right, the location to place the object), (2) the following two are from the same initial frames but replace the object to pick up, (3) the next row showcases the video model generating a robot trajectory which is very challenging to generate in simulation (spilling contents inside a mesh cup into a bin), and (4) the last row is generated from an initial frame from simulation data. We use thered rectangles to indicate the initial frames.

為了增加神經軌跡的多樣性,我們首先使用商業級多模態 LLM 檢測初始幀中的對象,并生成更多可能的“拿起 {對象} 從 {位置 A} 到 {位置 B}”的組合,同時指示模型只考慮物理上可行的組合。我們還對生成的視頻應用后處理機制,包括過濾和重新標注。為此,我們還使用商業級多模態 LLM 作為評判員,并輸入下采樣的 8 幀以過濾掉不精確遵循語言指令的神經軌跡。然后我們對過濾掉的視頻進行標注。(更多細節可以在附錄 E 中找到)。

仿真軌跡

由于同時控制雙臂和靈巧手的挑戰,為類人機器人擴展真實世界數據收集的規模成本極高。最近的研究(Jiang 等人,2024 年;Mandlekar 等人,2023 年;Wang 等人,2024 年)表明,在仿真中生成訓練數據是一種實用的替代方案。我們使用 DexMimicGen(Jiang 等人,2024 年)來合成大規模機器人操作軌跡。

從少量人類演示開始,DexMimicGen 在仿真中應用演示轉換和重放,以自動擴展數據集。每個任務被分解為一系列以對象為中心的子任務。初始人類演示被分割成更小的操作序列,每個序列對應一個涉及單個對象的子任務。然后通過將這些片段與對象的位置對齊來將它們適應到新環境中,同時保持機器人末端執行器與對象之間的相對姿態。為了確保平穩執行,系統在機器人當前狀態和轉換后的片段之間插值運動。然后機器人逐步按照完整序列執行,每一步都驗證任務的成功與否。只有成功的演示才會被保留,從而確保數據的高質量。使用 DexMimicGen,我們將有限的人類演示擴展為大規模類人操作數據集。考慮到預訓練和后訓練數據集,我們總共生成了 78 萬個仿真軌跡——相當于 6500 小時,或連續九個月的人類演示數據——僅用了 11 小時。這些仿真數據顯著補充了真實機器人數據,且幾乎不需要人工成本。

2.3 訓練細節

預訓練 在預訓練階段,GR00T N1 在多種實體和數據源上通過流匹配損失(公式 1)進行訓練,包括各種真實機器人數據集以及人類運動數據。我們參考第 3 節對數據集進行詳細描述。

對于人類視頻,由于缺乏真實動作,在這種情況下,我們提取了學習到的潛在動作,并將它們用作流匹配目標(見第 2.2 節)。對于機器人數據集,例如我們的 GR-1 類人數據或 Open X-Embodiment 數據,我們使用真實機器人動作以及學習到的潛在動作作為流匹配目標。在神經軌跡(第 2.2 節)用于增強機器人數據集的情況下,我們使用潛在動作以及在真實機器人數據上訓練的逆動力學模型預測的動作。預訓練超參數列在附錄中的表 6 中。

后訓練 在后訓練階段,我們在對應于每個單一實體的數據集上對預訓練模型進行微調。與預訓練一樣,我們保持 VLM 的語言部分凍結,并微調模型的其余部分。后訓練超參數在附錄中的表 6 中給出。

后訓練與神經軌跡 為了克服后訓練期間數據稀缺的挑戰,我們探索通過生成神經軌跡來增強每個下游任務的數據,類似于第 2.2 節中描述的程序。對于基于多視圖的下游任務,我們對視頻模型進行微調,以在網格中生成多個子圖像(見圖 13)。對于仿真任務,我們從隨機初始化的環境中收集多樣化的初始幀。對于真實機器人任務,我們手動隨機初始化對象姿態,并記錄機器人的初始觀察。也可以通過 img2img 擴散自動創建新的初始幀(示例見圖 13),但我們把進一步探索留到未來工作。我們還展示了

(1)多輪視頻生成用于生成由原子任務組成的長視域軌跡的示例,以及

(2)液體和關節對象的神經軌跡示例,這些對象已知在仿真中非常難以生成,盡管我們把下游任務的定量評估留到未來工作。

圖 13:更多神經生成軌跡示例。我們重點介紹神經軌跡的四個關鍵功能:(1)前三行展示了 RoboCasa 訓練后生成的多視角軌跡示例;我們通過在訓練期間將視角連接成一個四格視頻來實現這一點。(2)接下來的兩行展示了兩個連續的序列,其中后者的初始幀來自前者的末尾,這突顯了生成需要組合原子任務的任務軌跡的可能性。(3)接下來的兩行展示了我們的模型能夠生成帶有關節運動物體和液體的軌跡,而這些在模擬中是非常具有挑戰性的。(4)最后一行是從已繪制的初始幀生成的,這表明我們可以生成更加多樣化的視頻,而無需在現實世界中收集新的初始幀,也無需受人工勞動的約束。我們使用紅色矩形表示初始幀。

對于我們的后訓練流程與神經軌跡,我們將自己限制在僅對仿真任務的人類收集軌跡對視頻生成模型進行微調,以及僅對后訓練收集的真實世界基準數據的 10% 的數據進行微調,以匹配我們只有有限數量的遙操作數據的現實場景。由于生成的視頻沒有動作標簽,我們使用潛在動作或逆動力學模型(IDM)標記的動作(Baker 等人,2022 年),并訓練策略模型將這些偽動作視為不同實體的動作標簽。在低數據場景中,我們也將自己限制在僅對低數據進行 IDM 模型訓練,以促進現實場景

訓練。在后訓練過程中,我們以 1:1 的采樣比例共同訓練策略模型,使其同時學習真實世界軌跡和神經軌跡。

訓練基礎設施 我們在由 NVIDIA OSMO(NVIDIA,2025)管理的計算集群上訓練 GR00T N1,OSMO 是一個用于擴展復雜機器人工作負載的編排平臺。訓練集群配備了通過 NVIDIA Quantum-2 InfiniBand 以胖樹拓撲結構連接的 H100 NVIDIA GPU。我們通過在 Ray 分布式計算庫(Moritz 等人,2018 年)的基礎上構建的自定義庫,實現了容錯的多節點訓練和數據攝取。我們為單一模型使用了多達 1024 個 GPU。GR00T-N1-2B 大約使用了 50000 個 H100 GPU 小時進行預訓練。

在計算受限的微調環境中,我們在單個 A6000 GPU 上進行了測試。如果只調整適配器層(動作和狀態編碼器 + 動作解碼器) (action and state encoders + action decoder)? 和 DiT,可以使用高達 200 的批量大小。當調整視覺編碼器時,可以使用的批量大小為 16。

3. 預訓練數據集

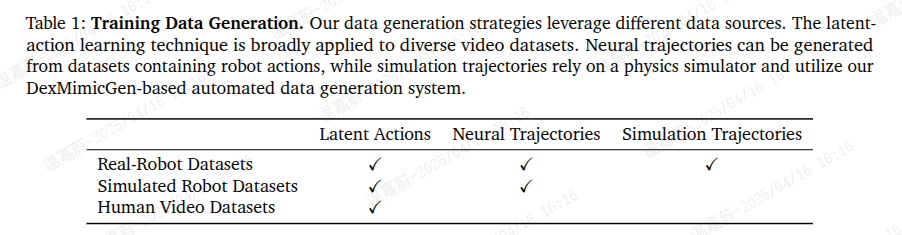

我們將預訓練語料庫分為三個主要類別:真實機器人數據集(第 3.1 節)、合成數據集(第 3.2 節)和人類視頻數據集(第 3.3 節)。這些分別對應于數據金字塔(圖 1)的頂端、中間和底部。合成數據集包括仿真軌跡和神經軌跡。表 1 總結了我們在第 2.2 節中描述的訓練數據生成策略及其適用的數據源。我們在表 7 中提供了預訓練數據集的完整統計數據(幀數、小時數和相機視角)。

表 1:訓練數據生成。我們的數據生成策略利用了不同類型的數據源。潛在動作學習技術廣泛應用于各種視頻數據集。可以從包含機器人動作的數據集中生成神經軌跡,而仿真軌跡則依賴于物理仿真器,并利用我們基于 DexMimicGen 的自動化數據生成系統。

3.1 真實世界數據集

我們使用了以下真實世界機器人數據集:

Figure 6: Data Collection via Teleoperation. Our teleoperation infrastructure supports multiple devices to capture human hand motion, including 6-DoF wrist poses and hand skeletons. Robot actions are produced through retargeting and executed on robots in real and simulation environments.

-

GR00T N1 類人預訓練數據集 我們內部收集的數據集涵蓋了廣泛的通用操作任務,專注于通過遙操作控制 Fourier GR1。我們利用 VIVE Ultimate Tracker 捕獲遙操作員的手腕姿態,同時使用 Xsens Metagloves 跟蹤手指運動。我們還探索了其他遙操作硬件選項,包括 Apple Vision Pro 和 Leap Motion(見圖 6)。記錄的人類運動隨后通過逆運動學重新定位到類人動作。實時遙操作的控制頻率為 20Hz。除了機器人的動作外,我們還在每一步捕獲頭戴式攝像機的圖像,以及人類的低維本體感知和動作。該數據集包含細粒度注釋,詳細描述了抓取、移動和放置等原子動作,以及粗粒度注釋,將細粒度動作序列聚合成更高級別的任務表示。這種層次結構支持學習精確的運動控制和高級別的任務推理。

-

Open X-Embodiment Open X-Embodiment Collaboration 等人(2024 年)是一個廣泛使用的跨實體機器人操作數據集。我們包括了 RT-1(Brohan 等人,2022 年)、Bridge-v2(Walke 等人,2023 年)、Language Table(Lynch 等人,2022 年)、DROID(Khazatsky 等人,2024 年)、MUTEX(Shah 等人,2023 年)、RoboSet(Bharadhwaj 等人,2024 年)和 Plex(Thomas 等人,2023 年),提供涵蓋各種操作任務、基于語言的控制和機器人 - 環境交互的多樣化數據集。

-

AgiBot-Alpha AgiBot-World-Contributors 等人(2025 年)是一個包含 100 個機器人軌跡的大規模數據集。我們在啟動訓練運行時使用了當時可用的 140000 個軌跡。該數據集涵蓋了精細操作、工具使用和多機器人協作。

3.2 合成數據集

我們的合成數據集包括

1)在物理仿真器中從少量人類演示中自動生成的仿真軌跡,以及

2)從現成的神經生成模型生成的視頻中衍生的神經軌跡。

仿真軌跡 除了真實世界數據集外,我們還如第 2.2 節所述,在仿真中生成了大規模合成數據集。我們的仿真任務包括類人機器人在仿真環境中執行各種桌面重新排列任務,并使用大量現實的 3D 資產。我們在 RoboCasa 仿真框架(Nasiriany 等人,2024 年)下構建了這些任務。總體而言,我們的任務遵循“將 A 從 B 重新排列到 C”的行為,其中 A 對應于一個對象,而 B 和 C 分別代表環境中的源和目標位置。源和目標位置是如盤子、籃子、餐墊和架子等容器,機器人必須在不同組合的源和目標容器之間重新排列對象。總體而言,我們的預訓練仿真數據集涵蓋了 54 種獨特的源和目標容器類別組合。我們在桌子上隨機放置對象和容器,并且在場景中還加入了干擾對象和容器。這些干擾項要求模型關注任務語言以執行所需的行為。

我們使用 DexMimicGen 生成大規模、高質量的訓練數據集。我們的數據集以 GR-1 類人機器人為特色,但我們可以將該系統應用于廣泛的機器人。我們首先通過 Leap Motion 設備收集幾十個源演示進行遙操作。Leap Motion 設備跟蹤 6 自由度手腕姿態和手指姿態,我們將這些值重新定位并通過基于 mink(Zakka,2024 年)的全身逆運動學控制器發送。鑒于人類演示,DexMimicGen 將演示處理成以對象為中心的片段,然后轉換和組合這些片段以生成新的演示。使用該系統,我們為預訓練任務體制中的每對(源,目標)容器生成 10000 個新演示,總共生成 540k 個演示。

神經軌跡 為了生成神經軌跡,我們在第 2.2 節描述的我們的真實世界 GR00T N1 類人預訓練數據集上對開源的圖像到視頻模型進行微調。我們在包含 3000 個真實世界機器人數據樣本的數據集上訓練了 100 個周期,每個樣本都帶有語言注釋,以 480P 分辨率記錄,包含 81 幀。如圖 5 所示,我們的模型可以根據新的語言提示生成高質量的反事實軌跡。此外,該模型在互聯網規模的視頻數據上進行訓練,展示了在處理未見初始幀、新對象和新的運動模式方面的強大泛化能力。這些視頻進一步用潛在動作和基于 IDM 的偽動作進行標記,以供模型訓練。我們總共生成了大約 827 小時的視頻;在 L40 GPU 上生成 1 秒視頻需要 2 分鐘,大約需要 105k L40 GPU 小時(約 1.5 天),在 3600 個 L40 GPU 上。

3.3 人類視頻數據集

我們包含了多樣化的人類視頻數據集。這些數據集不包含明確的動作標簽,但包含了大量的人類 - 對象交互序列,捕捉了可操作性、任務語義和自然運動模式。這些數據集涵蓋了廣泛的真實世界人類行為,包括在自然環境中執行的抓取、工具使用、烹飪、組裝和其他任務導向活動,并提供了手 - 對象交互的第一人稱視角(示例見圖 11)。我們的人類視頻數據集包括以下內容:

-

Ego4D 是一個大規模的第一人稱視頻數據集,包含了多樣化日常活動的記錄(Grauman 等人,2022 年);

-

Ego-Exo4D 在第一人稱記錄的基礎上增加了互補的第三人稱(外部)視角(Grauman 等人,2024 年);

-

Assembly-101 專注于復雜組裝任務,通過提供逐步組裝對象的詳細視頻(Sener 等人,2022 年);

-

EPIC-KITCHENS 包含了烹飪活動的第一人稱鏡頭(Damen 等人,2018 年);

-

HOI4D 捕捉了人類 -對象交互,并提供了逐幀注釋,包括分割、手部和對象姿態以及動作(Liu 等人,2022 年);

-

HoloAssist 捕捉了在增強現實環境中進行的協作和輔助任務(Wang 等人,2023 年);

-

RH20T-Human 包含了在多樣化真實場景中進行精細操作任務的記錄,重點是自然的手 - 對象交互(Fang 等人,2023 年)。

4. 評估

我們在多種仿真和現實世界基準測試中評估了 GR00T N1 模型。仿真實驗涵蓋了三個不同的基準測試,旨在系統地評估我們模型在不同機器人實體和操作任務中的有效性。在現實世界實驗中,我們研究了該模型在 GR-1 類人機器人上進行桌面操作任務的能力。這些實驗旨在展示 GR00T N1 在從有限數量的人類演示中獲取新技能方面的能力。

4.1 仿真基準測試

我們的仿真實驗包括來自先前工作(Jiang 等人,2024 年;Nasiriany 等人,2024 年)的兩個開源基準測試,以及一個新開發的桌面操作任務套件,旨在緊密模擬我們的現實世界任務設置。我們精心選擇這些基準測試,以在不同機器人實體和多樣化操作任務中評估我們的模型。我們公開發布的模型檢查點以及仿真環境和數據集,確保了我們關鍵結果的可重復性。圖 7 展示了這些三個基準測試中的一些示例任務。

RoboCasa 廚房(24 個任務,RoboCasa) RoboCasa(Nasiriany 等人,2024 年)包含了一系列在仿真廚房環境中的任務。我們專注于 24 個“原子”任務,涉及基礎的感觀運動技能,例如抓取 - 放置、開門和關門、按按鈕、擰水龍頭等。對于每個任務,我們使用公開可用的數據集,其中包含 3000 個演示,這些演示均使用 MimicGen(Mandlekar 等人,2023 年)生成,涉及 Franka Emika Panda 機械臂。觀察空間包括從左、右和腕部位置的攝像機捕獲的三張 RGB 圖像。狀態表示包括末端執行器和機器人基座的位置與旋轉,以及夾爪的狀態。動作空間由末端執行器的相對位置和旋轉以及夾爪狀態定義。我們遵循 Nasiriany 等人(2024 年)概述的相同訓練和評估協議。

DexMimicGen 跨實體套件(9 個任務,DexMG) DexMimicGen(Jiang 等人,2024 年)包含了一系列需要精確雙臂協調的九個雙臂靈巧操作任務。這些任務涵蓋了三種雙臂機器人實體:(1)雙臂 Panda 機械臂配備平行夾爪:任務包括穿線、部件組裝和運輸。狀態 / 動作空間包括雙臂末端執行器的位置和旋轉以及夾爪狀態;(2)雙臂 Panda 機械臂配備靈巧手:任務包括清理盒子、清理抽屜和托盤提升。狀態 / 動作空間包括雙臂和手部的末端執行器位置和旋轉;(3)GR-1 類人機器人配備靈巧手:任務包括倒水、咖啡準備和罐頭分類。狀態 / 動作空間包括雙臂和手部的關節位置和旋轉,以及腰部和頸部。我們使用 DexMimicGen 數據生成系統為每個任務生成 1000 個演示,并評估模型對新對象配置的泛化能力。

GR-1 桌面任務(24 個任務,GR-1) 該數據集作為現實世界類人數據集的數字對應物,使我們能夠進行系統評估,從而為現實機器人的部署提供信息。該基準測試專注于使用 GR-1 類人機器人配備 Fourier 靈巧手進行靈巧手控制。與 DexMG 相比,該基準測試涉及更多樣化的對象和不同的放置方式。我們總共模擬了 18 個重新排列任務,其結構與第 3.2 節中概述的預訓練任務類似,即從源容器重新排列對象到目標容器。每個任務都涉及獨特的容器組合,這些組合在我們的預訓練數據中未曾出現過。與預訓練任務一樣,大多數任務都涉及干擾對象和容器,這些干擾項要求模型關注任務語言。我們還額外增加了六個涉及將對象放入關節對象(例如櫥柜、抽屜和微波爐)并關閉它們的任務。觀察空間包括從機器人頭部的自我中心攝像機捕獲的一張 RGB 圖像。狀態 / 動作空間包括雙臂和手部的關節位置和旋轉,以及腰部和頸部。我們可選地在數據集中包含基于末端執行器的動作,以控制手臂,因為控制全身逆運動學控制器的原生動作空間是基于末端執行器的。我們使用 DexMimicGen 系統為每個任務生成 1000 個演示。

這些精心設計的基準測試引入了結構化、目標驅動的交互,以測試模型是否能夠無縫適應現實世界應用。為了構建高質量的后訓練數據集,我們讓人類操作員根據任務復雜性收集特定任務的數據,時間從 15 分鐘到 3 小時不等。然后我們過濾掉低質量軌跡,以保持數據的完整性。通過納入多樣化任務需求——從精確的單智能體操作到復雜的多智能體協作——我們的基準測試為評估人類操作任務中的泛化能力、適應性和精細控制能力提供了一個嚴格的測試平臺。

4.2 現實世界基準測試

我們引入了一套多樣化且精心設計的桌面操作任務,旨在評估和利用人類演示對模型進行后訓練。這些任務強調了現實世界靈巧性的關鍵方面,包括精確的對象操作、空間推理、雙臂協調和多智能體協作。我們仔細將基準測試分為四種不同類型,以確保對模型性能進行嚴格的評估。我們在圖 8 中展示了一些現實世界基準測試中的示例任務。

-

對象 - 容器抓取 - 放置(5 個任務,抓取 - 放置) 該類別評估模型抓取對象并將它們放入指定容器的能力,這是機器人操作的基本能力。任務包括在常見家庭容器(如托盤、盤子、切菜板、籃子、餐墊、碗和鍋)之間轉移對象。這些場景測試了精細運動技能、空間對齊以及對不同對象幾何形狀的適應性。為了嚴格評估泛化能力,我們在見過和未見過的對象上評估模型。

-

關節對象操作(3 個任務,關節對象) 這些任務評估模型操作關節存儲部件的能力。模型必須抓取一個對象,將其放入諸如木箱、深色櫥柜或白色抽屜等存儲單元中,然后關閉該部件。這些任務引入了在有限空間內進行受約束運動控制和精確放置的挑戰。使用見過和未見過的對象進行泛化測試。

-

工業對象操作(3 個任務,工業) 我們為工業場景設計了這一類別,涉及三個結構化的流程和基于工具的交互:1)機械包裝:抓取各種機械部件和工具,并將它們放入指定的黃色垃圾桶中;2)網眼杯倒水:抓取一個裝有小工業部件(例如螺絲和螺栓)的網眼杯,并將其內容物倒入塑料垃圾桶中;3)圓柱體交接:抓取一個圓柱形對象,將其從一只手轉移到另一只手,并將其放入黃色垃圾桶中。這些任務緊密模擬了現實世界中的工業應用,使其成為評估結構化環境中靈巧性的高度相關基準測試。

-

多智能體協調(2 個任務,協調) 協作任務需要多個智能體之間的同步,強調角色協調和自適應決策制定:1)協調第一部分:抓取一個圓柱體,將其放入網眼杯中,并將其交給另一個機器人;2)協調第二部分:接收機器人將圓柱體放入一個黃色垃圾桶中,然后將網眼杯中的剩余內容物倒入另一個黃色垃圾桶。

4.3 實驗設置

我們的評估實驗包括在數據受限環境中進行后訓練的 GR00T N1 和基線模型(如第 2.3 節所述),并在第 4.1 和 4.2 節中描述的仿真和現實世界基準測試中評估策略成功率。默認情況下,我們使用 1024 的全局批量大小,并訓練 60k 步。對于 DexMimicGen 跨實體套件,由于每個實體包含的任務相對較少,且總體訓練數據有限,我們為 GR00T-N1-2B 使用了 128 的較小批量大小。

基線

為了展示 GR00T N1 多樣化預訓練的有效性,我們與兩個已確立的基線模型進行比較,即 BC-Transformer(Mandlekar 等人,2021 年)和擴散策略(Diffusion Policy)(Chi 等人,2024 年)。以下是這兩種方法的詳細描述:

這些精心設計的基準測試引入了結構化、目標驅動的交互,以測試模型是否能夠無縫適應現實世界應用。為了構建高質量的后訓練數據集,我們讓人類操作員根據任務復雜性收集特定任務的數據,時間從 15 分鐘到 3 小時不等。然后我們過濾掉低質量軌跡,以保持數據的完整性。通過納入多樣化任務需求——從精確的單智能體操作到復雜的多智能體協作——我們的基準測試為評估人類操作任務中的泛化能力、適應性和精細控制能力提供了一個嚴格的測試平臺。(Mandlekar 等人,2021 年)和擴散策略(Diffusion Policy)(Chi 等人,2024 年)。以下是這兩種方法的詳細描述:

- BC-Transformer 是 RoboMimic(Mandlekar 等人,2021 年)中的基于 Transformer 的行為克隆策略。它由一個 Transformer 架構組成,用于處理觀測序列,以及一個高斯混合模型(GMM)模塊,用于建模動作分布。該策略以 10 幀觀測作為輸入,并預測接下來的 10 個動作。

- 擴散策略(Diffusion Policy)(Chi 等人,2024 年)通過基于擴散的生成過程建模動作分布。它采用 U-Net 架構,逐步從隨機樣本中去除噪聲,以生成基于觀測序列的精確機器人動作。它以單幀觀測作為輸入,并在一次推理過程中產生 16 個動作步驟。

評估協議?Evaluation Protocol

對于仿真基準測試評估,我們報告 100 次試驗的平均成功率,并取最后 5 個檢查點的最大分數,這些檢查點每 500 個訓練步驟寫入一次,遵循 RoboCasa(Nasiriany 等人,2024 年)的協議。

對于現實世界機器人的評估,我們采用部分評分系統,以捕捉模型在不同執行階段的行為,確保對性能進行細致的評估。我們報告每個任務 10 次試驗的平均成功率,但“機械包裝”任務除外;對于該任務,我們在 30 秒的時間限制內報告 5 個機械部件和工具中有多少個被放入垃圾桶的成功率。

由于時間限制,我們僅進行 5 次試驗。此外,為了評估模型在數據受限環境中的效率,我們對每個任務采樣 10% 的完整數據集,并評估模型是否仍能學習有效行為。

4.4 定量結果

Figure 8: Real-World Tasks. All images are captured from policy rollouts of GR00T-N1-2B and models posttrained from GR00T-N1-2B. (Top) Pre-training evaluations. We design two manipulation tasks to assess

our pretrained models. The left image shows a left-to-right handover, while the right image illustrates the placement of novel objects into an unseen target container. (Bottom) Post-training evaluations. We introduce four distinct task categories. From top to bottom, we present examples of object-to-container pick-and-place, articulated object manipulation, industrial object manipulation, and multi-agent coordination.

預訓練評估

為了評估我們預訓練檢查點的泛化能力,我們在真實的 GR-1 類人機器人上設計了兩個任務(見圖 8)。在第一個任務中,機器人被指示將一個對象放置在最低層架子上。然而,該對象被故意放置在機器人左臂的左側,這需要協調的雙臂策略。機器人必須首先用左臂抓取對象,將其傳遞到右臂的范圍內,然后完成將其放置到架子上的動作。在第二個任務中,機器人被指示將一個新對象放入一個未見過的目標容器中。對于每個任務,我們使用五個不同的對象對預訓練的 GR00T-N1-2B 模型進行評估,每個對象進行三次試驗。GR00T-N1-2B 在第一個協調設置中實現了 76.6%(11.5/15)的成功率,在涉及新對象操作的第二個設置中實現了 73.3%(11/15)的成功率。0.5 表示正確抓取了對象,但未能將對象放入容器中。在這兩個評估設置下取得的高績效表明了大規模預訓練的有效性。

后訓練評估

在仿真環境中,我們將我們后訓練的 GR00T N1 模型的定量結果與從頭開始的基線模型在三個仿真基準測試中進行了比較(見表 2)。對于每個基準測試,我們使用每個任務 30、100 和 300 個演示進行后訓練(RoboCasa 有 24 個任務,DexMG 有 9 個任務,GR-1 有 24 個任務)。我們觀察到 GR00T N1 在所有基準測試任務和數據集大小中始終優于基線模型。在附錄 B 中,我們包含了完整的比較結果和條形圖(圖 10)。

在現實機器人上,我們將 GR00T-N1-2B 與擴散策略進行了比較,分別在 10% 的人類遙操作數據集和完整數據集上進行訓練(見表 3 和圖 9)。

Figure 9: Neural Trajectories Ablations. In the RoboCasa simulation, we show using neural trajectories for post-training across 3 data regimes (30, 100, and 300 per task). In the real world, we show results only on the low-data regime (10% of the demonstrations). We co-train with 3k neural trajectories per task for RoboCasa?and 100 neural trajectories per task for real-world tasks. We explore using both latent and IDM-labeled actions in simulation and only IDM-labeled actions for the real robot.

圖9:神經軌跡消融實驗。在RoboCasa模擬實驗中,我們展示了在三種數據規模(每個任務分別有30、100和300個數據)下將神經軌跡用于后訓練的情況。在真實世界中,我們僅展示了在低數據規模(演示數據的10%)下的實驗結果。對于RoboCasa實驗,我們每個任務使用3000條神經軌跡進行共同訓練,對于真實世界的任務,每個任務使用100條神經軌跡進行共同訓練。我們在模擬實驗中探索使用基于潛在空間的動作和標注為IDM的動作,而對于真實機器人則僅使用標注為IDM的動作。

GR00T-N1-2B 在所有任務中均實現了顯著更高的成功率,比擴散策略在 10% 數據設置中高出 32.4%,在完整數據設置中高出 30.4%。值得注意的是,僅在 10% 數據上訓練的 GR00T-N1-2B 的表現僅比在完整數據上訓練的擴散策略低 3.8%,這突顯了其數據效率。

Post-training w/ Neural Trajectories Evaluations

我們在圖9中展示了一些初步結果,這些結果是關于在后訓練階段使用神經軌跡,在模擬評估的RoboCasa基準測試以及在真實世界評估的拾取與放置(已知任務)和工業任務中的應用情況。我們觀察到,與僅在真實世界軌跡上進行訓練的GR00T N1相比,與神經軌跡共同訓練的GR00T N1始終能帶來顯著的提升:在RoboCasa基準測試中,在30、100和300個數據規模下,平均分別提升4.2%、8.8%和6.8%;在GR-1人形機器人的8個任務中,平均提升5.8%。

在對比RoboCasa基準測試中的LAPA標簽和IDM標簽時,出現了一個有趣的現象:在數據量相對較少的情況下(30個數據),LAPA的表現略優于IDM,但隨著可用數據增多(達到100個和300個數據時),LAPA和IDM之間的性能差距就會拉大。這一趨勢是符合直覺的——隨著用于IDM訓練的數據增多,偽動作標簽會越來越接近真實世界的動作,從而產生更強的正向遷移效果。由于對于我們來說,GR-1人形機器人的訓練屬于相對 “高數據量” 的情況,因此在真實世界中進行神經軌跡的共同訓練時,我們僅使用IDM動作。

4.5 定性結果

這種行為在定性上看起來如何?為了回答這個問題,我們考慮 RoboCasa 中的“擰水龍頭”任務——在 100 個樣本的環境中,DP 基線的成功率為 11.8%,而 GR00T N1 的成功率為 42.2%。DP 基線經常對任務的語義感到困惑。從表 2 可以看出,GR00T N1 在數據受限環境中表現出色。當使用預訓練的 GR00T N1 模型提示任務指令“拿起紅蘋果并將其放入籃子”時,這是我們在后訓練基準測試中的一個任務,我們觀察到一些有趣的行為模式。在這種情況下,我們故意將蘋果放置在類人機器人手的左側。盡管在預訓練期間很少看到類似的任務,并且表現出更生硬的動作,但預訓練的檢查點使用其左臂抓取蘋果,將其傳遞給右臂,然后將其放入籃子中。我們在圖 12 中提供了這種行為的可視化。相比之下,后訓練的檢查點在這種情況下失敗了。由于所有后訓練數據僅涉及右臂,而沒有雙手之間的傳遞,因此后訓練的策略失去了執行這種行為的能力。

對于后訓練的 GR00T N1,與基線擴散策略相比,其動作通常更流暢,抓取精度顯著更高。相比之下,擴散策略基線在初始幀中經常出現運動不靈,頻繁出現抓取不準確的情況,導致我們在現實世界基準測試中的成功率較低。我們在圖 13 中提供了兩個策略展開示例的可視化。

4.6 限制

目前,我們的 GR00T N1 模型主要專注于短視域桌面操作任務。在未來的工作中,我們計劃將其能力擴展到處理長視域的行走 - 操作任務,這將需要在類人機器人硬件、模型架構和訓練語料庫方面取得進展。我們預計,一個更強大的視覺 - 語言骨干網絡將增強模型的空間推理能力、語言理解和適應性。我們用于合成數據生成的技術——利用視頻生成模型和自動化軌跡合成系統——已經展現出巨大潛力。然而,現有方法在生成多樣化和反事實數據時仍面臨挑戰,同時還需要遵循物理定律,這限制了合成數據集的質量和多樣性。我們計劃改進我們的合成數據生成技術,以進一步豐富用于模型訓練的數據金字塔。此外,我們還計劃探索新的模型架構和預訓練策略,以提高通用型機器人模型的魯棒性和泛化能力。

附錄

B. Detailed Experiment Results

表4和表5分別詳細展示了我們的GR00T-N1-2B模型與擴散策略基線模型在模擬基準測試和真實世界基準測試中各任務的對比情況。我們在不同規模的數據集上訓練這兩個模型——對于模擬基準測試,數據集分別包含30個、100個和300個演示數據;對于真實世界基準測試,數據集分別為演示數據的10%和全部數據。正如預期的那樣,隨著數據集規模的增大,兩個模型的性能都穩步提升。同時,在所有基準測試和各種數據集規模下,我們的模型始終優于基線模型,這表明我們的模型具有更好的泛化能力和樣本效率。

圖10:在不同數量演示數據下,模擬操作任務中策略的平均成功率。

C. Additional Qualitative Results

?我們在圖11和圖12中展示了經過預訓練和后訓練的GR00T-N1-2B模型的定性展示示例。我們的模型在雙手操作任務中展現出了強大的語言跟隨能力,以及對未見過情況的泛化能力。

圖11:預訓練定性示例。當用后訓練任務指令來驅動預訓練的GR00T-N1-2B模型時,我們甚至加大了難度,把蘋果放置在兩只手的左側。盡管在訓練過程中沒有遇到過這種設置,該模型還是成功地通過雙手傳遞將紅蘋果放進了籃子里,不過動作有些不流暢。

圖12:后訓練定性示例。(上)經過后訓練的GR00T-N1-2B成功地將黃瓜放進了籃子里,而擴散策略模型由于抓取不準確而失敗。(下)后訓練模型成功地從砧板上拿起檸檬并將其放入鍋中,而擴散策略模型則卡在了原處。??

D. Hyperparameters

我們在表6中列出了預訓練和后訓練階段所使用的重要超參數。總體而言,這兩個階段的大多數超參數取值是相同的。在后訓練階段,我們使用較小的批量大小,以避免在數據有限的情況下進行微調時出現過擬合問題。

E. System Design?

E.1. Dataset Formats

我們的訓練語料庫是基于LeRobot數據集格式(Cadene等人,2024年)構建的,該格式是開源機器人領域中被廣泛采用的標準。LeRobot由Hugging Face開發,旨在通過提供一種用于存儲、共享和利用機器人演示數據的標準化格式,降低機器人研究的入門門檻。由于其靈活性,以及可通過Hugging Face中心獲取的大量預訓練模型和數據集,這種格式已受到廣泛關注。

從本質上來說,LeRobot數據集格式采用了多種已有的文件格式相結合的方式,以實現高效的存儲和訪問:

1. 表格數據:機器人的狀態、動作以及元數據都存儲在parquet文件(Parquet文件)中,這種文件提供了高效的列式存儲方式,并且能實現快速的數據檢索。這種格式支持快速的篩選和切片操作,而這些操作對于訓練深度學習模型來說至關重要。

2. 圖像和視頻數據:視覺觀測數據被編碼為MP4視頻文件(或者也可以是PNG圖像序列),相關引用信息存儲在Parquet文件中。這種方法在保持數據可訪問性的同時,大幅降低了存儲需求。

3. 元數據:數據集統計信息、片段索引以及其他元數據都存儲在結構化的JSON文件中,這些文件提供了關于數據集特征的機器可讀信息。

這種格式將演示數據組織成多個片段,每一幀都包含同步的觀測數據與動作數據對。每個觀測數據通常包括攝像頭圖像(observation.images.*)和機器人狀態信息(observation.state),而動作數據則代表發送給機器人的控制指令。這種數據組織方式既有利于模仿學習(模型通過學習根據觀測數據來預測動作),也有利于強化學習(模型學習針對特定結果進行優化)。

雖然LeRobot格式提供了堅實的基礎,但我們在處理跨實體數據的工作中,需要額外的結構來支持更豐富的模態信息以及更復雜的訓練體系。因此,我們在LeRobot格式的基礎上增加了以下限制條件:

1. 模態配置文件:我們要求在元數據目錄中存在一個modality.json配置文件,該文件需明確界定狀態向量和動作向量的結構,將每個維度映射到一個語義含義,并提供額外的特定于模態的信息。

2. 細粒度的模態規范:與標準的LeRobot格式不同,標準格式將狀態和動作視為整體的向量,而我們的擴展將這些向量拆分成具有語義意義的字段(例如,末端執行器的位置、方向、夾爪狀態),每個字段都有其自身的元數據,包括數據類型、范圍以及變換規范。

3. 多種注釋支持:我們對該格式進行了擴展,以便在單個數據集中支持多種注釋類型(例如,任務描述、有效性標志、成功指標)。這遵循了LeRobot的慣例,即在Parquet文件中存儲索引,而將實際內容存儲在單獨的JSON文件中。

4. 旋轉類型規范:我們的格式明確規定了用于表示旋轉數據的方式(例如,四元數、歐拉角、軸角),以便在訓練過程中正確處理旋轉變換。

我們擴展后的格式在訓練視覺語言動作(VLA)模型方面具有幾個關鍵優勢:

1. 語義清晰性:通過明確界定狀態向量和動作向量中每個維度的結構和含義,我們的格式增強了可解釋性,并減少了數據預處理和模型訓練過程中的錯誤。

2. 靈活的變換:細粒度的模態規范使得在訓練過程中能夠進行復雜的、針對特定字段的歸一化和變換操作。例如,旋轉數據可以根據其特定的表示方式進行適當的歸一化和增強處理。

3. 多模態學習支持:這種擴展格式能夠自然地容納視覺語言動作(VLA)模型所需的各種數據類型,包括視覺觀測數據、狀態信息、動作指令以及語言注釋,同時還能保持這些不同模態數據之間清晰的關聯關系。

4. 增強的數據驗證:這種明確的結構能夠對數據集進行更全面的驗證,降低了使用格式錯誤或不一致的數據進行訓練的風險。

5. 增強的互操作性:盡管我們的格式添加了一些限制條件,但它仍與LeRobot生態系統保持向后兼容,這使我們能夠利用現有的工具和數據集,同時也支持更復雜的建模方法。

這種擴展格式在標準化和靈活性之間取得了平衡,為常見的機器人數據提供了清晰的結構,同時也滿足了視覺語言動作(VLA)模型的特定需求。實踐證明,這種方法在我們的工作中頗具價值,它在與更廣泛的機器人研究群體保持兼容的同時,實現了更高效的訓練,并提升了模型的性能。

E.2. Standardized Action Spaces

Auxiliary Object Detection Loss?輔助目標檢測損失

為了增強模型的空間理解能力,我們在訓練過程中引入了一個輔助的目標檢測損失函數。除了預測動作之外,該模型還必須根據給定的語言指令對感興趣的目標進行定位。具體來說,對于軌跡片段中的每一幀,我們使用OWL-v2目標檢測器(明德勒等人,2023年)標注目標物體的邊界框。然后,我們通過將邊界框的x坐標和y坐標分別除以圖像的寬度和高度,來計算邊界框歸一化后的中心坐標![]() 。為了預測二維坐標,我們在最終的視覺-語言嵌入標記之上添加一個線性層,并使用均方損失進行優化:

。為了預測二維坐標,我們在最終的視覺-語言嵌入標記之上添加一個線性層,并使用均方損失進行優化:![]() 。因此,最終的損失函數為:

。因此,最終的損失函數為:![]() 。

。

Neural Trajectory Generation

我們使用低秩自適應(LoRA)方法(胡等人,2022年),在收集到的遠程操作軌跡數據上對 WAN2.1-I2V-14B 模型(萬團隊,2025年)進行微調。為了進行微調,這些軌跡數據被統一降采樣至 81 幀,分辨率為 480P。由此得到的圖像轉視頻模型會生成神經軌跡,這些軌跡捕捉了現實世界中所有可能的 “反事實場景”。為了確保質量,我們會剔除那些沒有準確遵循給定語言指令的生成視頻。具體來說,我們從每個視頻中采樣 8 幀,并促使一個商業級的多模態大語言模型(LLM)來評估該視頻是否符合指令。未通過這一標準的視頻會進行重新標注字幕,在此過程中,這些視頻會被降采樣至 16 幀,分辨率為 256P。

IDM Model Training

我們通過以軌跡中的兩張圖像(當前幀和未來幀)為條件來訓練一個逆動力學模型(IDM),并訓練該模型以生成這兩幀圖像之間的動作塊。從初步實驗中我們觀察到,添加狀態信息或更多的圖像幀并沒有顯著提高驗證集上的動作預測性能。對于逆動力學模型架構,我們使用帶有SigLIP-2視覺嵌入的擴散變換器模塊(系統1),并以流匹配為目標進行訓練。我們針對每個實體訓練逆動力學模型30000步或60000步,具體取決于訓練集的大小。訓練完成后,對于神經軌跡的每一步,我們根據這兩張圖像(動作時間跨度與訓練時相同)對動作進行偽標注。

:原理、算法與應用)

![[react]Next.js之自適應布局和高清屏幕適配解決方案](http://pic.xiahunao.cn/[react]Next.js之自適應布局和高清屏幕適配解決方案)

![Python 趣味學習 -數據類型脫口秀速記公式 [特殊字符]](http://pic.xiahunao.cn/Python 趣味學習 -數據類型脫口秀速記公式 [特殊字符])