當你對著家用機器人說"把杯子放在筆筒和鍵盤之間,對齊杯身logo"時,它能精準理解空間關系并執行動作;當多臺機器人在超市協作補貨時,它們能自主規劃軌跡、避免沖突并完成長周期任務——這些曾經出現在科幻電影中的場景,正隨著RoboBrain 2.0的誕生加速成為現實。

作為新一代具身視覺-語言基礎模型,RoboBrain 2.0由北京人工智能研究院(BAAI)團隊研發,旨在打破"數字智能"與"物理智能"的鴻溝。這款模型以70億和320億參數的兩種規格,實現了感知、推理與規劃能力的統一,在空間理解、時間決策等核心任務上超越了現有開源與專有模型,為通用具身智能體的發展奠定了里程碑式的基礎。

傳統視覺語言模型(VLM)在數字世界表現出色,但面對物理環境時往往力不從心:要么無法精準判斷物體間的空間關系,要么難以規劃多步驟的長期任務,更遑論在動態環境中通過反饋持續優化行為。RoboBrain 2.0針對性解決了這三大瓶頸:

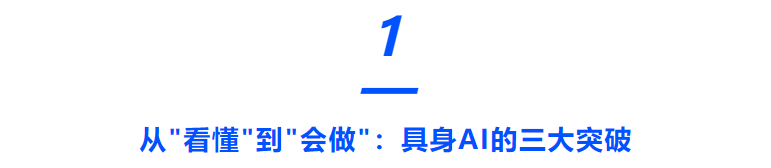

空間理解能力實現跨越式提升。模型能精準預測物體功能(如"杯子的握持部位")、解析復雜空間指向(如"冰箱右側第二層的牛奶"),甚至生成符合物理規律的放置軌跡。在RoboSpatial機器人環境基準測試中,32B版本以72.43分的成績大幅領先于Gemini(59.87分)和Qwen2.5-VL(48.33分),展現出對機器人操作場景的深度適配。

時間決策機制支持閉環交互與長程規劃。通過分析視頻序列中的時序依賴關系,模型能完成"先打開咖啡機再倒入牛奶"這類多步驟任務,甚至在多機器人協作時協調行動順序。在EgoPlan2日常活動規劃基準中,其57.23分的成績遠超GPT-4o(41.79分)和Claude(41.26分),證明了在復雜時序任務中的優勢。

因果推理鏈條讓智能行為可解釋。不同于直接輸出結果的傳統模型,RoboBrain 2.0能生成"觀察-思考-行動"(OTA)的完整推理過程。例如在"尋找馬克杯并倒咖啡"任務中,模型會先規劃搜索路徑,再根據反饋調整機器操作,最終完成目標,這種透明化的決策過程大幅提升了任務可靠性。

圖1 | 幾項標準的對比

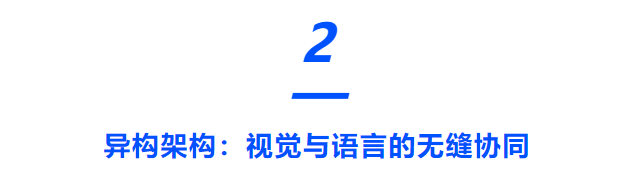

RoboBrain 2.0的強大能力源于其精心設計的異構架構,通過四大核心組件實現多模態信息的深度融合:

●?視覺編碼器:處理高分辨率圖像、多視角視頻等視覺輸入,采用自適應位置編碼和窗口注意力機制,高效解析復雜場景的空間特征。

●?MLP投影器:將視覺特征精準映射到語言模型的 token 空間,解決跨模態語義對齊難題。

●?語言模型主干:基于Qwen2.5-VL構建的解碼器,支持從自然語言指令到空間坐標、軌跡規劃等多樣化輸出。

●?場景圖處理器:結構化解析環境中的物體、位置及關系,為推理提供結構化知識支撐。

這種架構設計讓模型能同時接收"把紅色盒子放在圓桌中心"的語言指令、多攝像頭拍攝的廚房畫面、以及包含家具位置的場景圖數據,通過統一的 token 序列進行聯合推理,最終輸出精確到像素級的操作坐標。

圖2 | 該機器人的能力

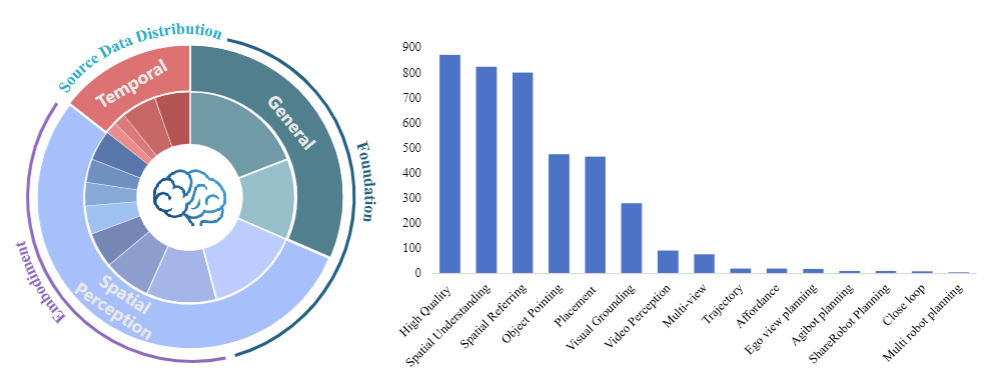

RoboBrain 2.0的性能突破離不開大規模高質量數據的支撐。團隊構建了涵蓋三大類別的訓練數據體系,總規模達數百萬樣本:

通用多模態數據奠定基礎能力。整合LLaVA-665K、LRV-400K等數據集,涵蓋視覺問答、區域查詢、OCR理解等任務,確保模型具備基本的跨模態交互能力。

空間數據強化物理世界感知。包括:

●??152K張高分辨率圖像的視覺定位數據,支持精確到 bounding box 的物體定位

●??190K組物體指向樣本,訓練模型理解"左上角的藍色杯子"等空間描述

●??826K條3D空間推理數據,涵蓋距離、方向等31種空間概念,遠超傳統數據集的15種

時間數據培養動態決策能力。包含:

●??50K條第一視角規劃軌跡,模擬人類日常活動的時序邏輯

●??44K組多機器人協作樣本,覆蓋家庭、超市、餐廳等場景

●??大規模閉環交互數據,通過模擬隨機故障事件,提升模型在動態環境中的魯棒性

訓練過程采用三階段遞進策略:首先通過基礎時空學習掌握環境感知能力,再通過具身增強訓練適配物理交互場景,最終通過思維鏈推理訓練提升復雜任務的解決能力。這種"從感知到行動"的培養路徑,使模型能高效吸收海量數據中的知識。

圖3 | 訓練數據的分布

在12項公開基準測試中,RoboBrain 2.0-32B在6項任務中刷新SOTA(state-of-the-art)成績,展現出全面的能力優勢:

●?空間推理:在BLINK基準的深度感知與空間關系任務中,以83.63分超越GPT-4o(77.90分)和Gemini-2.5(81.83分);在Where2Place物體放置預測任務中,73.59分的成績是Qwen2.5-VL(39.92分)的1.8倍。

●?時間規劃:Multi-Robot-Plan多機器人協作任務中,80.33分大幅領先于Claude(71.30分)和Gemini(65.39分);EgoPlan2日常活動規劃中,57.23分顯著超越所有對比模型。

●?實際操作:在ShareRobot-Bench的軌跡預測任務中,動態弗雷歇距離(DFD)達到0.2368,遠低于Qwen2.5-VL的0.5034,意味著機器人運動軌跡更平滑精準。

值得注意的是,輕量版7B模型在保持緊湊體積的同時,性能仍超越多數開源模型,為資源受限的邊緣設備部署提供了可能。這種"大模型保性能、小模型保部署"的雙版本策略,大幅降低了具身AI技術的落地門檻。

RoboBrain 2.0的技術突破已展現出廣泛的應用前景:

在家庭服務場景中,模型能理解"把陽臺的衣服收進衣柜下層"這類包含空間約束的指令,自主規劃移動路線并完成操作;在工業協作中,多臺機器人可基于模型的規劃能力協同完成流水線裝配,通過實時更新場景圖應對突發狀況;在倉儲物流中,系統能根據訂單需求優化機器人的取貨路徑,動態調整任務優先級。

更深遠的意義在于,團隊已開源模型代碼、 checkpoint 和基準測試工具(https://superrobobrain.github.io),這將推動整個具身AI領域的發展。正如報告中所言:"我們希望RoboBrain 2.0成為連接視覺-語言智能與物理世界交互的橋梁,為通用具身智能體的研發提供扎實基礎。"

未來,隨著與Vision-Language-Action(VLA)框架的融合以及機器人操作系統的深度集成,RoboBrain 2.0有望實現"感知-推理-行動"的端到端閉環,讓機器人真正理解物理世界的規則,在家庭、工廠、社區中成為可靠的智能助手。

當AI從屏幕走向三維空間,從處理數據轉向改造世界,RoboBrain 2.0的出現,或許正是通用人工智能征程上的關鍵一躍。

與源碼)

)

)

)

-渲染列表)

![[硬件電路-212]:電流的本質確實是電子的移動](http://pic.xiahunao.cn/[硬件電路-212]:電流的本質確實是電子的移動)