flume事務機制詳解:保障數據可靠性的核心邏輯

在數據采集過程中,“不丟數據、不重數據” 是核心需求。Flume 之所以能在分布式環境下保證數據可靠性,關鍵在于其內置的事務機制。Flume 通過在 “Source → Channel” 和 “Channel → Sink” 兩個階段分別引入事務,確保數據的原子性操作,即使出現故障也能通過回滾恢復數據。本文將深入解析 Flume 的事務原理、流程及核心保障機制。

為什么需要事務?

Flume 作為數據流轉的中間件,需應對各種異常場景(如網絡波動、組件崩潰、資源不足等)。事務的核心作用是:

-

原子性:確保一組數據要么全部成功處理,要么全部失敗回滾,避免部分數據丟失或重復;

-

可靠性:通過臨時緩沖和狀態校驗,在故障發生時恢復數據,保證數據最終一致性;

-

容錯性:允許組件在故障后重啟,通過事務日志或偏移量恢復未完成的操作。

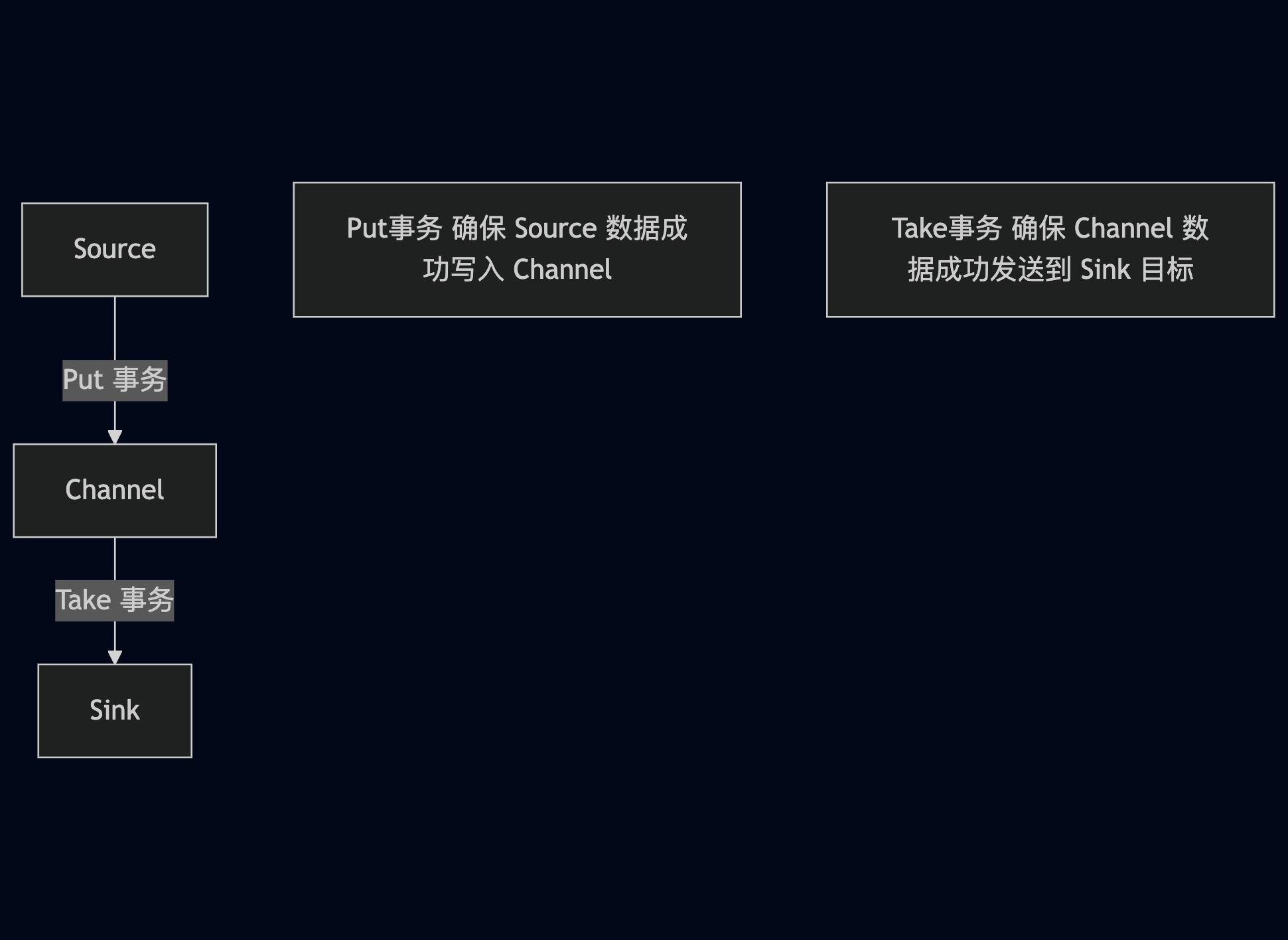

Flume 事務的兩大階段

Flume 的事務機制貫穿數據流轉的全流程,分為Put 事務(Source → Channel)和Take 事務(Channel → Sink),兩個階段獨立保障數據可靠性。

第一階段:Put 事務(Source → Channel)

Put 事務發生在 Source 向 Channel 寫入數據的過程,確保 Source 采集的數據能可靠存入 Channel。

事務流程

Put 事務通過 “臨時緩沖 → 校驗 → 提交 / 回滾” 三個步驟保障原子性,具體流程如下:

1. doPut:數據寫入臨時緩沖區putlist

- Source 從數據源(如文件、Kafka)采集一批數據,封裝為 Event 集合;

- 將 Event 臨時存入 Source 內部的putList 緩沖區(內存中的臨時列表),此時數據尚未寫入 Channel;

- 目的:避免直接寫入 Channel 時因突發故障(如 Channel 滿)導致數據丟失。

2. doCommit:校驗并提交數據到 Channel

- Source 調用 Channel 的

put()方法,嘗試將 putList 中的所有 Event 寫入 Channel; - Channel 校驗自身狀態(如內存 / 磁盤空間是否充足、是否可達):

- 校驗通過:Channel 成功接收所有 Event,putList 清空,事務提交;

- 校驗失敗:觸發

doRollback回滾操作。

3. doRollback:失敗時回滾數據

- 若 Channel 寫入失敗(如內存不足、磁盤故障),

doRollback被調用; - putList 中的數據保留不清除,Source 可在后續重試時重新提交這批數據;

- 回滾后,Source 會根據配置的重試策略(如

restartThrottle)再次發起 Put 事務。

關鍵保障機制

- 臨時緩沖(putList):數據先存入內存緩沖區,而非直接寫入 Channel,避免寫入過程中因 Channel 故障導致數據丟失;

- 批量提交:Source 通常批量處理 Event(如

batchSize=1000),減少事務次數,提升效率; - Channel 可靠性:不同 Channel 對 Put 事務的支持不同:

Memory Channel:依賴內存緩沖,故障時數據可能丟失(適合非核心場景);File Channel/Kafka Channel:通過磁盤或 Kafka 持久化存儲,即使崩潰也能恢復 putList 數據。

第二階段:Take 事務(Channel → Sink)

Take 事務發生在 Sink 從 Channel 讀取數據并發送到目標存儲(如 HDFS、Kafka)的過程,確保 Channel 中的數據能可靠送達目標。

事務流程

Take 事務通過 “臨時讀取 → 發送校驗 → 提交 / 回滾” 三個步驟保障原子性,具體流程如下:

1. doTake:從 Channel 讀取數據到臨時緩沖區

- Sink 調用 Channel 的

take()方法,從 Channel 中讀取一批 Event,存入 Sink 內部的takeList 緩沖區; - 此時 Channel 會標記這些 Event 為 “待處理” 狀態(但未刪除),確保即使 Sink 故障,數據仍在 Channel 中;

- 目的:避免數據從 Channel 讀取后、發送到目標前因故障導致丟失。

2. doCommit:確認數據發送成功后提交

- Sink 將 takeList 中的 Event 發送到目標存儲(如 HDFS 寫入、Kafka 生產);

- 目標存儲返回成功響應(如 HDFS 寫入確認、Kafka 生產者

acks=1確認); - Sink 調用

doCommit,Channel 清除 “待處理” 狀態的 Event,takeList 清空,事務完成。

3. doRollback:發送失敗時回滾數據

- 若數據發送失敗(如目標存儲不可達、網絡超時),

doRollback被調用; - Channel 將 “待處理” 狀態的 Event 恢復為 “可用” 狀態,允許 Sink 后續重新讀取;

- takeList 中的數據保留,Sink 會根據重試策略再次發起 Take 事務。

關鍵保障機制

- 臨時緩沖(takeList):數據從 Channel 讀取后先存入 takeList,發送成功才刪除 Channel 中的數據,避免 “已讀未發” 場景下的數據丟失;

- 狀態標記:Channel 對 Event 標記 “待處理” 狀態,區分已讀取但未提交的數據,支持故障恢復;

- 冪等性設計:部分 Sink(如 HDFS Sink)支持冪等寫入(通過文件名唯一標識),即使因回滾導致重復發送,也不會產生重復數據。

事務失敗的常見場景與恢復

Flume 事務通過回滾機制處理各類故障,以下是常見失敗場景及恢復邏輯:

場景 1:Put 事務失敗(Source → Channel)

- 失敗原因:Channel 內存 / 磁盤不足、Channel 崩潰、網絡分區(如 Kafka Channel 不可達);

- 恢復邏輯:

- putList 保留未提交數據,Source 觸發

doRollback; - Source 根據配置的重試間隔(如

restartThrottle=5000ms)重新發起 Put 事務; - 若重試多次失敗,部分 Source 會記錄失敗日志并暫停,避免無限重試消耗資源。

- putList 保留未提交數據,Source 觸發

場景 2:Take 事務失敗(Channel → Sink)

- 失敗原因:目標存儲(如 HDFS、Kafka)不可用、網絡超時、數據格式錯誤;

- 恢復邏輯:

- takeList 保留未發送數據,Sink 觸發

doRollback; - Channel 將 “待處理” Event 恢復為 “可用” 狀態;

- Sink 重試 Take 事務,重新讀取并發送這批數據,直至成功或達到最大重試次數。

- takeList 保留未發送數據,Sink 觸發

場景 3:組件崩潰(如 Flume Agent 重啟)

- 恢復邏輯:

- 若使用

File Channel或Kafka Channel:Channel 會通過磁盤日志或 Kafka 主題恢復未提交的 Event; - 若使用

Memory Channel:未提交的 putList/takeList 數據會丟失(因此核心場景不推薦 Memory Channel); - Source 和 Sink 重啟后,通過事務日志或偏移量(如 Kafka 的 consumer offset)恢復未完成的事務。

- 若使用

不同 Channel 對事務的支持差異

Channel 是事務的核心載體,不同類型的 Channel 對事務的實現方式和可靠性保障不同,選擇時需結合業務需求:

| Channel 類型 | 事務實現方式 | 數據可靠性 | 適用場景 |

|---|---|---|---|

| Memory Channel | 內存緩沖 + 無持久化日志 | 低 | 測試環境、非核心數據、對性能要求高 |

| File Channel | 磁盤日志 + 檢查點(Checkpoint) | 高 | 核心數據、需完全不丟數據的場景 |

| Kafka Channel | 依賴 Kafka 主題的持久化機制 | 高 | 分布式環境、需高可用的場景 |

推薦實踐

- 核心數據:優先選擇

File Channel或Kafka Channel,通過持久化保障事務恢復; - 非核心數據:可使用

Memory Channel提升性能,但需接受故障時的數據丟失風險; - 高吞吐場景:

Kafka Channel支持分布式部署,適合大規模集群下的事務緩沖。

參考文獻

- flume事務

)

:HandlerExceptionResolver - 異常處理的藝術)

介紹)

第一輪題解)

)

![[java] 控制三個線程按順序交替輸出數字123123…](http://pic.xiahunao.cn/[java] 控制三個線程按順序交替輸出數字123123…)

![[C#]winform基于yolov8-seg實現的指甲分割實現源碼](http://pic.xiahunao.cn/[C#]winform基于yolov8-seg實現的指甲分割實現源碼)

)