Tensorflow—基本用法

- 使用圖 (graph) 來表示計算任務.

- 在被稱之為 會話 (Session) 的上下文 (context) 中執行圖.

- 使用 tensor 表示數據.

- 通過 變量 (Variable) 維護狀態.

- 使用 feed 和 fetch 可以為任意的操作(arbitrary operation)賦值或者從其中獲取數據。

? TensorFlow 是一個編程系統, 使用圖來表示計算任務. 圖中的節點被稱之為 op (operation 的 縮寫)。一個 op 獲得 0 個或多個 Tensor。執行計算, 產生 0 個或多個 Tensor。

? 每個 Tensor 是一個類型化的多維數組。例如,你可以將一小組圖像集表示為一個四維浮點數 數組, 這四個維度分別是 [batch, height, width, channels].

? 一個 TensorFlow 圖描述了計算的過程. 為了進行計算, 圖必須在 會話 里被啟動.

? 會話 將圖的 op 分發到諸如 CPU 或 GPU 之類的 設備 上, 同時提供執行 op 的方法.

? 這些方法執行后, 將產生的 tensor 返回. 在 Python 語言中, 返回的 tensor 是numpy ndarray 對象。

Tensorflow—構建圖

- 創建源op:源op不需要任何輸入。例如常量(constant)。源op的輸出被傳遞給其他op做 運算。

- 在會話(session)中啟動圖

- 關閉session以釋放資源

Tensorflow—元素

Variables

變量Variables維護圖執行過程中的狀態信息. 通常會將一個統計模型中的參數表示為一組變量. 例如, 你可以將一個神經網絡的權重作為某個變量存儲在一個 tensor 中. 在訓練過程中, 通過重復運行訓 練圖, 更新這個 tensor.

Fetch:

為了取回操作的輸出內容,可以使用session對象的run()調用執行圖時,傳入一些tensor,這些 tensor會幫助你取回結果。

Feed:

使用一個tensor值臨時替換一個操作的輸出結果。可以提供feed數據作為run()調用的參數. feed 只在調用它的方法內有效, 方法結束, feed 就會消失. 最常見的用例是將某些特殊的操作指定為 “feed” 操作, 標記的方法是使用 tf.placeholder() 為這些操作創建占位符。

placeholder

placeholder是一個數據初始化的容器,它與變量最大的不同在于placeholder定義的是一個模板,這 樣我們就可以在session運行階段,利用feed_dict的字典結構給placeholder填充具體的內容,而無需 每次都提前定義好變量的值,大大提高了代碼的利用率。

代碼實現:

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt#使用numpy生成200個隨機點

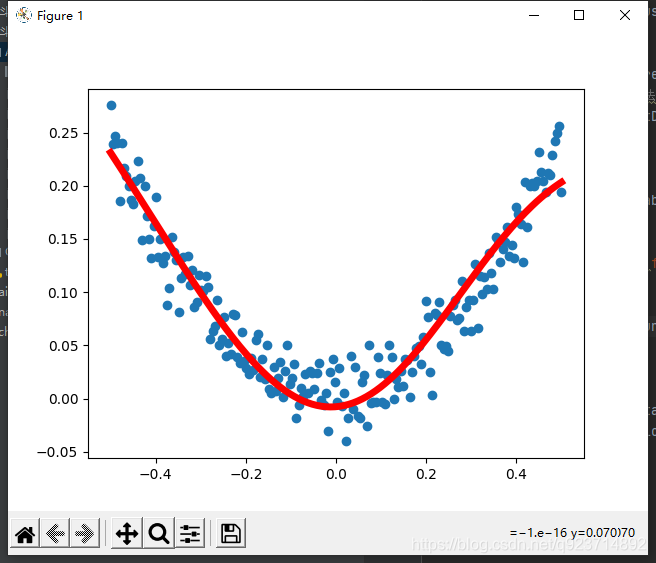

x_data=np.linspace(-0.5,0.5,200)[:,np.newaxis]

noise=np.random.normal(0,0.02,x_data.shape)

y_data=np.square(x_data)+noise#定義兩個placeholder存放輸入數據

x=tf.placeholder(tf.float32,[None,1])

y=tf.placeholder(tf.float32,[None,1])#定義神經網絡中間層

Weights_L1=tf.Variable(tf.random_normal([1,10]))

biases_L1=tf.Variable(tf.zeros([1,10])) #加入偏置項

Wx_plus_b_L1=tf.matmul(x,Weights_L1)+biases_L1

L1=tf.nn.tanh(Wx_plus_b_L1) #加入激活函數#定義神經網絡輸出層

Weights_L2=tf.Variable(tf.random_normal([10,1]))

biases_L2=tf.Variable(tf.zeros([1,1])) #加入偏置項

Wx_plus_b_L2=tf.matmul(L1,Weights_L2)+biases_L2

prediction=tf.nn.tanh(Wx_plus_b_L2) #加入激活函數#定義損失函數(均方差函數)

loss=tf.reduce_mean(tf.square(y-prediction))

#定義反向傳播算法(使用梯度下降算法訓練)

train_step=tf.train.GradientDescentOptimizer(0.1).minimize(loss)with tf.Session() as sess:#變量初始化sess.run(tf.global_variables_initializer())#訓練2000次for i in range(2000):sess.run(train_step,feed_dict={x:x_data,y:y_data})#獲得預測值prediction_value=sess.run(prediction,feed_dict={x:x_data})#畫圖plt.figure()plt.scatter(x_data,y_data) #散點是真實值plt.plot(x_data,prediction_value,'r-',lw=5) #曲線是預測值plt.show()運行結果:

![BZOJ 2003 [Hnoi2010]Matrix 矩陣](http://pic.xiahunao.cn/BZOJ 2003 [Hnoi2010]Matrix 矩陣)

)

之樂觀鎖插件)

)