240622_昇思學習打卡-Day4-ResNet50遷移學習

我們對事物的認知都是一點一點積累出來的,往往借助已經認識過的東西,可以更好地理解和認識新的有關聯的東西。比如一個人會騎自行車,我們讓他去騎摩托車他也很快就能學會,比如已經學會C++,現在讓他去學python他也很容易就能理解。這種情況我們一般稱為舉一反三。反言之,我們從原始部落找出來一個人(僅作舉例),指著摩托車讓他騎,可能是一件特別難的事,因為他對這個領域沒有絲毫的認知和理解,在實現這件事上就會特別困難。

映射到神經網絡上也是一樣的道理,如果我們在訓練時不導入預訓練權重,他就像一個沒有見過現代社會的原始人,學任何東西都特別慢,學習成本特別高,但如果我們導入了相似模型結構下針對別的任務的訓練權重(比如訓練識別自行車),用來訓練識別摩托車,我們只需要改變網絡最后的分類層,即可得到比較好的訓練效果,可以大大縮小模型訓練的時間。

原理是我在這么多層神經網絡的訓練下,已經明白了轱轆(車輪)長什么樣,把手長什么樣,最后的分類層只是區分出來什么是自行車,你現在給我一堆摩托的照片,我就可以去尋找兩者的相似處,我對轱轆和把手的認知就不用從0開始重新學習,只需要進行微調,比如摩托車的轱轆比自行車大一點,摩托車的車把手比自行車大一點。基于以前已經學習到的東西,可以大大縮小訓練成本。

遷移學習就是這個道理。我們在神經網絡技術的發展中,針對不同的任務,不可能每個網絡都從0開始訓練,那樣需要的數據集及成本都是不可承受的。

本文以ResNet50遷移學習為例展開講解,在MindSpore架構下運行。

數據準備

下載數據集

本文用到狗與狼分類數據集,使用download接口下載,也可自行下載放在項目當前目錄下

from download import downloaddataset_url = "https://mindspore-website.obs.cn-north-4.myhuaweicloud.com/notebook/datasets/intermediate/Canidae_data.zip"download(dataset_url, "./datasets-Canidae", kind="zip", replace=True)

數據目錄結構如下:

text

datasets-Canidae/data/

└── Canidae├── train│ ├── dogs│ └── wolves└── val├── dogs└── wolves

首先定義一些超參數:

batch_size = 18 # 批量大小

image_size = 224 # 訓練圖像空間大小

num_epochs = 5 # 訓練周期數

lr = 0.001 # 學習率

momentum = 0.9 # 動量

workers = 4 # 并行線程個數

加載數據集以及做一些數據增強(本文所用的狼狗數據集屬于ImageNet數據集,其典型mean和std值分別為[0.485, 0.456, 0.406]和[0.229, 0.224, 0.225],所以代碼中直接使用):

# 導入MindSpore庫,用于深度學習框架

import mindspore as ms

import mindspore.dataset as ds

import mindspore.dataset.vision as vision# 定義訓練數據集和驗證數據集的路徑

# 數據集目錄路徑

data_path_train = "./datasets-Canidae/data/Canidae/train/"

data_path_val = "./datasets-Canidae/data/Canidae/val/"# 定義函數,用于創建Canidae分類任務的訓練集或驗證集

# 參數dataset_path: 數據集路徑,usage: 數據集的用途,"train"或"val"

# 返回處理后的數據集

# 創建訓練數據集

def create_dataset_canidae(dataset_path, usage):"""數據加載"""# 初始化ImageFolderDataset,使用多線程并打亂數據順序# 使用mindspore.dataset.ImageFolderDataset接口來加載數據集data_set = ds.ImageFolderDataset(dataset_path,num_parallel_workers=workers,shuffle=True,)# 定義數據預處理的參數mean = [0.485 * 255, 0.456 * 255, 0.406 * 255]std = [0.229 * 255, 0.224 * 255, 0.225 * 255]scale = 32# 根據數據集的用途(訓練或驗證)選擇不同的數據增強操作if usage == "train":# 訓練集的數據增強操作,包括隨機裁剪、水平翻轉、歸一化等# Define map operations for training datasettrans = [vision.RandomCropDecodeResize(size=image_size, scale=(0.08, 1.0), ratio=(0.75, 1.333)),vision.RandomHorizontalFlip(prob=0.5),vision.Normalize(mean=mean, std=std),vision.HWC2CHW()]else:# 驗證集的數據增強操作,主要包括解碼、縮放、中心裁剪、歸一化等# Define map operations for inference datasettrans = [vision.Decode(),vision.Resize(image_size + scale),vision.CenterCrop(image_size),vision.Normalize(mean=mean, std=std),vision.HWC2CHW()]# 對數據集應用預處理操作# 數據映射操作data_set = data_set.map(operations=trans,input_columns='image',num_parallel_workers=workers)# 將數據集分批處理,指定批大小# 批量操作data_set = data_set.batch(batch_size)return data_set# 創建訓練數據集和驗證數據集,并獲取每個數據集的步長(即數據集的大小)

dataset_train = create_dataset_canidae(data_path_train, "train")

step_size_train = dataset_train.get_dataset_size()dataset_val = create_dataset_canidae(data_path_val, "val")

step_size_val = dataset_val.get_dataset_size()數據集可視化

從mindspore.dataset.ImageFolderDataset接口中加載的訓練數據集返回值為字典,用戶可通過 create_dict_iterator 接口創建數據迭代器,使用 next 迭代訪問數據集。前面 batch_size 設為18,所以使用 next 一次可獲取18個圖像及標簽數據。

# 獲取訓練數據集的第一個批次數據,是18張圖像及標簽數據。

data = next(dataset_train.create_dict_iterator())

images = data["image"]

labels = data["label"]print("Tensor of image", images.shape)

print("Labels:", labels)'''

執行結果為

Tensor of image (18, 3, 224, 224) # 意思是這一批有18張3通道(RGB通道)的長224寬224的圖像

Labels: [1 1 0 1 1 0 1 0 0 0 0 0 0 0 0 1 0 1] # 因為該任務是一個二分類任務,所以類別只有簡單的0和1

'''

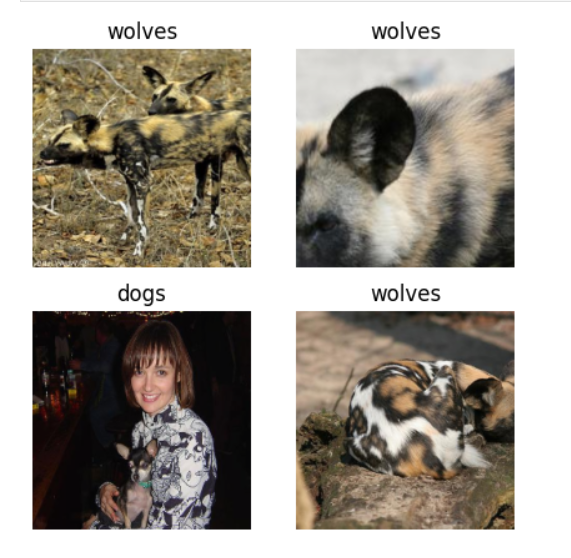

目前拿到的數據我們可以先看看長什么樣,展示圖像及標題,標題為對應的label名稱

# 導入matplotlib.pyplot庫用于繪圖

import matplotlib.pyplot as plt

# 導入numpy庫用于處理數組

import numpy as np# 定義一個字典,映射類別編號到類別名稱

# class_name對應label,按文件夾字符串從小到大的順序標記label

class_name = {0: "dogs", 1: "wolves"}# 創建一個5x5大小的畫布

plt.figure(figsize=(5, 5))

# 循環遍歷4個圖像

for i in range(4):# 獲取當前圖像的數據和標簽# 獲取圖像及其對應的labeldata_image = images[i].asnumpy()data_label = labels[i]# 將圖像數據從HWC格式轉換為RGB格式# 處理圖像供展示使用data_image = np.transpose(data_image, (1, 2, 0))# 對圖像進行預處理,包括歸一化和顏色空間轉換mean = np.array([0.485, 0.456, 0.406])std = np.array([0.229, 0.224, 0.225])data_image = std * data_image + meandata_image = np.clip(data_image, 0, 1)# 在畫布上創建子圖,并顯示當前圖像# 顯示圖像plt.subplot(2, 2, i+1)plt.imshow(data_image)# 設置子圖標題為圖像的類別名稱plt.title(class_name[int(labels[i].asnumpy())])# 關閉子圖的坐標軸顯示plt.axis("off")# 顯示畫布上的所有圖像

plt.show()

訓練模型

from typing import Type, Union, List, Optional

from mindspore import nn, train

from mindspore.common.initializer import Normalweight_init = Normal(mean=0, sigma=0.02)

gamma_init = Normal(mean=1, sigma=0.02)

今日就先寫這些,明天學完之后匯總。

不知道為什么我在這篇里面點編輯然后發表之后變成了一篇新的博客,那這里就附上后續的博客地址吧

240622_昇思學習打卡-Day4-5-ResNet50遷移學習

打卡圖片:

)

浮游菌檢測標準操作規程及GB/T 16292-2010測試方法解讀)