Python實現劍龍優化算法 (Stegosaurus Optimization Algorithm, SOA)優化函數(付完整代碼)

1.劍龍優化算法介紹

劍龍優化算法(Stegosaurus Optimization Algorithm,SOA)是一種受劍龍獨特生理結構和行為模式啟發而設計的元啟發式優化算法。該算法模擬了劍龍背部的骨板調節體溫機制以及尾部尖刺的防御行為,將其轉化為數學優化模型,用于解決復雜工程優化問題。

SOA的核心靈感來源于劍龍通過調整骨板角度以最大化散熱效率或吸收熱量的能力,以及利用尾部尖刺進行精準防御的策略。算法將解空間中的候選解視為“劍龍個體”,其位置更新機制包含兩個關鍵階段:一是“溫度調節階段”,模擬骨板對環境的響應,通過隨機調整解的方向以平衡全局探索和局部開發;二是“防御攻擊階段”,模擬尾部尖刺的精準攻擊,通過局部精細搜索提升收斂精度。

算法通過適應性權重和隨機參數模擬劍龍對環境的動態適應過程,能夠在探索與利用之間實現有效平衡。與其他優化算法(如粒子群優化、遺傳算法)相比,SOA在解決高維、多峰和非線性優化問題時表現出較強的魯棒性和收斂速度。

2.Python代碼

import numpy as np

import matplotlib.pyplot as plt# 定義目標函數:y = sum((x-0.5)^2)

def objective_function(x):"""目標函數:計算10維函數值"""return np.sum((x - 0.5) ** 2)class StegosaurusOptimization:"""劍龍優化算法類"""def __init__(self, objective_func, dim=10, population_size=30, max_iter=100,lower_bound=0, upper_bound=1):"""初始化劍龍優化算法參數參數:- objective_func: 目標函數- dim: 問題維度- population_size: 種群大小- max_iter: 最大迭代次數- lower_bound: 變量下界- upper_bound: 變量上界"""self.objective_func = objective_funcself.dim = dim # 維度設置為10self.pop_size = population_size # 劍龍種群數量self.max_iter = max_iter # 最大迭代次數self.lb = lower_bound # 變量下界self.ub = upper_bound # 變量上界# 初始化種群self.population = np.random.uniform(low=self.lb, high=self.ub,size=(self.pop_size, self.dim))# 計算初始適應度self.fitness = np.array([self.objective_func(ind) for ind in self.population])# 記錄全局最優解self.global_best_index = np.argmin(self.fitness)self.global_best_position = self.population[self.global_best_index].copy()self.global_best_fitness = self.fitness[self.global_best_index]# 記錄每次迭代的最優適應度,用于繪圖self.best_fitness_history = []def _update_position(self, current_pos, current_fitness, best_pos, best_fitness):"""更新劍龍位置模擬劍龍的覓食行為:- 向更優解移動- 加入隨機擾動探索新區域"""# 計算移動方向r1 = np.random.rand() # 隨機因子r2 = np.random.rand(self.dim) # 維度相關隨機因子# 劍龍的移動策略:結合最優解方向和隨機探索if current_fitness < best_fitness:# 如果當前解更好,進行局部搜索new_pos = current_pos + r1 * 0.1 * (current_pos - best_pos) + \0.05 * r2 * (self.ub - self.lb)else:# 否則向最優解移動new_pos = current_pos + r1 * 0.5 * (best_pos - current_pos) + \0.1 * r2 * (self.ub - self.lb)# 邊界處理new_pos = np.clip(new_pos, self.lb, self.ub)return new_posdef _social_behavior(self):"""模擬劍龍的社交行為劍龍群體中信息共享,優秀個體影響其他個體"""# 按適應度排序sorted_indices = np.argsort(self.fitness)# 前20%的優秀個體影響其他個體influence_count = int(0.2 * self.pop_size)for i in range(influence_count, self.pop_size):# 隨機選擇一個優秀個體influencer_idx = np.random.randint(0, influence_count)influencer_pos = self.population[sorted_indices[influencer_idx]]# 受影響的個體向優秀個體移動r = np.random.rand()self.population[i] = self.population[i] + 0.3 * r * (influencer_pos - self.population[i])self.population[i] = np.clip(self.population[i], self.lb, self.ub)def optimize(self):"""執行劍龍優化算法"""for iter in range(self.max_iter):# 更新每個劍龍的位置for i in range(self.pop_size):new_pos = self._update_position(self.population[i],self.fitness[i],self.global_best_position,self.global_best_fitness)# 計算新位置的適應度new_fitness = self.objective_func(new_pos)# 如果新位置更優,則更新if new_fitness < self.fitness[i]:self.population[i] = new_posself.fitness[i] = new_fitness# 更新全局最優if new_fitness < self.global_best_fitness:self.global_best_position = new_pos.copy()self.global_best_fitness = new_fitness# 執行社交行為self._social_behavior()# 更新適應度(社交行為后)self.fitness = np.array([self.objective_func(ind) for ind in self.population])current_best_idx = np.argmin(self.fitness)# 更新全局最優if self.fitness[current_best_idx] < self.global_best_fitness:self.global_best_position = self.population[current_best_idx].copy()self.global_best_fitness = self.fitness[current_best_idx]# 記錄當前迭代的最優適應度self.best_fitness_history.append(self.global_best_fitness)# 打印迭代信息if (iter + 1) % 10 == 0:print(f"迭代次數: {iter + 1}, 最優適應度: {self.global_best_fitness:.6f}")return self.global_best_position, self.global_best_fitnessdef plot_convergence_curve(self):"""繪制收斂曲線"""plt.figure(figsize=(10, 6))plt.plot(range(1, self.max_iter + 1), self.best_fitness_history)plt.title('劍龍優化算法的收斂曲線')plt.xlabel('迭代次數')plt.ylabel('最優適應度值')plt.grid(True)plt.show()# 主函數

def main():# 創建劍龍優化算法實例,優化10維函數soa = StegosaurusOptimization(objective_function,dim=10, # 10維函數population_size=50,max_iter=200,lower_bound=0,upper_bound=1)# 執行優化best_position, best_fitness = soa.optimize()# 顯示優化結果print("\n優化結果:")print(f"最優位置: {best_position}")print(f"最優適應度值: {best_fitness:.6f}")# 確保中文顯示正常plt.rcParams["font.family"] = ["SimHei", "Arial Unicode MS", "sans-serif"]plt.rcParams["axes.unicode_minus"] = False # 解決負號顯示問題# 繪制迭代曲線soa.plot_convergence_curve()# 保持窗口打開plt.ioff() # 關閉交互模式plt.show()if __name__ == "__main__":main()

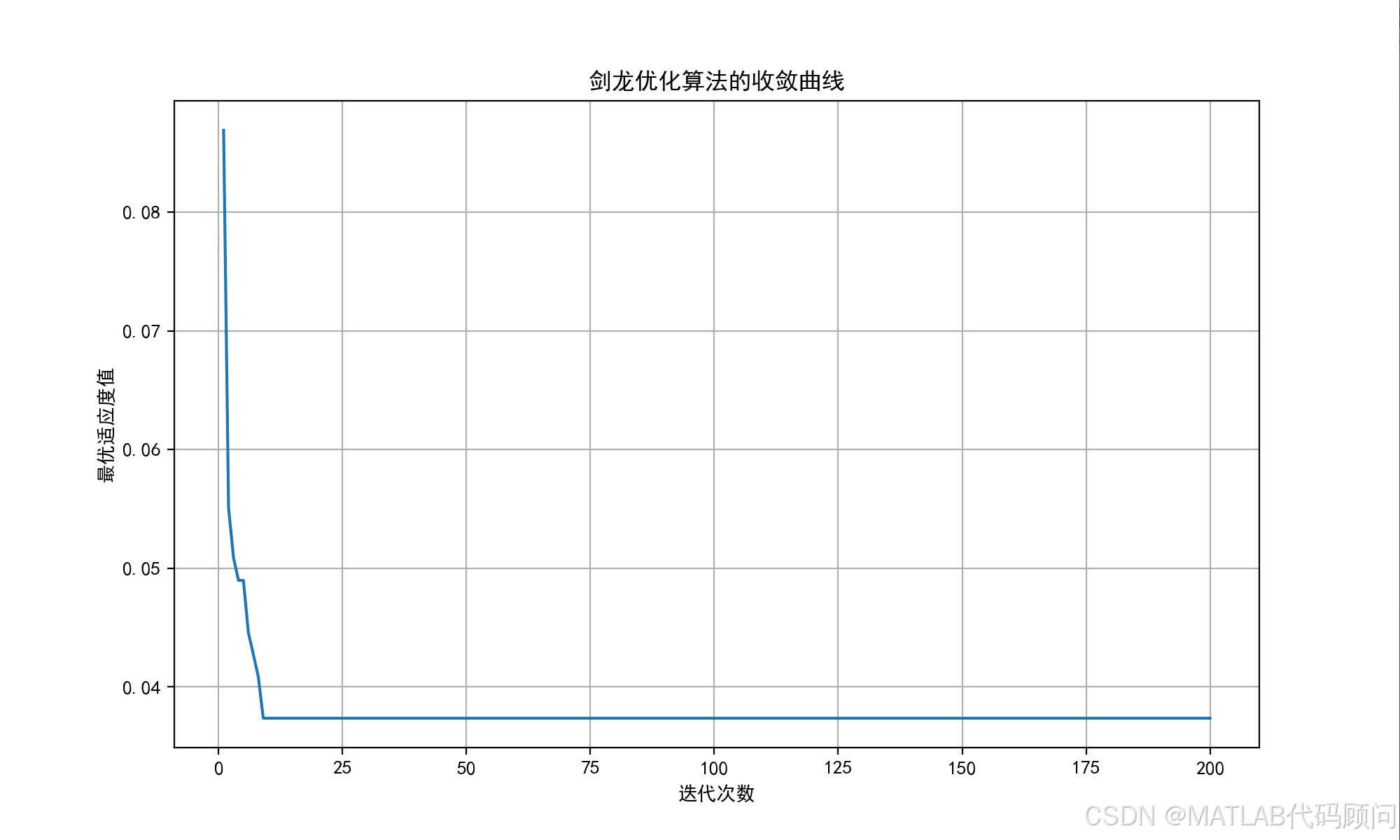

3.程序結果

迭代次數: 190, 最優適應度: 0.037376

迭代次數: 200, 最優適應度: 0.037376

優化結果:

最優位置: [0.45505218 0.53106685 0.52990886 0.48573503 0.55435184 0.54793402

0.62083922 0.60520667 0.54715607 0.48790803]

最優適應度值: 0.037376

4.代碼、程序訂制(MATLAB、Python)

4.1?各類智能算法

中文名稱 | 英文全稱 | 縮寫 | 出現年份 |

遺傳算法 | Genetic Algorithm | GA | 1975 |

粒子群優化算法 | Particle Swarm Optimization | PSO | 1995 |

蟻群優化算法 | Ant Colony Optimization | ACO | 1992 |

模擬退火算法 | Simulated Annealing | SA | 1983 |

免疫優化算法 | Immune Optimization Algorithm | IA | 1986 |

貪婪算法 | Greedy Algorithm | - | 1970 |

差分進化算法 | Differential Evolution | DE | 1997 |

混合蛙跳算法 | Shuffled Frog Leaping Algorithm | SFLA | 2003 |

人工蜂群算法 | Artificial Bee Colony | ABC | 2005 |

人工魚群算法 | Artificial Fish Swarm Algorithm | AFSA | 2002 |

螢火蟲算法 | Glowworm Swarm Optimization | GSO | 2005 |

果蠅優化算法 | Fruit Fly Optimization Algorithm | FOA | 2011 |

布谷鳥搜索算法 | Cuckoo Search | CS | 2009 |

猴群算法 | Monkey Algorithm | MA | 2008 |

免疫網絡算法 | Immune Network Algorithm | aiNet | 2000 |

水滴算法 | Intelligent Water Drops Algorithm | IWD | 2007 |

和聲搜索算法 | Harmony Search | HS | 2001 |

克隆選擇算法 | Clonal Selection Algorithm | CLONALG | 2000 |

禁忌搜索算法 | Tabu Search | TS | 1986 |

爬山算法 | Hill Climbing | HC | 1940 |

引力搜索算法 | Gravitational Search Algorithm | GSA | 2009 |

細菌覓食優化算法 | Bacterial Foraging Optimization | BFO | 2002 |

蝙蝠算法 | Bat Algorithm | BA | 2010 |

鄰域搜索算法 | Neighborhood Search | NS | 1960 |

變鄰域搜索算法 | Variable Neighborhood Search | VNS | 1997 |

蜜蜂交配優化算法 | Honey Bees Mating Optimization | HBMO | 2001 |

文化基因算法 | Memetic Algorithm | MA | 1989 |

煙花算法 | Fireworks Algorithm | FWA | 2010 |

思維進化算法 | Mind Evolutionary Algorithm | MEA | 1998 |

蜻蜓算法 | Dragonfly Algorithm | DA | 2016 |

虛擬力場算法 | Virtual Force Field Algorithm | VFF | 1989 |

遺傳規劃 | Genetic Programming | GP | 1992 |

鯨魚優化算法 | Whale Optimization Algorithm | WOA | 2016 |

灰狼優化算法 | Grey Wolf Optimizer | GWO | 2014 |

狼群算法 | Wolf Pack Algorithm | WPA | 2007 |

雞群優化算法 | Chicken Swarm Optimization | CSO | 2014 |

生物地理學優化算法 | Biogeography-Based Optimization | BBO | 2008 |

分布估計算法 | Estimation of Distribution Algorithm | EDA | 1996 |

帝國競爭算法 | Imperialist Competitive Algorithm | ICA | 2007 |

天牛須搜索算法 | Beetle Antennae Search Algorithm | BAS | 2017 |

頭腦風暴優化算法 | Brain Storm Optimization | BSO | 2011 |

人工勢場法 | Artificial Potential Field | APF | 1986 |

貓群算法 | Cat Swarm Optimization | CSO | 2006 |

蟻獅優化算法 | Ant Lion Optimizer | ALO | 2015 |

飛蛾火焰優化算法 | Moth-Flame Optimization | MFO | 2015 |

蘑菇繁殖優化算法 | Mushroom Reproduction Optimization | MRO | 2020 |

麻雀搜索算法 | Sparrow Search Algorithm | SSA | 2020 |

水波優化算法 | Water Wave Optimization | WWO | 2015 |

斑鬣狗優化算法 | Spotted Hyena Optimizer | SHO | 2017 |

雪融優化算法 | Snow Ablation Optimization | SAO | 2022 |

蝴蝶優化算法 | Butterfly Optimization Algorithm | BOA | 2019 |

磷蝦群算法 | Krill Herd Algorithm | KHA | 2012 |

黏菌算法 | Slime Mould Algorithm | SMA | 2020 |

人類學習優化算法 | Human Learning Optimization | HLO | 2014 |

母親優化算法 | Mother Optimization Algorithm | MOA | 2023 |

4.2各類優化問題

各種優化課題 | 各種優化課題 |

車間調度 | 路由路網優化 |

機場調度 | 順序約束項目調度 |

工程項目調度 | 雙層規劃 |

港口調度 | 零件拆卸裝配問題優化 |

生產線平衡問題 | 水資源調度 |

用電調度 | 庫位優化 |

公交車發車調度 | 庫位路線優化 |

車輛路徑物流配送優化 | 武器分配優化 |

選址配送優化 | 覆蓋問題優化 |

物流公鐵水問題優化 | 管網問題優化 |

供應鏈、生產計劃、庫存優化 | PID優化 |

庫位優化、貨位優化 | VMD優化 |

4.3各類神經網絡、深度學習、機器學習

序號 | 模型名稱 | 核心特點 | 適用場景 |

1 | BiLSTM 雙向長短時記憶神經網絡分類 | 雙向捕捉序列上下文信息 | 自然語言處理、語音識別 |

2 | BP 神經網絡分類 | 誤差反向傳播訓練 | 通用分類任務 |

3 | CNN 卷積神經網絡分類 | 自動提取空間特征 | 圖像、視頻分類 |

4 | DBN 深度置信網絡分類 | 多層受限玻爾茲曼機堆疊 | 特征學習、降維 |

5 | DELM 深度學習極限學習機分類 | 結合 ELM 與深度架構 | 復雜分類任務 |

6 | ELMAN 遞歸神經網絡分類 | 含反饋連接的遞歸結構 | 時間序列、語音 |

7 | ELM 極限學習機分類 | 隨機生成隱藏層,快速訓練 | 小樣本學習 |

8 | GRNN 廣義回歸神經網絡分類 | 基于徑向基函數回歸 | 函數逼近、時間序列 |

9 | GRU 門控循環單元分類 | 門控機制簡化 LSTM | 序列建模 |

10 | KELM 混合核極限學習機分類 | 結合多核 ELM | 高維復雜數據 |

11 | KNN 分類 | 基于距離的分類方法 | 模式識別 |

12 | LSSVM 最小二乘法支持向量機分類 | 最小二乘優化 SVM | 小樣本分類 |

13 | LSTM 長短時記憶網絡分類 | 門控機制處理長期依賴 | 語言建模 |

14 | MLP 全連接神經網絡分類 | 多層感知機 | 通用分類 |

15 | PNN 概率神經網絡分類 | 基于貝葉斯原理 | 模式識別 |

16 | RELM 魯棒極限學習機分類 | 增強魯棒性的 ELM | 噪聲數據 |

17 | RF 隨機森林分類 | 多棵決策樹集成 | 高維、非線性數據 |

18 | SCN 隨機配置網絡模型分類 | 隨機生成網絡結構 | 快速訓練 |

19 | SVM 支持向量機分類 | 尋找最優分類超平面 | 二分類、多分類 |

20 | XGBOOST 分類 | 梯度提升決策樹 | 大規模結構化數據 |

21 | ANFIS 自適應模糊神經網絡預測 | 融合模糊邏輯與神經網絡 | 復雜非線性系統建模 |

22 | ANN 人工神經網絡預測 | 多層神經元網絡 | 通用預測任務 |

23 | ARMA 自回歸滑動平均模型預測 | 線性時間序列建模 | 時間序列預測 |

24 | BF 粒子濾波預測 | 基于蒙特卡洛采樣 | 動態系統狀態估計 |

25 | BiLSTM 雙向長短時記憶神經網絡預測 | 雙向捕捉序列信息 | 時間序列、文本預測 |

26 | BLS 寬度學習神經網絡預測 | 增量學習結構 | 在線學習 |

27 | BP 神經網絡預測 | 誤差反向傳播訓練 | 通用預測 |

28 | CNN 卷積神經網絡預測 | 自動特征提取 | 圖像、視頻預測 |

29 | DBN 深度置信網絡預測 | 多層無監督預訓練 | 特征學習預測 |

30 | DELM 深度學習極限學習機預測 | 結合 ELM 與深度結構 | 復雜預測任務 |

31 | DKELM 回歸預測 | 動態核 ELM 回歸 | 時間序列回歸 |

32 | ELMAN 遞歸神經網絡預測 | 遞歸結構處理時序 | 時間序列 |

33 | ELM 極限學習機預測 | 快速訓練 | 小樣本回歸 |

34 | ESN 回聲狀態網絡預測 | 儲備池計算 | 時間序列預測 |

35 | FNN 前饋神經網絡預測 | 前向傳播 | 通用預測 |

36 | GMDN 預測 | 基因表達數據網絡建模 | 生物信息學預測 |

37 | GMM 高斯混合模型預測 | 多高斯分布建模 | 密度估計、聚類 |

38 | GRNN 廣義回歸神經網絡預測 | 徑向基函數回歸 | 函數逼近 |

39 | GRU 門控循環單元預測 | 門控機制簡化 LSTM | 時間序列預測 |

40 | KELM 混合核極限學習機預測 | 多核 ELM 回歸 | 高維回歸 |

41 | LMS 最小均方算法預測 | 線性回歸的迭代優化 | 自適應濾波 |

42 | LSSVM 最小二乘法支持向量機預測 | 最小二乘優化 SVM | 回歸預測 |

43 | LSTM 長短時記憶網絡預測 | 門控處理長期依賴 | 時間序列預測 |

44 | RBF 徑向基函數神經網絡預測 | 徑向基函數逼近 | 函數擬合 |

45 | RELM 魯棒極限學習機預測 | 增強魯棒性的 ELM | 噪聲數據回歸 |

46 | RF 隨機森林預測 | 決策樹集成 | 回歸預測 |

47 | RNN 循環神經網絡預測 | 循環連接處理序列 | 時間序列預測 |

48 | RVM 相關向量機預測 | 稀疏貝葉斯學習 | 回歸、分類 |

49 | SVM 支持向量機預測 | 尋找最優超平面 | 回歸預測 |

50 | TCN 時間卷積神經網絡預測 | 一維卷積處理時序 | 時間序列預測 |

51 | XGBoost 回歸預測 | 梯度提升決策樹 | 大規模回歸 |

算法詳解)

![[特殊字符] 認識用戶手冊用戶手冊(也稱用戶指南、產品手冊)是通過對產品功能的清](http://pic.xiahunao.cn/[特殊字符] 認識用戶手冊用戶手冊(也稱用戶指南、產品手冊)是通過對產品功能的清)

)

實現高可用負載均衡)

:)