成本

-

AIGC 時代對于冷熱儲存的呼喚

成本一直是向量數據庫獲得更廣泛使用的最大阻礙之一,這個成本來自兩點:

-

儲存,絕大多數向量數據庫為了保證低延遲,需要把數據全量緩存到內存或者本地磁盤。在這個動輒百億量級的AI 時代,意味著幾十上百 TB 的資源消耗。

-

計算,數據需要劃分成許多小片段來滿足工程上分布式支持大規模數據集的需求。對于每個分片需要單獨檢索再做規避,帶來了較大的查詢計算放大問題。百億級的數據如果按 10G 分片的話,會有一萬個分片,也就意味著計算放大了一萬倍。

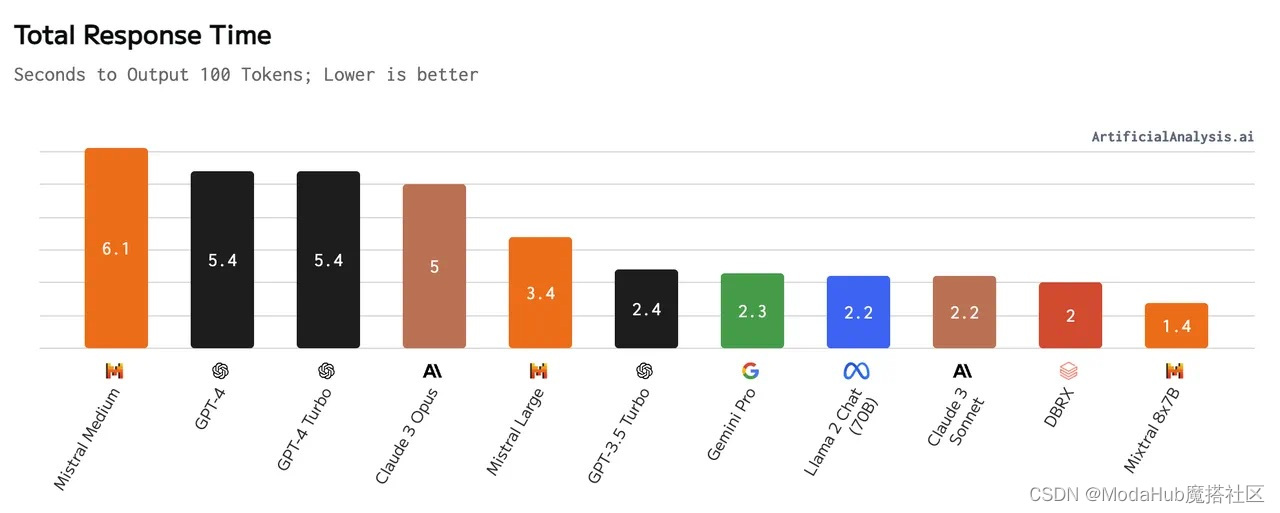

主流 LLM 的響應時間,圖源:https://artificialanalysis.ai/models

而在 AIGC 帶來的 RAG 浪潮中,單個 RAG 用戶(或者是 ToC 平臺的單個 tenant)對于延遲的敏感度都極低。原因是相較于向量數據庫幾毫秒到幾百毫秒的延遲,作為鏈路核心的大模型的延遲普遍超過秒級。加之云端對象儲存的成本遠遠低于本地磁盤和內存,人們越來越需要一種技術,可以:

<

)

)

)