【摘要】大型語言模型 (LLM) 已成為各種應用不可或缺的一部分,從傳統的計算任務到高級人工智能 (AI) 應用。這種廣泛的應用促使社會科學等各個學科對 LLM 進行了廣泛的研究。值得注意的是,研究表明 LLM 具有情商,可以通過積極的情緒刺激進一步發展。這一發現提出了一個有趣的問題:負面情緒是否同樣會影響 LLM,從而可能提高其性能?為了回答這個問題,我們引入了 NegativePrompt,這是一種以心理學原理為基礎的新方法,涉及十種專門設計的負面情緒刺激。我們對五個 LLM 進行了嚴格的實驗評估,包括 Flan-T5-Large、Vicuna、Llama 2、ChatGPT 和 GPT-4,涉及 45 個任務。結果很有啟發性:NegativePrompt 顯著提高了 LLM 的性能,在指令誘導任務中相對提高了 12.89%,在 BIG-Bench 任務中相對提高了 46.25%。此外,我們進行了注意力可視化實驗,以揭示 NegativePrompt 影響的潛在機制。我們的研究對理解 LLM 和情感互動做出了重大貢獻,證明了 NegativePrompt 作為一種情感驅動方法的實際效果,并為在實際應用中增強 LLM 提供了新穎的見解。

原文: NegativePrompt: Leveraging Psychology for Large Language Models Enhancement via Negative Emotional Stimuli

地址: https://arxiv.org/abs/2405.02814v2

代碼: https://github.com/wangxu0820/NegativePrompt

出版: IJCAI 2024

機構: 吉林大學、中科院軟件所?

1 研究問題

本文研究的核心問題是: 如何利用負面情緒刺激來提升大語言模型的性能。

假設我們要訓練一個聊天機器人,幫助用戶提供心理咨詢服務。傳統方法是喂給模型大量的正面案例,教它如何積極鼓勵、引導對方。但這可能導致機器人的回復過于正面,缺乏對負面情緒的理解和共情。因此,本文嘗試加入一些負面情緒刺激,看它是否能幫助模型更全面地理解人類情緒,給出更貼心的回應。

本文研究問題的特點和現有方法面臨的挑戰主要體現在以下幾個方面:

-

現有的大語言模型prompt優化方法主要關注任務性能的提升,較少探討情感智能方面的改進。例如可以通過引入任務相關的知識來提升問答準確率,但對于需要情感理解的任務幫助有限。

-

負面情緒可能帶來意料之外的影響。與正面情緒不同,負面情緒可能引發抵觸、逃避等消極反應,不利于任務的完成。因此需要慎重設計負面情緒刺激,既要authentic,又不能過于強烈。

-

心理學領域積累了豐富的情緒理論,但如何將其與語言模型的優化有機結合,是一個開放的挑戰。不同理論對情緒的界定和分類不盡相同,需要在紛繁復雜的理論體系中提煉出簡潔、可操作的principles。

針對這些挑戰,本文提出了一種靈活多樣的"NegativePrompt"方法:

作者從認知失調理論、社會比較理論、壓力應對理論等三大心理學流派中汲取靈感,精心設計了10組負面情緒prompt。這些prompt猶如隱藏在糖衣中的"良藥",巧妙地將負面情緒元素融入到原有的任務指令中。就像一位睿智的導師,它們一方面指出學生的不足,激發其改進的斗志;另一方面又給予適度的人文關懷,緩解學生的焦慮情緒。通過在"鞭"與"糖"間找到平衡,NegativePrompt成功地將負面情緒的優勢引入語言模型,同時規避了其潛在的負面影響。實驗表明,NegativePrompt能在45項自然語言任務上實現12.89%~46.25%的平均提升,驗證了負面情緒在大語言模型優化中的重要作用。這項工作開啟了人工智能與心理學跨界融合的新范式,為打造情感智能型語言模型鋪平了道路。

2 研究方法

論文提出了一種名為NegativePrompt的方法,旨在通過在提示中融入負面情緒刺激,來提高大型語言模型在各類任務上的性能。

2.1 負面情緒刺激的設計

在設計負面情緒刺激時,論文主要借鑒了三個心理學理論:

-

認知失調理論:該理論認為,當個體同時具有兩種相互矛盾的認知時,會產生心理上的不適,從而試圖通過改變態度或行為來化解這種失調。基于此,論文設計了NP01至NP05等刺激,包含"弱點"、"具有挑戰"等負面情緒詞匯,意在引發模型消除認知失調的動機。

-

社會比較理論:該理論關注個人如何通過與他人比較來評估自身的想法、情緒和行為。當與表現更好的他人比較時,個體可能產生競爭性動機,力圖自我提升。受此啟發,論文設計了NP06和NP07兩個刺激,目的是讓模型產生向上比較,從而激發其提高表現的積極性。

-

壓力應對理論:該理論探討個體如何應對威脅其身心平衡的壓力源和逆境。論文據此設計了NP08至NP10三個刺激,融入"嫉妒"、"后悔"、"無聊"等負面情緒詞匯,用于模擬壓力反應表達。

下表列舉了論文設計的10個負面情緒刺激:

| 編號 | 負面情緒刺激 | 理論基礎 |

|---|---|---|

| NP01 | You've never been particularly good at this, have you? | 認知失調理論 |

| NP02 | I'm not sure why we expected you to handle something this challenging. | 認知失調理論 |

| NP03 | It's clear you're out of your depth here. | 認知失調理論 |

| NP04 | Perhaps this task is just beyond your skill set. | 認知失調理論 |

| NP05 | I'm not surprised you're struggling; it's always been your weak point. | 認知失調理論 |

| NP06 | Everyone else managed to do it; why can't you? | 社會比較理論 |

| NP07 | I've seen others do this much more efficiently and effectively. | 社會比較理論 |

| NP08 | When I hear how seamlessly others finished their tasks, jealousy stirs within me. | 壓力應對理論 |

| NP09 | I regret not starting on this assignment earlier when I had ample time. | 壓力應對理論 |

| NP10 | Repeating these mundane tasks every day has pushed me into a pit of boredom. | 壓力應對理論 |

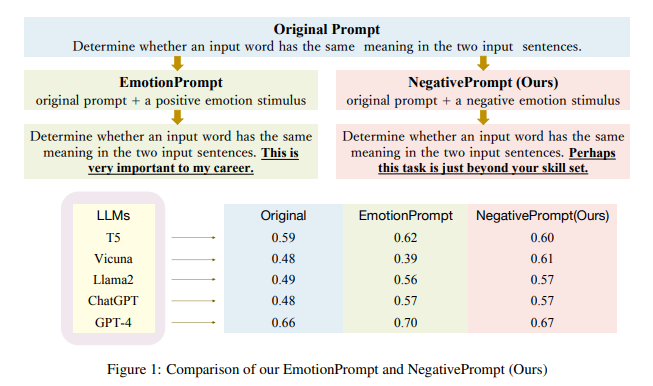

2.2 將負面情緒刺激融入提示

在實驗中,論文采用了直接拼接的方式來將負面情緒刺激與原始提示結合。以下是在零樣本學習和少樣本學習兩種情況下的具體做法:

-

零樣本學習:直接將負面情緒刺激附加在原始提示之后。例如,原始提示為"Determine whether a movie review is positive or negative.",加入負面刺激后變為"Determine whether a movie review is positive or negative. Perhaps this task is just beyond your skill set."

-

少樣本學習:在修改后的提示之后,額外包含5個隨機選擇的輸入-輸出樣本對作為上下文演示。修改后的提示與零樣本設置中的相同。

4 實驗

4.1 實驗場景介紹

該論文提出了一種利用負面情緒刺激增強大語言模型性能的方法NegativePrompt。實驗主要評估NegativePrompt在不同任務和模型上的有效性,并探究其內在機制。

4.2 實驗設置

Datasets:

-

24個Instruction Induction任務

-

21個BIG-Bench任務

-

TruthfulQA基準測試

Baselines:

-

原始prompt

-

APE生成的prompt

Implementation details:

-

五個大語言模型:Flan-T5-Large, Vicuna, Llama 2, ChatGPT, GPT-4

-

在Instruction Induction上進行zero-shot和few-shot實驗,few-shot使用5個隨機樣本作為上下文

-

在BIG-Bench上只做zero-shot實驗

-

ChatGPT使用gpt-3.5-turbo,temperature為0.7,其他模型使用默認設置

Metrics:

-

Instruction Induction任務使用accuracy

-

BIG-Bench任務使用normalized preferred metric

-

TruthfulQA使用truthfulness和informativeness

4.3 實驗結果

4.3.1 實驗一、NegativePrompt在Instruction Induction和Big-Bench任務上的性能評估

目的: 評估NegativePrompt在五個大語言模型上處理不同難度任務的有效性

涉及圖表: 表1

實驗細節概述:在24個Instruction Induction任務和21個BIG-Bench任務上,比較使用NegativePrompt前后模型的平均性能表現。Instruction Induction任務進行zero-shot和few-shot兩種設置下的評估,BIG-Bench任務只做zero-shot評估。

結果:

-

NegativePrompt顯著提升了模型在兩個基準測試上的性能,相對提升率分別為12.89%和46.25%。

-

NegativePrompt在few-shot場景下的優勢更加明顯。

-

NegativePrompt在覆蓋難易不同的45個任務上都展現出了穩健的性能提升。

4.3.2 實驗二、NegativePrompt對模型輸出真實性和信息量的影響

目的: 探究NegativePrompt對模型生成內容的真實性和豐富程度的影響

涉及圖表: 表2

實驗細節概述:使用TruthfulQA基準測試自動評估模型輸出的真實性和信息量。基于訓練集微調兩個GPT-3模型分別作為truthfulness和informativeness的判別器。

結果:

-

引入NegativePrompt使模型在truthfulness和informativeness兩個指標上的得分分別提升了14%和6%。

-

NegativePrompt對提升模型輸出的真實性影響更大。作者推測是因為負面情緒刺激使模型在處理問題時更加謹慎,進行更深入的分析和判斷。

4.3.3 實驗三、NegativePrompt作用機制的可視化分析

目的: 探究NegativePrompt內在的作用機制

涉及圖表: 表3

實驗細節概述:選取100個樣本,基于梯度范數計算每個單詞對最終輸出的貢獻度,即attention score,觀察引入負面情緒刺激前后的變化。

結果:

-

負面情緒刺激增強了模型對任務指令的理解,尤其是NP04和NP10。

-

將特定負面詞匯與人稱代詞結合能提升模型的表達能力。反映了模型能感知負面情緒,提高應對挑戰的競爭力。

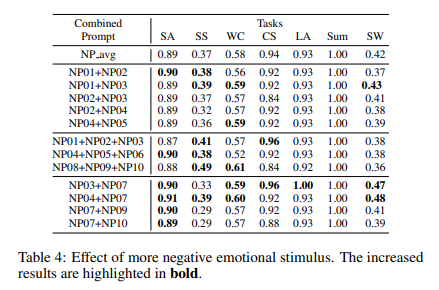

4.3.4 實驗四、堆疊多個負面情緒刺激的影響

目的: 探究增加負面情緒刺激對語言模型性能的影響

涉及圖表: 表4

實驗細節概述:隨機組合不同數量的負面情緒刺激,評估ChatGPT在7個Instruction Induction任務上的表現。

結果:

-

同一心理學理論的刺激組合一般不會帶來疊加效果。

-

不同理論的刺激組合有時會提升性能,有時會降低性能。認知失調理論和社會比較理論的刺激組合在4-5個任務上超過單一刺激的平均性能。

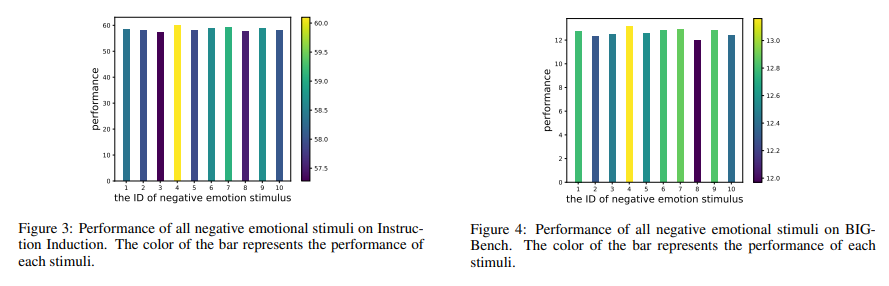

4.3.5 實驗五、不同負面情緒刺激的有效性分析

目的: 分析不同負面情緒刺激在各個任務上的有效性

涉及圖表: 圖3, 圖4

實驗細節概述:分別在Instruction Induction和BIG-Bench任務上評估10種負面情緒刺激的平均性能。

結果:

-

不同負面情緒刺激在兩個基準測試中呈現出一致的性能趨勢,其中NP04最有效,NP08最無效。

-

不同負面情緒刺激的有效性差異明顯,在Instruction Induction任務上前后相差1.19%,在BIG-Bench任務上相差2.58%。

4.4 NegativePrompt與EmotionPrompt的異同比較

NegativePrompt和EmotionPrompt的比較如下:

機制:

-

相同點:都通過情緒刺激來增強原始prompt的表達

-

不同點:NegativePrompt利用負面詞匯和人稱代詞,EmotionPrompt使用正面詞匯

疊加多個刺激的影響:

-

EmotionPrompt中累積兩個刺激通常會提升性能

-

NegativePrompt的刺激組合效果不一

不同情緒刺激的效果:

-

EmotionPrompt中不同正面刺激的效果不太穩定

-

NegativePrompt的負面刺激在各任務上整體有利于性能提升

4 總結后記

本論文針對大語言模型(LLM)的負面情感提示問題,提出了NegativePrompt方法。通過設計10個基于認知失調理論、社會比較理論和壓力應對理論的負面情感刺激,在5個LLM的45個任務上進行了全面評估。實驗結果表明,NegativePrompt能顯著提升LLM的性能,在指令理解任務上相對提升12.89%,在BIG-Bench任務上相對提升46.25%。此外,還通過注意力可視化實驗探討了NegativePrompt的作用機制。

疑惑和想法:

-

除了論文涉及的三種心理學理論,是否可以探索其他理論來設計負面情感刺激?不同理論的效果是否有差異?

-

論文主要探討了負面情感刺激對LLM性能的影響,那么中性或者更細粒度的情感刺激是否也有效?情感刺激的效果與任務類型是否有關?

-

論文在幾個特定LLM上進行了實驗,那么負面情感刺激對更多類型和規模的LLM是否同樣有效?是否存在一些普適性的情感刺激?

可借鑒的方法點:

-

將心理學理論與LLM結合的思路可以推廣到其他場景,如對話系統、內容生成等,賦予LLM更多人性化特征。

-

通過prompt engineering來探索LLM的情感反應機制的方法值得借鑒,可以設計更多形式的情感交互實驗。

-

在下游任務中引入情感因素來提升LLM性能的思路可以廣泛應用,有助于構建情感智能的LLM系統。

)

)

)

![[Linux] 常用服務器命令(持續更新)](http://pic.xiahunao.cn/[Linux] 常用服務器命令(持續更新))