本文主要介紹通過python實現tokens統計,避免重復調用openai等官方api,開源節流。

一、設計思路

- 初始化tokenizer

- 使用tokenizer將文本轉換為tokens

- 計算token的數量

二、業務場景

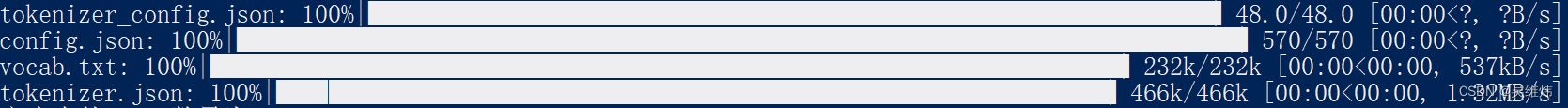

2.1 首次加載依賴

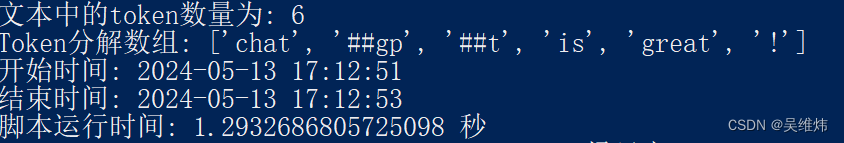

2.2 執行業務邏輯

三、核心代碼

from transformers import AutoTokenizer

import time

from datetime import datetime# 獲取開始時間,并格式化為"年-月-日 時:分:秒"

start_time = time.time()

start_datetime = datetime.fromtimestamp(start_time).strftime('%Y-%m-%d %H:%M:%S')# 初始化tokenizer

tokenizer = AutoTokenizer.from_pretrained('bert-base-uncased')# 示例文本

text = "ChatGPT is great!"# 使用t

:樹的概念和二叉樹初見)

)

![C++ 日志庫 log4cpp 編譯、壓測及其范例代碼 [全流程手工實踐]](http://pic.xiahunao.cn/C++ 日志庫 log4cpp 編譯、壓測及其范例代碼 [全流程手工實踐])

)

)

)