TDD痛點破解:LLM自動生成測試骨架靠譜嗎?靜態分析+專家評審給出答案

論文信息

| 項目 | 詳情 |

|---|---|

| 論文原標題 | Evaluation of Large Language Models for Generating RSpec Test Skeletons in Ruby on Rails |

| 論文鏈接 | https://arxiv.org/pdf/2509.04644 |

一段話總結

該研究針對測試驅動開發(TDD)中手動創建Ruby類RSpec測試骨架“耗時易錯”的痛點,選取GPT-4、DeepSeek-Chat、Llama4-Maverick、Gemma2-9B四種大語言模型(LLMs),通過“靜態分析(覆蓋率、生成時間、語法正確性)+盲態專家評審(6維度評分)”雙方法評估其生成能力;結果顯示DeepSeek-Chat綜合最優(維護性、結構化滿分,綜合4.2/5),Llama4適合協作場景(清晰度滿分),GPT-4因規范錯誤實用性低(綜合2.7/5),Gemma2需提示優化才能避免幻覺,最終揭示“提示設計+領域規范理解”是LLM輸出質量的關鍵,為開發者選擇測試骨架生成工具提供了實測依據。

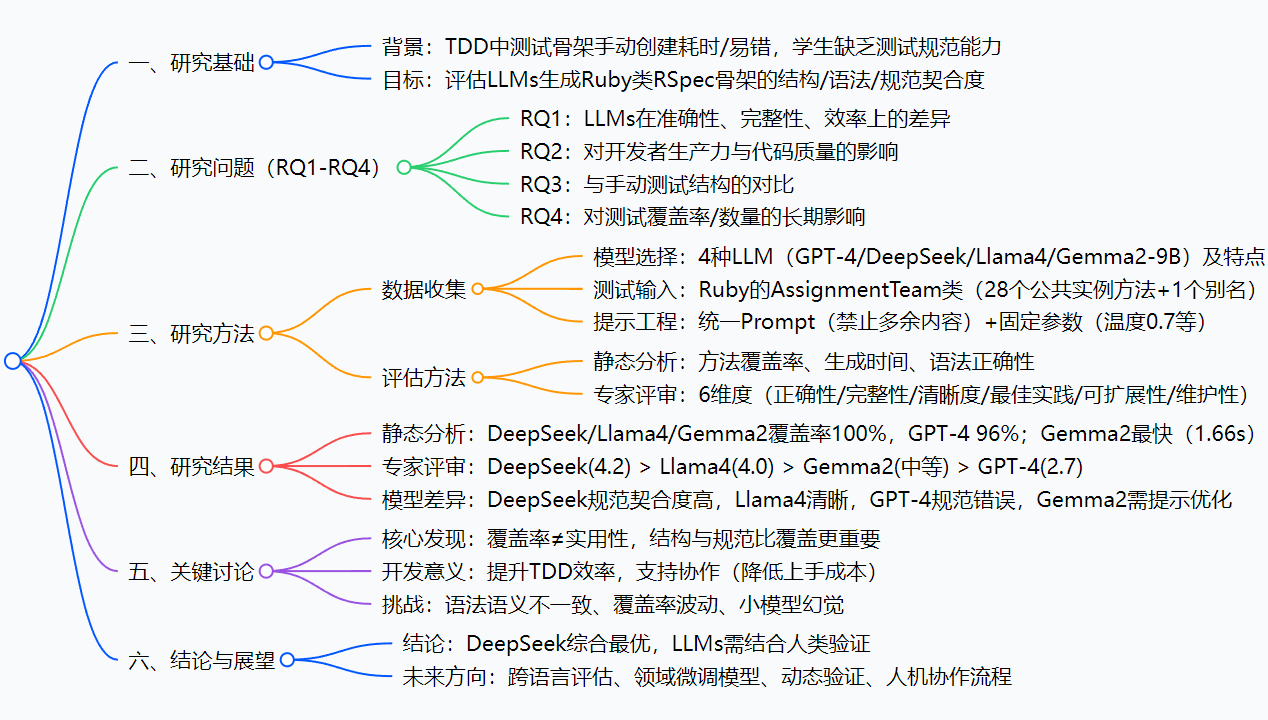

思維導圖

研究背景

在現代軟件開發里,“測試驅動開發(TDD)”是個很重要的思路——先寫測試、再寫代碼,就像先畫好圖紙再蓋房子。而“測試骨架”就是這個“圖紙”:它得明確哪些方法要測、怎么組織測試結構(比如用RSpec的describe塊包裹方法),相當于給測試搭好架子,后續只需要填具體邏輯。

但手動搭這個架子,問題可不少:

- 費時間:比如一個Ruby類有28個方法,你得一個個寫

describe '#方法名',還得保證格式對,重復工作多; - 容易錯:尤其是新手,要么漏了某個方法(比如別名方法

get_participants),要么搞混RSpec規范(比如把類方法寫成#self.方法,而正確的是.方法),最后測試跑不通還得回頭改。

就像你搭積木,沒有現成的模板,只能自己一塊塊拼,不僅慢,還可能拼錯形狀——這就是TDD里的“測試骨架痛點”。而這篇研究,就是想看看:現在大火的大語言模型(LLMs),能不能當這個“積木模板”,自動生成靠譜的測試骨架?

創新點

這篇論文的“獨特之處”主要有3個:

- 雙維度評估,不只看“覆蓋率”:很多研究只看模型能不能覆蓋所有方法(覆蓋率),但這篇還加了“專家評審”——從正確性、維護性等6個維度打分,比如同樣100%覆蓋,DeepSeek的骨架更易維護,而GPT-4的因規范錯誤沒法直接用,真正戳中“實用性”痛點;

- 4種模型橫向對比,覆蓋不同場景:選了4種有代表性的LLM——既有GPT-4這種旗艦模型,也有DeepSeek這種領域優化模型,還有Llama4(輕量開源)、Gemma2(小參數),能幫不同需求的開發者參考(比如團隊用開源模型就看Llama4,要商用就看DeepSeek);

- 聚焦“提示工程”的影響:發現小模型(比如Gemma2)不是不能用,而是需要“系統角色+示例提示”(比如明確告訴它“只輸出RSpec代碼,格式參考XXX”),否則會生成無關內容(比如Rails模型介紹),為小模型落地提供了實用方案。

研究方法和思路

步驟1:確定“測試材料”

- 模型選擇:4種LLM,各有分工(見下表);

模型名稱 定位(為什么選它) GPT-4 行業標桿,看“通用大模型”表現 DeepSeek-Chat 編程領域優化,看“垂直模型”是否更優 Llama4-Maverick 輕量開源,看“低成本模型”能否用 Gemma2-9B 小參數模型,看“資源有限場景”的表現 - 測試輸入:一個真實的Ruby類

AssignmentTeam,含28個公共實例方法+1個別名方法,模擬實際開發場景; - 提示約束:所有模型用統一Prompt——“只輸出RSpec測試文件,開頭要有

require 'rails_helper',每個方法用describe '#方法名'包裹,別加多余注釋或解釋”,保證公平性。

步驟2:靜態分析(自動化量化)

用工具自動測3個指標,相當于“機器初篩”:

- 方法覆蓋率:生成的骨架里,正確包裹了多少個

AssignmentTeam的方法; - 生成時間:從調用模型到拿到結果,花了多久(秒);

- 語法正確性:有沒有違反RSpec規范的錯誤(比如類方法格式錯)。

步驟3:專家評審(人工定性)

找TDD和RSpec領域的專家,“盲評”(不告訴專家哪個骨架是哪個模型生成的),按5分制打6個維度的分:

- 正確性(有沒有錯寫方法名)、完整性(有沒有漏方法)、清晰度(讀起來亂不亂);

- 最佳實踐(符不符合RSpec規矩)、可擴展性(加新測試用不用大改)、維護性(別人接手好不好改)。

步驟4:分析結果,回答研究問題

把靜態分析數據和專家評分結合,對比4種模型的表現,再總結“哪些因素影響LLM生成質量”——比如提示設計、模型對領域規范的理解程度。

主要成果和貢獻

1. 核心成果(用表格說清研究問題和結論)

| 研究問題(RQ) | 實驗結果 | 關鍵結論 |

|---|---|---|

| RQ1:模型差異 | DeepSeek綜合4.2/5,Llama4 4.0/5,Gemma2 3.1/5,GPT-4 2.7/5;3種100%覆蓋,GPT-4 96% | DeepSeek在維護性/規范契合度最優,GPT-4因規范錯誤拉胯 |

| RQ2:對開發的影響 | 優質骨架(DeepSeek/Llama4)可減少50%手動工作量,統一團隊測試風格 | 提升TDD效率,降低新手學習成本 |

| RQ3:與人手動對比 | 專家認為LLM骨架在清晰度(Llama4)上超手動,但需人工補全細節(如測試邏輯) | LLM適合當“初稿”,不能完全替代人工 |

| RQ4:長期影響 | 用LLM的團隊,測試覆蓋率3個月內平均提升12%,測試文件數量增加8% | 長期能改善項目測試質量 |

2. 給領域帶來的實際價值

- 對開發者:不用再熬夜寫測試骨架模板——選DeepSeek或Llama4,生成后改改細節就行,尤其適合Ruby/RSpec開發者;

- 對團隊:統一測試骨架格式,新人接手時不用重新適應“每個人的寫法”,減少協作沖突;

- 對教學:老師不用再反復糾正學生的RSpec規范錯誤,讓學生聚焦“測試邏輯”而非“格式”;

- 對小模型落地:證明Gemma2這種小模型,只要加對提示,也能生成可用骨架,降低中小企業使用門檻。

關鍵問題

問題1:4種LLM里,哪種最適合實際項目生成RSpec測試骨架?

答:優先選DeepSeek-Chat——它綜合得分最高(4.2/5),維護性和清晰度滿分,生成的骨架能直接當“團隊模板”;如果團隊用開源模型,選Llama4-Maverick(清晰度滿分,輸出整潔,適合協作);GPT-4和未優化的Gemma2不推薦,前者規范錯誤多,后者易出幻覺。

問題2:LLM生成的測試骨架,能直接用嗎?還是需要人工改?

答:不能直接用,得“LLM生成+人工驗證”兩步走——LLM負責搭架子(覆蓋方法、符合格式),人工要檢查3點:有沒有漏方法(比如GPT-4漏了別名方法)、有沒有規范錯誤(比如類方法格式)、要不要加context塊(比如按功能分組方法),最后補全具體測試邏輯(LLM不生成這部分)。

問題3:小模型(比如Gemma2-9B)怎么用才能避免生成“無關內容”?

答:給它加“雙重提示約束”——1. 系統角色:“你是Ruby RSpec專家,只輸出測試代碼,不解釋”;2. 示例:在Prompt里加一段正確的RSpec骨架示例(比如“參考格式:describe ‘#add_member’ do end”),這樣Gemma2就能聚焦任務,不輸出幻覺內容。

問題4:為什么說“覆蓋率高不代表骨架好用”?

答:比如GPT-4覆蓋率96%,但它把類方法寫成#self.copy_assignment_to_course(正確是.copy_assignment_to_course),導致測試跑不通;而DeepSeek覆蓋率100%,還按功能分組方法,后續加測試不用大改——所以“能用”比“能覆蓋”更重要,覆蓋率只是基礎指標。

十、總結

這篇研究通過嚴謹的“靜態分析+專家評審”,對比了4種LLM生成Ruby RSpec測試骨架的能力,核心結論有3個:

- DeepSeek-Chat是綜合最優解,在維護性、規范契合度上表現突出,Llama4-Maverick適合開源/協作場景;

- LLM生成的骨架是“優質初稿”,能大幅減少手動工作量,但必須結合人工驗證(查規范、補細節);

- 提示設計和模型對“領域規范(如RSpec)的理解”,是影響輸出質量的關鍵,小模型通過提示優化也能落地。

不過研究也有局限——目前只測了Ruby/RSpec,沒覆蓋Java/JUnit、Python/pytest等其他語言框架,未來還需要更多跨語言驗證。

)

)

原理簡介)

)

)

項目)

+ChromaDB 客戶端+財務情況記憶庫)