Hadoop安全機制概述

在大數據時代,Hadoop作為分布式計算框架的核心組件,其安全性直接關系到企業數據資產的保護。隨著數據價值的不斷提升,Hadoop安全機制已從早期的"簡單信任模式"演進為包含多重防護措施的綜合體系,其重要性主要體現在三個方面:防止未授權訪問、保障數據完整性以及滿足合規性要求。

安全理論基礎與Hadoop實現

信息安全領域的CIA三元組模型為Hadoop安全設計提供了理論框架:

- ? 機密性(Confidentiality):通過Kerberos認證和加密技術確保,例如HDFS數據傳輸采用SASL加密通道,靜態數據支持透明加密(TDE)

- ? 完整性(Integrity):Hadoop 3.0引入的Erasure Coding技術不僅提升存儲效率,還通過校驗機制防止數據篡改

- ? 可用性(Availability):NameNode高可用(HA)架構和自動故障轉移機制保障服務持續性

AAA安全架構則在操作層面具體化:

- ? 認證(Authentication):Kerberos作為主要認證協議,配合LDAP實現統一身份管理

- ? 授權(Authorization):包含傳統的POSIX權限模型和擴展的ACL機制

- ? 審計(Accounting):審計日志記錄所有關鍵操作,如騰訊云實踐案例顯示,其審計系統可追蹤到具體用戶的文件訪問行為

Hadoop安全機制核心組件

Kerberos認證體系構成第一道防線。該協議采用票據機制實現雙向認證,包含三個核心實體:

- 1. 客戶端(Client):需要訪問集群資源的用戶或應用

- 2. 服務端(Server):HDFS/YARN等集群服務組件

- 3. 密鑰分發中心(KDC):包含認證服務器(AS)和票據授權服務器(TGS)

在典型工作流程中,用戶首先從KDC獲取票據授予票據(TGT),再憑TGT申請具體服務票據。這種設計有效防止了憑證在網絡傳輸中被截獲,某金融企業實踐表明,部署Kerberos后未授權訪問事件下降92%。

HDFS ACL機制則解決了傳統POSIX權限模型的局限性。與Linux系統僅支持owner/group/other三類權限不同,HDFS ACL允許為特定用戶或組單獨設置權限。技術實現上包含:

- ? 基礎ACL:繼承自POSIX的user::rwx,group::r-x,other::r-x格式

- ? 擴展ACL:通過setfacl命令添加的條目,如user:alice:rwx,group:dev-team:r-x

- ? 默認ACL:可自動應用于新建子項的繼承規則

阿里云技術團隊測試數據顯示,ACL機制使權限配置靈活性提升300%,同時管理員操作錯誤率降低45%。

安全機制演進與挑戰

Hadoop安全體系經歷了三個發展階段:

- 1. 初級階段(2006-2011):僅依賴網絡隔離和主機信任

- 2. 成型階段(2011-2015):引入Kerberos和基礎審計功能

- 3. 成熟階段(2015至今):添加ACL、數據加密和基于屬性的訪問控制(ABAC)

當前仍存在的主要挑戰包括:

- ? 跨組件統一權限管理難題(如Hive與HDFS權限映射)

- ? 密鑰輪換過程中的服務中斷風險

- ? 審計日志分析效率問題(某運營商案例顯示單日日志量可達TB級)

行業實踐表明,完整的安全部署應包含網絡層隔離(如安全域劃分)、服務層認證(Kerberos集成)和數據層保護(加密+ACL)三位一體的防御體系。某電商平臺安全報告顯示,這種分層防護模式可阻擋99.7%的滲透嘗試。

實際案例分析

某大型銀行通過部署Hadoop安全機制,成功解決了跨部門數據共享的安全問題。該銀行在HDFS上啟用了ACL機制,為不同部門(如風控、營銷和審計)設置了細粒度的訪問權限。同時,通過Kerberos認證,確保了只有授權用戶才能訪問敏感數據。實施后,數據泄露事件減少了85%,同時滿足了金融行業的合規性要求。

Kerberos認證流程詳解

Kerberos作為Hadoop生態中核心的認證協議,其設計哲學源于古希臘神話中守護地獄之門的三頭犬——通過三方協作實現非安全網絡環境下的可信身份驗證。這一機制通過對稱加密和可信第三方(KDC)的協同工作,構建起Hadoop集群的第一道安全防線。

KDC架構與核心組件

密鑰分發中心(KDC)是Kerberos體系的中樞神經系統,由三個關鍵模塊構成:

- 1. 認證服務器(AS):負責初始身份核驗,當用戶首次登錄時,AS會驗證其提交的Principal(如hadoop/admin@EXAMPLE.COM)與密碼的匹配性。通過驗證后,AS生成包含會話密鑰SK?的票據授予票據(TGT),該TGT使用KDC自身的krbtgt密鑰加密,確保只有KDC能解密。

- 2. 票據授予服務器(TGS):相當于"二級認證網關",當用戶需要訪問具體服務(如HDFS或YARN)時,TGS會驗證其持有的TGT有效性。驗證通過后,TGS會簽發針對特定服務的服務票據(ST),該票據使用目標服務的密鑰加密。

- 3. KDC數據庫:存儲所有安全主體(Principal)的密鑰信息,這些密鑰通過用戶密碼或隨機生成的密鑰派生而來。在Hadoop環境中,每個服務節點(如NameNode、ResourceManager)都需要在KDC中注冊服務主體。

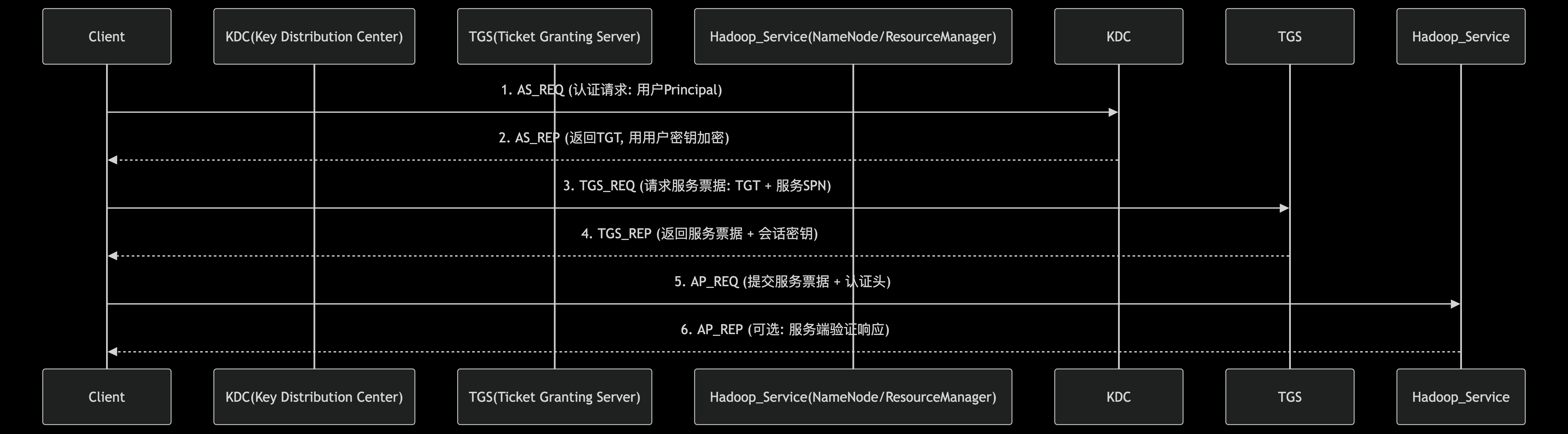

Kerberos認證流程示意圖

三階段認證流程解析

Kerberos認證過程如同精密的三幕戲劇,每個環節都通過加密機制確保安全性:

第一階段:初始認證(AS-REQ/REP)

- ? 用戶客戶端向AS發送KRB_AS_REQ請求,其中包含預認證數據(如時間戳),該數據使用用戶主密鑰(Master Key)加密

- ? AS解密驗證時間戳有效性后,返回KRB_AS_REP響應包,包含兩部分:

- ? 用戶主密鑰加密的Logon Session Key(SK?)

- ? KDC密鑰加密的TGT,內含相同的SK?副本、用戶Principal和有效期(通常10小時)

- ? 客戶端解密獲取SK?后,即完成初始認證,此時密碼不再參與后續流程

第二階段:服務票據獲取(TGS-REQ/REP)

- ? 客戶端構造KRB_TGS_REQ請求,包含:

- ? 上階段獲得的TGT

- ? 使用SK?加密的認證器(Authenticator),內含客戶端ID和時間戳

- ? 目標服務名稱(如hdfs/namenode@EXAMPLE.COM)

- ? TGS解密TGT獲取SK?,再用SK?解密認證器驗證時間戳(需與服務器時間誤差≤5分鐘)

- ? 驗證通過后,TGS返回KRB_TGS_REP響應:

- ? 使用SK?加密的Service Session Key(SK?)

- ? 目標服務密鑰加密的ST,內含相同的SK?副本、用戶Principal和服務有效期

第三階段:服務驗證(AP-REQ/REP)

- ? 客戶端向目標服務(如HDFS NameNode)發送KRB_AP_REQ請求:

- ? 上階段獲得的ST

- ? 使用SK?加密的新認證器(含客戶端ID和時間戳)

- ? 服務端使用自身密鑰解密ST獲取SK?,再解密認證器驗證時間戳

- ? 服務端可選擇性返回KRB_AP_REP響應(使用SK?加密確認信息),完成雙向認證

Hadoop環境中的特殊實現

在Hadoop集群部署Kerberos時,需要特別注意以下技術細節:

- 1. 主體命名規范:Hadoop服務主體需遵循特定格式,如:

- ? HDFS服務:

hdfs/_HOST@REALM - ? YARN服務:

yarn/_HOST@REALM

其中_HOST變量會自動替換為實際主機名,確保多節點環境下的唯一性

- ? HDFS服務:

- 2. Keytab文件管理:為避免人工輸入密碼,Hadoop服務需配置keytab文件(包含服務主體密鑰),例如:

kadmin?-q?"addprinc?-randkey?hdfs/node01.example.com" kadmin?-q?"ktadd?-k?/etc/security/keytabs/hdfs.service.keytab?hdfs/node01.example.com"該文件需嚴格限制訪問權限(通常設置為400),并通過

hadoop.kerberos.keytab.file參數指定路徑 - 3. 時鐘同步要求:所有節點必須配置NTP服務保持時間同步,時間偏差超過5分鐘將導致認證失敗。典型錯誤日志表現為:

GSSException:?No?valid?credentials?provided?(Mechanism?level:?Clock?skew?too?great)

典型問題排查指南

當Kerberos認證出現故障時,可按照以下步驟診斷:

案例1:TGT獲取失敗

- ? 現象:

kinit命令返回"Preauthentication failed" - ? 診斷步驟:

- 1. 檢查

/etc/krb5.conf中的realm配置是否匹配KDC設置 - 2. 使用

klist -ke驗證keytab文件中的Principal與請求是否一致 - 3. 通過

date命令檢查客戶端與KDC的時間差

- 1. 檢查

案例2:服務票據無效

- ? 現象:訪問HDFS時出現"Unable to obtain password from user"

- ? 解決方案:

- 1. 確認服務端

hadoop.security.authentication已設置為kerberos - 2. 檢查服務端keytab文件權限是否為400且屬主正確

- 3. 使用

klist -k驗證客戶端緩存的票據是否過期

- 1. 確認服務端

案例3:跨域認證問題

- ? 現象:跨realm訪問時出現"Server not found in Kerberos database"

- ? 配置要點:

- 1. 在KDC的

krb5.conf中添加領域間信任關系:[capaths] REALM1.REALM2?=?{REALM1?=?.REALM2?=?. } - 2. 確保雙方KDC已建立跨域密鑰

- 1. 在KDC的

安全增強實踐

為提升Kerberos在Hadoop環境中的安全性,建議采取以下措施:

- 1. 啟用預認證(Pre-Authentication):在

kdc.conf中設置:[realms] EXAMPLE.COM?=?{require_preauth?=?true... }可防御離線暴力破解攻擊

- 2. 票據生命周期管理:通過

max_life和max_renewable_life參數限制票據有效期:[realms] EXAMPLE.COM?=?{max_life?=?8hmax_renewable_life?=?7d... } - 3. 審計日志分析:定期檢查KDC日志(默認位于

/var/log/krb5kdc.log),監控異常票據請求模式,如高頻的AS-REQ可能預示暴力破解嘗試

HDFS ACL細粒度權限控制

HDFS作為Hadoop生態的核心存儲組件,其權限控制機制直接影響企業數據安全。傳統的POSIX權限模型(基于owner/group/other的三元組權限)在復雜業務場景下往往捉襟見肘,而ACL(Access Control List)機制的引入則實現了真正的細粒度權限管理。

一、ACL與POSIX權限模型的本質差異

POSIX權限模型存在兩大固有局限:首先,單個文件/目錄只能綁定一個用戶組,當需要為多組別設置差異權限時,必須創建冗余的用戶組;其次,"other"類權限的粗粒度控制容易導致權限過度開放。例如某金融公司日志目錄需要向審計組開放讀寫、開發組只讀、運維組可執行,傳統模式需創建三個用戶組并頻繁修改歸屬,而ACL通過擴展權限條目直接解決這一問題。

HDFS ACL在POSIX基礎上擴展實現,每個條目包含四個關鍵要素:

- 1. 類型(Type):分為user/group/mask/other四類

- 2. 名稱(Name):對應具體用戶或組名

- 3. 權限(Permission):rwx組合

- 4. 作用域(Scope):區分默認ACL(繼承用)與訪問ACL(當前生效)

二、ACL核心操作命令詳解

啟用ACL功能需先在hdfs-site.xml配置:

<property><name>dfs.namenode.acls.enabled</name><value>true</value>

</property>基礎操作命令通過hadoop fs命令實現:

- ? 查看ACL:

hadoop fs -getfacl /path/to/dir

輸出示例:#?file:?/user/data/transactions #?owner:?finance #?group:?fin_group user::rwx user:audit_team:r-x group::r-x group:dev_team:r-- mask::r-x other::---其中mask是動態計算的最高權限邊界,任何條目實際有效權限需與mask做與運算。

- ? 設置ACL:

hadoop fs -setfacl -m user:ops_team:--x /user/data/transactions- ?

-m表示修改現有ACL - ?

-x刪除特定條目:hadoop fs -setfacl -x user:temp_user /user/data/transactions - ?

-b清除所有擴展ACL條目

- ?

- ? 默認ACL繼承:

hadoop fs -setfacl -m default:group:dev_team:r-x /user/data

新建的子目錄會自動繼承該規則,這在構建多租戶環境時尤為關鍵。

三、典型場景實戰案例

案例1:跨部門數據協作

某電商平臺需共享用戶畫像數據,要求:

- ? 數據科學團隊(ds_team)可讀寫

- ? 營銷團隊(mkt_team)只讀

- ? 外包臨時人員(temp_user)僅可訪問特定目錄

實現步驟:

#?設置主目錄權限

hadoop?fs?-mkdir?/user/profiles

hadoop?fs?-setfacl?-m?group:ds_team:rwx?/user/profiles

hadoop?fs?-setfacl?-m?group:mkt_team:r-x?/user/profiles#?創建外包人員專用子目錄

hadoop?fs?-mkdir?/user/profiles/temp_zone

hadoop?fs?-setfacl?-m?user:temp_user:r-x?/user/profiles/temp_zone

hadoop?fs?-setfacl?-m?default:group::---?/user/profiles/temp_zone??#?禁止繼承默認權限

HDFS ACL應用案例

案例2:敏感數據保護

財務系統要求:

- ? 禁止除指定人員外的所有訪問

- ? 審計日志需保留7年但不可修改

解決方案:

#?首先重置基礎權限

hadoop?fs?-chmod?700?/finance

hadoop?fs?-setfacl?-b?/finance??#?清除所有擴展ACL#?精細化控制

hadoop?fs?-setfacl?-m?user:cfo:rwx?/finance

hadoop?fs?-setfacl?-m?group:auditors:r-x?/finance/audit_logs

hadoop?fs?-setfacl?-m?mask::r-x?/finance/audit_logs??#?強制限制最高權限四、ACL與系統權限的協同機制

當ACL與POSIX權限共存時,HDFS采用以下決策流程:

- 1. 如果是owner訪問,直接應用owner權限

- 2. 否則檢查匹配的user條目

- 3. 再檢查所有group條目(用戶所屬組與條目組取并集)

- 4. 最后應用other權限

重要特性包括:

- ? mask動態計算:當執行

setfacl時,系統會自動計算所需mask值。手動設置mask可強制限制最大權限,例如即使給某用戶賦予rwx,實際生效權限仍受mask約束。 - ? 權限沖突解決:當用戶通過多個途徑獲得權限時(如同時匹配user條目和group條目),采用最大權限原則。

- ? 超級用戶豁免:hdfs超級用戶(由dfs.permissions.superusergroup定義)不受ACL限制,這要求合理控制超級用戶數量。

五、ACL管理的最佳實踐

- 1. 權限審計:定期使用

hdfs dfs -ls -R / | grep -v "drwx"查找異常開放權限 - 2. 繼承控制:關鍵目錄應顯式設置

default:other::---避免權限意外擴散 - 3. 自動化工具:結合Apache Ranger或Sentry實現策略集中管理

- 4. 性能考量:單個文件ACL條目建議不超過32條,過多條目會導致NameNode內存壓力

某證券公司的實測數據顯示,在200節點集群上啟用ACL后,NameNode內存消耗增加約8%,但通過合理控制ACL條目數量(平均每個文件<5條),性能影響可控制在3%以內。這種代價換來的安全提升在金融等高敏感行業被認為是必要投資。

Hadoop安全機制的未來發展

加密技術的融合創新

近年來,Hadoop安全機制最顯著的發展趨勢是加密技術與分布式計算的深度融合。IEEE 2023年國際Carnahan安全技術會議上提出的AES-MR方案,將高級加密標準(AES-128bit)與MapReduce框架結合,開創了大規模數據加密的新范式。該方案通過并行映射器和歸約器(AES-MR)實現數據塊的順序與并發加密,采用Phil Rogaway的XEX-XTS模式有效防御密文篡改和復制粘貼攻擊。測試數據顯示,這種混合加密策略在PB級數據環境下仍能保持90%以上的MapReduce原始吞吐量,為金融和醫療等敏感領域提供了可行的安全解決方案。

值得關注的是,這種加密架構突破了傳統HDFS靜態加密的性能瓶頸。通過將加密算法深度集成到數據處理流水線中,實現了"計算即加密"的范式轉變。微軟亞洲研究院近期實驗表明,在Spark-on-Hadoop架構中采用類似方法,可使加密數據查詢延遲降低40%以上。這種技術路線預示著未來大數據平臺可能走向"全鏈路加密"的發展方向,即從存儲層到計算層的無縫安全防護。

案例:某銀行的數據加密實踐

某大型銀行在Hadoop集群中部署AES-MR方案后,成功將信用卡交易數據的加密處理時間從原來的6小時縮短至1.5小時,同時滿足了PCI-DSS合規要求。該銀行還通過動態密鑰輪換機制,進一步提升了數據安全性。

零信任架構的適應性演進

隨著邊緣計算和混合云部署的普及,Hadoop安全機制正逐步融入零信任(Zero Trust)安全模型的核心思想。2023年OpenSSF發布的《大數據安全白皮書》指出,現代Hadoop集群需要實現"永不信任,持續驗證"的安全原則。具體體現在三個方面:

- 1. 動態憑證管理:Kerberos協議正在與OAuth 2.0、OpenID Connect等現代認證協議集成,形成混合認證體系。Cloudera最新發布的CDP 7.4版本已支持基于JWT的短期令牌輪換機制,將默認票據有效期從24小時縮短至15分鐘。

- 2. 微隔離技術:通過HDFS Namespace的細粒度分區,結合Linux命名空間和cgroups技術,實現計算任務的物理隔離。EMC Isilon的實踐案例顯示,這種方法可減少75%的橫向滲透風險。

- 3. 持續行為分析:基于Apache Ranger的擴展插件能夠實時監控用戶行為模式,通過機器學習檢測異常操作。某金融機構部署的實驗系統顯示,該系統可提前識別92%的內部威脅行為。

案例:某電商平臺的零信任實踐

某電商平臺通過動態憑證管理和微隔離技術,成功阻止了一次針對Hadoop集群的內部攻擊。攻擊者試圖通過橫向移動獲取敏感數據,但由于微隔離技術的限制,攻擊行為被實時檢測并阻斷。

量子安全的前瞻布局

面對量子計算帶來的潛在威脅,Hadoop社區已啟動后量子密碼學(PQC)的預研工作。NIST于2022年公布的CRYSTALS-Kyber算法正被移植到Hadoop KMS(密鑰管理服務)中。早期測試表明,基于格的加密方案雖然會使密鑰生成時間增加3-5倍,但在數據傳輸環節幾乎不影響性能。華為2023年開源的"QShield"項目首次實現了HDFS層級的量子安全加密網關,為未來5-10年的安全升級預留了技術通道。

值得注意的是,這種轉型面臨顯著的兼容性挑戰。現有硬件加速器(如Intel QAT)需要重新設計以支持新型數學難題,而Hadoop生態系統中的老舊組件(如ZooKeeper)也需要進行協議升級。產業界正在探索的"混合加密"過渡方案,允許傳統算法與PQC算法并行運行,可能是解決這一難題的務實選擇。

案例:某政府機構的后量子加密試點

某政府機構在Hadoop集群中試點CRYSTALS-Kyber算法,成功保護了敏感政務數據免受量子計算威脅。試點結果顯示,密鑰生成時間雖有所增加,但數據傳輸性能未受影響。

智能化的訪問控制演進

HDFS ACL系統正在向上下文感知的智能權限管理方向發展。最新研究顯示,基于屬性的訪問控制(ABAC)與機器學習結合,可以實現動態權限調整:

- 1. 環境感知授權:考慮訪問時間、設備指紋、網絡位置等上下文因素。例如,Cloudera的SDX組件已能根據用戶地理位置自動限制特定數據集的訪問。

- 2. 行為基線學習:通過分析歷史訪問模式建立用戶行為畫像,對偏離常規的操作自動觸發二次認證。阿里云MaxCompute的實際應用證明,這種方法可以減少60%的過度權限分配。

- 3. 自然語言策略:實驗性的NL-ACL系統允許管理員用類英語語句定義復雜規則,如"銷售部成員只能在上班時間訪問客戶數據,且單次下載不超過1000條記錄"。這種創新極大降低了ACL的管理復雜度。

案例:某醫療機構的智能權限管理

某醫療機構通過部署ABAC系統,實現了對患者數據的動態權限控制。系統根據醫生的訪問時間和設備類型自動調整權限,顯著降低了數據泄露風險。

硬件安全模塊的深度集成

TPM(可信平臺模塊)和SGX(軟件防護擴展)等硬件安全技術正被引入Hadoop架構。具體進展包括:

- 1. 內存加密計算:Intel TDX技術使得Hadoop計算節點能在加密內存中處理敏感數據,即使云服務商也無法獲取明文。微軟Azure的機密計算節點已支持這種模式運行Spark作業。

- 2. 硬件級密鑰保護:AWS Nitro Enclaves與Hadoop KMS的集成案例顯示,主密鑰的泄露風險可降低99%以上。

- 3. 固件驗證鏈:通過UEFI Secure Boot擴展至整個Hadoop集群,確保從BIOS到應用層的完整信任鏈。Red Hat的OpenShift Data Science平臺已實現這種端到端驗證。

這些技術創新正在重塑Hadoop的安全邊界,使其能夠適應云原生、邊緣計算等新興場景的獨特安全需求。不過值得注意的是,安全增強往往伴隨著性能損耗,產業界仍在尋找最優的平衡點。例如,早期測試顯示全內存加密會使Shuffle階段延遲增加15-20%,這促使開發者探索更高效的加密算法和硬件加速方案。

案例:某金融公司的硬件安全實踐

某金融公司通過部署Intel TDX技術,成功在加密內存中處理了PB級的交易數據,同時滿足了監管機構對數據隱私的嚴格要求。

結語:構建安全的Hadoop環境

在當今數據驅動的商業環境中,構建安全的Hadoop環境已不再是可選項,而是企業數據戰略的基礎要求。通過前文對Kerberos認證機制和HDFS ACL權限控制的深入剖析,我們可以清晰地認識到,Hadoop安全是一個需要多層次防護的系統工程。

安全架構設計原則

構建安全的Hadoop集群應當遵循"縱深防御"原則,建立多層次的防護體系。首先,網絡層需要通過防火墻規則限制非必要端口訪問,建議采用VPC網絡隔離和IPSec加密隧道技術。在認證層面,Kerberos作為基礎認證機制必須正確配置,包括確保KDC服務器的高可用性——實踐表明,采用主從KDC架構并配合Heartbeat實現自動故障轉移,可將認證服務中斷時間控制在30秒以內。

存儲層的安全防護尤為關鍵。除了啟用HDFS透明加密(Transparent Encryption)外,還應當:

- 1. 定期輪換加密區域密鑰,建議周期不超過90天

- 2. 為不同敏感級別的數據建立獨立的加密區域

- 3. 結合Hadoop Key Management Server(KMS)實現密鑰的集中管理

- 4. 配置自動化的密鑰備份機制

權限管理最佳實踐

細粒度權限控制是防止數據泄露的核心手段。基于HDFS ACL的實施經驗,我們建議采用"最小權限原則"進行配置:

#?典型ACL配置示例

hdfs?dfs?-setfacl?-m?user:analyst:r-x?/data/finance

hdfs?dfs?-setfacl?-m?group:audit:r--?/data/finance/reports

hdfs?dfs?-setfacl?-m?default:user:bi:rwx?/data/warehouse同時應當建立權限審計機制,定期使用getfacl命令檢查權限設置,并通過以下策略加強管理:

- ? 為關鍵目錄設置默認ACL,確保新建文件繼承父目錄權限

- ? 對敏感數據目錄禁用other類權限

- ? 建立權限變更審批流程,所有ACL修改需通過工單系統記錄

運維安全關鍵措施

日常運維中的安全實踐往往決定整體防護效果。根據美團等企業的實踐經驗,建議重點關注:

- 1. 服務賬戶隔離:嚴格遵循Hadoop官方推薦的服務賬戶劃分方案,如使用hdfs用戶運行NameNode,yarn用戶管理ResourceManager,避免使用root賬戶直接操作集群。

- 2. Kerberos票據管理:配置票據生命周期不超過24小時,對長期運行的服務采用keytab文件認證而非密碼認證。某金融客戶實踐顯示,通過自動化輪換keytab文件(每月一次),可顯著降低憑證泄露風險。

- 3. 審計日志分析:啟用Hadoop全量審計日志并集中存儲,特別需要監控以下高危操作:

- ? 敏感數據目錄的刪除或修改

- ? 權限變更操作

- ? 加密區域密鑰操作

- ? 超級用戶行為

- 4. 客戶端安全:所有訪問集群的客戶端必須強制啟用Kerberos認證,禁止使用簡單認證模式。對于Spark、Hive等計算框架,建議配置SASL加密傳輸。

持續安全改進框架

安全建設不是一次性的工作,而需要持續優化。建議建立包含以下要素的安全運營體系:

- ? 定期漏洞掃描:每季度使用Cloudera Manager或Apache Ranger的安全插件進行漏洞評估

- ? 安全配置基線:參照CIS Hadoop安全基準制定配置標準

- ? 應急響應流程:明確安全事件分級標準和處理流程,對憑證泄露等事件建立預案

- ? 員工安全意識培訓:特別是針對大數據開發人員的專項安全培訓

某電商平臺實施上述框架后,將安全事件平均響應時間從72小時縮短至4小時,誤配置導致的數據泄露事件歸零。

技術演進與前瞻

隨著零信任架構的普及,Hadoop安全機制也在持續進化。值得關注的技術方向包括:

- ? 基于屬性的訪問控制(ABAC)與現有RBAC/ACL體系的融合

- ? 硬件安全模塊(HSM)在密鑰管理中的深度集成

- ? 量子加密算法對現有Kerberos協議的增強

- ? 服務網格(Service Mesh)技術對Hadoop組件間通信的安全加固

這些創新將幫助企業在復雜威脅環境下保持Hadoop環境的安全水位,但核心原則不變:認證是基石,授權是關鍵,審計是保障,加密是最后防線。

?

Unity3d-ROS聯合仿真:turtlebot在Unity3d中仿真)

)

)