亞馬遜云科技提供眾多免費云產品,可以訪問:亞馬遜云科技

在剛剛過去的 Amazon re:Invent 期間,Amazon 首席執行官 Andy Jassy 分享了從 Amazon 自己在全公司開發近 1000 個生成式 AI 應用程序的經驗中汲取的寶貴經驗。從這種廣泛的 AI 部署中,Jassy 提供了三個關鍵觀察結果,這些觀察結果塑造了 Amazon 的企業 AI 實施方法。

首先,隨著您開始擴展生成式 AI 應用程序,計算成本真的很重要。人們非常渴望更好的性價比。第二個實際上很難構建一個真正好的生成式 AI 應用程序。第三個是當我們讓建造者自由選擇他們想要做的事情時,所使用的模型的多樣性。這并不讓我們感到驚訝,因為我們一遍又一遍地學習同樣的教訓,那就是永遠不會有一種工具可以統治世界。

正如 Andy 所強調的那樣,Amazon 提供的廣泛而深入的模型使客戶能夠選擇最能滿足其獨特需求的精確功能。通過密切監控客戶需求和技術進步,亞馬遜云科技 會定期擴展我們精選的模型選擇,以包括有前途的新模型以及公認的行業熱門模型。這種高性能和差異化模型產品的持續擴展有助于客戶保持在 AI 創新的前沿。

這讓我們想到了中國的 AI 初創公司 DeepSeek。DeepSeek 于 2024 年 12 月推出了 DeepSeek-V3,隨后于 2025 年 1 月 20 日發布了 6710 億個參數的 DeepSeek-R1、DeepSeek-R1-Zero 和 1.5-700 億個參數的 DeepSeek-R1-Distill 模型。他們于 2025 年 1 月 27 日添加了基于視覺的 Janus-Pro-7B 模型。這些型號是公開可用的,據報道比同類型號便宜 90-95%。根據 Deepseek 的說法,他們的模型因其推理能力而脫穎而出,這是通過強化學習等創新訓練技術實現的。

現在,您現在可以在 Amazon Bedrock 和 Amazon SageMaker AI 中部署 DeepSeek-R1 模型。Amazon Bedrock 最適合尋求通過 API 快速集成預先訓練的基礎模型的團隊。Amazon SageMaker AI 非常適合需要高級自定義、培訓和部署并訪問底層基礎設施的組織。此外,您還可以使用 Amazon Trainium 和 Amazon Inferentia 通過 Amazon Elastic Compute Cloud (Amazon EC2) 或 Amazon SageMaker AI 經濟高效地部署 DeepSeek-R1-Distill 模型。

借助亞馬遜云科技,您可以使用 DeepSeek-R1 模型來構建、試驗和負責任地擴展您的生成式 AI 創意,方法是使用這種功能強大、經濟高效的模型,同時只需最少的基礎設施投資。您還可以通過在專為安全而設計的 亞馬遜云科技 服務上進行構建,自信地推動生成式 AI 創新。我們強烈建議您將 DeepSeek-R1 模型的部署與 Amazon Bedrock 護欄集成,為您的生成式 AI 應用程序增加一層保護,Amazon Bedrock 和 Amazon SageMaker AI 客戶都可以使用。

現在,您可以通過以下幾種方式選擇如何在 亞馬遜云科技 上部署 DeepSeek-R1 模型:1,用于 DeepSeek-R1 模型的 Amazon Bedrock Marketplace,2,用于 DeepSeek-R1 模型的 Amazon SageMaker JumpStart,3,用于 DeepSeek-R1-Distill 模型的 Amazon Bedrock 自定義模型導入,以及用于 DeepSeek-R1-Distill 模型的 4,Amazon EC2 Trn1 實例。

讓我向您介紹在 亞馬遜云科技 上開始使用 DeepSeek-R1 模型的各種路徑。無論您是構建第一個 AI 應用程序還是擴展現有解決方案,這些方法都可以根據您團隊的專業知識和要求提供靈活的起點。

亞馬遜云科技提供眾多免費云產品,可以訪問:亞馬遜云科技

- Amazon Bedrock Marketplace 中的 DeepSeek-R1 模型 Amazon Bedrock Marketplace 提供 100 多種流行的、新興的和專業的 FM,以及 Amazon Bedrock 中當前選擇的行業領先模型。

您可以輕松發現單個目錄中的模型,訂閱模型,然后在托管終端節點上部署模型。

要在 Amazon Bedrock Marketplace 中訪問 DeepSeek-R1 模型,請轉到 Amazon Bedrock 控制臺,然后在 Foundation models (基礎模型) 部分下選擇 Model catalog(模型目錄)。您可以通過按模型提供程序進行搜索或篩選來快速找到 DeepSeek。

在查看包含模型功能和實施指南的模型詳細信息頁面后,您可以通過提供終端節點名稱、選擇實例數量和選擇實例類型來直接部署模型。

您還可以配置高級選項,以便自定義 DeepSeek-R1 模型的安全性和基礎設施設置,包括 VPC 聯網、服務角色權限和加密設置。對于生產部署,您應該查看這些設置以符合您組織的安全性和合規性要求。

借助 Amazon Bedrock Guardrails,您可以獨立評估用戶輸入和模型輸出。您可以通過過濾生成式 AI 應用程序中的不需要和有害的內容,使用您定義的策略集來控制用戶與 DeepSeek-R1 之間的交互。Amazon Bedrock Marketplace 中的 DeepSeek-R1 模型只能與 Bedrock 的 ApplyGuardrail API 一起使用,以評估 Amazon Bedrock 外部可用的自定義和第三方 FM 的用戶輸入和模型響應。要了解更多信息,請閱讀使用 Amazon Bedrock Guardrails 實施獨立于模型的安全措施。

Amazon Bedrock Guardrails 還可以與其他 Bedrock 工具(包括 Amazon Bedrock 代理和 Amazon Bedrock 知識庫)集成,以構建更安全、更可靠的生成式 AI 應用程序,并符合負責任的 AI 策略。要了解更多信息,請訪問 亞馬遜云科技 負責任的 AI 頁面。

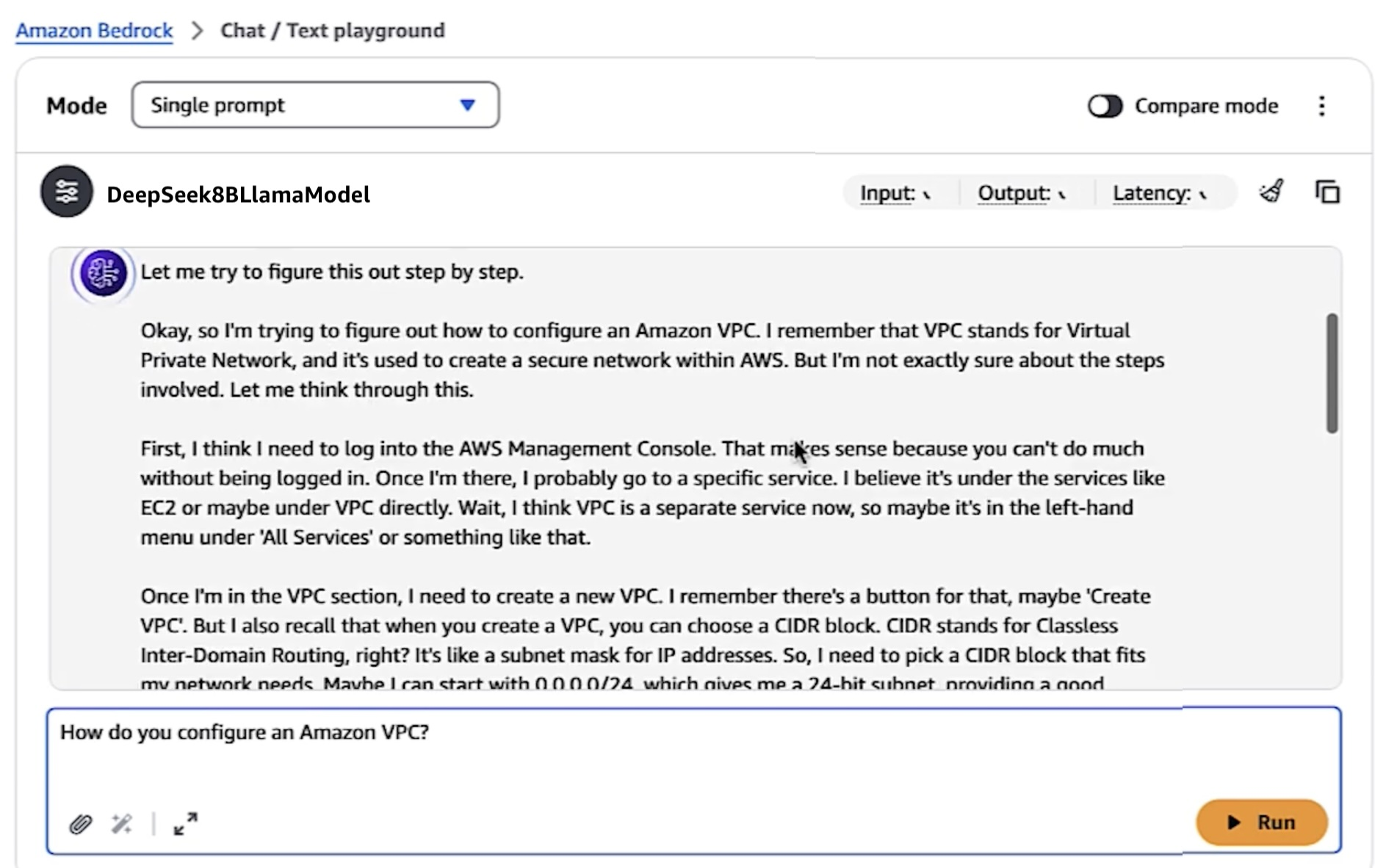

您可以使用 Bedrock Playground 來了解模型如何響應各種輸入,并讓您微調提示以獲得最佳結果。

當將 DeepSeek-R1 模型與 Bedrock 的 playground 或 API 一起使用時,請使用 DeepSeek 的聊天模板以獲得最佳結果。例如。

<|begin_of_sentence|><|User|>content for inference<|Assistant|>

請參閱此分步指南,了解如何在 Amazon Bedrock Marketplace 中部署 DeepSeek-R1 模型。要了解更多信息,請訪問在 Amazon Bedrock Marketplace 中部署模型。

- Amazon SageMaker JumpStart 中的 DeepSeek-R1 模型Amazon SageMaker JumpStart 是一個機器學習 (ML) 中心,具有 FM、內置算法和預構建的 ML 解決方案,只需單擊幾下即可部署。

要在 SageMaker JumpStart 中部署 DeepSeek-R1,您可以在 SageMaker Unified Studio、SageMaker Studio、SageMaker AI 控制臺中或通過 SageMaker Python 開發工具包以編程方式發現 DeepSeek-R1 模型。

在 Amazon SageMaker AI 控制臺中,打開 SageMaker Studio,然后選擇 JumpStart,然后在 All public models(所有公有模型)頁面中搜索 “DeepSeek-R1”。

您可以選擇模型,然后選擇 deploy (部署) 以創建具有默認設置的終端節點。當終端節點進入 InService 時,您可以通過向其終端節點發送請求來進行推理。

您可以使用 Amazon SageMaker AI 功能(如 Amazon SageMaker Pipelines、Amazon SageMaker Debugger 或容器日志)獲得模型性能和 ML作控制。該模型部署在 亞馬遜云科技 安全環境中,并受您的 Virtual Private Cloud (VPC) 控制,有助于支持數據安全。

與 Bedrock Marketpalce 一樣,您可以使用 SageMaker JumpStart 中的 API 將生成式 AI 應用程序的保護措施與 DeepSeek-R1 模型分離。現在,您可以在不調用 FM 的情況下使用護欄,這為將標準化和經過全面測試的企業保護措施更多地集成到您的應用程序流中打開了大門,而不管使用何種模型。

請參閱此分步指南,了解如何在 Amazon SageMaker JumpStart 中部署 DeepSeek-R1 模型。要了解更多信息,請訪問在 SageMaker Unified Studio 中發現 SageMaker JumpStart 模型或在 SageMaker Studio 中部署 SageMaker JumpStart 模型。

- 使用 Amazon Bedrock 自定義模型導入的 DeepSeek-R1-Distill 模型Amazon Bedrock 自定義模型導入能夠通過單個無服務器統一 API 導入自定義模型以及現有 FM 并使用自定義模型,而無需管理底層基礎設施。

使用 Amazon Bedrock 自定義模型導入,您可以導入 1.5-700 億個參數的 DeepSeek-R1-Distill 模型。正如我在關于 Amazon Bedrock 模型蒸餾的博客文章中強調的那樣,蒸餾過程涉及訓練更小、更高效的模型,以模擬具有 6710 億個參數的大型 DeepSeek-R1 模型的行為和推理模式,將其用作教師模型。

將這些公開可用的模型存儲在 Amazon Simple Storage Service (Amazon S3) 存儲桶或 Amazon SageMaker Model Registry 中后,轉到 Amazon Bedrock 控制臺中基礎模型下的導入模型,然后通過 Amazon Bedrock 將它們導入并部署到完全托管的無服務器環境中。這種無服務器方法消除了對基礎設施管理的需求,同時提供了企業級的安全性和可擴展性。

導入提煉模型后,您可以使用 Bedrock Playground 來了解輸入的提煉模型響應。

請參閱此分步指南,了解如何使用 Amazon Bedrock 自定義模型導入部署 DeepSeek-R1-Distill 模型。要了解更多信息,請訪問將自定義模型導入 Amazon Bedrock。

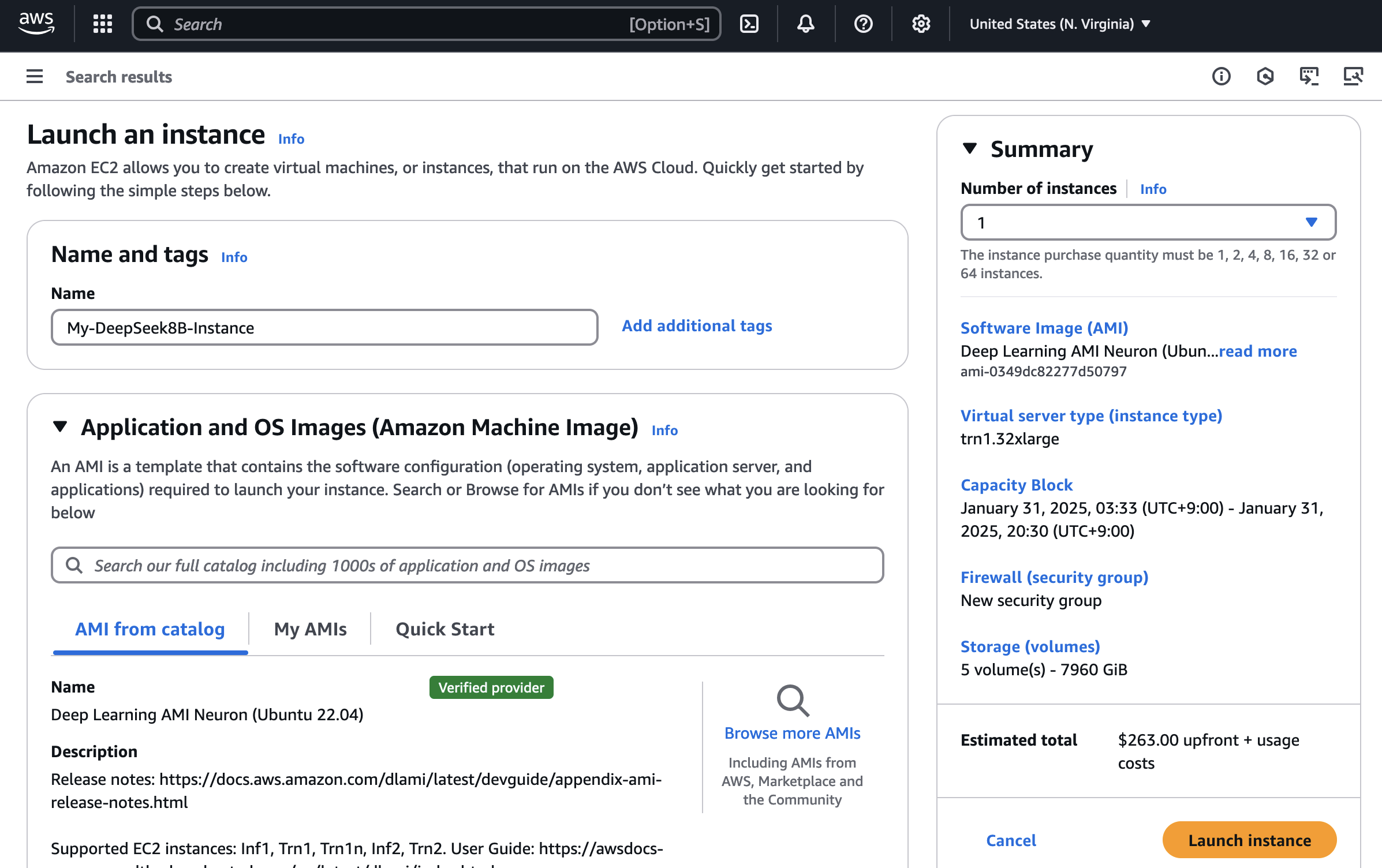

- 使用 Amazon Trainium 和 Amazon Inferentia 的 DeepSeek-R1-Distill 模型Amazon Deep Learning AMI (DLAMI) 提供自定義的系統映像,您可以使用這些映像在各種 Amazon EC2 實例中進行深度學習,從小型純 CPU 實例到最新的高性能多 GPU 實例。

您可以在 Amazon Trainuim1 或 Amazon Inferentia2 實例上部署 DeepSeek-R1-Distill 模型,以獲得最佳性價比。

要開始使用,請轉到 Amazon EC2 控制臺,然后使用名為 Deep Learning AMI Neuron (Ubuntu 22.04) 的 Neuron 多框架 DLAMI 啟動一個 EC2 實例。

連接到啟動的 ec2 實例后,安裝 vLLM,這是一個用于提供大型語言模型 (LLM) 的開源工具,并從 Hugging Face 下載 DeepSeek-R1-Distill 模型。您可以使用 vLLM 部署模型并調用模型服務器。

要了解更多信息,請參閱此分步指南,了解如何在 Amazon Inferentia 和 Trainium 上部署 DeepSeek-R1-Distill Llama 模型。

您還可以在 Hugging Face 上訪問 DeepSeek-R1-Distill 模型卡片,例如 DeepSeek-R1-Distill-Llama-8B 或 deepseek-ai/DeepSeek-R1-Distill-Llama-70B。選擇 Deploy (部署),然后選擇 Amazon SageMaker。從 Amazon Inferentia 和 Trainium 選項卡中,復制部署 DeepSeek-R1-Distill 模型的示例代碼。

注意事項

以下是一些需要了解的重要事項。

- 定價 – 對于 DeepSeek-R1 等公開可用的模型,您只需根據您為 Amazon Bedrock Markeplace、Amazon SageMaker JumpStart 和 Amazon EC2 選擇的推理實例小時數支付基礎設施價格。對于 Bedrock 自定義模型導入,您只需根據自定義模型的活躍副本數量支付模型推理費用,以 5 分鐘為周期計費。要了解更多信息,請查看 Amazon Bedrock 定價、Amazon SageMaker AI 定價和 Amazon EC2 定價頁面。

- 數據安全 – 您可以使用 Amazon Bedrock 和 Amazon SageMaker 中的企業級安全功能來幫助您確保數據和應用程序的安全性和私密性。這意味著您的數據不會與模型提供商共享,也不會用于改進模型。這適用于所有模型(專有和公開可用),例如 Amazon Bedrock 和 Amazon SageMaker 上的 DeepSeek-R1 模型。要了解更多信息,請訪問 Amazon Bedrock 安全性和隱私以及 Amazon SageMaker AI 中的安全性。

如果決定不再使用服務的話,記得要在控制臺關閉服務,以防超過免費額度產生扣費。

2023年亞馬遜云科技 技術峰會上海站是亞馬遜云科技在中國舉辦的大型科技盛會,聚焦云計算、人工智能、大數據等前沿技術。峰會匯聚行業領袖、技術專家及開發者,通過主題演講、技術分論壇及實踐案例分享,探討企業數字化轉型、云原生架構、AI/ML創新應用等熱門議題。參與者可深入了解亞馬遜云科技最新服務與解決方案,并體驗動手實踐工作坊,助力企業提升云上創新能力與效率,立即注冊。活動旨在推動云計算技術生態發展,促進企業間的交流與合作。

解析)

-> 創建端云一體化開發工程)

之后,pytorch模型的性能會很差?為什么 dropout 影響性能?| 深度學習)

![[爬蟲知識] http協議](http://pic.xiahunao.cn/[爬蟲知識] http協議)