為什么外設配置對機器人研究如此重要?

在當今機器人技術飛速發展的時代,高校學生研究團隊正成為創新的重要力量。無論是參加機器人競賽、開展畢業設計,還是進行學術研究,正確配置和使用外設設備都是成功的關鍵。尤其學生組裝一個服務機器人,它需要在家中自由行走,避開家具和寵物,還能識別你的手勢指令。這個看似神奇的能力,其實來自于一系列神奇的外設傳感器:激光雷達、IMU和深度相機。就像人類需要眼睛、耳朵和小腦來保持平衡和感知環境一樣,機器人也需要這些"感官"來理解周圍世界。

作為一名高校學生,你可能正在參與機器人或自動駕駛相關的研究項目。本文將帶你深入了解這些關鍵外設的工作原理、配置方法和應用場景,讓你能夠為自己的項目選擇合適的傳感器并快速上手使用。

一、?激光雷達:機器人的"智慧之眼"

1、什么是激光雷達?

激光雷達(LiDAR,Light Detection and Ranging)是一種通過激光束來探測和測距的先進技術。它就像是機器人的"眼睛",能夠幫助機器人"看見"周圍環境并測量距離。

?LDS-50C-C30E激光雷達,采用TOF(Time of Fight)飛行時間測距技術,根據激光飛行時間來測量距離。在40m的有效探測距離內測距精度可達到±25mm,測距精度不會隨距離變化而變化。同時具備自主研發的360度掃描,運行可靠。

關鍵技術解析:TOF(Time of Flight)飛行時間測距技術

TOF是激光雷達的核心技術原理,它的工作方式非常有趣:設備發射一束激光,當激光遇到物體后會反射回來,設備通過計算激光從發射到返回的時間差,再乘以光速,就能精確計算出距離。這些特性使得它非常適合用于機器人導航、環境建模、避障等應用場景。

硬件連接與配置

物理連接:使用網線將激光雷達的以太網口與Jetson Nano開發板相連。

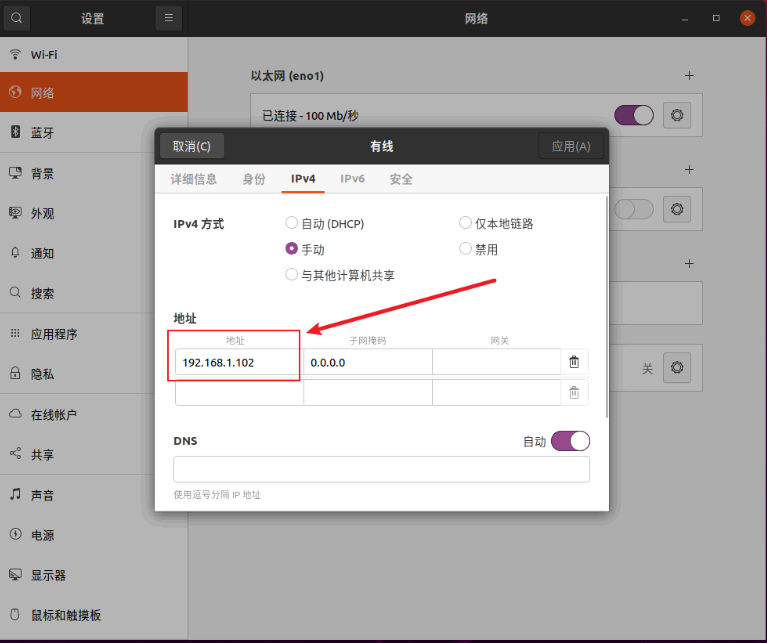

網絡配置:為了讓Jetson Nano能夠與雷達通信,需要將兩者設置在同一個局域網內。通過以下命令為Jetson Nano的網卡配置IP地址:

bash

sudo ip addr add 192.168.158.200/24 dev eth0

這里的eth0是網卡名稱,根據實際設備可能會有所不同。該命令為網卡分配了一個靜態IP地址192.168.158.200,并設置子網掩碼為24位(即255.255.255.0)。

# 給網絡接口添加IP地址sudo ip addr add 192.168.158.200/24 dev <網卡名稱>sudo ip addr add 192.168.158.200/24 dev eth0

2、?查看雷達點云

點云是什么?點云是激光雷達掃描后生成的一組數據點,這些點在三維空間中表示被探測物體的表面形狀。就像用無數個小點描繪出周圍環境的"輪廓圖"。

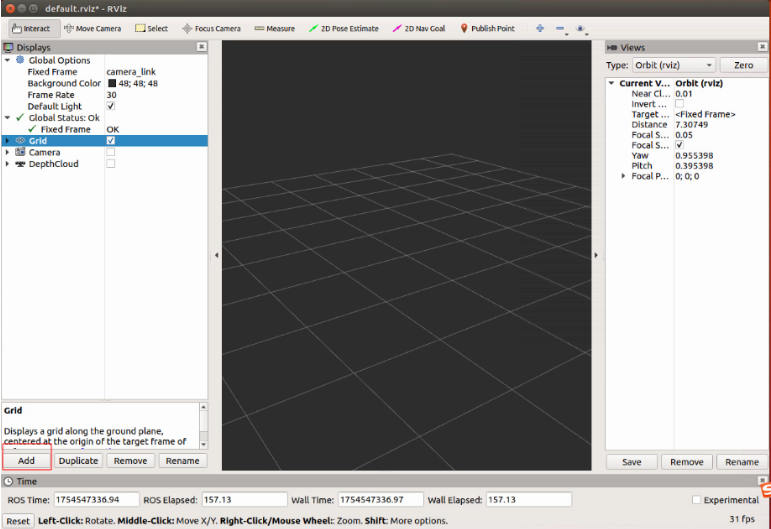

#啟動雷達驅動roslaunch bluesea2 udp_lidar.launch#打開rviz查看點云數據rviz -d /home/plan/AutoTrack-IR-DR200/src/drivers/bluesea2/rviz/demo.rviz

成功配置后,你將在屏幕上看到類似下圖的點云效果,它直觀地展示了雷達掃描到的環境信息:

二、?機器人IMU:感知姿態與運動的"內耳"

1 、IMU是什么?為什么機器人需要它?

IMU(Inertial Measurement Unit,慣性測量單元)是測量物體三軸姿態角和加速度的裝置。它就像是機器人的"內耳",幫助機器人感知自身的運動狀態和方位。

人類的內耳幫助我們保持平衡,知道自己是站著、坐著還是倒立。同樣,IMU讓機器人知道自己的姿態、加速度和旋轉速度。

3、?下載和編譯驅動

步驟1:下載源碼

# 進入工作空間cd ~/catkin_ws# 克隆倉庫到src目錄git clone --recursive https://github.com/ElettraSciComp/witmotion_IMU_ros.git src/witmotion_ros

步驟2:編譯驅動

# 編譯特定包catkin_make --pkg witmotion_ros# 重新加載環境

4、?運行和測試IMU數據

步驟1:啟動IMU驅動

# 確保環境變量已加載source ~/catkin_ws/devel/setup.bash

# 啟動IMU驅動

roslaunch witmotion_ros witmotion.launch

# 查看IMU數據(新開終端)

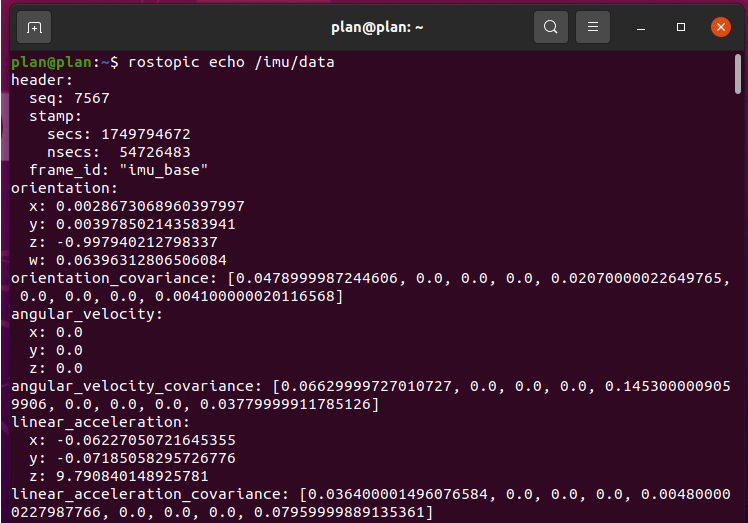

rostopic echo /imu/data

成功運行后,你將看到實時輸出的IMU數據,包括方向、加速度和角速度等信息:

三、深度相機:三維感知的"立體視覺"

1、?深度相機原理介紹

深度相機是一種能夠獲取場景中每個點距離信息的相機,它不僅能夠捕獲普通的彩色圖像(RGB圖像),還能同時獲取每個像素點的距離信息,形成"深度圖"。

雙目深度相機采用雙目結構光技術,它模擬了人類雙眼的立體視覺原理:通過兩個攝像頭(像人的兩只眼睛)從不同角度拍攝圖像信息同一場景,并通過比較兩幅圖像的差異,計算每個點的距離信息,結構光投射特定圖案到場景中,進一步提高了計算精度

2、安裝驅動依賴

深度相機需要較多的軟件依賴庫支持:

sudo apt install libgflags-dev ros-melodic-image-geometry ros-melodic-camera-info-manager \ ???ros-melodic-image-transport-plugins ros-melodic-compressed-image-transport \ ???ros-melodic-image-transport ros-melodic-image-publisher libgoogle-glog-dev libusb-1.0-0-dev libeigen3-dev \ ???ros-melodic-diagnostic-updater ros-melodic-diagnostic-msgs \ ???libdw-dev

安裝 udev 規則

cd ~/catkin_wssource ./devel/setup.bashroscd orbbec_camerasudo bash ./scripts/install_udev_rules.sh

?啟動相機

啟動相機并顯示RGB圖像與深度圖像

終端一:

source ./devel/setup.bashroslaunch orbbec_camera dabai_dcw.launch

終端二:

source ./devel/setup.bashrviz

在Rviz中,可以通過添加By topic選項,選擇/camera/color/image_raw話題來查看實時RGB圖像,選擇/camera/depth/image_raw話題來查看深度圖像。深度圖像通常以灰度圖形式顯示,顏色越亮表示距離越近,越暗表示距離越遠。

在實際機器人項目中,我們通常需要同時使用多種傳感器:激光雷達提供遠距離環境地圖、IMU提供機器人自身姿態信息、深度相機提供近距離精細物體識別,最后通過ROS框架,我們可以將這些設備的數據融合在一起,構建更加完整的環境感知系統。

總結(89))

-圖像修復與編輯)

)

![[react] react-router-dom是啥?](http://pic.xiahunao.cn/[react] react-router-dom是啥?)