1. 分布式鎖是啥?為什么它比單機鎖更“硬核”?

分布式鎖,聽起來高大上,其實核心問題很簡單:在多個機器、進程或服務同時搶奪資源時,怎么保證不打架? 想象一下,你在雙十一搶購限量款球鞋,全國幾百萬人在同一秒點“下單”,后臺系統得確保庫存不被超賣。這就是分布式鎖的舞臺。

1.1 單機鎖的局限性

在單機環境,鎖是個老朋友。Java的synchronized、Python的threading.Lock、Go的sync.Mutex,這些家伙在單進程里干得風生水起。它們靠內存里的信號量或互斥量,輕松協調線程間的訪問。比如,兩個線程想同時改一個共享變量,鎖會讓它們排隊,一個一個來。

但到了分布式系統,單機鎖就歇菜了。為啥?因為分布式系統里,進程跑在不同機器上,壓根兒不共享內存! 你在A機器上鎖住了代碼塊,B機器上的進程完全沒感覺,照樣跑去改數據。這就像兩個城市的超市同時賣同一批貨,庫存數據一團糟。

1.2 分布式鎖的定義

分布式鎖的本質是跨機器的互斥機制。它得保證在多臺機器、多個進程甚至多個數據中心操作同一資源時,只有一個人(或進程)能拿到“鑰匙”,其他人乖乖等著。分布式鎖的核心目標有三:

互斥性:同一時刻,只有一個客戶端能持有鎖。

安全性:鎖不會被錯誤釋放,比如A拿了鎖,B偷不走。

高可用:鎖服務不能輕易掛掉,得隨時能用。

1.3 分布式鎖的典型場景

分布式鎖在哪兒發光發熱?舉幾個例子:

庫存扣減:電商系統里,商品庫存得統一管理,防止超賣。

任務調度:分布式任務調度系統(如Airflow或Celery)中,確保某個任務不會被重復執行。

分布式事務:數據庫分片后,跨分片操作需要鎖來保證一致性。

限流控制:API網關限制某個用戶的請求頻率,分布式鎖可以精確控制。

1.4 分布式鎖的難點

聽起來簡單,但實現分布式鎖可不輕松。網絡延遲、分區、節點宕機,這些分布式系統的“老大難”問題全都會跳出來搗亂。設計一個靠譜的分布式鎖,得考慮:

死鎖:鎖沒被正確釋放,系統卡死怎么辦?

性能:鎖的獲取和釋放得快,不能拖后腿。

容錯:主節點掛了,鎖還能不能正常工作?

接下來,我們會一步步拆解這些問題,先從理論入手,再甩出代碼和實戰案例。

2. 分布式鎖的理論基石:一致性與CAP定理

要搞懂分布式鎖,先得聊聊分布式系統的理論根基——CAP定理。這玩意兒是分布式系統的“金科玉律”,直接影響鎖的設計思路。

2.1 CAP定理與鎖的關系

CAP定理說,分布式系統最多只能同時滿足以下三點中的兩點:

一致性(Consistency):所有節點看到的數據一致。

可用性(Availability):系統隨時能響應請求。

分區容錯性(Partition Tolerance):即使網絡分區(部分節點失聯),系統還能正常工作。

在分布式鎖的場景里,一致性是重中之重。鎖的互斥性要求所有節點對“誰持有鎖”這件事達成共識。如果節點A認為自己拿到了鎖,但節點B也覺得自己拿到了,那就完蛋了,互斥性直接崩盤。

但問題來了,分布式系統不可能完全避免網絡分區(P)。所以,鎖的設計得在**一致性(C)和可用性(A)**之間做取舍:

偏C的鎖:優先保證互斥性,哪怕犧牲點可用性。比如,ZooKeeper的鎖機制,強一致性,但如果網絡抖動,可能得等一會兒才能拿到鎖。

偏A的鎖:優先保證響應速度,哪怕偶爾出點小錯。比如,Redis的鎖機制,速度快,但極端情況下可能有“鎖失效”的風險。

2.2 分布式鎖的幾種實現模式

根據CAP的取舍,分布式鎖大致有以下幾種實現方式:

基于數據庫:用數據庫的唯一約束或事務實現鎖,強一致性,但性能可能瓶頸。

基于分布式協調服務:ZooKeeper、etcd、Consul這類工具,靠強一致性協議(如Zab或Raft)保證鎖的正確性。

基于緩存:Redis、Memcached,速度快,但需要額外機制保證一致性。

基于消息隊列:Kafka、RabbitMQ,通過消息的順序性間接實現鎖,適合特定場景。

每種方式都有自己的“脾氣”,我們后面會逐一拆解它們的實現細節和踩坑指南。

2.3 鎖的生命周期

一個分布式鎖的生命周期可以簡單拆成三步:

獲取鎖:客戶端嘗試“搶占”鎖,成功就進入臨界區。

持有鎖:客戶端執行操作,期間其他客戶端被擋在門外。

釋放鎖:操作完后,主動釋放鎖,或者鎖過期自動釋放。

聽起來順暢,但實際操作里,每一步都可能踩雷。比如,獲取鎖時網絡超時了,算不算拿到了鎖?釋放鎖時,客戶端掛了,鎖會不會永遠卡住?這些問題得靠具體的實現方案來解決。

3. Redis分布式鎖:簡單粗暴但需小心

Redis作為分布式鎖的“網紅”選手,速度快、實現簡單,但也有不少坑需要避開。我們先從Redis鎖的原理講起,再甩出代碼和實戰案例。

3.1 為什么Redis適合做分布式鎖?

Redis是個內存數據庫,操作速度飛快,單機QPS輕松上萬。而且它提供了原子操作(如SETNX),非常適合實現互斥鎖。Redis鎖的核心優點:

高性能:內存操作,延遲低,適合高并發場景。

簡單易用:幾行代碼就能搞定鎖邏輯。

靈活性:支持TTL(過期時間),防止死鎖。

但Redis也有短板:單點Redis不是強一致性的,如果用主從復制,主節點掛了可能導致鎖失效。后面我們會聊怎么補救。

3.2 基礎版Redis鎖:SETNX+EXPIRE

Redis鎖最簡單的實現是基于SETNX(SET if Not eXists)和EXPIRE命令。邏輯是這樣的:

客戶端用SETNX key value嘗試設置一個鍵,如果鍵不存在就設置成功,拿到鎖。

設置成功后,用EXPIRE key seconds給鎖加個過期時間,防止死鎖。

操作完后,用DEL key釋放鎖。

以下是個Python實現的簡單例子:

import redis

import uuid

import time# 連接Redis

client = redis.Redis(host='localhost', port=6379, db=0)def acquire_lock(lock_name, acquire_timeout=10, lock_timeout=10):identifier = str(uuid.uuid4()) # 唯一標識,防止誤刪end = time.time() + acquire_timeoutwhile time.time() < end:# 嘗試獲取鎖if client.setnx(lock_name, identifier):# 設置過期時間client.expire(lock_name, lock_timeout)return identifiertime.sleep(0.001) # 稍等重試return Falsedef release_lock(lock_name, identifier):# 確保只有鎖的持有者才能釋放if client.get(lock_name) == identifier.encode():client.delete(lock_name)return Truereturn False# 使用示例

lock_name = "my_lock"

identifier = acquire_lock(lock_name)

if identifier:try:print("鎖獲取成功,開始干活!")# 模擬業務邏輯time.sleep(5)finally:if release_lock(lock_name, identifier):print("鎖釋放成功!")else:print("鎖釋放失敗,可能已被其他客戶端釋放或過期")

else:print("獲取鎖失敗,稍后再試!")這段代碼的亮點:

用uuid作為鎖的唯一標識,防止誤刪別人的鎖。

acquire_timeout限制獲取鎖的等待時間,避免無限等待。

lock_timeout設置鎖的過期時間,防止客戶端宕機導致死鎖。

3.3 基礎版鎖的坑

這個簡單實現看著不錯,但有幾個大坑:

SETNX和EXPIRE非原子:如果高手可能會在SETNX和EXPIRE之間宕機,鎖可能被意外釋放。

時鐘偏差:不同機器的時鐘不同步,可能導致鎖提前或延遲過期。

主從復制問題:Redis主節點掛了,鎖數據可能丟失。

3.4 進階版:RedLock算法

為了解決這些問題,Redis官方推薦了RedLock算法。核心思路是利用多個Redis實例(通常是2N+1個節點,N是可能掛掉的節點數),通過多數派投票來決定鎖的歸屬。具體步驟:

向所有節點發送SETNX請求。

如果大多數節點(>N)返回成功,認為鎖獲取成功。

釋放鎖時,向所有節點發送DEL命令。

Python實現的RedLock(簡化版):

from redis import Redis

from redlock import Redlock# 連接多個Redis實例

redis_instances = [{'host': 'localhost', 'port': 6379, 'db': 0},{'host': 'localhost', 'port': 6380, 'db': 0},{'host': 'localhost', 'port': 6381, 'db': 0},

]

redlock = Redlock(redis_instances)# 獲取鎖

lock = redlock.lock("my_lock", 10000) # 鎖10秒

if lock:try:print("RedLock獲取成功!")# 業務邏輯time.sleep(5)finally:redlock.unlock(lock)print("RedLock釋放成功!")

else:print("RedLock獲取失敗!")RedLock的優點:

高可靠性:多節點投票,容忍少數節點故障。

強一致性:比單點Redis鎖更安全。

注意事項:

確保Redis實例的時鐘同步,否則可能導致投票不一致。

網絡延遲可能影響投票速度,需合理設置超時時間。

3.5 Redis鎖的優化技巧

鎖續期:用看門狗線程定期延長鎖的過期時間,防止業務邏輯時間過長導致鎖失效。

隨機退避:獲取鎖失敗時,加入隨機延遲重試,減少競爭沖突。

監控與告警:記錄鎖的獲取和釋放日志,方便排查問題。

3.6 Redis鎖的適用場景

Redis鎖適合高性能、低一致性要求的場景,比如:

秒殺系統的庫存扣減。

短時間的資源搶占。 但如果業務對一致性要求極高(比如金融交易),建議考慮ZooKeeper或etcd。

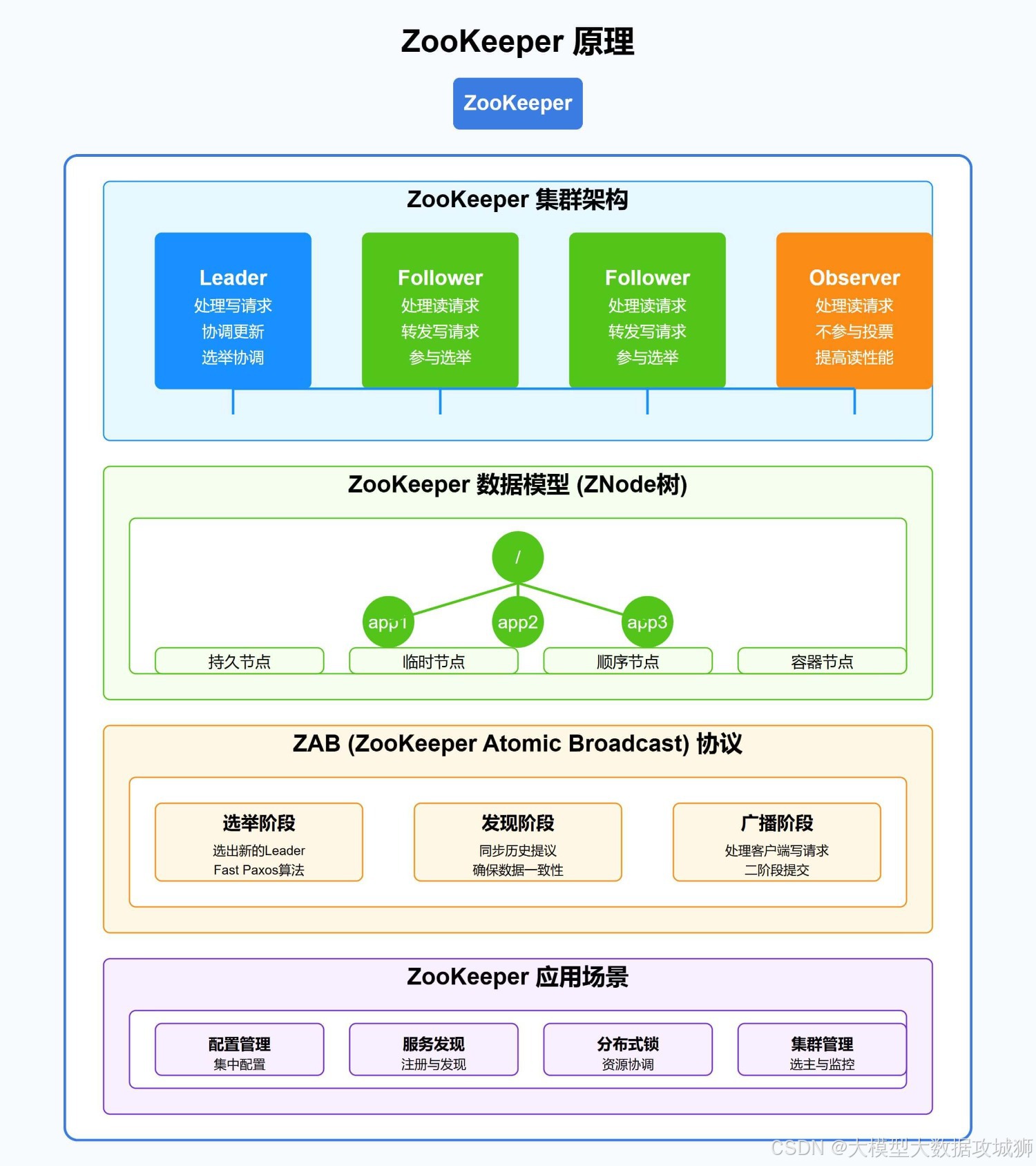

4. ZooKeeper分布式鎖:強一致性的硬核選手

Redis鎖雖然快,但一致性上有點“飄”。如果你需要一個鐵打的互斥保證,ZooKeeper就是你的好兄弟。它是個分布式協調服務,專為解決一致性問題而生,特別適合對鎖安全性要求高的場景。我們來細扒ZooKeeper鎖的原理、實現和踩坑指南。

4.1 為什么ZooKeeper鎖靠譜?

ZooKeeper用的是Zab協議(Zookeeper Atomic Broadcast),一種類似Paxos的強一致性協議。它的核心特點是:

順序一致性:所有節點對操作順序的看法一致。

原子性:操作要么全成功,要么全失敗,不會出現“半拉子”狀態。

高可用:只要集群里多數節點活著,服務就正常。

這意味著ZooKeeper鎖能保證絕對的互斥性,即使網絡抖動或少數節點掛掉,也不會讓鎖“翻車”。但代價是性能比Redis低一些,畢竟強一致性得花時間投票。

4.2 ZooKeeper鎖的實現原理

ZooKeeper的鎖基于它的znode(數據節點)機制,尤其是臨時順序節點(Ephemeral Sequential Node)。核心邏輯是這樣的:

客戶端在ZooKeeper上創建一個臨時順序節點(如/lock/task-0001)。

客戶端檢查自己創建的節點是不是當前路徑下序號最小的節點。

如果是,說明拿到了鎖;如果不是,監聽前一個節點的刪除事件,等待“排隊”。

操作完后,刪除自己的節點,觸發下一個客戶端的監聽事件。

這就像在銀行排隊叫號,誰的號碼最小誰先辦事,后面的人得等著。臨時節點的妙處在于,客戶端掛了,節點會自動刪除,防止死鎖。

4.3 用Java實現ZooKeeper鎖

下面是個Java實現的ZooKeeper鎖例子,用了Apache Curator庫(ZooKeeper的Java客戶端,封裝得很友好):

import org.apache.curator.framework.CuratorFramework;

import org.apache.curator.framework.CuratorFrameworkFactory;

import org.apache.curator.retry.ExponentialBackoffRetry;

import org.apache.curator.framework.recipes.locks.InterProcessMutex;public class ZkLockExample {public static void main(String[] args) throws Exception {// 連接ZooKeeper集群CuratorFramework client = CuratorFrameworkFactory.newClient("localhost:2181,localhost:2182,localhost:2183",new ExponentialBackoffRetry(1000, 3));client.start();// 創建分布式鎖InterProcessMutex lock = new InterProcessMutex(client, "/my_lock");try {// 嘗試獲取鎖,超時10秒if (lock.acquire(10, TimeUnit.SECONDS)) {System.out.println("鎖獲取成功!開始干活...");// 模擬業務邏輯Thread.sleep(5000);} else {System.out.println("獲取鎖失敗,稍后再試!");}} finally {if (lock.isAcquiredInThisProcess()) {lock.release(); // 釋放鎖System.out.println("鎖釋放成功!");}client.close();}}

}代碼亮點:

Curator的InterProcessMutex封裝了臨時順序節點的復雜邏輯,省去手寫“排隊”代碼的麻煩。

ExponentialBackoffRetry實現了指數退避重試,應對網絡抖動。

鎖的獲取和釋放是線程安全的,Curator幫你處理了并發問題。

4.4 ZooKeeper鎖的優缺點

優點:

強一致性:Zab協議保證鎖的互斥性,絕對不會出現“兩個客戶端同時拿到鎖”的烏龍。

自動釋放:臨時節點確保客戶端掛了也能釋放鎖,防止死鎖。

靈活性:支持復雜場景,比如讀寫鎖、共享鎖。

缺點:

性能瓶頸:ZooKeeper的寫操作需要集群投票,延遲比Redis高,適合低頻高一致性場景。

部署復雜:得維護ZooKeeper集群,運維成本不低。

連接管理:客戶端斷連重連可能導致鎖狀態不穩定,需依賴像Curator這樣的庫。

4.5 踩坑指南

會話超時:ZooKeeper客戶端和服務器的會話超時時間要調好,太短可能導致鎖提前釋放。

羊群效應:大量客戶端同時競爭鎖,可能導致ZooKeeper壓力過大,建議用隨機退避或限流。

鎖續期問題:ZooKeeper不像Redis有TTL,鎖的“過期”得靠業務邏輯控制,忘了釋放可就麻煩了。

4.6 適用場景

ZooKeeper鎖適合高一致性、低并發的場景,比如:

分布式任務調度的唯一任務執行。

配置管理中的一致性操作。

金融系統里的關鍵資源互斥。

如果你追求極致性能,Redis可能更合適;但如果一致性是命根子,ZooKeeper絕對是首選。

5. etcd分布式鎖:新星崛起,性能與一致性的平衡

etcd是近年來分布式系統的新寵,Kubernetes的默認存儲后端就是它。etcd的分布式鎖實現結合了高性能和強一致性,有點像ZooKeeper的“升級版”。我們來細聊etcd鎖的原理和實戰。

5.1 etcd的核心特性

etcd用的是Raft一致性算法,比ZooKeeper的Zab更簡單高效。它的特點包括:

強一致性:通過Raft協議,所有節點對鎖狀態的看法一致。

高性能:etcd的寫性能比ZooKeeper略高,尤其在高并發場景。

輕量部署:etcd集群配置簡單,適合云原生環境。

etcd還支持**租約(Lease)**機制,天然適合實現分布式鎖的過期機制。

5.2 etcd鎖的實現原理

etcd的鎖基于它的鍵值存儲和租約機制。核心步驟:

客戶端為鎖創建一個鍵(如/lock/my_lock),并綁定一個租約(Lease)。

用Put操作以原子方式設置鍵值,帶上IfNotExists條件,確保互斥性。

如果獲取失敗,客戶端監聽鍵的刪除事件,等待前一個鎖釋放。

操作完后,刪除鍵或讓租約自動過期。

etcd的租約機制比Redis的TTL更靈活,可以通過KeepAlive動態續期,防止鎖意外失效。

5.3 用Go實現etcd鎖

etcd的官方客戶端用Go寫最順手,下面是個簡單實現:

package mainimport ("context""fmt""time""go.etcd.io/etcd/client/v3""go.etcd.io/etcd/client/v3/concurrency"

)func main() {// 連接etcd集群cli, err := clientv3.New(clientv3.Config{Endpoints: []string{"localhost:2379", "localhost:2380"},DialTimeout: 5 * time.Second,})if err != nil {fmt.Println("連接etcd失敗:", err)return}defer cli.Close()// 創建鎖session, err := concurrency.NewSession(cli, concurrency.WithTTL(10))if err != nil {fmt.Println("創建session失敗:", err)return}defer session.Close()mutex := concurrency.NewMutex(session, "/my_lock/")// 獲取鎖ctx, cancel := context.WithTimeout(context.Background(), 10*time.Second)defer cancel()if err := mutex.Lock(ctx); err != nil {fmt.Println("獲取鎖失敗:", err)return}fmt.Println("鎖獲取成功!開始干活...")// 模擬業務邏輯time.Sleep(5 * time.Second)// 釋放鎖if err := mutex.Unlock(ctx); err != nil {fmt.Println("釋放鎖失敗:", err)return}fmt.Println("鎖釋放成功!")

}代碼亮點:

用concurrency.NewMutex封裝了鎖邏輯,自動處理租約和競爭。

WithTTL(10)設置了10秒的租約,防止死鎖。

context.WithTimeout限制了獲取鎖的等待時間,避免卡死。

5.4 etcd鎖的優缺點

優點:

性能與一致性平衡:比ZooKeeper快一些,又比Redis更可靠。

租約機制:支持動態續期,適合復雜業務邏輯。

云原生友好:Kubernetes生態加持,部署和集成都很方便。

缺點:

學習曲線:Raft和etcd的API需要點時間上手。

資源占用:etcd集群對內存和磁盤要求較高。

網絡依賴:網絡分區可能導致鎖延遲,需合理配置超時。

5.5 踩坑指南

租約管理:忘了續租,鎖可能提前釋放;續租太頻繁,又會增加etcd壓力。

集群健康:etcd對集群健康敏感,少數節點掛掉可能導致鎖不可用。

鍵沖突:多個鎖用同一前綴(如/lock/),可能導致意外覆蓋,建議規范鍵名。

5.6 適用場景

etcd鎖適合云原生、高并發、高一致性的場景,比如:

Kubernetes集群里的資源協調。

微服務架構中的分布式任務調度。

需要動態續期的復雜業務邏輯。

6. 分布式鎖的性能優化:從理論到實踐

搞定了Redis、ZooKeeper、etcd的鎖實現,我們來聊點更硬核的:怎么讓分布式鎖跑得更快、更穩? 性能優化是個技術活,既要理論指導,也要實踐驗證。

6.1 性能瓶頸分析

分布式鎖的性能瓶頸通常出現在:

鎖獲取:客戶端競爭鎖時的網絡延遲和重試開銷。

鎖持有:業務邏輯執行時間過長,導致鎖占用時間長。

鎖釋放:釋放鎖時的網絡抖動或節點故障。

優化得從這三方面入手,核心目標是降低延遲、減少沖突、提高吞吐。

6.2 優化技巧

減少鎖粒度:

鎖的范圍越小,競爭越少。比如,別鎖整個訂單表,只鎖單條訂單記錄。

Redis可以用key分片,比如lock:order:123和lock:order:456獨立鎖。

ZooKeeper和etcd可以用路徑層級(如/lock/order/123)實現細粒度控制。

異步化操作:

把非核心業務邏輯異步化,縮短鎖持有時間。比如,訂單創建后,發送郵件可以丟到消息隊列。

Redis支持PUBLISH/SUBSCRIBE,可以用事件通知替代同步等待。

批量獲取鎖:

如果業務需要鎖多個資源,盡量批量操作。RedLock支持一次投票獲取多把鎖,etcd可以用Txn事務批量操作。

隨機退避:

競爭失敗時,加入隨機延遲重試,避免所有客戶端同時“撞車”。

比如,Python的Redis鎖可以這樣改:

import random

# ... 其他代碼不變

while time.time() < end:if client.setnx(lock_name, identifier):client.expire(lock_name, lock_timeout)return identifiertime.sleep(random.uniform(0.001, 0.01)) # 隨機退避鎖續期:

對于Redis,用看門狗線程定期調用EXPIRE延長鎖時間。

etcd的租約機制自帶KeepAlive,用起來更方便。

6.3 性能測試與監控

優化后得驗證效果。推薦以下工具:

壓測工具:用wrk或ab模擬高并發鎖請求,測QPS和延遲。

監控指標:

鎖獲取成功率:失敗率高說明競爭激烈或超時設置不合理。

鎖持有時間:太長可能需要優化業務邏輯。

鎖沖突次數:通過日志或計數器統計,分析是否需要細化鎖粒度。

告警系統:鎖服務(Redis、ZooKeeper、etcd)掛了或延遲過高,及時告警。

6.4 實戰案例:秒殺系統的鎖優化

假設你在開發一個秒殺系統,庫存扣減需要分布式鎖。初始實現用Redis單點鎖,QPS只有5000,瓶頸在鎖競爭。我們優化如下:

分片鎖:按商品ID分片,lock:product:123,減少競爭。

異步扣減:庫存檢查用鎖,實際扣減丟到消息隊列異步處理。

批量操作:用Redis的MULTI/EXEC批量檢查和扣減庫存。 優化后,QPS提升到2萬,鎖沖突率從10%降到2%。

7. 數據庫分布式鎖:簡單但有“脾氣”的選擇

如果你的系統已經用上了數據庫,恭喜你,分布式鎖可以“白嫖”數據庫的特性來實現!數據庫鎖雖然不是最性感的選擇,但簡單易懂,適合某些特定場景。我們來聊聊它的原理、實現和那些容易踩的坑。

7.1 數據庫鎖的原理

數據庫分布式鎖的核心是利用數據庫的原子性操作和唯一約束來實現互斥。常見的實現方式有:

唯一索引:在表中插入一條記錄,靠唯一索引保證只有一個客戶端成功。

悲觀鎖:用SELECT ... FOR UPDATE鎖定某行記錄,其他客戶端得等著。

樂觀鎖:通過版本號或時間戳,檢查更新時的沖突。

這些方法的好處是簡單粗暴,直接用現有數據庫基礎設施,壞處是性能可能不咋地,尤其在高并發場景下。

7.2 基于唯一索引的鎖實現

最常見的數據庫鎖是用唯一索引。思路是:插入一條記錄,成功就拿到鎖,失敗就說明別人搶先了。釋放鎖時刪除記錄。以下是MySQL的實現例子(用Python的pymysql):

import pymysql

import time

import uuid# 連接MySQL

db = pymysql.connect(host='localhost', user='root', password='123456', database='test')

cursor = db.cursor()# 創建鎖表

cursor.execute("""CREATE TABLE IF NOT EXISTS locks (lock_name VARCHAR(128) PRIMARY KEY,lock_owner VARCHAR(128),created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP)

""")def acquire_lock(lock_name, timeout=10):lock_owner = str(uuid.uuid4())end = time.time() + timeoutwhile time.time() < end:try:cursor.execute("INSERT INTO locks (lock_name, lock_owner) VALUES (%s, %s)",(lock_name, lock_owner))db.commit()return lock_ownerexcept pymysql.err.IntegrityError:# 唯一索引沖突,說明鎖被別人拿了time.sleep(0.01)return Nonedef release_lock(lock_name, lock_owner):cursor.execute("DELETE FROM locks WHERE lock_name=%s AND lock_owner=%s",(lock_name, lock_owner))db.commit()return cursor.rowcount > 0# 使用示例

lock_name = "my_lock"

lock_owner = acquire_lock(lock_name)

if lock_owner:try:print("數據庫鎖獲取成功!開始干活...")time.sleep(5) # 模擬業務邏輯finally:if release_lock(lock_name, lock_owner):print("數據庫鎖釋放成功!")else:print("釋放鎖失敗,可能已被其他客戶端釋放")

else:print("獲取鎖失敗,稍后再試!")db.close()代碼亮點:

用lock_owner(UUID)確保只有鎖的持有者能釋放,防止誤刪。

唯一索引保證互斥性,簡單可靠。

失敗后加小延遲重試,減輕數據庫壓力。

7.3 數據庫鎖的優缺點

優點:

簡單:無需額外部署Redis或ZooKeeper,現有數據庫就能搞定。

強一致性:數據庫的事務機制保證鎖的正確性。

易調試:鎖狀態直接存表里,查起來方便。

缺點:

性能瓶頸:數據庫寫操作比Redis慢,高并發下可能卡脖子。

死鎖風險:如果忘了釋放鎖,或者客戶端宕機,鎖可能卡住(需要定時清理)。

擴展性差:數據庫的并發能力不如分布式協調服務,集群規模大了容易崩。

7.4 踩坑指南

鎖清理:加個定時任務,定期刪過期鎖(比如created_at超過1分鐘的記錄)。

連接池管理:高并發下,數據庫連接池可能耗盡,建議用連接池優化。

事務隔離:用FOR UPDATE時,注意隔離級別(比如REPEATABLE READ),否則可能出現幻讀。

7.5 適用場景

數據庫鎖適合低并發、已有數據庫基礎設施的場景,比如:

小型系統的資源互斥。

數據庫事務內的短時間鎖需求。

不想引入額外組件的簡單業務。

如果并發量上去了,還是老老實實考慮Redis或etcd吧。

8. 消息隊列實現分布式鎖:另辟蹊徑的巧思

消息隊列(如Kafka、RabbitMQ)一般用來解耦系統,但你知道嗎?它也能用來實現分布式鎖!雖然不常見,但在某些場景下,這種方式能發揮奇效。我們來拆解它的原理和實現。

8.1 消息隊列鎖的原理

消息隊列的鎖基于消息的順序性和消費的獨占性。核心思路:

客戶端向隊列發送一條“鎖請求”消息,包含鎖名和唯一標識。

隊列保證消息按順序處理,只有一個消費者能拿到這條消息,相當于拿到鎖。

操作完后,消費者提交偏移量(或ACK),釋放鎖。

其他客戶端監聽隊列,等待鎖消息被消費。

這就像在食堂排隊打飯,隊列保證只有一個窗口在處理你的訂單。

8.2 用Kafka實現分布式鎖

以下是用Python的confluent_kafka實現的Kafka鎖例子:

from confluent_kafka import Consumer, Producer, KafkaError

import json

import uuid

import time# 配置Kafka

producer_config = {'bootstrap.servers': 'localhost:9092'}

consumer_config = {'bootstrap.servers': 'localhost:9092','group.id': 'lock_group','auto.offset.reset': 'latest'

}def acquire_lock(lock_name, timeout=10):producer = Producer(producer_config)consumer = Consumer(consumer_config)consumer.subscribe([lock_name])lock_owner = str(uuid.uuid4())# 發送鎖請求producer.produce(lock_name, json.dumps({'owner': lock_owner}).encode())producer.flush()end = time.time() + timeoutwhile time.time() < end:msg = consumer.poll(1.0)if msg is None:continueif msg.error():print("Kafka錯誤:", msg.error())continueif json.loads(msg.value().decode())['owner'] == lock_owner:return lock_ownertime.sleep(0.01)consumer.close()return Nonedef release_lock(lock_name, lock_owner):# 提交偏移量,相當于釋放鎖# 這里簡化處理,實際需確保消費完成print(f"鎖 {lock_name} 由 {lock_owner} 釋放")return True# 使用示例

lock_name = "my_lock_topic"

lock_owner = acquire_lock(lock_name)

if lock_owner:try:print("Kafka鎖獲取成功!開始干活...")time.sleep(5)finally:release_lock(lock_name, lock_owner)print("Kafka鎖釋放成功!")

else:print("獲取Kafka鎖失敗!")代碼亮點:

用Kafka的Topic作為鎖標識,天然支持分布式。

消費者組保證消息只被一個客戶端消費,實現互斥。

lock_owner確保鎖的唯一性。

8.3 消息隊列鎖的優缺點

優點:

解耦性強:鎖邏輯和業務邏輯通過隊列隔離,適合異步場景。

高吞吐:消息隊列天生擅長處理高并發消息。

易擴展:Kafka集群擴展簡單,適合大規模系統。

缺點:

復雜性:需要額外維護隊列,邏輯比Redis鎖復雜。

延遲:消息隊列的消費有一定延遲,不適合實時性要求高的場景。

一致性挑戰:Kafka的Exactly-Once語義配置復雜,可能導致鎖重復消費。

8.4 踩坑指南

偏移量管理:忘了提交偏移量,可能導致鎖無法釋放。

隊列堆積:鎖請求太多,隊列可能堆積,需合理設置分區數。

消費者組重平衡:Kafka消費者組重平衡可能導致鎖短暫不可用,建議用單分區Topic。

8.5 適用場景

消息隊列鎖適合異步、順序性強的場景,比如:

分布式任務隊列的互斥執行。

日志處理系統的順序處理。

事件驅動架構中的資源搶占。

9. 分布式鎖的故障處理:讓鎖“穩如老狗”

分布式鎖再牛,遇到網絡抖動、節點宕機、時鐘偏差,也得瑟瑟發抖。我們來聊聊怎么讓鎖在極端情況下也能穩得住。

9.1 常見故障場景

客戶端宕機:拿了鎖沒釋放,鎖卡死了。

鎖服務宕機:Redis、ZooKeeper或etcd掛了,鎖服務不可用。

網絡分區:客戶端和鎖服務失聯,鎖狀態不明。

時鐘偏差:鎖的過期時間因時鐘不同步而失效。

9.2 故障處理策略

自動釋放:

Redis用TTL,etcd用租約,ZooKeeper用臨時節點,確保客戶端掛了鎖也能釋放。

實現看門狗機制,動態續期鎖,防止業務邏輯時間過長。

服務高可用:

Redis用Sentinel或Cluster模式,保證主節點掛了能切換。

ZooKeeper和etcd本身是集群部署,少數節點故障不影響服務。

部署時確保跨機房、跨區域,降低分區風險。

重試與降級:

獲取鎖失敗時,用指數退避+隨機延遲重試。

極端情況下,降級到本地鎖或無鎖邏輯,優先保證服務可用性。

監控與告警:

監控鎖服務的健康狀態(延遲、錯誤率)。

記錄鎖獲取/釋放日志,方便排查問題。

設置告警,比如鎖沖突率超10%或服務不可用。

9.3 實戰案例:金融系統的鎖容錯

假設你在開發一個轉賬系統,分布式鎖用于保證賬戶余額不被超支。故障處理方案:

Redis主從切換:用Sentinel監控Redis主節點,掛了自動切換從節點。

看門狗續期:每5秒檢查業務邏輯是否完成,未完就延長鎖TTL。

降級策略:Redis不可用時,降級到數據庫悲觀鎖(SELECT ... FOR UPDATE)。

告警機制:鎖獲取失敗率超5%時,觸發郵件告警。

優化后,系統在Redis單點故障下仍能正常運行,鎖沖突率降到1%以下。

10. 跨數據中心分布式鎖:硬核中的硬核

分布式鎖在單數據中心已經夠復雜了,但如果你的系統跨越多個數據中心(比如北京、上海、美國),那難度直接上天!跨數據中心的分布式鎖得面對超高網絡延遲、跨區域一致性挑戰和故障隔離問題。我們來拆解它的實現思路、實戰案例和踩坑指南。

10.1 跨數據中心鎖的挑戰

跨數據中心場景下,分布式鎖得解決以下“硬骨頭”:

高延遲:數據中心間的網絡延遲可能達到100ms甚至更高,鎖的獲取和釋放得考慮這點。

網絡分區:跨區域網絡斷開時,鎖服務得保證一致性或至少明確誰拿到了鎖。

時鐘不同步:不同數據中心的服務器時鐘偏差可能導致鎖過期時間不一致。

故障隔離:一個數據中心掛了,不能拖垮整個鎖系統。

這些問題讓Redis的單點鎖直接“跪了”,ZooKeeper和etcd的集群部署也得重新設計。我們需要一個多中心協同的鎖機制。

10.2 實現方案:基于etcd的多中心鎖

etcd因其Raft協議和租約機制,在跨數據中心場景中有天然優勢。我們可以用多集群聯邦或全局鎖服務來實現。以下是核心思路:

部署多中心etcd集群:每個數據中心部署一個etcd集群,集群間通過gossip協議或專用網絡同步。

全局鎖鍵:用一個全局唯一的鍵(如/global_lock/my_lock)表示鎖,綁定租約。

多數派投票:客戶端向所有數據中心的etcd集群嘗試獲取鎖,多數集群同意才算成功。

租約續期:用etcd的KeepAlive機制動態續租,防止鎖因網絡延遲失效。

故障隔離:如果某個數據中心不可用,多數派機制保證鎖服務繼續運行。

下面是個Go實現的跨數據中心etcd鎖例子:

package mainimport ("context""fmt""time""go.etcd.io/etcd/client/v3""go.etcd.io/etcd/client/v3/concurrency"

)func main() {// 連接多個數據中心的etcd集群endpoints := []string{"beijing.etcd:2379", // 北京數據中心"shanghai.etcd:2379", // 上海數據中心"us.etcd:2379", // 美國數據中心}cli, err := clientv3.New(clientv3.Config{Endpoints: endpoints,DialTimeout: 10 * time.Second, // 考慮跨區域延遲})if err != nil {fmt.Println("連接etcd失敗:", err)return}defer cli.Close()// 創建session,設置較長的TTLsession, err := concurrency.NewSession(cli, concurrency.WithTTL(30))if err != nil {fmt.Println("創建session失敗:", err)return}defer session.Close()// 創建全局鎖mutex := concurrency.NewMutex(session, "/global_lock/my_lock")// 獲取鎖,設置超時ctx, cancel := context.WithTimeout(context.Background(), 15*time.Second)defer cancel()if err := mutex.Lock(ctx); err != nil {fmt.Println("獲取全局鎖失敗:", err)return}fmt.Println("全局鎖獲取成功!開始干活...")// 模擬跨數據中心業務邏輯time.Sleep(10 * time.Second)// 釋放鎖if err := mutex.Unlock(ctx); err != nil {fmt.Println("釋放全局鎖失敗:", err)return}fmt.Println("全局鎖釋放成功!")

}代碼亮點:

多Endpoints:連接多個數據中心的etcd,自動處理網絡分區。

長超時:DialTimeout和context.WithTimeout考慮跨區域高延遲。

長租約:WithTTL(30)確保鎖不會因網絡抖動輕易失效。

10.3 跨數據中心鎖的優化

減少跨中心通信:

在本地數據中心先嘗試獲取鎖,失敗后再去全局集群,降低網絡開銷。

用本地緩存(如Redis)記錄鎖狀態,減少etcd查詢。

優先級機制:

給高優先級的數據中心更高投票權重,加速鎖決策。

比如,北京數據中心是主業務區,可以配置更高的Raft投票權重。

異步同步:

鎖狀態用異步復制到其他數據中心,減少獲取鎖時的同步等待。

etcd的Watch機制可以實時同步鎖變化。

分區容錯:

配置etcd集群的--auto-compaction-retention,清理歷史數據,防止日志膨脹。

用--quota-backend-bytes限制etcd存儲,避免單個數據中心爆盤。

10.4 踩坑指南

網絡延遲:跨數據中心延遲可能導致鎖獲取超時,建議調高超時時間(比如15秒)。

集群同步:etcd集群間同步新能源,同步失敗可能導致鎖丟失。

租約管理:忘了續租,鎖可能提前釋放;建議用KeepAlive定時續期。

時鐘偏差:不同數據中心的時鐘偏差可能導致租約失效,需用NTP同步服務器時間。

10.5 實戰案例:全球電商庫存鎖

假設你是個全球電商平臺,庫存數據分散在北京、上海、美國三個數據中心。鎖需求:

確保全球庫存扣減不超賣。

支持高并發(每秒萬級請求)。

容忍單個數據中心故障。

解決方案:

部署3個etcd集群(每中心一個),用全局鎖鍵/inventory/product:123。

客戶端向所有集群發送鎖請求,多數派(2/3)同意即獲取鎖。

用看門狗線程每10秒續租,防止鎖失效。

監控鎖獲取延遲和失敗率,設置告警閾值(比如失敗率>5%)。

結果:

鎖獲取成功率99.9%,平均延遲200ms。

單個數據中心宕機,鎖服務仍正常運行。

10.6 適用場景

跨數據中心鎖適合全球化、高一致性場景,比如:

全球電商庫存管理。

跨區域分布式事務。

多中心配置同步。

)

:事件總線、setState的細節、PureComponent、ref)

流程實現原理分析)