過去兩年,AI 模型的發展敘事幾乎被兩大陣營主導:無所不能的云端模型與充滿想象的端側模型。行業曾描繪一個誘人藍圖:隨著輕量化模型能力的提升,AI 終將擺脫云端束縛,在每個人的設備上實現永不離線的貼身智能。然而,喧囂過后,現實略顯尷尬:無論是近期爆火的 AI 玩具,還是備受矚目的 AI 眼鏡,其核心交互與智能依然高度依賴云端。即便是算力更強的手機和 PC,真正實現離線 AI 能力的設備也鳳毛麟角。技術演示中無所不能的端側模型,為何最終仍難擺脫網絡依賴?

矛盾的核心在于用戶對體驗的極致追求:即時響應、隱私保障、斷網可用。而端側設備卻面臨無法回避的“物理天花板”——有限的算力、功耗和內存,如同無形壁壘,阻礙了絕大多數高性能模型的落地。

更深層的矛盾則源于商業引力。對掌握頂尖模型的巨頭而言,云端是技術領導力的標桿,更是利潤豐厚的收費站。當所有目光和資源聚焦云端時,投入大、回報周期長且不明確的端側領域,自然成了被忽視的角落。

那么,那些執著推動“離線智能”的少數派在做什么?在今年的世界人工智能大會(WAIC)上,一家名為 RockAI 的公司給出了自己的答案。他們選擇了一條少有人走的路,并找到了破局之鑰。

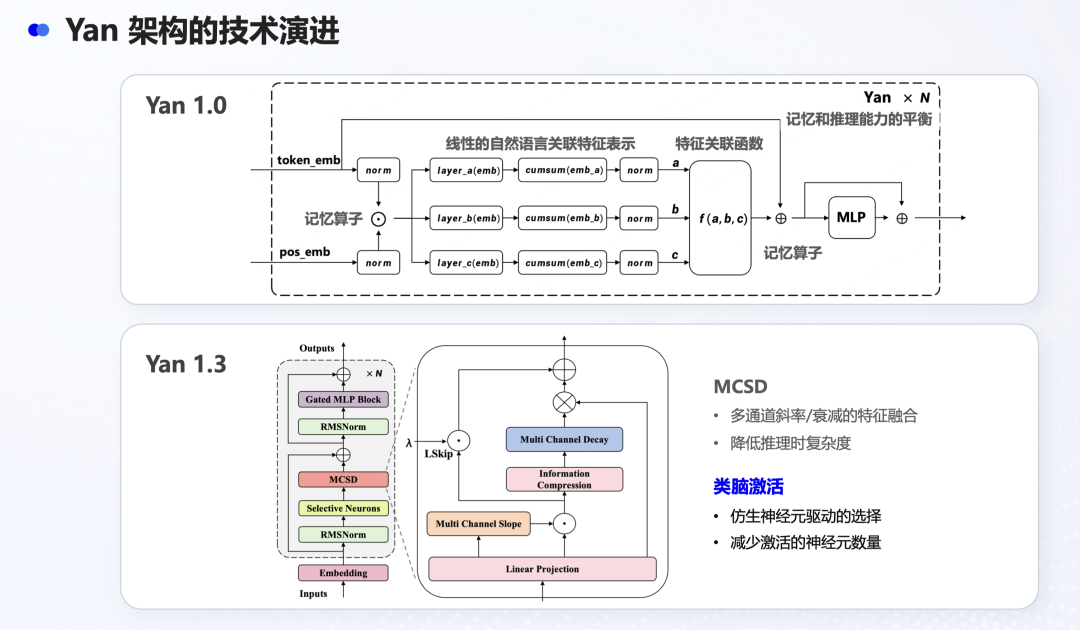

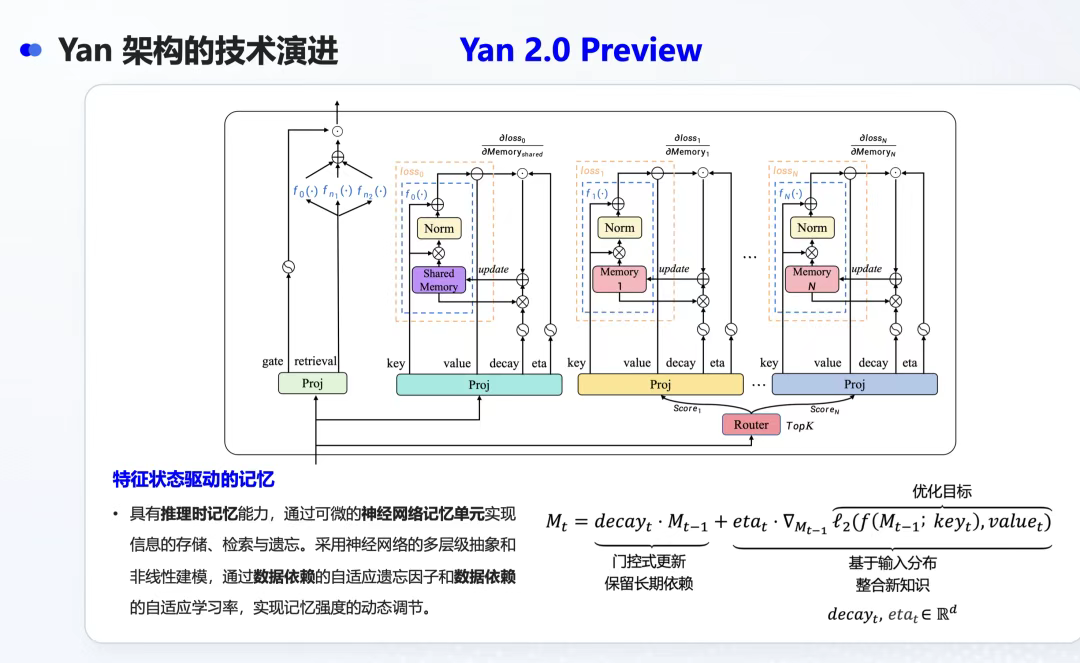

以“讓每臺設備都擁有專屬智能”為使命,RockAI 團隊深入底層技術,甚至大膽舍棄主流的 Transformer 架構,啃下了端側部署這塊“硬骨頭”。早期,他們的模型就能流暢運行在資源有限的樹莓派上——這張卡片大小的電腦是端側部署的嚴苛試金石,多數同類模型在此僅能勉強輸出幾句話便告卡頓。今年 WAIC 推出的 Yan 2.0 Preview 僅 30 億參數,已實現多模態能力,并在本地實現了真正的“記憶”:模型可動態調整權重,長期保留并更新用戶偏好。

這項“不可能的任務”并未止步于實驗室演示。海內外市場的量產訂單紛至沓來,迅速將技術實力轉化為商業價值。RockAI 的故事或許能解答那個根本問題:在云端模型高歌猛進的時代,為何以及如何實現真正的離線智能?極客公園采訪了 RockAI 聯合創始人鄒佳思,探討其背后的商業邏輯。

01 為何永不下線的隨身 AI 尚未普及?

問:?整個行業,包括蘋果這樣的巨頭,都將離線智能視為核心戰略。為何從技術演示到消費者手中,這“最后一公里”如此艱難?

鄒佳思:?理想與現實之間橫亙著兩座大山:算力與功耗。設備端運行大模型需高算力配置。當前許多 AI 公司的小型化模型,仍需高端芯片(如高通最新旗艦芯片+16GB以上內存)支撐。然而,大多數智能設備不具備此等算力。這是最殘酷的鴻溝:再先進的 AI 技術,若只能服務于少數頂配設備,便失去了普惠價值。

功耗則是另一座大山,在手機上尤為突出。一旦嘗試部署大模型,設備便嚴重發熱,這是幾乎所有基于傳統 Transformer 架構模型的通病。主流手機廠商均向我們反饋此痛點,皆被這堵“功耗之墻”所阻。

硬件更新節奏緩慢是根源。大量在售設備配置陳舊(芯片、存儲、麥克風、攝像頭等),并非為當今大模型設計。將 Transformer 強行部署其上,要么無法運行,要么效果差強人意。即使上游推出新一代高端芯片,集成到新產品線也需6-12個月;產品熱銷、規模化普及還需額外1-2年。這是客觀物理現實,無法逾越。

問:?您提到算力功耗問題多源于

Transformer 架構。它在云端表現出色,為何在端側水土不服?

鄒佳思:?這觸及了端側部署的核心挑戰。Transformer 的強大依賴于其革命性的注意力(Attention)機制,但問題也在于此。

傳統 AI 模型像流水線工人,順序處理信息,記憶力有限。Transformer 則像擁有超能力的指揮家,讓信息“排成方陣”,要求每個字與其他所有字“全局握手”計算關聯度。這種機制賦予其超凡理解力。

在云端,無限算力支撐這種計算。但手機芯片(CPU/NPU)設計更擅長高速順序執行任務。突然要求其完成每增加一字計算量便指數級暴增的“全局握手”任務,它便不堪重負。

我們早期便關注此問題。業界現有改進方案(如 Flash Attention、線性注意力)只是在“指揮大廳”內小修小補,未根本改變“全局握手”的高能耗模式。我們選擇了一條更徹底的路:保留 Transformer 強大的特征提取能力,徹底摒棄高耗能的 Attention 機制,代之以全新的、適配“流水線”運行的架構。同期國外的 Mamba 架構也看到了類似方向。我們不是改造不適合小路的 F1 賽車,而是重新設計能在小路上疾馳的越野車。

問:?僅為在設備端運行就需重構架構?離線智能真有此必要?

鄒佳思:?非常必要,且市場需求強勁。其價值無法被云端替代:

絕對隱私安全:?這是蘋果等公司投入端側的核心。最敏感數據(相冊、健康信息、聊天記錄)根本不應離開設備,這是原則問題。

極致實時交互:?許多場景需毫秒級響應。例如,搭載 Yan 架構的無人機需瞬間響應“在我跳起時抓拍”指令。網絡波動在此場景下可能是致命的,無法依賴云端。未來的機器人也需基于其獨特的硬件參數(臂長、傳感器)進行精準實時控制,必須由本地“大腦”完成。

成本考量:?云端 API 價格雖降,但仍有成本。以億級出貨量的攝像頭為例,云端成本乘以海量基數仍是天文數字。離線智能則幾乎無后續使用成本,硬件投入已前置。海量設備本地部署是成本最優解。

本地模型如同守在門口的聰明管家:隱私安全、理解個性化需求。它或許無法解決所有復雜問題,但能又快又安全地處理80%的日常事務(啟動應用、設置提醒、簡單翻譯、會議紀要等)。對多數用戶而言,并非時刻需要處理復雜任務。設備端模型能以更快、更安全、更低成本滿足大部分需求。

02 實現離線智能的模型應如何設計?

問:?為打造這輛“越野車”,其核心引擎——新架構的機制是什么?

鄒佳思:?核心創新在于摒棄 Transformer 高耗能的“全局握手” Attention 機制,回歸更輕量的“特征—抑制—激活”架構,并引入分區激活技術,將每次實際運算的參數量壓縮至十分之一甚至更低,算力需求降至五分之一以上,功耗降至十分之一。

標準 Transformer 中,無論任務多小,所有參數都需全量激活以獲取高智能答案。但人腦并非如此運行。人腦約800-900億“參數”(神經元),若全量激活功耗或達數千瓦,而實際僅約30瓦。奧秘在于分區激活。

我們的模型借鑒此機制。除了顯著降低功耗,新架構還使我們能在30億參數的模型中實現多模態。不嚴謹地比喻:當你看到鳥、聽到鳥鳴、讀到“鳥”字時,大腦并非整體點亮,而是在視覺、聽覺、語言等特定分區激活小范圍神經元。這種分區獨立且重疊的激活,高效對齊了形態、聲音與詞匯。

30億參數以下的 Transformer 因全局計算特性,難以高效對齊多模態信息。而我們的類腦激活機制天然適配大腦分區處理模式,不同模態輸入激活不同分區,使對齊更輕松精準。因此,在3B規模下我們仍保有強大的文本、語音、視覺聯合理解能力。

問:?“分區激活”思路巧妙。但人腦有近千億參數“厚底子”支撐小范圍激活。端側模型僅數十億參數,已是“螺螄殼里做道場”。小模型通過激活更小部分,真能實現更好智能?

鄒佳思:?您的問題觸及了當前大模型范式的核心困境——壓縮智能的局限。

當前預訓練大模型本質是將海量互聯網數據壓縮進千億參數“容器”。參數量越大,“海綿”越大,容納知識越多。但此范式處理多模態時存在弊端:如同文件壓縮,1G文本壓縮后遠小于1G視頻/圖像(后者本身體積大、壓縮比低)。因此,小參數 Transformer 模型難以加入多模態能力。

若規則僅是比拼“海綿”大小與“背書”厚度,小模型確無前途。但我們認為,真正的智能不應僅是壓縮,更應是成長與學習。這是我們的根本差異:壓縮智能 + 自主學習雙線并行。

分區激活的意義不僅在于節能,更在于為成長提供可能。當前模型30億參數,通過精細的動態分區(如分為100區),一次僅激活約3000萬參數。這意味著,未來可在手機內存允許范圍內,將端側模型總參數做大(如百億級),但僅激活極小部分以維持低功耗。

這顛覆了游戲規則。我們不再內卷于如何壓縮大模型,而是探索如何讓端側模型從小成長到大。當業界在壓縮之路上內卷時,我們通過 MCSD 架構、分區激活、記憶神經單元,為端側模型開辟了第二條、更符合生命本質的成長路徑——可持續、低成本的自主學習。我們不僅在構建能跑在設備端的模型,更在構建端側 AI 未來所需的、可不斷成長的“大腦底座”。

問:?如何理解 Yan 模型的“自主學習”?它與云端模型的個性化有何不同?

鄒佳思:?“自主學習”正是我們在 WAIC 展示的最令人興奮的突破之一。

當前云端大模型需通過預訓練更新智能。模型真正的學習過程——理解用戶反饋并體現于神經網絡變化——依賴前向傳播(推理)?和反向傳播(學習)。反向傳播極其耗能:云端千億模型一次反向傳播需動用龐大 GPU 訓練集群。

因此,所有基于 Transformer 的模型,一旦部署到手機,便淪為“只讀存儲器”——僅有前向傳播能力,喪失學習可能。所謂的“個性化”只是通過對話形成外掛知識庫記憶偏好,并非根本性學習。故用戶即使多次強調偏好,模型仍可能“自行其是”。

我們的創新恰恰在最根本的物理限制上實現了突破:首次讓反向傳播學習過程在端側設備成為可能。得益于分區激活,當模型需學習新知識(如“喝咖啡不加糖”)時,無需撼動整個神經網絡。架構能鎖定與此新知識直接相關的、被激活的極小區塊。在這個隔離的“微型戰場”,執行一次低功耗反向傳播,僅更新該分區內極少數權重參數,將新知識直接、永久寫入模型本體神經網絡。

通往個性化記憶和自主學習的大門由此開啟。模型可邊使用(推理)邊學習(訓練),將新習慣、新偏好直接寫入本體,獲得真正的自主進化能力。

03 離線智能何時賦能 AI 玩具?

問:?從技術回到市場:當業界追逐云端千億模型時,你們的技術已獲真實訂單。哪些玩家對離線智能最執著?其商業驅動力何在?

鄒佳思:?我們接觸多領域客戶,其離線智能訴求背后皆有深刻商業邏輯。PC、平板和機器人是當前核心量產領域,我們更關注廣闊的中低算力市場。

以某頭部出海廠商合作為例。其核心訴求不僅是打造未來旗艦機的 AI 功能,更是盤活手中數億已售或正售的中低端設備。這關乎兩條生命線:

存量設備激活:?通過 OTA 為舊設備推送我們的 AI 模型,可創造全新軟件預裝和增值服務收入,極大提升品牌價值(“幾年前買的電腦竟能升級為 AI PC!”)。

非旗艦新機賦能:?品牌不能僅靠頂配 AI PC 生存,真正銷量利潤源于中低端市場。但這些設備受限于芯片算力,無法運行主流 Transformer 模型。我們的技術填補了巨大空窗期,讓廠商能立即(而非苦等三年)將 AI PC 賣到用戶手中。

此外,我們也關注機器人和手機領域,并與無人機公司合作。

問:?炙手可熱的 AI 眼鏡和 AI 玩具領域呢?

鄒佳思:?這兩類產品代表了端側 AI 最性感的想象,但也面臨最骨感的現實:根源問題是相同的——為極致成本控制和輕便性,其內置芯片設計之初并非為運行 AI。

AI 眼鏡:?主流方案使用高通 AR 芯片或恒玄等通信芯片,任務聚焦藍牙連接、信息投屏、簡單翻譯,算力內存被嚴格限制。我們的模型在多數眼鏡上尚難運行,更遑論數十億參數的 Transformer 模型。

AI 玩具:?市場對體驗期望極高,硬件現實卻極殘酷。

面對此困境,我們推進兩條路徑:

曲線救國(當下務實):?借助手機算力。正與頭部眼鏡廠商深入洽談此方案。

釜底抽薪(面向未來):?與影目科技(INMO)等伙伴嘗試在下一代眼鏡中換裝更強“大腦”芯片。雖面臨功耗和工業設計挑戰,但一旦成功,將打造出真正離線智能的差異化產品(如無網環境下的高質量即時翻譯)。

因此,對眼鏡和玩具市場,我們有務實當下方案,也有著眼未來的終極目標。爆發需等待技術與硬件完美共振。

問:?國內 AI 硬件賽道火熱但多依賴云端。觀察到你們客戶主要銷往海外。離線智能需求在海外是否更旺盛?

鄒佳思:?您觀察到的“溫度差”正是我們當前戰略核心。海外智能硬件市場提供了一片更廣闊的藍海,源于三個國內相對不敏感的痛點:

文化驅動的隱私執念:?歐美用戶對數據隱私的重視深入骨髓且受法律保障。例如,某頭部玩具 IP 公司因不愿用戶隱私上云而對我們的方案興趣濃厚。

客觀存在的網絡鴻溝:?全球許多地區(如非洲原野、東南亞島嶼)網絡環境不穩定,離線模型是確保可靠體驗的“救命稻草”。

高人力成本催生的效率需求:?海外用機器替代人力的意愿更強,對無需聯網的7x24小時服務(如接待員、導游)需求更直接迫切。

因此,我們戰略清晰——“借船出海”:賦能優秀的中國出海企業,將技術帶給全球對離線智能有真實、強烈需求的C端用戶。

問:?前景激動人心,但需直面現實:一方面,手機巨頭重兵自研端側 AI;另一方面,硬件遵循摩爾定律飛速發展。兩三年后,當手機芯片能輕松運行更大模型時,你們“小而美”的優勢是否仍在?RockAI 的核心護城河是什么?

鄒佳思:?此問題點出了我們每日思考的兩大挑戰。

首先,硬件變強對我們有利:

高端硬件普及需至少2-3年窗口期,此間我們是解決海量存量及中端設備 AI 化的最優解。

硬件底座變強后,不僅能運行更大的 Transformer,也能運行我們從小長大的 Yan 架構大模型(如10B+)。我們獨特的自主學習、低功耗等優勢依然存在。

更深層的護城河關乎公司靈魂。團隊源于一個始于2015年未竟的智能硬件夢(類似小愛同學),因當時AI技術不成熟而失敗。看到 Transformer 潛力后我們重聚創業,卻痛苦發現將這臺“云端猛獸”塞入設備在工程上走不通。

當時有兩條路:

跟隨主流,優化 Transformer(更易行、易獲投資認可)。

選擇更艱難孤獨之路:承認此路不通,從零構建全新的端側原生架構。

我們選擇了后者。支撐我們的并非資金、算力或團隊光環,而是一種近乎“信念”的堅持。我們篤信模型必須運行于端側,設備必須擁有自身智能。正是這份執念,讓我們在別人追逐云端風口時,甘坐兩年多“冷板凳”,在實驗室反復“煉丹”,最終煉成 Yan 架構這顆“丹”。

因此,我們的護城河非單一技術點(聰明團隊眾多),而是因堅持而積累的深刻認知、趟過的深坑,以及從第一天起就為端側智能而生的創新基因。

)

![洛谷P1036 [NOIP 2002 普及組] 選數](http://pic.xiahunao.cn/洛谷P1036 [NOIP 2002 普及組] 選數)

文件共享)

詳細教程(2025.3最新可用鏡像,全網最詳細))

)