交叉驗證(Cross-Validation)是機器學習中評估模型性能、選擇最優參數和防止過擬合的核心技術。它在整個機器學習流程中扮演著關鍵角色。

一、為什么需要交叉驗證?

1. 解決訓練/測試劃分的局限性

- ??問題??:隨機單次劃分訓練集/測試集可能導致:

- ??評估不穩定??:不同劃分結果差異大

- ??數據利用低效??:測試集固定且單一

- ??解決方案??:交叉驗證循環使用數據作為測試集

2. 避免過擬合

- ??問題??:在測試集上直接調參會導致"??模型過擬合測試集??"

- ??解決方案??:在交叉驗證的內部循環中進行參數調整,保留獨立測試集用于最終評估

3. 提高數據利用效率

- ??小樣本場景??:交叉驗證最大化利用有限數據(尤其醫療、金融等數據獲取難的領域)

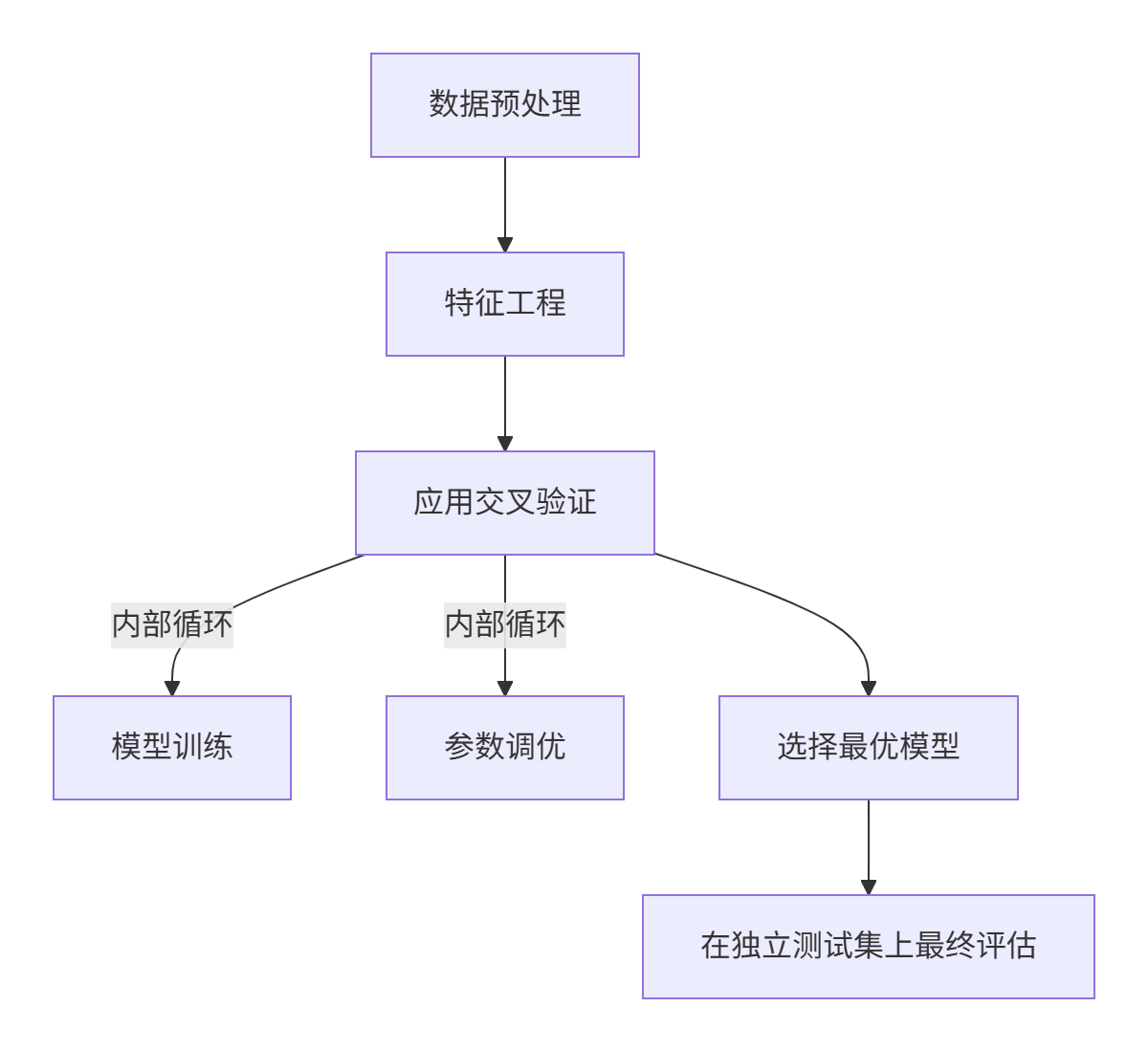

二、交叉驗證在機器學習流程中的位置

交叉驗證在機器學習三大階段的角色

??模型訓練階段??

- 交叉驗證提供多個訓練/驗證循環

- 每個循環中用部分數據訓練,剩余數據驗證

??模型評估階段??

- 將k次驗證結果平均作為模型性能評估

- 比單次驗證更穩定可靠

??參數調優階段??

- 網格搜索(GridSearchCV)的核心是交叉驗證

- 系統地探索不同參數組合的效果

三、交叉驗證的常見類型

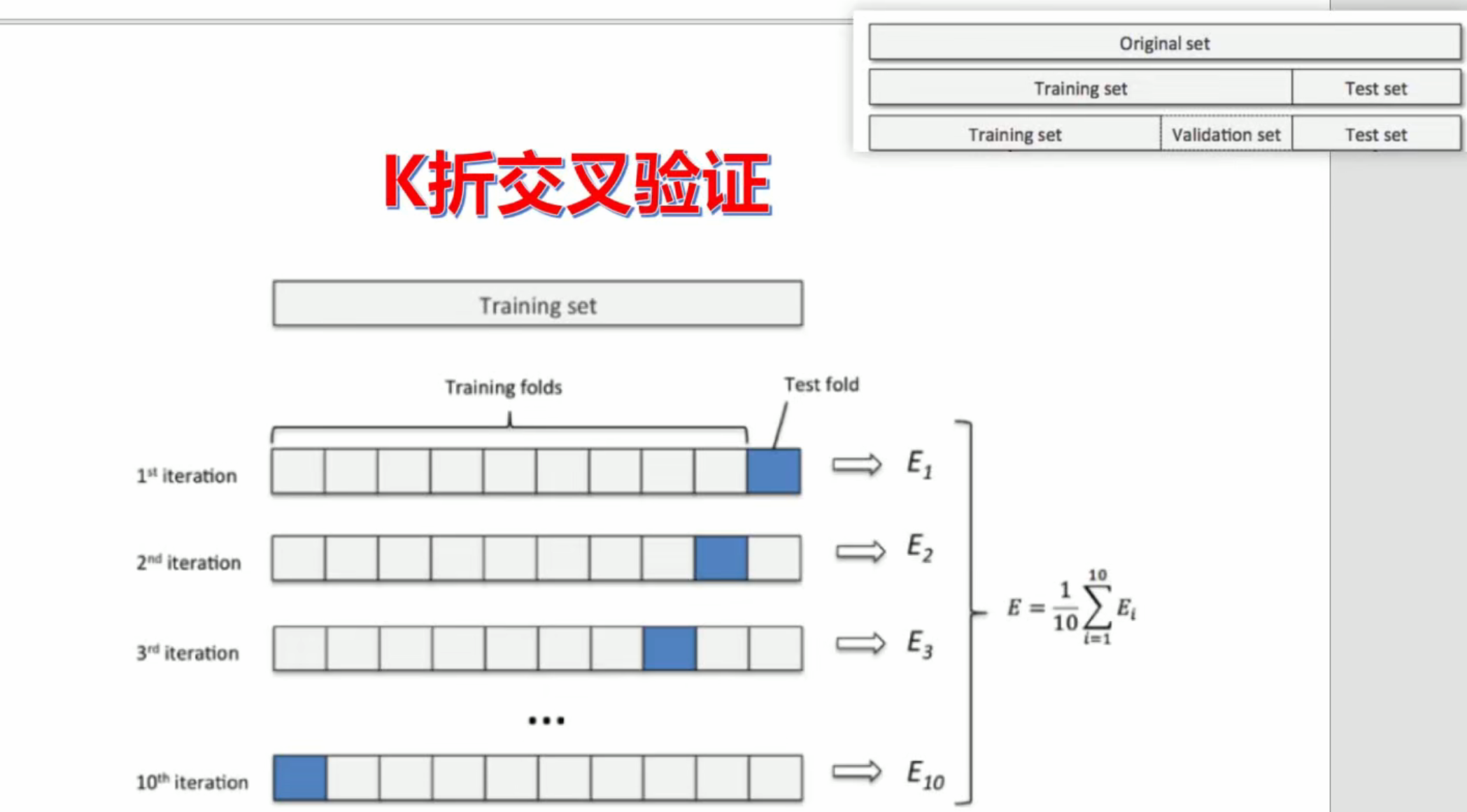

1. K折交叉驗證(K-Fold)

將數據分為K個大小相似的互斥子集,每次用K-1個子集訓練,剩余1個測試

from sklearn.model_selection import KFoldkf = KFold(n_splits=5) # 5折交叉驗證

for train_index, test_index in kf.split(X):X_train, X_test = X[train_index], X[test_index]y_train, y_test = y[train_index], y[test_index]# 訓練并評估模型

from sklearn.model_selection import cross_val_score# 執行交叉驗證(此處為示例模板,實際需要具體模型和數據)

scores = cross_val_score(estimator, # 模型對象(如LogisticRegression)X, # 特征矩陣y, # 目標向量cv=5, # 交叉驗證折疊數(K折交叉驗證)scoring='accuracy', # 評估指標(可用'recall', 'precision', 'f1'等)n_jobs=-1 # 使用全部CPU核心并行計算

)# 實際應用中模型和評分指標選擇示例:

# from sklearn.linear_model import LogisticRegression

# model = LogisticRegression()

# scores = cross_val_score(model, X, y, cv=5, scoring='recall', n_jobs=-1)2. 分層K折交叉驗證(Stratified K-Fold)

保持每個折中類別的分布與完整數據集相同

from sklearn.model_selection import StratifiedKFoldskf = StratifiedKFold(n_splits=5) # 分層5折3. 留一交叉驗證(Leave-One-Out, LOO)

每個樣本都單獨作為測試集一次(極端的K=N折)

from sklearn.model_selection import LeaveOneOutloo = LeaveOneOut()4. 時間序列交叉驗證(Time Series Split)

考慮時間依賴關系,確保未來數據不用于預測過去

from sklearn.model_selection import TimeSeriesSplittscv = TimeSeriesSplit(n_splits=5)四、交叉驗證在模型選擇中的應用示例

from sklearn.model_selection import cross_val_score

from sklearn.linear_model import LogisticRegression# 創建邏輯回歸模型

model = LogisticRegression(max_iter=1000)# 執行5折交叉驗證

cv_scores = cross_val_score(model, X_train, y_train,cv=5, # 5折交叉驗證scoring='recall', # 評估指標為召回率n_jobs=-1 # 使用所有CPU核心

)# 計算平均分

mean_recall = np.mean(cv_scores)

print(f"平均召回率: {mean_recall:.4f} (±{np.std(cv_scores):.4f})")五、交叉驗證在網格搜索中的應用示例

from sklearn.model_selection import GridSearchCV# 定義參數網格

param_grid = {'C': [0.001, 0.01, 0.1, 1, 10, 100],'penalty': ['l1', 'l2']

}# 設置網格搜索交叉驗證

grid_search = GridSearchCV(LogisticRegression(solver='liblinear', max_iter=1000),param_grid,cv=5, # 5折交叉驗證scoring='roc_auc',# 使用AUC評分n_jobs=-1

)# 執行網格搜索

grid_search.fit(X_train, y_train)# 輸出最優參數

print(f"最優參數: {grid_search.best_params_}")六、交叉驗證與數據集大小的關系

| 數據規模 | 推薦方法 | 原因 |

|---|---|---|

| ??大樣本??(>10萬) | 簡單訓練/驗證/測試分割 | 計算效率優先 |

| ??中樣本??(1千-10萬) | K折交叉驗證(K=5或10) | 平衡穩定性和計算量 |

| ??小樣本??(<1千) | 留一交叉驗證或分層K折(K=10) | 最大化數據利用 |

七、交叉驗證的最佳實踐

??數據分布??:

- 不平衡數據使用分層交叉驗證

- 時間序列數據使用時序交叉驗證

??計算效率??:

- 數據量大時考慮縮小K值或使用ShuffleSplit

- 并行計算加速(n_jobs參數)

??結果解釋??:

- 考慮交叉驗證分數的方差

- 檢查不同折之間的性能差異

??避免泄露??:

- 所有特征工程步驟應在每個折疊中獨立進行

- 永遠不要在交叉驗證循環中包含測試集數據

??交叉驗證是機器學習實踐中最實用、最核心的技術之一??,掌握它可以顯著提升建模的穩健性和可靠性。在整個機器學習流程中,從模型開發到參數選擇再到最終評估,交叉驗證都扮演著不可或缺的角色。

)

![洛谷P1036 [NOIP 2002 普及組] 選數](http://pic.xiahunao.cn/洛谷P1036 [NOIP 2002 普及組] 選數)

文件共享)

詳細教程(2025.3最新可用鏡像,全網最詳細))

)

-卷積神經網絡架構)