歡迎關注[【AIGC論文精讀】](https://blog.csdn.net/youcans/category_12321605.html)原創作品

【DeepSeek論文精讀】1. 從 DeepSeek LLM 到 DeepSeek R1

【DeepSeek論文精讀】7. DeepSeek 的發展歷程與關鍵技術

【DeepSeek論文精讀】11. 洞察 DeepSeek-V3:擴展挑戰和對 AI 架構硬件的思考

【DeepSeek論文精讀】11. 洞察 DeepSeek-V3:擴展挑戰和對 AI 架構硬件的思考

- 0. 論文簡介與摘要

- 0.1 論文簡介

- 0.2 論文概覽

- 0.3 摘要

- 1. 引言

- 1.1 背景

- 1.2 目標

- 1.3 本文結構

- 2. DeepSeek模型的設計原則

- 2.1 內存效率

- 2.1.1 低精度模型

- 2.1.2 MLA壓縮KV緩存

- 2.1.3 資源高效技術的未來方向

- 2.2 MoE模型的成本效益

- 2.2.1 降低訓練的計算需求

- 2.2.2 本地部署優勢

- 2.3 推理加速

- 2.3.1 通信與計算重疊

- 2.3.2 推理速度極限

- 2.3.3 多令牌預測

- 2.3.4 推理模型的測試時擴展

- 2.4 技術驗證方法

- 3 低精度驅動設計

- 3.1 FP8混合精度訓練

- 3.1.1 局限性

- 3.1.2 建議

- 3.2 LogFMT:通信壓縮

- 3.2.1 局限性

- 3.2.2 建議

- 4. 互連驅動設計

- 4.1 當前硬件架構

- 4.2 硬件感知并行策略

- 4.3 模型協同設計:節點受限路由

- 4.4 縱向與橫向擴展融合

- 4.4.1 現有實現局限

- 4.4.2 改進建議

- 4.5 帶寬爭用與延遲

- 4.5.1 現存問題

- 4.5.2 優化方向

- 5. 大規模網絡驅動設計

- 5.1 網絡協同設計:多平面胖樹

- 5.1.1 多平面胖樹網絡優勢

- 5.1.2 性能分析

- 5.2 低延遲網絡

- 5.2.1 IB與RoCE對比

- 5.2.2 RoCE改進建議

- 5.2.3 InfiniBand GPUDirect異步(IBGDA)

- 6. 未來硬件架構設計的討論和洞見

- 6.1 魯棒性挑戰

- 6.1.1 現存問題

- 6.1.2 高級錯誤檢測和更正建議

- 6.2 CPU瓶頸與互連

- 6.3 智能網絡演進方向

- 6.4 內存語義通信與順序問題

- 6.5 網內計算與壓縮

- 6.6 內存中心創新

- 6.6.1 內存帶寬局限

- 6.6.2 發展方向

- 7. 結論

- 參考文獻

0. 論文簡介與摘要

0.1 論文簡介

2025年 5月,DeepSeek AI 公開了將于 ISCA’25 發表的論文 Insights into DeepSeek-V3: Scaling Challenges and Reflections on Hardware for AI Architectures(洞察 DeepSeek-V3:擴展挑戰和對 AI 架構硬件的思考)。梁文鋒也是本文的署名作者。

本文深入分析了DeepSeek-V3/R1模型架構及其AI基礎設施,重點闡述了多項關鍵創新:提升內存效率的多頭潛在注意力(MLA)、優化計算-通信權衡的混合專家(MoE)架構、釋放硬件全部潛力的FP8混合精度訓練,以及最小化集群級網絡開銷的多平面網絡拓撲。

論文標題:Insights into DeepSeek-V3: Scaling Challenges and Reflections on Hardware for AI Architectures

發布時間:2025年5月 [2405.09343]

論文地址:arxiv-DeepSeek-V3

發表于:Proceedings of the 52nd Annual International Symposium on Computer Architecture; June 21–25, 2025; Tokyo, Japan

引用格式:Chenggang Zhao, Chengqi Deng, Chong Ruan, Damai Dai, Huazuo Gao, Jiashi Li, Liyue Zhang, Panpan Huang, Shangyan Zhou, Shirong Ma, Wenfeng Liang, Ying He, Yuqing Wang, Yuxuan Liu, Y.X. Wei . 2025. Insights into DeepSeek-V3: Scaling Challenges and Reflections on Hardware for AI Architectures. In Proceedings of the 52nd Annual International Symposium on Computer Architecture (ISCA ’25), June 21–25, 2025, Tokyo, Japan. ACM, New York, NY, USA https://doi.org/10.1145/3695053.3731412

0.2 論文概覽

研究背景:

論文指出當前大模型(如OpenAI o1/o3、DeepSeek-R1、Claude-3.7等)的發展凸顯了提升推理效率的必要性,尤其是在長上下文處理與深度推理場景下,這對計算資源提出了更高需求。

核心內容:

- 模型設計原則:

- 內存效率優化:通過改進注意力機制等設計降低內存占用。

- 低精度訓練:提出FP8混合精度訓練方案,并針對現有硬件局限性給出改進建議(如減少特定操作的計算復雜度)。

- 硬件協同設計:

- 互聯驅動設計:強調通過 Scale-Up 與 Scale-Out 網絡融合優化帶寬利用率,減少EP all-to-all通信的操作開銷。

關鍵技術與創新:

- 采用混合專家(MoE)架構和多平面網絡(Multi-Plane Network),結合FP8混合精度訓練提升計算效率。

- 提出硬件與算法的協同設計思路,以應對大模型推理中的算力瓶頸。

0.3 摘要

大型語言模型(LLM)的快速擴展揭示了當前硬件架構的關鍵局限性,包括內存容量、計算效率和互連帶寬的約束。

基于2,048塊NVIDIA H800 GPU訓練的DeepSeek-V3證明了硬件感知的模型協同設計如何有效應對這些挑戰,從而實現高性價比的大規模訓練與推理。

本文深入分析了DeepSeek-V3/R1模型架構及其AI基礎設施,重點闡述了多項關鍵創新:提升內存效率的多頭潛在注意力(MLA)、優化計算-通信權衡的混合專家(MoE)架構、釋放硬件全部潛力的FP8混合精度訓練,以及最小化集群級網絡開銷的多平面網絡拓撲。

基于DeepSeek-V3開發過程中遇到的硬件瓶頸,我們與學界和業界同行展開更廣泛的討論,探討未來硬件的潛在發展方向,包括精確低精度計算單元、縱向擴展與橫向擴展的融合,以及低延遲通信架構的創新。這些見解強調了硬件與模型協同設計在滿足AI工作負載日益增長需求中的關鍵作用,為下一代AI系統創新提供了實用藍圖。

關鍵詞:大語言模型,混合專家,深度學習,FP8混合精度訓練,多平面網絡,協同設計

1. 引言

1.1 背景

近年來,大型語言模型(LLM)在模型設計、計算能力和數據可用性的迭代進步推動下快速發展。2024年,GPT4o(OpenAI, 2024a)、LLaMa-3(AI@Meta, 2024a)、Claude 3.5 Sonnet(Anthropic, 2024)、Grok-2(xAI, 2024a)、Qwen2.5(Yang et al., 2024)、Gemini-2(Google, 2024)以及我們的DeepSeek-V3(DeepSeek-AI, 2024d)等突破性模型展現了顯著進展,進一步縮小了與通用人工智能(AGI)的差距。正如《縮放法則》(Kaplan et al., 2020)所示,增加模型規模、訓練數據和計算資源可顯著提升模型性能,凸顯了規模擴展在推動AI能力中的關鍵作用。總體而言,這些進展開啟了一個新時代,其中擴大模型規模與計算能力被視為解鎖更高智能水平的關鍵。

近期,OpenAI的o1/o3系列模型(OpenAI, 2024b, 2025)、DeepSeek-R1(DeepSeek-AI, 2025a)、Claude-3.7 Sonnet(Anthropic, 2025)、Gemini 2.5 Pro(Google, 2025)、Seed1.5-Thinking(Seed, 2025)和Qwen3(Team, 2025)等推理模型不僅展示了大尺度架構的優勢,還凸顯了提升推理效率的必要性,尤其是在處理更長上下文和實現更深層次推理方面。這些進步對計算資源提出了日益增長的需求,要求推理更快、更高效。

為應對這些挑戰,阿里巴巴、字節跳動、谷歌、xAI和Meta等行業領導者部署了龐大的訓練集群(Jouppi et al., 2023; Mudigere et al., 2023; Gangidi et al., 2024; Jiang et al., 2024; Qian et al., 2024; xAI, 2024b),配備數萬甚至數十萬GPU或TPU。盡管此類超大規模基礎設施支持了尖端模型的開發,但其高昂成本對小型研究團隊和組織構成了顯著壁壘。盡管如此,DeepSeek(DeepSeek-AI, 2024b, c, d, a, 2025a)和Mistral(Jiang et al., 2023; Mistral, 2024)等開源初創公司仍致力于開發前沿模型。其中,DeepSeek尤其證明了軟硬件協同設計能夠實現大模型的高性價比訓練,為小型團隊創造了公平競爭環境。

基于這一傳統,DeepSeek-V3(DeepSeek-AI, 2024d)代表了高性價比訓練的新里程碑。僅使用2,048塊NVIDIA H800 GPU,DeepSeek-V3便實現了頂尖性能。這一成就與通過實用、可擴展方案推動AI發展的承諾一致,此前Fire-Flyer AI-HPC(An et al., 2024)的高性價比架構已印證這一點。DeepSeek-V3的實踐與洞見展示了如何最大限度利用現有硬件資源,為更廣泛的AI和HPC社區提供了寶貴經驗。

1.2 目標

本文并非重申DeepSeek-V3的詳細架構與算法細節(其技術報告已全面記錄,見DeepSeek-AI, 2024d),而是從硬件架構與模型設計的雙重視角出發,探討二者如何協同實現高性價比的大規模訓練與推理。通過分析這種協同效應,我們旨在為高效擴展LLM提供可行見解,同時不犧牲性能或可及性。

具體而言,本文聚焦于:

- 硬件驅動的模型設計:

分析FP8低精度計算、縱向/橫向擴展網絡特性等硬件特性如何影響DeepSeek-V3的架構選擇。 - 硬件與模型的相互依賴:

研究硬件能力如何塑造模型創新,以及LLM不斷演進的需求如何推動下一代硬件的需求。 - 硬件發展的未來方向:

從DeepSeek-V3中提煉可行洞見,指導未來硬件與模型架構的協同設計,為可擴展、高性價比的AI系統鋪路。

1.3 本文結構

本文余下部分安排如下:

- 第2章 探討DeepSeek-V3模型架構的設計原則,重點介紹多頭潛在注意力(MLA)、混合專家(MoE)優化和多令牌預測模塊等關鍵創新;

- 第3章 闡述模型架構如何實現低精度計算與通信;

- 第4章 涵蓋縱向擴展互連優化,討論縱向/橫向擴展的融合,并分析硬件特性如何影響并行性與專家選擇策略;

- 第5章 聚焦橫向擴展網絡優化,包括多平面網絡協同設計與低延遲互連。除第3~5章提及的當前局限與未來建議外,

- 第6章 進一步提煉DeepSeek-V3的關鍵洞見,并指明未來硬件與模型協同設計的方向。

圖 1:DeepSeek-V3 的基本架構。

基于 DeepSeek-V2 的 MLA 和 DeepSeekMoE 構建,引入了多標記預測模塊和 FP8 混合精度訓練,以提高推理和訓練效率。該圖顯示了架構不同部分用于計算的精度。所有組件都采用 BF16 的輸入和輸出。

2. DeepSeek模型的設計原則

DeepSeek-V3的開發體現了硬件感知的大語言模型擴展方法,每個設計決策都與硬件約束精準對齊,以優化性能和成本效益。

如圖1所示,DeepSeek-V3采用了已在DeepSeek-V2[25]中驗證有效的DeepSeekMoE[27]和多頭潛在注意力(MLA)[25]架構。

- DeepSeekMoE釋放了混合專家架構的潛力,而MLA通過壓縮鍵值(KV)緩存大幅降低內存消耗。

- DeepSeek-V3引入FP8混合精度訓練,在保持模型質量的同時顯著降低計算成本。

- 為提升推理速度,模型基于多令牌預測模塊實現推測式解碼,使生成速度顯著提升。

- 在基礎設施層面,我們采用多平面雙層胖樹網絡替代傳統三層拓撲,降低集群組網成本。

這些創新共同應對大模型擴展的三大核心挑戰——內存效率、成本效益和推理速度,下文將詳細闡述。

2.1 內存效率

大語言模型通常需要大量內存資源,其需求年增長率超1000%,而HBM等高速內存容量年增速不足50%[35]。雖然多節點并行是解決內存限制的可行方案,但從源頭優化內存使用仍是關鍵策略。

2.1.1 低精度模型

相比BF16權重模型,FP8將內存消耗減半,有效緩解AI內存墻問題。第3章將詳細討論低精度驅動設計。

2.1.2 MLA壓縮KV緩存

多輪對話場景中,歷史上下文的KV緩存會持續增長。傳統方法需為每個注意力頭存儲獨立的KV對,導致內存占用隨序列長度線性增加。我們采用多頭潛在注意力(MLA)[25],通過投影矩陣將所有注意力頭的KV表示壓縮為聯合訓練的潛在向量。推理時僅需緩存潛在向量,較傳統方法顯著節省內存。

其他KV壓縮方法包括:

- 共享KV(GQA/MQA):多個頭共享一組 KV 對,而不是為每個注意力頭維護單獨的 KV 對,從而顯著壓縮了 KV 存儲。代表性方法包括 GQA [5] 和 MQA [70]。

- 滑動窗口KV:對于長序列,緩存中僅保留 KV 對的滑動窗口,丟棄窗口外的結果。雖然這減少了存儲,但它損害了長上下文推理。代表性方法包括 Longformer [11] 和相關架構。

- 量化壓縮:KV 對使用低位表示 [40, 44, 52] 進行存儲,進一步減少內存使用。量化可實現顯著的壓縮,同時對模型性能的影響最小。

如表1所示,DeepSeek-V3每令牌僅需70KB KV緩存,遠低于LLaMA-3.1 405B(516KB)和Qwen-2.5 72B(327KB)。

表 1 比較了 DeepSeek-V3 、 Qwen-2.5 72B [75] 和 LLaMA-3.1 405B [4] 之間每個令牌的 KV 緩存內存使用情況。通過采用 MLA,DeepSeek-V3 顯著減少了 KV 緩存大小,每個令牌只需要 70 KB,大大小于 LLaMA-3.1 405B 的 516 KB 和 Qwen-2.5 72B 的 327 KB。與基于 GQA 的方法相比,這種減少突出了 MLA 在壓縮 KV 表示方面的效率。實現如此顯著的內存消耗降低的能力使 DeepSeekV3 特別適合涉及長上下文處理和資源受限環境的場景,從而實現更具可擴展性和成本效益的推理。

2.1.3 資源高效技術的未來方向

雖然減小 KV 緩存的大小是提高內存效率的一種很有前途的方法,但基于 Transformer 的自回歸解碼固有的二次復雜度仍然是一個艱巨的挑戰,尤其是對于極長的上下文。最近的研究工作,如 Mamba-2 [21] 和 Lightning Attention[63],研究了為平衡計算成本和模型性能提供新可能性的線性時間替代方案。此外,諸如稀疏注意力[76]等方法,試圖壓縮和稀疏激活注意力鍵和值,代表了克服與注意力相關的計算挑戰的另一種嘗試。我們期待與更廣泛的社區合作,在這一領域取得突破。

2.2 MoE模型的成本效益

對于稀疏計算,我們開發了 DeepSeekMoE,這是一種高級專家混合 (MoE) 架構,如圖 1 的右下角所示。MoE 模型的優勢在于兩個方面。

2.2.1 降低訓練的計算需求

MoE 架構的主要優勢在于它能夠顯著降低訓練成本。

通過選擇性地僅激活專家參數的子集,MoE 模型允許總參數數量急劇增加,同時保持計算要求適中。例如,DeepSeek-V2 具有 236B 參數,但每個令牌只激活了 21B 參數。同樣,DeepSeek-V3 擴展到 671B 參數(幾乎是 V2 的三倍),同時將每個令牌的激活率保持在僅 37B。相比之下,Qwen2.5-72B 和 LLaMa3.1-405B 等密集模型要求所有參數在訓練期間都處于活動狀態。

如表 2 所示,DeepSeekV3 的總計算成本約為每個令牌 250 GFLOPS,而 72B 密集模型需要 394 GFLOPS,405B 密集模型需要 2448 GFLOPS。這表明 MoE 模型實現了與密集模型相當甚至更好的性能,同時消耗的計算資源減少了一個數量級。

2.2.2 本地部署優勢

個人使用和本地部署的優勢。

在未來,個性化 LLM 代理 [53] 變得無處不在,MoE 模型在單一請求場景中提供了獨特的優勢。由于每個請求僅激活一個參數子集,因此內存和計算需求大大減少。例如,DeepSeek-V2(236B 參數)在推理過程中僅激活 21B 參數。這使得配備 AI SoC 芯片 [6, 10, 58] 的 PC 能夠實現每秒近 20 個令牌 (TPS),甚至是該速度的兩倍,這對于個人使用來說綽綽有余。相比之下,具有相似功能(例如 70B 參數)的密集模型在類似硬件上通常只能達到個位數的 TPS。

值得注意的是,越來越流行的 KTransformers [39] 推理引擎允許完整的 DeepSeek-V3 模型在配備消費類 GPU 的低成本服務器上運行(成本約為 10,000 美元),同時仍能實現近 20 TPS。這種效率使 MoE 架構適用于硬件資源通常有限的本地部署和單用戶場景。通過最大限度地減少內存和計算開銷,MoE 模型可以提供高質量的推理性能,而無需昂貴的基礎設施。

2.3 推理加速

2.3.1 通信與計算重疊

通過雙微批次流水線設計[31,78],我們將MLA與MoE計算解耦為兩個階段,使all-to-all通信與計算完全重疊。生產環境中還采用預填充/解碼分離架構[80],根據任務特性分配專家并行組規模以最大化系統吞吐。

推理速度包括系統范圍的最大吞吐量和單次請求延遲。為了最大限度地提高吞吐量,我們的模型從一開始就被構建為利用雙微批處理重疊 [31, 78],有意將通信延遲與計算重疊。正如我們的在線推理系統所展示的,并得到開源分析數據 [31] 的支持,我們將 MLA 和 MoE 的計算解耦為兩個不同的階段。當一個微批處理執行一部分 MLA 或 MoE 計算時,另一個微批處理同時執行相應的調度通信。相反,在第二個微批處理的計算階段,第一個微批處理將執行組合通信步驟。這種流水線方法實現了全對全通信與正在進行的計算的無縫重疊,確保 GPU 始終保持充分利用。此外,在生產中,我們采用預填充和解碼解聚架構 [80],將大批量預填充和延遲敏感的解碼請求分配給不同的專家并行組大小。此策略最終可在實際服務條件下最大限度地提高系統吞吐量。

2.3.2 推理速度極限

在配備400Gbps InfiniBand的系統中,DeepSeek-V3的理論TPOT上限為14.76ms(67TPS)。若采用GB200 NVL72(900GB/s單向帶寬),理論極限可提升至0.82ms(1200TPS),凸顯高帶寬互連的革命性潛力。

本節重點介紹 LLM 服務的解碼輸出速度,通常以每個輸出令牌的時間 (TPOT) 來衡量。TPOT 是用戶體驗的關鍵指標,它也直接影響 OpenAI 的 o1/o3 和 DeepSeek-R1 等推理模型的響應能力,這些模型依靠推理長度來增強其智能。對于 MoE 模型,實現高推理速度依賴于跨計算設備高效部署專家參數。為了實現盡可能快的推理速度,理想情況下,每個設備都應該為單個 EA 執行計算(或者如有必要,多個設備應協同計算單個 EA)。但是,Expert Parallelism (EP) 需要將令牌路由到適當的設備,這涉及跨網絡的多對多通信。因此,MoE 推理速度的上限由互連帶寬決定。考慮這樣一個系統:每個設備都保存一個 EA 的參數,一次處理大約 32 個令牌。此令牌計數在計算內存比率和通信延遲之間取得平衡。此令牌計數可確保每個設備在專家并行期間處理相等的批量大小,從而可以輕松計算通信時間。對于與 CX7 400Gbps InfiniBand (IB) NIC 互連的系統,EP 中兩次全對全通信所需的時間計算如下:

C o m m . T i m e = ( 1 B y t e + 2 B y t e s ) × 32 × 9 × 7 K / 50 G B / s = 120.96 μ s Comm. Time = (1Byte + 2Bytes) × 32 × 9 × 7K/50GB/s = 120.96μs Comm.Time=(1Byte+2Bytes)×32×9×7K/50GB/s=120.96μs

這里,dispatch 使用 FP8(1 字節),而 combine 使用 BF16(2 字節),每個令牌的隱藏大小約為 7K。因子 9 表示每個令牌都轉移到 8 個路由專家和 1 個共享專家。如 Section 2.3.1 中所述,最大化吞吐量需要使用雙微批處理重疊。在這種策略中,我們的理論最佳情況分析假設計算開銷最小,因此性能上限由通信延遲決定。但是,在實際推理工作負載中,請求上下文通常要長得多,并且 MLA 計算通常主導執行時間。因此,該分析代表了雙微批次重疊下的理想化情景。在此假設下,每層的總時間可以表示為:

T o t a l T i m e P e r L a y e r = 2 × 120.96 μ s = 241.92 μ s Total Time Per Layer = 2 × 120.96μs = 241.92μs TotalTimePerLayer=2×120.96μs=241.92μs

在 DeepSeek-V3 中有 61 層,總推理時間為:

T o t a l I n f e r e n c e T i m e = 61 × 241.92 μ s = 14.76 m s Total Inference Time = 61 × 241.92μs = 14.76ms TotalInferenceTime=61×241.92μs=14.76ms

因此,該系統的理論上限約為 14.76 毫秒 TPOT,相當于每秒 67 個令牌。但是,在實踐中,通信開銷、延遲、帶寬利用率不完整和計算效率低下等因素會減少這個數字。

相比之下,如果使用 GB200 NVL72 等高帶寬互連(72 個 GPU 上的 900GB/s 單向帶寬),則每個 EP 步驟的通信時間將下降到:

C o m m . T i m e = ( 1 B y t e + 2 B y t e s ) × 32 × 9 × 7 K / 900 G B / s = 6.72 μ s Comm. Time = (1Byte + 2Bytes) × 32 × 9 × 7K/900GB/s = 6.72μs Comm.Time=(1Byte+2Bytes)×32×9×7K/900GB/s=6.72μs

假設計算時間等于通信時間,這會顯著減少總推理時間,從而實現超過 0.82 毫秒 TPOT 的理論上限,大約每秒 1200 個令牌。雖然這個數字是純粹的理論,尚未得到實證驗證,但它生動地說明了高帶寬縱向擴展網絡在加速大規模模型推理方面的變革潛力。

雖然 MoE 模型表現出良好的可擴展性,但僅通過增加硬件資源來實現高推理速度的成本高昂。因此,軟件和算法也必須有助于提高推理效率。

2.3.3 多令牌預測

如圖1頂部所示,MTP模塊通過輕量級層預測后續令牌,實現80%-90%的第二令牌接受率,使生成速度提升1.8倍。該方法還通過增大推理批次提升硬件利用率。

受 Gloeckle 等人 [36] 的啟發,DeepSeek-V3 引入了多標記預測 (MTP) 框架,該框架可同時增強模型性能并提高推理速度。在推理過程中,傳統的自回歸模型在解碼步驟中生成一個標記,從而導致順序瓶頸。MTP 使模型能夠以較低的成本生成額外的候選令牌并并行驗證它們,從而緩解了這個問題,類似于以前基于自起草的推測解碼方法 [14, 48]。該框架在不影響準確性的情況下顯著加快了推理速度。

如圖 1 的頂部所示,每個 MTP 模塊都使用一個比完整模型輕量級得多的單層來預測額外的令牌,從而支持多個候選令牌的并行驗證。雖然這種方法對吞吐量略有影響,但顯著改善了端到端的生成延遲。實際實踐數據表明,MTP 模塊預測第二個后續令牌的接受率為 80% 到 90%,與沒有 MTP 模塊的場景相比,生成的 TPS 提高了 1.8 倍。

此外,通過預測每步多個令牌,MTP 增加了推理批量大小,這對于提高 EP 計算強度和硬件利用率至關重要。這種算法創新對于 DeepSeek-V3 中快速且經濟高效的推理至關重要。

2.3.4 推理模型的測試時擴展

OpenAI o1/o3系列[60,61]和DeepSeek-R1[28]等推理模型通過動態調整計算資源,在數學推理等任務中取得突破。強化學習工作流(如PPO[67])對高吞吐的需求,使得推理加速成為關鍵研究方向。

以 OpenAI 的 o1/o3 系列 [60, 61] 為例,LLM 中的測試時間縮放通過在推理過程中動態調整計算資源,實現了數學推理、編程和一般推理的重大進步。隨后的模型——包括 DeepSeek-R1 [28]、Claude-3.7 Sonnet [9]、Gemini 2.5 Pro [38]、Seed1.5-Thinking [68] 和 Qwen3 [71]——都采用了類似的策略,并在這些任務中取得了顯著的改進。

對于這些推理模型,高 token 輸出速度至關重要。在強化學習 (RL) 工作流程中,例如 PPO [67]、DPO [64] 和 GRPO [69],快速生成大量樣本的必要性使推理吞吐量成為一個關鍵的瓶頸。同樣,較長的推理序列會增加用戶的等待時間,從而降低此類模型的實際可用性。因此,通過協同硬件和軟件創新來優化推理速度對于提高推理模型的效率是必不可少的。然而,加速推理和加速 RL 訓練的有效策略仍然是活躍的研究領域,如第 2.1.3 節所述。我們鼓勵更廣泛的社區合作探索和開發新穎的解決方案,以應對這些持續的挑戰。

2.4 技術驗證方法

每種加速技術都經過嚴格的實證驗證,以評估其精度影響,包括 MLA、FP8 混合精度計算和網絡共同設計的 MoE 門路由。

鑒于在全尺寸模型上窮舉消融的成本高昂,我們采用了分層且資源高效的驗證管道。每種技術首先在小規模模型上進行廣泛驗證,然后進行最少的大規模調整,最后集成到一個全面的訓練運行中。

例如,在最終集成之前,我們首先對 16B 和 230B DeepSeek-V2 模型進行了細粒度的 FP8 訓練消融研究。在這些受控設置下,與 BF16 相比,相對精度損失保持在 0.25% 以下,這歸因于我們使用了高精度累積和細粒度量化策略。

3 低精度驅動設計

3.1 FP8混合精度訓練

GPTQ[32]和AWQ[51]等量化技術已廣泛用于將位寬降至8位、4位甚至更低,顯著減少內存需求。但這些技術主要應用于推理階段以節省內存,而非訓練階段。NVIDIA Transformer Engine雖早已支持FP8混合精度訓練,但在DeepSeek-V3之前尚未有開源大模型采用FP8訓練。通過基礎設施與算法團隊的深度協作及大量實驗創新,我們開發了支持MoE模型的FP8訓練框架。圖1展示了訓練流程中采用FP8精度前向與反向過程的計算組件。我們應用細粒度量化策略:對激活值采用1x128分塊量化,對模型權重采用128x128分塊量化。FP8框架的更多技術細節記錄于DeepSeek-V3技術報告[26],細粒度FP8 GEMM實現已通過DeepGEMM[77]開源。

3.1.1 局限性

盡管FP8具有加速訓練的潛力,仍需解決以下硬件限制以充分發揮其效能:

-

FP8累加精度:

Tensor Core中FP8采用受限累加精度,影響大模型訓練穩定性(尤其在NVIDIA Hopper GPU上)。基于最大指數右移對齊32個尾數乘積后,Tensor Core僅保留最高13位小數位進行加法運算,超范圍位直接截斷。加法結果累積至FP22寄存器(1符號位+8指數位+13尾數位)。 -

細粒度量化挑戰:

分塊量化導致部分結果從Tensor Core傳輸至CUDA Core進行縮放因子乘法的反量化開銷過大。頻繁數據移動會降低計算效率并增加硬件利用復雜度。

3.1.2 建議

針對現有硬件局限,我們對未來設計提出以下建議:

-

提升累加精度:

硬件應提高累加寄存器精度至合適值(如FP32),或支持可配置累加精度,以適應不同模型訓練/推理的精度-性能權衡需求。 -

原生細粒度量化支持:

硬件應原生支持細粒度量化,使Tensor Core可直接接收縮放因子并執行分組縮放矩陣乘。如此整個部分和累加與反量化可在Tensor Core內部完成,避免頻繁數據移動。NVIDIA Blackwell對微縮放數據格式[66]的支持即為該方向的工業級實踐范例。

3.2 LogFMT:通信壓縮

當前DeepSeek-V3架構中,我們對網絡通信采用低精度壓縮。在專家并行(EP)階段,令牌分發使用細粒度FP8量化,通信量較BF16減少50%。雖然組合階段因精度要求仍采用BF16,但我們正積極測試FP8、自定義格式(如E5M6)及FP8-BF16混合方案。

除傳統浮點格式外,我們還嘗試了對數浮點格式 $(LogFMT-nBit)¥,其中n為總位數(首位為符號位S)。通過將激活值從線性空間映射至對數空間,其分布更趨均勻。具體實現中,對1x128元素塊取絕對值并計算對數后,確定最小值min與最大值max。最小值編碼為S.00···01,最大值編碼為S.11···11,步長 S t e p = ( m a x ? m i n ) / ( 2 ( n ? 1 ) ? 2 ) Step=(max-min)/(2^{(n-1)}-2) Step=(max?min)/(2(n?1)?2)。零值特例編碼為S.00···00,其余值四舍五入至最近的 K × S t e p K×Step K×Step 整數倍。解碼過程通過符號位與 e x p ( m i n + S t e p × ( K ? 1 ) ) exp^{(min+Step×(K-1))} exp(min+Step×(K?1))組合實現。該格式支持動態表示范圍,較靜態浮點格式能覆蓋更大范圍或提供更高精度。

通過本地計算 min 和 Step,此數據類型支持不同塊的動態表示范圍,與靜態浮點格式相比,涵蓋更大的范圍或提供更高的精度。此外,我們發現在原始 Linear 空間而不是 Log 空間中四舍五入對于無偏激活量化很重要。我們還將 min 限制為大于 max ? log(232),這意味著 max 表示范圍類似于 E5,一個具有 5 個指數的浮點。我們通過量化殘差分支的輸出來模擬 MoE 模型中的組合階段,在具有大約 70 億個參數的密集語言模型上驗證我們的 LogFMT-nBit。當設置 n = 8 時,與 FP8 共享相同的位,LogFMT-8Bit 顯示出優越的圖 2:H800 節點互連。 與 E4M3 或 E5M2 相比的訓練準確性。將 n 增加到 10 位后,我們發現它類似于 BF16 組合級。

3.2.1 局限性

使用 LogFMT 的最初目的是將其應用于傳輸期間的激活或接近激活函數,因為它在相同的位寬下提供比 FP8 更高的精度。但是,后續計算需要重新轉換為 BF16 或 FP8 以適應 Hopper GPU 張量核心的數據類型。由于用于 log/exp作的 GPU 帶寬不足以及編碼/解碼期間的寄存器壓力過大,如果編碼/解碼作與多對多通信融合,開銷可能會很大 (50%~100%)。因此,盡管實驗結果驗證了這種格式的有效性,但我們最終沒有采用它。

3.2.2 建議

未來硬件可提供面向FP8或自定義格式的原生編解碼單元,以降低帶寬需求并優化通信流水線。這種優化對MoE訓練等帶寬敏感任務尤為重要。

4. 互連驅動設計

4.1 當前硬件架構

我們采用的NVIDIA H800 GPU SXM架構(如圖2所示)基于Hopper架構,與H100 GPU類似,但為符合監管要求降低了FP64計算性能和NVLink帶寬。具體而言,H800 SXM節點的NVLink帶寬從900GB/s降至400GB/s。這種節點內縱向擴展帶寬的大幅削減對高性能工作負載構成挑戰。為彌補此缺陷,每個節點配備八張400G Infiniband(IB)CX7網卡,通過增強橫向擴展能力緩解帶寬不足問題。

為應對這些硬件限制,DeepSeek-V3模型融入多項與硬件特性匹配的設計考量。

圖 2:H800 節點互連。

4.2 硬件感知并行策略

為適應H800架構約束,我們采用以下并行策略優化DeepSeek-V3性能:

-

規避張量并行(TP):

訓練階段因NVLink帶寬限制回避TP,但推理階段仍可選擇性采用以降低延遲 -

增強流水線并行(PP):

采用DualPipe(DeepSeek-AI, 2025b)重疊注意力計算與MoE通信,減少流水線氣泡并平衡GPU內存使用 -

加速專家并行(EP):

借助8張400Gbps IB網卡實現超40GB/s的全對全通信,開源實現DeepEP(Zhao et al., 2025b)提供高效專家并行支持

值得注意的是,我們的 all-to-all EP 實現 DeepEP [78] 是開源的,實現了高效的專家并行性,如以下小節所述。

4.3 模型協同設計:節點受限路由

H800架構中縱向(節點內)與橫向(節點間)通信帶寬比約為4:1(NVLink實際帶寬160GB/s vs 單IB網卡有效帶寬40GB/s)。具體來說,NVLink 提供 200GB/s 的帶寬(其中實際可以達到約 160GB/s),而每個 400Gbps 的 IB NIC 僅提供 50GB/s 的帶寬(我們考慮到小消息大小和延遲的影響,使用 40GB/s 作為有效帶寬)。為了平衡和充分利用更高的節點內帶寬,模型架構與硬件共同設計,特別是在 TopK 專家選擇策略中。

以8節點(64GPU)部署256名路由專家(每GPU4專家)為例。如果其 8 個目標專家分布在所有 8 個節點上,則通過 IB 的通信時間為 8t,其中 t 表示通過 IB 發送一個代幣的時間。但是,通過利用更高的 NVLink 帶寬,路由到同一節點的令牌可以通過 IB 發送一次,然后通過 NVLink 轉發到其他節點內 GPU 。NVLink 轉發支持 IB 流量的重復數據刪除。當給定代幣的目標專家分布在 M 個節點上時,去重后的 IB 通信成本將降低到 Mt (M < 8)。

由于 IB 流量僅依賴于 M,因此 DeepSeek-V3 為 TopK 專家選擇策略引入了 Node-Limited Routing。具體來說,我們將 256 名路由專家分為 8 個組,每組 32 名專家,并將每個組部署在單個節點上。在此部署之上,我們在算法上確保每個令牌將被路由到最多 4 個節點。這種方法緩解了 IB 通信的瓶頸,提高了訓練期間的有效通信帶寬。

4.4 縱向與橫向擴展融合

4.4.1 現有實現局限

節點受限路由策略雖降低帶寬需求,但因NVLink與IB帶寬差異導致通信流水線內核實現復雜化。訓練中H800 GPU需分配多達20個流式多處理器(SM)處理通信任務(如填充QP/WQE、NVLink數據轉發),擠占計算資源。在線推理場景為規避SM爭用,我們完全通過NIC RDMA執行EP全對全通信,凸顯RDMA異步通信優勢。

雖然 NodeLimited 路由策略降低了通信帶寬要求,但由于節點內 (NVLink) 和節點間 (IB) 互連之間的帶寬差異,它使通信管道內核實現復雜化。在實踐中,GPU 流式多處理器 (SM) 線程用于網絡消息處理(例如,填充 QP 和 WQE)和通過 NVLink 進行數據轉發,消耗計算資源。例如,在訓練期間,H800 GPU 上多達 20 個 SMs 被分配給與通信相關的作,從而留給實際計算的資源較少。為了最大限度地提高在線推理的吞吐量,我們完全通過 NIC RDMA 執行 EP 全對全通信,避免了 SM 資源爭用并提高計算效率。這凸顯了 RDMA 的異步通信模型在重疊計算和通信方面的優勢。

以下是 SM 當前在 EP 通信期間執行的關鍵任務,特別是對于 combine 階段的 reduce作和數據類型轉換。將這些任務卸載到專用通信硬件可以釋放 SM 用于計算內核,從而顯著提高整體效率:

- 轉發數據:聚合發往 IB 和 NVLink 域之間同一節點內多個 GPU 的 IB 流量。

- 數據傳輸:在 RDMA 緩沖區 (已注冊的 GPU 內存區域) 和輸入/輸出緩沖區之間移動數據。

- 減少操作:執行 EP all-to-all 組合通信所需的 reduce作。

- 管理內存布局:處理跨 IB 和 NVLink 域的分塊數據傳輸的精細內存布局。? 數據類型轉換:在所有通信之前和之后轉換數據類型。

4.4.2 改進建議

為了解決這些低效率問題,我們強烈建議未來的硬件應將節點內(縱向擴展)和節點間(橫向擴展)通信集成到一個統一的框架中。通過整合專用協處理器來管理網絡流量以及 NVLink 和 IB 域之間的無縫轉發,此類設計可以降低軟件復雜性并最大限度地提高帶寬利用率。例如,DeepSeek-V3 中采用的節點限制路由策略可以通過對動態流量重復數據刪除的硬件支持進一步優化。

-

統一網絡適配器:

設計連接到統一縱向擴展和橫向擴展網絡的 NIC(網絡接口卡)或 I/O 芯片。這些適配器還應支持基本的交換機功能,例如將數據包從橫向擴展網絡轉發到縱向擴展網絡中的特定 GPU。這可以通過使用具有基于策略的路由的單個 LID(本地標識符)或 IP 地址來實現。 -

專用通信協處理器:

引入專用協處理器或可編程組件(如 I/O 芯片)來處理網絡流量。此組件將卸載 GPU SM 的數據包處理,從而防止性能下降。此外,它還應包括硬件加速的內存復制功能,以實現高效的緩沖區管理。 -

靈活廣播/歸約機制:

硬件應支持跨縱向擴展和橫向擴展網絡的靈活轉發、廣播(EP分發)與歸約(EP組合)操作,這反映了我們當前基于 GPU SM 的實現。這不僅可以提高有效帶寬,還可以降低特定于網絡的作的計算復雜性。 -

硬件同步原語:

提供精細的硬件同步指令,以處理硬件級別的內存一致性問題或無序數據包到達。這將消除對基于軟件的同步機制(如 RDMA 完成事件)的需求,這些機制會帶來額外的延遲并增加編程復雜性。具有 acquire/release 機制的內存語義通信是一種很有前途的實現。

通過實施這些建議,未來的硬件設計可以顯著提高大規模分布式 AI 系統的效率,同時簡化軟件開發。

4.5 帶寬爭用與延遲

4.5.1 現存問題

當前硬件缺乏NVLink/PCIe帶寬動態分配能力。例如推理時KV緩存從CPU內存傳輸至GPU可能占滿PCIe帶寬,若同時進行EP通信將導致性能下降與延遲尖峰。

4.5.2 優化方向

-

動態流量優先級:

硬件應支持根據流量類型對流量進行動態優先級排序。例如,應為與 EP、TP 和 KV 緩存傳輸相關的流量分配不同的優先級,以最大限度地提高互連效率。對于 PCIe,將 traffic class (TC) 公開給用戶級編程就足夠了。 -

I/O芯片集成:

將 NIC 直接集成到 I/O 芯片中,并將它們連接到同一封裝中的計算芯片,而不是通過傳統的 PCIe,將大大減少通信延遲并緩解 PCIe 帶寬爭用。 -

CPU-GPU專用互連:

為了進一步優化節點內通信,CPU 和 GPU 應使用 NVLink 或類似的專用高帶寬結構互連,而不是僅僅依賴 PCIe。與將 NIC 集成到 I / O 芯片中帶來的好處類似,這種方法可以顯著改善訓練和推理期間在 GPU 和 CPU 內存之間卸載參數或 KV 緩存等場景。

5. 大規模網絡驅動設計

5.1 網絡協同設計:多平面胖樹

在DeepSeek-V3 訓練中,我們部署了如圖3所示的多平面胖樹(MPFT)橫向擴展網絡。每個節點配備8塊GPU與8張IB網卡,每對GPU-網卡分配至獨立網絡平面。另設400Gbps以太網RoCE網卡連接專用存儲平面以訪問3FS(DeepSeek-AI, 2025c)分布式文件系統。橫向網絡采用64端口400G IB交換機,理論上支持16,384 GPU規模的兩層拓撲,但因政策限制最終僅部署兩千余GPU。

受限于當前IB ConnectX-7技術,實際MPFT網絡未完全實現理想架構——如圖4 所示,理想情況下每張網卡應具備多物理端口并支持端口聚合,使單個隊列對(QP)能跨端口分發數據包,這要求網卡原生支持亂序報文重組。InfiniBand ConnectX-8已原生支持四平面架構,未來網卡應全面增強多平面能力以支撐超大規模AI集群。

圖 3 :八平面兩層胖樹橫向擴展網絡:每個 GPU 和 IB NIC 對屬于一個網絡平面。跨平面流量必須使用另一個 NIC 和 PCIe 或 NVLink 進行節點內轉發。

圖 4:理想的多平面網絡:

每個 NIC 都配備了多個物理端口,每個端口都連接到不同的網絡平面。單個隊列對 (QP) 可以同時利用所有可用端口來傳輸和接收數據包,這需要對 NIC 中的無序放置提供本機支持。

5.1.1 多平面胖樹網絡優勢

-

多軌胖樹(MRFT)子集:

MPFT屬于MRFT特例,可直接復用NVIDIA與NCCL對多軌網絡的優化成果,NCCL PXN技術(Mandakolathur and Jeaugey, 2022)有效解決平面間隔離通信問題 -

成本效益:

如表3所示,MPFT在16K端點規模下較三層胖樹(FT3)顯著降低成本,單端點成本甚至優于經濟型Slim Fly(SF)拓撲(Blach et al., 2025) -

流量隔離:

平面間故障互不影響,提升整體穩定性 -

低延遲:

實驗證明兩層拓撲延遲低于三層架構,特別適合MoE訓練等時敏場景 -

高容錯:

如圖4所示,多端口網卡提供冗余上行鏈路,單端口故障可快速透明恢復

注:當前400G NDR InfiniBand需通過節點內轉發實現跨平面通信,引入額外延遲。若未來硬件實現4.4節所述的縱向-橫向網絡融合,可顯著降低此類延遲。

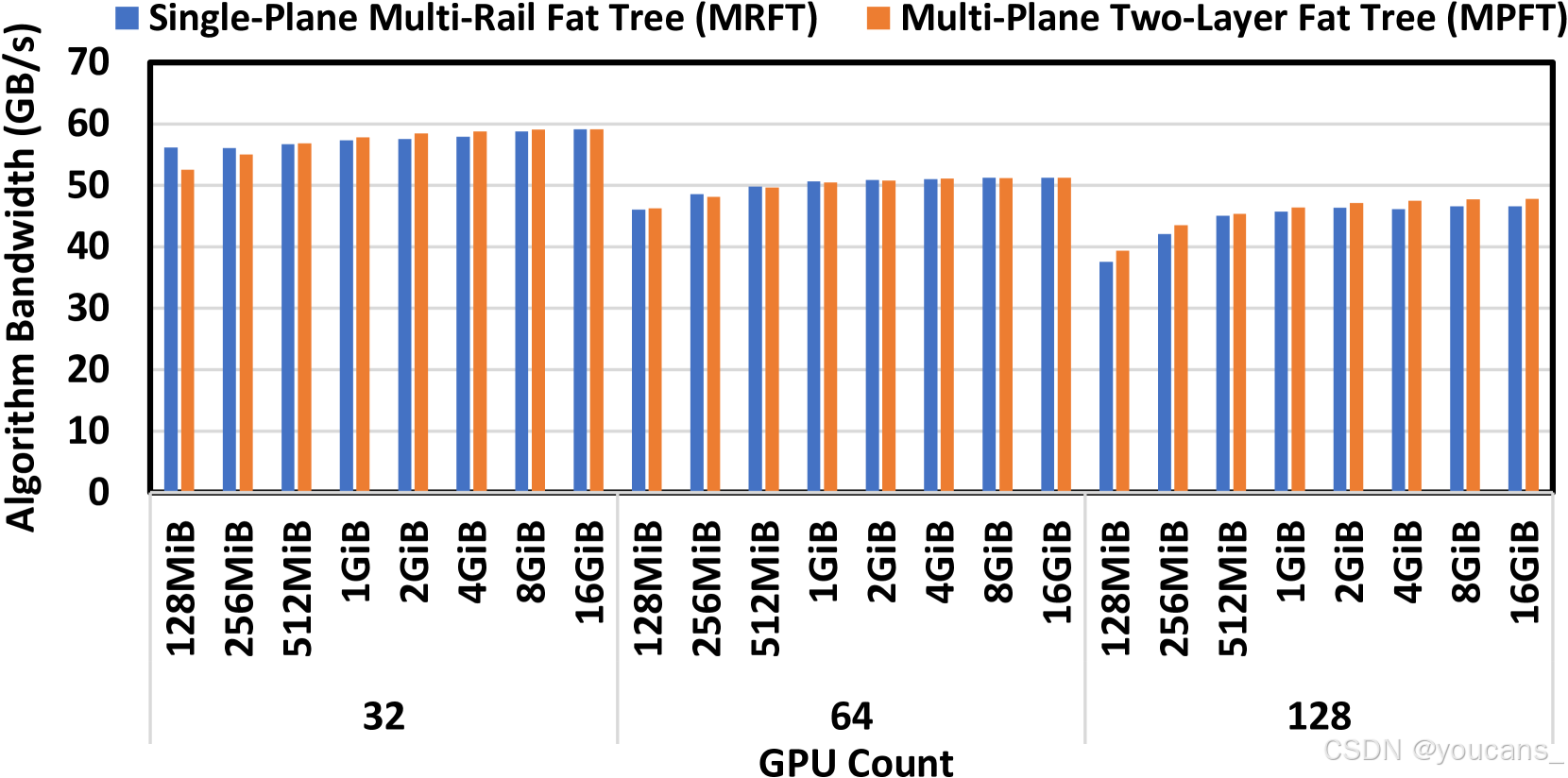

5.1.2 性能分析

為驗證MPFT有效性,我們在集群中對比MPFT與單平面多軌胖樹(MRFT)性能:

- All-to-All 通信與EP場景:圖5 顯示MPFT全對全性能與MRFT相當,歸功于NCCL PXN機制通過NVLink優化流量轉發。圖6 的16GPU全對全測試中兩者延遲差異可忽略。圖7展示訓練場景下EP通信帶寬穩定超40GB/s。

圖 5 :MRFT 和 MPFT 網絡的 NCCL 全對全性能,從 32 到 128 個 GPU 。

圖 6:在不同消息大小下,NCCL all-to-all 測試中 MPFT 和 MRFT 網絡之間的延遲比較,表明它們的性能幾乎相同。

圖 7 : MPFT 上的 DeepEP 性能:

EP 調度和組合內核使用多對多在 16 到 128 個 GPU 之間進行通信。每個 GPU 處理 4096 個令牌。觀察到的吞吐量幾乎使 400Gps NIC 帶寬飽和。

- DeepSeek-V3 模型的訓練吞吐量:

我們還在表 4 中比較了 DeepSeek-V3 模型在 MPFT 和 MRFT 之間的訓練指標。

MFU (Model Flops Utilization) 是根據 BF16 峰值性能計算的。因果 MFU 只考慮了注意力矩陣下三角形的翻牌(與 FlashAttention[19, 20] 一致),而非因果 MFU 包括整個注意力矩陣的翻牌(與 Megatron [47] 一致)。1F、1B 和 1W 分別表示前進時間、輸入后退時間和重量后退時間。在 2048 個 GPU 上訓練 V3 模型時,MPFT 的性能與 MRFT 的性能幾乎相同,觀察到的差異屬于正常波動和測量誤差。

5.2 低延遲網絡

在我們的模型推理中,大規模 EP 嚴重依賴于多對多通信,這對帶寬和延遲都非常敏感。考慮第 2.3.2 節中討論的典型場景,網絡帶寬為 50GB/s,理想情況下數據傳輸大約需要 120 μs。因此,微秒級的固有網絡延遲會嚴重影響系統性能,使其影響不可忽略。

5.2.1 IB與RoCE對比

如表5 所示,IB憑借更低延遲成為分布式訓練/推理首選,但存在兩大局限:

擴展性:單IB交換機僅支持64端口,而RoCE交換機通常支持128端口

-

成本:

IB 硬件比 RoCE 解決方案貴得多,這限制了它的廣泛采用。 -

可擴展性:

IB 交換機通常僅支持每臺交換機 64 個端口,而 RoCE 交換機通常支持 128 個端口。這限制了基于 IB 的集群的可擴展性,尤其是對于大規模部署。

5.2.2 RoCE改進建議

雖然 RoCE 有可能成為 IB 的經濟高效的替代方案,但其當前在延遲和可擴展性方面的限制使其無法完全滿足大規模 AI 系統的需求。下面,我們概述了改進 RoCE 的具體建議:

-

專用低延遲RoCE交換機:

建議以太網廠商剝離冗余功能專為RDMA優化,Slingshot架構(De Sensi et al., 2020)與Broadcom(2025)的AI轉發頭(AIFH)技術已證明可行性。 -

優化路由策略:

如圖8所示,RoCE默認ECMP路由在NCCL集合通信中易引發鏈路擁塞,而自適應路由(AR)(Geoffray and Hoefler, 2008)能通過動態多路徑分發顯著提升性能。 -

增強流量隔離與擁塞控制:

當前RoCE交換機優先級隊列數不足,難以應對EP全對全與DP全規約的混合流量。建議采用虛擬輸出隊列(VOQ)隔離流,或部署RTTCC/PCC等先進擁塞控制機制。

圖 8:AllGather 和 ReduceScatter 通信原語在不同路由方法(ECMP、AR、靜態路由)和 TP 維度下的 RoCE 網絡帶寬。

5.2.3 InfiniBand GPUDirect異步(IBGDA)

我們利用IBGDA(NVIDIA,2022;Agostini等人,2018)來減少網絡通信中的延遲。

傳統上,網絡通信涉及創建CPU代理線程:一旦GPU準備好數據,它必須通知CPU代理,然后CPU代理填充工作請求(WR)的控制信息,并通過門鈴機制向NIC發出信號以啟動數據傳輸。此過程引入了額外的通信開銷。

IBGDA 通過允許 GPU 直接填充 WR 內容并寫入 RDMA 門鈴 MMIO 地址來解決這個問題。通過在 GPU 中管理整個控制平面, IBGDA 消除了與 GPU-CPU 通信相關的大量延遲開銷。而且,當發送大量小數據包時,控制平面處理器很容易成為瓶頸。由于 GPU 具有多個并行線程,因此發送者可以利用這些線程來分配工作負載,從而避免此類瓶頸。

我們的DeepEP(Zhao et al., 2025b)等實踐已證明IBGDA可帶來顯著性能提升(Agostini et al., 2017),因此我們主張在 Accelerator 設備中廣泛支持這些功能。

6. 未來硬件架構設計的討論和洞見

在前面的部分的基礎上,我們總結了關鍵的架構見解,并概述了針對大規模 AI 工作負載量身定制的硬件設計的未來方向。第 2.3.2 節強調了大規模擴展網絡對加速模型推理的重要性。第 3 節討論了對低精度計算和通信的高效支持的必要性。第 4 節探討了縱向擴展和橫向擴展架構的融合,以及一些建議的增強功能。第 5 節重點介紹了多平面網絡拓撲,并確定了基于以太網的互連所需的關鍵改進。這些部分共同確定了具體應用程序上下文中的硬件限制,并提供了相應的建議。在此基礎上,本節將討論擴展到更廣泛的考慮因素,并為未來的硬件架構設計提出了前瞻性的方向。

6.1 魯棒性挑戰

6.1.1 現存問題

-

互連故障:

高性能互連(例如 IB 和 NVLink)容易出現間歇性斷開連接,這可能會中斷節點到節點的通信。這在 EP 等通信密集型工作負載中尤其有害,即使是短暫的中斷也可能導致性能顯著下降或作業失敗。 -

單點硬件故障:

節點崩潰、GPU 故障或 ECC(糾錯碼)內存錯誤可能會損害長時間運行的訓練作業,通常需要代價高昂的重啟。在大規模部署中,此類故障的影響會升級,其中單點故障的可能性與系統大小成比例增加。 -

靜默數據損壞:

ECC 機制未檢測到的錯誤(例如多位內存翻轉或計算不準確)會對模型質量構成重大風險。這些錯誤在長時間運行的任務中尤其陰險,因為它們可能會傳播未檢測到的 JSON 計算并破壞下游計算。當前的緩解策略依賴于應用程序級啟發式方法,這不足以確保系統范圍的穩健性。

6.1.2 高級錯誤檢測和更正建議

為了降低與靜默損壞相關的風險,硬件必須采用超越傳統 ECC 的高級錯誤檢測機制。

基于校驗和的驗證或硬件加速冗余檢查等技術可以為大規模部署提供更高的可靠性。此外,硬件供應商應向最終用戶提供全面的診斷工具包,使他們能夠嚴格驗證其系統的完整性,并主動識別任何潛在的靜默數據損壞。當作為標準硬件包的一部分嵌入時,此類工具包可以提高透明度并在整個運營生命周期中實現持續驗證,從而提高整體系統的可信度。

6.2 CPU瓶頸與互連

雖然加速器設計通常占據中心位置,但 CPU 對于協調計算、管理 I/O 和維持系統吞吐量仍然至關重要。然而,當前的架構面臨幾個關鍵瓶頸:

-

PCIe接口限制:

如4.5節所述,CPU-GPU間PCIe在參數/KV緩存傳輸時成為帶寬瓶頸,尤其是在大規模參數、梯度或 KV 緩存傳輸期間。為了緩解這種情況,未來的系統應采用直接的 CPU-GPU 互連(例如 NVLink 或 Infinity Fabric),或者將 CPU 和 GPU 集成到縱向擴展域中,從而消除節點內瓶頸。 -

內存帶寬需求:

除了 PCIe 限制之外,維持如此高的數據傳輸速率還需要極高的內存帶寬。例如,飽和 160 個 PCIe 5.0 通道需要每個節點超過 640 GB/s,這意味著每個節點的內存帶寬要求約為 1 TB/s,這對傳統 DRAM 架構構成了重大挑戰。 -

核心性能要求:

延遲敏感型任務(如內核啟動和網絡處理)需要較高的單核 CPU 性能,通常需要 4 GHz 以上的基本頻率。此外,現代 AI 工作負載需要每個 GPU 有足夠的 CPU 內核,以防止控制端瓶頸。對于基于 chiplet 的架構,需要額外的內核來支持緩存感知工作負載分區和隔離。

6.3 智能網絡演進方向

為了滿足延遲敏感型工作負載的需求,未來的互連必須優先考慮低延遲和智能網絡:

-

共封裝光學:硅光技術提升能效與帶寬擴展性

結合硅光子學可實現可擴展的更高帶寬可擴展性和更高的能效,這兩者都對于大規模分布式系統至關重要。 -

無損網絡:基于信用機制的流量控制需結合終端驅動擁塞控制算法

基于信用的流量控制 (CBFC) 機制可確保無損數據傳輸,但天真地觸發流量控制可能會導致嚴重的隊頭阻塞。因此,必須部署先進的端點驅動型擁塞控制 (CC) 算法,以主動調節注射速率并避免病態的擁塞情況。 -

自適應路由:應標準化動態路由方案(如數據包噴灑)

正如第 5.2.2 節所強調的,未來的網絡應該標準化采用動態路由方案,例如數據包噴灑和擁塞感知路徑選擇,這些方案可持續監控實時網絡狀況并智能地重新分配流量。這些自適應策略在緩解集體通信工作負載(包括全對全和減少分散作)期間的熱點和瓶頸方面特別有效。 -

高效容錯協議:鏈路層重試機制與選擇性重傳協議提升可靠性

通過部署自我修復協議、冗余端口和快速故障轉移技術,可以顯著提高對故障的穩健性。例如,鏈路層重試機制和選擇性重傳協議被證明對于在大型網絡中擴展可靠性、最大限度地減少停機時間和確保在間歇性故障的情況下無縫運行是必不可少的。 -

動態資源管理:支持訓練/推理流量隔離與帶寬動態分配

為了有效地處理混合工作負載,未來的硬件應支持動態帶寬分配和流量優先級。例如,推理任務應與統一集群中的訓練流量隔離,以確保延遲敏感型應用程序的響應能力。

6.4 內存語義通信與順序問題

現有跨節點內存語義通信受限于內存順序約束:發送方必須顯式內存屏障才能更新通知標志,引入額外RTT延遲。我們主張硬件原生支持內存語義通信的順序保障,建議采用區域獲取/釋放(RAR)機制——接收方硬件通過位圖跟蹤RNR內存區域狀態,將排序任務卸載至NIC/I/O芯片。該機制同樣有利于RDMA原子操作等消息語義場景。

使用 load/store memory 語義的節點間通信是高效且對程序員友好的,但當前的實現受到內存排序挑戰的阻礙。例如,寫入數據后,發送方必須在更新標志之前發出顯式內存屏障(柵欄)以通知接收方,從而確保數據一致性。這種嚴格的排序會帶來額外的往返時間 (RTT) 延遲,并可能使發出線程停止,從而阻礙正在進行的存儲并降低吞吐量。消息語義 RDMA 中也會出現類似的無序同步問題;例如,在 InfiniBand 或 NVIDIA BlueField-3 上進行常規 RDMA 寫入后,使用數據包噴射執行 RDMA 原子添加作可能會導致額外的 RTT 延遲。

為了解決這些問題,我們提倡為內存語義通信提供內置排序保證的硬件支持。這種一致性應該在編程級別(例如,通過 acquire/release 語義)和接收器的硬件中強制執行,從而在不增加開銷的情況下實現按順序交付。

有幾種可能的方法。例如,接收方可以緩沖原子消息并使用數據包序列號進行順序處理。但是,獲取/釋放機制更優雅、更高效。我們建議使用一種簡單的概念機制,即區域獲取/釋放 (RAR) 機制,其中接收器硬件維護位圖以跟蹤 RNR 內存區域的狀態,并且獲取/釋放作的范圍限定為 RAR 地址范圍。憑借最小的位圖開銷,這實現了高效的、硬件強制的排序,消除了明確的發送方圍欄,并將排序委托給硬件 — 最好是在 NIC 或 I/O 芯片上。重要的是,RAR 機制不僅有利于內存語義作,也有利于消息語義 RDMA 原語,從而擴大了其實際適用性。

6.5 網內計算與壓縮

EP的兩個關鍵的 All-to-All 階段存在優化機遇:

-

分發階段:硬件級協議實現自動包復制與多目標轉發

分發階段類似于小規模多播作,其中必須將單個消息轉發到多個目標設備。支持自動數據包復制和轉發到多個目的地的硬件級協議可以大大降低通信開銷并提高效率。 -

組合階段:支持靈活的小規模網內聚合

組合階段作為小規模的縮減作,可以從網絡內聚合技術中受益。

然而,由于 EP 聯合收斂的縮減范圍小且工作負載不平衡,以靈活的方式實現網絡內聚合具有挑戰性。此外,正如第 3.2 節所強調的,LogFMT 支持低精度令牌傳輸,對模型性能的影響最小。將 LogFMT 原生整合到網絡硬件中,可以通過增加熵密度和減少帶寬使用來進一步優化通信。硬件加速的壓縮和解壓縮將允許將 LogFMT 無縫集成到分布式系統中,從而提高整體吞吐量。

6.6 內存中心創新

6.6.1 內存帶寬局限

模型大小的指數級增長超過了高帶寬內存 (HBM) 技術的進步。這種差異造成了內存瓶頸,尤其是在像 Transformer 這樣需要大量注意力的架構中。

6.6.2 發展方向

-

DRAM堆疊加速器:采用3D堆疊技術(如SeDRAM[Wang et al., 2023])實現超高帶寬推理

利用先進的 3D 堆疊技術,DRAM 芯片可以垂直集成在邏輯芯片上,從而實現極高的內存帶寬、超低延遲和實用的內存容量(盡管堆棧有限)。事實證明,這種架構范式對于 MoE 模型中的超快速推理非常有利,其中內存吞吐量是一個關鍵瓶頸。SeDRAM[72] 等架構體現了這種方法的潛力,為內存受限的工作負載提供前所未有的性能。 -

晶圓級系統(SoW):晶圓級集成[Lie, 2022]滿足超大規模模型需求

晶圓級集成 [50] 可以最大限度地提高計算密度和內存帶寬,滿足超大規模模型的需求。

7. 結論

DeepSeek-V3 體現了硬件軟件協同設計在提高大規模 AI 系統的可擴展性、效率和穩健性方面的變革潛力。

通過解決當前硬件架構的局限性并提出可行的建議,本文為下一代 AI 優化硬件提供了路線圖。隨著 AI 工作負載的復雜性和

規模不斷增長,這些創新將至關重要,從而推動智能系統的未來發展。

參考文獻

[1] Elena Agostini, Davide Rossetti, and Sreeram Potluri. 2017. Offloading Communication Control Logic in GPU Accelerated Applications. In 2017 17th IEEE/ACM International Symposium on Cluster, Cloud and Grid Computing (CCGRID). 248257. https://doi.org/10.1109/CCGRID.2017.29

[2] E. Agostini, D. Rossetti, and S. Potluri. 2018. GPUDirect Async: Exploring GPU synchronous communication techniques for InfiniBand clusters. J. Parallel and Distrib. Comput. 114 (2018), 28–45. https://doi.org/10.1016/j.jpdc.2017.12.007

[3] AI@Meta. 2024. Llama 3 Model Card. https://github.com/meta-llama/llama3/ blob/main/MODEL_CARD.md

[4] AI@Meta. 2024. Llama 3.1 Model Card. https://github.com/meta-llama/llamamodels/blob/main/models/llama3_1/MODEL_CARD.md

[5] Joshua Ainslie, James Lee-Thorp, Michiel de Jong, Yury Zemlyanskiy, Federico Lebrón, and Sumit Sanghai. 2023. GQA: Training Generalized Multi-Query Transformer Models from Multi-Head Checkpoints. arXiv preprint arXiv:2305.13245 (2023).

[6] AMD. 2025. AMD Ryzen AI Max+ PRO 395: Designed to power a new generation of compact Copilot+ PC workstations. https: //www.amd.com/en/products/processors/laptop/ryzen- pro/ai- max- pro300- series/amd- ryzen- ai- max- plus- pro- 395.html

[7] Wei An, Xiao Bi, Guanting Chen, Shanhuang Chen, Chengqi Deng, Honghui Ding, Kai Dong, Qiushi Du, Wenjun Gao, Kang Guan, Jianzhong Guo, Yongqiang Guo, Zhe Fu, Ying He, Panpan Huang, Jiashi Li, Wenfeng Liang, Xiaodong Liu, Xin Liu, Yiyuan Liu, Yuxuan Liu, Shanghao Lu, Xuan Lu, Xiaotao Nie, Tian Pei, Junjie Qiu, Hui Qu, Zehui Ren, Zhangli Sha, Xuecheng Su, Xiaowen Sun, Yixuan Tan, Minghui Tang, Shiyu Wang, Yaohui Wang, Yongji Wang, Ziwei Xie, Yiliang Xiong, Yanhong Xu, Shengfeng Ye, Shuiping Yu, Yukun Zha, Liyue Zhang, Haowei Zhang, Mingchuan Zhang, Wentao Zhang, Yichao Zhang, Chenggang Zhao, Yao Zhao, Shangyan Zhou, Shunfeng Zhou, and Yuheng Zou. 2024. Fire-Flyer AIHPC: A Cost-Effective Software-Hardware Co-Design for Deep Learning. In SC24: International Conference for High Performance Computing, Networking, Storage and Analysis. 1–23. https://doi.org/10.1109/SC41406.2024.00089

[8] Anthropic. 2024. Claude 3.5 Sonnet. https://www.anthropic.com/news/claude3- 5- sonnet

[9] Anthropic. 2025. Claude 3.7 Sonnet and Claude Code. https:// www.anthropic.com/news/claude- 3- 7- sonnet

[10] Apple. 2024. Apple introduces M4 Pro and M4 Max. https://www.apple.com/ newsroom/2024/10/apple- introduces- m4- pro- and- m4- max/

[11] Iz Beltagy, Matthew E. Peters, and Arman Cohan. 2020. Longformer: The LongDocument Transformer. arXiv:2004.05150 (2020).

[12] Nils Blach, Maciej Besta, Daniele De Sensi, Jens Domke, Hussein Harake, Shigang Li, Patrick Iff, Marek Konieczny, Kartik Lakhotia, Ales Kubicek, Marcel Ferrari, Fabrizio Petrini, and Torsten Hoefler. 2025. A high-performance design, implementation, deployment, and evaluation of the slim fly network. In Proceedings of the 21st USENIX Symposium on Networked Systems Design and Implementation (Santa Clara, CA, USA) (NSDI’24). USENIX Association, USA, Article 57, 20 pages.

[13] Broadcom. 2025. Scale Up Ethernet Framework. https://docs.broadcom.com/ doc/scale- up- ethernet- framework

[14] Tianle Cai, Yuhong Li, Zhengyang Geng, Hongwu Peng, Jason D. Lee, Deming Chen, and Tri Dao. 2024. Medusa: Simple LLM Inference Acceleration Framework with Multiple Decoding Heads. In Forty-first International Conference on Machine Learning, ICML 2024, Vienna, Austria, July 21-27, 2024. OpenReview.net. https: //openreview.net/forum?id=PEpbUobf Jv

[15] Shaoyuan Chen, Wencong Xiao, Yutong Lin, Mingxing Zhang, Yingdi Shan, Jinlei Jiang, Kang Chen, and Yongwei Wu. 2025. Efficient Heterogeneous Large Language Model Decoding with Model-Attention Disaggregation. arXiv:2405.01814

[cs.LG] https://arxiv.org/abs/2405.01814

[16] ULTRA ACCELERATOR LINK CONSORTIUM. 2025. Introducing UALink 200G 1.0 Specification. https://ualinkconsortium.org/wp-content/uploads/2025/04/ UALink- 1.0- White_Paper_FINAL.pdf

[17] Ultra Ethernet Consortium. 2023. Overview of and Motivation for the Forthcoming Ultra Ethernet Consortium Specification. https://ultraethernet.org/wpcontent/uploads/sites/20/2023/10/23.07.12- UEC- 1.0- Overview- FINAL- WI THLOGO.pdf

[18] Ultra Ethernet Consortium. 2024. UEC Progresses Towards v1.0 Set of Specifications. https://ultraethernet.org/uec-progresses-towards-v1-0-set-ofspecifications/

[19] Tri Dao. 2023. FlashAttention-2: Faster Attention with Better Parallelism and Work Partitioning.

[20] Tri Dao, Daniel Y. Fu, Stefano Ermon, Atri Rudra, and Christopher Ré. 2022. FlashAttention: Fast and Memory-Efficient Exact Attention with IO-Awareness. In Advances in Neural Information Processing Systems.

[21] Tri Dao and Albert Gu. 2024. Transformers are SSMs: generalized models and efficient algorithms through structured state space duality. In Proceedings of the 41st International Conference on Machine Learning (Vienna, Austria) (ICML’24). JMLR.org, Article 399, 31 pages.

[22] Daniele De Sensi, Salvatore Di Girolamo, Kim H. McMahon, Duncan Roweth, and Torsten Hoefler. 2020. An In-Depth Analysis of the Slingshot Interconnect. In SC20: International Conference for High Performance Computing, Networking, Storage and Analysis. 1–14. https://doi.org/10.1109/SC41405.2020.00039

[23] DeepSeek-AI. 2024. DeepSeek-Coder-V2: Breaking the Barrier of Closed-Source Models in Code Intelligence. CoRR abs/2406.11931 (2024). https://doi.org/ 10.48550/arXiv.2406.11931

[24] DeepSeek-AI. 2024. DeepSeek LLM: Scaling Open-Source Language Models with Longtermism. CoRR abs/2401.02954 (2024). https://doi.org/10.48550/ arXiv.2401.02954

[25] DeepSeek-AI. 2024. DeepSeek-V2: A Strong, Economical, and Efficient Mixture-ofExperts Language Model. CoRR abs/2405.04434 (2024). https://doi.org/10.48550/ arXiv.2405.04434

[26] DeepSeek-AI. 2024. DeepSeek-V3 Technical Report. (2024). arXiv:2412.19437

[cs.CL] https://arxiv.org/abs/2412.19437

[27] DeepSeek-AI. 2024. DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models. CoRR abs/2401.06066 (2024). https: //doi.org/10.48550/arXiv.2401.06066

[28] DeepSeek-AI. 2025. DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning. arXiv:2501.12948[cs.CL] https://arxiv.org/abs/ 2501.12948

[29] DeepSeek-AI. 2025. DualPipe: A bidirectional pipeline parallelism algorithm for computation-communication overlap in V3/R1 training. https://github.com/ deepseek- ai/dualpipe.

[30] DeepSeek-AI. 2025. Fire-Flyer File System. https://github.com/deepseek-ai/3FS

[31] DeepSeek-AI. 2025. Profiling Data in DeepSeek Infra. https://github.com/ deepseek- ai/profile- data?tab=readme- ov- file#inference

[32] Elias Frantar, Saleh Ashkboos, Torsten Hoefler, and Dan Alistarh. 2022. Gptq: Accurate post-training quantization for generative pre-trained transformers. arXiv preprint arXiv:2210.17323 (2022).

[33] Adithya Gangidi, Rui Miao, Shengbao Zheng, Sai Jayesh Bondu, Guilherme Goes, Hany Morsy, Rohit Puri, Mohammad Riftadi, Ashmitha Jeevaraj Shetty, Jingyi Yang, Shuqiang Zhang, Mikel Jimenez Fernandez, Shashidhar Gandham, and Hongyi Zeng. 2024. RDMA over Ethernet for Distributed Training at Meta Scale. In Proceedings of the ACM SIGCOMM 2024 Conference (Sydney, NSW, Australia) (ACM SIGCOMM ’24). Association for Computing Machinery, New York, NY, USA, 57–70. https://doi.org/10.1145/3651890.3672233

[34] Patrick Geoffray and Torsten Hoefler. 2008. Adaptive Routing Strategies for Modern High Performance Networks. In 2008 16th IEEE Symposium on High Performance Interconnects. 165–172. https://doi.org/10.1109/HOTI.2008.21

[35] Amir Gholami, Zhewei Yao, Sehoon Kim, Coleman Hooper, Michael W. Mahoney, and Kurt Keutzer. 2024. AI and Memory Wall . IEEE Micro 44, 03 (May 2024), 33–39. https://doi.org/10.1109/MM.2024.3373763

[36] Fabian Gloeckle, Badr Youbi Idrissi, Baptiste Rozière, David Lopez-Paz, and Gabriel Synnaeve. 2024. Better & Faster Large Language Models via Multi-token Prediction. In Forty-first International Conference on Machine Learning, ICML 2024, Vienna, Austria, July 21-27, 2024. OpenReview.net. https://openreview.net/ forum?id=pEWAcejiU2

[37] Google. 2024. Introducing Gemini 2.0: our new AI model for the agentic era. https://blog.google/technology/google-deepmind/google-gemini-aiupdate- december- 2024

[38] Google. 2025. Gemini 2.5: Our most intelligent AI model. https://blog.google/ technology/google- deepmind/gemini- model- thinking- updates- march- 2025/

[39] MADSys group and Approaching.AI. 2025. A Flexible Framework for Experiencing Cutting-edge LLM Inference Optimizations. https://github.com/kvcacheai/ktransformers

[40] Coleman Hooper, Sehoon Kim, Hiva Mohammadzadeh, Michael W Mahoney, Yakun Sophia Shao, Kurt Keutzer, and Amir Gholami. 2024. KVQuant: Towards 10 Million Context Length LLM Inference with KV Cache Quantization. arXiv preprint arXiv:2401.18079 (2024).

[41] Albert Q Jiang, Alexandre Sablayrolles, Arthur Mensch, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Florian Bressand, Gianna Lengyel, Guillaume Lample, Lucile Saulnier, et al. 2023. Mistral 7B. arXiv preprint arXiv:2310.06825 (2023).

[42] Ziheng Jiang, Haibin Lin, Yinmin Zhong, Qi Huang, Yangrui Chen, Zhi Zhang, Yanghua Peng, Xiang Li, Cong Xie, Shibiao Nong, Yulu Jia, Sun He, Hongmin Chen, Zhihao Bai, Qi Hou, Shipeng Yan, Ding Zhou, Yiyao Sheng, Zhuo Jiang, Haohan Xu, Haoran Wei, Zhang Zhang, Pengfei Nie, Leqi Zou, Sida Zhao, Liang Xiang, Zherui Liu, Zhe Li, Xiaoying Jia, Jianxi Ye, Xin Jin, and Xin Liu. 2024. MegaScale: Scaling Large Language Model Training to More Than 10,000 GPUs. http://arxiv.org/abs/2402.15627 arXiv:2402.15627 [cs].

[43] Norm Jouppi, George Kurian, Sheng Li, Peter Ma, Rahul Nagarajan, Lifeng Nai, Nishant Patil, Suvinay Subramanian, Andy Swing, Brian Towles, Clifford Young, Xiang Zhou, Zongwei Zhou, and David A Patterson. 2023. TPU v4: An Optically Reconfigurable Supercomputer for Machine Learning with Hardware Support for Embeddings. In Proceedings of the 50th Annual International Symposium on Computer Architecture (Orlando, FL, USA) (ISCA ’23). Association for Computing Machinery, New York, NY, USA, Article 82, 14 pages. https://doi.org/10.1145/ 13 ISCA ’25, June 21–25, 2025, Tokyo, Japan DeepSeek-AI 3579371.3589350

[44] Hao Kang, Qingru Zhang, Souvik Kundu, Geonhwa Jeong, Zaoxing Liu, Tushar Krishna, and Tuo Zhao. 2024. GEAR: An Efficient KV Cache Compression Recipe for Near-Lossless Generative Inference of LLM. arXiv:2403.05527 [cs.LG]

[45] Jared Kaplan, Sam McCandlish, Tom Henighan, Tom B. Brown, Benjamin Chess, Rewon Child, Scott Gray, Alec Radford, Jeffrey Wu, and Dario Amodei. 2020. Scaling Laws for Neural Language Models. CoRR abs/2001.08361 (2020). arXiv:2001.08361 https://arxiv.org/abs/2001.08361

[46] John Kim, Wiliam J. Dally, Steve Scott, and Dennis Abts. 2008. TechnologyDriven, Highly-Scalable Dragonfly Topology. In 2008 International Symposium on Computer Architecture. 77–88. https://doi.org/10.1109/ISCA.2008.19

[47] Vijay Anand Korthikanti, Jared Casper, Sangkug Lym, Lawrence McAfee, Michael Andersch, Mohammad Shoeybi, and Bryan Catanzaro. 2023. Reducing activation recomputation in large transformer models. Proceedings of Machine Learning and Systems 5 (2023).

[48] Yuhui Li, Fangyun Wei, Chao Zhang, and Hongyang Zhang. 2024. EAGLE: Speculative Sampling Requires Rethinking Feature Uncertainty. In Forty-first International Conference on Machine Learning, ICML 2024, Vienna, Austria, July 21-27, 2024. OpenReview.net. https://openreview.net/forum?id=1NdN7eXyb4

[49] Heng Liao, Bingyang Liu, Xianping Chen, Zhigang Guo, Chuanning Cheng, Jianbing Wang, Xiangyu Chen, Peng Dong, Rui Meng, Wenjie Liu, Zhe Zhou, Ziyang Zhang, Yuhang Gai, Cunle Qian, Yi Xiong, Zhongwu Cheng, Jing Xia, Yuli Ma, Xi Chen, Wenhua Du, Shizhong Xiao, Chungang Li, Yong Qin, Liudong Xiong, Zhou Yu, Lv Chen, Lei Chen, Buyun Wang, Pei Wu, Junen Gao, Xiaochu Li, Jian He, Shizhuan Yan, and Bill McColl. 2025. UB-Mesh: a Hierarchically Localized nD-FullMesh Datacenter Network Architecture. arXiv:2503.20377 [cs.AR] https: //arxiv.org/abs/2503.20377

[50] Sean Lie. 2022. Cerebras Architecture Deep Dive: First Look Inside the HW/SW Co-Design for Deep Learning : Cerebras Systems. In 2022 IEEE Hot Chips 34 Symposium (HCS). 1–34. https://doi.org/10.1109/HCS55958.2022.9895479

[51] Ji Lin, Jiaming Tang, Haotian Tang, Shang Yang, Wei-Ming Chen, Wei-Chen Wang, Guangxuan Xiao, Xingyu Dang, Chuang Gan, and Song Han. 2024. AWQ: Activation-aware Weight Quantization for LLM Compression and Acceleration. In MLSys.

[52] Zirui Liu, Jiayi Yuan, Hongye Jin, Shaochen Zhong, Zhaozhuo Xu, Vladimir Braverman, Beidi Chen, and Xia Hu. 2024. KIVI: A Tuning-Free Asymmetric 2bit Quantization for KV Cache. arXiv preprint arXiv:2402.02750 (2024).

[53] Junyu Luo, Weizhi Zhang, Ye Yuan, Yusheng Zhao, Junwei Yang, Yiyang Gu, Bohan Wu, Binqi Chen, Ziyue Qiao, Qingqing Long, Rongcheng Tu, Xiao Luo, Wei Ju, Zhiping Xiao, Yifan Wang, Meng Xiao, Chenwu Liu, Jingyang Yuan, Shichang Zhang, Yiqiao Jin, Fan Zhang, Xian Wu, Hanqing Zhao, Dacheng Tao, Philip S. Yu, and Ming Zhang. 2025. Large Language Model Agent: A Survey on Methodology, Applications and Challenges. arXiv preprint arXiv:2503.21460 (2025).

[54] Karthik Mandakolathur and Sylvain Jeaugey. 2022. Doubling all2all Performance with NVIDIA Collective Communication Library 2.12. https://developer.nvidia.com/blog/doubling- all2all- performance- withnvidia- collective- communication- library- 2- 12/

[55] Mistral. 2024. Cheaper, Better, Faster, Stronger: Continuing to push the frontier of AI and making it accessible to all. https://mistral.ai/news/mixtral-8x22b

[56] Dheevatsa Mudigere, Yuchen Hao, Jianyu Huang, Zhihao Jia, Andrew Tulloch, Srinivas Sridharan, Xing Liu, Mustafa Ozdal, Jade Nie, Jongsoo Park, Liang Luo, Jie Amy Yang, Leon Gao, Dmytro Ivchenko, Aarti Basant, Yuxi Hu, Jiyan Yang, Ehsan K. Ardestani, Xiaodong Wang, Rakesh Komuravelli, Ching-Hsiang Chu, Serhat Yilmaz, Huayu Li, Jiyuan Qian, Zhuobo Feng, Yinbin Ma, Junjie Yang, Ellie Wen, Hong Li, Lin Yang, Chonglin Sun, Whitney Zhao, Dimitry Melts, Krishna Dhulipala, K. R. Kishore, Tyler Graf, Assaf Eisenman, Kiran Kumar Matam, Adi Gangidi, Guoqiang Jerry Chen, Manoj Krishnan, Avinash Nayak, Krishnakumar Nair, Bharath Muthiah, Mahmoud khorashadi, Pallab Bhattacharya, Petr Lapukhov, Maxim Naumov, Ajit Mathews, Lin Qiao, Mikhail Smelyanskiy, Bill Jia, and Vijay Rao. 2023. Software-Hardware Co-design for Fast and Scalable Training of Deep Learning Recommendation Models. http://arxiv.org/abs/2104.05158 arXiv:2104.05158 [cs].

[57] NVIDIA. 2022. Improving Network Performance of HPC Systems Using NVIDIA Magnum IO NVSHMEM and GPUDirect Async. https://developer.nvidia.com/blog/improving- network- performance- ofhpc- systems- using- nvidia- magnum- io- nvshmem- and- gpudirect- async/

[58] NVIDIA. 2025. NVIDIA DGX Spark: A Grace Blackwell AI supercomputer on your desk. https://www.nvidia.com/en-us/products/workstations/dgx-spark/

[59] OpenAI. 2024. Hello GPT-4o. https://openai.com/index/hello-gpt-4o/

[60] OpenAI. 2024. Introducing OpenAI o1. https://openai.com/o1/

[61] OpenAI. 2025. Introducing OpenAI o3 and o4-mini. https://openai.com/index/ introducing- o3- and- o4- mini/.

[62] Kun Qian, Yongqing Xi, Jiamin Cao, Jiaqi Gao, Yichi Xu, Yu Guan, Binzhang Fu, Xuemei Shi, Fangbo Zhu, Rui Miao, Chao Wang, Peng Wang, Pengcheng Zhang, Xianlong Zeng, Eddie Ruan, Zhiping Yao, Ennan Zhai, and Dennis Cai. 2024. Alibaba HPN: A Data Center Network for Large Language Model Training. In Proceedings of the ACM SIGCOMM 2024 Conference (Sydney, NSW, Australia) (ACM SIGCOMM ’24). Association for Computing Machinery, New York, NY, USA, 691–706. https://doi.org/10.1145/3651890.3672265

[63] Zhen Qin, Weigao Sun, Dong Li, Xuyang Shen, Weixuan Sun, and Yiran Zhong. 2024. Various lengths, constant speed: efficient language modeling with lightning attention. In Proceedings of the 41st International Conference on Machine Learning (Vienna, Austria) (ICML’24). JMLR.org, Article 1688, 19 pages.

[64] Rafael Rafailov, Archit Sharma, Eric Mitchell, Stefano Ermon, Christopher D. Manning, and Chelsea Finn. 2024. Direct Preference Optimization: Your Language Model is Secretly a Reward Model. arXiv:2305.18290 [cs.LG] https://arxiv.org/ abs/2305.18290

[65] Md Shafayat Rahman, Saptarshi Bhowmik, Yevgeniy Ryasnianskiy, Xin Yuan, and Michael Lang. 2019. Topology-custom UGAL routing on dragonfly. In Proceedings of the International Conference for High Performance Computing, Networking, Storage and Analysis (Denver, Colorado) (SC ’19). Association for Computing Machinery, New York, NY, USA, Article 17, 15 pages. https://doi.org/10.1145/ 3295500.3356208

[66] Bita Darvish Rouhani, Ritchie Zhao, Ankit More, Mathew Hall, Alireza Khodamoradi, Summer Deng, Dhruv Choudhary, Marius Cornea, Eric Dellinger, Kristof Denolf, Stosic Dusan, Venmugil Elango, Maximilian Golub, Alexander Heinecke, Phil James-Roxby, Dharmesh Jani, Gaurav Kolhe, Martin Langhammer, Ada Li, Levi Melnick, Maral Mesmakhosroshahi, Andres Rodriguez, Michael Schulte, Rasoul Shafipour, Lei Shao, Michael Siu, Pradeep Dubey, Paulius Micikevicius, Maxim Naumov, Colin Verrilli, Ralph Wittig, Doug Burger, and Eric Chung. 2023. Microscaling Data Formats for Deep Learning. arXiv:2310.10537 [cs.LG] https://arxiv.org/abs/2310.10537

[67] John Schulman, Filip Wolski, Prafulla Dhariwal, Alec Radford, and Oleg Klimov. 2017. Proximal Policy Optimization Algorithms. arXiv:1707.06347 [cs.LG] https://arxiv.org/abs/1707.06347

[68] ByteDance Seed. 2025. Seed1.5-Thinking: Advancing Superb Reasoning Models with Reinforcement Learning. arXiv:2504.13914 [cs.CL] https://arxiv.org/abs/ 2504.13914

[69] Zhihong Shao, Peiyi Wang, Qihao Zhu, Runxin Xu, Junxiao Song, Xiao Bi, Haowei Zhang, Mingchuan Zhang, Y. K. Li, Y. Wu, and Daya Guo. 2024. DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models. arXiv:2402.03300 [cs.CL] https://arxiv.org/abs/2402.03300

[70] Noam Shazeer. 2019. Fast Transformer Decoding: One Write-Head is All You Need. CoRR abs/1911.02150 (2019). http://arxiv.org/abs/1911.02150

[71] Qwen Team. 2025. Qwen3: Think Deeper, Act Faster. https://github.com/ QwenLM/Qwen3

[72] Song Wang, Bing Yu, Wenwu Xiao, Fujun Bai, Xiaodong Long, Liang Bai, Xuerong Jia, Fengguo Zuo, Jie Tan, Yixin Guo, Peng Sun, Jun Zhou, Qiong Zhan, Sheng Hu, Yu Zhou, Yi Kang, Qiwei Ren, and Xiping Jiang. 2023. A 135 GBps/Gbit 0.66 pJ/bit Stacked Embedded DRAM with Multilayer Arrays by Fine Pitch Hybrid Bonding and Mini-TSV. In 2023 IEEE Symposium on VLSI Technology and Circuits (VLSI Technology and Circuits). 1–2. https://doi.org/10.23919/ VLSITechnologyandCir57934.2023.10185427

[73] xAI. 2024. Grok-2 Beta Release. https://x.ai/news/grok-2.

[74] xAI. 2024. Our Gigafactory of Compute:Colossus. https://x.ai/colossus.

[75] An Yang, Baosong Yang, Beichen Zhang, Binyuan Hui, Bo Zheng, Bowen Yu, Chengyuan Li, Dayiheng Liu, Fei Huang, Haoran Wei, Huan Lin, Jian Yang, Jianhong Tu, Jianwei Zhang, Jianxin Yang, Jiaxi Yang, Jingren Zhou, Junyang Lin, Kai Dang, Keming Lu, Keqin Bao, Kexin Yang, Le Yu, Mei Li, Mingfeng Xue, Pei Zhang, Qin Zhu, Rui Men, Runji Lin, Tianhao Li, Tianyi Tang, Tingyu Xia, Xingzhang Ren, Xuancheng Ren, Yang Fan, Yang Su, Yichang Zhang, Yu Wan, Yuqiong Liu, Zeyu Cui, Zhenru Zhang, and Zihan Qiu. 2024. Qwen2.5 Technical Report. arXiv preprint arXiv:2412.15115 (2024).

[76] Jingyang Yuan, Huazuo Gao, Damai Dai, Junyu Luo, Liang Zhao, Zhengyan Zhang, Zhenda Xie, Y. X. Wei, Lean Wang, Zhiping Xiao, Yuqing Wang, Chong Ruan, Ming Zhang, Wenfeng Liang, and Wangding Zeng. 2025. Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention. https: //arxiv.org/abs/2502.11089

[77] Chenggang Zhao, Liang Zhao, Jiashi Li, and Zhean Xu. 2025. DeepGEMM: clean and efficient FP8 GEMM kernels with fine-grained scaling. https://github.com/ deepseek- ai/DeepGEMM.

[78] Chenggang Zhao, Shangyan Zhou, Liyue Zhang, Chengqi Deng, Zhean Xu, Yuxuan Liu, Kuai Yu, Jiashi Li, and Liang Zhao. 2025. DeepEP: an efficient expert-parallel communication library. https://github.com/deepseek-ai/DeepEP.

[79] Size Zheng, Jin Fang, Xuegui Zheng, Qi Hou, Wenlei Bao, Ningxin Zheng, Ziheng Jiang, Dongyang Wang, Jianxi Ye, Haibin Lin, Li-Wen Chang, and Xin Liu. 2025. TileLink: Generating Efficient Compute-Communication Overlapping Kernels using Tile-Centric Primitives. arXiv:2503.20313 [cs.DC] https://arxiv.org/abs/ 2503.20313

[80] Yinmin Zhong, Shengyu Liu, Junda Chen, Jianbo Hu, Yibo Zhu, Xuanzhe Liu, Xin Jin, and Hao Zhang. 2024. DistServe: Disaggregating Prefill and Decoding for Goodput-optimized Large Language Model Serving. In 18th USENIX Symposium on Operating Systems Design and Implementation (OSDI 24). USENIX Association, Santa Clara, CA, 193–210. https://www.usenix.org/conference/osdi24/ presentation/zhong- yinmin

版權聲明:

本文由 youcans@xidian 對論文 Insights into DeepSeek-V3: Scaling Challenges and Reflections on Hardware for AI Architectures 進行摘編和翻譯,只供研究學習使用。

youcans@xidian 作品,轉載必須標注原文鏈接:

【DeepSeek論文精讀】11. 洞察 DeepSeek-V3:擴展挑戰和對 AI 架構硬件的思考

Copyright 2025 youcans, XIDIAN

Created:2025-05

:解釋器風格)