目錄

1.算法運行效果圖預覽

2.算法運行軟件版本

3.部分核心程序

4.算法理論概述

4.1卷積神經網絡(CNN)在時間序列中的應用

4.2 長短時記憶網絡(LSTM)處理序列依賴關系

4.3 注意力機制(Attention)

5.算法完整程序工程

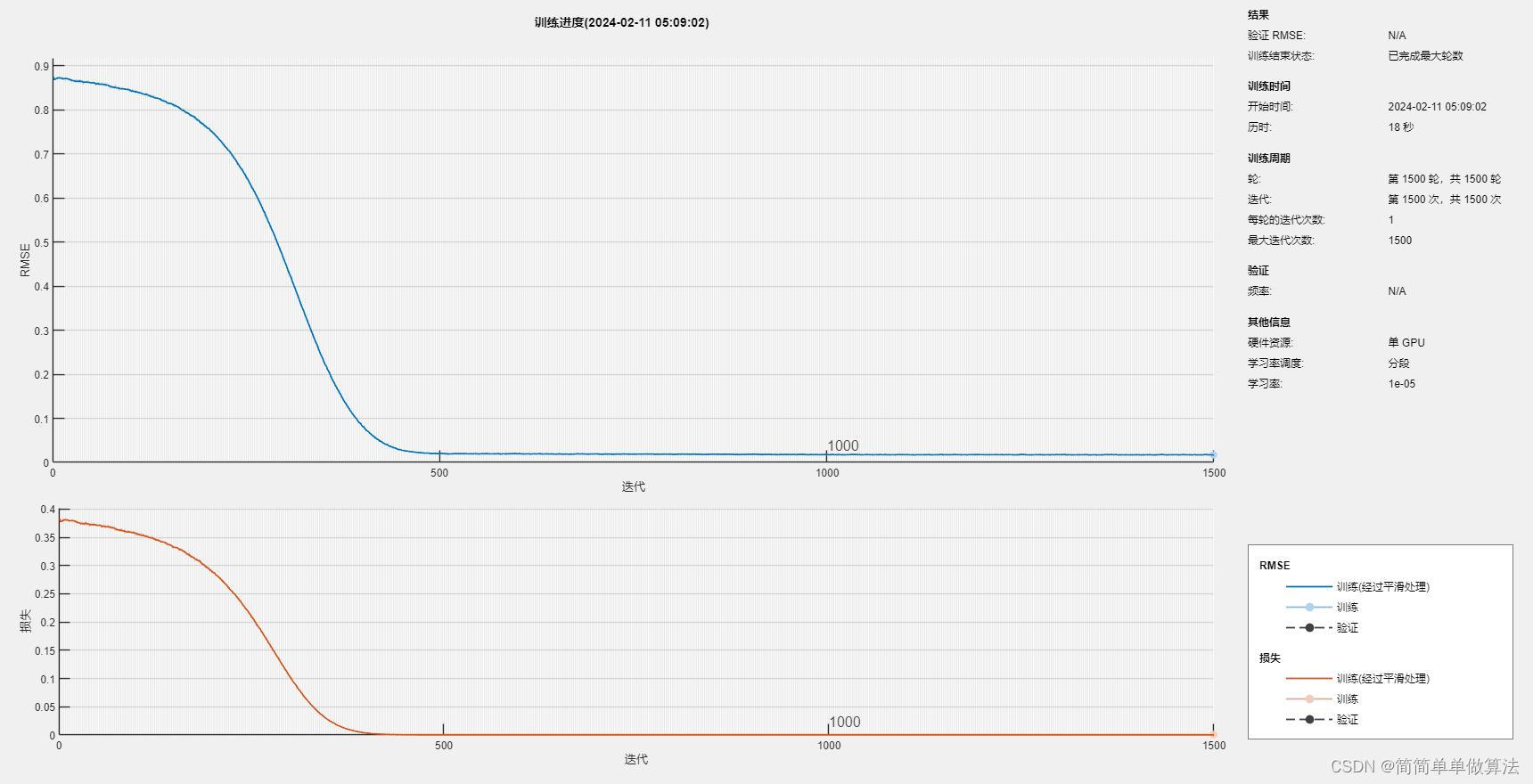

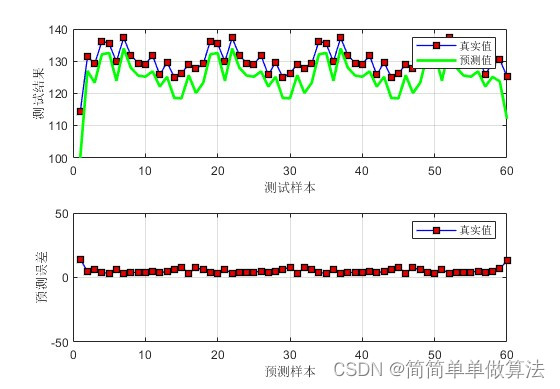

1.算法運行效果圖預覽

2.算法運行軟件版本

matlab2022a

3.部分核心程序

.............................................................

%格式轉換

for i = 1 : Num1Nsp_train2{i} = Nsp_train(:,:,1,i);

endfor i = 1 : Num2Nsp_test2{i} = Nsp_test(:,:,1,i);

end%CNN-LSTM-ATT

layers = func_model(Dim);%數據預測

Dpre1 = predict(Net, Nsp_train2);

Dpre2 = predict(Net, Nsp_test2);%歸一化還原

T_sim1=Dpre1*Vmax2;

T_sim2=Dpre2*Vmax2;%網絡結構

analyzeNetwork(Net)figure

subplot(211);

plot(1: Num1, Tat_train,'-bs',...'LineWidth',1,...'MarkerSize',6,...'MarkerEdgeColor','k',...'MarkerFaceColor',[0.9,0.0,0.0]);

hold on

plot(1: Num1, T_sim1,'g',...'LineWidth',2,...'MarkerSize',6,...'MarkerEdgeColor','k',...'MarkerFaceColor',[0.9,0.9,0.0]);legend('真實值', '預測值')

xlabel('預測樣本')

ylabel('預測結果')

grid onsubplot(212);

plot(1: Num1, Tat_train-T_sim1','-bs',...'LineWidth',1,...'MarkerSize',6,...'MarkerEdgeColor','k',...'MarkerFaceColor',[0.9,0.0,0.0]);

legend('真實值', '預測值')

xlabel('預測樣本')

ylabel('預測誤差')

grid on

ylim([-50,50]);figure

subplot(211);

plot(1: Num2, Tat_test,'-bs',...'LineWidth',1,...'MarkerSize',6,...'MarkerEdgeColor','k',...'MarkerFaceColor',[0.9,0.0,0.0]);

hold on

plot(1: Num2, T_sim2,'g',...'LineWidth',2,...'MarkerSize',6,...'MarkerEdgeColor','k',...'MarkerFaceColor',[0.9,0.9,0.0]);

legend('真實值', '預測值')

xlabel('測試樣本')

ylabel('測試結果')

grid onsubplot(212);

plot(1: Num2, Tat_test-T_sim2','-bs',...'LineWidth',1,...'MarkerSize',6,...'MarkerEdgeColor','k',...'MarkerFaceColor',[0.9,0.0,0.0]);

legend('真實值', '預測值')

xlabel('預測樣本')

ylabel('預測誤差')

grid on

ylim([-50,50]);

1154.算法理論概述

? ? ? ? 時間序列預測是許多領域中的核心問題,如金融市場分析、氣候預測、交通流量預測等。近年來,深度學習在時間序列分析上取得了顯著的成果,尤其是卷積神經網絡(CNN)、長短時記憶網絡(LSTM)和注意力機制(Attention)的結合使用。

4.1卷積神經網絡(CNN)在時間序列中的應用

? ? ? 在時間序列數據中,CNN用于提取局部特征和模式。對于一個長度為T的時間序列數據X = [x_1, x_2, ..., x_T],通過卷積層可以生成一組特征映射:

? ? ? ?CNN通過多個卷積層和池化層的堆疊來提取輸入數據的特征。每個卷積層都包含多個卷積核,用于捕捉不同的特征。池化層則用于降低數據的維度,減少計算量并增強模型的魯棒性。

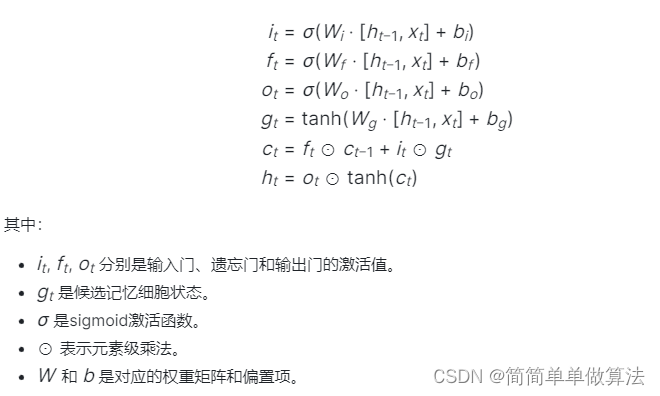

4.2 長短時記憶網絡(LSTM)處理序列依賴關系

? ? ? ?LSTM單元能夠有效捕捉時間序列中的長期依賴關系。在一個時間步t,LSTM的內部狀態h_t和隱藏狀態c_t更新如下:

? ? ? ?長短時記憶網絡是一種特殊的循環神經網絡(RNN),設計用于解決長序列依賴問題。在時間序列預測中,LSTM能夠有效地捕捉時間序列中的長期依賴關系。

4.3 注意力機制(Attention)

? ? ? ?注意力機制是一種讓模型能夠自動地關注輸入數據中重要部分的技術。在時間序列預測中,注意力機制可以幫助模型關注與當前預測最相關的歷史信息。

? ? ? ?CNN-LSTM-Attention模型結合了CNN、LSTM和Attention三種技術的優勢。首先,使用CNN提取時間序列中的局部特征;然后,將提取的特征輸入到LSTM中,捕捉時間序列中的長期依賴關系;最后,通過注意力機制對LSTM的輸出進行加權,使模型能夠關注與當前預測最相關的歷史信息。具體來說,模型的流程如下:

- 使用CNN處理原始時間序列數據,提取局部特征。這可以通過多個卷積層和池化層的堆疊來實現。

- 將CNN的輸出作為LSTM的輸入,捕捉時間序列中的長期依賴關系。這里可以使用多層LSTM來增強模型的表達能力。

- 在LSTM的輸出上應用注意力機制,計算每個歷史時刻的注意力權重,并生成上下文向量。這個上下文向量包含了所有歷史時刻的信息,但已經根據當前時刻的查詢進行了加權。

- 將上下文向量與當前時刻的輸入或隱藏狀態進行融合,生成最終的預測結果。這可以通過一個簡單的全連接層來實現。

5.算法完整程序工程

OOOOO

OOO

O

)

)

【python源碼+UI界面+功能源碼詳解】)

動畫的基礎了解(感覺不了解其實也行))