大家好,我是風雨無阻。

本文適合人群:

-

想要了解AI繪圖基本原理的朋友。

-

對Stable Diffusion AI繪圖感興趣的朋友。

本期內容:

-

Stable Diffusion 能做什么

-

什么是擴散模型

-

擴散模型實現原理

-

Stable Diffusion 潛擴散模型

-

Stable Diffusion文本如何影響圖片生成

-

Stable Diffusion Cross-attention 技術

-

Stable Diffusion noise schedule 技術

-

Stable Diffusion文生圖底層運行演示

一、 Stable Diffusion能做什么

通過前面幾篇文章關于 Stable Diffusion 整合包的安裝、ControlNet插件的介紹使、sd模型的安裝和使用以及文生圖功能的介紹后,相信看過的朋友應該都清楚的知道 Stable Diffusion 是做什么的吧?

對于新朋友,想詳細了解的話,請前往:

AI 繪畫Stable Diffusion 研究(一)sd整合包v4.2 版本安裝說明

AI 繪畫Stable Diffusion 研究(二)sd模型ControlNet1.1 介紹與安裝

AI 繪畫Stable Diffusion 研究(三)sd模型種類介紹及安裝使用詳解

AI 繪畫Stable Diffusion 研究(四)sd文生圖功能詳解(上)

AI 繪畫Stable Diffusion 研究(五)sd文生圖功能詳解(下)

AI 繪畫Stable Diffusion 研究(六)sd提示詞插件

這里再用最直白的話說一下:SD它是一個text-to-image模型 ,通過給定的 text prompt(文本提示詞),可生成一張匹配文本的圖片。

二、什么是擴散模型

大家都經常聽到有人說,Stable Diffusion是一種潛在擴散模型(Diffusion Models)。

那我們先弄明白什么是擴散模型?

為什么叫擴散模型呢?因為它的數學公式看起來非常像物理上的擴散現象。

1、前向擴散

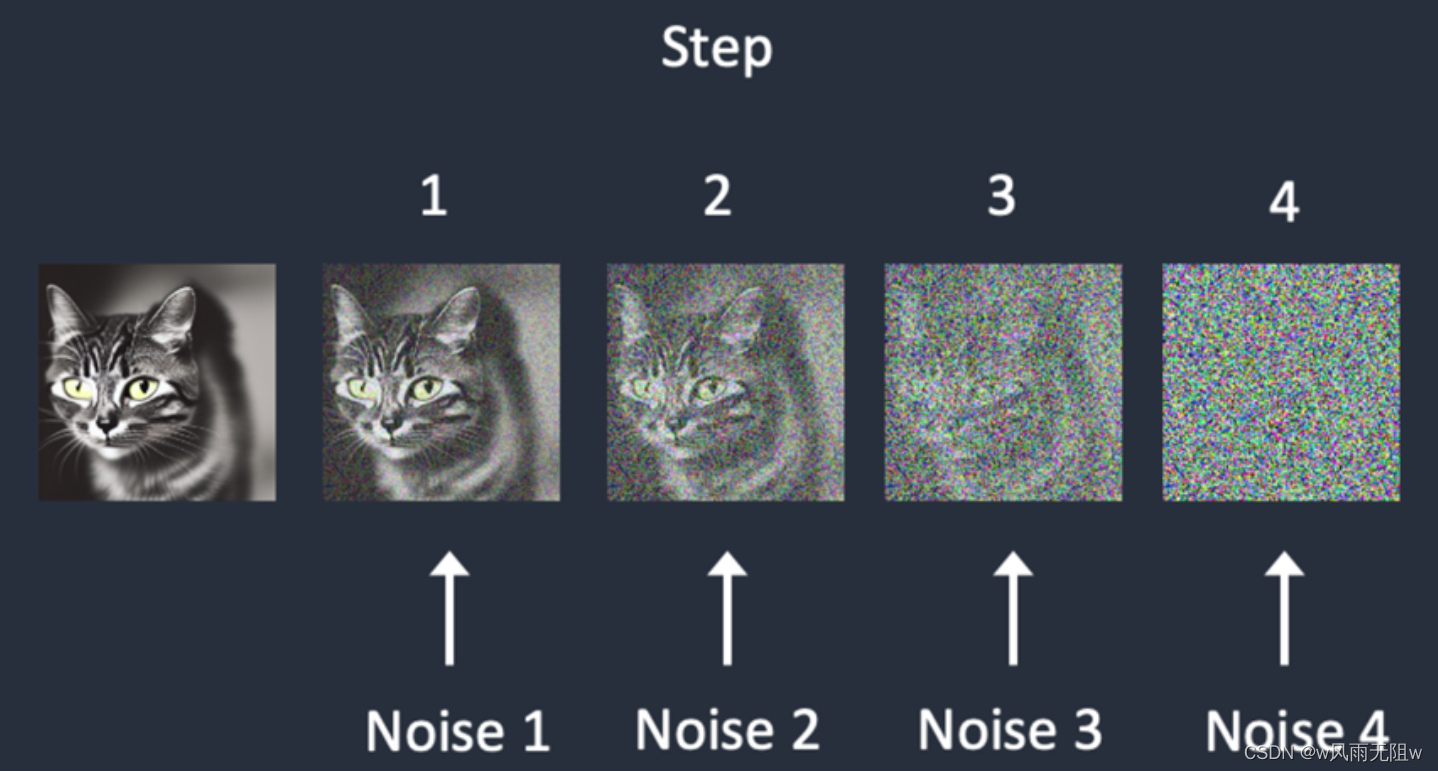

假如我們訓練一個模型如下:

正如上圖所示,是一個前向擴散的過程,它是在訓練圖像上逐漸添加噪聲,最后變成完全隨機噪聲圖,并最終無法辨認噪點圖對應的初始圖片。

這個過程就像是一滴墨水滴在一杯清水里,會慢慢擴散最終均勻分布在清水里一樣,且無法判斷它最初是從水杯的中心滴入,還是從邊緣滴入,擴散這個名字就是這么來的。

2、反向擴散

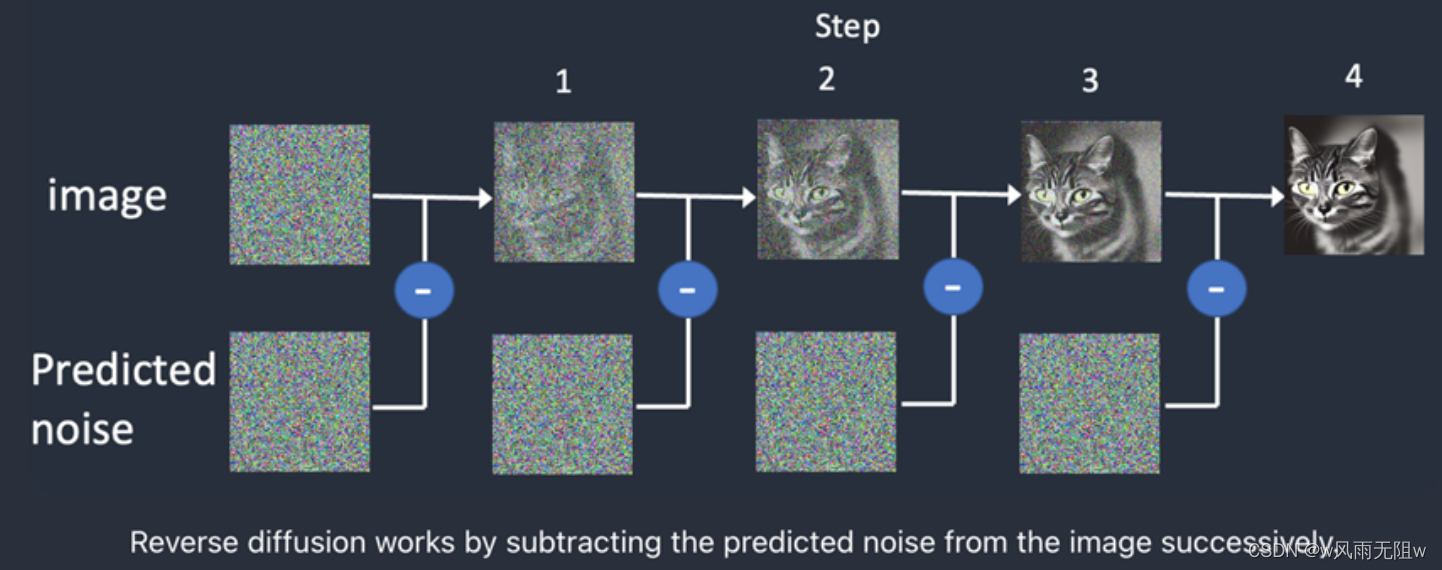

反向擴散的思想是:輸入一張噪點圖,反向擴散(Reverse Diffusion),讓上述過程獲得逆向從隨機噪聲圖生成清晰圖像的過程。

從反向擴散的角度來說,我們需要知道有多少“噪點”加入到了某張圖片里。

那么要知道答案的方式便是:訓練一個神經網絡來預測添加的噪點,這在SD里稱為噪點預測器(Noise Predicator),其本質是一個U-Net模型。

訓練流程為:

(1)、選擇一張訓練圖(例如一張貓的圖片)

(2)、生成隨機的噪點圖

(3)、給這張圖繼續增加多輪噪點

(4)、訓練Noise Predicator,預測加入了多少噪點,通過神經網絡訓練權重,并展示其正確答案。

反向擴散訓練的重點下圖中的噪聲預測器(Noise Predicator),它可以通過訓練得出每次需要減掉的噪聲,每次需要減多少噪聲是預測出來的,從而實現還原清晰圖片的目的。

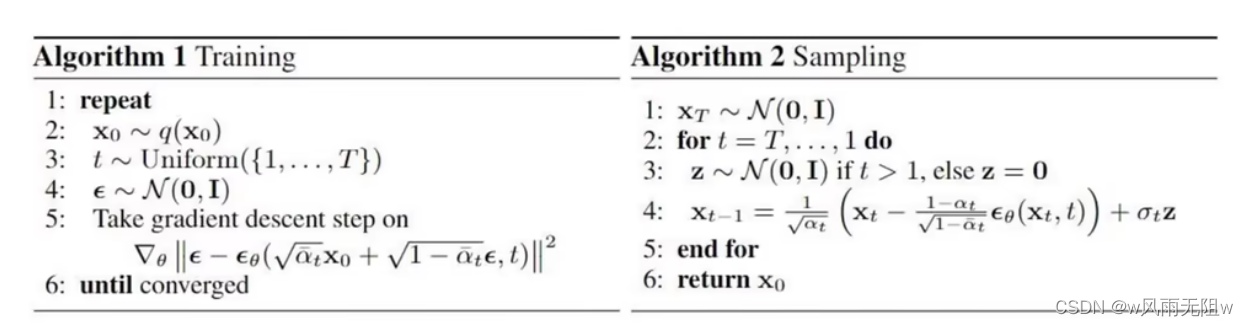

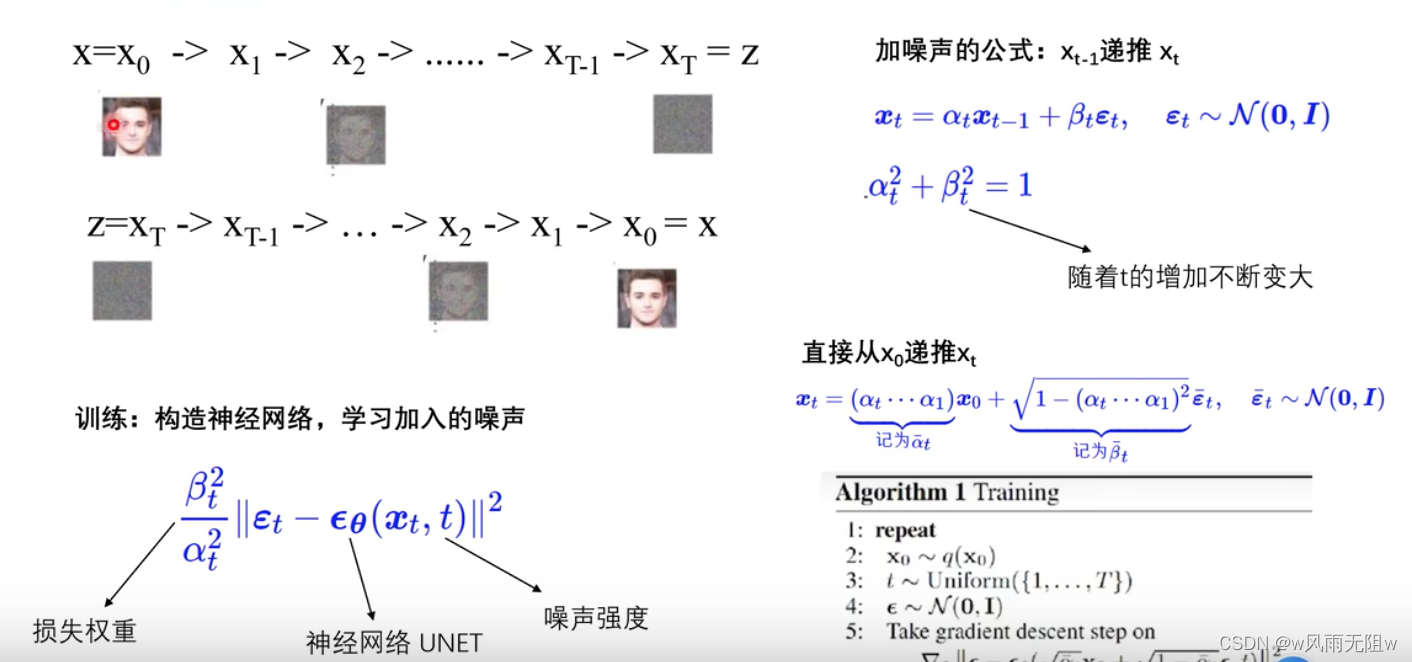

三、擴散模型實現原理

擴散模型(Diffusion Models)的成功,其實并非橫空出世,突然出現在人們的視野中。其實早在2015年就已有人提出了類似的想法,最終在2020年提出了擴散模型的生成技術。

以下是擴散模型推導公式:

更詳細的原理:

參考:擴散模型詳解原理+代碼

通過前面的介紹,我們大概明白了,什么是擴散模型,但這并不是 Stable Diffusion的工作原理。

這是因為:上述擴散過程是在圖片空間里完成的,無論是模型訓練,還是生成圖片的過程,都是需要海量的算力支持和內存需求。

想象一下:一張512 x 512的圖片(包含3個顏色通道:紅、綠、藍),它的空間是786432維,也就是說我們要為一張圖片指定這么多的值。因此,基本無法在單個GPU上運行。

Stable Diffusion就是降低算力和內存需求的一個解決方案。它讓Stable Diffusion在消費級GPU上運行成為了可能。

**四、Stable Diffusion 潛擴散模型 **

Stable Diffusion 它是一個Latent Diffusion Model(潛擴散模型)。其方式是將圖片壓縮到一個“潛空間”(Latent Space)中,而不是在高維的圖片空間里工作。潛空間比圖片空間小了48倍,所以它可以節省大量計算,繼而運行速度更快。

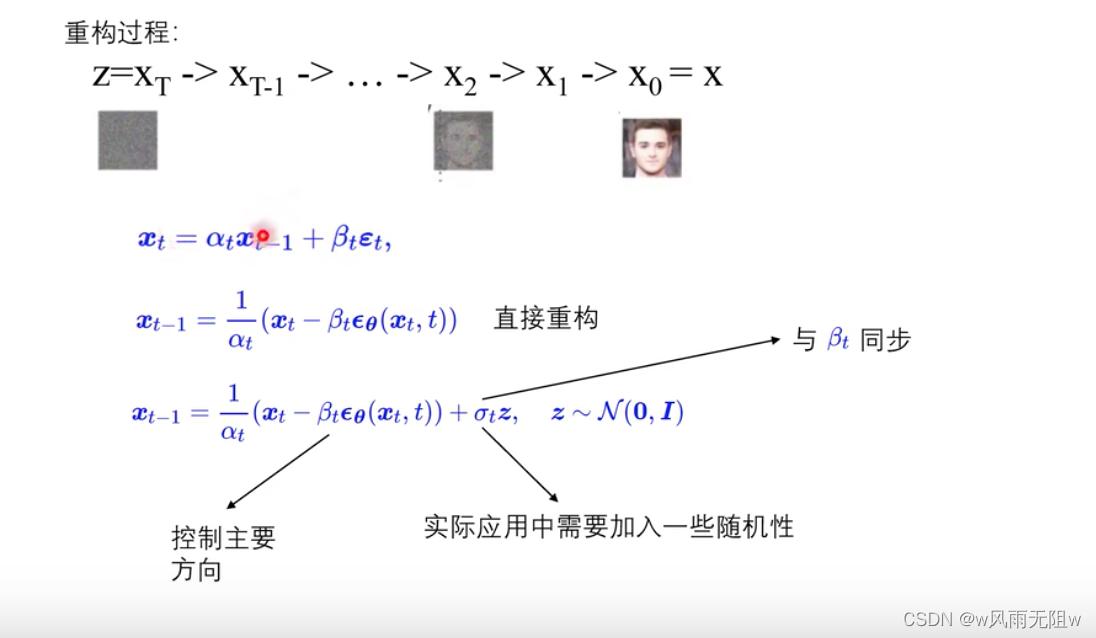

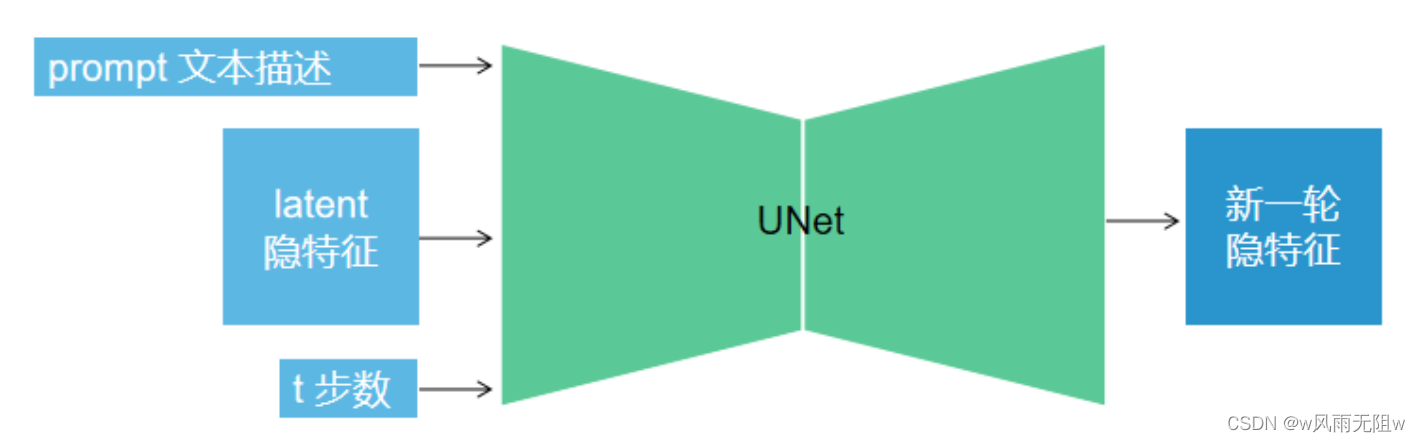

擴散過程會分成很多步循環,而每一步的過程如下圖所示,將文本描述、隱變量、步數等數值傳入UNet,生成新的隱變量,而這個過程會涉及一些模型。

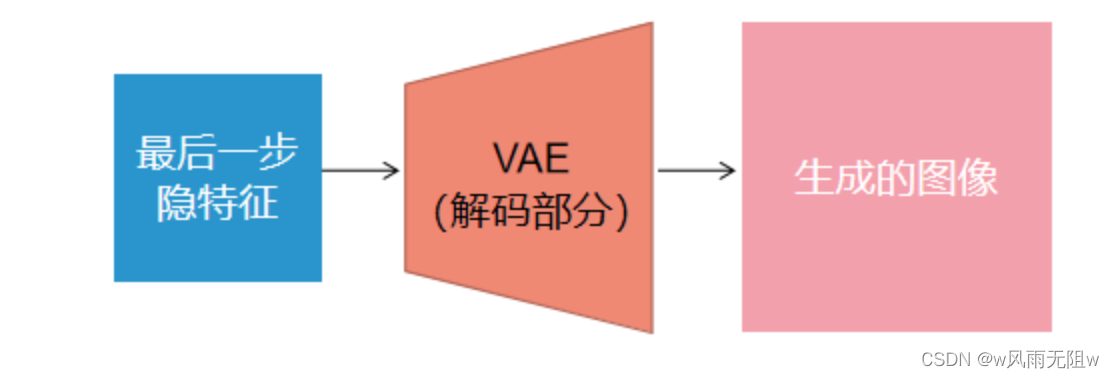

在最后一步循環,將隱特征經由 Variational Autoencoder(VAE)解碼成圖像。

這個過程的核心思想就是:壓縮圖像,它通過變分自編碼器 Variational Autoencoder(VAE)模型,把圖像壓縮到極致,我們把此類壓縮方式稱作降維,這種降維級別的壓縮不丟失重要信息。

經過壓縮后,圖像被稱作低維潛在(Latent)“圖像”,作為U-net的輸入,去潛空間(Latent Space)里一步一步降噪后,完成反向擴散的低維“圖片”還得通過VAE的解碼器,把圖像從潛空間轉換回像素空間(Pixel Space)。

VAE包含2部分:Encoder與Decoder。

-

Encoder將一張圖片壓縮到“潛空間”里的一個低維空間表示

-

Decoder從“潛空間”里的表示恢復為一張圖片

下列代碼演示了VAE模型的使用方法,其中load_vae為根據配置init_config去初始化模型,然后從預訓練模型model.ckpt中讀取參數,預訓練模型的first_stage_model即指代VAE模型。

from ldm.models.autoencoder import AutoencoderKL

#VAE模型

def load_vae():#初始化模型init_config = {"embed_dim": 4,"monitor": "val/rec_loss","ddconfig":{"double_z": True,"z_channels": 4,"resolution": 256,"in_channels": 3,"out_ch": 3,"ch": 128,"ch_mult":[1,2,4,4],"num_res_blocks": 2,"attn_resolutions": [],"dropout": 0.0,},"lossconfig":{"target": "torch.nn.Identity"}}vae = AutoencoderKL(**init_config)#加載預訓練參數pl_sd = torch.load("model.ckpt", map_location="cpu")sd = pl_sd["state_dict"]model_dict = vae.state_dict()for k, v in model_dict.items():model_dict[k] = sd["first_stage_model."+k]vae.load_state_dict(model_dict, strict=False)vae.eval()return vae#測試vae模型

def test_vae():vae = load_vae()img = load_image("girl_and_horse.png") #(1,3,512,512) latent = vae.encode(img).sample() #(1,4,64,64)samples = vae.decode(latent) #(1,3,512,512)save_image(samples,"vae.png")test_vae()

五、Stable Diffusion 文本如何影響圖片生成

在 Stable Diffusion 模型中,prompt 是通過引導向量(guidance vector)來控制 U-Net 的。具體來說,prompt 會被編碼成一個文本嵌入向量(text embeddings),然后與其他輸入一起傳遞給 U-Net。

通過這種方式,prompt 能夠影響 U-Net 的輸出,從而在生成過程中引導模型產生符合預期的結果,即通過 prompt 產生我們想要的圖。

在Stable Diffusion模型限制prompt在75個單詞。

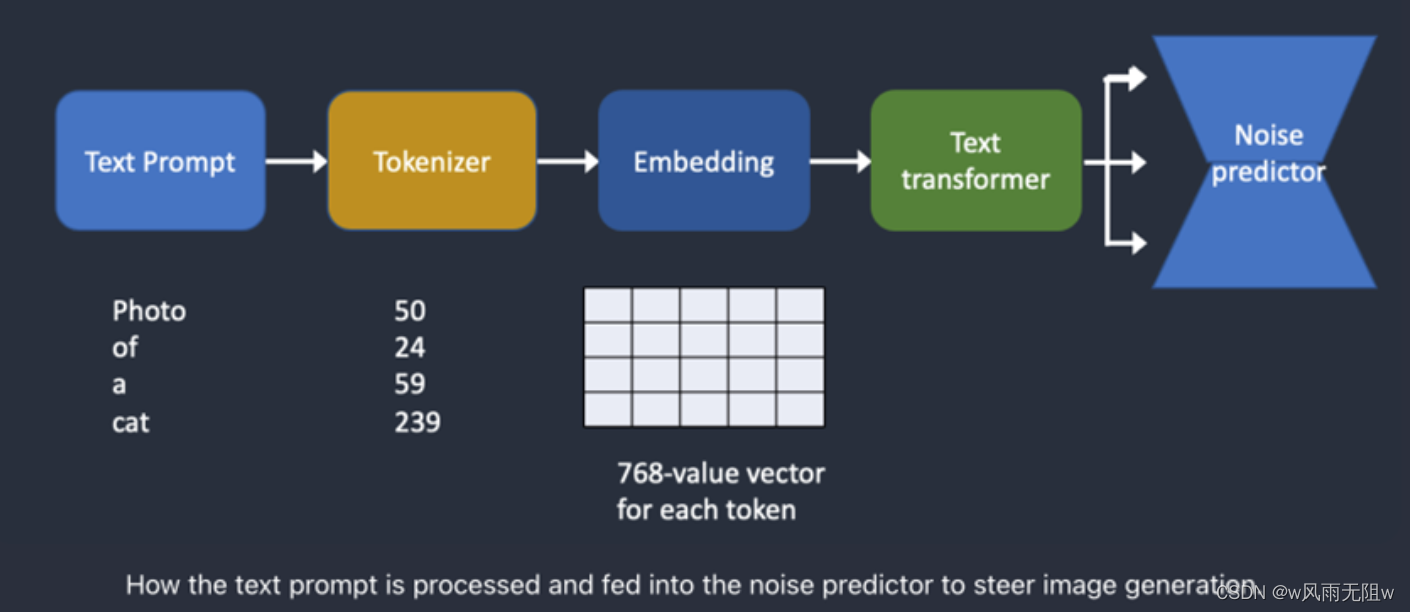

下圖是文本提示詞(text prompt)如何處理并輸入到Noise Predictor的流程:

根據上圖,我們可以看到這個流程:

首先,Tokenizer(分詞器)將每個輸入的單詞轉為一個數字,我們稱為token。

然后,每個token轉為一個768維的向量,稱為詞嵌入(embedding)。

最后,由Text Transformer處理詞嵌入,并可以被Noise predictor進行消費。

1、分詞器 (Tokenizer)

人類可以讀懂單詞,但計算機只能讀懂數字。所以這也是為什么文本提示詞首先要轉為單詞。

文本提示詞(text prompt)首先由一個CLIP tokenizer做分詞。

CLIP是一個深度學習模型,由Open AI開發,用于為任何圖片生成文本描述。

以下是CLIP具體的實例

展示了如何將文本“蘋果”通過CLIP技術轉化為能輸入到神經網絡中訓練的tokens數據。

這里使用Python和OpenAI庫來實現。

(1)、安裝依賴庫

pip install torch openai

(2)、導入相關庫

import torch import openai

(3)、加載CLIP模型

model, preprocess = openai.clip.load("ViT-B/32")

(4)、準備輸入文本

text_description = "蘋果"

(5)、將文本轉換為tokens

使用CLIP模型的tokenize方法將文本轉換為tokens

text_tokens = openai.clip.tokenize(text_description)

這里,text_tokens是一個PyTorch張量,形狀為(1, N),其中N是文本描述中的token數量。

在這個例子中,N=3,因為"蘋果"被分成了3個tokens。

(6)、 查看tokens

print(f"Tokens: {text_tokens}")

輸出結果可能類似于:

Tokens: tensor([[49406, 3782, 49407]])

這里,49406表示開始符號(start-of-sentence),3782表示“蘋果”,49407表示結束符號(end-of-sentence)。

通過以上步驟,我們將文本“蘋果”轉換為了tokens。

PS:

-

Stable Diffusion v1使用了CLIP模型的tokenizer

-

Tokenizer只能將其在訓練過程中見到過的單詞進行分詞

例如:假設CLIP模型里有“dream”與“beach”單詞,但是沒有“dreambeach”單詞。

Tokenizer會將“dreambeach”分成2個單詞“dream”與“beach”。

-

1個單詞并非代表1個token,而是有可能進一步進行拆分

-

空格也是token的一部分

例如:短語 “dream beach” 產生了兩個token “dream” 和 “[space]beach”。

這些標記與 “dreambeach” 產生的標記不同,后者是 “dream” 和 “beach”(beach 前沒有空格)。

2、詞嵌入(Embedding)

(1)、為什么需要詞嵌入(Embedding)?

因為有些單詞相互之間是非常相似,我們希望利用到這些語義信息。

例如:

man、gentleman、guy的詞嵌入是非常相近的,因此它們可以相互替換。

Monet、Manet以及Degas都以印象派的風格繪畫,但是方式各不相同。

這些名字看起來是非常相似,但是在詞嵌入(Embedding)里是不一樣的。

(2)、詞嵌入(Embedding) 是如何工作的?

Embedding 將輸入的tokens轉換為一個連續的向量來表示,這個向量可以捕捉文本中的語義信息。在我們的例子中,"蘋果"的tokens經過CLIP模型的encode_text方法后,會得到一個特征向量。

這個特征向量是一個高維空間中的點,通常具有固定的維度(在CLIP模型中,維度為512)。請注意,由于模型權重和隨機性的原因,每次運行時生成的特征向量可能略有不同。以下是一個示例輸出:

print(f"Text features: {text_features}")

輸出結果可能類似于:

Text features: tensor([[-0.0123, 0.0345, -0.0678, ..., 0.0219, -0.0456, 0.0789]])

這里,text_features是一個形狀為(1, 512)的PyTorch張量,其中包含了“蘋果”這個詞的向量表示。神經網絡可以利用這個向量表示進行訓練和預測任務。

Stable diffusion v1使用Open AI的ViT-L/14模型,詞嵌入為768維的向量。

3、文本轉換器(text transformer)

(1)、為什么需要text transformer ?

既然通過embedding后可以直接輸入到模型中進行訓練,為何在stable diffusion中還需要將embedding通過text transformer轉換后再作為模型的輸入呢?

這是因為Stable Diffusion模型是一個圖像生成模型,它需要理解輸入文本的語義信息以生成與之相關的圖像。直接使用基本的文本embedding可能無法充分捕捉到文本中的復雜語義關系。通過使用text transformer,可以獲得一個更豐富、更具表現力的文本表示,這有助于提高生成圖像的質量和與輸入文本的相關性。

使用text transformer 在捕捉文本語義信息時,能夠考慮到更多上下文關系和抽象概念。

這個轉換器就像是一個通用的條件(conditioning)適配器。

(2)、text transformer轉換示例

下面以"蘋果"為例進行說明。

假設我們已經獲得了"蘋果"的基本embedding(一個形狀為(1, 512)的PyTorch張量):

text_features = tensor([[-0.0123, 0.0345, -0.0678, ..., 0.0219, -0.0456, 0.0789]])

接下來,我們將這個張量輸入到text transformer中:

transformed_text_features = text_transformer(text_features)

經過text transformer處理后,我們可能會得到一個新的張量,如:

print(f"Transformed text features: {transformed_text_features}")

輸出結果可能類似于:

Transformed text features: tensor([[ 0.0234, -0.0567, 0.0890, ..., -0.0321, 0.0672, -0.0813]])

這個新的張量(形狀仍為(1, 512))包含了更豐富的語義信息,例如上下文關系和抽象概念。

這有助于Stable Diffusion模型更好地理解輸入文本,并生成與之相關的圖像。

請注意:

由于模型權重和隨機性的原因,每次運行時生成的特征向量可能略有不同。

此外,具體的變化過程取決于所使用的text transformer結構和參數。

六、Stable Diffusion Cross-attention技術

Cross-attention 是通過提示詞產生圖片的核心技術。

文本轉換器的輸出,會被noise predictor在U-Net中使用到多次。

U-Net以一個叫做cross-attention機制的方式來使用它,cross-attention機制允許模型在不同的特征層次上關注相關的區域,從而提高生成結果的質量,這即是prompt適配圖片的地方。

下面代碼是stable diffusion所使用的transformers塊,實現了cross-attention:

class SpatialTransformer(nn.Module):"""Transformer block for image-like data.First, project the input (aka embedding)and reshape to b, t, d.Then apply standard transformer action.Finally, reshape to image"""def __init__(self, in_channels, n_heads, d_head,depth=1, dropout=0., context_dim=None):super().__init__()self.in_channels = in_channelsinner_dim = n_heads * d_headself.norm = Normalize(in_channels)self.proj_in = nn.Conv2d(in_channels,inner_dim,kernel_size=1,stride=1,padding=0)self.transformer_blocks = nn.ModuleList([BasicTransformerBlock(inner_dim, n_heads, d_head, dropout=dropout, context_dim=context_dim)for d in range(depth)])self.proj_out = zero_module(nn.Conv2d(inner_dim,in_channels,kernel_size=1,stride=1,padding=0))def forward(self, x, context=None):# note: if no context is given, cross-attention defaults to self-attentionb, c, h, w = x.shapex_in = xx = self.norm(x)x = self.proj_in(x)x = rearrange(x, 'b c h w -> b (h w) c')for block in self.transformer_blocks:x = block(x, context=context)x = rearrange(x, 'b (h w) c -> b c h w', h=h, w=w)x = self.proj_out(x)return x + x_in

七、Stable Diffusion noise schedule 技術

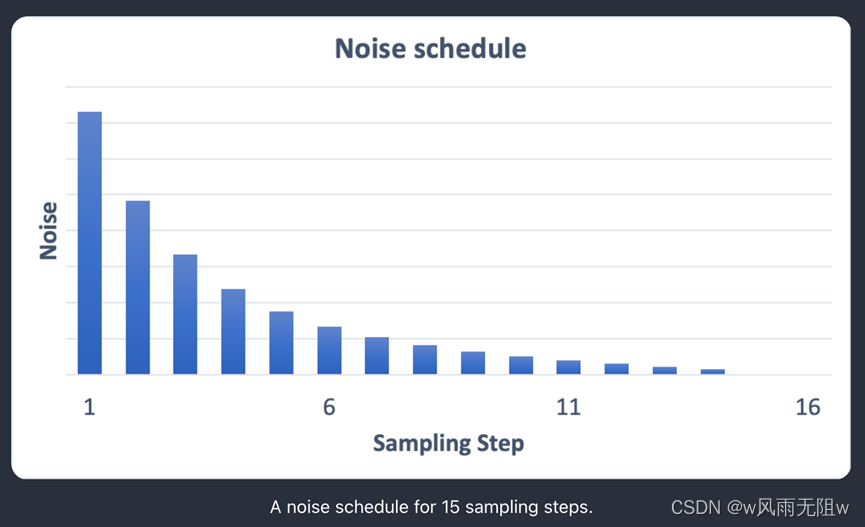

1、什么是 noise schedule ?

噪聲通過多次U-Net的處理,最終會輸出我們想要的圖片。

在這多次處理中,每一次的降噪的幅度是不同的,所以我們就要通過schedulers來控制每次降噪的幅度(幅度一般是遞減的)。這個技術就叫做 noise schedule。

如圖:

那么為什么要使用 noise schedule 技術呢?

在 Stable Diffusion 這種生成模型中,U-Net 是一個核心組件,用于從噪聲圖像中逐步恢復出原始圖像。在多次迭代過程中,降噪幅度逐漸減小的原因是為了更精細地恢復圖像的細節和結構。

Stable Diffusion 的過程可以看作是一個逆向擴散過程,它從一個高度噪聲的圖像開始,然后通過多個步驟逐漸去除噪聲以重建原始圖像。在這個過程中,U-Net 被用來預測每一步的降噪操作。

在前幾輪迭代中,圖像中的噪聲較大,因此需要較大的降噪幅度來消除這些噪聲。隨著迭代次數的增加,圖像中的噪聲逐漸減小,因此降噪幅度也應相應減小。這樣做的目的是避免過度平滑或損壞已經恢復的圖像細節。

通過逐漸減小降噪幅度,U-Net 可以更好地控制去噪過程,使其在保留圖像細節的同時有效地去除噪聲。這有助于生成更清晰、更真實的圖像。

這里舉一個文生圖的代碼,用于說明noise schedule技術:

def txt2img():#unetunet = load_unet()#調度器scheduler = lms_scheduler()scheduler.set_timesteps(100)#文本編碼prompts = ["a photograph of an astronaut riding a horse"]text_embeddings = prompts_embedding(prompts)text_embeddings = text_embeddings.cuda() #(1, 77, 768)uncond_prompts = [""]uncond_embeddings = prompts_embedding(uncond_prompts)uncond_embeddings = uncond_embeddings.cuda() #(1, 77, 768)#初始隱變量latents = torch.randn( (1, 4, 64, 64)) #(1, 4, 64, 64)latents = latents * scheduler.sigmas[0] #sigmas[0]=157.40723latents = latents.cuda()#循環步驟for i, t in enumerate(scheduler.timesteps): #timesteps=[999. 988.90909091 978.81818182 ...100個latent_model_input = latents #(1, 4, 64, 64) sigma = scheduler.sigmas[i]latent_model_input = latent_model_input / ((sigma**2 + 1) ** 0.5)timestamp = torch.tensor([t]).cuda()with torch.no_grad(): noise_pred_text = unet(latent_model_input, timestamp, text_embeddings)noise_pred_uncond = unet(latent_model_input, timestamp, uncond_embeddings)guidance_scale = 7.5 noise_pred = noise_pred_uncond + guidance_scale * (noise_pred_text - noise_pred_uncond)latents = scheduler.step(noise_pred, i, latents)vae = load_vae()latents = 1 / 0.18215 * latentsimage = vae.decode(latents.cpu()) #(1, 3, 512, 512)save_image(image,"txt2img.png")txt2img()

八、Stable Diffusion 文生圖底層運行演示

在文本生成圖的場景下,我們給SD模型輸入一組文本提示詞,它可以返回一張圖片。

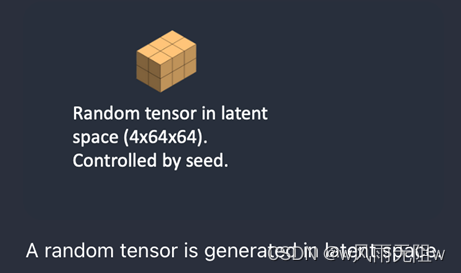

第一步、 Stable Diffusion在潛空間里生成一個隨機張量。

我們通過設置隨機種子seed來控制這個張量的生成。如果我們設置這個隨機種子為一個特定的值,則會得到相同的隨機張量。這就是我們在潛空間里的圖片。但是當前還全是噪點。

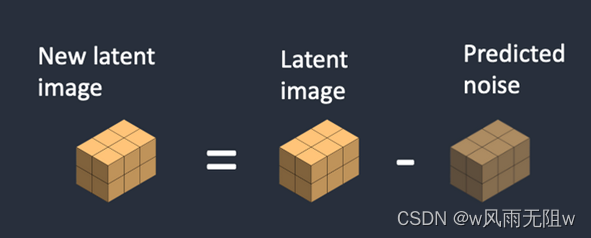

第二步、 Noise predictor U-Net將潛噪點圖已經文本提示詞作為輸入,并預測噪點

此噪點同樣也在潛空間內(一個4 x 64 x 64的張量)

第三步、從潛圖片中抽取潛噪點,并生成了新的潛圖片

第二步 與 第三步重復特定采樣次數,例如20次。

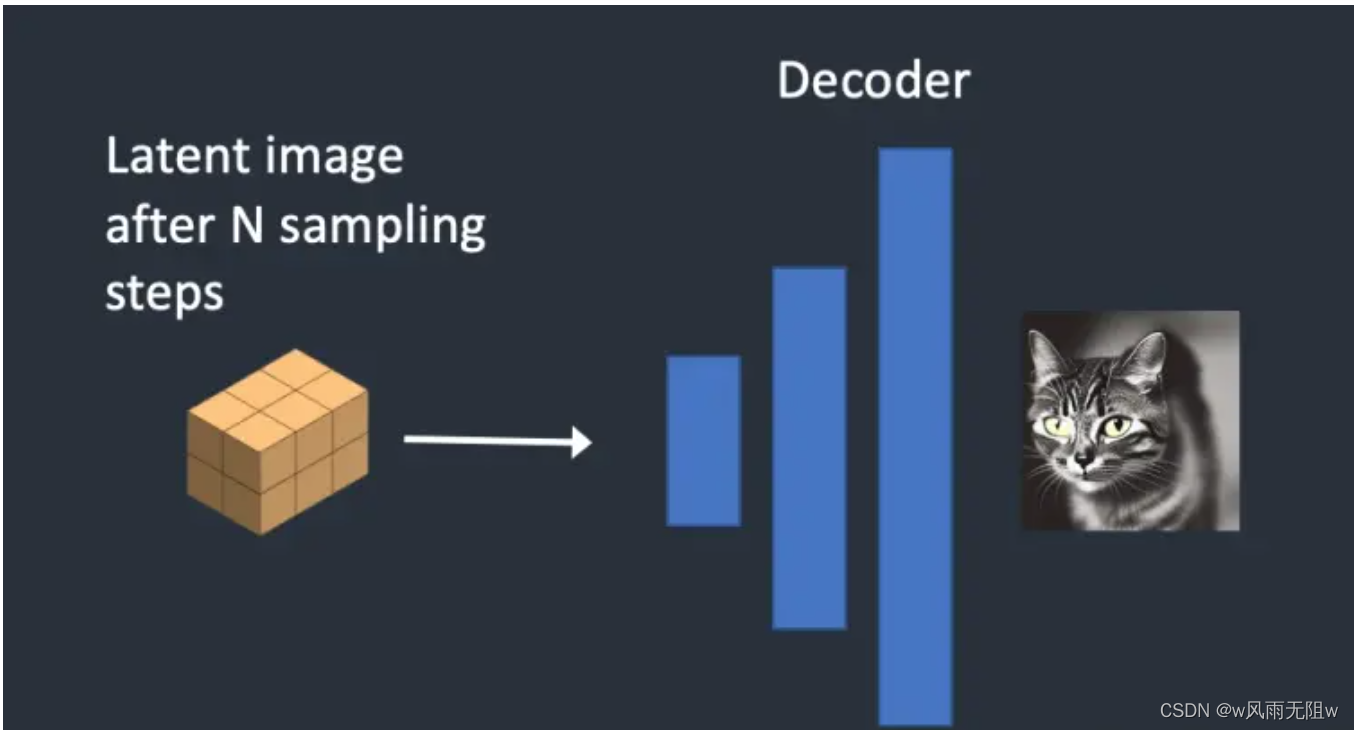

第四步、VAE 的decoder將潛圖片轉回像素空間

這便是我們通過SD模型最終得到的圖片。

參考資料:

1. How does Stable Diffusion work?

2. stable-diffusion

3.擴散模型詳解原理+代碼

—— 速算技巧 - 高照)

)

模式)

嵌套列表,Xpath路徑表達式,XML增刪查改,Implicit,Operator,Xml序列化,淺拷貝與深拷貝)

![[oneAPI] BERT](http://pic.xiahunao.cn/[oneAPI] BERT)

------ completeWork的工作流程【mount】)