該如何使用GPT助手--將GPT助手模型應用于問題

現在我要換個方向,讓我們看看如何最好地將 GPT 助手模型應用于您的問題。

現在我想在一個具體示例的場景里展示。讓我們在這里使用一個具體示例。

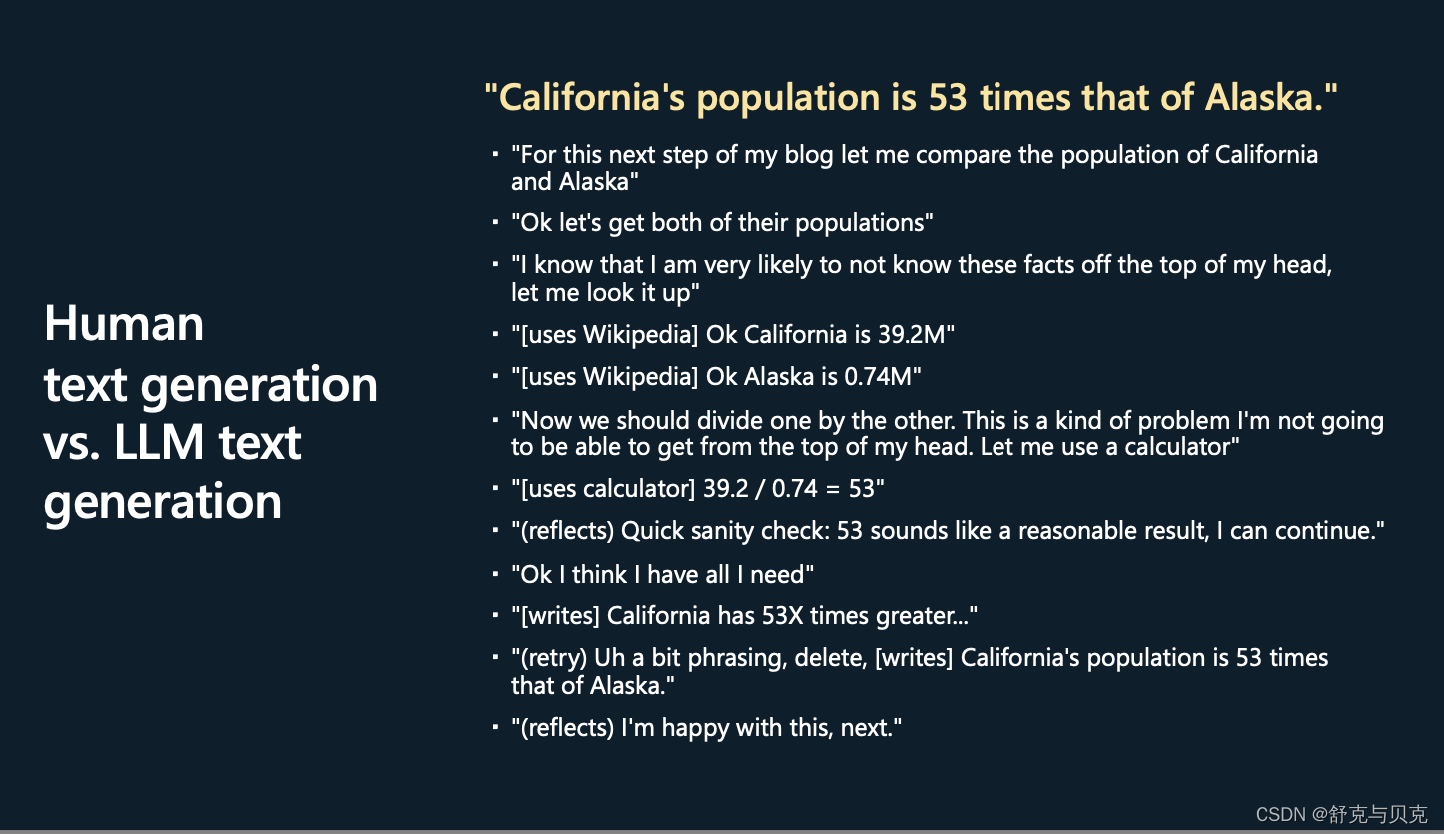

假設你正在寫一篇文章或一篇博客文章,你打算在最后寫這句話。

加州的人口是阿拉斯加的 53 倍。因此出于某種原因,您想比較這兩個州的人口。

想想我們自己豐富的內心獨白和工具的使用,以及在你的大腦中實際進行了多少計算工作來生成這最后一句話。

這可能是你大腦中的樣子:

好的。對于下一步,讓我寫博客——在我的博客中,讓我比較這兩個人群。

好的。首先,我顯然需要得到這兩個人群。

現在我知道我可能根本不了解這些人群。

我有點,比如,意識到我知道或不知道我的自我知識;正確的?

我去了——我做了一些工具的使用,然后我去了維基百科,我查找了加利福尼亞的人口和阿拉斯加的人口。

現在我知道我應該把兩者分開。

同樣,我知道用 39.2 除以 0.74 不太可能成功。

那不是我腦子里能做的事情。

因此,我將依靠計算器。

我打算用一個計算器,把它打進去,看看輸出大約是 53。

然后也許我會在我的大腦中做一些反思和理智檢查。

那么53有意義嗎?

好吧,這是相當大的一部分,但是加利福尼亞是人口最多的州,也許這看起來還可以。

這樣我就有了我可能需要的所有信息,現在我開始寫作的創造性部分了。

我可能會開始寫類似,加利福尼亞有 53 倍之類的東西,然后我對自己說,這實際上是非常尷尬的措辭,讓我刪除它,然后再試一次。

在我寫作的時候,我有一個獨立的過程,幾乎是在檢查我正在寫的東西,并判斷它是否好看。

然后也許我刪除了,也許我重新構造了它,然后也許我對結果感到滿意。

基本上,長話短說,當你創造這樣的句子時,你的內心獨白會發生很多事情。

這里Andrej從一個具體的例子開始講起,首先假設我們需要寫一篇博客,在博客的最后希望寫一句話“加州的人口是阿拉斯加的53倍”,為了能夠給出這個結論,我們的大腦中需要進行很多前置工作,如下圖所示,先想一下我得知道他們各自的人口是多少,但是這不在我的腦海中,因此我需要去檢索。然后通過wiki我知道了加州有39.2M的人,阿拉斯加有0.74M的人,然后我需要計算一下兩者的除法,但我沒法心算,所以我用計算器算了一下,得到39.2/0.74=53. 快速的在腦海中確認一下,這個數值是否合理,加州人確實比阿拉斯加多很多,感覺應該合理,于是我確信加州的人是阿拉斯加的53倍,并寫到我的博客中,在寫的過程中可能還會覺得辭藻不夠美妙,反復修改一下。 所以為了達成這個目標,我的腦海中需要經過很多很多的事項才可以。

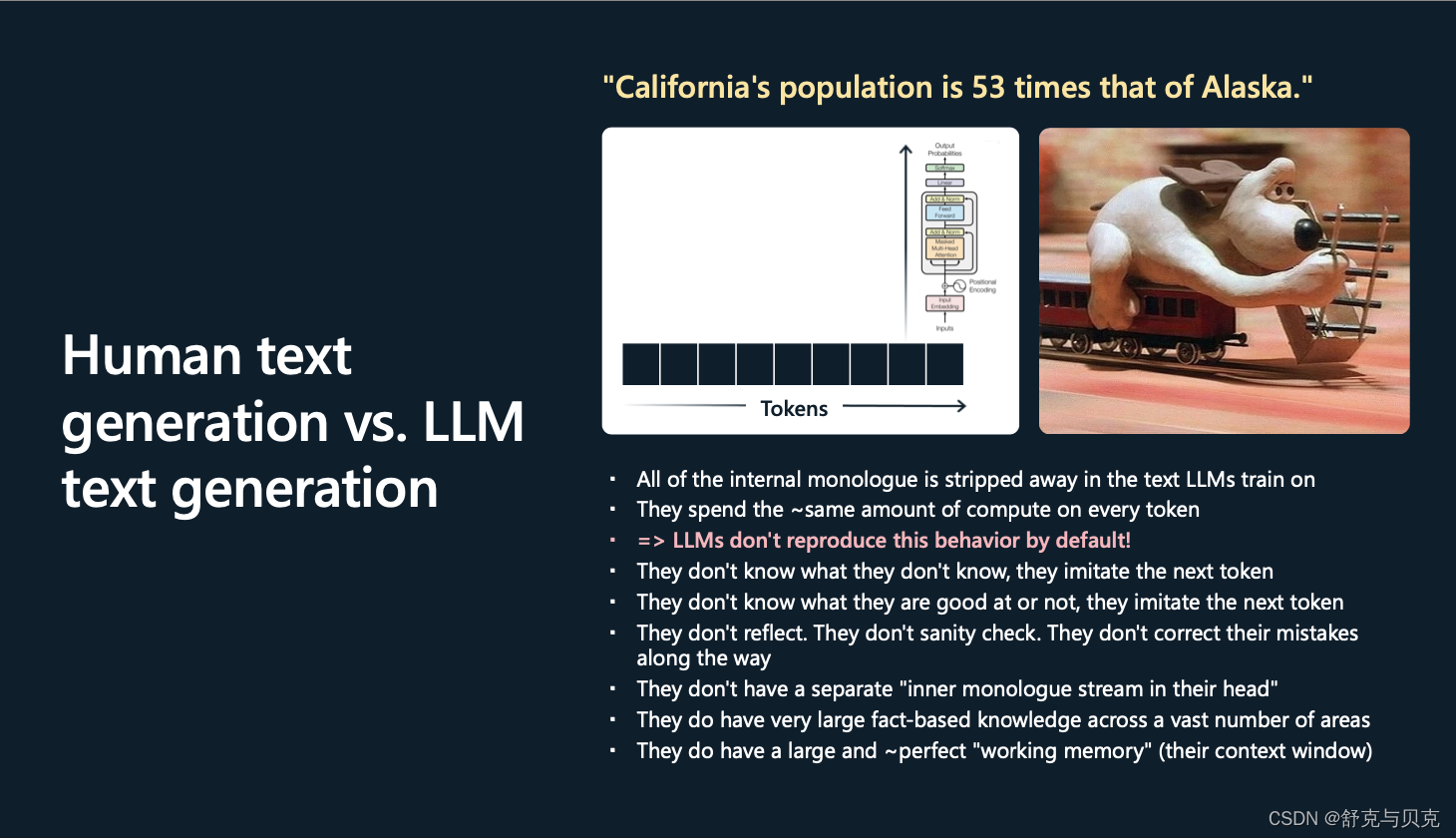

但是,當我們在其上訓練 GPT 時,這樣的句子是什么樣的?

從 GPT 的角度來看,這只是一個標記序列。因此,當 GPT 讀取或生成這些標記時,它只會進行分塊、分塊、分塊,每個塊對每個標記的計算工作量大致相同。

這些 Transformer 都不是很淺的網絡,它們有大約 80 層的推理,但 80 仍然不算太多。

這個Transformer將盡最大努力模仿...但是,當然,這里的過程看起來與你采用的過程非常非常不同。

特別是,在我們最終的人工制品中,在創建并最終提供給 LLM 的數據集中,所有內部對話都被完全剝離(只給出最后結果作為訓練數據)。

并且與您不同的是,GPT 將查看每個標記并花費相同的算力去計算它們中的每一個,實際上,你不能指望它對每個標記做太多的工作。

基本上,這些Transformer就像標記模擬器。它們不知道自己不知道什么,它們只是模仿(預測)下一個標記;它們不知道自己擅長什么,不擅長什么,只是盡力模仿(預測)下一個標記。

它們不反映在循環中,它們不檢查任何東西,它們在默認情況下不糾正它們的錯誤,它們只是對標記序列進行采樣。

它們的頭腦中沒有單獨的內心獨白流,它們正在評估正在發生的事情。

現在它們確實有某種認知優勢,我想說,那就是它們實際上擁有大量基于事實的知識,涵蓋大量領域,因為它們有幾百億個參數,這是大量存儲和大量事實。

而且我認為,它們也有相對大而完美的工作記憶。

因此,任何適合上下文窗口的內容都可以通過其內部自注意機制立即供Transformer使用,它有點像完美的記憶。它的大小是有限的,但Transformer可以非常直接地訪問它,它可以無損地記住其上下文窗口內的任何內容。

這就是我比較這兩者的方式。

我之提出所有這些,是因為我認為在很大程度上,提示只是彌補了這兩種架構之間的這種認知差異。就像我們人類大腦和 LLM 大腦(的比較),你可以這么看。

這樣的一個過程其實就是一連串的token序列。在GPT處理時,他只會一塊一塊又一塊的逐個去處理這些token,花差不多的時間去計算下一個詞是什么,他并不像我們人類一下具有豐富的心理活動。他不知道他知道什么,他只是去模擬下一個詞。他不知道什么好什么壞,他只是去模擬下一個詞。他不會反思,不會檢查,不會修正自己的問題。他的優勢在于具備大量的基礎知識,涵蓋了大量的領域,保存在他的幾百億的參數中,并且對于他們的context windows可以完美處理。

人們發現有一件事,在實踐中效果很好。

特別是如果您的任務需要推理,您不能指望Transformer對每個標記進行太多推理,因此

fēnix 7X 增加小睡檢測功能)

)

)

相關類總結)