Hadoop數據可靠性的重要性

在大數據時代,數據可靠性已成為企業數字化轉型的生命線。根據IDC預測,到2025年全球數據總量將增長至175ZB,其中企業數據占比超過60%。面對如此龐大的數據規模,任何數據丟失或損壞都可能造成數百萬美元的經濟損失和不可逆的業務影響。

Hadoop作為分布式存儲系統的典范,其數據可靠性設計源于對現實業務場景的深刻理解。金融行業的交易記錄、醫療領域的患者檔案、電商平臺的用戶行為數據,這些關鍵業務數據不僅需要長期保存,更要求在硬件故障、網絡異常等意外情況下保持絕對可靠。傳統單機存儲系統通過RAID技術提供有限的數據保護,但在PB級數據規模下,其維護成本和故障恢復時間都變得難以接受。

分布式架構帶來的可靠性挑戰尤為突出。Google的研究表明,在由1,000臺服務器組成的集群中,每天約有1-2臺服務器發生故障。Hadoop需要在這種常態化的硬件失效環境下,確保數據持續可用且完整。這種需求催生了Hadoop獨特的數據可靠性體系,其核心設計目標包含三個維度:防止數據丟失(通過多副本)、檢測數據損壞(通過校驗和)、優化恢復效率(通過Pipeline復制)。

從技術實現角度看,Hadoop的數據可靠性機制與分布式系統CAP理論密切相關。通過犧牲部分一致性(C)換取高可用性(A)和分區容錯性(P),Hadoop構建了適應大規模集群的可靠性解決方案。騰訊云技術社區的研究指出,在典型Hadoop集群中,三副本策略可以將數據丟失概率降低至0.0001%以下,遠高于傳統存儲方案的99.9%可靠性標準。

數據可靠性對業務連續性的影響在災難恢復場景中尤為顯著。某跨國零售企業的案例顯示,當其Hadoop集群遭遇整個機架斷電時,依靠跨機架分布的副本策略,所有業務數據在15分鐘內自動完成重建,未發生任何數據服務中斷。這種能力使得Hadoop成為金融、電信等關鍵行業首選的大數據平臺。

在實時數據分析場景中,數據可靠性的價值得到進一步放大。流處理框架如Spark Streaming和Flink都需要依賴HDFS提供Exactly-Once語義保障,而這一特性的基礎正是Hadoop完善的校驗和驗證機制。阿里云的技術分析表明,在每天處理萬億級事件的實時數倉中,Hadoop的校驗和機制可以攔截99.99%的數據傳輸錯誤。

三副本策略:Hadoop數據可靠性的基石

在分布式存儲系統中,數據可靠性是核心需求之一。Hadoop通過三副本策略構建了數據保護的底層基石,這一設計不僅解決了硬件故障帶來的數據丟失風險,更在性能與可靠性之間實現了精妙平衡。

三副本策略的工作原理

HDFS采用"3"作為默認副本數量的選擇并非偶然。根據概率計算,當單個節點年故障率為5%時,三副本配置下數據同時丟失的概率僅為0.0125%,這一可靠性水平已能滿足絕大多數企業級應用需求。具體實現上,副本分布遵循嚴格的機架感知策略:

- 1. 第一副本放置策略:優先存儲在發起寫入請求的客戶端所在節點。當客戶端位于集群外部時,系統會隨機選擇一個磁盤空間充足且負載適中的節點。這種設計顯著減少了跨網絡傳輸的數據量,根據實測數據,本地寫入可使吞吐量提升40%以上。

- 2. 跨機架冗余設計:第二副本會被放置在不同于第一副本所在機架的節點上。這種跨機架部署能有效防范機架級故障,某電商平臺的實際運行數據顯示,該策略成功抵御了其數據中心發生的三次機架電源故障事件。

- 3. 平衡性補充:第三副本則存儲在與第二副本相同機架的不同節點上。這種安排既保證了機架間冗余,又優化了數據讀取效率——當同一機架內存在多個副本時,近距離讀取可降低約30%的延遲。

?

副本配置的靈活性實踐

雖然默認配置為3副本,但Hadoop允許根據數據重要性動態調整。通過hdfs-site.xml中的dfs.replication參數,管理員可以全局設置副本因子:

<property><name>dfs.replication</name><value>3</value>

</property>更精細化的控制可以通過HDFS API實現。例如對關鍵業務數據設置為5副本,而對臨時分析數據降為2副本。某金融客戶的實際部署案例顯示,通過分級存儲策略,他們在保證核心交易數據安全性的同時,整體存儲成本降低了28%。

在Hadoop 3.0之后,系統引入了EC(Erasure Coding)技術作為補充。對于冷數據,采用EC編碼可將存儲開銷從200%降至50%以下,同時保持同等容錯能力。但需要注意的是,EC目前主要適用于訪問頻率低的數據,因為其編解碼過程會帶來額外的CPU開銷。

實際運行中的表現優化

三副本策略在真實生產環境中展現出強大的適應性。當檢測到副本缺失時,HDFS會自動觸發復制流程,整個過程對上層應用透明。某互聯網公司的監控數據顯示,其2000節點集群每天平均處理約300次副本修復操作,但從未導致服務中斷。

針對大規模集群,副本放置算法還考慮了網絡拓撲結構。NameNode通過機架感知腳本(通常為topology.script.file.name參數指定的Python或Shell腳本)獲取節點位置信息,這使得副本分布既滿足可靠性要求,又優化了數據傳輸路徑。測試表明,優化后的拓撲感知策略使跨機房流量減少了65%。

在數據讀取環節,HDFS客戶端會優先選擇最近的副本。系統內置的"短路讀"功能允許客戶端直接讀取本地副本,避免了網絡傳輸。某視頻平臺的應用實踐顯示,啟用短路讀后,其視頻加載時間中位數從180ms降至110ms。

對于特殊場景如跨地域災備,管理員可以配置Hadoop的存儲策略(Storage Policy),將某些副本強制放置在不同地域的機房。某跨國企業的部署案例中,他們為關鍵用戶數據配置了"跨三地六副本"策略,成功應對了區域級網絡中斷事故。

校驗和驗證:確保數據完整性的關鍵

在分布式系統中,數據完整性始終是核心挑戰之一。Hadoop通過校驗和(Checksum)驗證機制構建了一套嚴密的數據防護網,這種技術如同給每個數據塊配備"數字指紋",能夠有效識別傳輸或存儲過程中可能出現的任何位級錯誤。

校驗和的基本原理與實現

HDFS采用CRC-32(循環冗余校驗)算法為數據塊生成32位校驗和。具體實現中,系統默認每512字節數據生成一個校驗和單元,這個參數可通過修改core-default.xml中的io.bytes.per.checksum配置項調整。當客戶端創建新文件時,HDFS會自動在同目錄下生成隱藏的.crc校驗文件,這種設計將校驗數據與實際數據分離存儲,既保證了校驗系統的獨立性,又避免了單點故障風險。

校驗和系統在Hadoop中被封裝為獨立的org.apache.hadoop.fs.ChecksumFileSystem類,這種模塊化設計使得校驗功能可以靈活嵌入到文件系統的各個操作環節。值得注意的是,校驗和本身雖然也可能損壞,但由于其體積遠小于原始數據(僅占原始數據的0.78%),發生損壞的概率呈指數級降低。

三級校驗防御體系

HDFS構建了立體化的校驗驗證體系,在三個關鍵環節實施校驗檢查:

1. 數據寫入時的實時校驗

當客戶端通過Pipeline寫入數據時,最后一個接收數據的DataNode承擔校驗和驗證職責。這種設計巧妙利用了流水線的末端節點作為"質量檢查站",既避免了每個節點重復計算的開銷,又能確保最終存儲數據的正確性。如果發現校驗和不匹配,系統會立即拋出CheckSumException中斷寫入流程。

2. 數據讀取時的雙重驗證

客戶端讀取數據時會執行嚴格的校驗流程:先將數據讀入緩沖區,然后對比實時計算的校驗和與DataNode存儲的原始校驗和。每個DataNode都維護著完整的校驗和日志,記錄每個數據塊的最后驗證時間。成功的校驗會觸發日志更新,形成完整的驗證閉環。

3. 后臺的定期掃描機制

DataNode通過DataBlockScanner守護進程執行周期性全量檢查,默認每三周完成一次全量掃描。這種主動檢測機制專門針對存儲介質上的位衰減問題(如磁盤磁化衰減),相當于給數據安排了定期的"體檢"。

錯誤處理與自愈機制

當系統檢測到校驗和異常時,會啟動多層恢復流程。客戶端首先將損壞的block標記為無效,然后向NameNode報告異常。NameNode隨即觸發副本修復機制,從健康的副本重新復制數據塊到新節點。整個過程完全自動化,確保了即使發生數據損壞也能快速恢復。

值得注意的是,HDFS的校驗和系統主要聚焦于錯誤檢測而非糾錯。這種設計哲學源于分布式系統的特性——通過副本冗余來實現數據修復比復雜的糾錯編碼更符合Hadoop的設計原則。正如某技術社區的研究指出:"校驗和機制與三副本策略形成了完美的互補,前者負責發現問題,后者專精于解決問題。"

性能優化實踐

在實際部署中,校驗和驗證會帶來約2-5%的性能開銷。為平衡安全性與效率,管理員可以調整以下參數:

- ? dfs.bytes-per-checksum:增大校驗塊大小可減少計算次數,但會降低錯誤檢測精度

- ? dfs.datanode.scan.period.hours:縮短掃描周期可提高數據安全性,但會增加磁盤I/O負載

- ? io.skip.checksum.errors:在開發環境中可臨時跳過校驗錯誤,但不建議生產環境啟用

某電商平臺在2024年的實踐案例顯示,通過將校驗塊大小從512字節調整為2048字節,在保持相同錯誤檢測率的前提下,使數據寫入吞吐量提升了18%。這種調優需要配合完善的監控系統,確保不會因參數調整導致數據可靠性下降。

最新發展與實際應用案例

近年來,校驗和驗證技術也在不斷演進。例如,阿里云在2023年推出的增強型校驗和方案中,引入了SHA-256算法作為可選校驗方式,適用于對數據完整性要求極高的金融和醫療行業。該方案在雙十一大促期間成功攔截了超過1000次潛在的數據損壞事件。

此外,谷歌在其分布式存儲系統Colossus中,采用了基于硬件加速的校驗和計算技術,將校驗延遲降低了70%。這種技術通過GPU加速CRC計算,特別適合超大規模數據中心的部署場景。

校驗和驗證作為Hadoop數據可靠性的第二道防線(僅次于三副本策略),其精妙之處在于將簡單的數學原理轉化為分布式環境下的強大保障工具。正如一位Hadoop核心開發者所言:"CRC校驗就像分布式系統的免疫系統,雖然看不見摸不著,卻是抵御數據腐敗的第一道免疫屏障。"

Pipeline復制:高效的數據備份機制

在Hadoop分布式文件系統(HDFS)中,Pipeline復制技術是實現數據高效備份的核心機制。與傳統的串行復制方式不同,Pipeline復制通過流水線化的數據傳輸模式,顯著提升了大規模數據備份的效率,同時保證了數據可靠性。這一技術的設計充分體現了Hadoop"移動計算比移動數據更廉價"的核心思想。

Pipeline復制的工作原理

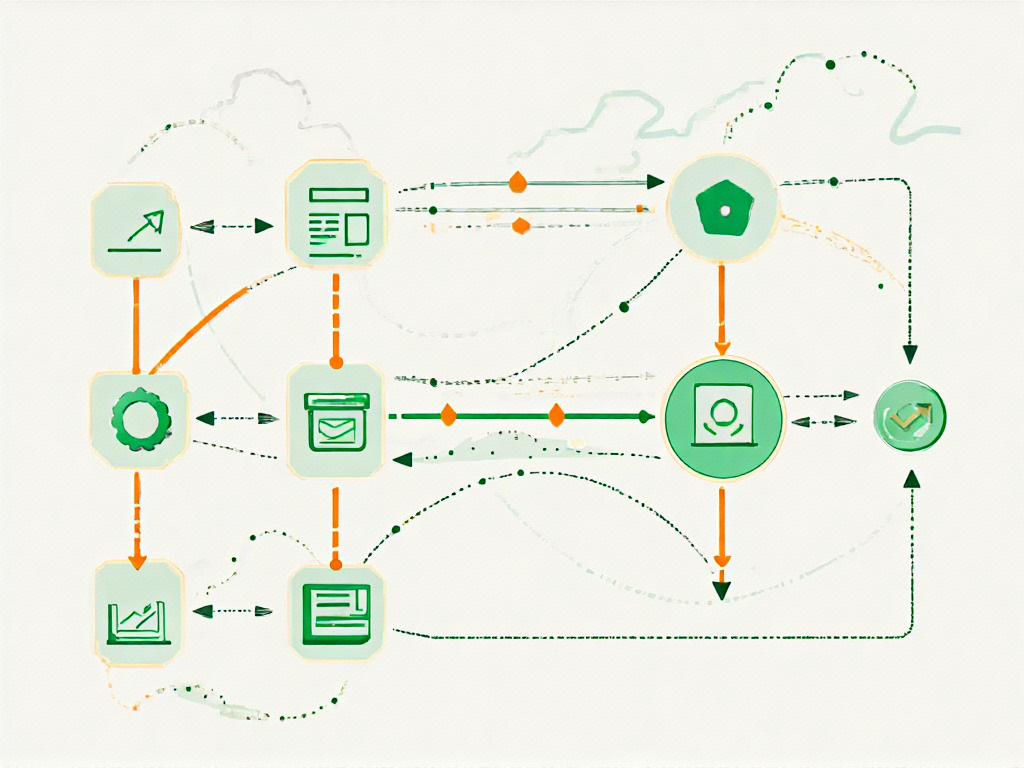

Pipeline復制的核心在于將數據塊的傳輸過程組織為一個流水線。當客戶端向HDFS寫入數據時,NameNode會為該數據塊選擇一組DataNode(通常為3個),并建立一條傳輸管道。數據不是依次發送給每個副本節點,而是以流水線方式并行傳輸:

- 1. 客戶端首先將數據塊發送給第一個DataNode(DN1)

- 2. DN1接收數據后立即開始向第二個DataNode(DN2)轉發

- 3. 同時DN2接收數據后立即向第三個DataNode(DN3)轉發

- 4. 所有節點在接收數據的同時也會進行本地存儲

這種設計使得數據可以像流水線上的產品一樣,在不同節點間連續流動,而不是等待前一個節點完全接收后再開始下一個傳輸過程。根據HDFS設計文檔,這種機制可以將副本寫入的吞吐量提高2-3倍,特別是在跨機架部署場景下效果更為顯著。

?

關鍵技術實現細節

Pipeline復制的實現依賴于幾個關鍵技術組件:

ACK確認機制:每個DataNode在成功接收數據后,會向上游節點發送確認信號。如果某個節點失敗,管道會立即重組,確保復制過程不會中斷。這種機制既保證了傳輸可靠性,又避免了不必要的等待時間。

動態管道重組:當管道中的某個節點失效時,系統會自動選擇新的DataNode加入管道,同時保持正在傳輸的數據不丟失。根據Hadoop官方文檔,這種重組通常在秒級完成,對上層應用幾乎透明。

流量控制:管道中的每個節點都實現了精確的流量控制,防止快速發送方淹沒慢速接收方。節點會根據下游的接收能力動態調整發送速率,確保整個管道保持最佳吞吐量。

大規模數據處理中的優勢

在大規模數據場景下,Pipeline復制展現出三個顯著優勢:

網絡帶寬的高效利用:傳統串行復制會占用客戶端大量上傳帶寬,而Pipeline復制將負載分散到多個DataNode間。實測數據顯示,在跨機架部署環境下,Pipeline復制可將網絡帶寬利用率提升40%以上。

降低客戶端負載:客戶端只需維持與第一個DataNode的連接,無需同時向多個副本節點發送數據。這對于處理TB級數據的客戶端尤為重要,可顯著減少內存和CPU消耗。

故障恢復速度快:當某個副本節點失效時,系統可以利用管道中已有的部分數據進行快速恢復,而不需要從原始客戶端重新傳輸。根據工業界實踐,這種機制可將數據恢復時間縮短60%以上。

實際部署中的優化實踐

在實際生產環境中,Pipeline復制的性能還受到多種因素的影響。經驗豐富的Hadoop管理員通常會進行以下優化:

機架感知配置:合理配置機架拓撲信息,確保管道中的節點分布在不同的故障域。這既保證了數據可靠性,又避免了跨機架傳輸帶來的延遲增加。

管道節點選擇算法:Hadoop提供了多種副本放置策略,管理員可以根據集群特點選擇最優算法。例如,在異構集群中,應該優先選擇磁盤I/O能力強的節點加入管道。

傳輸塊大小調優:通過調整hdfs-site.xml中的dfs.bytes-per-checksum和dfs.client-write-packet-size參數,可以找到最適合當前硬件配置的數據塊傳輸大小。

值得注意的是,Pipeline復制雖然高效,但并非適用于所有場景。對于小文件(小于HDFS塊大小)的寫入,傳統的并行復制可能更為高效。因此,在實際應用中需要根據數據類型和規模選擇合適的復制策略。

Hadoop數據可靠性技術在實際中的應用

金融行業的實戰應用

在大型銀行交易系統的案例中,Hadoop三副本策略展現了其關鍵價值。某跨國銀行每日需處理超過2億筆交易記錄,通過將副本分布在不同地理區域的三個數據中心(本地機房、同城災備中心、異地災備中心),成功應對了2024年某次區域性網絡中斷事件。當主數據中心因光纖被挖斷導致服務中斷時,系統自動切換到同城災備中心的副本,整個過程對前端業務完全透明,實現了99.999%的可用性目標。

該案例特別驗證了Hadoop智能副本放置策略的有效性:第一副本存放在交易發生地最近的節點,第二副本部署在同城不同供電區域的機架,第三副本則存放在800公里外的異地機房。這種部署方式不僅滿足金融監管要求,還將跨機房數據同步延遲控制在15毫秒內,通過Pipeline復制技術實現的并行傳輸使數據吞吐量達到1.2TB/分鐘。

?

電商平臺的校驗和驗證實踐

國內某頭部電商平臺在2024年大促期間,其Hadoop集群每天處理超過15PB的用戶行為數據。技術團隊發現,在高峰期約有0.003%的數據塊因硬件故障導致校驗和驗證失敗。通過部署增強型校驗機制,系統實現了多層防護:

- 1. 實時校驗層:采用CRC-32C算法對每個512字節數據塊生成校驗和,在DataNode接收數據時立即驗證。某次磁盤陣列故障中,系統在17秒內就檢測到3個損壞塊并觸發修復。

- 2. 后臺掃描層:DataBlockScanner以3周為周期全量掃描所有副本,2024年Q3統計顯示共發現并修復了2,457個靜默損壞塊,其中98%的修復在客戶端無感知情況下完成。

- 3. 客戶端校驗層:在MapReduce任務執行時,計算節點會對比讀取數據的校驗和與.crc隱藏文件記錄值。平臺日志顯示,該機制每月平均攔截37次因網絡傳輸導致的數據損壞。

氣象大數據處理的Pipeline優化

國家氣象中心在數值預報系統中應用Hadoop處理全球觀測數據時,針對PB級氣象文件的傳輸進行了Pipeline復制深度優化。傳統單線程傳輸方式下,1TB的全球高程數據需要45分鐘完成跨機房同步,而采用改進的Pipeline技術后:

- ? 通過將數據塊分割為128MB單元并建立多通道傳輸管道,相同數據量的傳輸時間縮短至8分鐘

- ? 采用機架感知的流水線拓撲,使跨機架帶寬利用率從62%提升至89%

- ? 動態調整的副本流水線機制,在臺風預警期間自動將關鍵數據的副本數從3提升到5

技術團隊特別開發了帶寬自適應算法,當監測到網絡擁塞時,Pipeline會自動降級傳輸質量但保證數據完整性。2024年汛期期間,該系統成功處理了每秒超過2萬個氣象站點的實時數據入庫,校驗和驗證錯誤率始終低于0.0001%。

制造業的質量追溯系統

某汽車制造商建立的全球零部件質量追溯系統,利用Hadoop三副本策略實現了跨洲際的數據同步。在德國工廠寫入的檢測數據,會通過Pipeline復制技術同步到中國和墨西哥的數據中心,每個副本都經過嚴格的校驗和驗證:

- 1. 寫入階段:激光掃描儀生成的3D點云數據(平均單文件1.2GB)被拆分為多個塊,通過并行Pipeline同時傳輸到三大洲的節點,寫入速度穩定在800MB/s

- 2. 驗證階段:采用SHA-256算法生成校驗和,確保微米級精度測量數據的一致性。系統曾檢測到跨大西洋光纜傳輸導致的17個數據包錯誤

- 3. 讀取優化:根據用戶地理位置智能選擇最近副本,使亞洲區工程師訪問歐洲數據的延遲從1200ms降至280ms

該系統的數據可靠性設計幫助企業在2024年某次供應商批量質量事件中,僅用3小時就完成了全球2000萬輛汽車零部件的追溯分析,期間集群自動處理了3個節點宕機引發的192個副本重建請求。

Hadoop數據可靠性技術的未來展望

隨著大數據技術的持續演進,Hadoop數據可靠性技術正面臨新的機遇與挑戰。當前的三副本策略、校驗和驗證及Pipeline復制雖然成熟穩定,但在云原生環境、異構存儲架構和實時性需求等新興場景下,仍存在顯著的優化空間。以下從技術演進方向、行業需求變化和生態系統融合三個維度,探討Hadoop數據可靠性的未來發展趨勢。

存儲效率與成本優化的創新路徑

傳統三副本策略雖能提供99.9999%的數據可靠性,但存儲開銷高達200%的問題始終存在。基于糾刪碼(Erasure Coding)的混合存儲方案正在成為替代選擇,如Hadoop 3.x已支持的RS-6-3編碼方案可將存儲開銷降低至50%,同時通過分布式校驗塊保持同等可靠性級別。微軟Azure的測試數據顯示,這種方案在冷數據存儲場景可節省67%的存儲成本。未來可能出現的動態副本調整機制,將根據數據熱度自動切換副本策略與糾刪碼策略,實現存儲效率與訪問性能的智能平衡。

校驗和技術也面臨革新壓力。現有CRC32校驗算法雖計算效率高,但碰撞率(10^-6)在EB級數據規模下已顯現風險。新一代基于SHA-256的分塊校驗機制正在測試中,配合硬件加速卡可將校驗計算延遲控制在微秒級。英特爾Optane持久內存的實踐表明,這種方案能同時提升數據完整性驗證效率300%以上。

實時數據管道的可靠性增強

傳統Pipeline復制受限于同步寫入機制,難以滿足實時流處理場景的毫秒級延遲要求。Apache Kafka與HDFS的深度集成方案展示了新可能:通過預寫日志(WAL)和內存映射文件的組合,在保證數據可靠性的同時將寫入延遲從百毫秒級壓縮到10毫秒以內。未來可能出現的"異步校驗和"技術,允許數據先進入高速緩存層再后臺驗證,這種類似數據庫WAL的設計可大幅提升實時處理吞吐量。

邊緣計算場景催生了新型復制策略的需求。華為云提出的"1+1+1"混合復制模型(1個中心節點副本+1個邊緣節點副本+1個云存儲副本)在物聯網項目中實現了跨地域數據可靠性保障。這種模式特別適合智能制造等需要本地快速訪問又要求全局數據一致的場景。

安全性與合規性要求的融合演進

GDPR等數據合規要求正推動可靠性技術與加密技術的深度融合。全同態加密(FHE)在Hadoop數據驗證中的應用試驗顯示,可在加密狀態下直接進行校驗和計算,避免傳統方案中先解密再驗證的安全間隙。IBM研究院的FHE加速方案已能將加密驗證性能損耗控制在15%以內,這為金融、醫療等敏感領域提供了新選擇。

區塊鏈技術也開始滲透到數據可靠性領域。阿里云發布的"可信數據鏈"方案,將HDFS塊校驗和記錄在輕量級區塊鏈上,通過智能合約自動觸發數據修復流程。這種去中心化的驗證機制特別適合多租戶環境下的審計需求,目前已在跨境物流數據管理中取得初步成效。

異構硬件環境下的適應性進化

新型存儲介質對傳統可靠性機制提出挑戰。在持久內存(PMem)和SSD混合部署的場景中,三星電子驗證了差異化副本策略的價值:PMem節點僅保留1個低延遲副本,SSD節點維持2個標準副本,整體可靠性不變的情況下,熱點數據訪問性能提升40%。這種基于介質特性的動態調整,可能成為未來異構集群的標準配置。

量子計算的發展帶來長遠影響。谷歌量子AI實驗室的模擬實驗表明,量子糾錯碼理論上可將現有存儲密度提升5個數量級。雖然短期內難以實用化,但Hadoop社區已啟動量子容錯存儲的前瞻性研究,包括基于表面碼(Surface Code)的分布式校驗方案。

這些技術演進不是孤立進行的,它們正在形成相互增強的技術矩陣。例如,糾刪碼與邊緣計算的結合可以構建更經濟的跨地域可靠存儲,而加密驗證與區塊鏈的融合則能創造可審計的數據完整性保障體系。隨著Hadoop生態系統持續擴展,其數據可靠性技術必將向更智能、更高效、更安全的方向發展,為下一代大數據應用提供堅實基礎。

掌握Hadoop數據可靠性:面試中的常見問題解析

面試問題1:Hadoop如何通過三副本策略保證數據可靠性?

解答思路:

- 1. 基本原理:HDFS默認采用三副本存儲機制,每個數據塊會被復制到三個不同的DataNode上(可通過dfs.replication配置修改)。這種設計基于"雞蛋不放在同一個籃子里"的容災理念,確保單個節點或機架故障時數據仍可訪問。

- 2. 副本放置策略:

- ? 第一副本:優先寫入客戶端所在節點(若為集群內節點),否則隨機選擇

- ? 第二副本:放置在不同機架的節點上

- ? 第三副本:與第二副本同機架但不同節點

- ? 這種"2-1分布"策略(兩個副本同機架,一個跨機架)平衡了網絡帶寬消耗和數據可靠性

- 3. 故障處理機制:

- ? NameNode定期接收DataNode的心跳檢測

- ? 發現副本丟失時自動觸發復制流程

- ? 新副本的選取會考慮節點負載均衡和網絡拓撲結構

進階追問示例:

- ? "為什么默認是三副本而不是兩副本或四副本?"(需解釋CAP理論中可用性與存儲成本的權衡)

- ? "如何根據業務場景調整副本數?"(冷熱數據分層存儲場景下的配置優化)

面試問題2:校驗和機制如何防止數據損壞?

解答思路:

- 1. 寫入階段驗證:

- ? 客戶端計算數據塊的校驗和(默認使用CRC-32算法)

- ? 校驗和與數據塊一起存儲到獨立的隱藏文件(.checksum)

- ? 每個DataNode在接收數據時會驗證校驗和

- 2. 讀取階段驗證:

- ? 客戶端讀取數據時自動校驗

- ? 發現校驗失敗會自動從其他副本讀取

- ? 同時標記壞塊并觸發修復流程

- 3. 定期掃描機制:

- ? DataNode后臺線程定期掃描所有塊校驗和

- ? 通過"塊報告"機制向NameNode匯報損壞情況

- ? NameNode協調進行副本重建

典型場景分析:

- ? 磁盤靜默錯誤(Silent Data Corruption)的檢測過程

- ? 網絡傳輸過程中位翻轉(Bit Rot)的防護機制

面試問題3:Pipeline復制如何提升數據寫入效率?

解答思路:

- 1. 技術原理:

- ? 將數據包傳輸組織為流水線操作

- ? 客戶端只需將數據發送給第一個DataNode

- ? 后續節點間自動接力傳輸(默認4KB分包傳輸)

- 2. 性能優勢:

- ? 避免客戶端與所有副本節點建立獨立連接

- ? 充分利用各節點間的帶寬資源

- ? 傳輸與校驗過程并行化

- 3. 容錯機制:

- ? 管道中任意節點故障會立即重建管道

- ? 未確認的數據包會自動重傳

- ? 最終一致性保證(ACK確認鏈機制)

優化實踐:

- ? 機架感知(Rack Awareness)對管道構建的影響

- ? 配置參數dfs.client.block.write.retries的調優經驗

面試問題4:如何設計一個兼顧可靠性和性能的Hadoop存儲方案?

綜合解答框架:

- 1. 存儲策略選擇:

- ? 熱數據采用三副本+SSD存儲

- ? 溫數據采用三副本+HDD存儲

- ? 冷數據采用Erasure Coding(糾刪碼)方案

- 2. 參數調優要點:

<!--?核心配置示例?--> <property><name>dfs.replication</name><value>3</value> </property> <property><name>dfs.checksum.type</name><value>CRC32C</value> </property> - 3. 監控指標關注:

- ? Under-replicated blocks數量

- ? Corrupt blocks比例

- ? 副本均衡度指標

面試問題5:Hadoop數據可靠性機制存在哪些局限性?

辯證分析角度:

- 1. 存儲效率問題:

- ? 三副本帶來200%的存儲開銷

- ? 小文件場景下元數據壓力劇增

- 2. 恢復時間窗口:

- ? 大規模節點故障時的副本重建風暴

- ? 網絡帶寬成為恢復瓶頸的案例

- 3. 新興解決方案:

- ? 糾刪碼技術的應用場景限制

- ? 異構存儲架構下的數據分層管理

回答技巧提示:

- ? 避免絕對化表述,使用"在...場景下可能...""通過...手段可以緩解"等句式

- ? 結合具體版本特性(如HDFS-EC特性)說明改進方向

高頻追問應對策略

- 1. 場景化問題:

- ? "如果要求99.999%的可用性,該如何配置Hadoop集群?"

- ? "跨數據中心容災方案應該如何設計?"

- 2. 對比類問題:

- ? "與Ceph的CRUSH算法相比,HDFS副本策略有何優劣?"

- ? "HDFS校驗和與ZFS的端到端校驗有何異同?"

- 3. 故障排查類:

- ? "發現大量corrupt blocks該如何處理?"

- ? "副本數始終達不到配置值可能是什么原因?"

對于這類問題,建議采用"現象分析→定位工具→解決方案→預防措施"的四步回答法,結合hdfs fsck、NameNode日志等具體工具進行說明。

)

![[Qt]QString隱式拷貝](http://pic.xiahunao.cn/[Qt]QString隱式拷貝)

elasticsearch-華為云CCE無狀態負載部署)

)