今天OpenAI發布了gpt-4o,我體驗之后,gpt-4o簡直逆天了。中文能力也挺別強。速度比現在的gpt4還要快。

早在 5 月 11 日,Sam 就在推文中表示:OpenAI 并沒有推出 GPT-5,或搜索引擎,但團隊一直在努力研發一些認為大家會喜歡的新東西(感覺就像是魔法一樣)!

添加圖片注釋,不超過 140 字(可選)

現在來看應該說的就是 GPT-4o 了,它在免費和付費賬戶中均可使用(應該是目前最強的免費模型了)。除此之外,ChatGPT 頁面也進行了許多細節方面的優化,并且推出了桌面應用,進一步提升用戶體驗。

一、什么是GPT-4o

GPT-4o(“o”代表“omni”)是 OpenAI 在實現更自然人機交互方面的重要進展(Hello GPT-4o[1])。它能夠接受文本、音頻和圖像的任意組合輸入,并生成相應的輸出,包括文本、音頻和圖像。該模型在音頻輸入的響應時間非常短,最短可達 232 毫秒,平均為 320 毫秒,接近人類對話的反應時間。在文本(英語)和代碼方面,GPT-4o 的表現與 GPT-4 Turbo 相當,但在處理非英語語言文本方面有顯著提升,同時在 API 中的速度更快且成本降低 50%。此外,GPT-4o 在視覺和音頻理解方面表現尤為出色。

在 GPT-4o 之前,使用語音模式與 ChatGPT 對話的平均延遲時間分別為 GPT-3.5 的 2.8 秒和 GPT-4 的 5.4 秒。實現這一功能的流水線涉及三個獨立模型(音頻 → 文本 → 音頻):一個用于將音頻轉錄為文本,GPT-3.5 或 GPT-4 處理文本并生成文本,然后第三個模型將文本轉換回音頻。這種方式導致 GPT-4 無法直接感知語調、多位說話者或背景噪音,也無法生成笑聲、歌唱或表達情感。

為了克服這些局限,OpenAI 訓練了一個新的端到端跨文本、視覺和音頻的單一模型(GPT-4o),這意味著所有輸入和輸出都由同一個神經網絡處理。由于這是 OpenAI 第一個結合所有這些模態的模型,因此其功能和局限性仍在探索中。

它將首先在 ChatGPT 和 API 中作為文本和視覺模型提供(ChatGPT 將繼續通過現有的語音模式功能支持語音)。具體來說,GPT-4o 將在 ChatGPT 免費版、Plus 版和團隊版(企業版即將推出)以及 Chat Completions API、Assistants API 和 Batch API 中提供。

二、GPT-4o vs GPT-4 Turbo 的區別

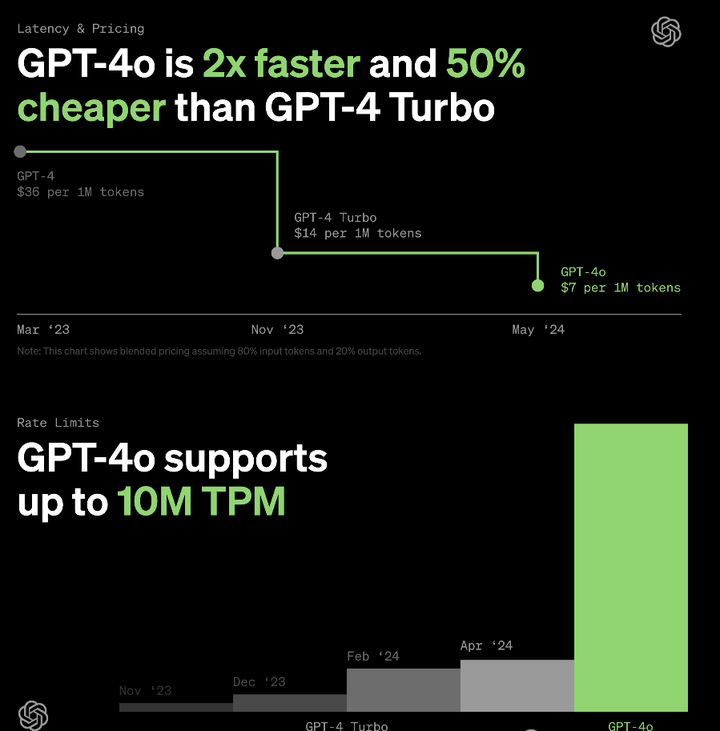

GPT-4o 擁有相同的高智能性,但比 GPT-4 Turbo 更快、更便宜,且速率限制更高。具體來說:

-

價格:GPT-4o 比 GPT-4 Turbo 便宜 50%,輸入每百萬 tokens 收費 $5,輸出每百萬 tokens 收費 $15。

-

速率限制:GPT-4o 的速率限制是 GPT-4 Turbo 的 5 倍——每分鐘最多 1000 萬 tokens。

-

速度:GPT-4o 是 GPT-4 Turbo 的兩倍快。

-

視覺:在視覺能力相關評估中,GPT-4o 的表現優于 GPT-4 Turbo。

-

多語言:GPT-4o 對非英語語言的支持優于 GPT-4 Turbo。

GPT-4o 目前有 128k 的上下文窗口,知識截止日期為 2023 年 10 月。

添加圖片注釋,不超過 140 字(可選)

(1)ChatGPT 免費版

免費版用戶將默認使用 GPT-4o,并限制使用 GPT-4o 發送消息的數量,這取決于當前的使用情況和需求。當不可用時,免費版用戶將自動切換回 GPT-3.5。還可以有限地使用高級工具發送消息,例如:

-

數據分析(Data analysis)

-

文件上傳(File Uploads)

-

聯網(Browse)

-

發現和使用 GPTs(Discovering and using GPTs)

-

視覺(Vision)

GPT-4o 具有先進的視覺能力,能夠更準確地理解你共享的圖像,免費版用戶隨時可以點擊 ChatGPT Plus 按鈕來升級。

如果無法升級,或者不知道怎么升級Plus的用戶,可以參考GPT4的升級方法:教程傳送大門

(2)LLM基準測試區別

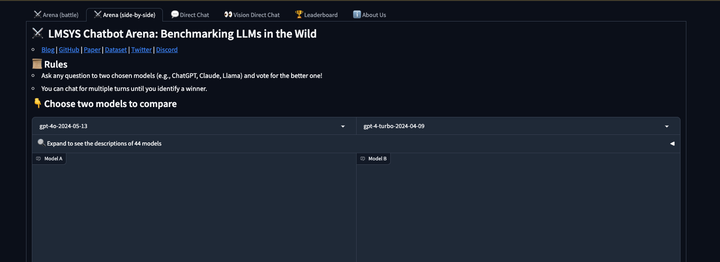

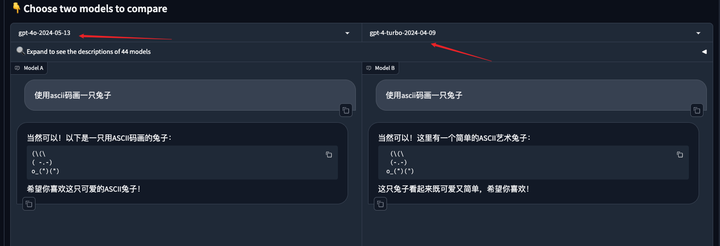

可以到競技場去測試GPT-4o 和 GPT-4 turbo兩者到區別。另外競技場是可以直接免費體驗GPT-4o的地方。但是有次數限制。

添加圖片注釋,不超過 140 字(可選)

添加圖片注釋,不超過 140 字(可選)

(3)通過申請Open API接口

通過Open API的接口,接入接口后,也可以快速的使用gpt-4o,前提你已經有了chatgpt賬號。

)

)

)

)

)

)