TCP:Textual-based Class-aware Prompt tuning for Visual-Language Model(CVPR2024)

- 基于文本的類感知提示調優的VLM

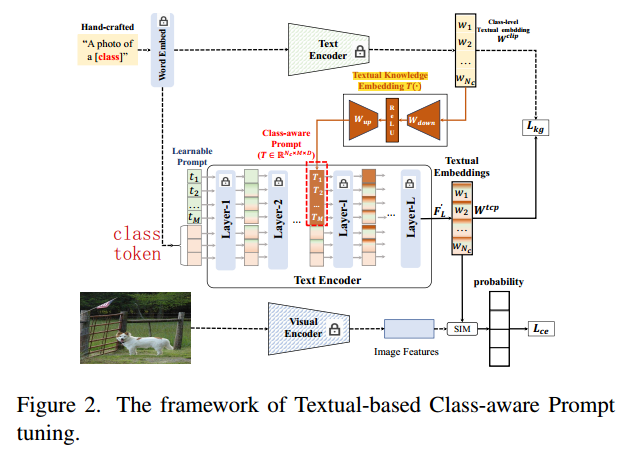

- KgCoOp為baseline,進行改進,把 w c l i p w_{clip} wclip?進行投影,然后與Learnable prompts進行結合。

![![[TCPf2.png|600]]](https://img-blog.csdnimg.cn/direct/95412ea63b444bbcbf67d99359080de1.png)

Abstract

近年來,通過可學習的域共享或圖像條件的文本tokens,促進生成適用于特定任務的分類器

問題:

這些textual tokens對unseen域具有有限的泛化能力,不能動態地適應測試類的分布

解決:

提出了新的基于文本的類感知提示調優(TCP,Textual-based Class-aware Prompt)。顯式地結合關于類的先驗知識,增強它們的可辨別性。利用文本知識嵌入(TKE),映射高泛化性的類級文本知識,到類感知文本tokens。通過無縫地將這些類感知提示集成到Text Encoder中,可以生成一個動態的類感知分類器,以增強對不可見域的可辨別性。

推斷階段,TKE動態地生成與unseen類相關的類感知提示,可作為即插即用的模型與現有方法輕松結合。

1 Introduction

圖像條件文tokens封裝了每個圖像的特定知識,特別是測試圖像,從而更容易泛化到unseen類。

3 方法

TKE將一般類級的textual embedding轉化成類感知提示,然后與Learnable tokens 結合。

3.2 基于文本的類感知提示提示調優

TKE:投影class-level embedding W c l i p W^{clip} Wclip,得到class-aware prompt T

![![[TCPg2.png]]](https://img-blog.csdnimg.cn/direct/be9a6277991e4a7fb35d0d140f2e23f4.png)

![![[TCPg3.png]]](https://img-blog.csdnimg.cn/direct/9c015ef9ea534fd88b87839cf3a86e34.png)

![![[TCPg4.png]]](https://img-blog.csdnimg.cn/direct/ee67f08c2da04d83a686f04203266f53.png)

![![[TCPg1.png]]](https://img-blog.csdnimg.cn/direct/1f73cfde22d047589f856babbef84460.png)

TKE包括兩層

- 下投影層

使用權重 W d o w n W_{down} Wdown?將 W c l i p W^{clip} Wclip其投成低維特征 - 上投影層

使用權重 W u p W_{up} Wup?將 W d w o n W^{dwon} Wdwon其投成高維特征

得到

![[TCPg5.png]]

再重塑成

![[TCPg6.png]]

插入到文本編碼器的中間層

4 實驗

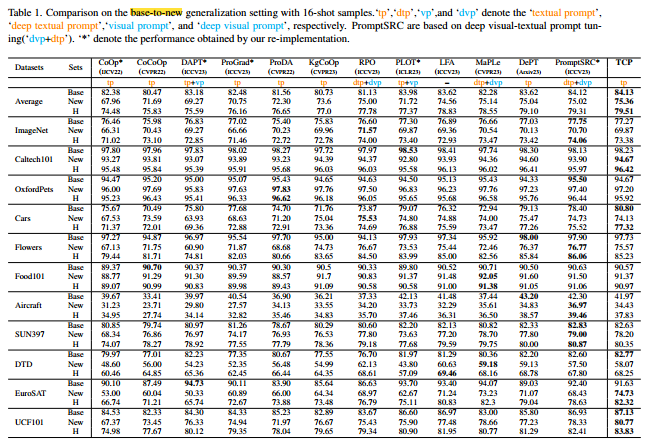

作者將其分為tp、vp、dtp、dvp,比較了近年來的方法

消融實驗

- Prompt長度:M=8最好

- 不同模板的效果:可學習prompt最好

- Dmid的作用:128時效果最好

- 類感知prompt拼接到哪:第8層最好

)

)

)