1.在terminal中檢查是否安裝brew命令?

brew --version

如果沒有安裝,在terminal中執行命令,安裝brew

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

安裝完成后,再重新打開teminal brew --version進行檢查

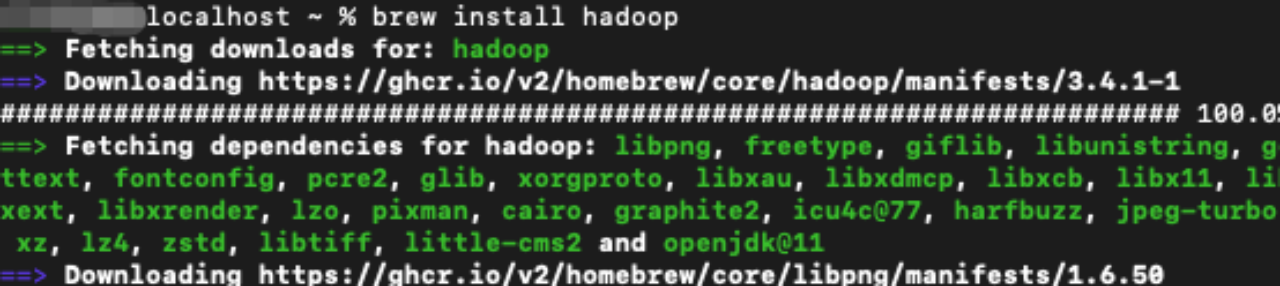

2.下載安裝hadoop

brew install hadoop

通過hadoop version 檢查是否安裝完成

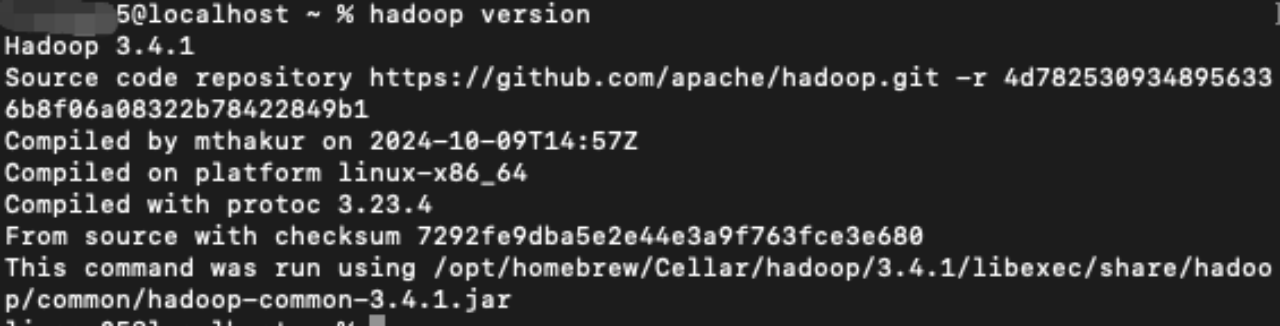

3.查看是否可以遠程登錄,在terminal中執行命令

ssh localhost?

如果顯示不允許登錄,在系統中設置允許遠程登錄,進行系統設置

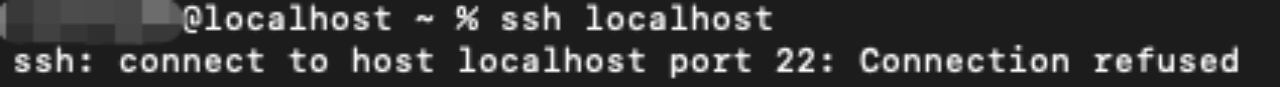

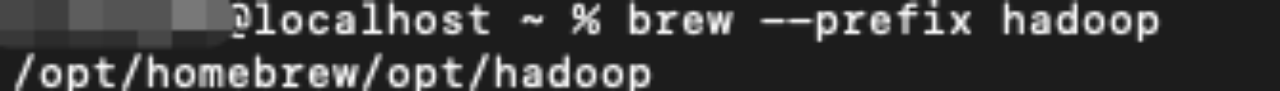

4.查看hadoop安裝目錄

brew --prefix hadoop

5.修改hadoop配置信息

cd /opt/homebrew/opt/hadoop/libexec/etc/hadoop

修改vi core-site.xml文件

<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:8082</value></property><property><name>hadoop.tmp.dir</name><value>file:/opt/homebrew/opt/hadoop/datatmp</value></property>

</configuration>修改hdfs-site.xml

<configuration><property><name>dfs.replication</name><value>1</value></property><!--不是root用戶也可以寫文件到hdfs--><property><name>dfs.permissions</name><value>false</value>? ? <!--關閉防火墻--></property><!--把路徑換成本地的name坐在位置--><property><name>dfs.namenode.name.dir</name> ?<value>file:/opt/homebrew/opt/hadoop/datatmp/dfs/name</value></property><!--在本地新建一個存放hadoop數據的文件夾,然后將路徑在這里配置一下--><property><name>dfs.datanode.data.dir</name><value>file:/opt/homebrew/opt/hadoop/datatmp/dfs/data</value></property>

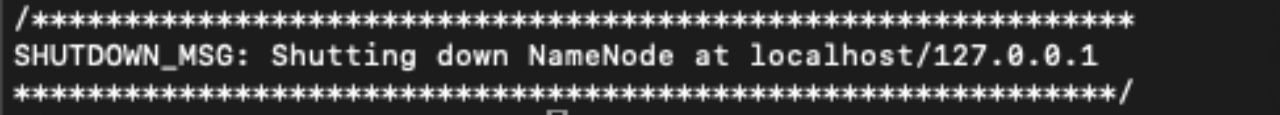

</configuration>格式化namenode

輸入hdfs namenode -format

修改yarn-site.xml

<property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property>

<property><name>yarn.resourcemanager.address</name><value>localhost:9000</value></property> 6.啟動hdfs

在/opt/homebrew/opt/hadoop/libexec/sbin目錄輸入

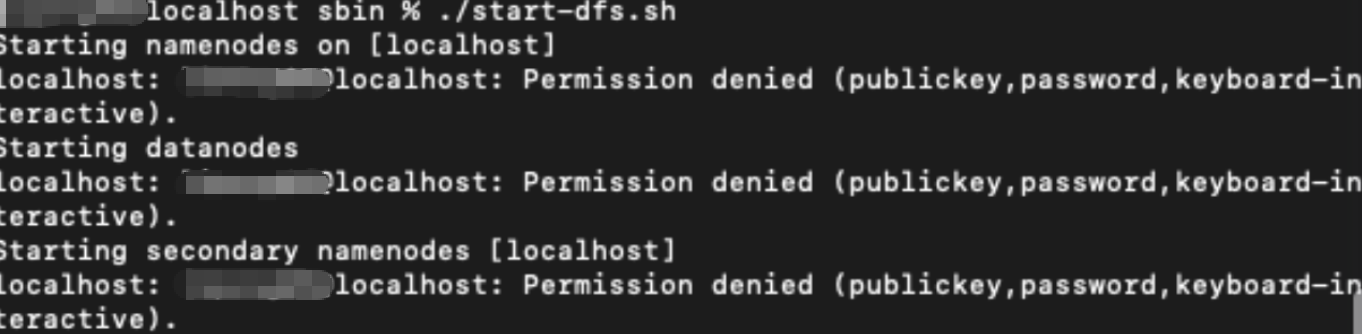

./start-dfs.sh?如報以下錯誤

執行命令

ssh-keygen -t rsa

cat ~/.ssh/id_rsa.pub >>~/.ssh/authorized_keys

chmod og-wx ~/.ssh/authorized_keys

重新啟動?

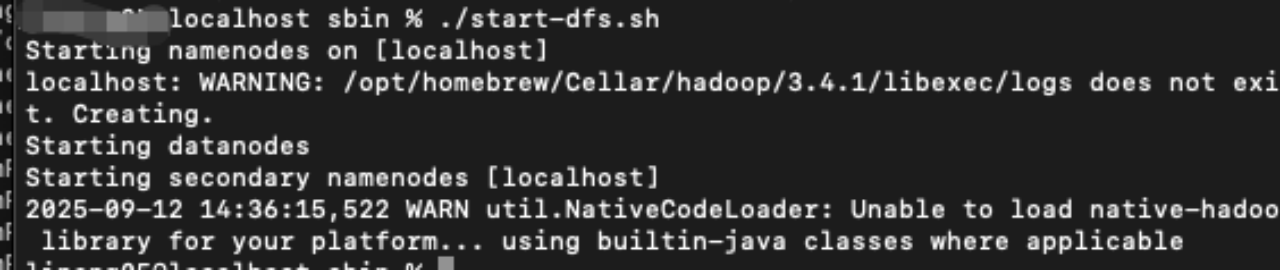

在sbin目錄下輸入./start-dfs.sh

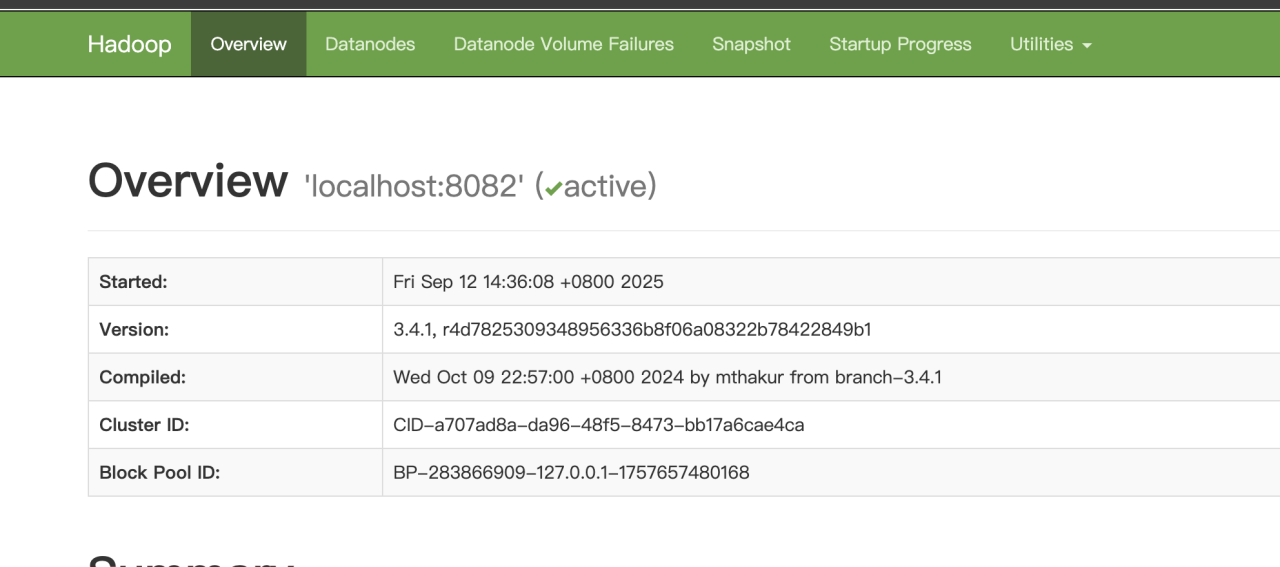

在瀏覽器中輸入http://localhost:9870/?如果出現以下界面說明安裝成功

使用 ./stop-dfs.sh?關閉服務

7.啟動yarn

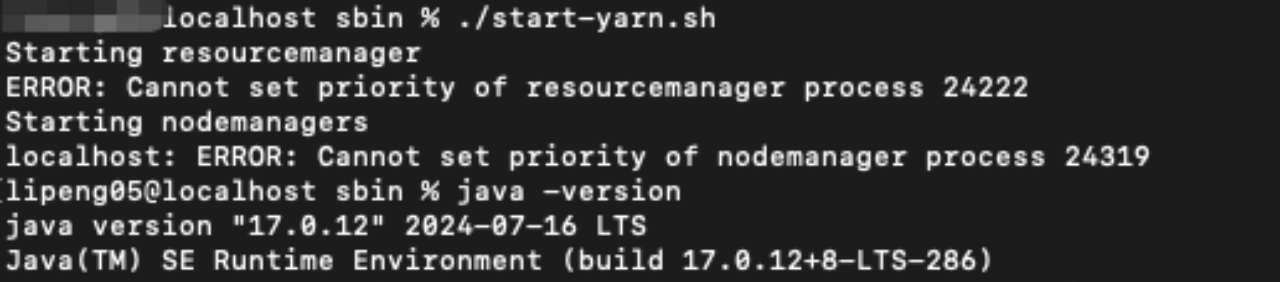

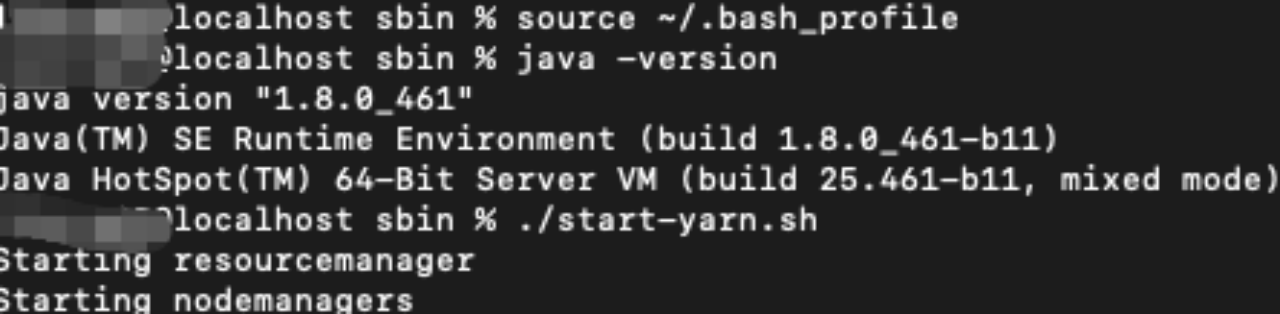

在sbin目錄下輸入./start-yarn.sh

如果啟動的過程中出現錯誤

原因是jdk版本過高,安裝jdk8.重新配置JAVA_HOME再啟動,jdk下載地址

https://www.oracle.com/java/technologies/downloads/#java8

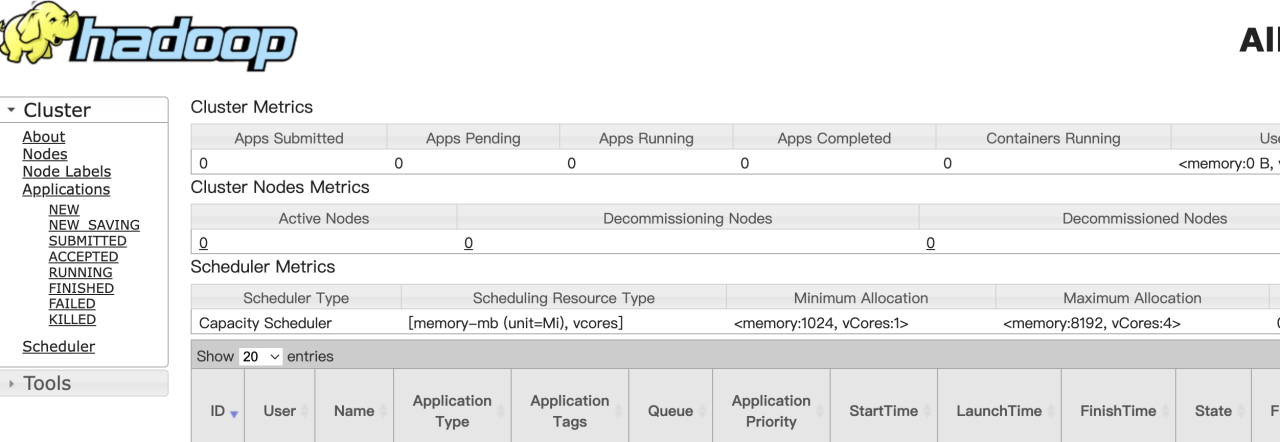

在瀏覽器輸入 http://localhost:8088/?出現下圖頁面成功

執行 ./stop-yarn.sh?關閉服務

參考:https://blog.csdn.net/zx1245773445/article/details/84875774

-Eclipse插件實現)

)

Linux Journalctl命令、Journalctl日志持久化存儲)

實戰二十二——指紋圖像中提取特征點,計算兩兩指紋之間的相似度)