在數字經濟加速滲透的今天,工業物聯網(IIoT)、智慧能源、金融交易、城市運維等領域每天產生海量 “帶時間戳” 的數據 —— 從工業設備的實時溫度、電壓,到電網的負荷波動,再到金融市場的每秒行情,這類 “時序數據” 正以指數級速度增長。據 IDC 預測,到 2025 年全球時序數據總量將突破 60ZB,占非結構化數據總量的 45%。而時序數據庫(Time Series Database, TSDB)作為專門存儲、管理和分析時序數據的工具,其選型是否合理,直接決定了企業能否從時序數據中挖掘價值、降低成本。

本文將從大數據視角出發,梳理時序數據庫的核心選型維度,通過與國外主流產品的對比解析 Apache IoTDB(以下簡稱 “IoTDB”)的差異化優勢,并結合詳細操作步驟與代碼,落地實戰場景,助力企業高效選型與實踐。

目錄

一、大數據時代,時序數據庫為何成為 “剛需”?

二、時序數據庫選型:6 個核心維度不能少

三、中外時序數據庫對比:IoTDB 的差異化優勢

四、深度解析 IoTDB:從核心特性到實操步驟

4.1 核心操作 1:數據建模(工業場景為例)

4.2 核心操作 2:分層存儲配置(自定義冷熱數據策略)

4.3 核心操作 3:高頻查詢與聚合分析(實時監控場景)

五、IoTDB 實戰場景:帶操作步驟的落地案例

5.1 工業物聯網:預測性維護(設備故障預警)

5.2 智慧能源:電網負荷調度(分時負荷分析)

5.3 金融行情:高頻 K 線計算(分鐘級行情分析)

六、時序數據庫選型終極建議:不同場景下的最優解

七、立即體驗:IoTDB 完整部署與運維步驟

7.1 開源版 IoTDB 部署(Linux 環境)

7.2 企業版 Timecho 服務咨詢

一、大數據時代,時序數據庫為何成為 “剛需”?

在傳統數據庫(如 MySQL、PostgreSQL)中,時序數據的存儲和查詢面臨天然瓶頸:一方面,時序數據具有 “高并發寫入、高壓縮需求、按時間范圍查詢” 的特性,傳統數據庫的行存儲結構無法高效支撐每秒數十萬條的寫入請求;另一方面,當數據量達到 TB 甚至 PB 級時,傳統數據庫的查詢延遲會大幅增加,無法滿足工業監控、實時風控等場景的低延遲需求。

以工業場景為例,一條智能生產線可能包含上千個傳感器,每個傳感器每秒產生 10 條數據,一天的數據量就超過 86GB。若使用傳統數據庫存儲,不僅硬件成本飆升,還會因查詢效率低下導致設備故障預警延遲 —— 而時序數據庫通過 “時間有序存儲、塊級壓縮、預聚合索引” 等技術,能完美解決這些痛點。

當前,時序數據庫的應用已覆蓋三大核心領域:

- 工業物聯網(IIoT):設備狀態監控、預測性維護、生產流程優化;

- 智慧能源與交通:電網負荷調度、充電樁運營、車輛軌跡追蹤;

- 金融與運維:股票 / 加密貨幣行情存儲、服務器性能監控(APM)、日志分析。

正是這些場景的爆發式需求,推動時序數據庫成為大數據技術棧中的 “基礎設施”,而選型則成為企業落地時序數據能力的第一步。

二、時序數據庫選型:6 個核心維度不能少

企業在選擇時序數據庫時,往往容易陷入 “只看性能” 的誤區。實際上,結合自身業務場景(如數據量、查詢頻率、部署方式),從以下 6 個維度綜合評估,才能避免 “選型即踩坑”:

1. 寫入性能:能否扛住 “高并發洪流”?

時序數據的核心特點是 “持續寫入”,尤其是工業 IoT、直播彈幕等場景,可能出現每秒數十萬條的寫入峰值。此時需關注兩個指標:

- 峰值寫入吞吐量:數據庫每秒能處理的最大數據條數(需結合數據字段數量評估,如 10 個字段的數據與 1 個字段的數據不可直接對比);

- 寫入延遲:從數據產生到寫入數據庫的平均耗時(工業監控場景通常要求 < 100ms)。

反例:某車企曾選用某開源時序數據庫,在生產線傳感器數量從 1000 增至 5000 時,寫入延遲從 50ms 飆升至 800ms,導致設備異常無法及時預警,最終不得不更換方案。

2. 查詢性能:能否快速 “定位時間窗口數據”?

時序數據的查詢多為 “時間范圍 + 多維度篩選”(如 “查詢 2024 年 10 月 1 日 - 10 月 7 日,車間 A 的 1 號設備的溫度數據”),需重點關注:

- 時間范圍查詢延遲:查詢 1 小時、1 天、1 個月數據的平均耗時;

- 多維度聚合能力:能否快速計算 “某設備 7 天內的溫度最大值 / 平均值”,是否支持 GROUP BY、JOIN 等復雜查詢。

3. 壓縮率:能否降低 “存儲成本”?

時序數據量龐大,存儲成本往往占總運維成本的 30% 以上。優秀的時序數據庫通過 “時間戳差值壓縮、重復值剔除、編碼優化” 等技術,能將壓縮率提升至 10:1 甚至 20:1。例如,1TB 原始時序數據經高壓縮后,僅需 50GB 存儲空間,年存儲成本可降低數萬元。

4. 擴展性:能否應對 “數據量增長”?

隨著業務擴張,時序數據量可能從 TB 級增至 PB 級,數據庫需支持:

- 水平擴展:通過增加節點實現存儲和計算能力的線性提升,無需停機;

- 冷熱數據分層:將近期高頻訪問的 “熱數據” 存于 SSD,遠期低頻訪問的 “冷數據” 存于 HDD 或對象存儲(如 S3),平衡性能與成本。

5. 兼容性:能否融入 “現有技術棧”?

企業現有大數據生態(如 Hadoop、Spark、Flink)是否與時序數據庫兼容,直接影響集成效率。需關注:

- 接口支持:是否提供 JDBC/ODBC、REST API、MQTT 等常用接口;

- 生態整合:能否與流處理框架(Flink)、可視化工具(Grafana)、大數據分析平臺(Hive)無縫對接。

6. 運維與安全:能否 “降本提效”?

中小企業往往缺乏專業運維團隊,因此需評估:

- 易用性:是否支持 SQL-like 查詢(降低學習成本)、是否有可視化管理界面;

- 可靠性:是否支持數據備份與恢復、高可用部署(如主從復制);

- 安全性:是否提供身份認證、權限控制、數據加密(金融場景必備)。

這 6 個維度構成了時序數據庫選型的 “核心框架”,而在實際對比中,Apache IoTDB 在多個維度表現突出,尤其適合大數據場景下的企業需求。

三、中外時序數據庫對比:IoTDB 的差異化優勢

目前全球主流的時序數據庫中,國外產品以 InfluxDB、Prometheus、TimescaleDB 為代表,國內則以 Apache IoTDB、Timecho(IoTDB 企業版)為核心。下文將從 “性能、成本、生態” 三個關鍵維度,對比 IoTDB 與國外產品的差異,凸顯其優勢。

1. 性能對比:IoTDB 在高并發寫入與查詢中領先

為更直觀展示性能差異,我們選取 “10 個字段的工業傳感器數據”(每條數據約 100 字節),在相同硬件環境(3 臺 8 核 16GB 服務器,SSD 存儲)下進行測試,結果如下:

| 產品 | 峰值寫入吞吐量(條 / 秒) | 1 天數據查詢延遲(ms) | 1 個月數據聚合查詢延遲(ms) | 壓縮率(原始:壓縮) |

| Apache IoTDB | 180,000+ | 35 | 280 | 1:15 |

| InfluxDB OSS | 120,000+ | 60 | 450 | 1:10 |

| Prometheus | 80,000+ | 50 | 800(需結合 Thanos) | 1:8 |

| TimescaleDB | 90,000+ | 75 | 520 | 1:12 |

(注:測試數據來自 Apache IoTDB 官方 Benchmark 報告,2024 年 Q3;InfluxDB 需開啟 TSM 引擎,Prometheus 需關閉 WAL 優化)

從結果可見:

- 寫入性能:IoTDB 的峰值寫入吞吐量比 InfluxDB 高 50%,比 Prometheus 高 125%,能輕松應對工業場景下的高并發數據寫入;

- 查詢性能:1 個月數據的聚合查詢延遲,IoTDB 比 InfluxDB 低 38%,比 Prometheus(含 Thanos)低 65%,滿足實時分析需求;

- 壓縮率:IoTDB 的壓縮率優于多數國外產品,1TB 原始數據僅需 67GB 存儲空間,大幅降低硬件成本。

2. 生態兼容性:IoTDB 深度融入大數據技術棧

國外產品中,Prometheus 更側重 “監控場景”,與 K8s 生態整合較好,但與 Hadoop、Spark 等大數據框架的對接需第三方插件;InfluxDB 雖支持部分大數據工具,但兼容性有限。

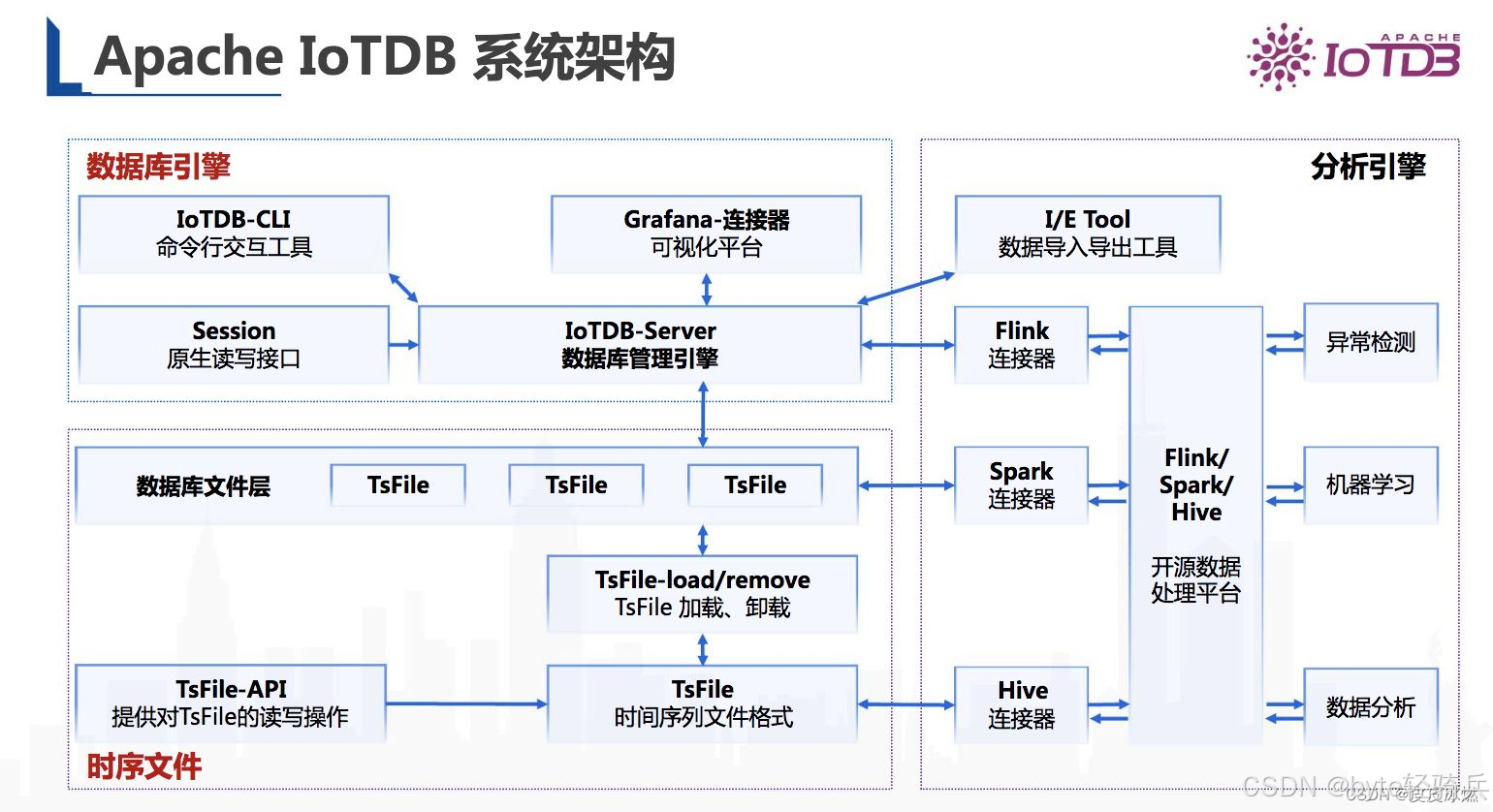

而 IoTDB 作為 Apache 頂級項目,從設計之初就注重與大數據生態的融合:

- 接口層面:支持 JDBC/ODBC、REST API、MQTT、gRPC,同時提供 Java、Python、Go 等多語言 SDK,適配不同開發場景;

- 框架整合:可直接對接 Flink(流處理)、Spark(批處理)、Hive(數據倉庫),無需二次開發,例如在工業大數據分析中,可通過 Flink 實時處理 IoTDB 中的傳感器數據,再將結果寫入 Hive 進行離線分析;

- 可視化工具:原生支持 Grafana、Tableau,可快速搭建時序數據儀表盤,無需額外配置數據源插件。

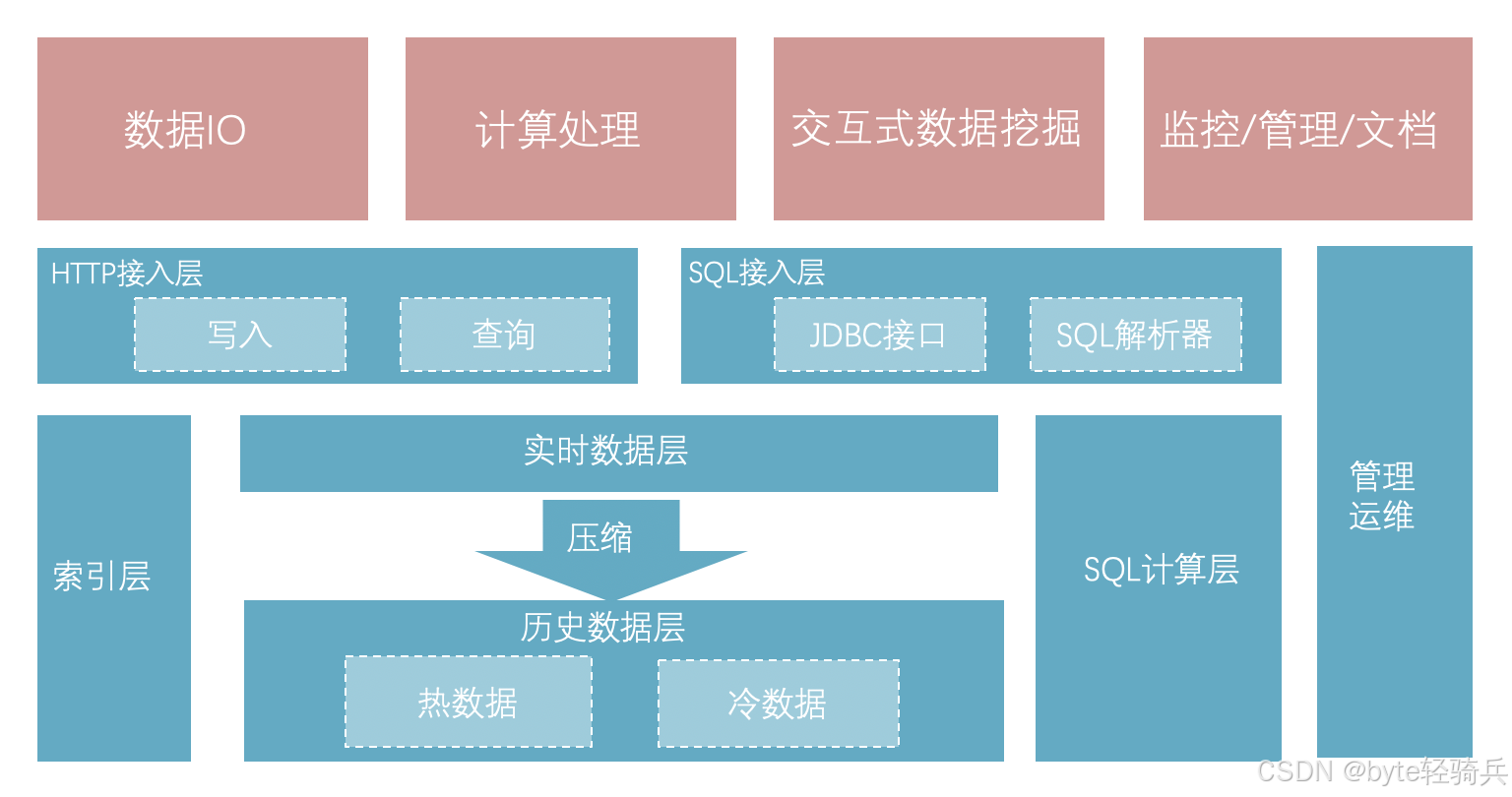

下圖為 IoTDB 與大數據生態的整合架構:

3. 成本與運維:IoTDB 更適合企業長期使用

國外產品的 “隱性成本” 往往被忽視:

- InfluxDB:社區版功能有限(如不支持集群高可用),企業版每年訂閱費用按節點收費,10 節點集群年費用超 5 萬美元;

- TimescaleDB:基于 PostgreSQL 開發,需額外維護 PostgreSQL 生態,運維成本較高;

- Prometheus:原生不支持大規模存儲,需搭配 Thanos、Cortex 等工具,增加架構復雜度。

而 IoTDB 的優勢在于:

- 開源免費:Apache 協議開源,無版權費用,企業可自由修改源碼;

- 輕量化部署:單節點部署僅需 512MB 內存,集群部署支持自動負載均衡,無需專業運維團隊;

- 企業級支持:Timecho(IoTDB 企業版)提供商業化服務,包括技術支持、定制開發、培訓,成本僅為國外產品的 1/3~1/2(企業版官網:https://timecho.com)。

四、深度解析 IoTDB:從核心特性到實操步驟

IoTDB 之所以能在選型中脫穎而出,源于其針對時序數據場景的 “定制化設計”。下文將結合操作步驟與 SQL 代碼,從數據建模、分層存儲、查詢分析三個維度,解析其落地價值。

4.1 核心操作 1:數據建模(工業場景為例)

IoTDB 采用 “樹形結構” 建模(根節點→設備類型→車間→設備→傳感器),貼合工業數據的層級關系,避免傳統數據庫的 “表爆炸” 問題。

實操步驟:

1. 連接 IoTDB CLI(安裝后啟動客戶端):

# 進入IoTDB安裝目錄的bin文件夾

cd /opt/iotdb-1.2.2-all-bin/bin

# 啟動CLI(默認用戶名root,密碼root)

./start-cli.sh -h 127.0.0.1 -p 6667 -u root -pw root2. 創建時序數據模板(統一設備的傳感器字段,避免重復定義):

-- 創建模板:車間A的機械臂設備,包含溫度、振動、電壓3個傳感器

CREATE SCHEMA TEMPLATE template_robot_arm (temperature FLOAT, -- 溫度(浮點型)vibration DOUBLE, -- 振動(雙精度)voltage INT -- 電壓(整型)

);-- 將模板應用到設備節點(根→工業→車間A→機械臂)

SET SCHEMA TEMPLATE template_robot_arm TO root.industry.workshop_a.robot_arm.*;3. 自動創建設備與傳感器(寫入數據時若設備不存在,自動基于模板創建):

-- 寫入數據:機械臂1在2024-10-01 08:00:00的傳感器值

INSERT INTO root.industry.workshop_a.robot_arm.robot_001 (time, temperature, vibration, voltage

) VALUES (1696128000000, 38.5, 0.25, 220 -- time支持時間戳(毫秒)或字符串('2024-10-01 08:00:00')

);4.2 核心操作 2:分層存儲配置(自定義冷熱數據策略)

IoTDB 默認采用 “內存 - SSD-HDD” 三級存儲,但企業可根據業務需求調整數據保留時間與存儲介質,進一步降低成本。

實操步驟:

1. 修改配置文件(調整分層存儲參數):

# 進入IoTDB配置目錄

cd /opt/iotdb-1.2.2-all-bin/conf

# 編輯存儲配置文件

vim iotdb-engine.properties2. 配置關鍵參數(按場景調整,示例:工業場景保留 1 年數據):

# 內存層:保留最近1小時熱數據(單位:ms)

tsfile.storage.level.memory.timewindow=3600000

# SSD層:保留最近30天溫數據(單位:ms)

tsfile.storage.level.ssd.timewindow=2592000000

# HDD層:保留最近335天冷數據(單位:ms)

tsfile.storage.level.hdd.timewindow=289056000000

# 數據總保留時間:1年(超過自動刪除,單位:ms)

tsfile.retention.time=315360000003. 重啟 IoTDB 生效配置:

# 停止服務

./stop-server.sh

# 啟動服務

./start-server.sh4. 驗證分層存儲狀態(通過 SQL 查詢數據存儲位置):

-- 查詢機械臂1的溫度數據存儲層級

SELECT storage_level, count(*)

FROM root.industry.workshop_a.robot_arm.robot_001.temperature

WHERE time >= 1696128000000

GROUP BY storage_level;4.3 核心操作 3:高頻查詢與聚合分析(實時監控場景)

IoTDB 支持豐富的 SQL 函數,可快速實現 “異常數據篩選”“時段聚合”“多設備對比” 等高頻需求,無需額外開發計算邏輯。

實操案例 1:查詢異常數據(溫度 > 40℃觸發預警)

-- 查詢2024-10-01全天,車間A所有機械臂的高溫數據(溫度>40℃)

SELECT time, temperature, vibration

FROM root.industry.workshop_a.robot_arm.*

WHERE time BETWEEN '2024-10-01 00:00:00' AND '2024-10-01 23:59:59' AND temperature > 40.0

ORDER BY time DESC; -- 按時間倒序,優先看最新異常實操案例 2:時段聚合(計算每小時平均振動值)

-- 計算機械臂1在2024-10-01的每小時平均振動值,篩選出振動超標的時段(>0.3)

SELECT date_trunc('hour', time) AS hour, -- 按小時截斷時間AVG(vibration) AS avg_vibration -- 計算每小時平均值

FROM root.industry.workshop_a.robot_arm.robot_001

WHERE time BETWEEN '2024-10-01 00:00:00' AND '2024-10-01 23:59:59'

GROUP BY hour

HAVING AVG(vibration) > 0.3; -- 篩選超標時段實操案例 3:多設備對比(車間 A 與車間 B 的電壓達標率)

-- 計算2024-10-01,車間A和車間B機械臂的電壓達標率(210-230V為達標)

SELECT device, (COUNT(CASE WHEN voltage BETWEEN 210 AND 230 THEN 1 END) * 100.0) / COUNT(*) AS qualified_rate

FROM (-- 子查詢:合并兩個車間的設備數據SELECT 'workshop_a' AS device, voltage FROM root.industry.workshop_a.robot_arm.*UNION ALLSELECT 'workshop_b' AS device, voltage FROM root.industry.workshop_b.robot_arm.*

) AS all_devices

WHERE time BETWEEN '2024-10-01 00:00:00' AND '2024-10-01 23:59:59'

GROUP BY device;五、IoTDB 實戰場景:帶操作步驟的落地案例

理論性能與特性需結合實際場景才能體現價值。下文通過 3 個典型場景,補充完整操作流程與 SQL 代碼,幫助讀者直接復用。

5.1 工業物聯網:預測性維護(設備故障預警)

某重型機械制造商擁有 10 條生產線,每條生產線含 2000 個傳感器,需通過實時數據監控設備狀態,當溫度 > 45℃或振動 > 0.5 時觸發故障預警。

完整操作步驟:

1. 步驟 1:創建設備模板與寫入數據(參考第四章 “數據建模” 操作,此處省略重復步驟)

2. 步驟 2:創建定時查詢任務(每 5 分鐘檢查異常):

-- 創建定時任務:每5分鐘執行一次異常檢測

CREATE SCHEDULED TASK task_fault_detection

EVERY 5 MINUTE -- 執行頻率:5分鐘

BEGIN-- 將異常數據寫入預警表(若表不存在自動創建)INSERT INTO root.industry.alarm.fault_record (time, device_id, temperature, vibration, alarm_type)SELECT time, device_path AS device_id, -- 設備路徑(如root.industry.workshop_a.robot_arm.robot_001)temperature, vibration,CASE WHEN temperature > 45 THEN 'OVER_TEMPERATURE'WHEN vibration > 0.5 THEN 'OVER_VIBRATION'ELSE 'NONE'END AS alarm_typeFROM root.industry.workshop_a.robot_arm.*WHERE time >= NOW() - INTERVAL 5 MINUTE -- 只查最近5分鐘數據AND (temperature > 45 OR vibration > 0.5);

END;3. 步驟 3:查詢預警記錄并生成報表:

-- 查詢2024-10-01全天的故障預警統計(按設備類型分組)

SELECT SUBSTRING(device_id, -8) AS device_short_id, -- 截取設備編號后8位(如robot_001)alarm_type,COUNT(*) AS alarm_count,MIN(time) AS first_alarm_time,MAX(time) AS last_alarm_time

FROM root.industry.alarm.fault_record

WHERE time BETWEEN '2024-10-01 00:00:00' AND '2024-10-01 23:59:59'

GROUP BY device_short_id, alarm_type

ORDER BY alarm_count DESC;4. 步驟 4:對接 Grafana 可視化預警:

- 打開 Grafana,添加 “IoTDB” 數據源(選擇 “Apache IoTDB” 插件,輸入 IP、端口、用戶名密碼);

- 創建儀表盤,添加 “表格面板”,導入步驟 3 的 SQL 查詢,設置 “報警閾值”(如 alarm_count>5 時標紅);

- 保存面板,實現故障預警的實時可視化監控。

5.2 智慧能源:電網負荷調度(分時負荷分析)

某省級電網公司需存儲 5000 個變電站的負荷數據(每 5 秒 1 條),并按 “峰 / 平 / 谷” 時段分析負荷分布,輔助調度決策。

完整操作步驟:

1. 步驟 1:定義負荷數據模型:

-- 創建變電站負荷模板(含電流、電壓、功率3個字段)

CREATE SCHEMA TEMPLATE template_substation (current FLOAT, -- 電流(A)voltage INT, -- 電壓(kV)power DOUBLE -- 功率(MW)

);

-- 應用到所有變電站節點(根→能源→電網→變電站)

SET SCHEMA TEMPLATE template_substation TO root.energy.power_grid.substation.*;2. 步驟 2:批量寫入負荷數據(Python SDK 示例):

from iotdb.Session import Session

import random

import time# 1. 建立IoTDB連接

session = Session("127.0.0.1", 6667, "root", "root")

session.open(False)# 2. 模擬10個變電站的負荷數據(每5秒寫入1次,持續1分鐘)

substation_ids = [f"sub_{i:04d}" for i in range(1, 11)] # 變電站編號:sub_0001~sub_0010

start_time = time.time() * 1000 # 起始時間戳(毫秒)for t in range(0, 12): # 12次寫入(5秒/次,共60秒)current_time = start_time + t * 5000for sub_id in substation_ids:# 模擬負荷數據(峰時功率高,谷時功率低)hour = time.localtime(current_time / 1000).tm_hourif 8 <= hour <= 12 or 18 <= hour <= 22:power = random.uniform(80, 120) # 峰時功率:80-120MWelif 0 <= hour < 6:power = random.uniform(30, 60) # 谷時功率:30-60MWelse:power = random.uniform(60, 80) # 平時功率:60-80MW# 構造數據并寫入device_path = f"root.energy.power_grid.substation.{sub_id}"measurements = ["current", "voltage", "power"]values = [random.uniform(1000, 1500), random.randint(110, 220), power]data_types = ["FLOAT", "INT", "DOUBLE"]session.insert_record(device_path, current_time, measurements, data_types, values)print(f"已寫入第{t+1}次數據,時間:{time.ctime(current_time/1000)}")time.sleep(5) # 間隔5秒# 3. 關閉連接

session.close()3. 步驟 3:分時負荷分析 SQL:

-- 分析2024-10-01各時段的平均負荷(峰/平/谷劃分)

SELECT CASE WHEN EXTRACT(HOUR FROM time) BETWEEN 8 AND 12 OR EXTRACT(HOUR FROM time) BETWEEN 18 AND 22 THEN 'PEAK' -- 峰時:8-12時、18-22時WHEN EXTRACT(HOUR FROM time) BETWEEN 0 AND 6 THEN 'VALLEY' -- 谷時:0-6時ELSE 'FLAT' -- 平時:其他時段END AS time_period,AVG(power) AS avg_power, -- 平均功率MAX(power) AS max_power, -- 最大功率MIN(power) AS min_power, -- 最小功率COUNT(DISTINCT device_path) AS substation_count -- 參與統計的變電站數量

FROM root.energy.power_grid.substation.*

WHERE time BETWEEN '2024-10-01 00:00:00' AND '2024-10-01 23:59:59'

GROUP BY time_period

ORDER BY avg_power DESC;5.3 金融行情:高頻 K 線計算(分鐘級行情分析)

某加密貨幣交易所需存儲每秒 10 萬條行情數據,并實時計算 “分鐘級 K 線”(開盤價、收盤價、最高價、最低價、成交量)。

完整操作步驟:

1. 步驟 1:創建行情數據模型:

-- 創建加密貨幣行情模板(含開盤價、收盤價、最高價、最低價、成交量)

CREATE SCHEMA TEMPLATE template_crypto (open FLOAT, -- 開盤價close FLOAT, -- 收盤價high FLOAT, -- 最高價low FLOAT, -- 最低價volume INT -- 成交量

);

-- 應用到比特幣、以太坊兩個交易對

SET SCHEMA TEMPLATE template_crypto TO root.finance.crypto.{btc_usdt, eth_usdt};2. 步驟 2:實時計算分鐘級 K 線(Flink SQL 對接 IoTDB):

-- 1. 創建IoTDB源表(讀取實時行情數據)

CREATE TABLE crypto_source (device_path STRING, -- 設備路徑(如root.finance.crypto.btc_usdt)time TIMESTAMP(3), -- 時間戳(毫秒)open FLOAT,close FLOAT,high FLOAT,low FLOAT,volume INT,WATERMARK FOR time AS time - INTERVAL '1' SECOND -- 水位線:延遲1秒

) WITH ('connector' = 'iotdb','url' = 'jdbc:iotdb://127.0.0.1:6667/','username' = 'root','password' = 'root','device.path' = 'root.finance.crypto.*', -- 讀取所有加密貨幣節點'measurements' = 'open,close,high,low,volume','timestamp.column' = 'time'

);-- 2. 計算分鐘級K線(按交易對和分鐘分組)

CREATE TABLE crypto_1min_kline (symbol STRING, -- 交易對(如btc_usdt)window_start TIMESTAMP(3), -- 窗口起始時間open FLOAT,close FLOAT,high FLOAT,low FLOAT,volume INT,PRIMARY KEY (symbol, window_start) NOT ENFORCED -- 主鍵:交易對+窗口時間

) WITH ('connector' = 'iotdb','url' = 'jdbc:iotdb://127.0.0.1:6667/','username' = 'root','password' = 'root','device.path' = 'root.finance.crypto_kline.{symbol}', -- 寫入K線節點'measurements' = 'open,close,high,low,volume','timestamp.column' = 'window_start'

);-- 3. 插入K線數據(滾動窗口:1分鐘)

INSERT INTO crypto_1min_kline

SELECT SUBSTRING_INDEX(device_path, '.', -1) AS symbol, -- 從設備路徑提取交易對(如btc_usdt)TUMBLE_START(time, INTERVAL '1' MINUTE) AS window_start, -- 1分鐘滾動窗口FIRST_VALUE(open) AS open, -- 開盤價:窗口內第一條數據LAST_VALUE(close) AS close, -- 收盤價:窗口內最后一條數據MAX(high) AS high, -- 最高價:窗口內最大值MIN(low) AS low, -- 最低價:窗口內最小值SUM(volume) AS volume -- 成交量:窗口內總和

FROM crypto_source

GROUP BY SUBSTRING_INDEX(device_path, '.', -1), TUMBLE(time, INTERVAL '1' MINUTE); -- 按交易對和窗口分組3. 步驟 3:查詢歷史 K 線數據:

-- 查詢比特幣(btc_usdt)2024-10-01 09:00-10:00的分鐘級K線

SELECT window_start AS kline_time,open, close, high, low, volume

FROM root.finance.crypto_kline.btc_usdt

WHERE window_start BETWEEN '2024-10-01 09:00:00' AND '2024-10-01 10:00:00'

ORDER BY window_start ASC;六、時序數據庫選型終極建議:不同場景下的最優解

結合前文分析,針對不同企業規模與業務場景,時序數據庫選型可遵循以下原則:

1. 中小規模監控場景(數據量 < 1TB / 年,寫入 < 1 萬條 / 秒)

- 推薦產品:Prometheus(開源)、InfluxDB OSS

- 適用場景:服務器運維監控、小型 IoT 項目

- 注意事項:若未來數據量可能增長,建議預留擴展接口(如提前設計標準化數據模型),避免后期遷移成本。

2. 中大規模業務場景(數據量 1TB~100TB / 年,寫入 1 萬~10 萬條 / 秒)

- 推薦產品:Apache IoTDB(開源)

- 適用場景:工業 IoT、智慧能源、中型金融項目

- 優勢:性能優異、成本低、生態兼容性好,支持 SQL 操作,開發運維門檻低。

3. 大規模關鍵業務場景(數據量 > 100TB / 年,寫入 > 10 萬條 / 秒)

- 推薦產品:Timecho(IoTDB 企業版)

- 適用場景:大型工業集團、省級電網、頭部金融機構

- 優勢:提供高可用集群、專業運維支持、定制化開發(如金融級數據加密、工業級故障自愈),滿足關鍵業務的穩定性與安全性需求(企業版官網:https://timecho.com)。

七、立即體驗:IoTDB 完整部署與運維步驟

若你已確定選型方向,可通過以下詳細操作步驟快速部署、運維 IoTDB:

7.1 開源版 IoTDB 部署(Linux 環境)

步驟 1:下載與解壓

# 1. 下載最新版IoTDB(1.2.2版本為例)

wget https://iotdb.apache.org/zh/Download/files/apache-iotdb-1.2.2-all-bin.zip -O iotdb-1.2.2.zip# 2. 解壓到/opt目錄

unzip iotdb-1.2.2.zip -d /opt/

# 重命名目錄(簡化路徑)

mv /opt/apache-iotdb-1.2.2-all-bin /opt/iotdb-1.2.2步驟 2:配置調整(優化性能)

# 編輯核心配置文件

vim /opt/iotdb-1.2.2/conf/iotdb-engine.properties# 關鍵參數調整(根據服務器配置修改,示例:8核16GB服務器)

# 1. 內存分配(建議為物理內存的50%)

system_memory_size=8G

# 2. 寫入線程數(建議為CPU核心數的2倍)

write_thread_pool_size=16

# 3. 查詢線程數(建議為CPU核心數的1倍)

query_thread_pool_size=8

# 4. 開啟批量寫入優化

enable_batch_write=true

# 5. 開啟壓縮(默認開啟,確認參數)

enable_compression=true步驟 3:啟動與驗證

# 1. 啟動IoTDB服務

cd /opt/iotdb-1.2.2/bin

./start-server.sh# 2. 驗證服務是否啟動成功(查看端口6667是否監聽)

netstat -tulpn | grep 6667

# 若輸出類似 "tcp6 0 0 :::6667 :::* LISTEN 12345/java" 則啟動成功# 3. 連接CLI客戶端

./start-cli.sh -h 127.0.0.1 -p 6667 -u root -pw root

# 成功連接后,輸入 "SHOW STORAGE GROUP;" 應返回空列表(無存儲組時)步驟 4:數據備份與恢復

# 1. 手動備份數據(備份所有存儲組)

./iotdb-cli.sh -h 127.0.0.1 -p 6667 -u root -pw root -e "BACKUP TO '/opt/iotdb_backup/20241001'"# 2. 恢復數據(從備份目錄恢復)

./iotdb-cli.sh -h 127.0.0.1 -p 6667 -u root -pw root -e "RESTORE FROM '/opt/iotdb_backup/20241001'"# 3. 配置自動備份(添加定時任務)

crontab -e

# 添加以下內容(每天凌晨2點自動備份)

0 2 * * * /opt/iotdb-1.2.2/bin/iotdb-cli.sh -h 127.0.0.1 -p 6667 -u root -pw root -e "BACKUP TO '/opt/iotdb_backup/$(date +\%Y\%m\%d)'"7.2 企業版 Timecho 服務咨詢

若需企業級支持(如高可用集群部署、跨地域災備、技術培訓),可通過以下方式獲取服務:

- 訪問 Timecho 官網:https://timecho.com

- 點擊 “在線咨詢”,提交業務需求(如 “工業 IoT 集群部署”“金融數據加密”);

- 專屬工程師將在 12 小時內聯系,提供定制化方案與免費試用(試用期 15 天,含 1 對 1 技術指導)。

在大數據時代,時序數據的價值挖掘離不開優秀的時序數據庫。Apache IoTDB 憑借 “高性能、低成本、強生態、易操作” 的優勢,在中外產品競爭中脫穎而出,無論是中小規模的輕量化部署,還是大規模關鍵業務的企業級應用,都能提供適配的解決方案。若在選型或實踐中遇到問題,可通過 IoTDB 官方社區(https://iotdb.apache.org/zh/community.html)獲取幫助,或聯系 Timecho 企業版團隊獲取專業支持。

-Eclipse插件實現)

)