- 深入理解深度學習中的激活層:Sigmoid和Softmax作為非終結層的應用

- Sigmoid 和 Softmax 激活函數簡介

- Sigmoid函數

- Softmax函數

- Sigmoid 和 Softmax 作為非終結層

- 多任務學習

- 特征變換

- 增加網絡的非線性

- 實際案例

- 注意事項

- 結論

深入理解深度學習中的激活層:Sigmoid和Softmax作為非終結層的應用

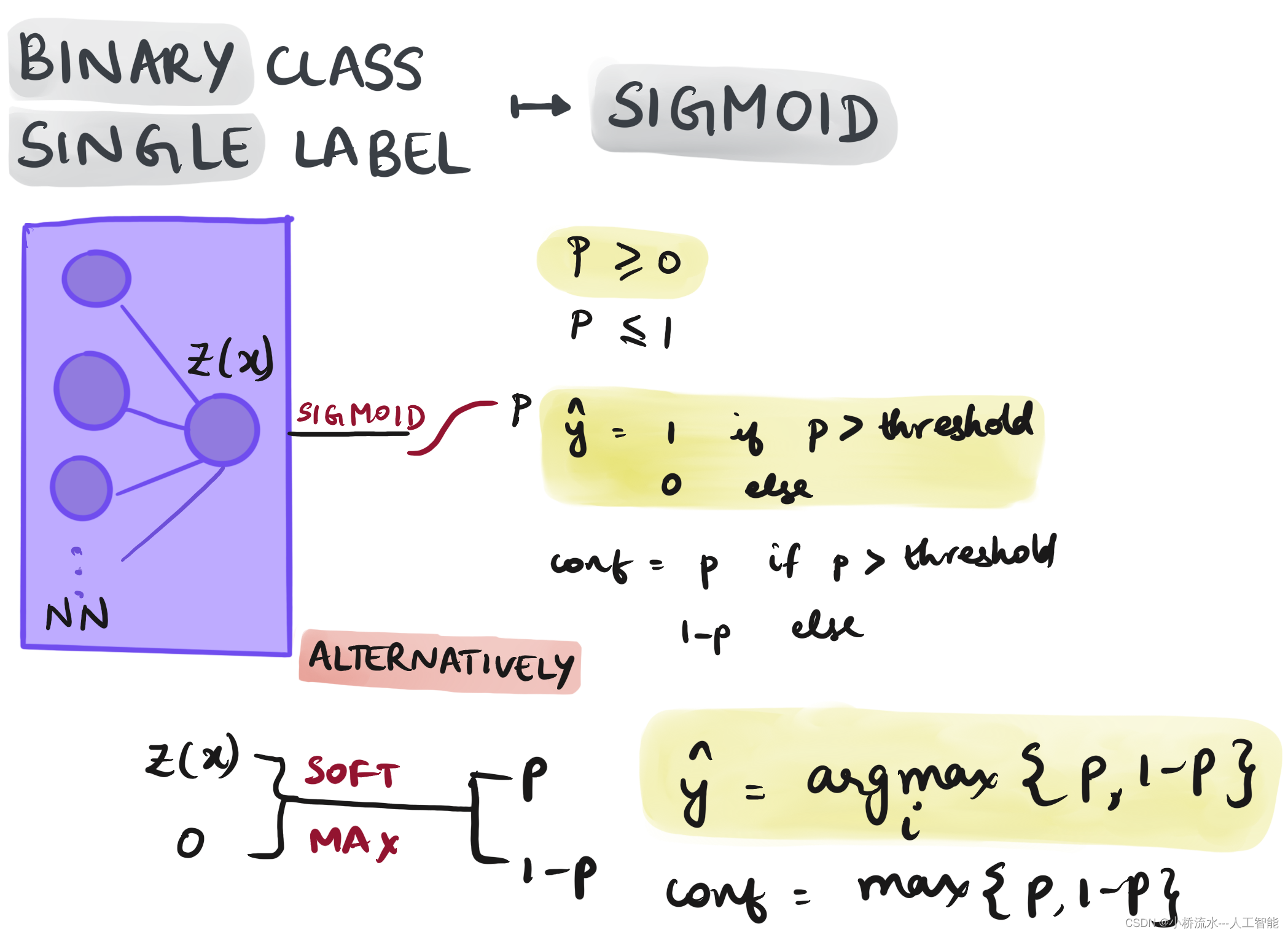

在深度學習的網絡架構設計中,Sigmoid和Softmax層通常被用作最后的輸出層,特別是在處理二分類、多分類問題時。然而,也存在一些情景和設計選擇,其中這些激活函數被用作中間層,連接到后續的全連接層。本篇博客將詳細探討在何種情況下Sigmoid或Softmax層可以用作非終結層,以及這樣做的潛在理由和效果。

Sigmoid 和 Softmax 激活函數簡介

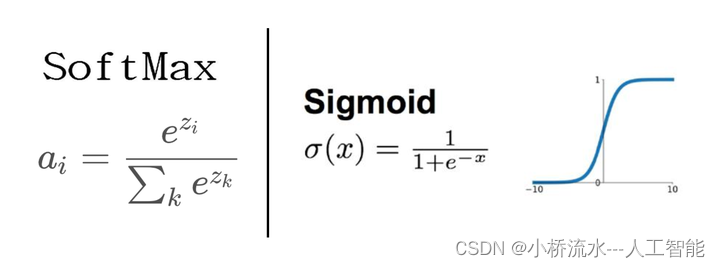

Sigmoid函數

Sigmoid激活函數將輸入值壓縮到0和1之間,公式為:

σ ( x ) = 1 1 + e ? x \sigma(x) = \frac{1}{1 + e^{-x}} σ(x)=1+e?x1?

這使得它非常適合于二分類問題的輸出層,比如預測一個事件發生與否。

Softmax函數

Softmax函數是Sigmoid函數在多類分類問題上的推廣,它將一個向量壓縮成一個概率分布,其中每個元素的值都在0和1之間,且所有元素值的總和為1。公式為:

Softmax ( x i ) = e x i ∑ j e x j \text{Softmax}(x_i) = \frac{e^{x_i}}{\sum_{j} e^{x_j}} Softmax(xi?)=∑j?exj?exi??

Softmax常用于多分類問題的輸出層,每個輸出代表一個類別的預測概率。

Sigmoid 和 Softmax 作為非終結層

雖然不常見,Sigmoid和Softmax函數有時也被用作隱藏層。以下是一些使用場景和理由:

多任務學習

在多任務學習中,網絡需要同時預測多個標簽或輸出。這種情況下,可能會在網絡的中間部分使用Sigmoid或Softmax層,以處理不同的任務需求,然后可能再連接到其他全連接層進行進一步的處理。

特征變換

Sigmoid或Softmax層可以用于將特征轉換成更適合后續處理的形式。例如,在某些自然語言處理任務中,可能需要將特征轉換為概率形式,然后再進行進一步的分析和處理。

增加網絡的非線性

使用Sigmoid或Softmax作為中間層可以增加模型的非線性,有助于處理更復雜的數據模式。盡管如此,這樣做需謹慎,因為它可能導致梯度消失的問題,特別是在網絡較深的情況下。

實際案例

假設一個神經網絡模型需要根據前面的特征預測兩個不同的目標變量,其中一個是二分類問題,另一個是多分類問題。可以在中間使用一個Sigmoid層來處理二分類輸出,然后將這個輸出和其他特征一起傳遞到另一個Softmax層來處理多分類問題。

注意事項

使用Sigmoid或Softmax作為非終結層時,必須注意梯度消失和爆炸的問題。這些激活函數在輸出接近0或1時的梯度非常小,可能會在訓練過程中導致梯度傳遞效率低下。

結論

雖然Sigmoid和Softmax通常用作輸出層,但在某些特定的設計和需求下,它們也可以用作中間層。這樣做可以為模型設計帶來更大的靈活性和功能,但也需要考慮到潛在的技術挑戰,如梯度問題。理解這些激活函數的特性和適用場景對于構建有效的深度學習模型至關重要。希望本篇博客能幫助您更深入地理解這些激活層的使用及其在實際應用中的潛在效果。

LRU緩存、數組中最大的第k個元素)

)