文章目錄

- 00 環境設置

- 01 部署一個 chat 小模型

- 02 Lagent 運行 InternLM2-chat-7B

- 03 浦語·靈筆2

第二節課程視頻與文檔:

https://www.bilibili.com/video/BV1AH4y1H78d/

https://github.com/InternLM/Tutorial/blob/camp2/helloworld/hello_world.md

視頻和文檔內容基本重合,因此這次筆記也同時記錄和推進

課程分成這四個部分;社區也隨訓練營產生了多個興趣小組:

估計是完成訓練營后可以加入其中繼續學習和研究。

00 環境設置

完成作業一官方會發放算力點,兌換成開發機的使用配置*時間。

第一次配置開發機需要十分鐘左右,后續再開會快很多。

第一個項目需要的算力比較少,因此選擇了資源最小的配置+4小時時長,但真正跑起來發現可能時間非常緊張,僅安裝環境差不多需要一個小時時間,IO 效率太離譜了……但免費的教學資源也不好多說啥。

忍忍吧。

PS. 教程中的等效配置理論上會快一些,注意要把-c pytorch -c nvidia去掉。開發機的網絡環境訪問不了這些源。

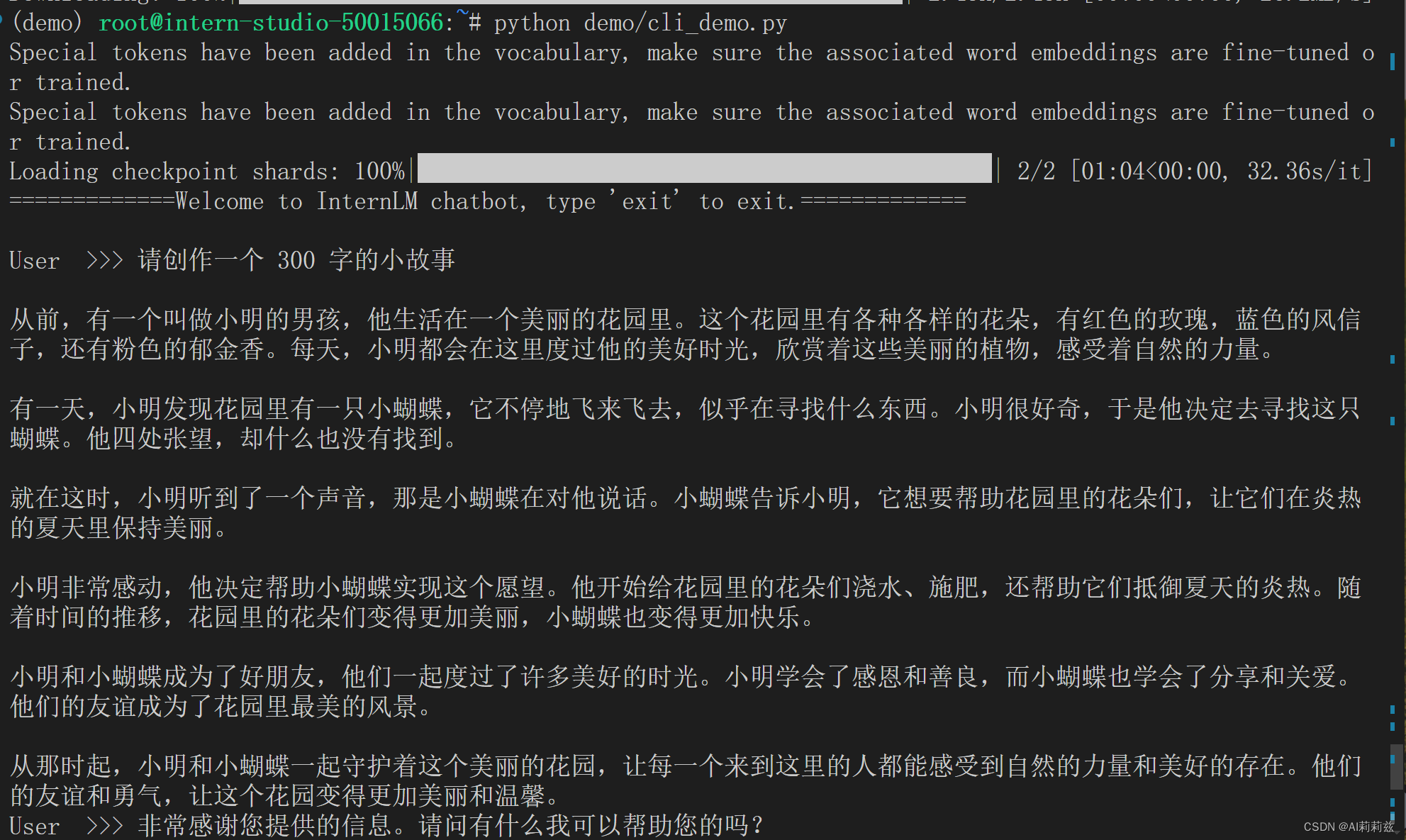

01 部署一個 chat 小模型

安裝完環境,剩下的流程就非常簡單了。跑過本地模型的人都比較熟悉,教程提供了相應腳本,下載權重,運行腳本加載、推理即可。

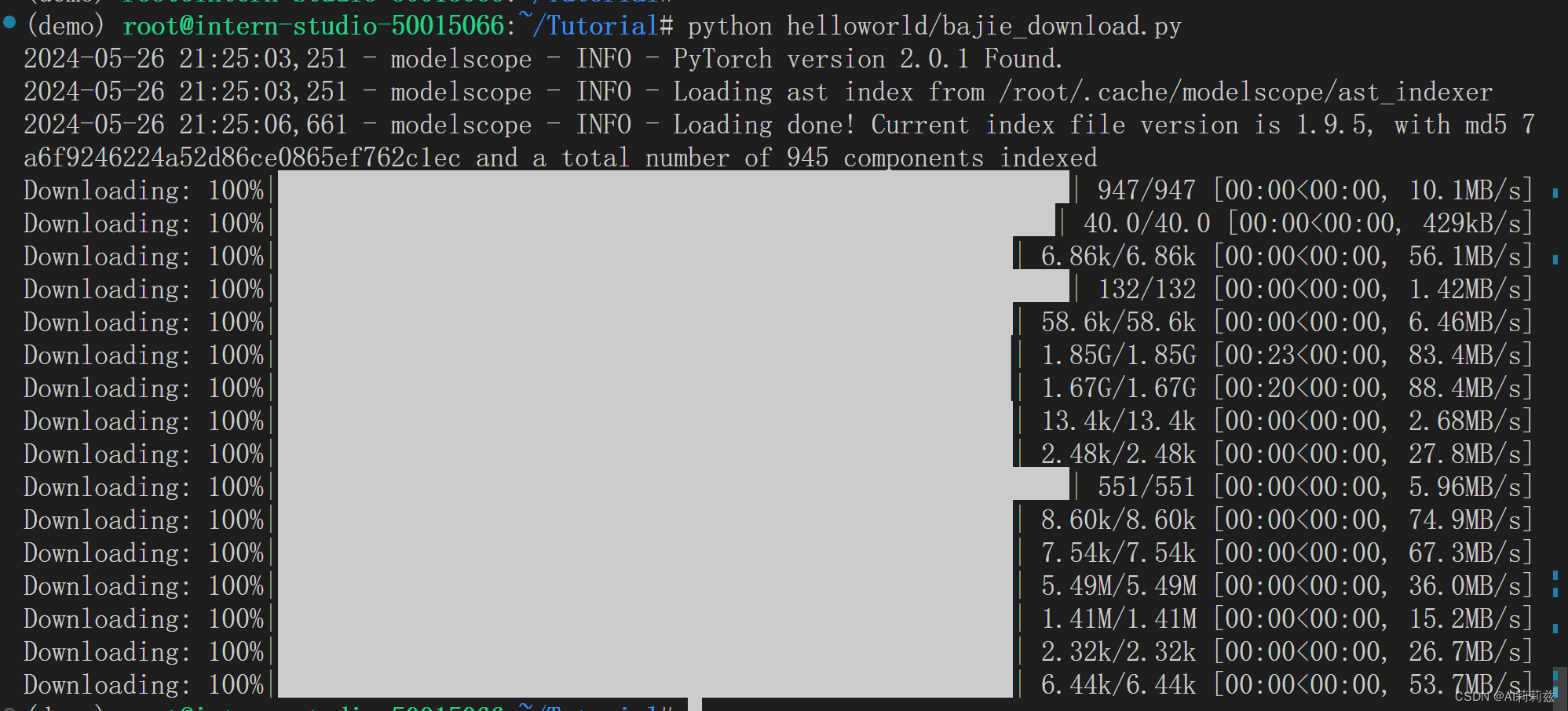

下載八戒微調版本:

可見網速是非常快的,但推理速度比較慢。

運行體驗:

python /root/Tutorial/helloworld/bajie_download.py

streamlit run /root/Tutorial/helloworld/bajie_chat.py --server.address 127.0.0.1 --server.port 6006

我也是 windows 用戶,不過由于上方命令是直接在 IDE 的 terminal 中運行的,VS Code 自動提供了端口轉發。

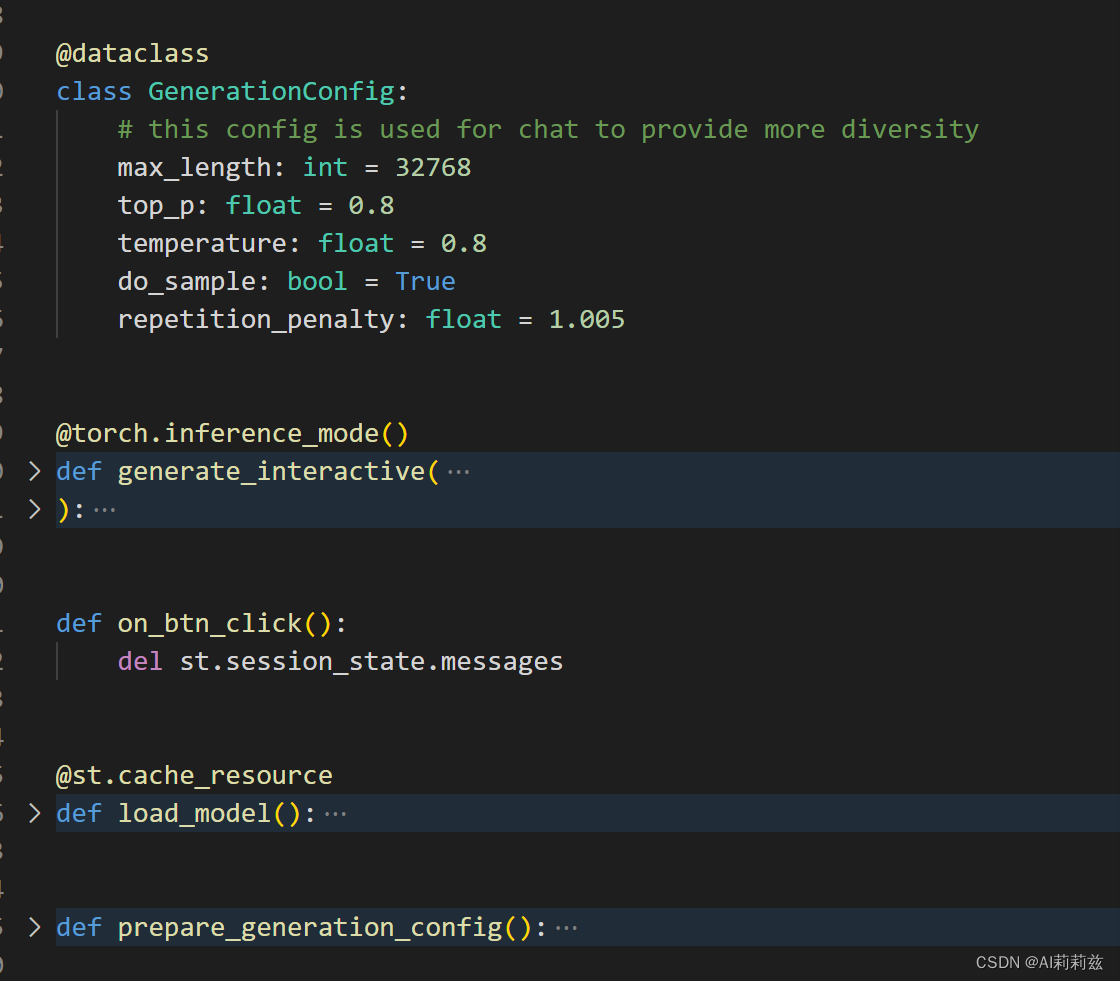

streamlit 提供了在線對話 UI,趁后臺在慢悠悠加載模型,去瞅一眼 bajie_chat.py 的代碼:

- 生成設置

- 交互處理

- 加載模型

- ……

模型加載好了:

換了幾條 Query 都能接上,自我認知倒是入心入腦了。

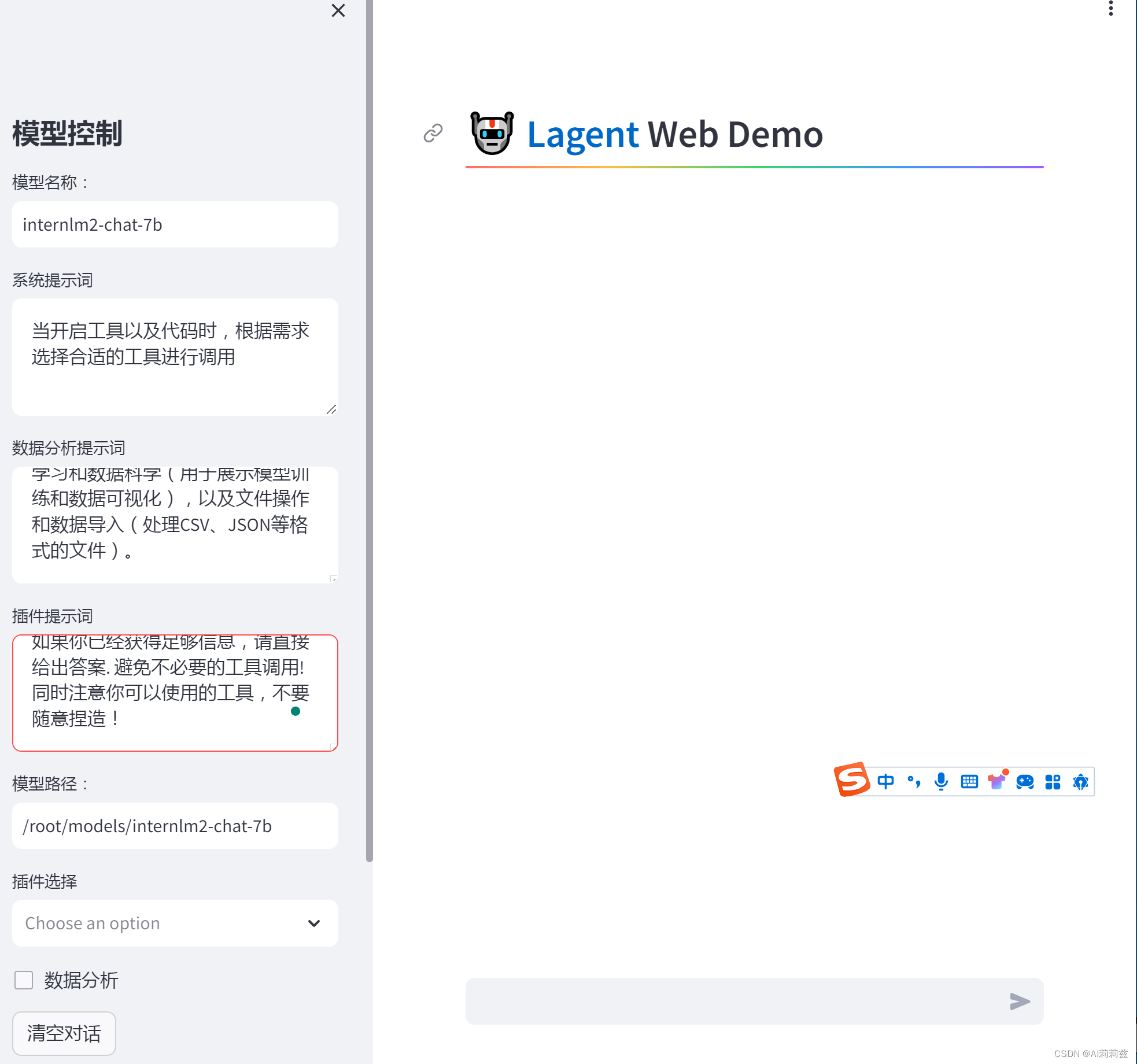

02 Lagent 運行 InternLM2-chat-7B

按照教程下載項目文件并安裝,五分鐘左右安裝完 Lagent 的教學版本并加載模型。

同樣,WebIDE 是你的好幫手,直接運行點擊彈出的提示跳轉到頁面即可:

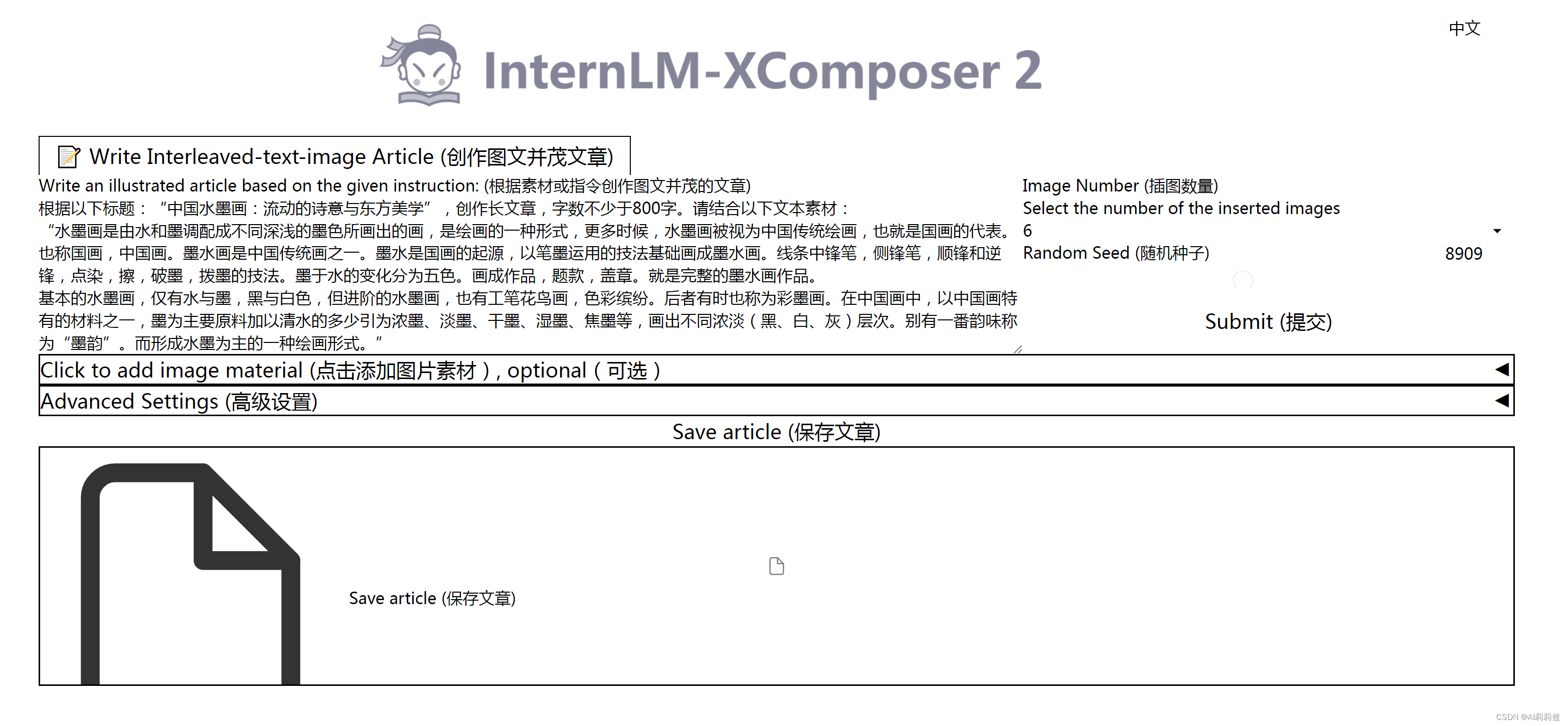

03 浦語·靈筆2

網頁怎么沒有正常渲染出來呢……

換到 VQA 模型,好像有同樣的問題:

不知道問題出在哪……這個作業的花費時間有點超出我預計,第二節容我先這樣吧.

)

)

)

選擇IDE和配置環境)