LLaMA 模型的第三代,是 LLaMA 2 的一個更大和更強的版本。LLaMA 3 擁有 35 億個參數,訓練在更大的文本數據集上GpuMall智算云 | 省錢、好用、彈性。租GPU就上GpuMall,面向AI開發者的GPU云平臺

Llama 3 的推出標志著 Meta 基于 Llama 2 架構推出了四個新的開放型大語言模型。這些模型分為兩種規模:8B 和 70B 參數,每種規模都提供預訓練基礎版和指令調優版。所有版本均可在各種消費級硬件上運行,并具有 8000 Token 的上下文長度。

Meta-Llama-3-8b: 8B 基礎模型#autodl#恒源云#矩池云#算力云#恒源云 實例遷移#autodl 官網#autodi#GpuMall#GPU云#AutoDL#AotuDL 算力云#GpuMall智算云#AI#大數據#算力租賃#大模型#深度學習#人工智能#算力變現Meta-Llama-3-8b-instruct: 8B 基礎模型的指令調優版Meta-Llama-3-70b: 70B 基礎模型Meta-Llama-3-70b-instruct: 70B 基礎模型的指令調優版

與?Llama 2?相比,Llama 3?最大的變化是采用了新的?Tokenizer,將詞匯表大小擴展至?128,256(前版本為?32,000?Token)。這一更大的詞匯庫能夠更高效地編碼文本(無論輸入還是輸出),并有可能提升模型的多語種處理能力。不過,這也導致嵌入層的輸入和輸出矩陣尺寸增大,這是小型模型參數增加(從 Llama 2 的 7B 增至 Llama 3 的 8B)的主要原因之一。此外,8B 版本的模型現在采用了分組查詢注意力(GQA),這是一種效率更高的表達方式,有助于處理更長的上下文。

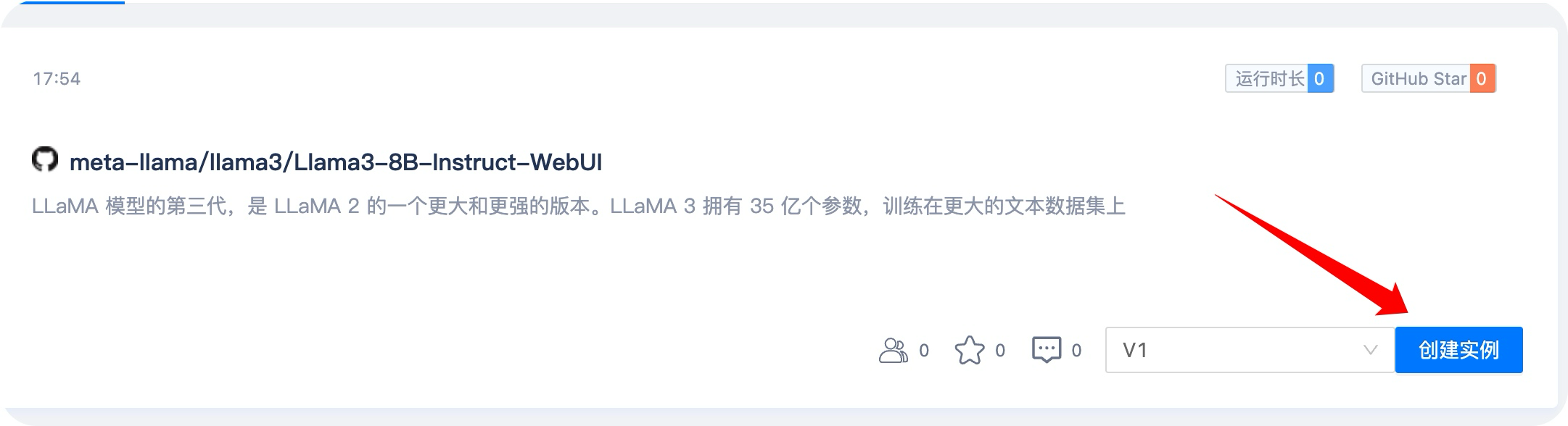

創建實例

通過該模型創建實例,需要使用16G以上顯存GPU,建議使用 3090 或 4090,否則因顯存問題無法載入模型。

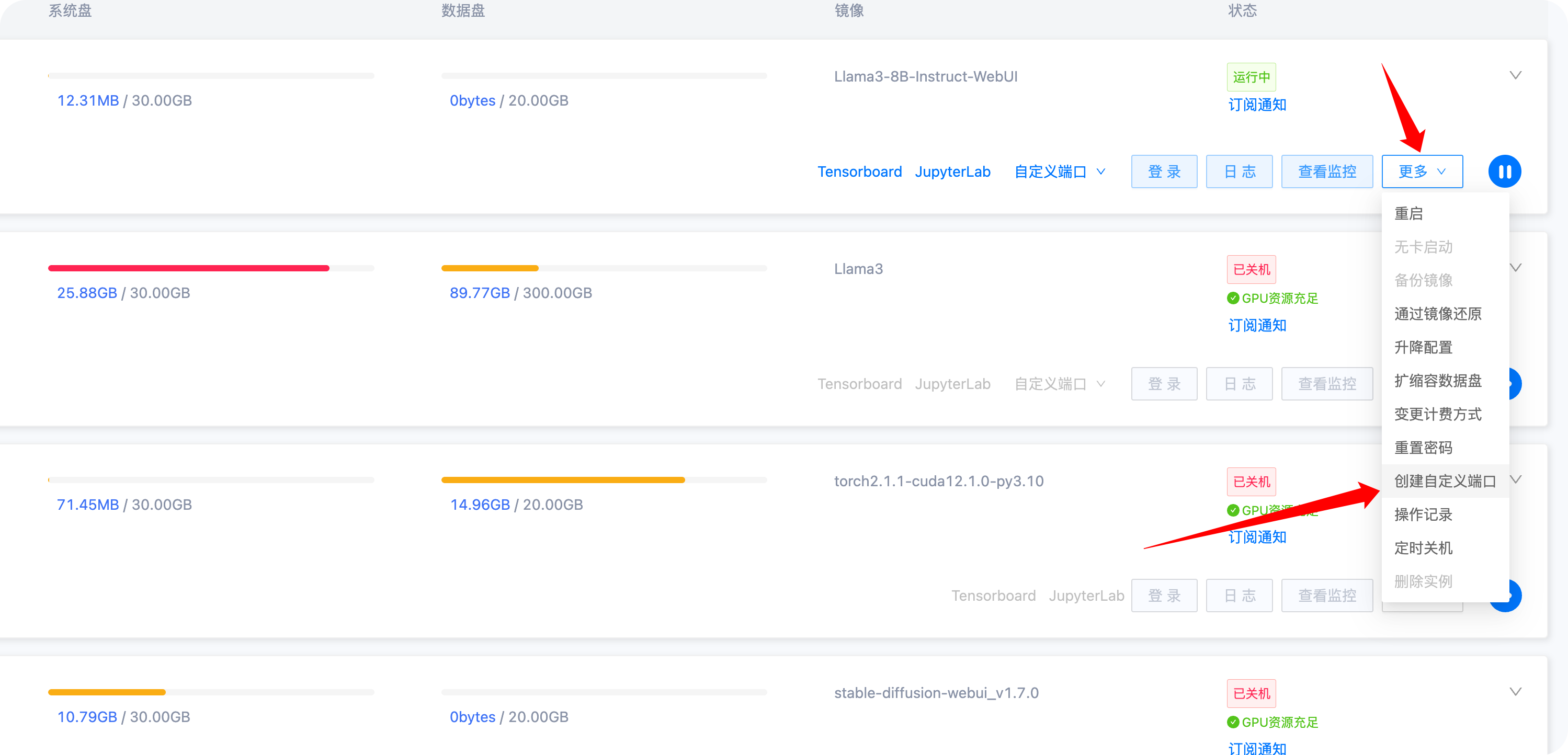

創建自定義端口

實例創建成功后,點擊更多 - 創建自定義端口

輸入7860端口(該端口為實例中?text-generation-webui?監聽的端口)

端口重置成功后點擊自定義端口7860,然后跳轉到Llama3模型的web控制臺

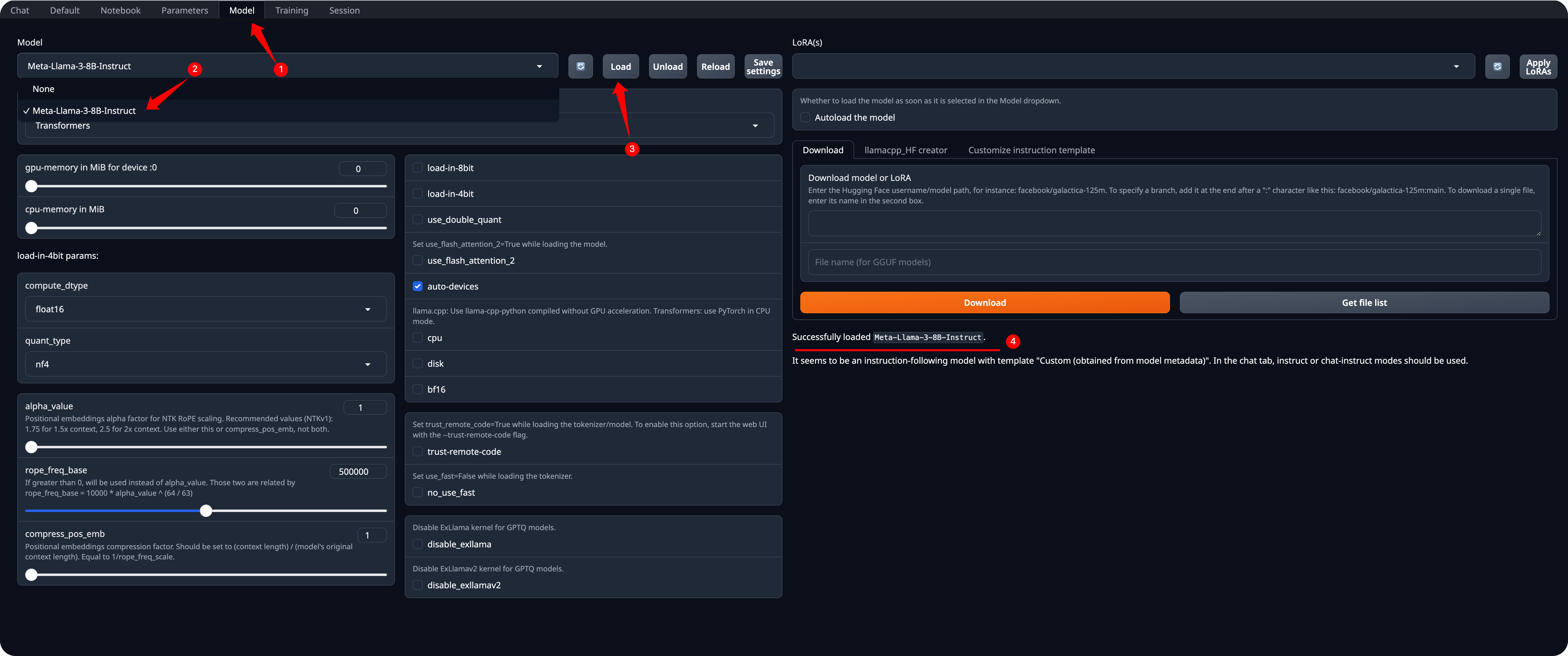

載入模型并使用

1.選擇Model

2.切換模型為Meta-Llama-3-8B-Instruct

3.點擊Load來加載模型

4.等待模型加載成功

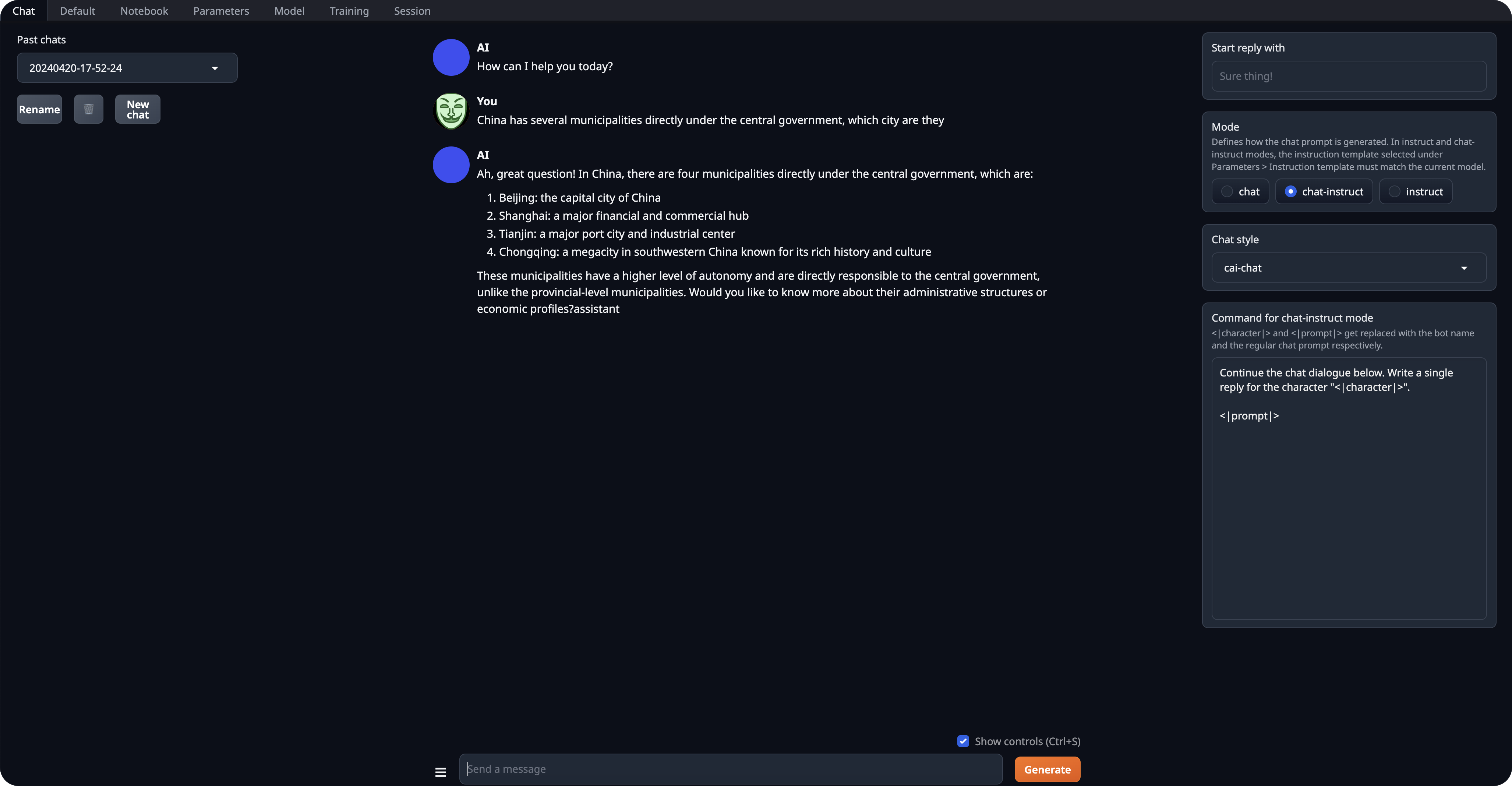

切換到Chat,然后就可以開始與Meta-Llama-3-8b-instruct模型開始對話了。

)

選擇IDE和配置環境)

)

Linux基本命令)