目錄

一、特征提取核心概念:什么是圖像特征?

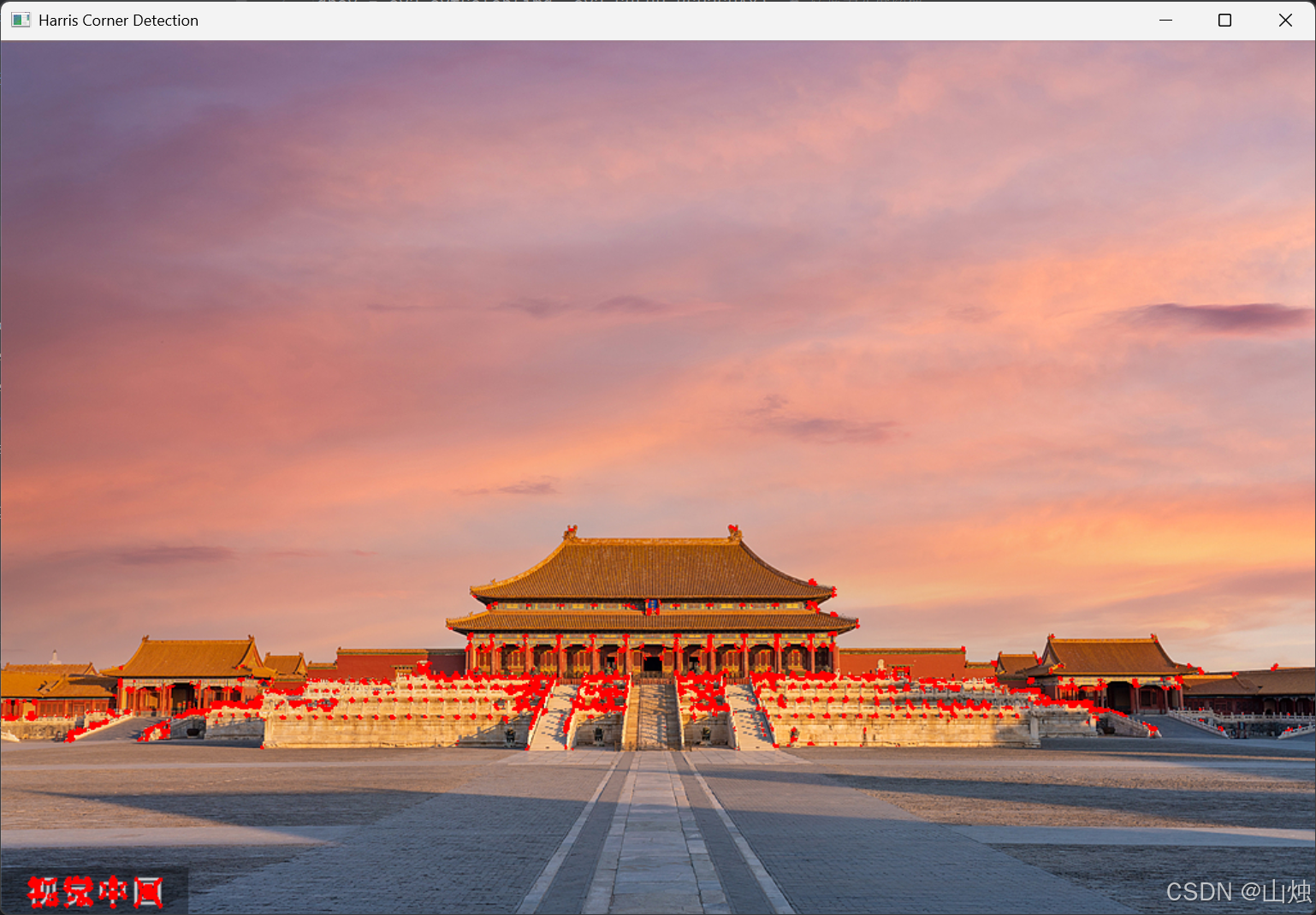

二、實戰 1:Harris 角點檢測

1.1 角點的物理意義

1.2 Harris 算法原理

1.3 OpenCV 實戰代碼與解析

1.4 結果分析

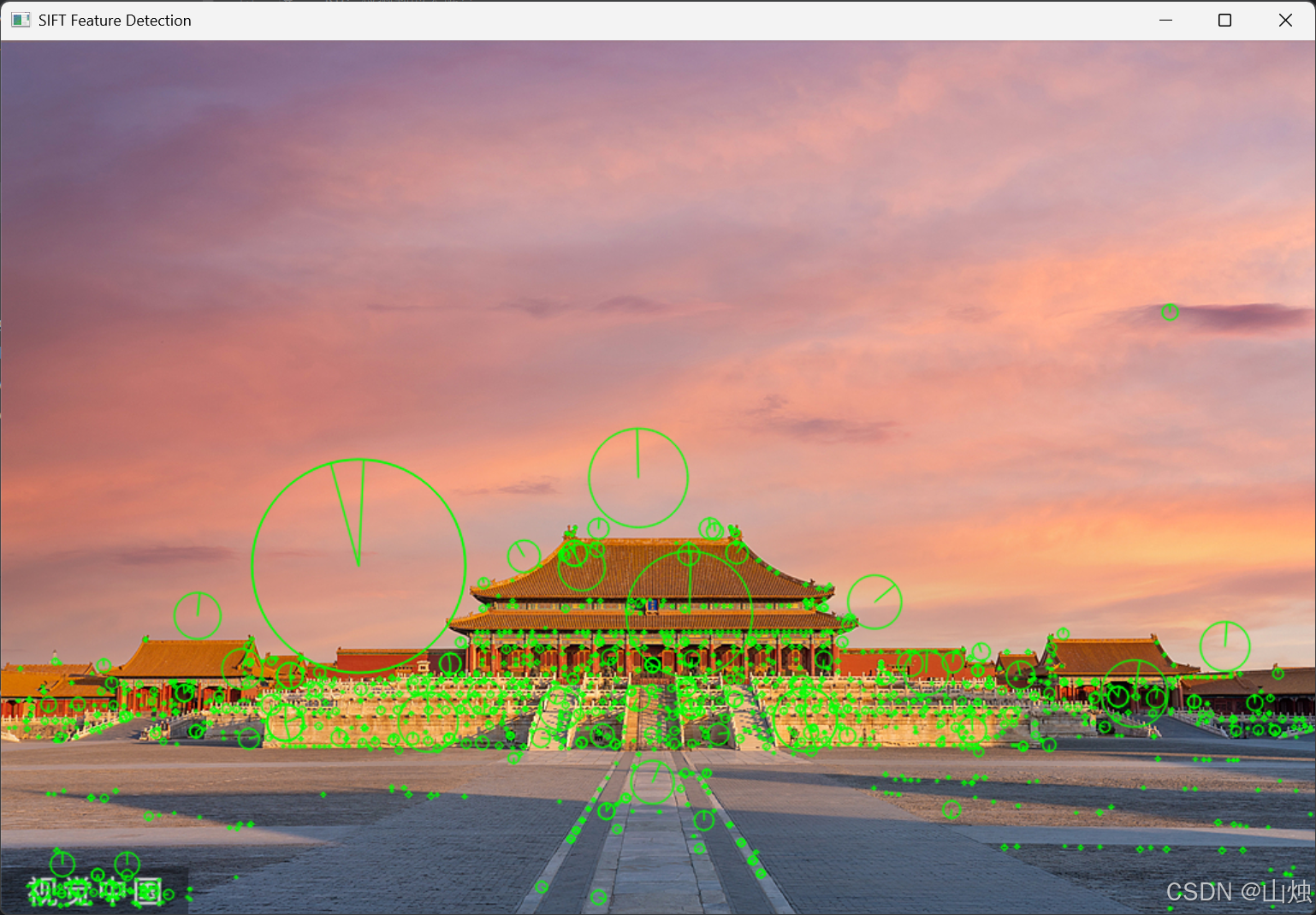

三、實戰 2:SIFT 特征提取?

3.1 SIFT 算法核心優勢

3.2 SIFT 算法步驟

3.3 OpenCV 實戰代碼與解析

3.4 關鍵點屬性解析

四、特征提取的工程應用場景

4.1 圖像拼接

4.2 目標跟蹤

4.3 文物數字化

五、常見問題與解決方案

5.1 SIFT 算法運行報錯:“module 'cv2' has no attribute 'xfeatures2d'”

5.2 角點檢測結果中 “偽角點” 過多

5.3 SIFT 特征匹配速度慢

在計算機視覺領域,特征提取是連接圖像原始像素與高層語義理解的關鍵橋梁。無論是圖像拼接、目標跟蹤,還是人臉識別、文物數字化,都依賴于高效的特征提取技術。本文將以 OpenCV 為工具,從基礎概念出發,結合實戰代碼,系統講解角點檢測、SIFT 特征提取等核心技術,幫助讀者掌握特征提取的本質與應用。

一、特征提取核心概念:什么是圖像特征?

圖像特征是圖像中具有獨特性、可區分性的 “關鍵信息”,能夠反映圖像局部或全局的本質屬性。常見的圖像特征可分為三類:

- 局部特征:如角點、邊緣、紋理,聚焦圖像局部區域的灰度變化或結構信息,適用于目標匹配、姿態估計等場景;

- 全局特征:如直方圖、圖像矩,描述整幅圖像的統計屬性,常用于圖像檢索、風格分類;

- 深度學習特征:通過 CNN 網絡自動學習的抽象特征,如 CNN 的卷積層輸出,適用于復雜場景的圖像識別。

在傳統計算機視覺中,局部特征因具備尺度不變性(對圖像縮放不敏感)、旋轉不變性(對圖像旋轉不敏感)和光照魯棒性(對光照變化不敏感),成為特征提取的核心研究對象。本文重點講解兩類經典局部特征提取技術:角點檢測(Harris 算法)與尺度不變特征變換(SIFT)。

二、實戰 1:Harris 角點檢測

1.1 角點的物理意義

角點是圖像中局部區域與周圍區域存在劇烈灰度變化的像素點,通俗來說,就是 “兩條邊緣的交點”(如矩形的四個頂點、建筑物的轉角)。角點的核心特性是:當窗口沿任意方向滑動時,窗口內像素的灰度值都會發生顯著變化,這也是 Harris 算法的核心判斷依據。

1.2 Harris 算法原理

Harris 算法通過計算圖像中每個像素的局部自相關矩陣,來量化像素的 “角點程度”。其核心步驟如下:

- 灰度化處理:將彩色圖像轉換為灰度圖像,減少計算量(顏色信息對角度檢測無關鍵影響);

- 計算梯度:使用 Sobel 算子計算像素在 x、y 方向的梯度(反映灰度變化率);

- 構建自相關矩陣:對梯度進行高斯加權(增強局部相關性),構建每個像素的 2×2 自相關矩陣;

- 計算角點響應值:通過自相關矩陣的特征值,計算角點響應值

R,公式為:

R = det(M) - k·trace(M)2

其中det(M)是矩陣行列式,trace(M)是矩陣跡,k為經驗參數(通常取 0.04~0.06); - 閾值篩選:將響應值

R大于 “0.05×R_max”(R_max 為全局最大響應值)的像素標記為角點。

1.3 OpenCV 實戰代碼與解析

以下代碼以 “故宮.jpg” 為例,實現 Harris 角點檢測,并將檢測到的角點用紅色標記:

import cv2

import numpy as np# 1. 讀取圖像并灰度化

img = cv2.imread('gugong.jpg') # 讀取彩色圖像

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY) # 轉換為灰度圖像# 2. 調用Harris角點檢測函數

# 參數說明:

# - gray:輸入灰度圖像

# - blockSize:角點檢測的鄰域大小(通常取3~5)

# - ksize:Sobel算子的窗口大小(必須為奇數,通常取3)

# - k:經驗參數(0.04~0.06)

dst = cv2.cornerHarris(gray, blockSize=4, ksize=3, k=0.04)# 3. 閾值篩選并標記角點(紅色:BGR格式為[0,0,255])

img[dst > 0.05 * dst.max()] = [0, 0, 255] # 響應值大于閾值的像素標記為紅色# 4. 顯示結果

cv2.imshow('Harris Corner Detection', img)

cv2.waitKey(0) # 等待按鍵關閉窗口

cv2.destroyAllWindows()

1.4 結果分析

運行代碼后,圖像中建筑物的轉角、欄桿的交點等角點會被紅色標記。需注意:

blockSize過小時,易受噪聲干擾(誤檢率高);過大時,會遺漏小尺度角點;- 閾值 “0.05×dst.max ()” 可根據圖像調整,若角點過多可增大閾值(如 0.1×dst.max ()),若角點過少可減小閾值(如 0.03×dst.max ())。

三、實戰 2:SIFT 特征提取?

Harris 角點檢測雖能捕捉局部特征,但存在明顯缺陷:不具備尺度不變性(同一物體在不同縮放比例下,Harris 檢測的角點可能完全不同)。而 SIFT(Scale-Invariant Feature Transform,尺度不變特征變換)算法通過 “尺度空間” 理論,解決了這一問題,成為計算機視覺領域的經典算法。

3.1 SIFT 算法核心優勢

SIFT 特征具有四大關鍵特性,使其適用于復雜場景:

- 尺度不變性:通過構建高斯金字塔,在不同尺度下檢測特征點,同一物體無論縮放多少倍,都能檢測到相同的特征;

- 旋轉不變性:為每個特征點計算主方向,使特征描述符與旋轉角度無關;

- 光照魯棒性:通過歸一化處理,減少光照變化對特征描述符的影響;

- 獨特性強:每個特征點用 128 維向量描述,能在海量特征中準確匹配。

3.2 SIFT 算法步驟

SIFT 算法分為 “特征點檢測” 和 “特征點描述” 兩大階段,共四步:

- 尺度空間構建:通過高斯模糊(不同標準差 σ)和下采樣,構建高斯金字塔,再計算相鄰層的差分(DOG,Difference of Gaussians),形成 DOG 金字塔;

- 特征點定位:在 DOG 金字塔中,通過三維插值(空間 + 尺度)找到極值點,剔除低對比度和邊緣點,得到穩定的特征點;

- 主方向分配:以特征點為中心,統計鄰域內像素的梯度方向直方圖,取直方圖峰值對應的方向作為主方向(若存在多個峰值,可分配輔方向);

- 特征描述符生成:將特征點鄰域劃分為 16 個 4×4 的子塊,每個子塊統計 8 個方向的梯度直方圖,最終形成 16×8=128 維的特征向量(即描述符)。

3.3 OpenCV 實戰代碼與解析

OpenCV 3.4 及以上版本中,SIFT 算法已集成到cv2.SIFT_create()中(需安裝opencv-contrib-python擴展庫)。以下代碼實現 SIFT 特征點檢測與可視化:

import cv2

import numpy as np# 1. 讀取圖像并灰度化

img = cv2.imread('gugong.jpg')

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)# 2. 創建SIFT對象并檢測特征點

sift = cv2.SIFT_create() # 初始化SIFT提取器

kp = sift.detect(gray, None) # 檢測特征點(kp為關鍵點列表)# 3. 可視化特征點(繪制“富信息關鍵點”:包含位置、尺度、方向)

# 參數說明:

# - img:原始圖像

# - kp:檢測到的關鍵點

# - flags=cv2.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS:繪制關鍵點的大小和方向

img_sift = cv2.drawKeypoints(image=img,keypoints=kp,outImage=None,flags=cv2.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS,color=(0, 255, 0) # 關鍵點標記為綠色

)# 4. 計算特征描述符(128維向量)

kp, des = sift.compute(img, kp) # des為描述符矩陣,形狀為(關鍵點數量, 128)# 5. 輸出特征信息并顯示結果

print(f"關鍵點數量:{np.array(kp).shape[0]}")

print(f"描述符形狀:{des.shape}") # 例如:(1200, 128)表示1200個特征點,每個用128維向量描述cv2.imshow('SIFT Feature Detection', img_sift)

cv2.waitKey(0)

cv2.destroyAllWindows()

關鍵點數量:1508

描述符形狀:(1508, 128)3.4 關鍵點屬性解析

kp(關鍵點列表)中的每個元素包含多個核心屬性,可用于后續特征匹配或分析:

kp.pt:關鍵點的坐標(x, y),如 (123.4, 45.6);kp.size:關鍵點的尺度(對應高斯金字塔的層,尺度越大,關鍵點覆蓋范圍越廣);kp.angle:關鍵點的主方向(0~360 度,順時針為正);kp.response:關鍵點的響應值(值越大,關鍵點越穩定);kp.octave:關鍵點所在的高斯金字塔層級(用于尺度恢復)。

四、特征提取的工程應用場景

特征提取技術并非孤立存在,而是支撐眾多計算機視覺應用的核心模塊。以下是三個典型應用場景:

4.1 圖像拼接

通過 SIFT 特征匹配,找到兩張重疊圖像的對應特征點,再通過單應性矩陣計算圖像的透視變換,最終將多張圖像拼接為全景圖。例如:

- 對兩張重疊的 “故宮” 圖像分別提取 SIFT 特征;

- 使用 FLANN 匹配器(快速最近鄰搜索)匹配兩張圖像的特征點;

- 剔除錯誤匹配(如通過 “比值法”:d1/d2 < 0.7,d1、d2 為最近鄰和次近鄰的距離);

- 基于正確匹配的特征點,求解透視變換矩陣;

- 調用

cv2.warpPerspective()實現圖像拼接。

4.2 目標跟蹤

在視頻跟蹤中,通過 SIFT 或 ORB(高效版 SIFT)提取初始幀的目標特征,后續幀中匹配相同特征,實現目標的實時跟蹤。相比單純的顏色跟蹤,特征跟蹤對目標旋轉、遮擋的魯棒性更強。

4.3 文物數字化

在文物保護中,通過 Harris 角點檢測捕捉文物的輪廓拐點(如青銅器的紋飾轉角),結合 SIFT 特征構建文物的 “特征圖譜”,可用于文物的碎片拼接、真偽鑒別(仿品的特征分布與真品存在差異)。

五、常見問題與解決方案

5.1 SIFT 算法運行報錯:“module 'cv2' has no attribute 'xfeatures2d'”

原因:OpenCV 官方版本中,SIFT 等專利算法已移至opencv-contrib-python擴展庫,需單獨安裝。

解決方案:

卸載原 OpenCV,安裝指定版本的擴展庫(避免版本兼容性問題):

pip uninstall opencv-python

pip install opencv-python==3.4.18.65

pip install opencv-contrib-python==3.4.18.65

5.2 角點檢測結果中 “偽角點” 過多

原因:圖像噪聲干擾、blockSize過小或閾值過低。

解決方案:

- 先對圖像進行高斯模糊(

cv2.GaussianBlur(gray, (3,3), 0)),減少噪聲; - 增大

blockSize(如從 3 調整為 5); - 提高閾值(如從 0.05×dst.max () 調整為 0.1×dst.max ())。

5.3 SIFT 特征匹配速度慢

原因:SIFT 描述符為 128 維,暴力匹配(cv2.BFMatcher())的時間復雜度高。

解決方案:使用 FLANN 匹配器(cv2.FlannBasedMatcher()),通過索引加速匹配,適用于海量特征點場景:

# FLANN匹配器示例

FLANN_INDEX_KDTREE = 1

index_params = dict(algorithm=FLANN_INDEX_KDTREE, trees=5)

search_params = dict(checks=50) # checks越大,匹配越準確,但速度越慢

flann = cv2.FlannBasedMatcher(index_params, search_params)

matches = flann.knnMatch(des1, des2, k=2) # des1、des2為兩張圖像的描述符

詳解(環境搭建+項目開發示例))

基礎概念)

)

:基于IMX6ULL的點燈操作》)

![洛谷P9468 [EGOI 2023] Candy / 糖果題解](http://pic.xiahunao.cn/洛谷P9468 [EGOI 2023] Candy / 糖果題解)

大模型入門【3】--基于Chailit客服端實現頁面AI對話)