?作者主頁:IT畢設夢工廠?

個人簡介:曾從事計算機專業培訓教學,擅長Java、Python、PHP、.NET、Node.js、GO、微信小程序、安卓Android等項目實戰。接項目定制開發、代碼講解、答辯教學、文檔編寫、降重等。

?文末獲取源碼?

精彩專欄推薦???

Java項目

Python項目

安卓項目

微信小程序項目

文章目錄

- 一、前言

- 二、開發環境

- 三、系統界面展示

- 四、部分代碼設計

- 五、系統視頻

- 結語

一、前言

系統介紹:

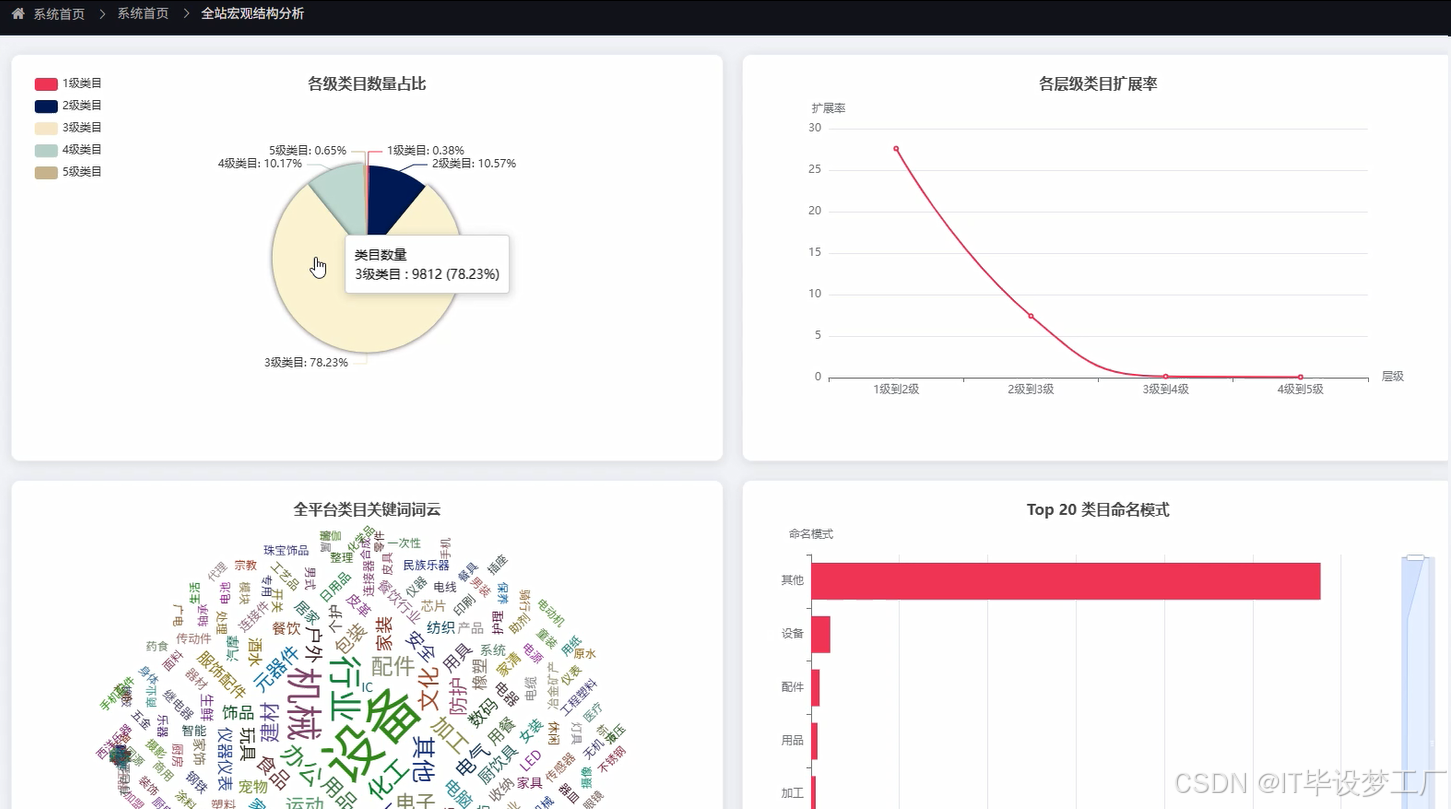

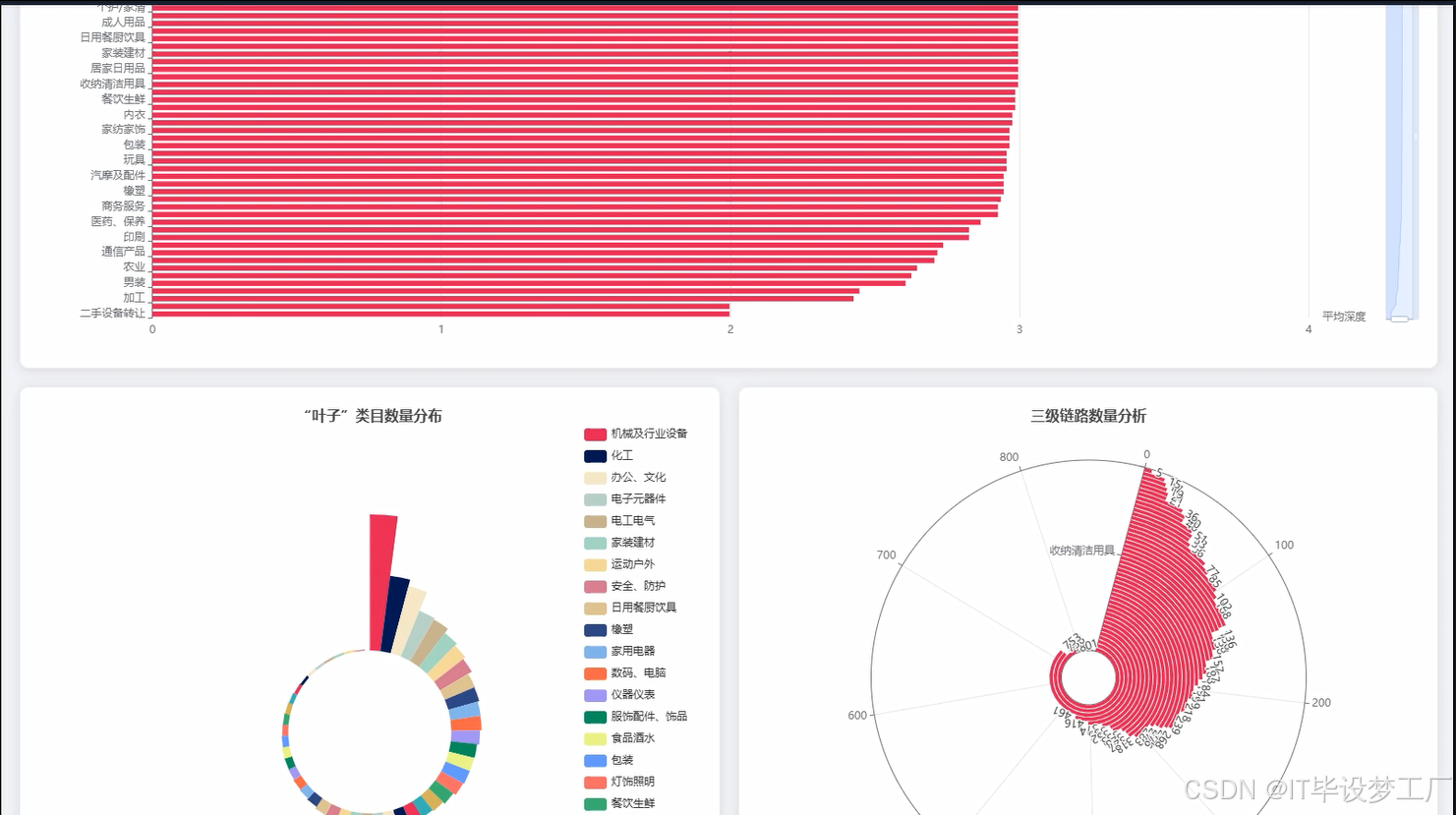

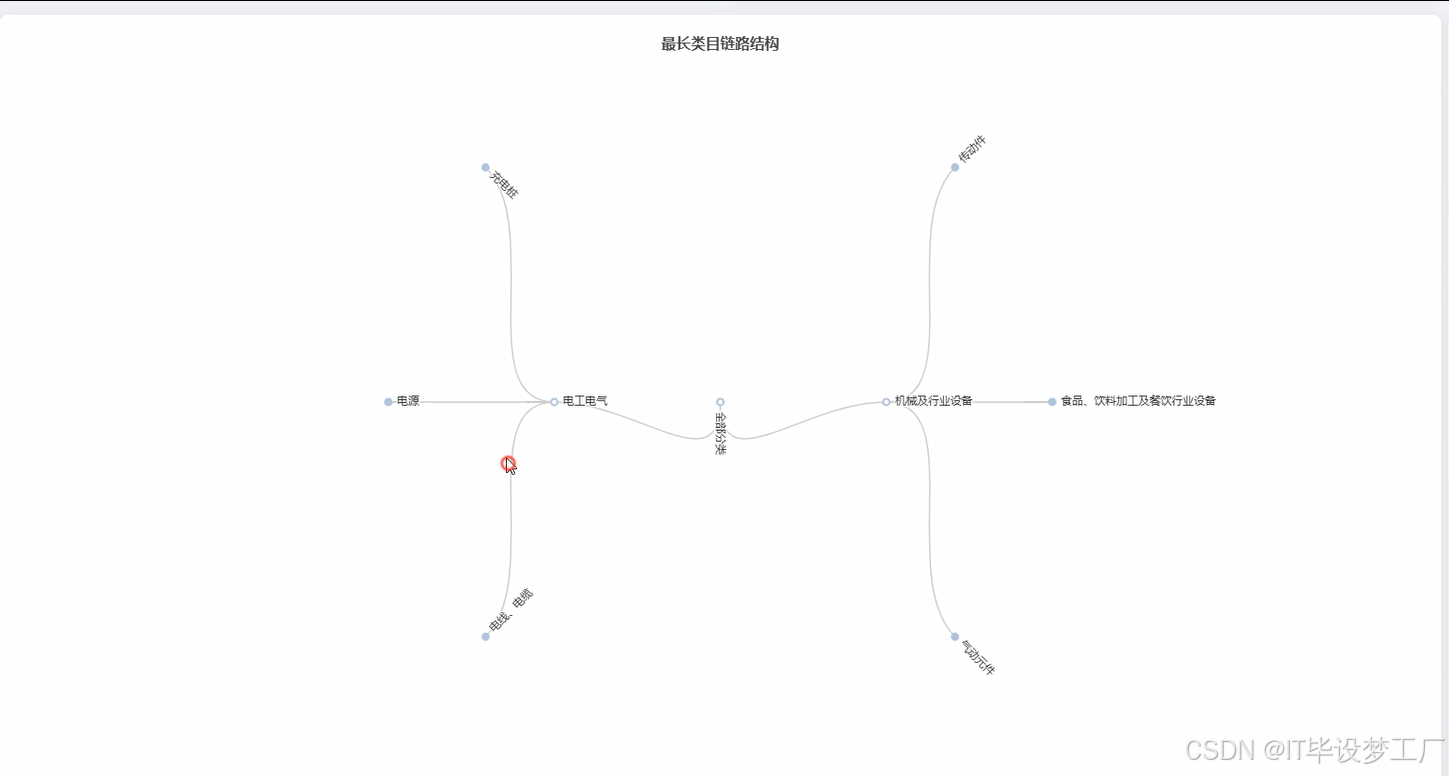

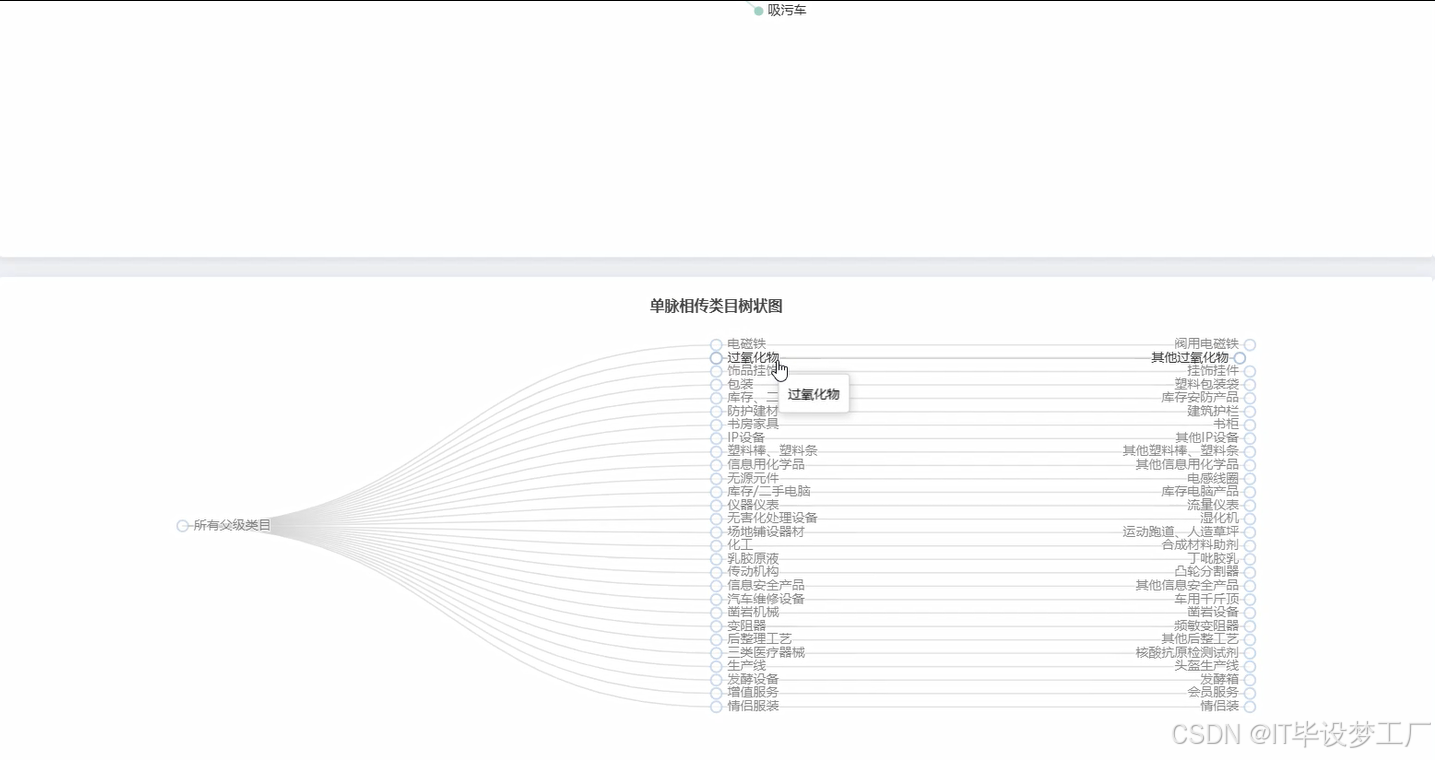

本系統“基于大數據的1688商品類目關系分析與可視化系統”旨在通過對1688平臺商品類目進行全面的分析,利用大數據技術對商品類目之間的層級關系、關鍵詞分布和業務關聯進行深度挖掘,并通過可視化手段展示各類目之間的內在聯系與市場結構。系統基于Hadoop與Spark的分布式處理框架,通過Python、Java(兩個版本),后端采用Django、Spring Boot框架(兩個版本),前端利用Vue、ElementUI、Echarts等現代Web技術提供靈活的數據展示與交互界面。通過對商品類目的多維度分析與可視化展示,幫助用戶深入理解平臺商品的分類結構,發現潛在的市場機會。

選題背景:

隨著互聯網電商平臺的迅猛發展,商品分類體系成為平臺運營和商品管理的重要組成部分。1688作為阿里巴巴集團的B2B平臺,匯聚了大量的商品和供應商,其商品類目體系涵蓋了多個行業和領域。平臺上商品類目的組織結構影響著商品的曝光度、購買流量以及供應鏈的效率。尤其是在大數據時代,商品類目之間的關系數據日益龐大且復雜,傳統的手動分析方式已經無法滿足實時數據分析的需求。因此,利用大數據技術對1688商品類目的關系進行全面剖析,已經成為一種迫切需求。通過對這些大數據的分析,能夠有效識別出商品類目之間的關聯模式,優化平臺的商品分類體系,提高平臺的商品管理效率。

選題意義:

本課題的研究意義體現在多個方面。首先,從學術角度來看,商品類目的層級關系與結構化分析屬于電商平臺大數據領域的前沿課題,通過對類目體系的深入挖掘,可以為電商平臺的運營研究提供新的思路與方法。其次,從實踐應用的角度,本系統能幫助1688平臺和類似電商平臺在商品分類和管理上獲得精準的決策支持。通過對平臺商品類目的全面分析,商家和平臺管理者可以更好地理解市場趨勢,進行精準的市場定位,優化產品推薦和推廣策略。此外,系統對類目層級關系的可視化展示,有助于用戶更加直觀地了解平臺商品結構,提升用戶體驗。最后,結合大數據技術,系統能夠在海量數據中快速識別出潛在的商品關系和市場趨勢,具有顯著的商業價值和社會價值。

二、開發環境

- 大數據框架:Hadoop+Spark(本次沒用Hive,支持定制)

- 開發語言:Python+Java(兩個版本都支持)

- 后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(兩個版本都支持)

- 前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

- 詳細技術點:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy

- 數據庫:MySQL

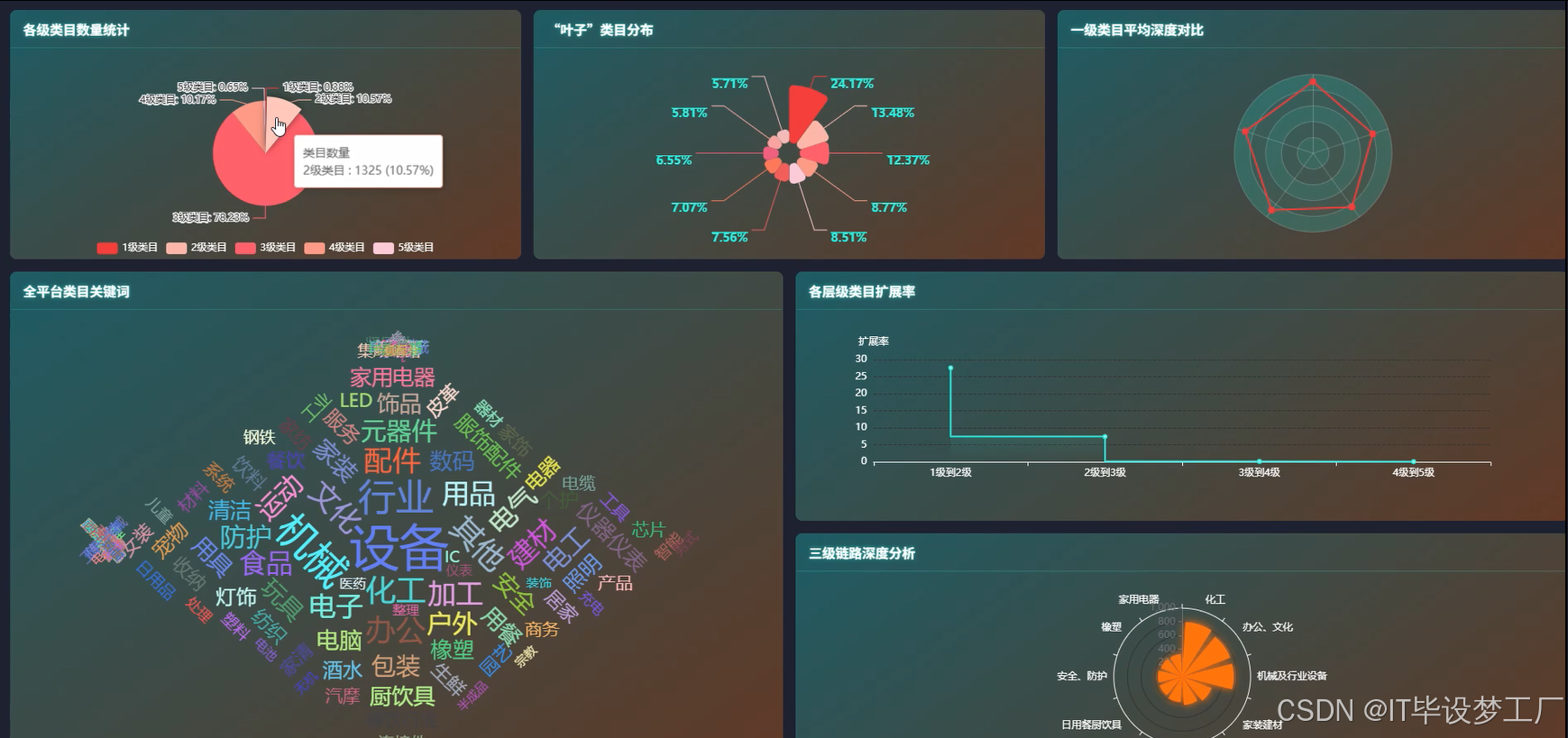

三、系統界面展示

- 基于大數據的1688商品類目關系分析與可視化系統界面展示:

四、部分代碼設計

- 項目實戰-代碼參考:

# 引入大數據處理框架

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, countDistinct

import pandas as pd

import numpy as np# 初始化SparkSession

spark = SparkSession.builder \.appName("1688商品類目分析") \.getOrCreate()# 核心功能1: 全站各級類目數量統計

def category_level_count(dataframe):# 從數據框中提取各個級別類目level_1_count = dataframe.select("一級類目名").distinct().count()level_2_count = dataframe.select("二級類目名").distinct().count()level_3_count = dataframe.select("三級類目名").distinct().count()level_4_count = dataframe.select("四級類目名").distinct().count()level_5_count = dataframe.select("五級類目名").distinct().count()# 返回各級類目的數量return {"一級類目": level_1_count, "二級類目": level_2_count, "三級類目": level_3_count, "四級類目": level_4_count, "五級類目": level_5_count}# 核心功能2: 各一級類目下二級類目數量對比

def category_depth_comparison(dataframe):# 按一級類目分組,計算每個一級類目下二級類目數量result = dataframe.groupBy("一級類目名").agg(countDistinct("二級類目名").alias("二級類目數"))result.show() # 顯示結果# 轉換為Pandas DataFrame以進行后續處理result_pdf = result.toPandas()return result_pdf# 核心功能3: 類目層級深度分布分析

def category_depth_distribution(dataframe):# 計算每個類目的深度(即非空的類目字段數)dataframe = dataframe.withColumn("深度", (col("一級類目名").isNotNull().cast("int") + col("二級類目名").isNotNull().cast("int") + col("三級類目名").isNotNull().cast("int") + col("四級類目名").isNotNull().cast("int") + col("五級類目名").isNotNull().cast("int")))# 統計不同深度的類目數量depth_dist = dataframe.groupBy("深度").count().orderBy("深度")depth_dist.show() # 顯示深度分布return depth_dist# 核心功能4: 類目網絡“度中心性”Top N分析

def category_network_degree_analysis(dataframe):# 轉換為圖結構,計算每個類目的連接數(即度)edges = dataframe.select("父類目", "子類目").distinct()vertices = edges.select("父類目").distinct().union(edges.select("子類目").distinct()).distinct()# 創建圖對象from pyspark.graphx import Graphgraph = Graph(vertices.rdd, edges.rdd)degree = graph.degreestop_degree = degree.orderBy(degree["degree"], ascending=False).limit(10)top_degree.show() # 顯示度中心性Top Nreturn top_degree# 核心功能5: 類目“社群”結構發現

def category_community_detection(dataframe):# 將類目轉換為圖數據格式,進行社群發現edges = dataframe.select("父類目", "子類目").distinct()from pyspark.graphx import Graphvertices = edges.select("父類目").distinct().union(edges.select("子類目").distinct()).distinct()graph = Graph(vertices.rdd, edges.rdd)communities = graph.connectedComponents()# 提取社群信息communities.show() # 顯示社群分布return communities五、系統視頻

- 基于大數據的1688商品類目關系分析與可視化系統-項目視頻:

大數據畢業設計選題推薦-基于大數據的1688商品類目關系分析與可視化系統-Hadoop-Spark-數據可視化-BigData

結語

大數據畢業設計選題推薦-基于大數據的1688商品類目關系分析與可視化系統-Hadoop-Spark-數據可視化-BigData

大家可以幫忙點贊、收藏、關注、評論啦~

源碼獲取:???

精彩專欄推薦???

Java項目

Python項目

安卓項目

微信小程序項目

day58)

與機器翻譯的結合應用)

)

:原理剖析與實戰 SOP)

------詞向量轉化的算法思想詳解與基于詞向量轉換的文本數據處理的好評差評分類實戰(NPL基礎實戰))

)