【1】引言

前序學習進程中,已經對線性回歸和嶺回歸做了初步解讀。

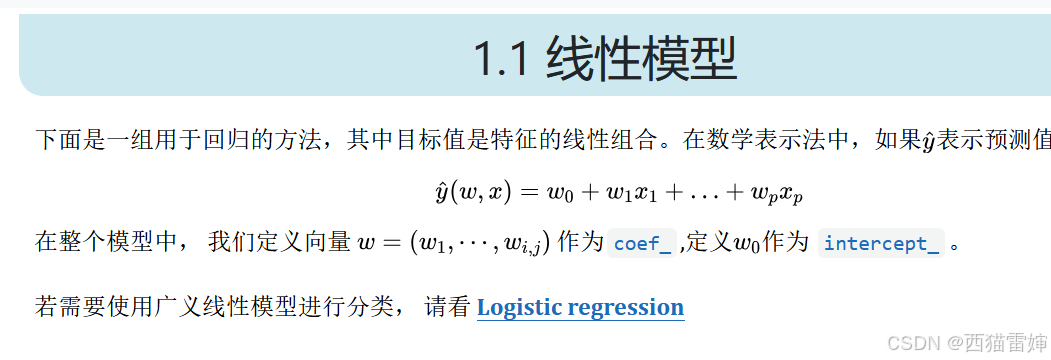

實際上, Logistic regression是一種廣義的線性模型,在對線性分類的進一步學習前,有必要了解 Logistic regression。

【2】Logistic regression的3種成本函數

點擊下方鏈接直達官網學習教程:logistic regression

Logistic regression是Logistic回歸所使用的算法,包括的成本函數有3種,具體為:

L2L2L2正則化成本函數:

min?12wTw+C∑i=1nlog(exp(?yi(XiTw+c))+1)\min\frac{1}{2}w^Tw+C\sum_{i=1}^{n}log(exp(-y_{i}(X_{i}^Tw+c))+1)min21?wTw+Ci=1∑n?log(exp(?yi?(XiT?w+c))+1)

L1L1L1正則化成本函數:

min?∣∣w∣∣1+C∑i=1nlog(exp(?yi(XiTw+c))+1)\min||w||_{1}+C\sum_{i=1}^{n}log(exp(-y_{i}(X_{i}^Tw+c))+1)min∣∣w∣∣1?+Ci=1∑n?log(exp(?yi?(XiT?w+c))+1)

彈性網正則化成本,結合了L2L2L2正則化和L1L1L1正則化的成本函數:

min?1?ρ2wTw+ρ∣∣w∣∣1+C∑i=1nlog(exp(?yi(XiTw+c))+1)\min\frac{1-\rho}{2}w^Tw+\rho||w||_{1}+C\sum_{i=1}^{n}log(exp(-y_{i}(X_{i}^Tw+c))+1)min21?ρ?wTw+ρ∣∣w∣∣1?+Ci=1∑n?log(exp(?yi?(XiT?w+c))+1)

顯然,當ρ=1\rho=1ρ=1時,彈性網正則化等價于L1L1L1正則化

當ρ=0\rho=0ρ=0時,彈性網正則化等價于L2L2L2正則化。

【3】總結

學習了Logistic regression的3種成本函數。

vs TinyMCE:哪個更適合你的技術棧?)

)

)

![[逆向知識] AST抽象語法樹:混淆與反混淆的邏輯互換(一)](http://pic.xiahunao.cn/[逆向知識] AST抽象語法樹:混淆與反混淆的邏輯互換(一))

)

)