一文讀懂GPU最強輔助:HBM

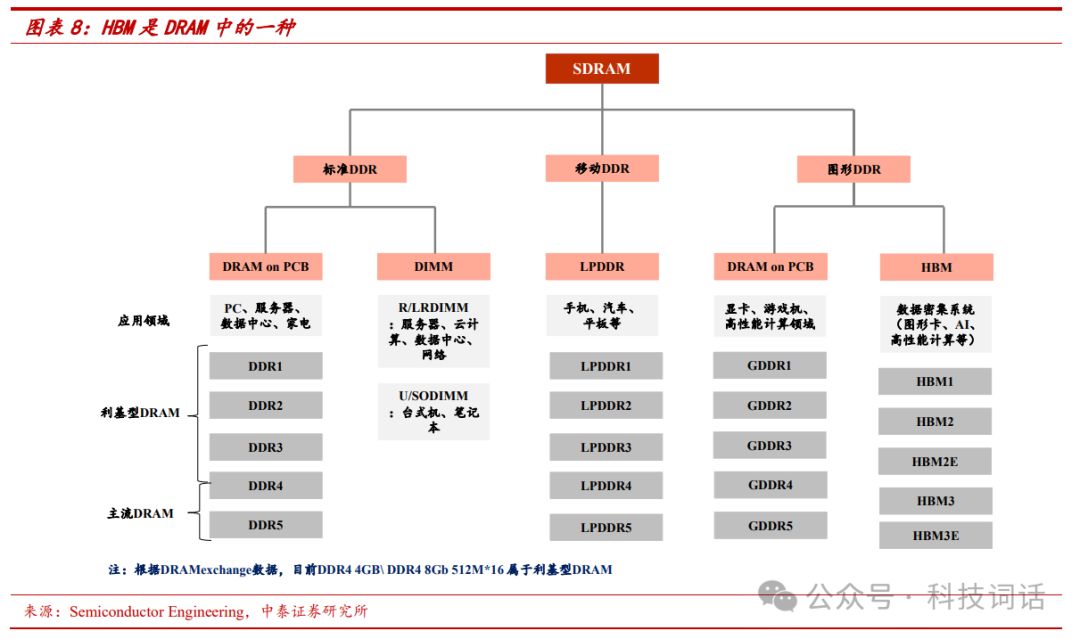

HBM,即高帶寬內存,是一項領先的3D堆疊DRAM技術,專為高性能計算和圖形處理單元(GPU)設計,滿足其對內存帶寬和容量的極致需求。該技術由AMD與海力士攜手研發,并于2013年問世,為行業帶來革命性突破。

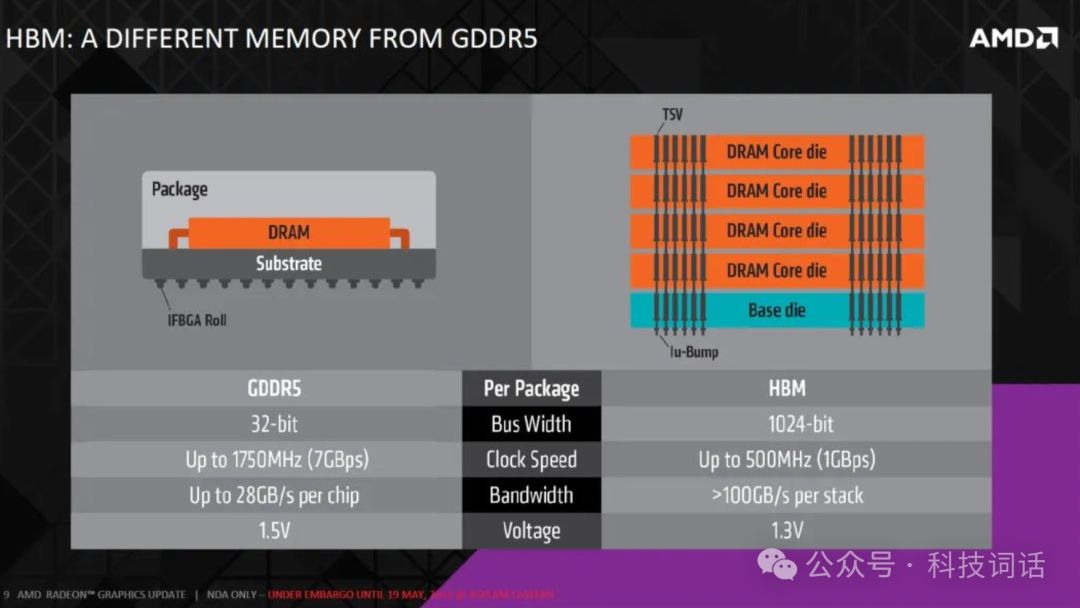

隨著計算需求的不斷增長,傳統的內存技術已經難以滿足高性能計算(HPC)和圖形處理單元(GPU)對內存帶寬和容量的日益增長的需求。在這樣的背景下,高帶寬內存(HBM)技術應運而生,為解決這一問題提供了創新性的解決方案。 HBM是一種3D堆疊DRAM技術,它通過將多個DRAM芯片層疊在一起,并使用高密度的硅通孔(TSV)和微凸點(microbumps)技術,實現與處理器或GPU的垂直互連。這種設計大幅提高了內存的帶寬和容量,同時減小了內存模塊的物理尺寸。與傳統的GDDR5內存相比,HBM由于其緊湊的設計和高效的數據傳輸,通常具有更低的功耗。

HBM是一種3D堆疊DRAM技術,它通過將多個DRAM芯片層疊在一起,并使用高密度的硅通孔(TSV)和微凸點(microbumps)技術,實現與處理器或GPU的垂直互連。這種設計大幅提高了內存的帶寬和容量,同時減小了內存模塊的物理尺寸。與傳統的GDDR5內存相比,HBM由于其緊湊的設計和高效的數據傳輸,通常具有更低的功耗。

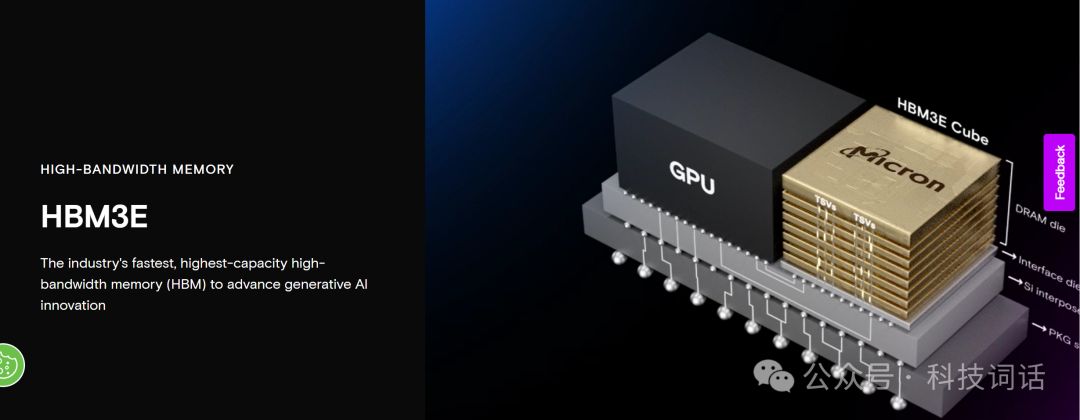

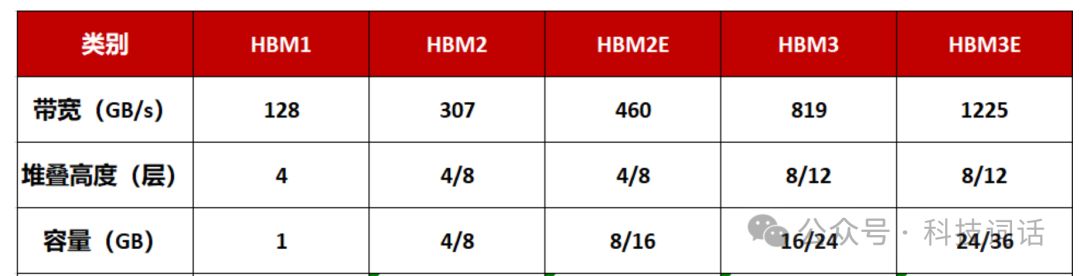

HBM產品系列已進化至第五代HBM3E,作為HBM3的擴展版,持續引領技術前沿。GPU現普遍支持2至8顆堆疊,最大堆疊層數達12層,展現了卓越的集成與性能優勢。

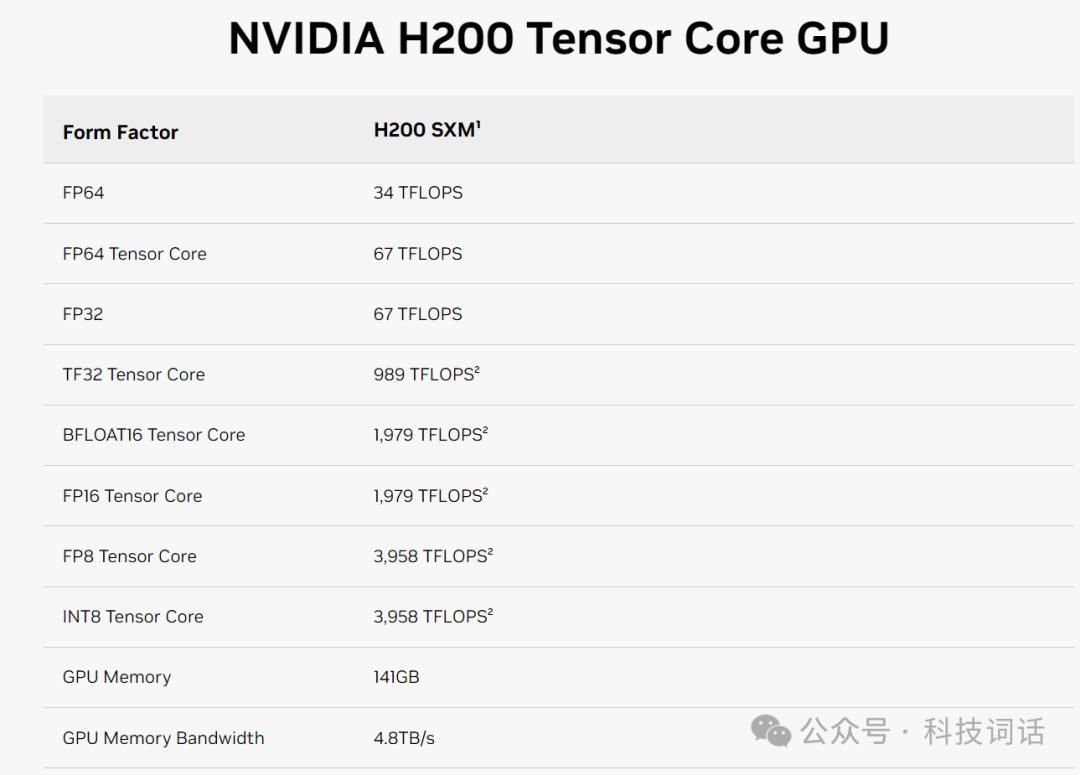

美光科技于2月26日宣布批量生產HBM3E高帶寬內存,其24GB 8H產品將供貨給英偉達,并用于H200 Tensor Core GPU。這款內存擁有24GB大容量,引腳速度突破9.2Gb/s,提供高達1.2TB/s的內存帶寬,為AI加速器、超級計算機等數據應用帶來前所未有的閃電速度。美光HBM3E,引領內存技術新篇章。

英偉達H200 GPU搭載6顆美光HBM3E 24GB高速顯存,理論上內存容量應為144GB,帶寬達7.2TB/s。然而,量產考量下,英偉達官網顯示其顯存為141GB,帶寬為4.8TB/s。這一調整旨在通過保留冗余空間,提升產品良品率,確保用戶獲得穩定高效的AI訓練體驗。

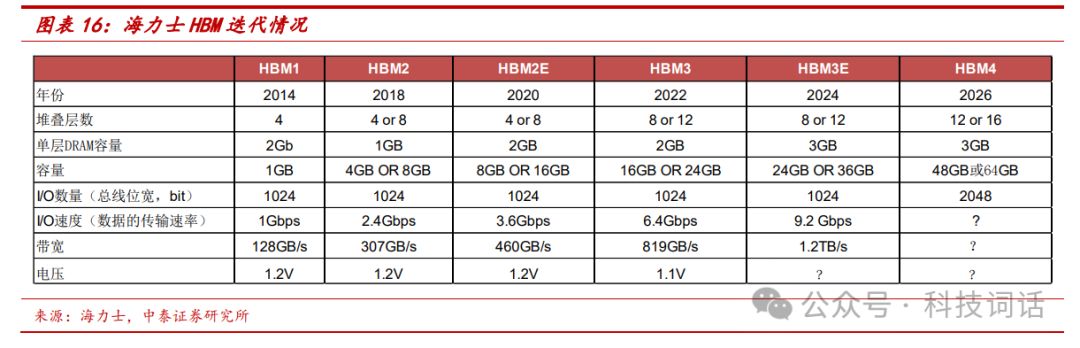

HBM 不斷迭代,迭代方向為增加容量和帶寬,目前最高層數為12層。海力士 2014 年推出全世界第一顆 HBM,2018 年推出 HBM2,后續每隔兩年推出新一代HBM,目前最新量產的是HBM3e,原廠加速研發,HBM4 可能采用16層堆 疊。從 I/O 數量看(總線位寬),HBM1到HBM3e均保持在1024bit, 而數據的傳輸速率從HBM1的1Gb/s 提升到 HBM3e的9.2Gb/s,最終實現帶寬從HBM1的128GB/s 提升至 HBM3e的1.2TB/s。

HBM4的標準目前未確定,目前普遍預期HBM4最高16層堆疊,2048bit總線位寬。

HBM市場主要由三大存儲巨頭所主導:

SK海力士,HBM技術的領軍者,從早期開發到技術迭代如HBM2、HBM2E至HBM3,均保持領先地位。其卓越的創新和量產能力,使其成為偉達AI芯片HBM的首選供應商,市場份額遙遙領先,彰顯技術實力與行業地位。

三星電子:三星電子是全球領先的半導體公司之一,在HBM技術方面也具有強大的研發和生產能力。三星電子不僅在HBM的研發上投入巨大,還積極擴大產能以滿足市場需求。三星電子在HBM技術上的進展,包括開發更高密度和更大容量的產品,對提升其在高性能計算和AI領域的競爭力起到了關鍵作用。三星著重滿足其他云端服務業者的訂單,在客戶加單下,預計在 HBM3 與海力士的市占率差距會大幅縮小,

2023~2024 年三星和海力士市占率預估相當,合計擁 HBM 市場約 95%的市占率。

美光科技雖在HBM市場起步晚于SK海力士和三星,但憑借直接從HBM3E切入并快速增強技術實力,正逐步挑戰市場格局。盡管市場份額尚低,但英偉達在H200中選用美光產品,展現了對其的高度認可,美光正在迅速追趕中。

-對此,您有什么看法見解?-

-歡迎在評論區留言探討和分享。-

搞清楚了!)

(算法導論習題第二十四章))

)

![[數據集][圖像分類]蘑菇分類數據集3122張215類別](http://pic.xiahunao.cn/[數據集][圖像分類]蘑菇分類數據集3122張215類別)

)