方法一. 利用pytorch自身

PyTorch是一個流行的深度學習框架,它允許研究人員和開發者快速構建和訓練神經網絡。計算一個PyTorch網絡的參數量通常涉及兩個步驟:確定網絡中每個層的參數數量,并將它們加起來得到總數。

以下是在PyTorch中計算網絡參數量的一般方法:

-

定義網絡結構:首先,你需要定義你的網絡結構,通常通過繼承

torch.nn.Module類并實現一個構造函數來完成。 -

計算單個層的參數量:對于網絡中的每個層,你可以通過檢查層的

weight和bias屬性來計算參數量。例如,對于一個全連接層(torch.nn.Linear),它的參數量由輸入特征數、輸出特征數和偏置項決定。 -

遍歷網絡并累加參數:使用一個循環遍歷網絡中的所有層,并累加它們的參數量。

-

考慮非參數層:有些層可能沒有可訓練參數,例如激活層(如ReLU)。這些層雖然對網絡功能至關重要,但對參數量的計算沒有貢獻。

下面是一個示例代碼,展示如何計算一個簡單網絡的參數量:

import torch

import torch.nn as nnclass SimpleNet(nn.Module):def __init__(self):super(SimpleNet, self).__init__()self.fc1 = nn.Linear(10, 20) # 10個輸入特征到20個輸出特征的全連接層self.fc2 = nn.Linear(20, 30) # 20個輸入特征到30個輸出特征的全連接層# 假設還有一個ReLU激活層,但它沒有參數def forward(self, x):x = self.fc1(x)x = torch.relu(x) # 激活層x = self.fc2(x)return x# 實例化網絡

net = SimpleNet()# 計算總參數量

total_params = sum(p.numel() for p in net.parameters() if p.requires_grad)

print(f'Total number of parameters: {total_params}')

在這個例子中,numel()函數用于計算張量中元素的數量,requires_grad=True確保只計算那些需要在反向傳播中更新的參數。

請注意,這個示例只計算了網絡中需要梯度的參數,也就是那些可訓練的參數。如果你想要計算所有參數,包括那些不需要梯度的,可以去掉if p.requires_grad的條件。

方法二. 利用torchsummary

在PyTorch中,可以使用torchsummary庫來計算神經網絡的參數量。首先,確保已經安裝了torchsummary庫:

pip install torchsummary

然后,按照以下步驟計算網絡的參數量:

- 導入所需的庫和模塊:

import torch

from torchsummary import summary

- 定義網絡模型:

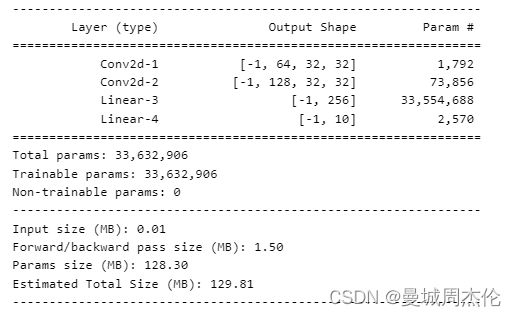

class Net(torch.nn.Module):def __init__(self):super(Net, self).__init__()self.conv1 = torch.nn.Conv2d(3, 64, kernel_size=3, stride=1, padding=1)self.conv2 = torch.nn.Conv2d(64, 128, kernel_size=3, stride=1, padding=1)self.fc1 = torch.nn.Linear(128 * 32 * 32, 256)self.fc2 = torch.nn.Linear(256, 10)def forward(self, x):x = torch.nn.functional.relu(self.conv1(x))x = torch.nn.functional.relu(self.conv2(x))x = x.view(-1, 128 * 32 * 32)x = torch.nn.functional.relu(self.fc1(x))x = self.fc2(x)return xmodel = Net()

- 使用

summary函數計算參數量:

summary(model, (3, 32, 32))

這里的(3, 32, 32)是輸入數據的形狀,根據實際情況進行修改。

運行以上代碼后,將會輸出網絡的結構以及每一層的參數量和總參數量。

| 文件系統和諧共處的基礎)

)

并不可怕,可怕的是...)

![[ACTF新生賽2020]SoulLike](http://pic.xiahunao.cn/[ACTF新生賽2020]SoulLike)

。Javaee項目,ssm vue前后端分離項目)