前言

Ollama 是一個開源的本地化大模型運行平臺,支持用戶直接在個人計算機上部署、管理和交互大型語言模型(LLMs),無需依賴云端服務。而且其混合推理的特性也使得CPU和GPU的算力能夠充分被使用,能夠在同等配置下跑更大的模型,是非常適合個人學習使用的平臺。本篇將詳細介紹Ollama在各種平臺上的詳細安裝過程以及應用。

Ollama的安裝

官網地址:https://ollama.com/

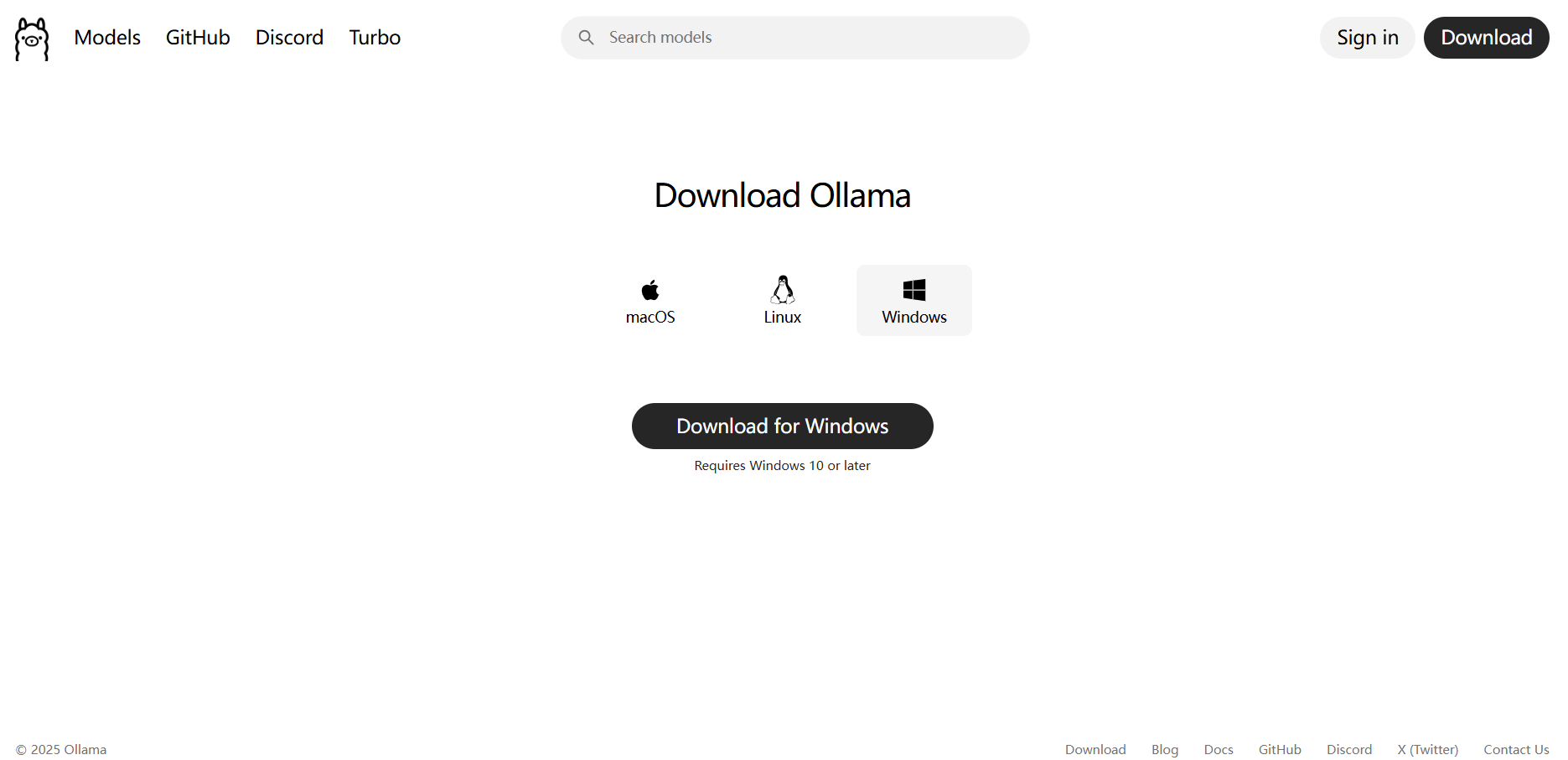

進到官網之后點擊Download然后就可以選擇相應的安裝包

在線安裝

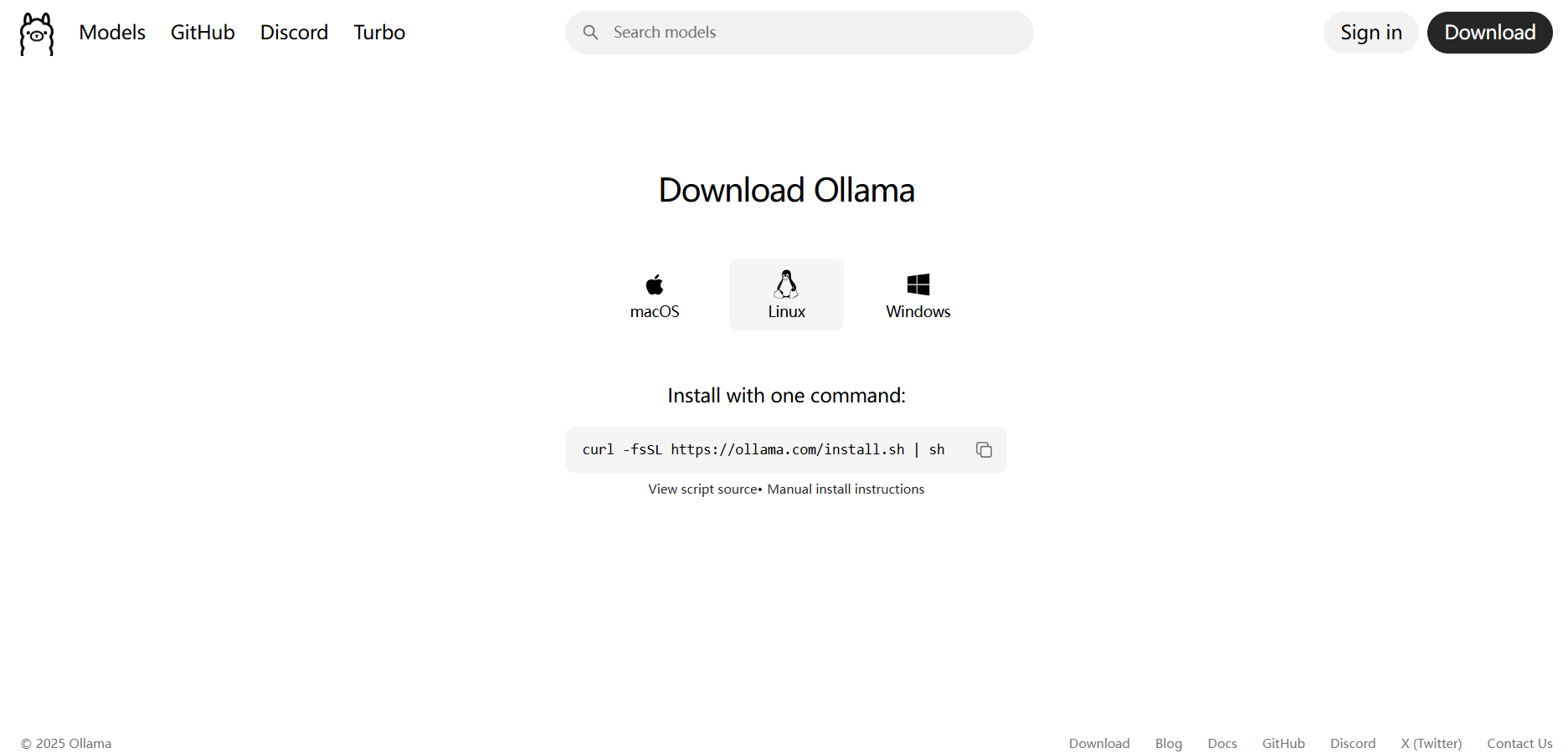

Windows環境下下載安裝根據安裝包指引下載安裝即可,linux環境下執行以下命令:

curl -fsSL https://ollama.com/install.sh | sh

離線安裝

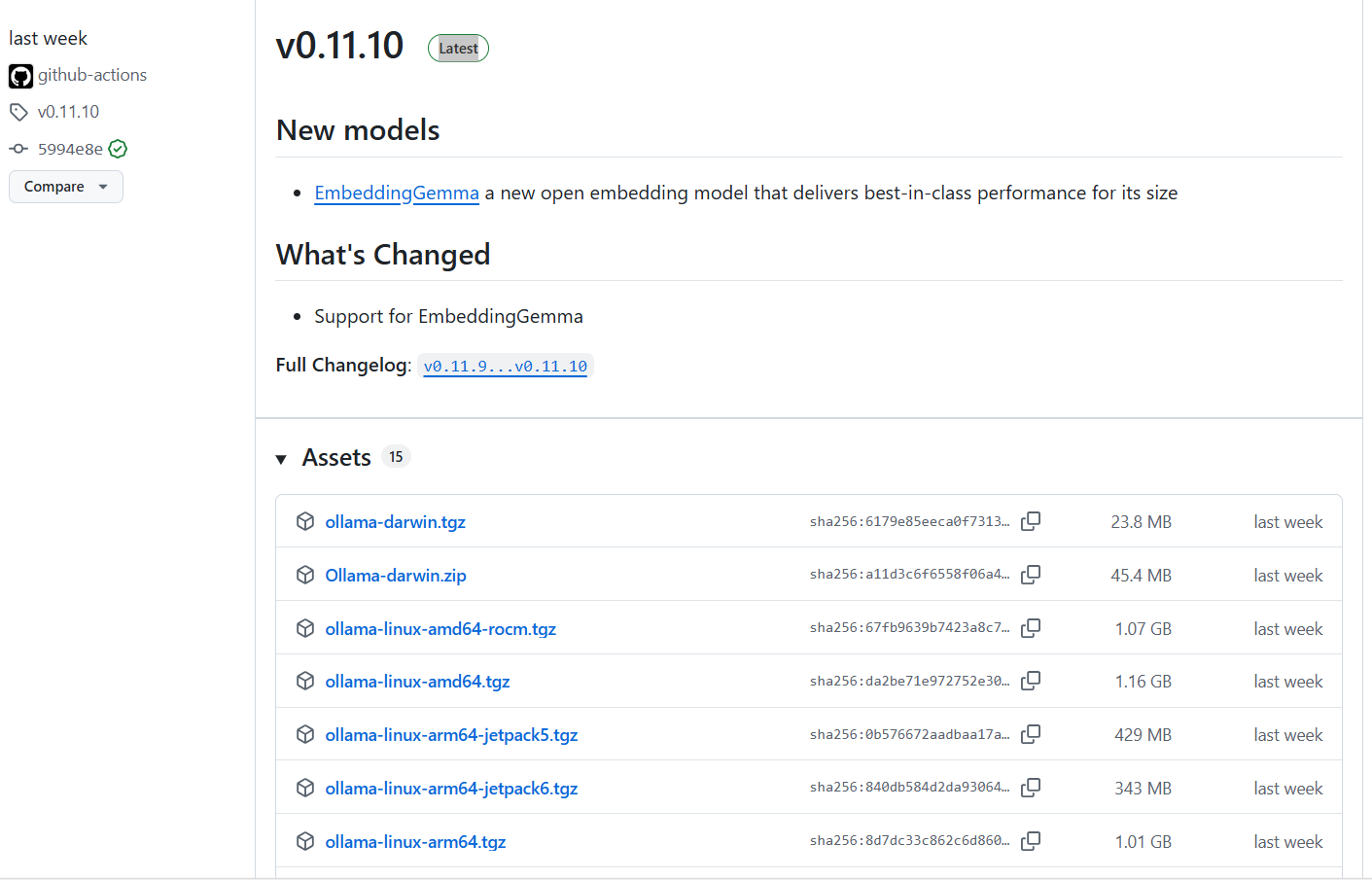

在線安裝受網絡的影響,并不能完全解決所有的安裝問題,那么就可以選擇離線安裝的方式安裝Ollama。

離線包下載地址:https://github.com/ollama/ollama/releases

由于Windows可以直接在官網下載安裝包并安裝,本文以Linux-amd64環境下的安裝為例

下載好壓縮包后,新建一個文件夾名為ollama,然后解壓

mkdir ./ollama

tar -zxvf ollama-linux-amd64.tgz -C ./ollama

為ollama添加執行權限

cd ./bin

chmod +x ollama

添加環境變量

在 .bashrc 文件結尾寫入ollama/bin文件路徑

vi ~/.bashrc

然后在下面添加以下內容(假設壓縮包下載的路徑為/home/data,讀者應該根據自己實際路徑調整)

export PATH=$PATH:/home/data/ollama/bin

更新環境變量

source ~/.bashrc

修改Ollama模型保存路徑

這一步還是很有必要的,能夠方便管理模型,尤其是在windows系統中,如果不做相關的設置,會默認下載到C盤

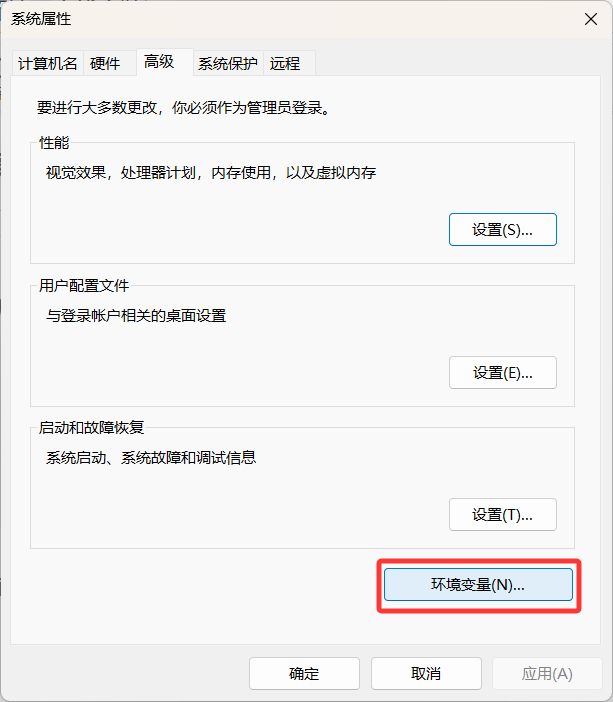

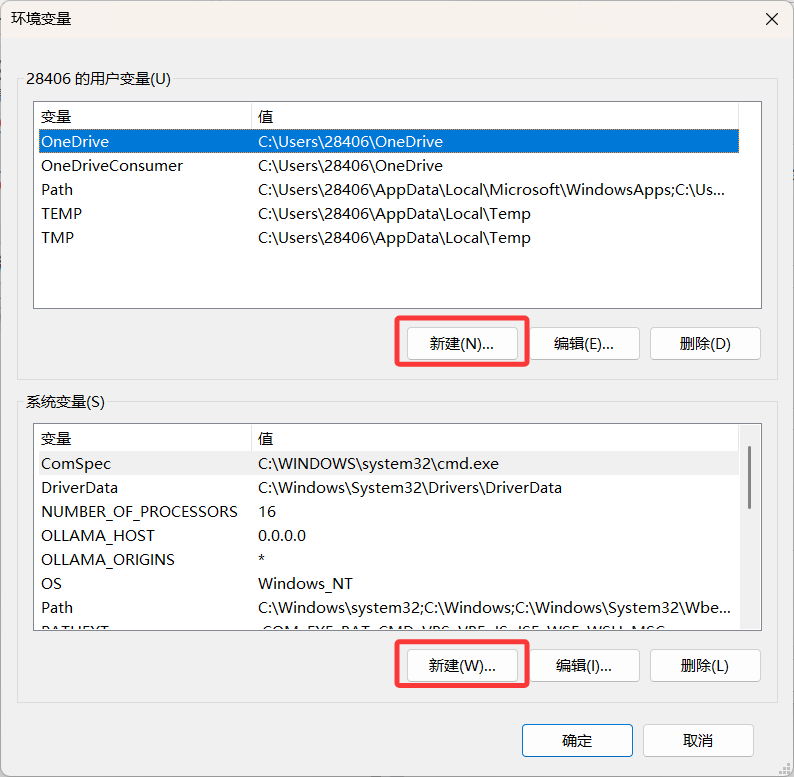

Windows環境修改保存路徑

然后點擊環境變量

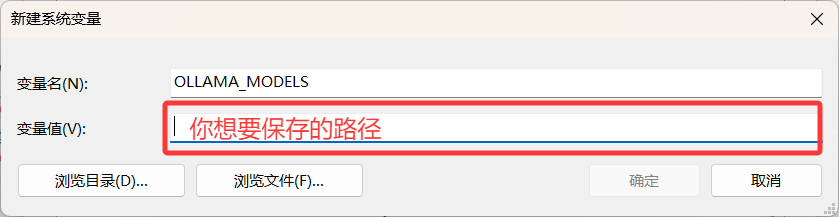

這里選任意一個就行

變量名為OLLAMA_MODELS

Linux環境修改保存路徑

Linux環境更為簡單,直接打開bashrc添加環境變量即可

vi ~/.bashrc

然后添加

export OLLAMA_MODELS=你想設置的路徑

保存并退出后

source ~/.bashrc

然后可以使用以下命令啟動ollama

ollama start

模型下載

在線下載

ollama官網: https://ollama.com/

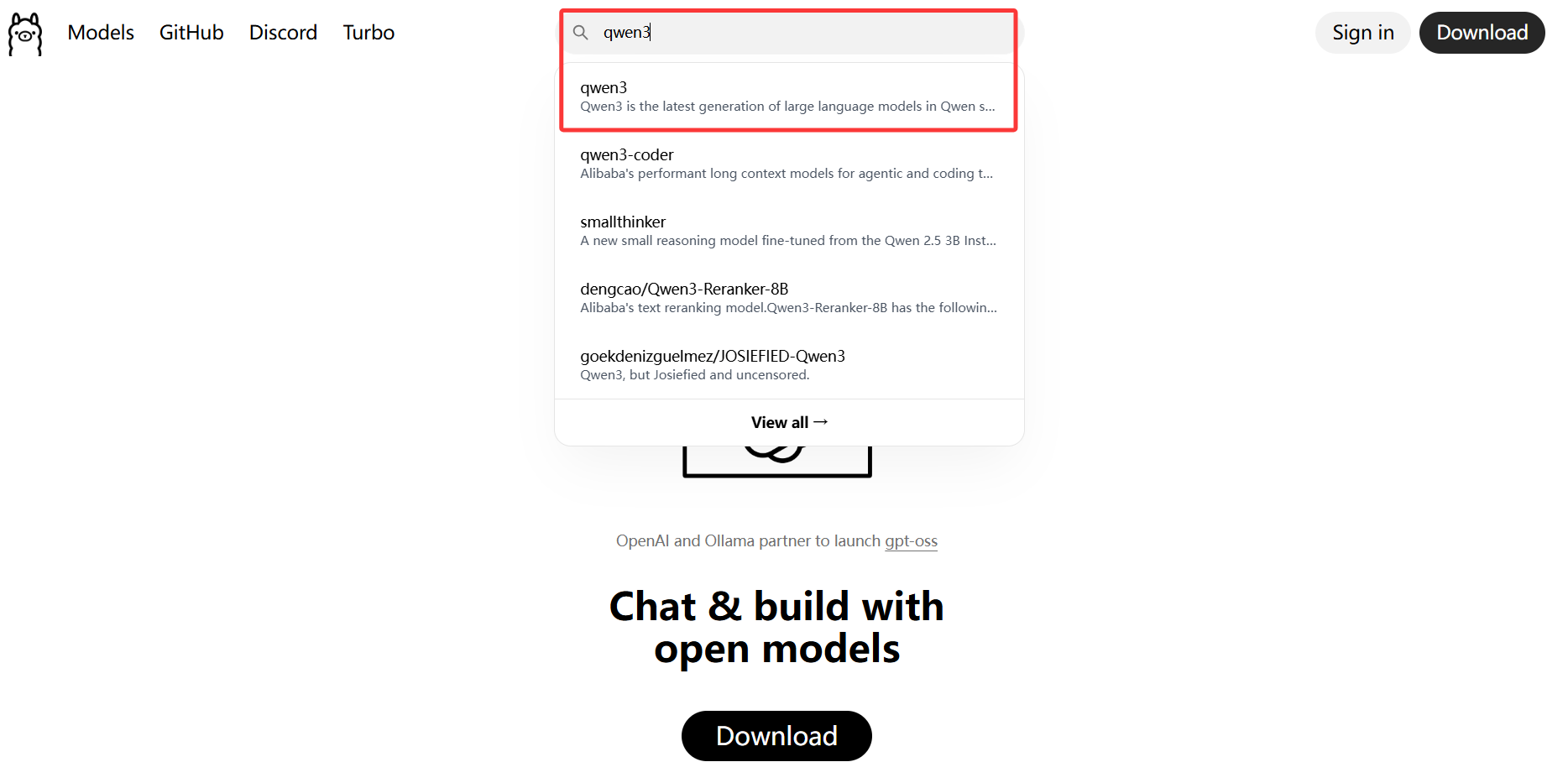

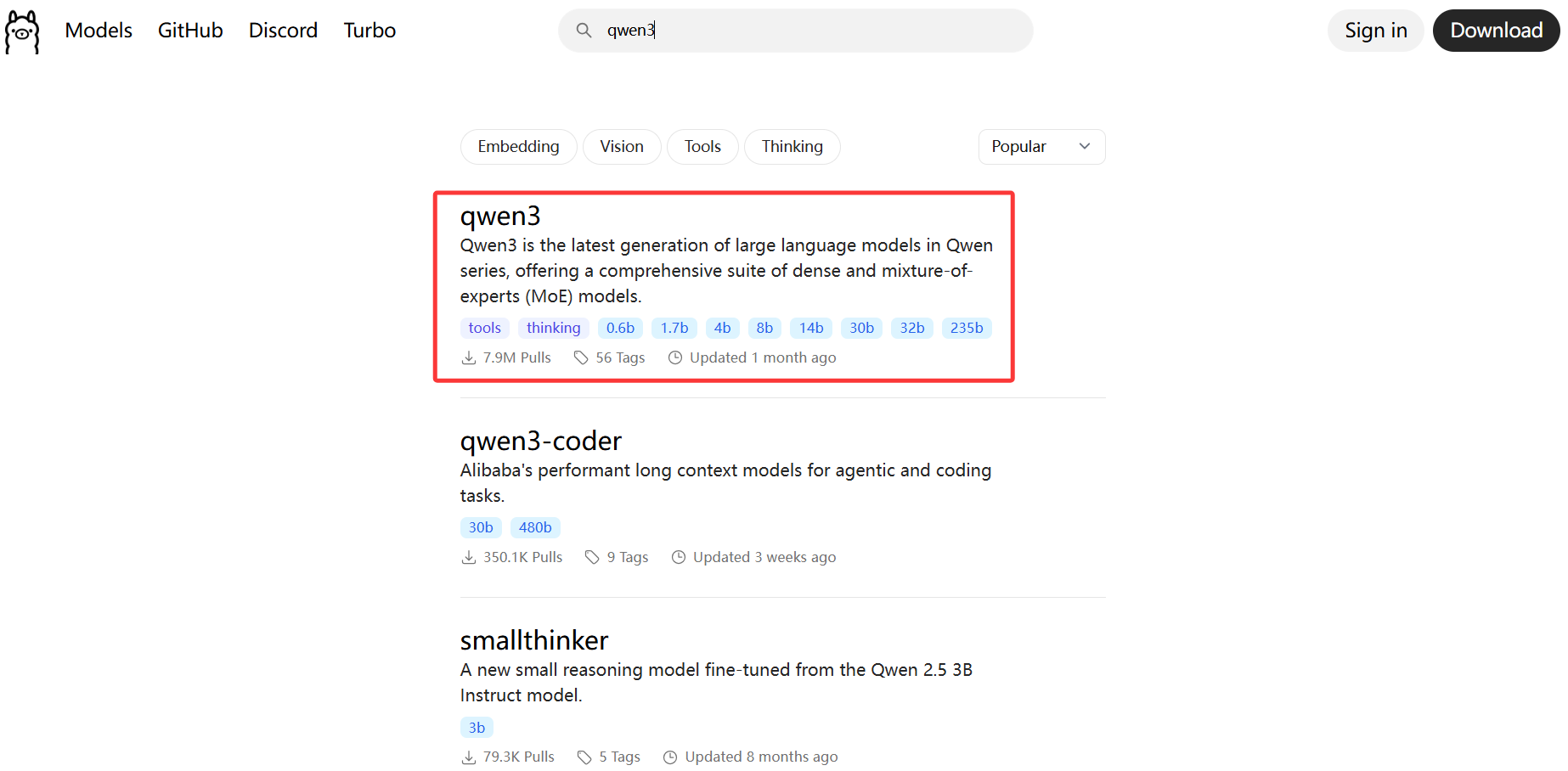

打開官網直接搜索需要的模型,本文以qwen3為例

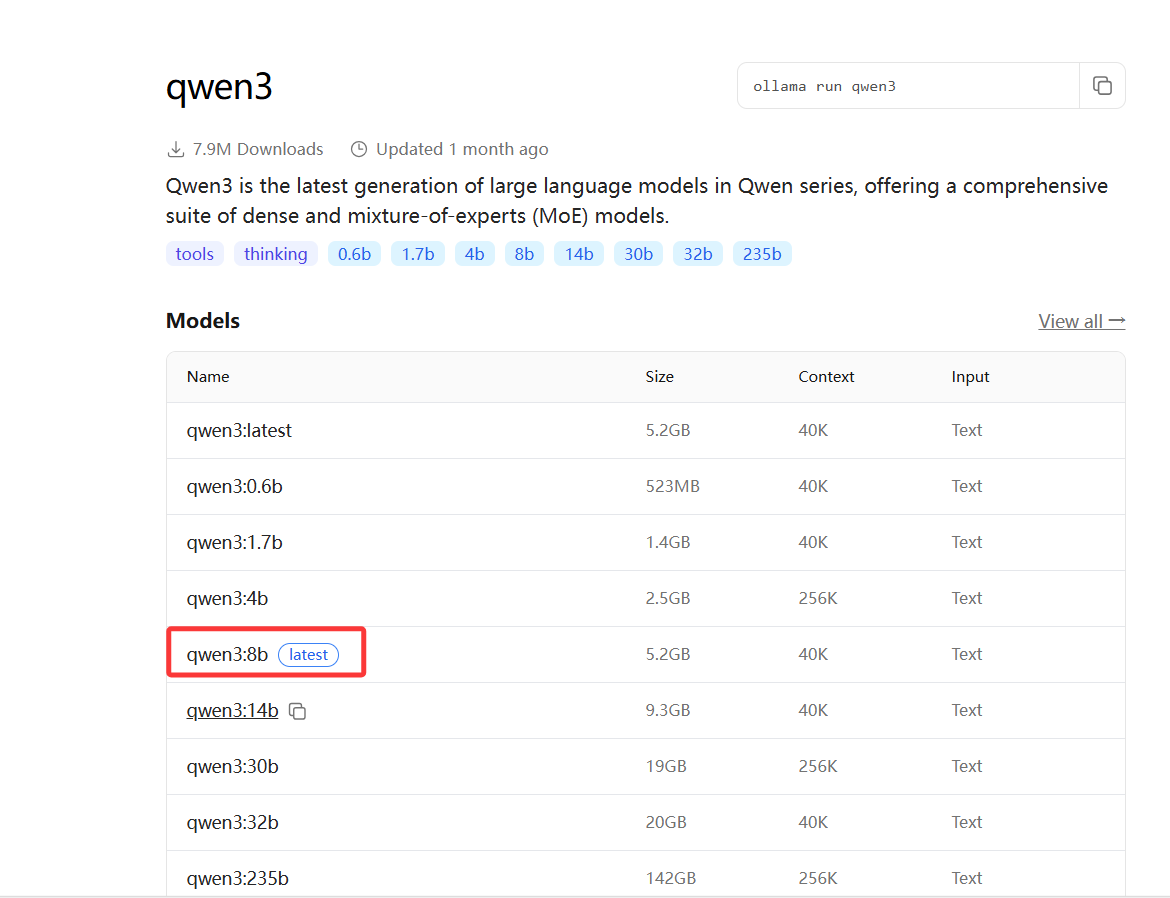

然后點擊適合自己設備的模型(基本上size比自己的顯存小一點就合適)

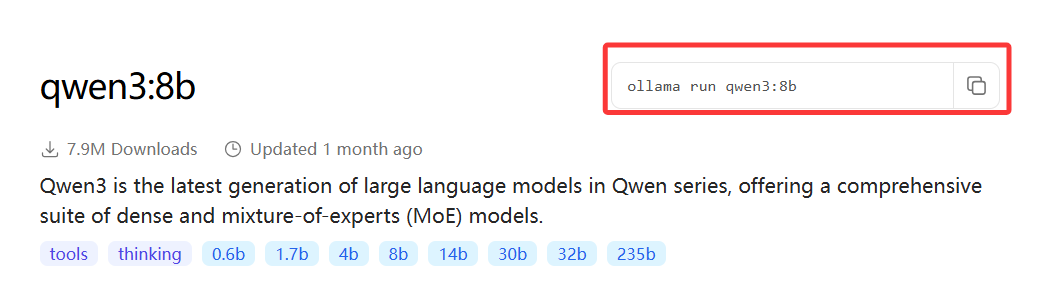

然后復制命令到命令行

隨后ollama會自動下載并運行該模型

手動下載

手動下載的方式參照玩轉大語言模型——ollama導入huggingface下載的模型,這里不再贅述

)

)

)

)