0.LLamaFactory

LLaMA-Factory 是一個開源的低代碼大模型訓練與微調框架,旨在簡化大規模語言模型(LLM)的微調、評估和部署流程,幫助開發者和研究人員更高效地定制和優化模型。

1.安裝部署

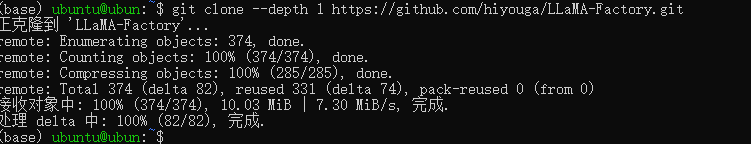

1.1克隆倉庫

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

克隆成功如下圖所示

1.2切換目錄

cd LLaMA-Factory

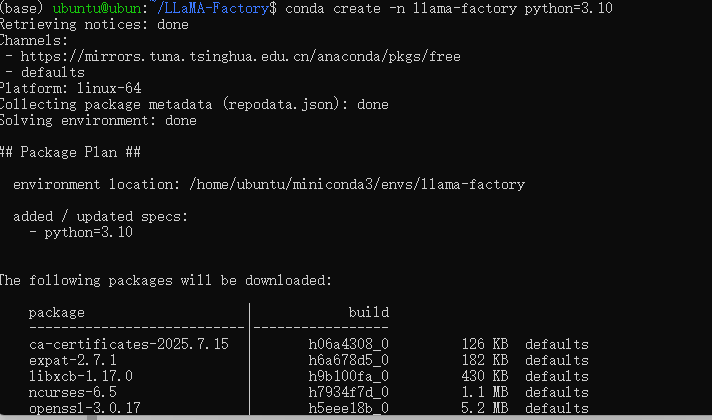

1.3通過conda創建python環境

conda create -n llama-factory python=3.10

1.4激活虛擬環境

conda activate llama-factory

1.5在conda環境中安裝LLama-Factory相關依賴

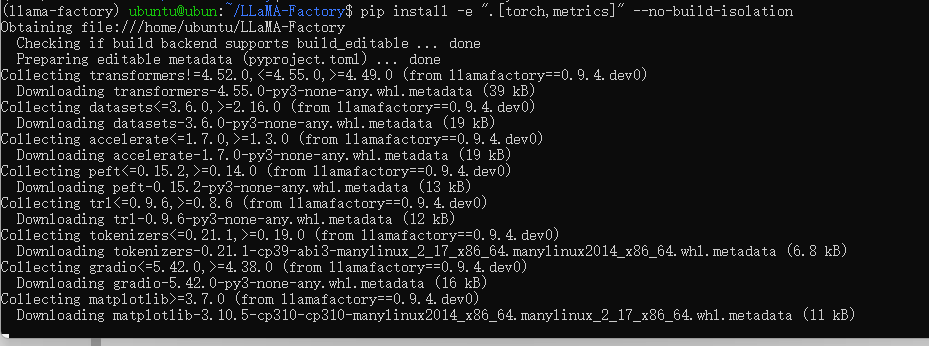

pip install -e ".[torch,metrics]" --no-build-isolation

安裝過程如下

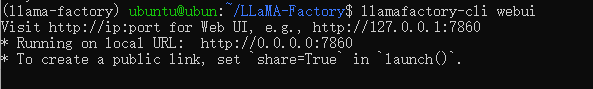

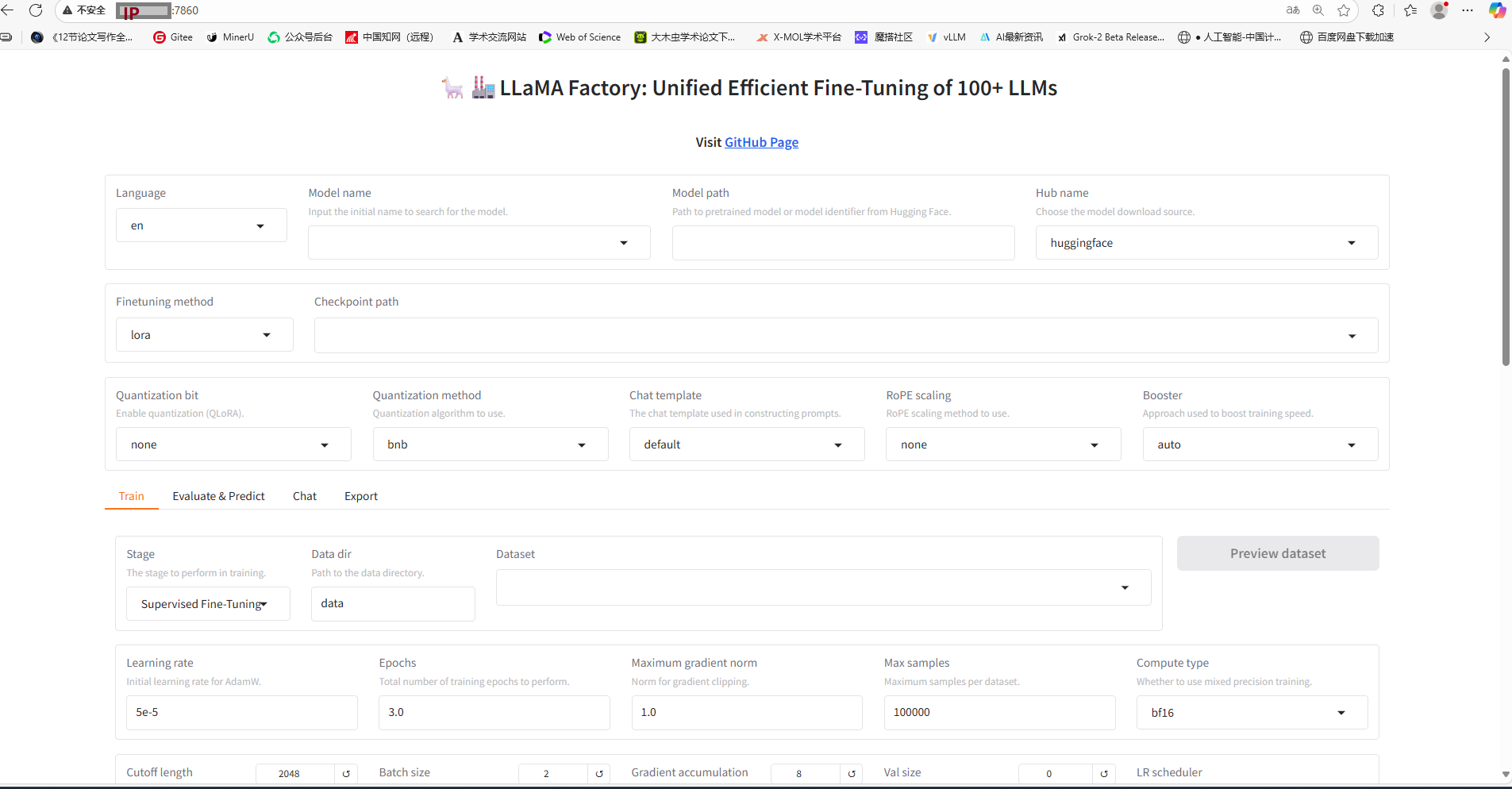

2.啟動LLama-Factory可視化微調界面(由 Gradio 驅動)

llamafactory-cli webui

3.在瀏覽器輸入服務器ip+端口

啟動成功如下圖所示

4.從Hugging-Face上面下載基座模型

4.1創建一個文件夾統一存放所有基座模型

mkdir Hugging-Face

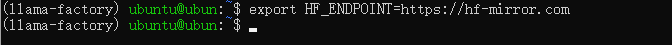

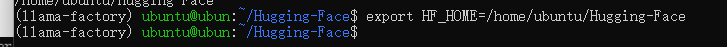

4.2修改 HuggingFace 鏡像源(加速下載)

export HF_ENDPOINT=https://hf-mirror.com

4.3修改模型默認下載位置

export HF_HOME=/data/Hugging-Face

————————————————————————

NOTES:

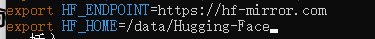

4.2和4.3的做法是在臨時會話中生效,如果想要永久化生效,如下操作:

(1)打開配置文件

sudo vi ~/.bashrc

(2)寫入以下內容

export HF_ENDPOINT=https://hf-mirror.com

export HF_HOME=/data/Hugging-Face

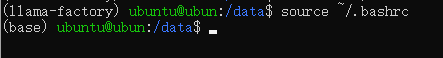

(3)配置生效

source ~/.bashrc

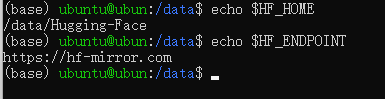

(4)驗證生效即可

echo $HF_HOME

echo $HF_ENDPOINT

如下圖所示

——————————————————————————

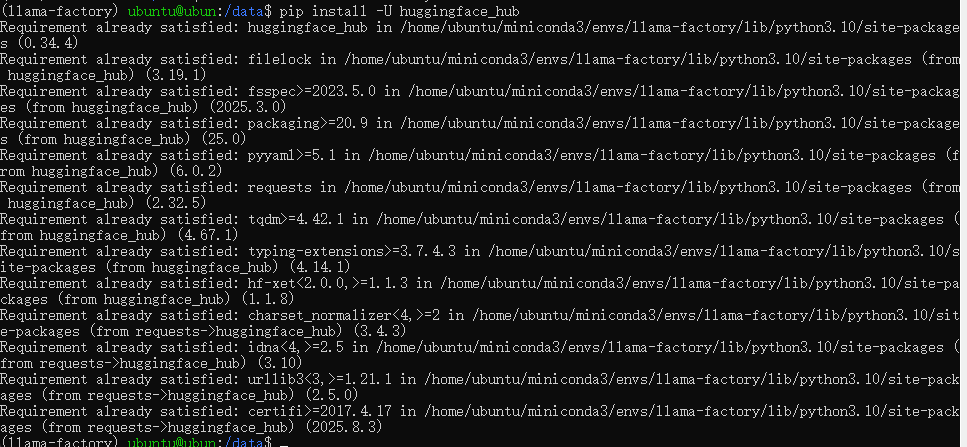

4.4安裝HuggingFace官方下載工具

pip install -U huggingface_hub

——————————————————

NOTES:

1.??pip install??

Python 包管理工具的標準安裝命令。

2.??-U參數??

--upgrade的簡寫,表示強制升級到最新版本(若已安裝則更新)。

3.??huggingface_hub??

HuggingFace 官方提供的 Python 庫,用于:

?訪問 Hub 上的模型/數據集

?管理倉庫和文件

?集成 Transformers/Diffusers 等庫

———————————————————

執行成功如下

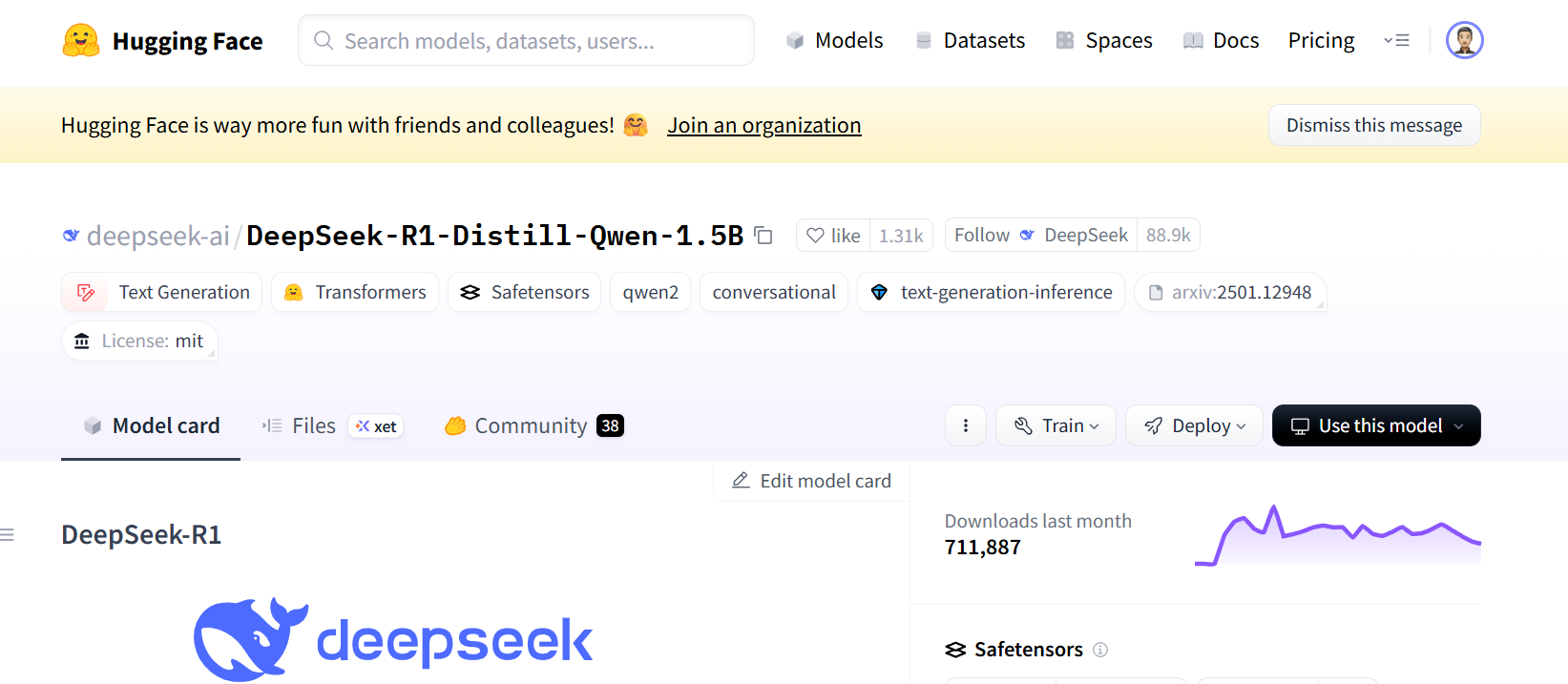

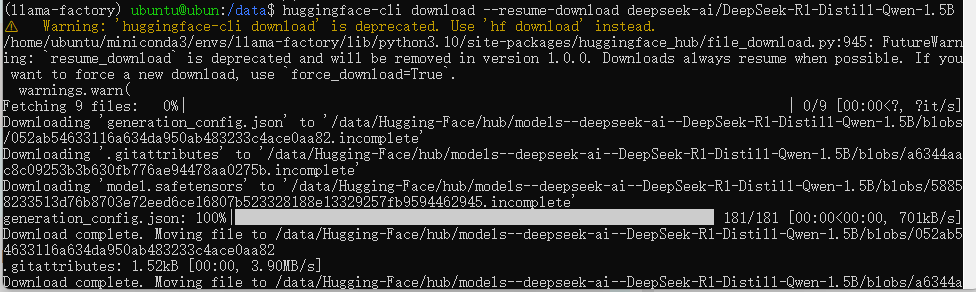

4.5執行下載命令

huggingface-cli download --resume-download deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

下載哪個模型到HuggingFace官網上面搜索即可

下載成功截圖

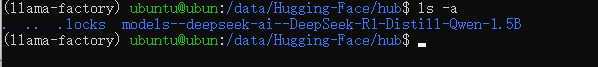

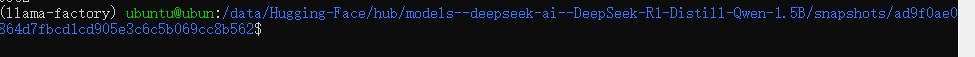

模型位置

5.在LLamaFactory可視化頁面上加載模型,檢驗是否加載成功

5.1選擇模型

——————————————————

NOTES:

這里的模型路徑不是整個模型文件夾,而是精確到模型特定快照的唯一哈希值snapshots

路徑如下所示

——————————————————

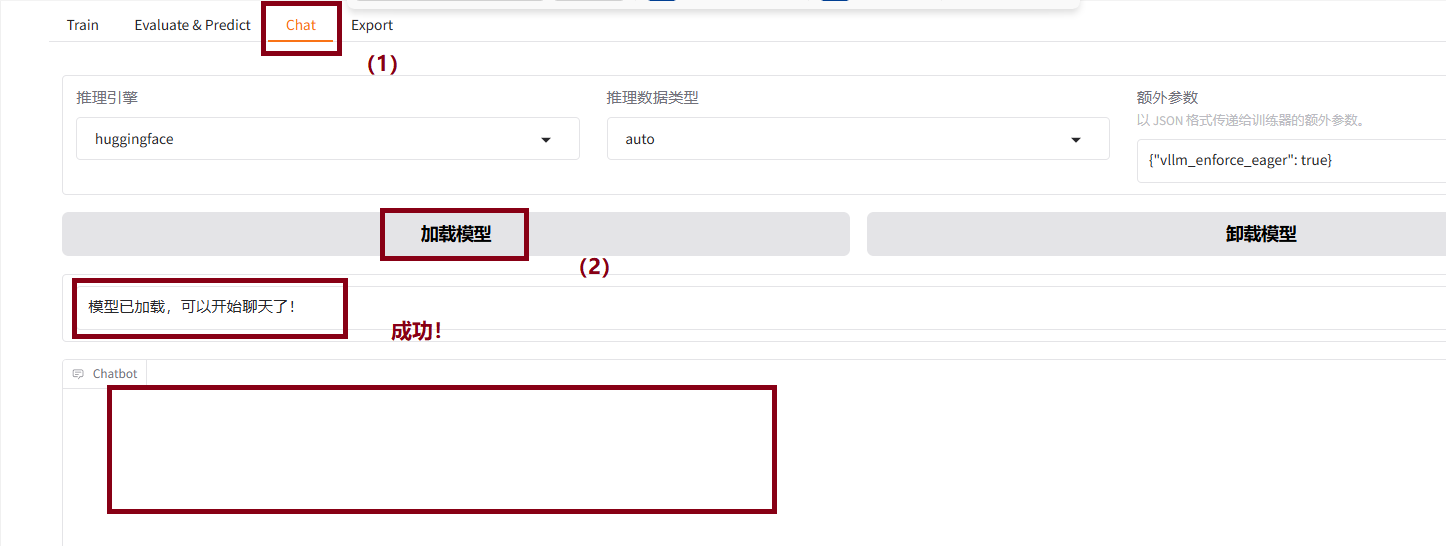

5.2執行測試

5.2.1 分別點擊chat->加載模型,出現如下界面即為成功

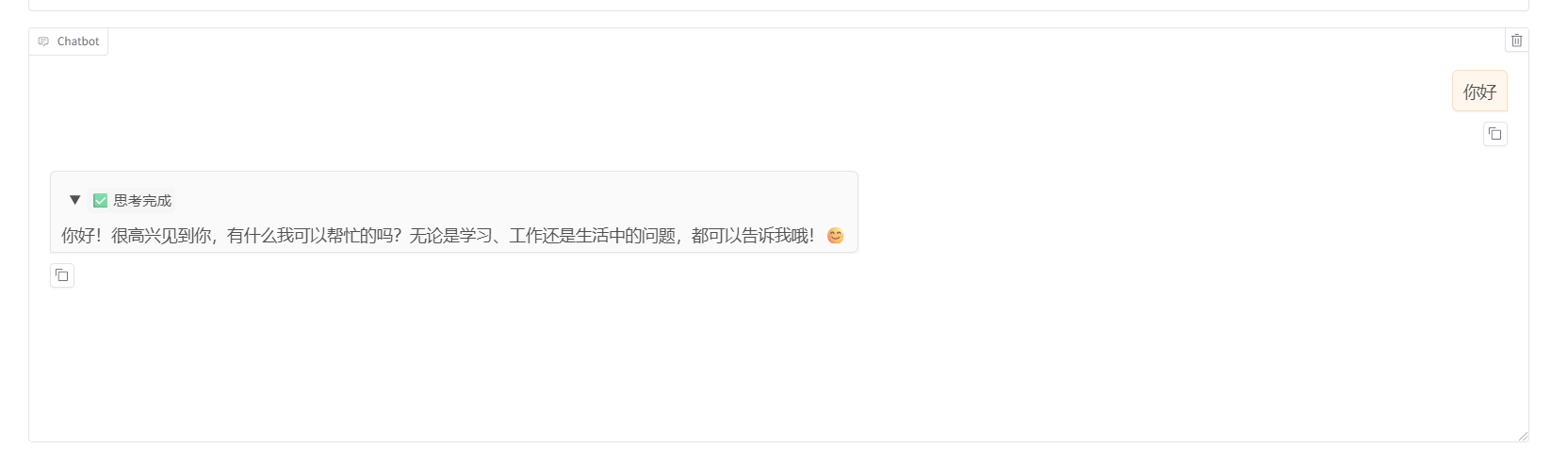

5.2.2 聊天測試

下圖即為成功

)

get聯合注入 過濾select和union “閉合)

)