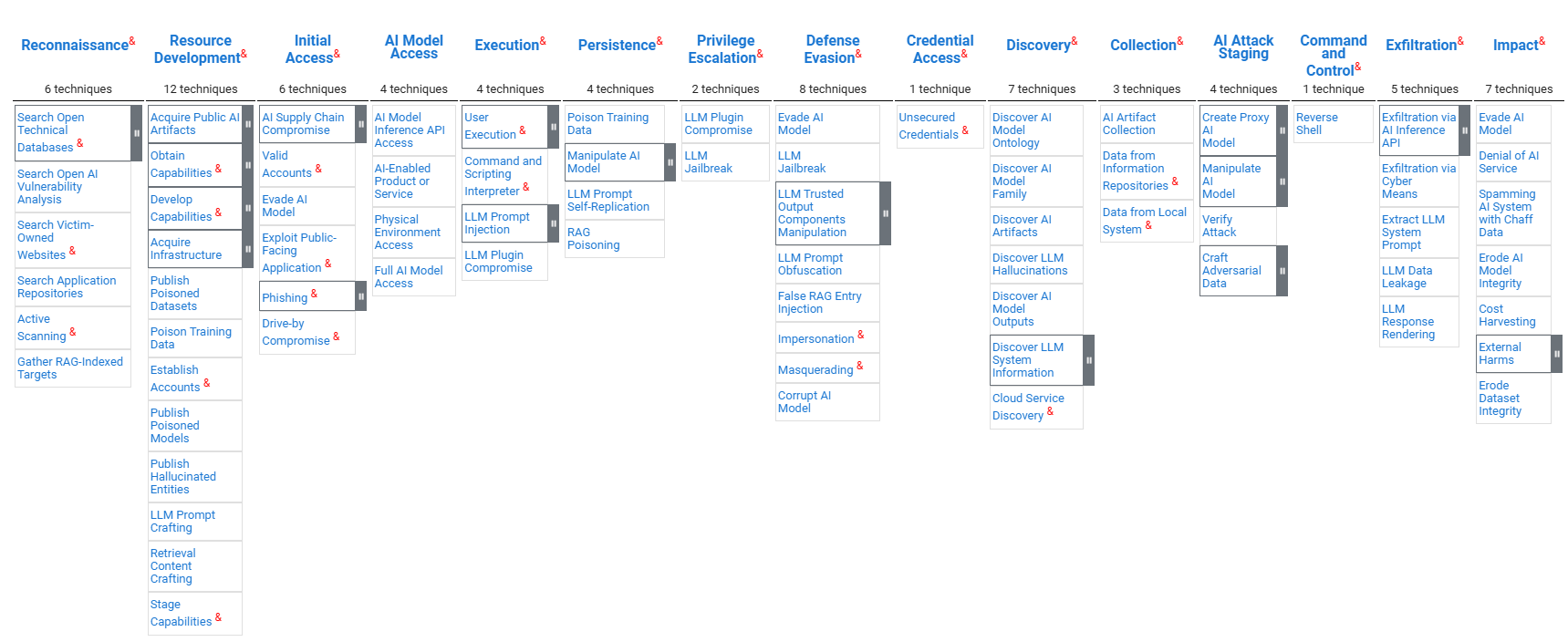

一、Mitre Atlas矩陣概述

? ? ? ?ATLAS 矩陣從左到右以列形式顯示了攻擊中使用的策略的進展,ML 技術屬于上面的每種策略。&?表示從 ATT&CK 改編而來。

? ? ? ?ATLAS 矩陣從左到右以列形式顯示了攻擊中使用的策略的進展,ML 技術屬于上面的每種策略。&?表示從 ATT&CK 改編而來。

? ? ?詳見:ATLAS Matrix | MITRE ATLAS?

? ? ? 注:機翻的效果不是太好,對照理解用吧。

二、緩解措施

▎限制公開信息

限制公開發布組織產品或服務中使用的 AI 堆棧的技術信息。攻擊者可以利用 AI 使用方式的技術知識來執行針對性攻擊,并針對目標系統進行定制攻擊。此外,考慮限制發布組織信息(包括實際位置、研究人員姓名和部門結構),因為這些信息可能推斷出 AI 技術、模型架構或數據集等技術細節。

▎限制模型發布信息

限制公開發布技術項目細節,包括生產中使用的或代表生產中使用的數據、算法、模型架構和模型檢查點。

▎被動AI輸出混淆

降低向最終用戶提供的模型輸出的保真度可以降低對手提取有關模型的信息和優化模型攻擊的能力。

▎模型強化

使用技術使 AI 模型對對抗性輸入(例如對抗性訓練或網絡蒸餾)具有魯棒性。

▎限制模型查詢

限制用戶可以執行的查詢總數和速率。

▎控制模型訪問權限

建立內部模型注冊表的訪問控制,并限制內部對生產模型的訪問。僅限經批準的用戶訪問訓練數據。

▎使用模型集成架構

使用模型集成進行推理,以增強對對抗性輸入的魯棒性。某些攻擊可能有效規避某個模型或模型系列,但對其他模型或模型系列無效。

▎凈化訓練數據

檢測并移除或修復中毒的訓練數據。在模型訓練之前,應先對訓練數據進行清理,并在主動學習模型中反復進行清理。通過過濾器以限制攝入的訓練數據。制定內容政策,刪除不受歡迎的內容,例如某些露骨或冒犯性的語言。

▎驗證模型完整性

通過測試后門觸發器或對抗性偏見,驗證 AI 模型是否按預期運行。監控模型中的概念漂移和訓練數據漂移,這可能表明數據被篡改和中毒。

▎使用多模傳感器

結合多個傳感器來整合不同的視角和模式,以避免容易受到物理攻擊的單點故障。

▎輸入恢復

預處理所有推理數據以消除或逆轉潛在的對抗性擾動。

▎限制庫加載

通過配置適當的庫加載機制和調查潛在的易受攻擊的軟件,防止濫用操作系統和軟件中的庫加載機制來加載不受信任的代碼。通常用于存儲 AI 模型的文件格式(例如 pickle 文件)可能包含允許加載惡意庫的漏洞。

▎加密敏感信息

加密 AI 模型等敏感數據,以防止對手試圖訪問敏感數據。

▎代碼簽名

通過數字簽名驗證強制執行二進制和應用程序完整性,以防止不受信任的代碼執行。攻擊者可以將惡意代碼嵌入 AI 軟件或模型中。強制執行代碼簽名可以防止 AI 供應鏈受到損害,并阻止惡意代碼的執行。

▎驗證AI組件

驗證所有 AI 組件的加密校驗和,以確認文件未被攻擊者修改。

▎對抗性輸入檢測

檢測并阻止對抗性輸入或異常查詢,這些查詢偏離了已知的良性行為,表現出先前攻擊中觀察到的行為模式,或來自潛在惡意 IP。在 AI 模型之前,將對抗性檢測算法集成到 AI 系統中。

▎漏洞掃描

洞掃描用于查找可能被利用的軟件漏洞并進行修復。諸如 pickle 文件之類的常用于存儲 AI 模型的文件格式可能包含允許任意代碼執行的漏洞。應掃描這些文件以查找潛在的不安全調用,這些調用可能被用于執行代碼、創建新進程或建立網絡功能。攻擊者可能會在損壞的模型文件中嵌入惡意代碼,因此掃描程序應該能夠處理無法完全反序列化的模型。模型工件及其生成的下游產品都應進行已知漏洞掃描。

▎模型分布

將 AI 模型部署到邊緣設備可能會增加系統的攻擊面。考慮在云端提供模型服務,以降低攻擊者對模型的訪問級別。此外,還應考慮在云端使用計算功能,以防止灰盒攻擊(攻擊者可以訪問模型預處理方法)。

▎用戶教育

對人工智能模型開發人員進行安全編碼實踐和人工智能漏洞方面的教育。

▎身份驗證

要求用戶在訪問生產模型之前驗證其身份。要求對 API 端點進行身份驗證,并監控生產模型查詢,以確保符合使用政策并防止模型濫用。

▎生成式AI護欄

護欄是設置在生成式AI模型與用戶共享的輸出之間的安全控制措施,用于防止不必要的輸入和輸出。護欄可以采用驗證器的形式,例如過濾器、基于規則的邏輯或正則表達式,也可以采用基于AI的方法,例如分類器和使用LLM或命名實體識別(NER)來評估提示或響應的安全性。可以采用特定領域的方法來降低價值觀、品牌損害、越獄、虛假信息、代碼漏洞、SQL注入和數據泄露等各個領域的風險。

▎生成式AI指南

指南是位于用戶提供的輸入和生成式 AI 模型之間的安全控制,旨在幫助指導模型產生所需的輸出并防止不良輸出。指南可以作為附加在所有用戶提示后的說明,也可以作為系統提示中的一部分。指南可以定義系統的目標、角色和聲音,并概述安全參數。

▎生成式AI對齊

在訓練或微調生成式 AI 模型時,重要的是利用能夠改善模型與安全性、保障性和內容策略的一致性的技術。微調過程可能會消除生成式人工智能模型中的內置安全機制,但利用監督微調、從人類反饋或人工智能反饋中進行強化學習以及有針對性的安全上下文提煉等技術可以提高模型的安全性和一致性。

▎構建AI物料清單

人工智能物料清單 (AI BOM) 包含構建人工智能所需的所有工件和資源的完整列表。AI BOM 有助于降低供應鏈風險,并快速響應已報告的漏洞。這可以包括維護數據集來源,即用于人工智能應用的數據集的詳細歷史記錄。歷史記錄可以包括數據集來源的信息以及任何修改的完整記錄。

▎AI日志審計

實現已部署 AI 模型的輸入和輸出日志記錄。監控日志有助于檢測安全威脅并減輕影響。此外,啟用日志記錄可以阻止那些想要不被發現的對手利用人工智能資源。

▎數據集來源管理

維護用于人工智能應用的數據集的詳細歷史記錄。歷史記錄應包括數據集來源信息以及所有修改的完整記錄。

參考文獻:

面向AI安全的26個防御措施(MITRE ATLAS,2025)

(日更))

)

:區塊鏈世界的計算引擎)