背景意義

研究背景與意義

隨著工業自動化和智能制造的快速發展,孔洞檢測作為關鍵的質量控制環節,受到了廣泛關注。孔洞的存在可能會影響產品的強度、密封性和整體性能,因此,準確、快速地檢測孔洞對于保障產品質量至關重要。傳統的孔洞檢測方法多依賴于人工檢查或簡單的圖像處理技術,這些方法不僅效率低下,而且容易受到人為因素的影響,導致檢測結果的不一致性和不可靠性。因此,開發一種基于先進計算機視覺技術的自動化孔洞檢測系統顯得尤為重要。

近年來,深度學習技術的飛速發展為圖像識別和目標檢測提供了新的解決方案。YOLO(You Only Look Once)系列模型因其高效的實時檢測能力而廣泛應用于各種視覺任務。特別是YOLOv11的改進版本,憑借其在準確性和速度上的優越表現,成為了研究者們關注的焦點。本項目旨在基于改進的YOLOv11模型,構建一個高效的孔洞檢測系統,以實現對工業產品中孔洞的快速、準確檢測。

為實現這一目標,我們將使用一個包含1500張經過標注的孔洞圖像的數據集。該數據集專門針對孔洞這一單一類別進行了優化,確保模型能夠專注于識別和定位孔洞特征。通過對數據集的精細處理和增強,我們期望提高模型的魯棒性和泛化能力,使其在不同環境和條件下均能保持高效的檢測性能。

本研究不僅將推動孔洞檢測技術的發展,還將為相關領域的智能檢測系統提供有力的技術支持,具有重要的理論意義和實際應用價值。通過這一項目,我們希望能夠為工業生產提供更加智能化的解決方案,提升產品質量和生產效率。

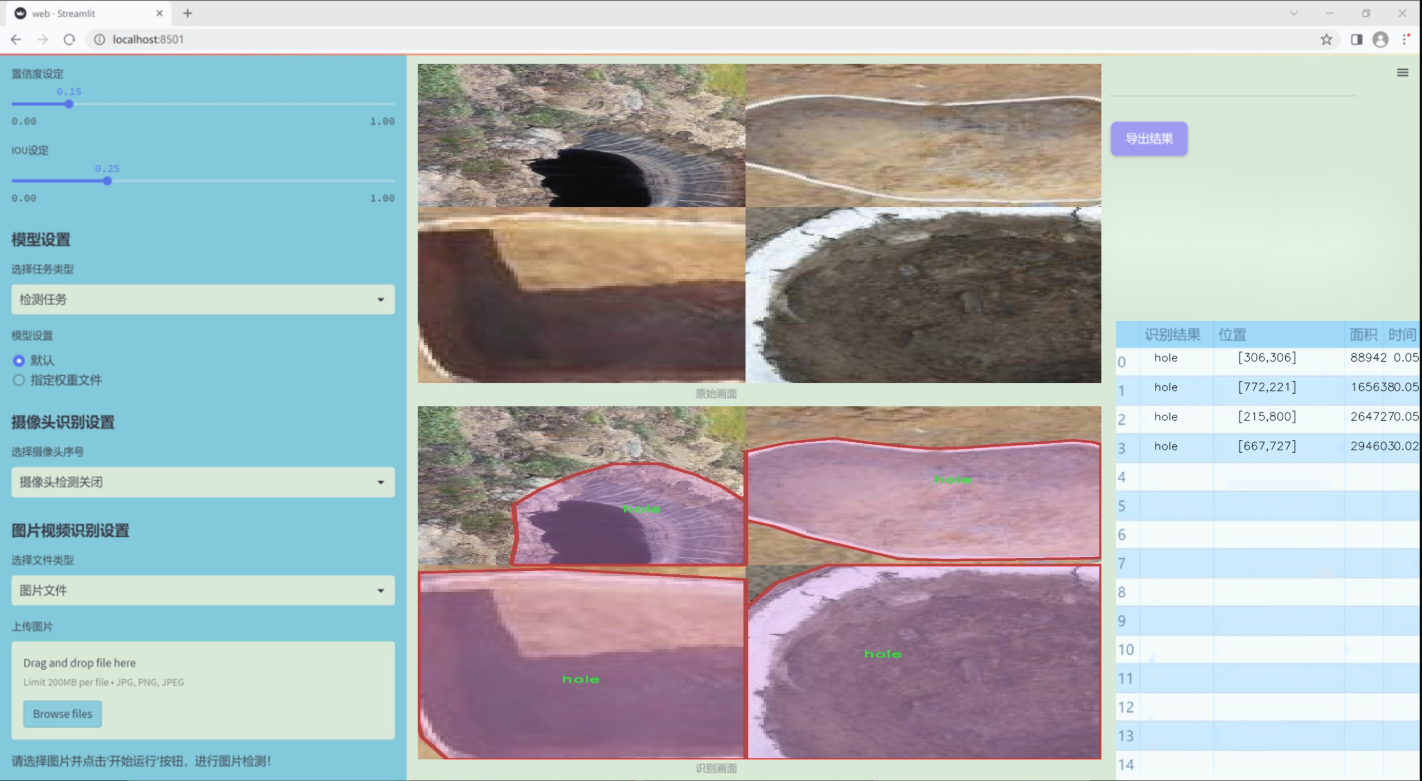

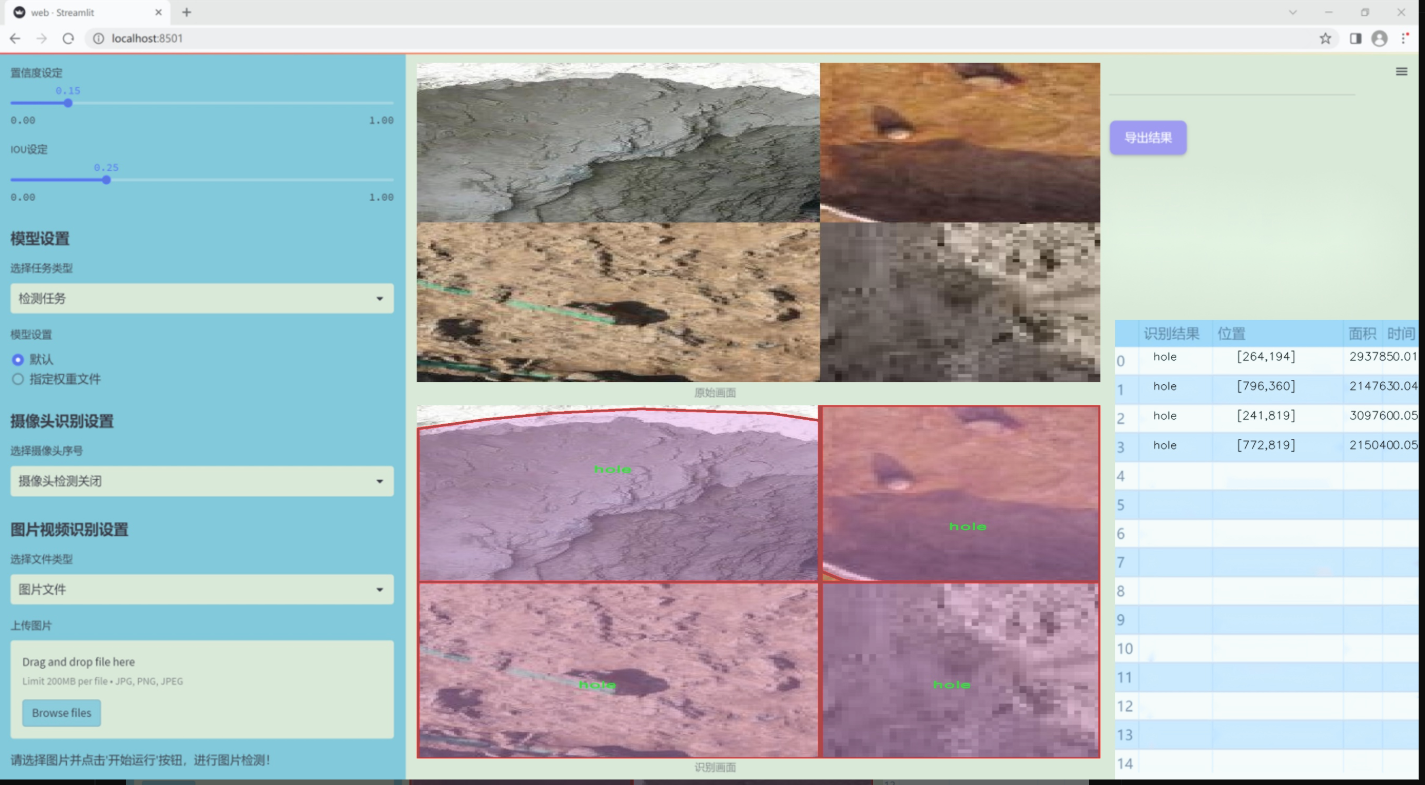

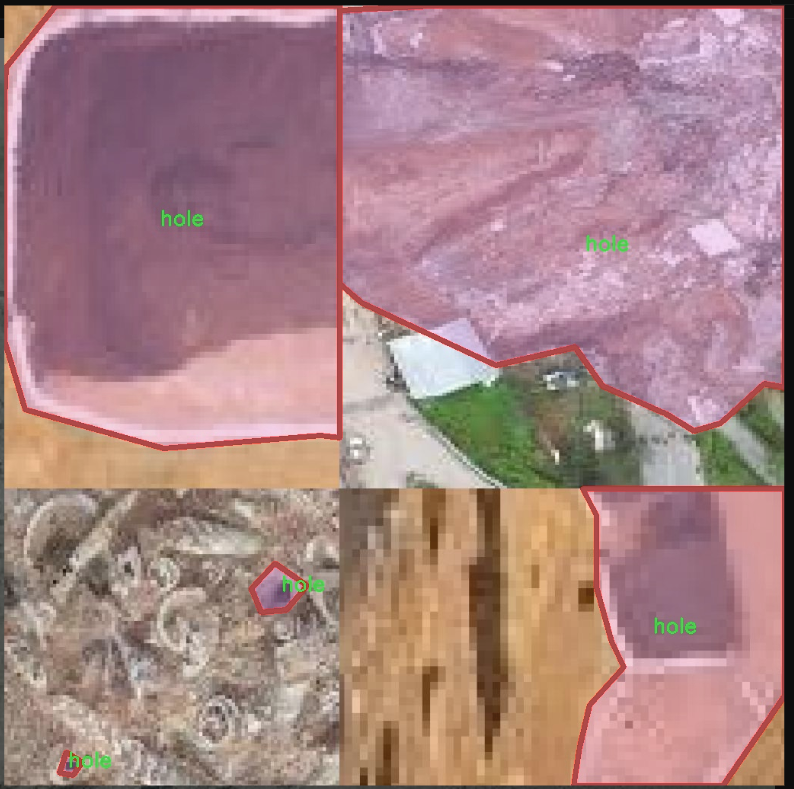

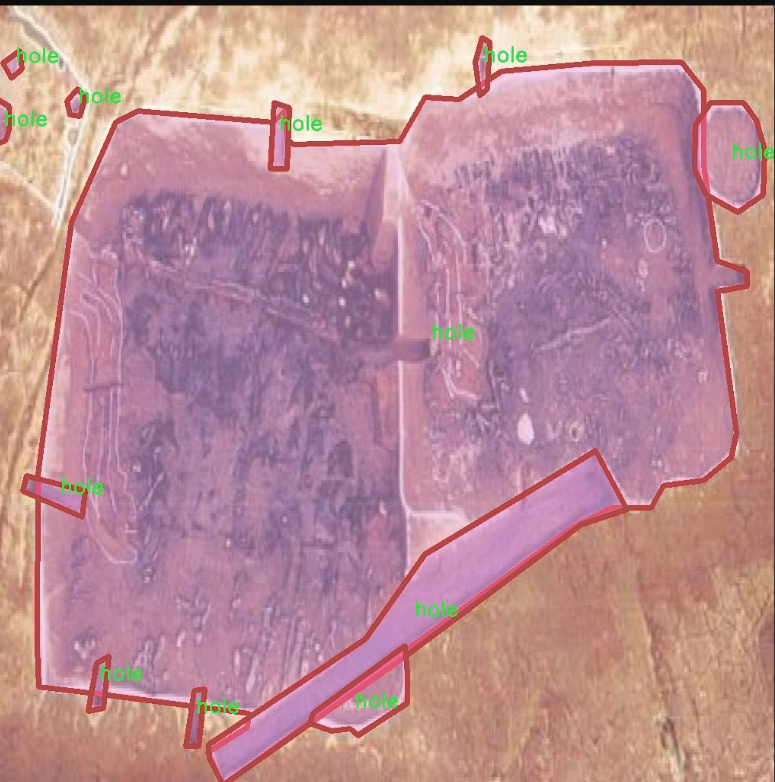

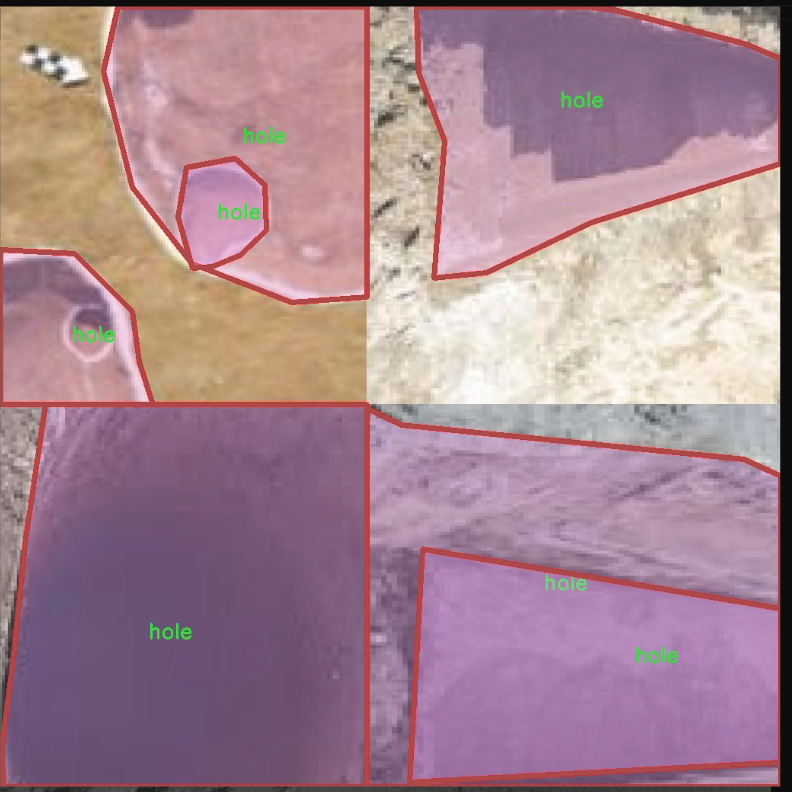

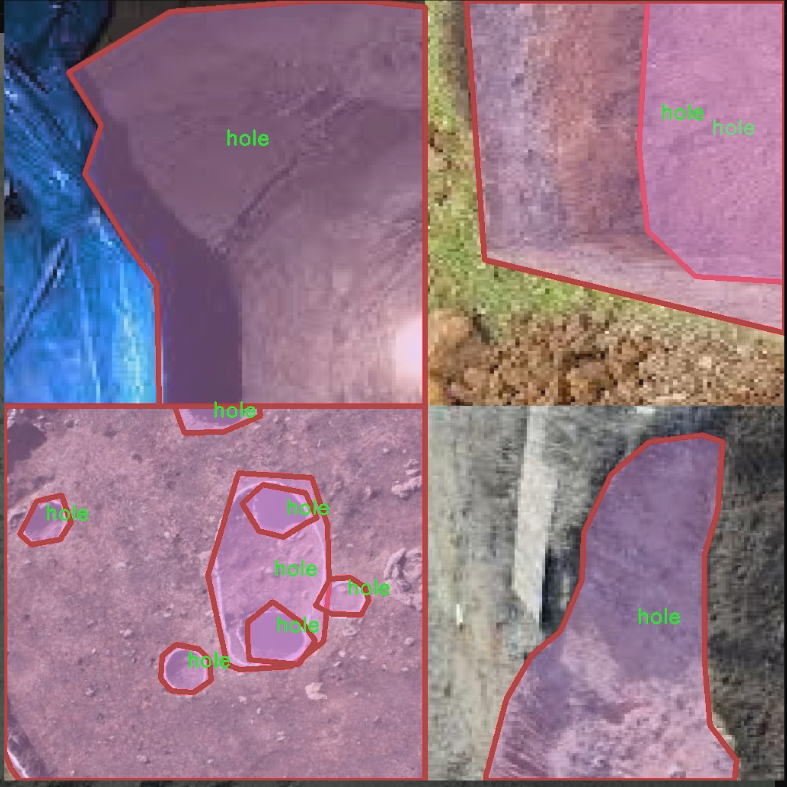

圖片效果

數據集信息

本項目數據集信息介紹

本項目旨在通過改進YOLOv11算法,構建一個高效的孔洞檢測系統,以滿足工業檢測和質量控制的需求。為此,我們構建了一個專門針對孔洞檢測的訓練數據集,命名為“holes-resize”。該數據集專注于識別和分類不同尺寸和形狀的孔洞,涵蓋了實際應用中可能遇到的各種情況。數據集中包含的類別數量為1,具體類別為“hole”,這一設計使得模型能夠專注于該特定目標的檢測與識別。

在數據集的構建過程中,我們收集了大量具有代表性的孔洞圖像,這些圖像來源于不同的工業場景,包括但不限于制造業、建筑業和材料檢測等領域。為了確保數據集的多樣性和廣泛性,我們對孔洞的尺寸、形狀、背景和光照條件進行了精心設計,確保模型在訓練過程中能夠接觸到豐富的樣本,從而提高其泛化能力和檢測精度。此外,為了增強數據集的實用性,我們還對圖像進行了適當的預處理和增強,例如旋轉、縮放和亮度調整,以模擬實際應用中可能遇到的各種情況。

通過使用該數據集進行訓練,我們期望改進后的YOLOv11模型能夠在孔洞檢測任務中表現出色,能夠快速、準確地識別出不同尺寸和形狀的孔洞。這將為相關行業提供更為高效的檢測工具,降低人工檢測的成本,提高產品質量和生產效率。我們相信,這一數據集的構建和應用將為孔洞檢測技術的發展提供重要的支持和推動力。

核心代碼

以下是提取后的核心代碼部分,并附上詳細的中文注釋:

import torch

import torch.nn as nn

import numpy as np

class Mlp(nn.Module):

“”“多層感知機(MLP)模塊”“”

def init(self, in_features, hidden_features=None, out_features=None, act_layer=nn.GELU, drop=0.):

super().init()

out_features = out_features or in_features # 輸出特征數

hidden_features = hidden_features or in_features # 隱藏層特征數

self.fc1 = nn.Linear(in_features, hidden_features) # 第一層線性變換

self.act = act_layer() # 激活函數

self.fc2 = nn.Linear(hidden_features, out_features) # 第二層線性變換

self.drop = nn.Dropout(drop) # Dropout層

def forward(self, x):"""前向傳播"""x = self.fc1(x) # 線性變換x = self.act(x) # 激活x = self.drop(x) # Dropoutx = self.fc2(x) # 線性變換x = self.drop(x) # Dropoutreturn x

class CSWinBlock(nn.Module):

“”“CSWin Transformer的基本塊”“”

def init(self, dim, num_heads, mlp_ratio=4., drop=0., attn_drop=0., norm_layer=nn.LayerNorm):

super().init()

self.dim = dim # 輸入特征維度

self.num_heads = num_heads # 注意力頭數

self.mlp_ratio = mlp_ratio # MLP的隱藏層比率

self.qkv = nn.Linear(dim, dim * 3) # 線性變換生成Q、K、V

self.norm1 = norm_layer(dim) # 歸一化層

self.attn = LePEAttention(dim, num_heads=num_heads, attn_drop=attn_drop) # 注意力層

self.mlp = Mlp(in_features=dim, hidden_features=int(dim * mlp_ratio), out_features=dim) # MLP層

self.norm2 = norm_layer(dim) # 歸一化層

def forward(self, x):"""前向傳播"""img = self.norm1(x) # 歸一化qkv = self.qkv(img).reshape(x.shape[0], -1, 3, self.dim).permute(2, 0, 1, 3) # 生成Q、K、Vx = self.attn(qkv) # 注意力計算x = x + self.mlp(self.norm2(x)) # 加上MLP的輸出return x

class CSWinTransformer(nn.Module):

“”“CSWin Transformer模型”“”

def init(self, img_size=640, in_chans=3, num_classes=1000, embed_dim=96, depth=[2,2,6,2], num_heads=12):

super().init()

self.num_classes = num_classes # 類別數

self.embed_dim = embed_dim # 嵌入維度

self.stage1_conv_embed = nn.Sequential(

nn.Conv2d(in_chans, embed_dim, 7, 4, 2), # 卷積層

nn.LayerNorm(embed_dim) # 歸一化層

)

self.stage1 = nn.ModuleList([

CSWinBlock(dim=embed_dim, num_heads=num_heads) for _ in range(depth[0]) # 堆疊CSWinBlock

])

# 其他階段的初始化略去

def forward(self, x):"""前向傳播"""x = self.stage1_conv_embed(x) # 初始卷積嵌入for blk in self.stage1:x = blk(x) # 通過每個塊return x

示例代碼,創建模型并進行前向傳播

if name == ‘main’:

inputs = torch.randn((1, 3, 640, 640)) # 輸入張量

model = CSWinTransformer() # 創建模型

res = model(inputs) # 前向傳播

print(res.size()) # 輸出結果的尺寸

代碼說明:

Mlp類:實現了一個簡單的多層感知機,包含兩個線性層和一個激活函數,支持Dropout。

CSWinBlock類:實現了CSWin Transformer的基本構建塊,包含注意力機制和MLP。

CSWinTransformer類:整體模型結構,包含輸入卷積層和多個CSWinBlock的堆疊。

前向傳播:模型通過輸入數據進行前向傳播,輸出特征。

該代碼實現了CSWin Transformer的基本結構,適用于圖像分類等任務。

這個程序文件 CSWinTransformer.py 實現了 CSWin Transformer 模型,這是一個用于計算機視覺任務的深度學習模型。文件的結構主要包括模型的定義、輔助類和函數,以及一些用于創建不同規模模型的工廠函數。

首先,文件引入了必要的庫,包括 PyTorch 和一些來自 timm 庫的工具。接著,定義了幾個重要的類。

Mlp 類實現了一個多層感知機(MLP),包含兩個線性層和一個激活函數(默認為 GELU),并在每個線性層后添加了 dropout 層,以防止過擬合。

LePEAttention 類實現了一個局部增強的自注意力機制。該類通過將輸入的特征圖轉換為窗口形式,來計算自注意力。它的構造函數接受多個參數,包括輸入維度、分辨率、頭數等,并定義了用于計算注意力的卷積層和 dropout 層。forward 方法實現了注意力的計算過程。

CSWinBlock 類是 CSWin Transformer 的基本構建塊,它結合了自注意力機制和 MLP。該類的構造函數定義了輸入的維度、頭數、分辨率等參數,并初始化了注意力層和 MLP。forward 方法則實現了前向傳播過程,計算輸入的注意力輸出并通過 MLP 進行處理。

img2windows 和 windows2img 函數用于在圖像和窗口之間進行轉換,方便進行自注意力計算。

Merge_Block 類用于在不同階段之間合并特征圖,通過卷積層和歸一化層來處理特征。

CSWinTransformer 類是整個模型的核心,它定義了輸入圖像的處理流程,包括卷積嵌入、多個 CSWinBlock 的堆疊以及特征的合并。構造函數中設置了模型的各個階段,并根據輸入的參數初始化相應的層。forward_features 方法用于提取特征,而 forward 方法則是模型的前向傳播入口。

此外,文件中還定義了一些輔助函數,例如 _conv_filter 用于轉換權重,update_weight 用于更新模型權重,以及幾個用于創建不同規模的 CSWin Transformer 模型的工廠函數(如 CSWin_tiny, CSWin_small, CSWin_base, CSWin_large)。

最后,在 main 部分,代碼演示了如何使用不同規模的 CSWin Transformer 模型進行推理,生成隨機輸入并輸出各個模型的特征圖尺寸。

整體來看,這個文件實現了一個復雜的視覺 Transformer 模型,結合了自注意力機制和卷積操作,適用于各種計算機視覺任務。

10.4 head.py

以下是代碼中最核心的部分,經過簡化并添加了詳細的中文注釋:

import torch

import torch.nn as nn

import torch.nn.functional as F

from ultralytics.utils.tal import dist2bbox, make_anchors

class Detect_DyHead(nn.Module):

“”“YOLOv8 檢測頭,使用動態頭進行目標檢測。”“”

def __init__(self, nc=80, hidc=256, block_num=2, ch=()):super().__init__()self.nc = nc # 類別數量self.nl = len(ch) # 檢測層數量self.reg_max = 16 # DFL通道數量self.no = nc + self.reg_max * 4 # 每個錨點的輸出數量self.stride = torch.zeros(self.nl) # 在構建過程中計算的步幅c2, c3 = max((16, ch[0] // 4, self.reg_max * 4)), max(ch[0], self.nc) # 通道數# 定義卷積層self.conv = nn.ModuleList(nn.Sequential(Conv(x, hidc, 1)) for x in ch)self.dyhead = nn.Sequential(*[DyHeadBlock(hidc) for _ in range(block_num)]) # 動態頭塊self.cv2 = nn.ModuleList(nn.Sequential(Conv(hidc, c2, 3), Conv(c2, c2, 3), nn.Conv2d(c2, 4 * self.reg_max, 1)) for _ in ch)self.cv3 = nn.ModuleList(nn.Sequential(nn.Sequential(DWConv(hidc, x, 3), Conv(x, c3, 1)),nn.Sequential(DWConv(c3, c3, 3), Conv(c3, c3, 1)),nn.Conv2d(c3, self.nc, 1),)for x in ch)self.dfl = DFL(self.reg_max) if self.reg_max > 1 else nn.Identity() # DFL層def forward(self, x):"""前向傳播,返回預測的邊界框和類別概率。"""for i in range(self.nl):x[i] = self.conv[i](x[i]) # 通過卷積層處理輸入x = self.dyhead(x) # 通過動態頭處理特征shape = x[0].shape # 獲取輸出形狀for i in range(self.nl):# 將 cv2 和 cv3 的輸出進行拼接x[i] = torch.cat((self.cv2[i](x[i]), self.cv3[i](x[i])), 1)# 如果在訓練模式下,直接返回處理后的特征if self.training:return x# 動態調整錨點和步幅self.anchors, self.strides = (x.transpose(0, 1) for x in make_anchors(x, self.stride, 0.5))# 將特征展平并分割為邊界框和類別x_cat = torch.cat([xi.view(shape[0], self.no, -1) for xi in x], 2)box, cls = x_cat.split((self.reg_max * 4, self.nc), 1) # 分割為邊界框和類別# 解碼邊界框dbox = dist2bbox(self.dfl(box), self.anchors.unsqueeze(0), xywh=True, dim=1) * self.stridesy = torch.cat((dbox, cls.sigmoid()), 1) # 返回邊界框和經過sigmoid處理的類別概率return ydef bias_init(self):"""初始化檢測頭的偏置,要求步幅可用。"""for a, b, s in zip(self.cv2, self.cv3, self.stride):a[-1].bias.data[:] = 1.0 # 邊界框偏置初始化為1b[-1].bias.data[:self.nc] = math.log(5 / self.nc / (640 / s) ** 2) # 類別偏置初始化

代碼說明:

Detect_DyHead 類:這是 YOLOv8 的檢測頭,使用動態頭進行目標檢測。它負責處理輸入特征并生成邊界框和類別概率。

構造函數 (init):初始化檢測頭的參數,包括類別數量、隱藏通道、檢測層數量等,并定義卷積層和動態頭塊。

前向傳播 (forward):處理輸入特征,經過卷積層和動態頭,最終生成邊界框和類別概率。

偏置初始化 (bias_init):初始化邊界框和類別的偏置值,確保模型在訓練時的穩定性。

這個簡化版本保留了核心邏輯,并添加了詳細的中文注釋,便于理解代碼的功能和實現。

這個文件 head.py 是一個實現 YOLOv8 檢測頭的 PyTorch 模塊,包含多個類和方法,用于目標檢測、分割和姿態估計等任務。文件中定義了多個檢測頭類,主要包括 Detect_DyHead、Detect_AFPN_P345、Detect_Efficient 等,這些類繼承自 nn.Module,并實現了不同的前向傳播邏輯和網絡結構。

首先,文件導入了一些必要的庫,包括 torch 和 torch.nn,以及一些自定義模塊和函數。接著,定義了一個名為 Detect_DyHead 的類,它是 YOLOv8 的檢測頭,具有動態網格重建和導出模式的功能。該類的構造函數接受類別數、隱藏通道數、塊數量和通道配置等參數,并初始化了多個卷積層和動態頭塊。

在 forward 方法中,輸入的特征圖經過卷積和動態頭塊處理后,生成預測的邊界框和類別概率。該方法還處理了訓練和推理模式下的不同邏輯,包括動態錨框的生成和輸出格式的調整。

接下來,文件中定義了多個繼承自 Detect_DyHead 的類,例如 Detect_DyHeadWithDCNV3 和 Detect_DyHeadWithDCNV4,這些類實現了不同的動態頭塊變體。類似地,Detect_AFPN_P345 和 Detect_AFPN_P345_Custom 等類實現了基于自適應特征金字塔網絡(AFPN)的檢測頭。

文件中還定義了一些輕量級和高效的檢測頭類,如 Detect_Efficient 和 Detect_LSCD,這些類通過共享卷積和輕量化設計來提高模型的效率。每個檢測頭類都有自己的前向傳播邏輯,處理輸入特征并生成輸出。

此外,文件中還實現了用于姿態估計和分割的檢測頭類,如 Pose_LSCD 和 Segment_LSCD,這些類在檢測頭的基礎上增加了處理關鍵點和分割掩碼的功能。

最后,文件中包含了一些用于初始化偏置和解碼邊界框的輔助方法,確保模型在訓練和推理過程中能夠正確處理數據。整體而言,這個文件實現了 YOLOv8 的多個檢測頭,支持多種任務和模型變體,具有靈活性和可擴展性。

源碼文件

源碼獲取

歡迎大家點贊、收藏、關注、評論啦 、查看👇🏻獲取聯系方式👇🏻

)

|所有權機制 Ownership)

關鍵字搜索 API 實戰:從認證到商品列表獲取全流程解析)

)

)